本笔记仅记录《统计学习方法》中各个章节算法|模型的简要概述,比较泛泛而谈,用于应对夏令营面试可能会问的一些问题,不记录证明过程和详细的算法流程。大佬可自行绕路。

更多章节内容请参阅:李航《统计学习方法》学习笔记-优快云博客

目录

奇异值分解概述:

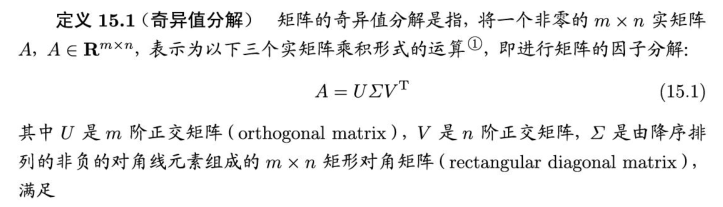

SVD是一种矩阵因子分解方法,是线性代数的概念,但在统计学习中被广泛使用,可以用于降维或数据压缩。

任意一个m×n矩阵,都可以表示为三个矩阵的乘积(因子分解)形式,分别是m阶正交矩阵、由降序排列的非负的对角线元素组成的m×n矩形对角矩阵和n阶正交矩阵,称为该矩阵的奇异值分解。矩阵的奇异值分解一定存在,但不唯一。奇异值分解可以看作是矩阵数据压缩的一种方法,即用因子分解的方式近似地表示原始矩阵,这种近似是在平方损失意义下的最优近似。

奇异值分解的定义与性质:

定义与定理:

所谓正交矩阵即:①正交矩阵的列向量和行向量都是单位向量,即每个向量的长度为1;②正交矩阵的列向量和行向量彼此正交,即任何两个不同的列向量(或行向量)之间的点积为0。

- 奇异值分解不要求矩阵A是方阵;

- 矩阵的奇异值分解不是唯一的;

- 任意给定一个实矩阵,其奇异值分解一定存在;

例子:

紧奇异值分解与截断奇异值分解:

上述的奇异值分解为矩阵的完全奇异值分解,现实中常用的是奇异值分解的紧凑形式和截断形式。紧奇异值分解是与原始矩阵等秩的奇异值分解,而截断奇异值分解是比原始矩阵低秩的奇异值分解。

矩阵的秩(Rank)是一个反映矩阵特性的重要概念,它描述了矩阵中线性无关行(或列)的最大数量。直观上,矩阵的秩表示该矩阵能够生成的向量空间的维数。秩可以从矩阵的行或者列来计算,因为它们的秩是相同的。

紧奇异值分解:

定理:

例子:

截断奇异值分解:

在矩阵的奇异值分解中,只取最大的k个奇异值(k <r, r为矩阵的秩)对应的部分,就得到矩阵的截断奇异值分解。实际应用中提到矩阵的奇异值分解时,通常指截断奇异值分解。

定理:

例子:

紧奇异值分解对应着无损压缩,截断奇异值分解对应的有损压缩。

几何解释:

这里不再探讨奇异值分解的性质。

奇异值分解的计算:

例子:

奇异值分解与矩阵近似:

奇异值分解也是一种矩阵近似的方法,这个近似是在弗罗贝尼乌斯范数(Frobeniusnorm)意义下的近似。矩阵的弗罗贝尼乌斯范数是向量的L2范数的直接推广,对应着机器学习中的平方损失函数。

这里不再赘述。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?