1、下载JDK压缩包

下载链接:https://www.oracle.com/webapps/redirect/signon?nexturl=https://download.oracle.com/otn/java/jdk/8u341-b10/424b9da4b48848379167015dcc250d8d/jdk-8u341-linux-i586.tar.gz (需要登录Oracle官网才能下载)

2、上传到master虚拟机

-

将JDK压缩包上传到master虚拟机

/opt目录 -

查看上传的JDK压缩包

3、在master虚拟机上安装配置JDK

执行命令:tar -zxvf jdk-8u341-linux-x64.tar.gz -C /usr/local,将JDK压缩包解压到指定目录

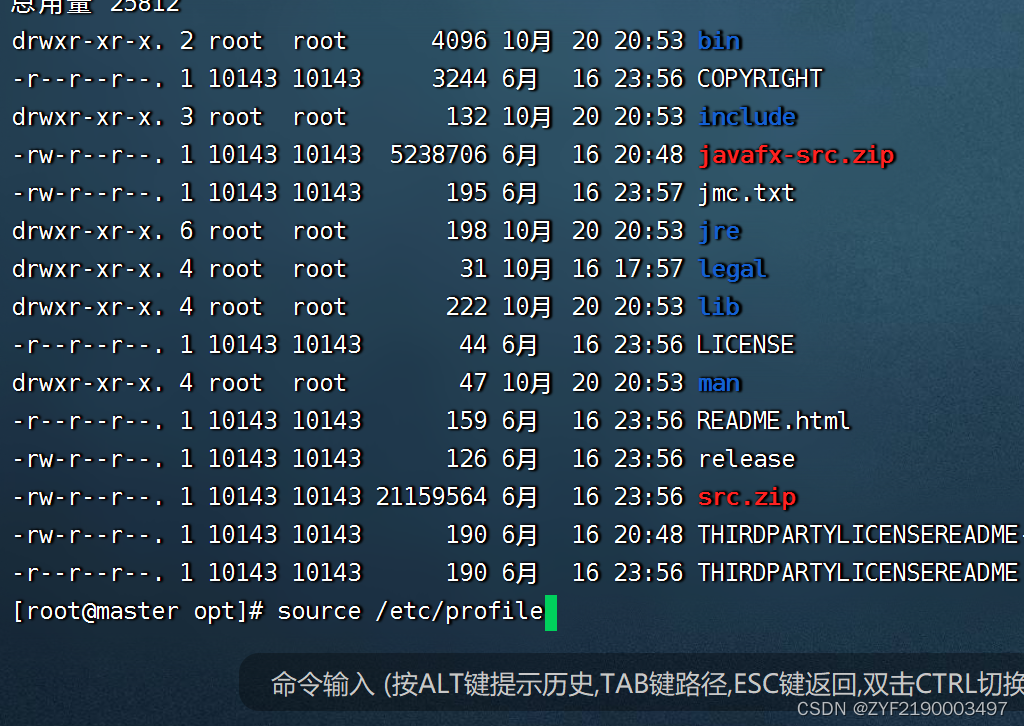

执行命令:ll /usr/local/jdk1.8.0_341,查看解压之后的jdk1.8.0_341目录

执行命令:vim /etc/profile,配置环境变量

export JAVA_HOME=/usr/local/jdk1.8.0_341

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

存盘退出,执行命令:source /etc/profile,让配置生效

查看jdk版本

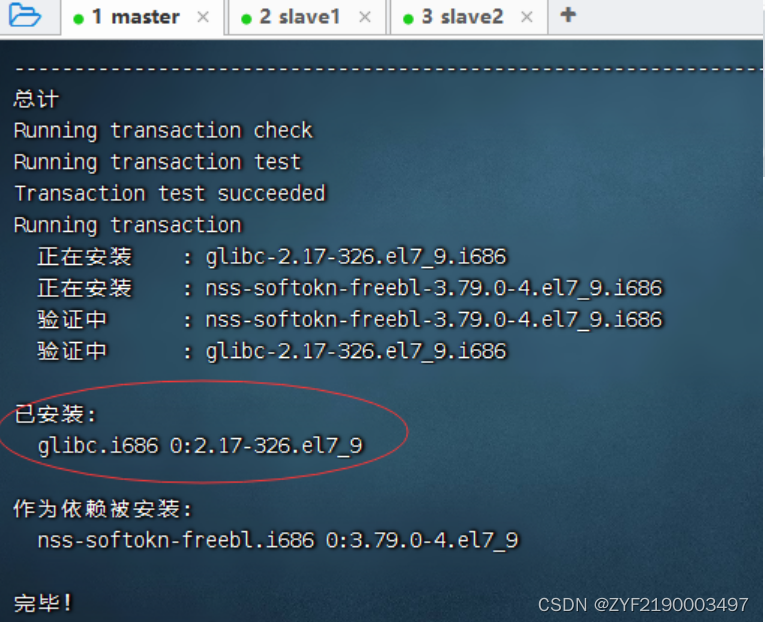

解决问题,执行命令:yum -y install glibc.i686

提示:除了master以外,slave1,slave2都要执行上面这个命令

执行命令:java -version

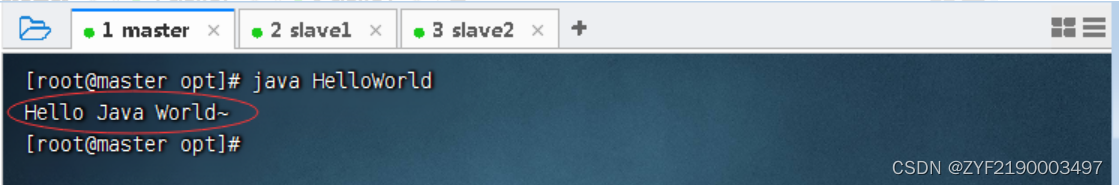

编写一个Java程序 - HelloWorld.java

存盘退出后,执行命令:javac HelloWorld.java,编译成字节码文件

执行命令:java HelloWorld

4、将JDK分发到slave1和slave2虚拟机

执行命令:scp -r $JAVA_HOME root@slave1:$JAVA_HOME (-r:recursive - 递归)

在slave1虚拟机上查看JDK是否拷贝成功

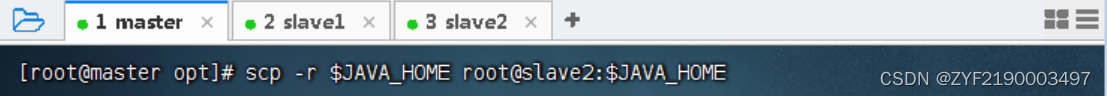

执行命令:scp -r $JAVA_HOME root@slave2:$JAVA_HOME (-r recursive - 递归)

在slave2虚拟机上查看JDK是否拷贝成功

将环境配置文件分发到slave1和slave2虚拟机

执行命令:scp /etc/profile root@slave1:/etc

执行命令:scp /etc/profile root@slave2:/etc

在slave1与slave2虚拟机上执行命令:source /etc/profile,让环境配置生效

在slave1虚拟机上查看JDK版本

在slave2虚拟机上查看JDK版本

将master中的HelloWorld.java拷贝到slave1和slave2中

4.Hadoop安装

1、下载Hadoop压缩包

- 下载链接:Apache Downloads

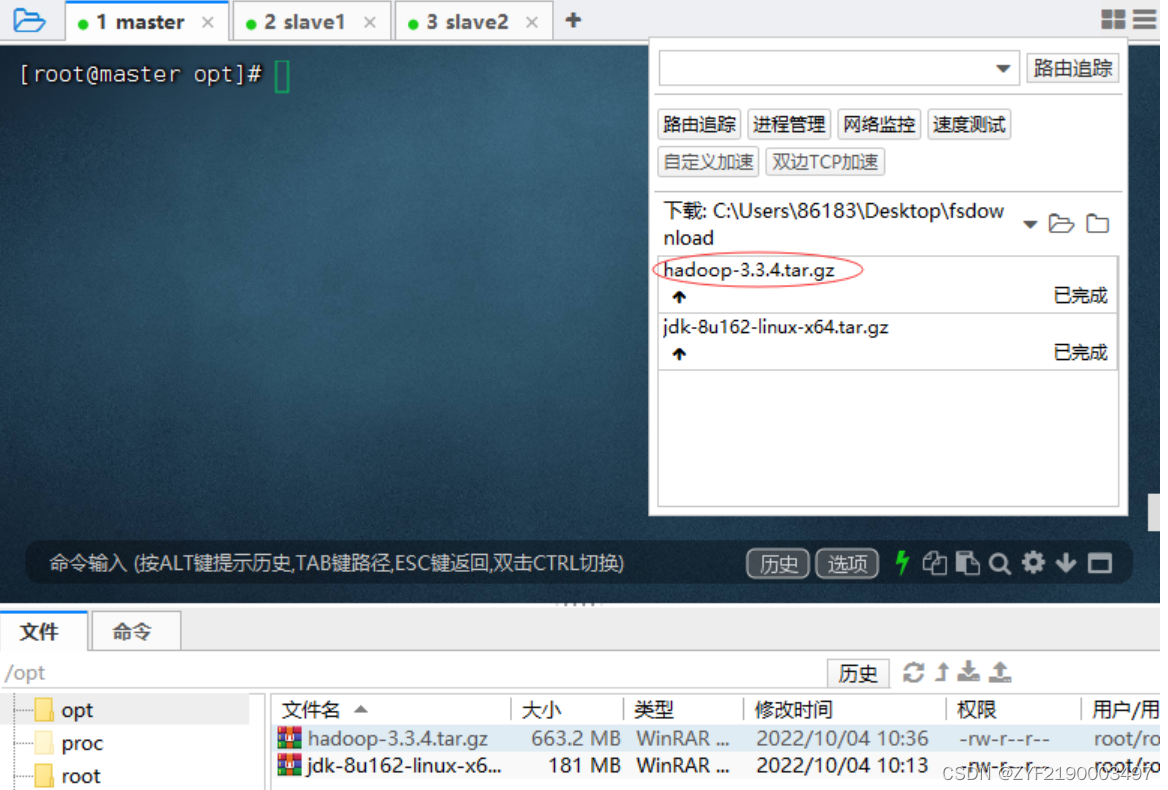

2、上传Hadoop压缩包到虚拟机

- 将Hadoop压缩包上传到master虚拟机

/opt目录

查看上传的hadoop压缩包

3.配置Hadoop环境变量

- 执行命令:

vim /etc/profile

存盘退出,执行命令source /etc/profile,让配置生效

4、验证Hadoop环境

- 执行命令:

hadoop -version,检查Hadoop安装是否成功

(二)格式化文件系统

- 初次启动HDFS集群时,必须对主节点进行格式化处理。

- 执行命令:

hdfs namenode -format

三)启动和关闭Hadoop集群

1、主节点上启动hadoop集群

- 执行

start-all.sh命令,一起启动hdfs和yarn服务,也可以分开启动两种服务。

-

执行命令:

start-dfs.sh

查看master的进程节点

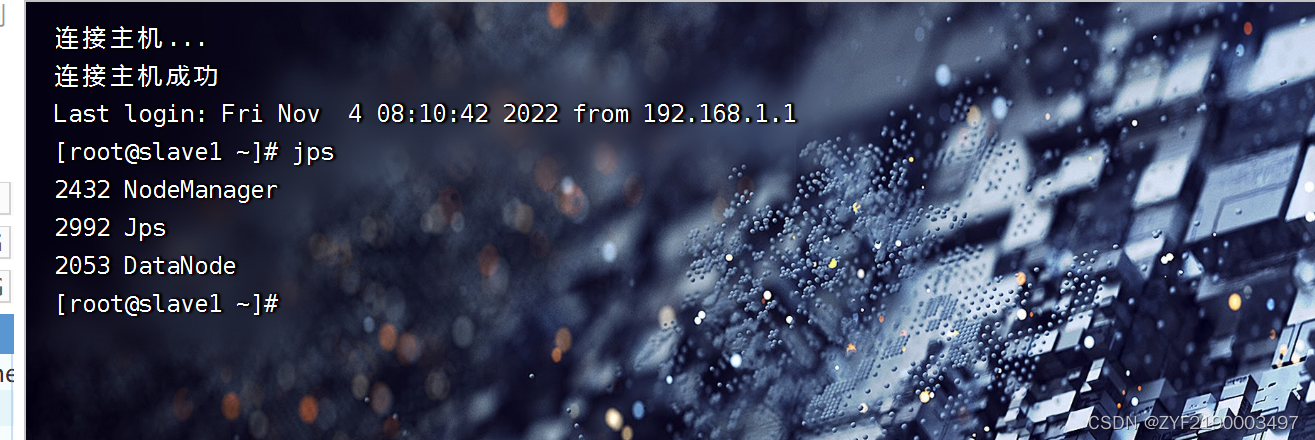

查看slave1的进程节点

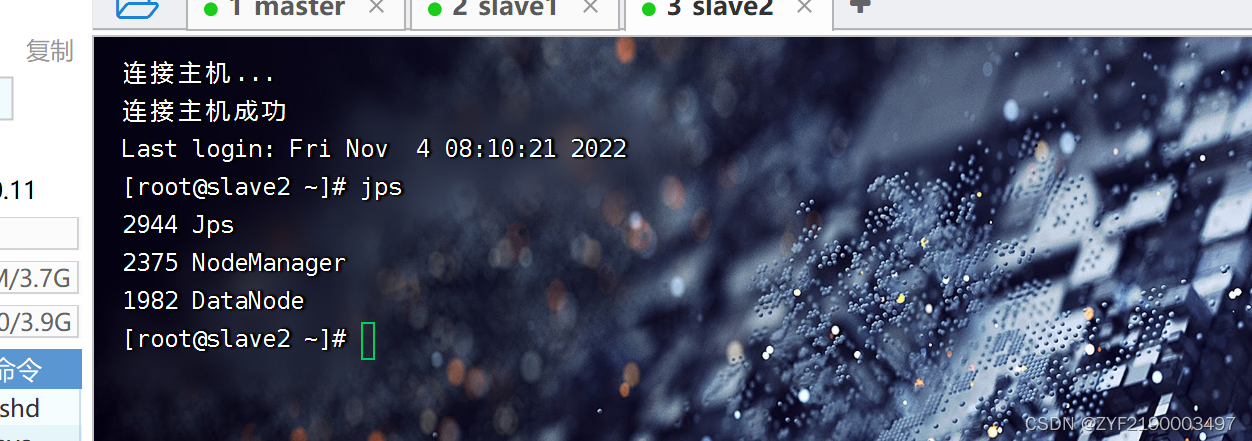

查看slave2的进程节点

启动yarn服务

-

执行命令:

start-yarn.sh

查看hadoop服务进程总体状况

2、主节点上停止Hadoop集群

- 在master虚拟机上执行命令:

stop-all.sh(相当于同时执行了stop-dfs.sh与stop-yarn.sh)

本文详细介绍了如何配置Hadoop集群,包括在master虚拟机上下载和安装JDK,配置环境变量,并分发到slave1和slave2虚拟机。接着,下载Hadoop压缩包,配置Hadoop环境变量,验证安装,格式化文件系统,最后启动和关闭Hadoop集群。

本文详细介绍了如何配置Hadoop集群,包括在master虚拟机上下载和安装JDK,配置环境变量,并分发到slave1和slave2虚拟机。接着,下载Hadoop压缩包,配置Hadoop环境变量,验证安装,格式化文件系统,最后启动和关闭Hadoop集群。

1318

1318

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?