FastDFS简介

FastDFS是一个开源的轻量级分布式文件系统,它对文件进行管理,功能包括:文件存储、文件同步、文件访问(文件上传、文件下载)等,

解决了大容量存储和负载均衡的问题。特别适合以文件为载体的在线服务,如相册网站、视频网站等等。

FastDFS为互联网量身定制,充分考虑了冗余备份、负载均衡、线性扩容等机制,并注重高可用、高性能等指标,

使用FastDFS很容易搭建一套高性能的文件服务器集群提供文件上传、下载等服务。

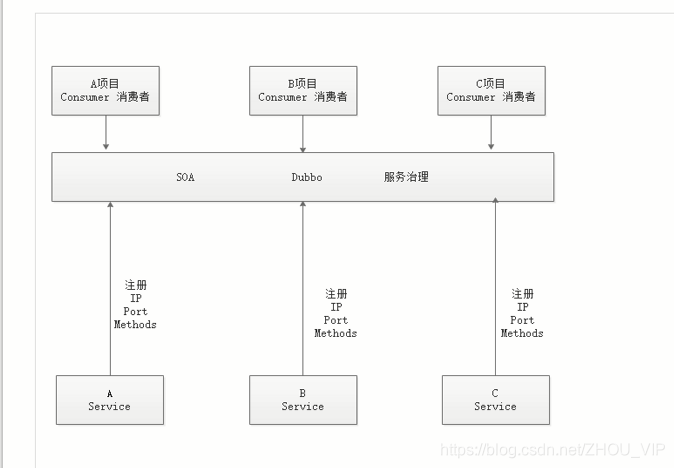

Dubbo工作流程:服务治理,在微服务方面占很小,充其量算服务治理,不能称之为微服务

注册什么,把服务的IP、端口号、方法名注册到Dubbo

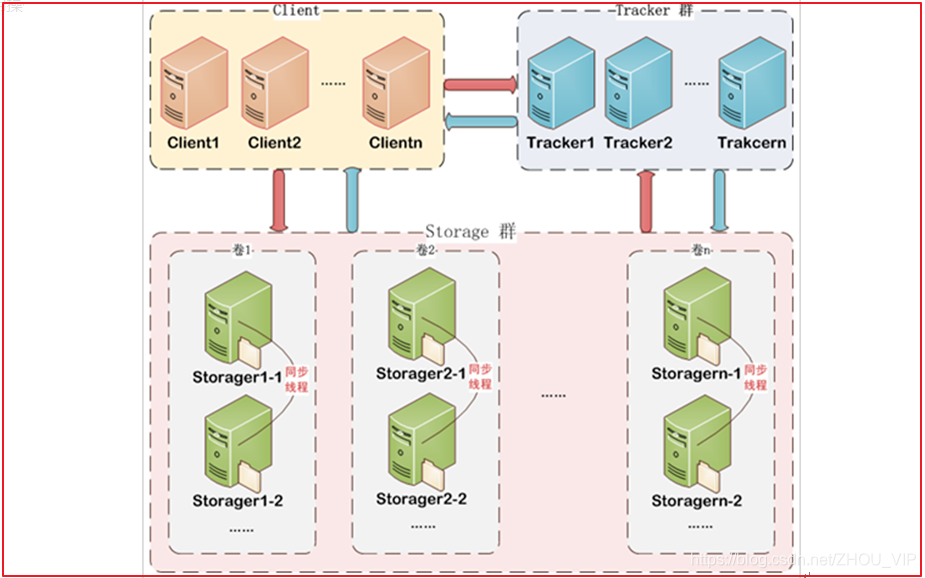

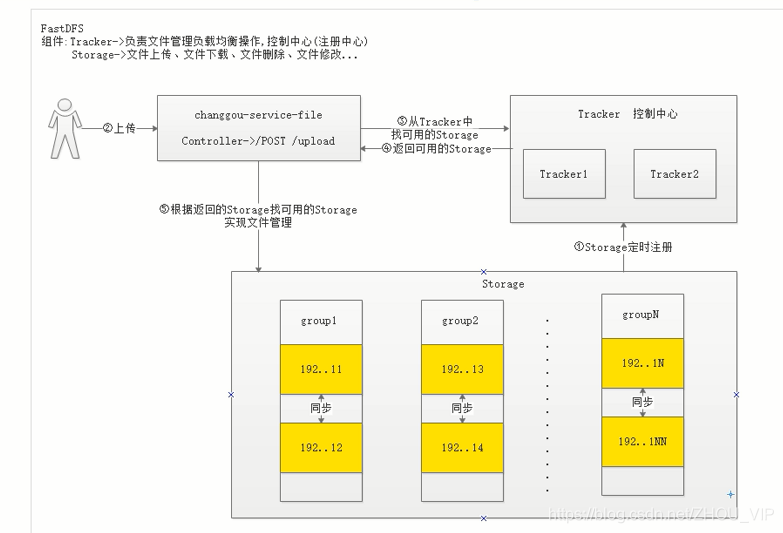

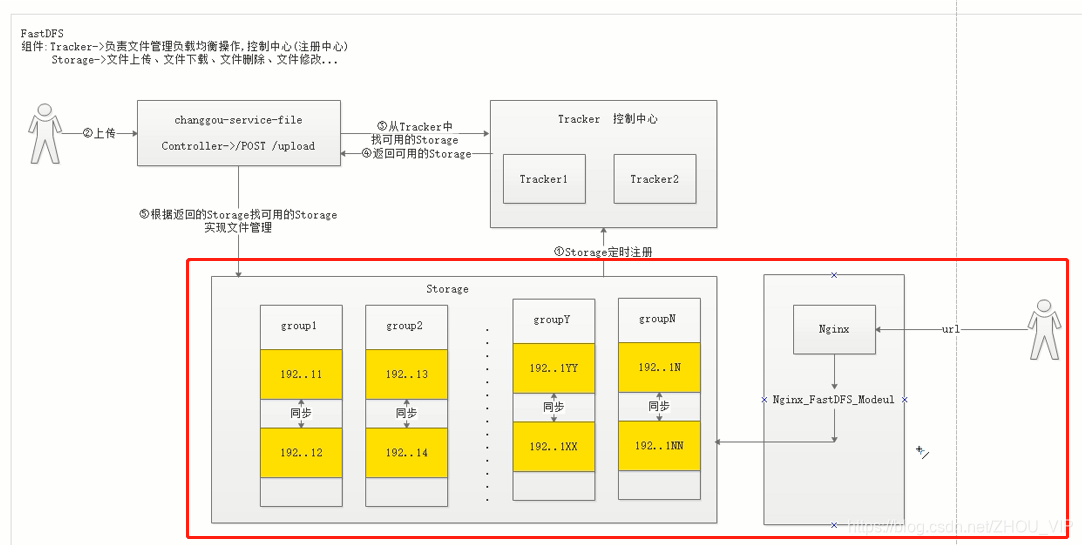

FastDFS体系结构

FastDFS 架构包括 Tracker server 和 Storage server。客户端请求 Tracker server 进行文件上传、下载,通过Tracker server 调度最终由 Storage server 完成文件上传和下载。

Tracker server 作用是负载均衡和调度,通过 Tracker server 在文件上传时可以根据一些策略找到Storage server 提供文件上传服务。可以将 tracker 称为追踪服务器或调度服务器。

Storage server 作用是文件存储,客户端上传的文件最终存储在 Storage 服务器上,Storageserver 没有实现自己的文件系统而是利用操作系统的文件系统来管理文件。可以将storage称为存储服务器。

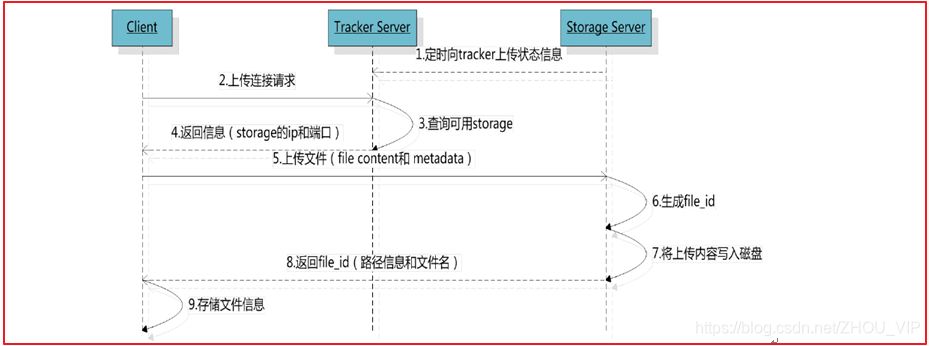

上传流程

客户端上传文件后存储服务器将文件 ID 返回给客户端,此文件 ID 用于以后访问该文件的索引信息。文件索引信息包括:组名,虚拟磁盘路径,数据两级目录,文件名。

![]()

组名:文件上传后所在的 storage 组名称,在文件上传成功后有storage 服务器返回,需要客户端自行保存。

虚拟磁盘路径:storage 配置的虚拟路径,与磁盘选项store_path*对应。如果配置了store_path0 则是 M00,如果配置了 store_path1 则是 M01,以此类推。

数据两级目录:storage 服务器在每个虚拟磁盘路径下创建的两级目录,用于存储数据文件。

文件名:与文件上传时不同。是由存储服务器根据特定信息生成,文件名包含:源存储服务器 IP 地址、文件创建时间戳、文件大小、随机数和文件拓展名等信息。

FastDFS搭建

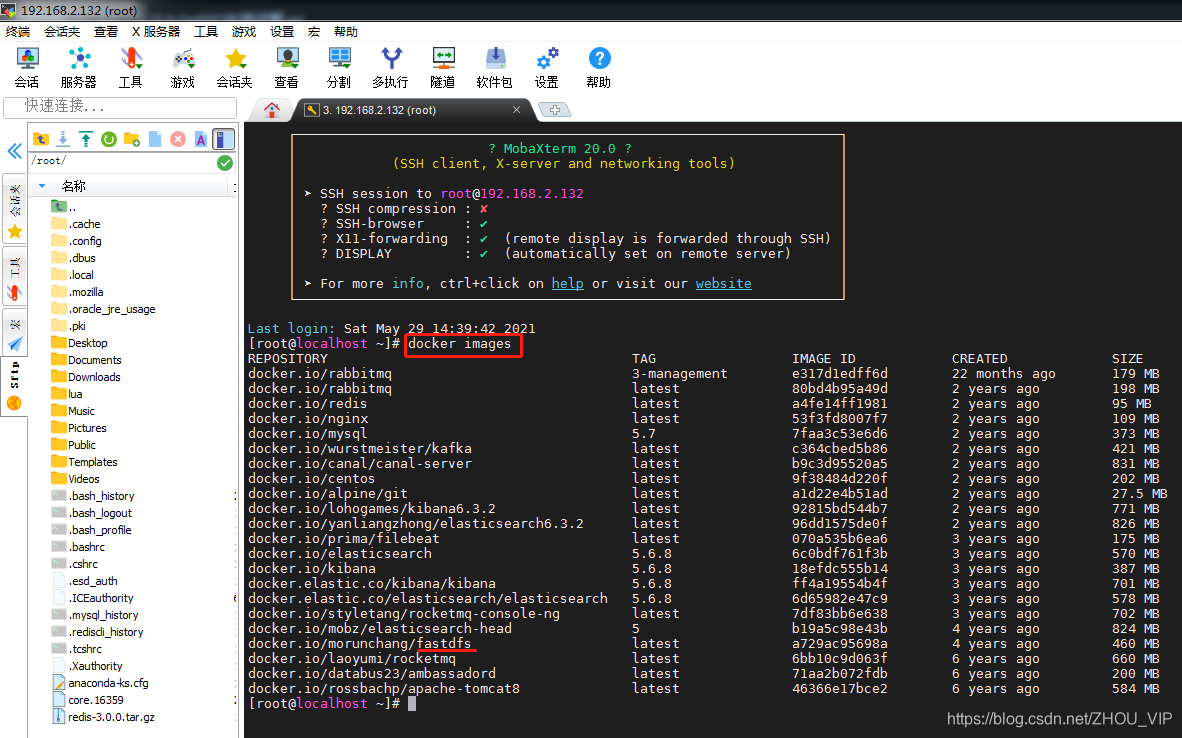

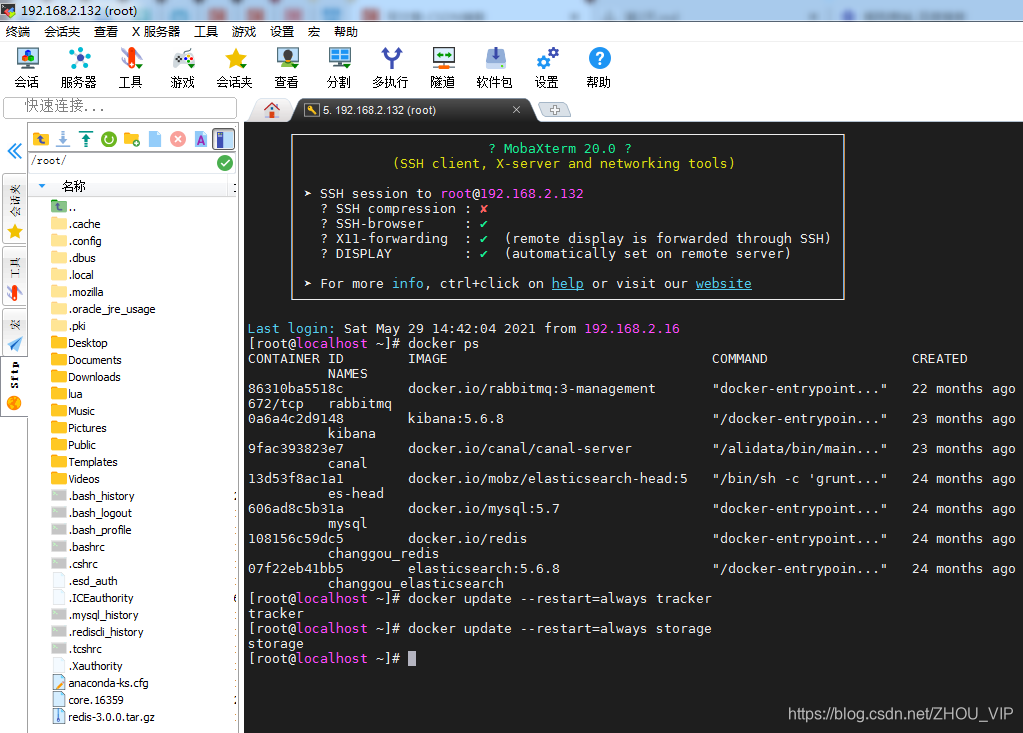

我们使用Docker搭建FastDFS的开发环境,虚拟机中已经下载了fastdfs的镜像,可以通过docker images查看,如下图:

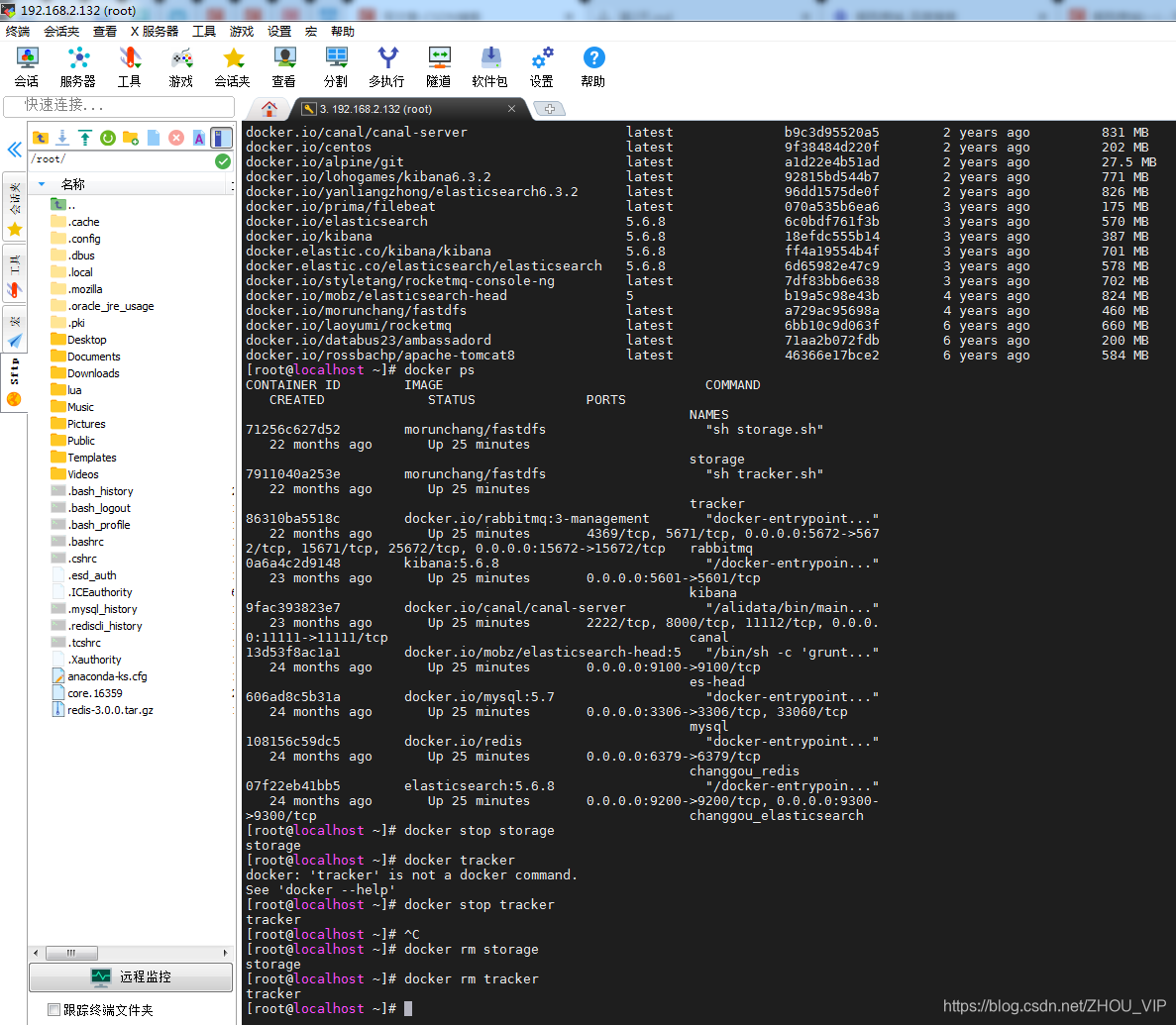

如果需要重新安装的,先停掉,移除,然后重新安装

//停掉

docker stop storage

docker stop tracker

//移除

docker rm storage

docker rm tracker

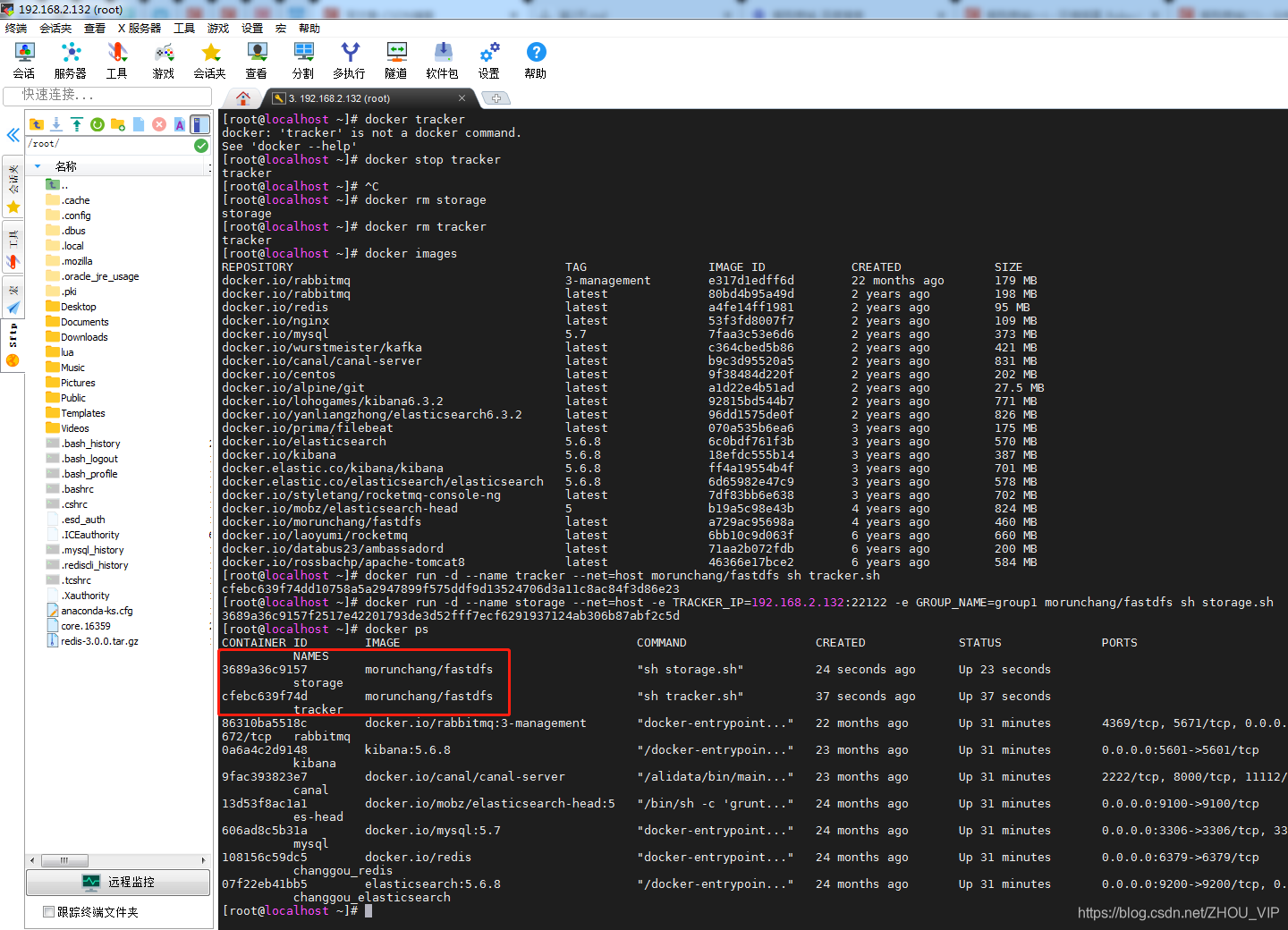

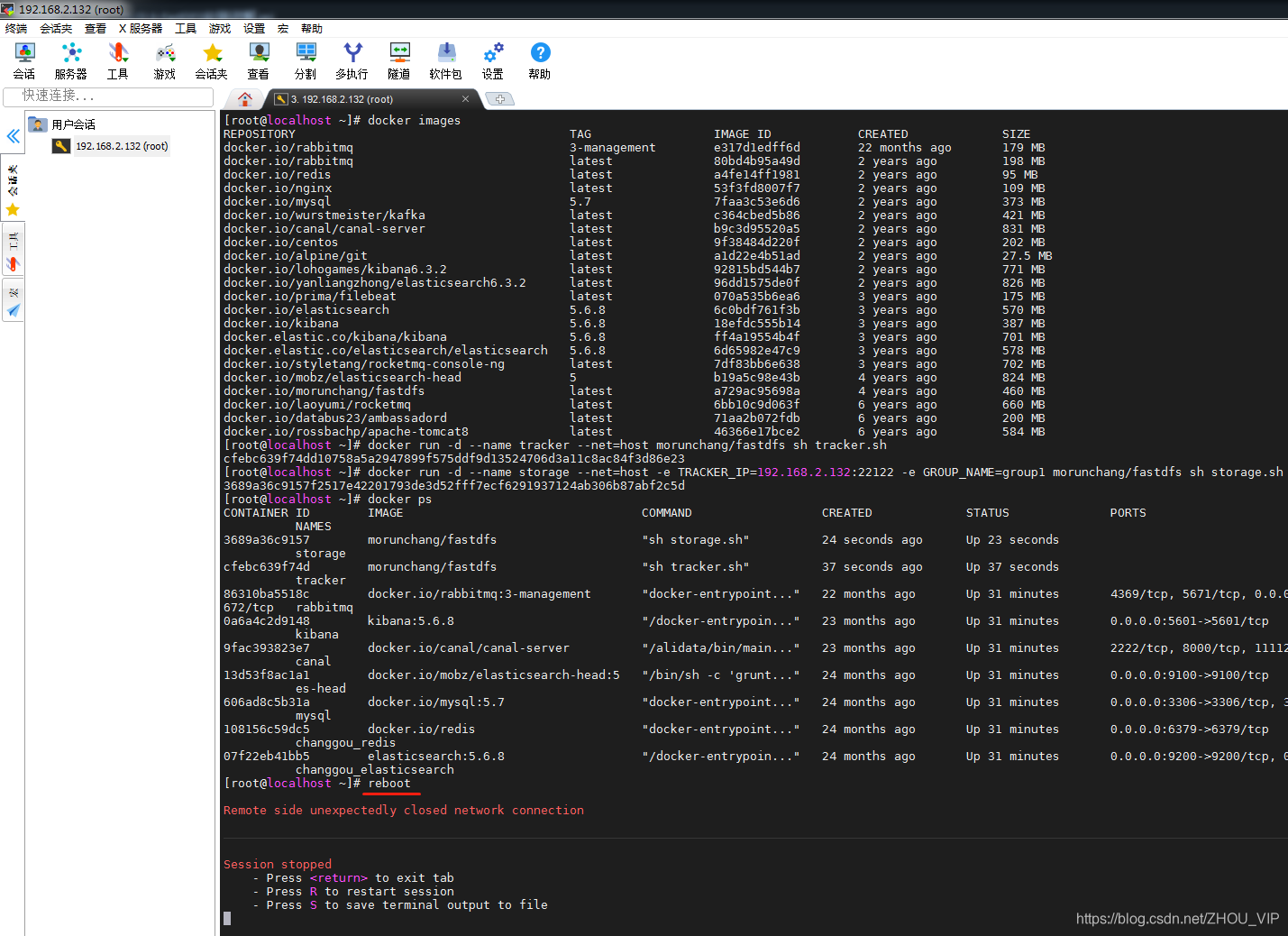

安装tracker

docker run -d --name tracker --net=host morunchang/fastdfs sh tracker.sh安装storage

docker run -d --name storage --net=host -e TRACKER_IP=192.168.2.132:22122 -e GROUP_NAME=group1 morunchang/fastdfs sh storage.sh- 使用的网络模式是–net=host, 192.168.2.132是宿主机的IP

- group1是组名,即storage的组

- 如果想要增加新的storage服务器,再次运行该命令,注意更换 新组名

重启虚拟机:reboot

设置开机启动:

docker update --restart=always tracker

docker update --restart=always storage

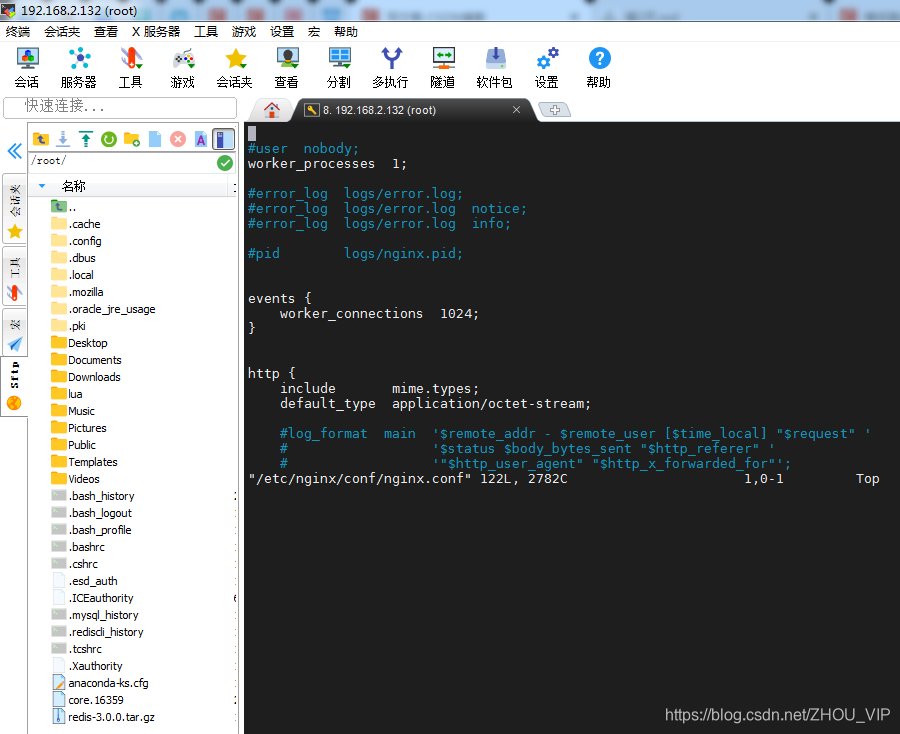

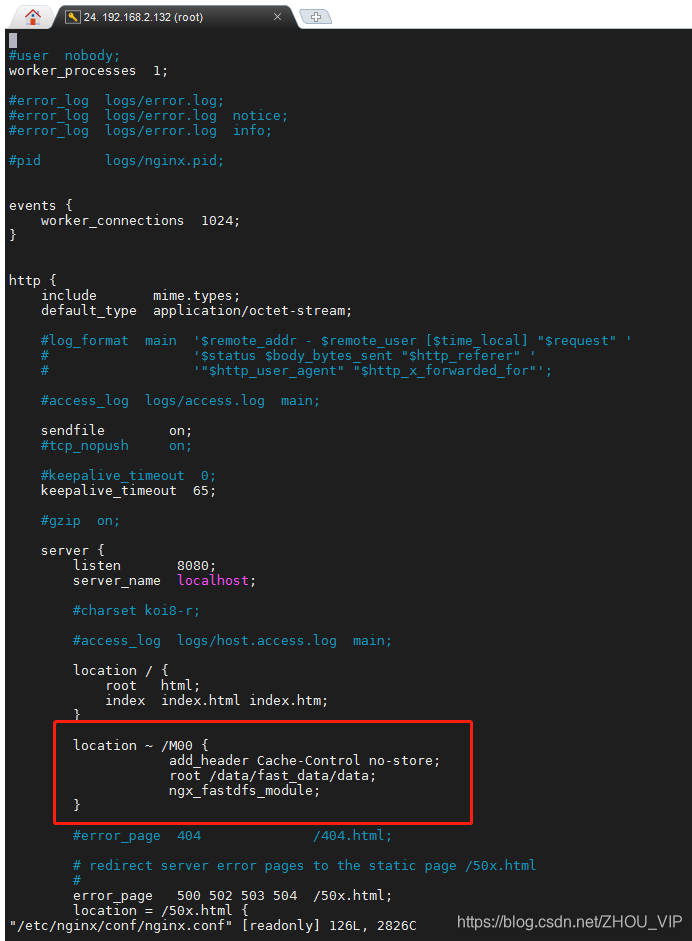

配置Nginx

Nginx在这里主要提供对FastDFS图片访问的支持,Docker容器中已经集成了Nginx,我们需要修改nginx的配置,进入storage的容器内部,修改nginx.conf

docker exec -it storage /bin/bash进入后

vi /etc/nginx/conf/nginx.conf

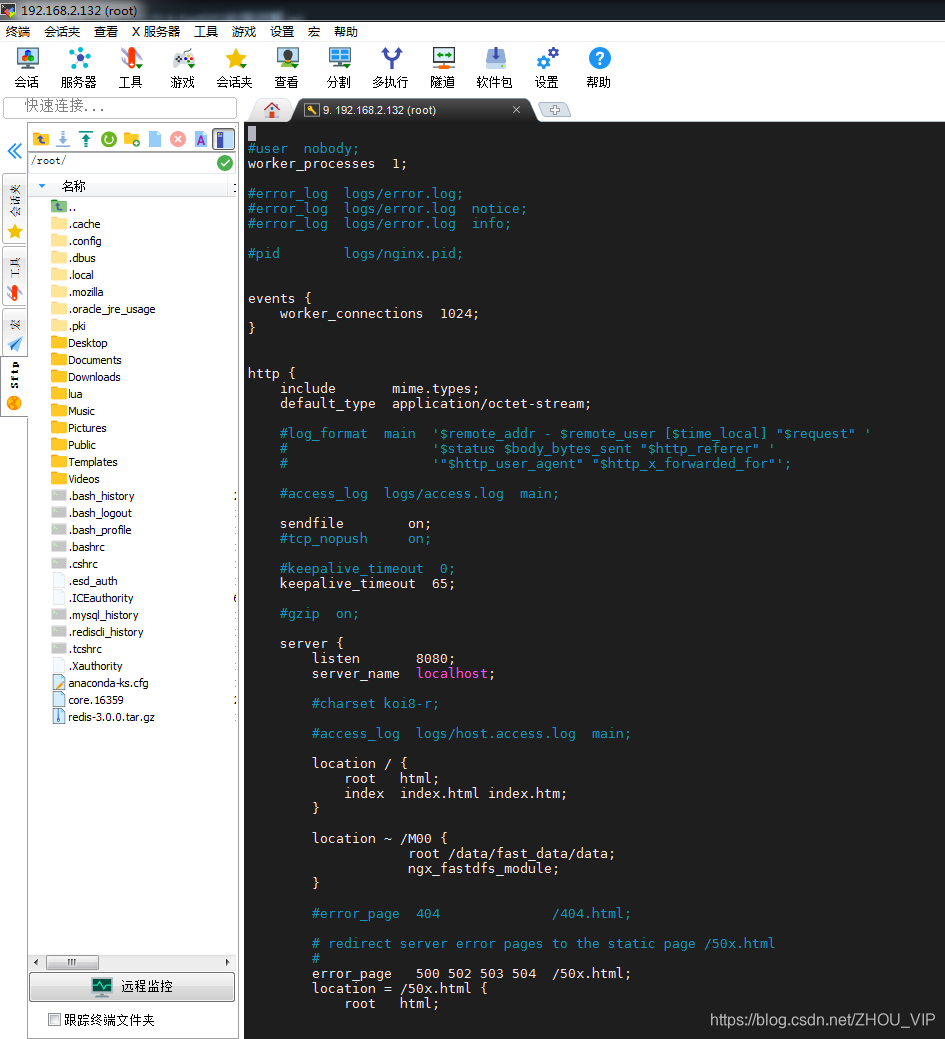

添加以下内容:

location ~ /M00 {

root /data/fast_data/data;

ngx_fastdfs_module;

}一定要记得保存,按Esc——>Shift+冒号——>wq——Enter退出

重新连接会话,查看

docker exec -it storage /bin/bash

vi /etc/nginx/conf/nginx.conf

配置文件:

Last login: Sun May 30 00:07:16 2021 from 192.168.2.16

[root@localhost ~]# docker exec -it storage /bin/bash

root@localhost:/# vi /etc/nginx/conf/nginx.conf

#user nobody;

worker_processes 1;

#error_log logs/error.log;

#error_log logs/error.log notice;

#error_log logs/error.log info;

#pid logs/nginx.pid;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

#log_format main '$remote_addr - $remote_user [$time_local] "$request" '

# '$status $body_bytes_sent "$http_referer" '

# '"$http_user_agent" "$http_x_forwarded_for"';

#access_log logs/access.log main;

sendfile on;

#tcp_nopush on;

#keepalive_timeout 0;

keepalive_timeout 65;

#gzip on;

server {

listen 8080;

server_name localhost;

#charset koi8-r;

#access_log logs/host.access.log main;

location / {

root html;

index index.html index.htm;

}

location ~ /M00 {

root /data/fast_data/data;

ngx_fastdfs_module;

}

#error_page 404 /404.html;

# redirect server error pages to the static page /51x.html

#

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

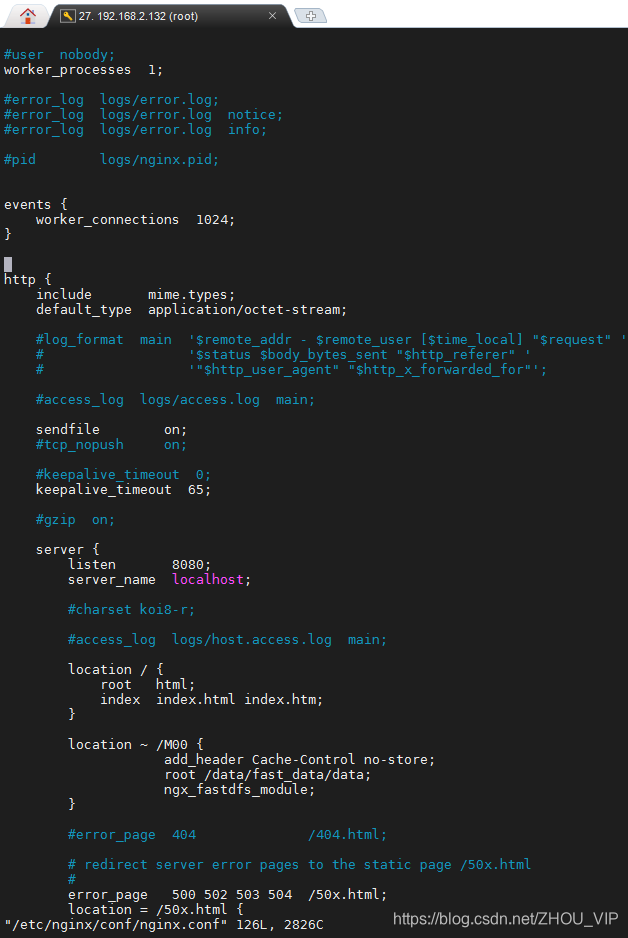

可以看到配置已存在:

location ~ /M00 {

root /data/fast_data/data;

ngx_fastdfs_module;

}增加浏览器禁止缓存:

add_header Cache-Control no-store;修改好了按Esc——>Shift+冒号——>wq——Enter退出,报错E45: 'readonly' option is set (add ! to override)

其实这是权限造成的,文件设置成了只读权限,众所周知,只读文件修改前需要执行sudo,但是已经修改了,如何强制保存呢?技术宅告诉你!只需要保存的时候执行如下命令:

:wq!以上命令是强制保存退出,按Esc——>Shift+冒号——>wq!

增加成功:

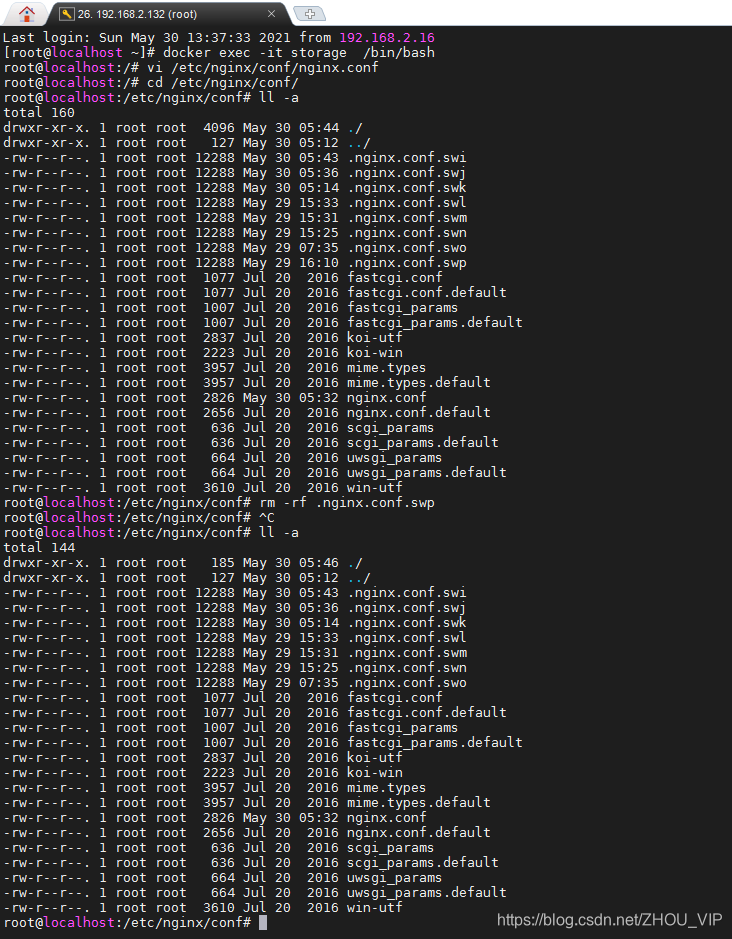

开发过程中修改后没有保存就退出了,会报:Swap file "/etc/nginx/conf/.nginx.conf.swp" already exists!

原因:

1.此时该文件已经被打开,在这种情况下可以使用只读方式打开;

2.就是由于swp文件存在,可能是由于上次编辑的时候崩溃造成的

解决方法:

1.通过ls -a查看全部隐藏文件

2.查看当前目录下与打开的文件同名的.swp文件,如.FILENAME.conf.swp显示为.nginx.conf.swp

3.使用rm -rf删除这个.swp文件,当再打开.nginx.conf.swp文件时,便不会弹出警告信息。

我用的ll -a

列出文件的详细信息。 相当于ls -al

exit命令退出,

然后重新输入,ok,不会报错了

docker exec -it storage /bin/bashvi /etc/nginx/conf/nginx.conf

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

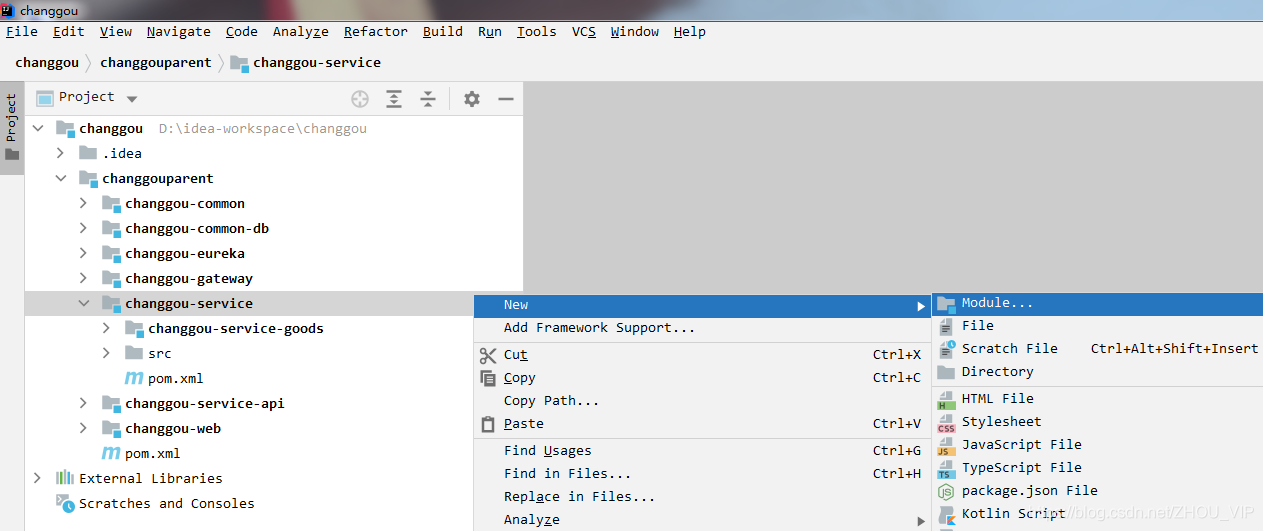

文件存储微服务

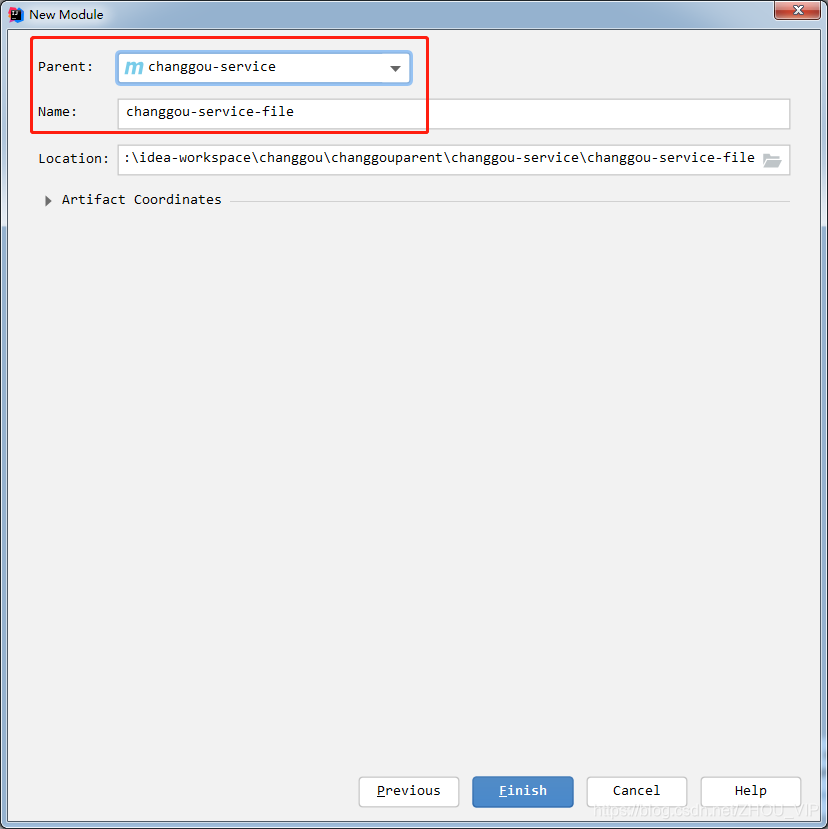

创建文件管理微服务changgou-service-file,该工程主要用于实现文件上传以及文件删除等功能。

修改pom.xml,引入依赖

<!--依赖包-->

<dependencies>

<dependency>

<groupId>net.oschina.zcx7878</groupId>

<artifactId>fastdfs-client-java</artifactId>

<version>1.27.0.0</version>

</dependency>

<dependency>

<groupId>com.changgou</groupId>

<artifactId>changgou-common</artifactId>

<version>1.0-SNAPSHOT</version>

</dependency>

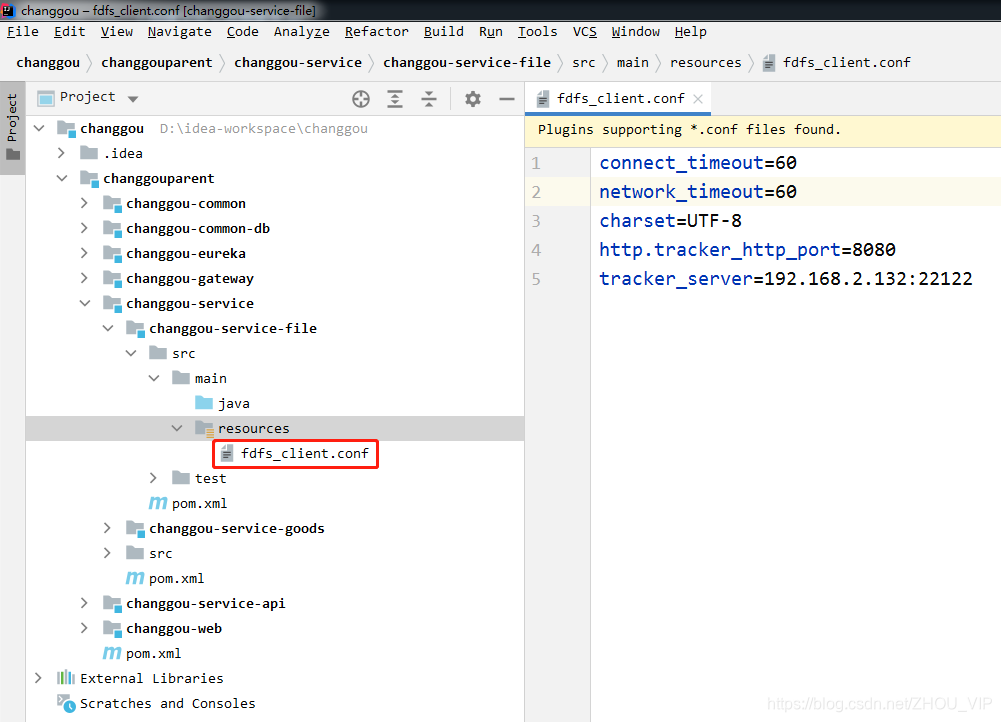

</dependencies>在resources文件夹下创建fasfDFS的配置文件fdfs_client.conf

connect_timeout:连接超时时间,单位为秒。

network_timeout:通信超时时间,单位为秒。发送或接收数据时。假设在超时时间后还不能发送或接收数据,则本次网络通信失败

charset: 字符集

http.tracker_http_port :.tracker的http端口

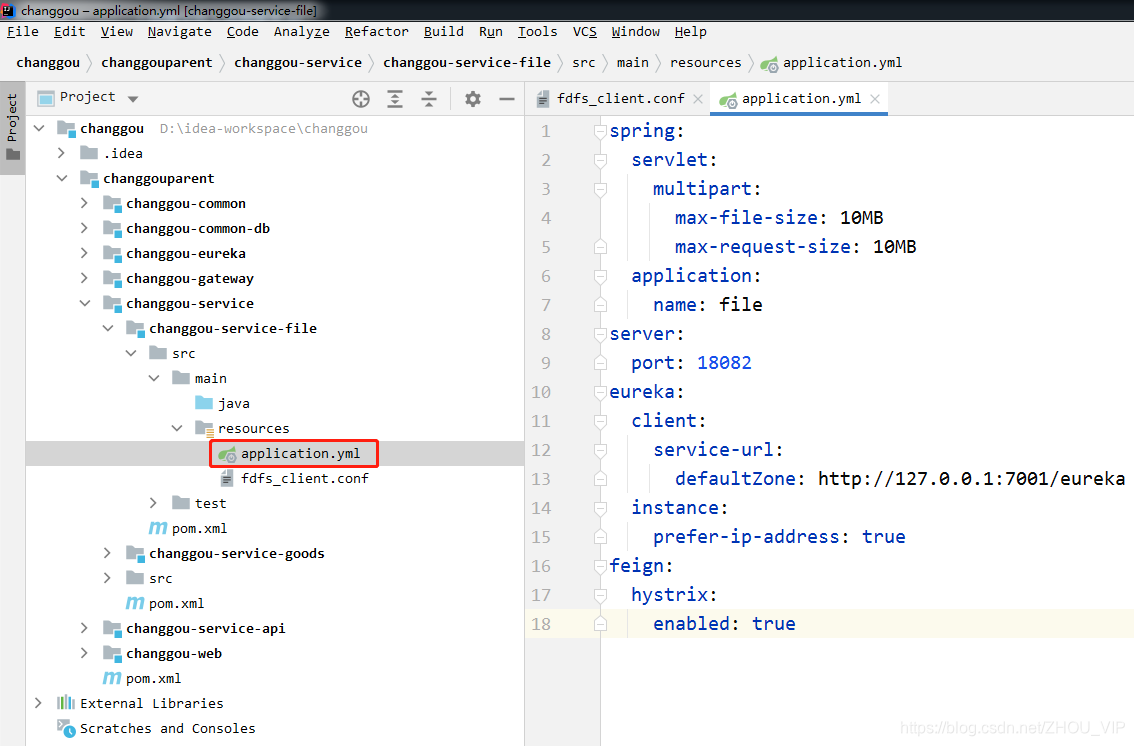

tracker_server: tracker服务器IP和端口设置在resources文件夹下创建application.yml

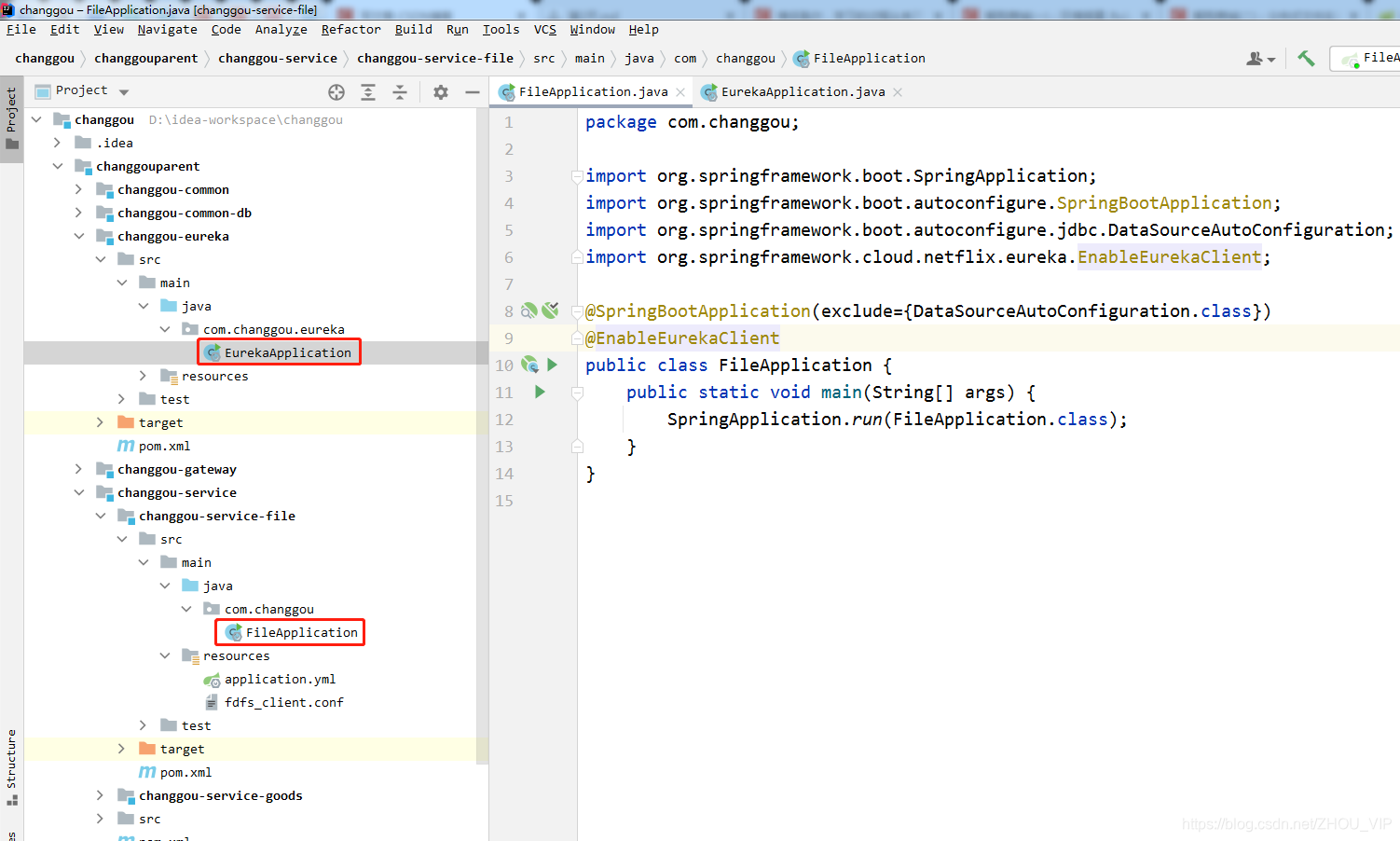

max-file-size是单个文件大小,max-request-size是设置总上传的数据大小创建com.changgou包,创建启动类FileApplication

package com.changgou;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.autoconfigure.jdbc.DataSourceAutoConfiguration;

import org.springframework.cloud.netflix.eureka.EnableEurekaClient;

@SpringBootApplication(exclude={DataSourceAutoConfiguration.class})

@EnableEurekaClient

public class FileApplication {

public static void main(String[] args) {

SpringApplication.run(FileApplication.class);

}

}

这里有个地方需要强调一下,就是(exclude = {DataSourceAutoConfiguration.class}),它的作用是取消数据源自动导入。

SpringBoot会自动从配置文件中查找spring.datasource.相关属性并自动配置单数据源。因为在这个微服务工程并没有配置数据库的相关属性,所以不加exclude的话就会报错。

Description:

Failed to configure a DataSource: 'url' attribute is not specified and no embedded datasource could be configured.

Reason: Failed to determine a suitable driver class

Action:

Consider the following:

If you want an embedded database (H2, HSQL or Derby), please put it on the classpath.

If you have database settings to be loaded from a particular profile you may need to activate it (no profiles are currently active).

测试:

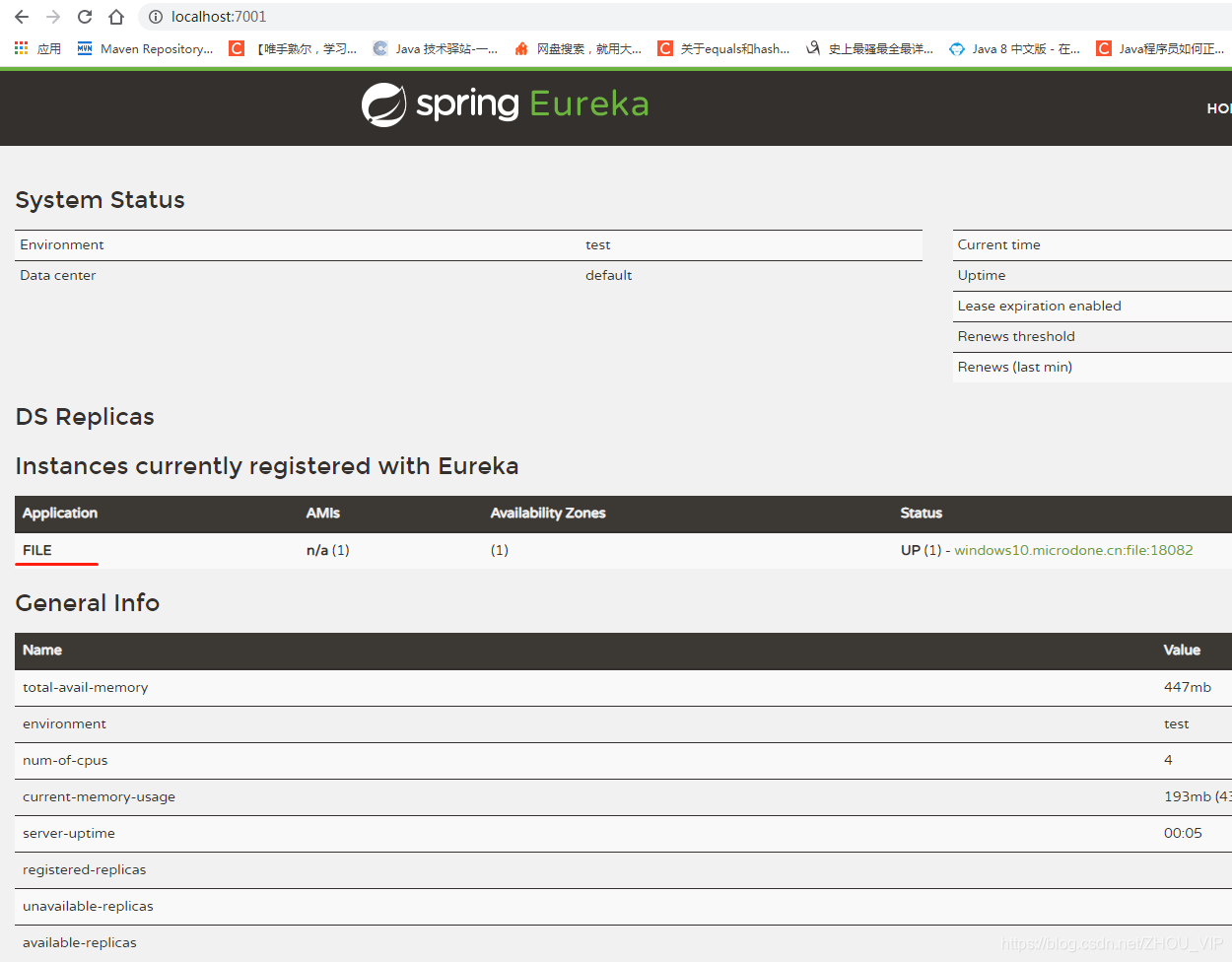

先启动EurekaApplication,再启动FileApplication,浏览器访问:http://localhost:7001/,结果ok,已经注册进去了

文件上传

文件上传一般都有文件的名字、文件的内容、文件的扩展名、文件的md5值、文件的作者等相关属性,我们可以创建一个对象封装这些属性,代码如下:

创建com.changgou.file.FastDFSFile代码如下:

package com.changgou.file;

import java.io.Serializable;

public class FastDFSFile implements Serializable {

//文件名字

private String name;

//文件内容

private byte[] content;

//文件扩展名

private String ext;

//文件MD5摘要值

private String md5;

//文件创建作者

private String author;

public FastDFSFile() {

}

public FastDFSFile(String name, byte[] content, String ext) {

this.name = name;

this.content = content;

this.ext = ext;

}

public FastDFSFile(String name, byte[] content, String ext, String md5, String author) {

this.name = name;

this.content = content;

this.ext = ext;

this.md5 = md5;

this.author = author;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public byte[] getContent() {

return content;

}

public void setContent(byte[] content) {

this.content = content;

}

public String getExt() {

return ext;

}

public void setExt(String ext) {

this.ext = ext;

}

public String getMd5() {

return md5;

}

public void setMd5(String md5) {

this.md5 = md5;

}

public String getAuthor() {

return author;

}

public void setAuthor(String author) {

this.author = author;

}

}

FastDFSUtil

package com.changgou.util;

import com.changgou.file.FastDFSFile;

import org.csource.common.NameValuePair;

import org.csource.fastdfs.*;

import org.springframework.core.io.ClassPathResource;

import java.io.ByteArrayInputStream;

import java.io.IOException;

import java.io.InputStream;

public class FastDFSUtil {

/***

* 初始化tracker信息

*/

static {

try {

//获取tracker的配置文件fdfs_client.conf的位置

String filePath = new ClassPathResource("fdfs_client.conf").getPath();

//加载tracker配置信息

ClientGlobal.init(filePath);

} catch (Exception e) {

e.printStackTrace();

}

}

/****

* 文件上传

* @param file : 要上传的文件信息封装->FastDFSFile

* @return String[]

* 1:文件上传所存储的组名

* 2:文件存储路径

*/

public static String[] upload(FastDFSFile file){

//获取文件作者

NameValuePair[] meta_list = new NameValuePair[1];

meta_list[0] =new NameValuePair(file.getAuthor());

/***

* 文件上传后的返回值

* uploadResults[0]:文件上传所存储的组名,例如:group1

* uploadResults[1]:文件存储路径,例如:M00/00/00/wKjThF0DBzaAP23MAAXz2mMp9oM26.jpeg

*/

String[] uploadResults = null;

try {

//创建TrackerClient客户端对象

TrackerClient trackerClient = new TrackerClient();

//通过TrackerClient对象获取TrackerServer信息

TrackerServer trackerServer = trackerClient.getConnection();

//获取StorageClient对象

StorageClient storageClient = new StorageClient(trackerServer, null);

//执行文件上传

uploadResults = storageClient.upload_file(file.getContent(), file.getExt(), meta_list);

} catch (Exception e) {

e.printStackTrace();

本文介绍了FastDFS分布式文件系统,包括其架构、上传流程和Docker部署。FastDFS是一个轻量级的开源文件系统,用于文件存储、同步和访问。它包括Tracker Server和Storage Server,Tracker负责调度,Storage负责文件存储。文章还展示了FastDFS的配置、文件上传和下载流程,以及如何在Spring Boot应用中集成FastDFS。

本文介绍了FastDFS分布式文件系统,包括其架构、上传流程和Docker部署。FastDFS是一个轻量级的开源文件系统,用于文件存储、同步和访问。它包括Tracker Server和Storage Server,Tracker负责调度,Storage负责文件存储。文章还展示了FastDFS的配置、文件上传和下载流程,以及如何在Spring Boot应用中集成FastDFS。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4417

4417

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?