文章探讨了大模型训练的两大扩展定律:预训练"更大"和后训练"思考更久"。尽管过去一年强化学习备受关注,但预训练并未消亡,反而将在2026年迎来复兴。作者强调,评估AI不应仅看推理步骤数量,更应关注单次前向传播质量(潜在推理能力)。预训练仍是进步核心驱动力,这将影响数据中心扩建和AI硬件发展方向,对投资者和开发者都有重要启示。

1、两条 AI 扩展定律

我们现在都知道,要让 AI 变得更好主要有两种路径:“更大”(bigger)与“思考更久”(thinking for longer)。但要理解二者,我们先需简要地回顾 ChatGPT 类模型的构建原理。

“世事变迁愈烈,本质却愈恒常。”

从外部看,AI 行业生机勃勃、喧嚣纷呈:技术突破、炒作浪潮、迅猛迭代,堪称人类史上最具活力的产业。

但事实上,当前 AI 模型与近十年前的模型惊人地相似。早年发现的基本原理不仅依然有效,更仍是当今进步的支柱。算法层面的实质性改进,多年以来几乎停滞不前。

因此,当前最前沿的模型仍高度趋同,决定谁领先的关键变量,主要仍是训练数据规模与算力。

归根结底,一切都取决于算力,不仅在于你拥有多少,更关键的是你如何高效地使用它。

第一条扩展定律:预训练“更大”

第一条扩展定律围绕模仿学习(imitation learning)展开:向模型喂入海量数据,要求其模仿。

通过机械式重复,模型从中提炼数据底层规律。这是一种归纳式过程:当模型反复看到“I”后接“am”,下次再遇到“I”,就更可能预测出“am”。

如何优化这一方法?是扩大训练预算,具体体现为:

- 扩大数据集规模;

- 扩大模型参数规模。

但这些数据究竟有多大?其规模近乎难以想象。Transformer 的训练预算(以 FLOPs——浮点运算次数衡量)可近似用公式 6 × D × N 计算。

6 代表一次前向传播(2×FLOPs)与一次反向传播(4×FLOPs)。D 为训练词元(token)总数,N 是模型参数量。

对当前主流的 MOE 模型,“N”实为“A”即激活参数量,暂不深究。如今的前沿预训练预算已达约 10²⁷ FLOPs 即 100 亿亿亿次浮点运算(1 octillion FLOPs)。

依上述公式,假设模型参数为 5 万亿(实际尚不及最前沿水平),则对应训练数据量约为 3.33 × 10¹³ tokens。

按平均每词 0.75 词元估算,相当于 24 万亿单词的训练数据。而这仅是一次训练运行的规模;2025 年已出现多次同级甚至更大规模的训练!可见,“大数据”之“大”,名副其实。

过去十年间,我们曾笃信只需将此流程“卷”到极致,甚至一度认为:仅靠扩大模型规模,便能抵达通用人工智能(AGI)。

然而,当著名的 GPT-4.5 训练失败(原计划为 GPT-5)后,人们猛然醒悟:这不仅不是实现 AGI 的充分条件,技术实已陷入停滞。

随后,ChatGPT 之父 Ilya Sutskever 公开宣称:我们熟知的扩展定律已死。

第二条扩展定律:后训练“思考更久”

约两年前,正值预训练狂热高峰之际,包括 IIya 本人在内的 OpenAI 少数研究员提出一问:“如果我们给模型时间思考呢?”

逻辑很简单:人类面对复杂任务时,并非立即作答,而是先在脑内反复推演;我们常将问题拆解为更简单的步骤,这本质上是向任务投入更多‘思考’。

于是他们开始测试此构想。方法极其简单:基于一个已完成预训练的 LLM,用小型“冷启动”带思维链的数据,然后就可以向其提出中等难度问题,但不直接提供答案供模仿,而是让其通过试错自行推导。

这种试错训练法,即强化学习(RL),一项已有三十年历史、如今终被规模化应用的技术—,效果惊人,由此诞生了第二条扩展定律:当模型被赋予思考时间,其表现将大幅提升。

“推理模型”(reasoning models)应运而生,以 OpenAI 的 o1 为先驱。这种额外训练阶段称为“后训练”(post-training),因发生在预训练之后。

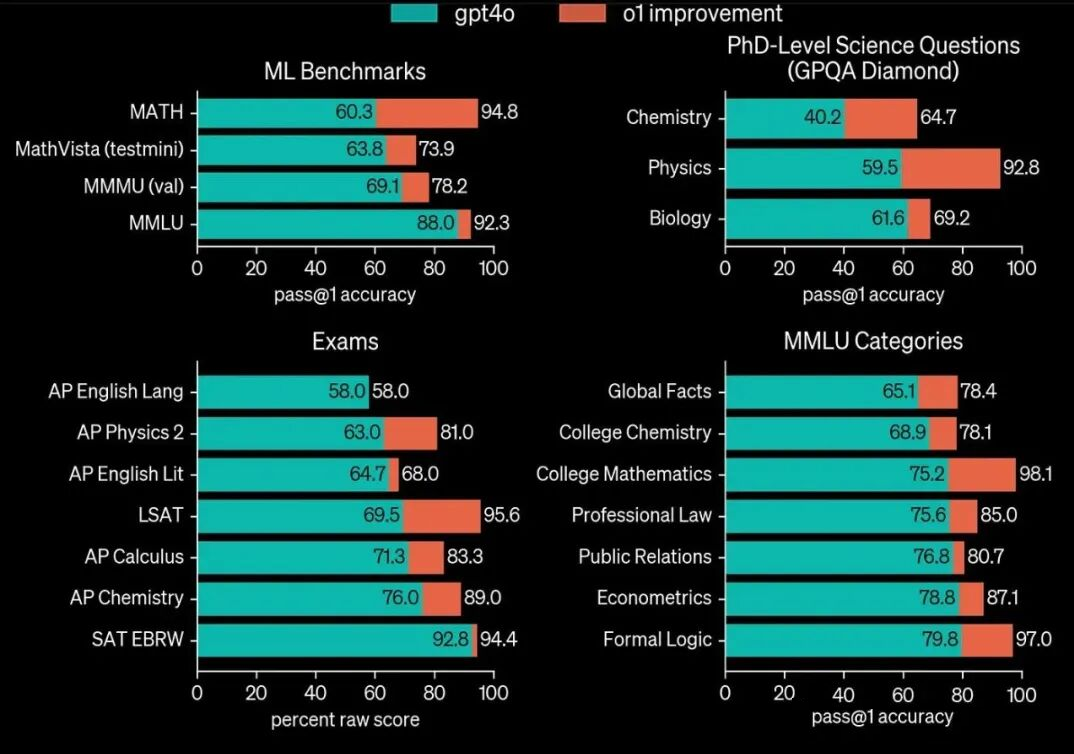

它使 GPT-4o 蜕变为 o1,在所有“思考时间越长表现越好”的基准测试中全面跃升。

如今,我们还有“中期训练”(mid-training)即预训练与后训练间的补充训练。

虽概念略显拗口,却支持灵活操作,如 DeepSeek v3.2 在不重训的前提下改良注意力机制。

更关键在于:此扩展定律不仅能提升“聪明模型”的智商,还可让小模型凭借 inference-time compute 媲美大模型。过去一年间,扩大后训练算力成了各家 AI 实验室的执念。

2、潜在推理(Latent Reasoning)的重要性

评判智能,无论对象是模型还是人类,我们既可以看结果(“观其行”),也可以看过程(“察其思”)。

多数人倾向前者,但我坚信后者更优。原因如下:前者可概括为著名“鸭子测试”(duck test):“若其行如鸭、鸣如鸭,则必为鸭。”

我反对的是:聪明结果等于智能本身,我们应关注过程。评估智能,主要是看如何抵达结论,无论结论是否正确。

因为模型看似智能,实则多为复述记忆数据。你能死记硬背一道极难的物理学博士考题答案,但这绝不意味着你具备博士级物理智慧。更何况有大量证据表明:记忆仍在模型能力中扮演重要角色。

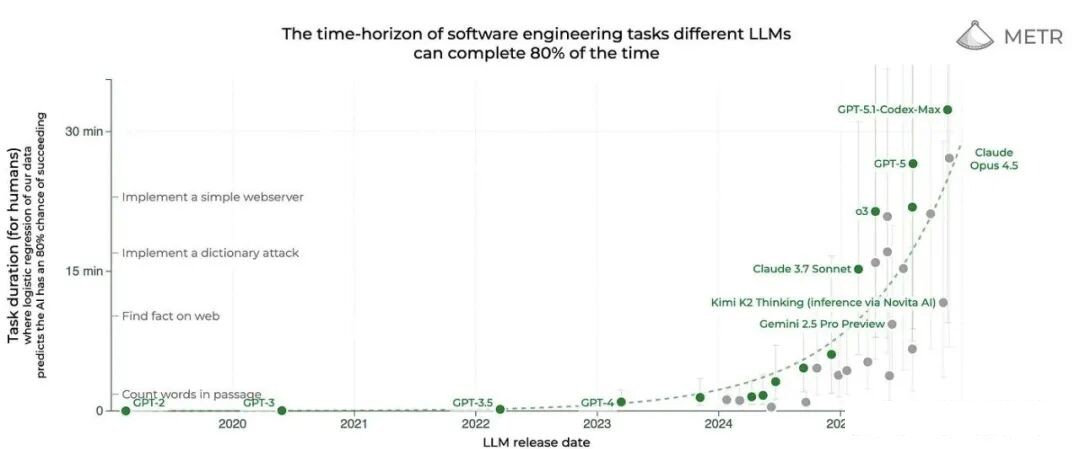

评估 AI 能解决的最复杂问题时,我们常将算力调至极限,观察其能力边界。赋予模型充裕推理算力,测试其上限。METR 基准即典型:衡量 AI 在 80% 情况下能完成的最长软件工程任务。

但此类基准设计允许模型自由生成 token,意味着结果未必具商业可行性。这里我们实质在问:“如果忽略成本,模型能力极限何在?”,因为单次任务可能涉及数十万乃至数百万次 token 消耗。

这确实是衡量推理算力进步的绝佳方式。但过度聚焦于此,会使人忽视基座模型本身也需要提升。

我们应观察单次预测质量的净提升。因这点差异,可能导致一模型需比另一模型多耗 100 倍算力(生成更多词元),仅因其单次预测质量更低,被迫靠堆砌推理步数抵达答案。

3、单次前向传播(Single Forward Pass)

我们真正想评估的,是单次前向传播(forward pass)的质量:即模型仅凭当前输入,预测下一个 token 的能力。

这样我们就能回答:LLM 凭借单次预测,在无“外显推理”时,能力边界何在?这里的思考是这样的:人类被要求即兴作答时,成败取决于是否“知道答案”。

而对AI而言,“外显推理”本就是记忆序列的一部分,强制其跳过外显推理,便切断其连接问题与答案的关键环节,记忆在此失效。

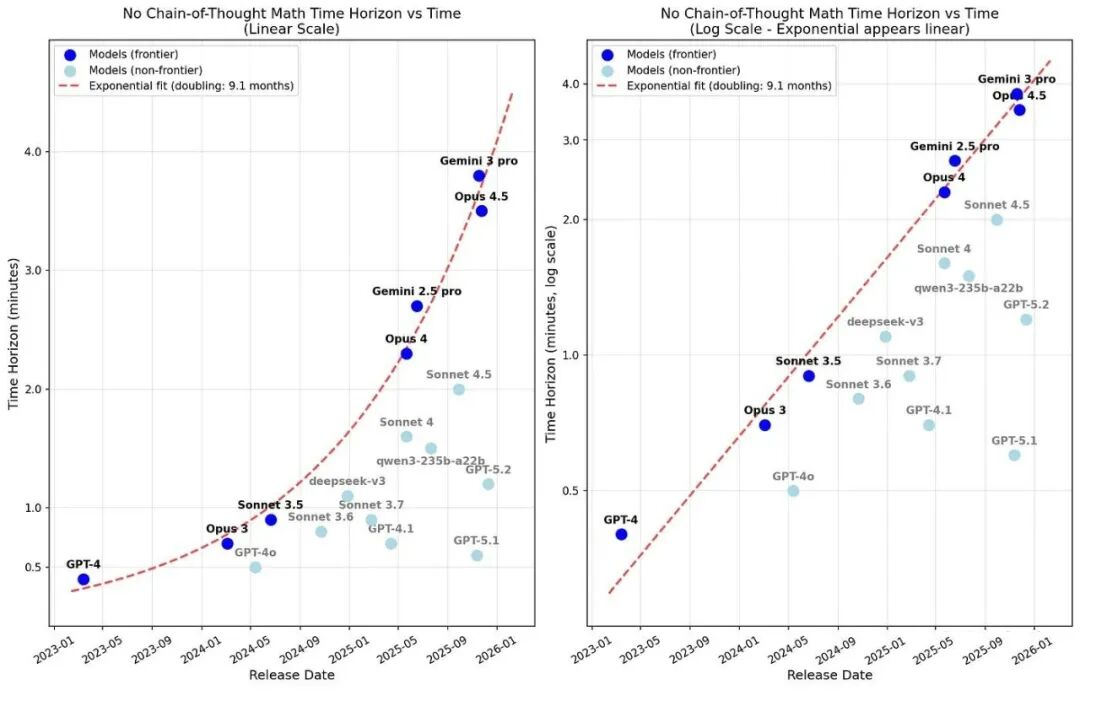

如果模型在无推理轨迹时仍能解决需推理的问题,这便是评估其潜在推理能力(latent reasoning)即内在、非外显的推理智能的绝佳指标。那么,模型在此项测试中表现如何?

好消息是预训练层面仍有进展。通俗地说,模型的“单次预测智能”正在提升,即每预测一次,就更聪明一分。

其中尤以 Gemini 与 Claude 为甚:如下图(线性/对数尺度)所示,其代际间呈现清晰净提升。

反观 OpenAI,则已完全将进步押注于推理算力。其 GPT-4 到 GPT-5 代际间仅现中等性能提升,进步主要源于第二条扩展定律:单任务投入更多算力。

这也解释了我个人体验:ChatGPT 在非推理任务上表现极度糟糕,其非推理版 GPT-5.2 Instant 堪称对技术进步的侮辱,迫使我永远开启‘Thinking’开关,确保所有答复均经推理生成。

OpenAI 首席研究官 Mark Chen 已公开承认:过去一年其后训练投入“过头”,现已转回重拾“预训练”。

DeepMind 高管 Oriol Vinyals 更直言:预训练是 Gemini 3 Pro 惊艳表现的关键。

可见,预训练不仅尚在,并且正深刻影响普通用户的体验。2026 年,其研究关注度必将远超 2025 年“已死”论调。

4、而这对你我意味着什么?

推理决定服务器规模,训练决定数据中心规模。如果预训练仍是进步核心驱动力,则数据中心扩建压力必将重燃,且证据确凿。

原因在于预训练数据规模:如前所述,其体量已极庞大,且只会更大。这意味着训练需集成更多加速器(如 GPU)。

同时,随着训练预算增长,我们也将更倾向采用“专家稀疏化”(expert sparsity)。

此技术由 DeepSeek 推广,当前前沿模型已普遍采用细粒度专家混合(MoE)将模型“分割”为更小子模型,以降低单次预测运算量。

MoE 并非真将模型物理切分,而是划分 MLP 层(其占 FLOPs 大头),从而按激活专家数均摊算力需求。

鉴于 GPU 集群扩展难度极高,算法优化将成为容纳更大训练的必要手段。模型将依第一条扩展定律继续增大,但内部结构将趋向“精瘦”。

关键的问题来了,英伟达等硬件厂商是否过度押注“推理”?训练算力占比是否真会被推理完全吞噬?

它们已宣布下一代 GPU 平台 Rubin 将首推纯推理 GPU,Rubin CPX。如果这种趋势叠加“推理向边缘设备迁移”的压力,AI 硬件路线图恐怕会过度倾向于推理。

当前,“纵向扩展”(scaling-up,即单服务器内增配加速器)因其提升推理性能的主因是当前的主流,在重推理的RL训练中,试错需反复运行推理直至成功,所以同样关键。

但随着大规模非 RL 训练重获重视,“横向扩展”(scaling-out,增服务器数)与“跨域扩展”(scaling-across,数据中心互联)将再度成为进步关键,而纵向扩展重要性显著下降,这显然与硬件演进方向相悖。微妙差异对投资者意味深长。

小白/程序员如何系统学习大模型LLM?

作为在一线互联网企业深耕十余年的技术老兵,我经常收到小白和程序员朋友的提问:“零基础怎么入门大模型?”“自学没有方向怎么办?”“实战项目怎么找?”等问题。难以高效入门。

这里为了帮助大家少走弯路,我整理了一套全网最全最细的大模型零基础教程。涵盖入门思维导图、经典书籍手册、实战视频教程、项目源码等核心内容。免费分享给需要的朋友!

👇👇扫码免费领取全部内容👇👇

1、我们为什么要学大模型?

很多开发者会问:大模型值得花时间学吗?答案是肯定的——学大模型不是跟风追热点,而是抓住数字经济时代的核心机遇,其背后是明确的行业需求和实打实的个人优势:

第一,行业刚需驱动,并非突发热潮。大模型是AI规模化落地的核心引擎,互联网产品迭代、传统行业转型、新兴领域创新均离不开它,掌握大模型就是拿到高需求赛道入场券。

第二,人才缺口巨大,职业机会稀缺。2023年我国大模型人才缺口超百万,2025年预计达400万,具备相关能力的开发者岗位多、薪资高,是职场核心竞争力。

第三,技术赋能增效,提升个人价值。大模型可大幅提升开发效率,还能拓展职业边界,让开发者从“写代码”升级为“AI解决方案设计者”,对接更高价值业务。

对于开发者而言,现在入门大模型,不仅能搭上行业发展的快车,还能为自己的职业发展增添核心竞争力——无论是互联网大厂的AI相关岗位,还是传统行业的AI转型需求,都在争抢具备大模型技术能力的人才。

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

2、大模型入门到实战全套学习大礼包分享

最后再跟大家说几句:只要你是真心想系统学习AI大模型技术,这份我耗时许久精心整理的学习资料,愿意无偿分享给每一位志同道合的朋友。

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

部分资料展示

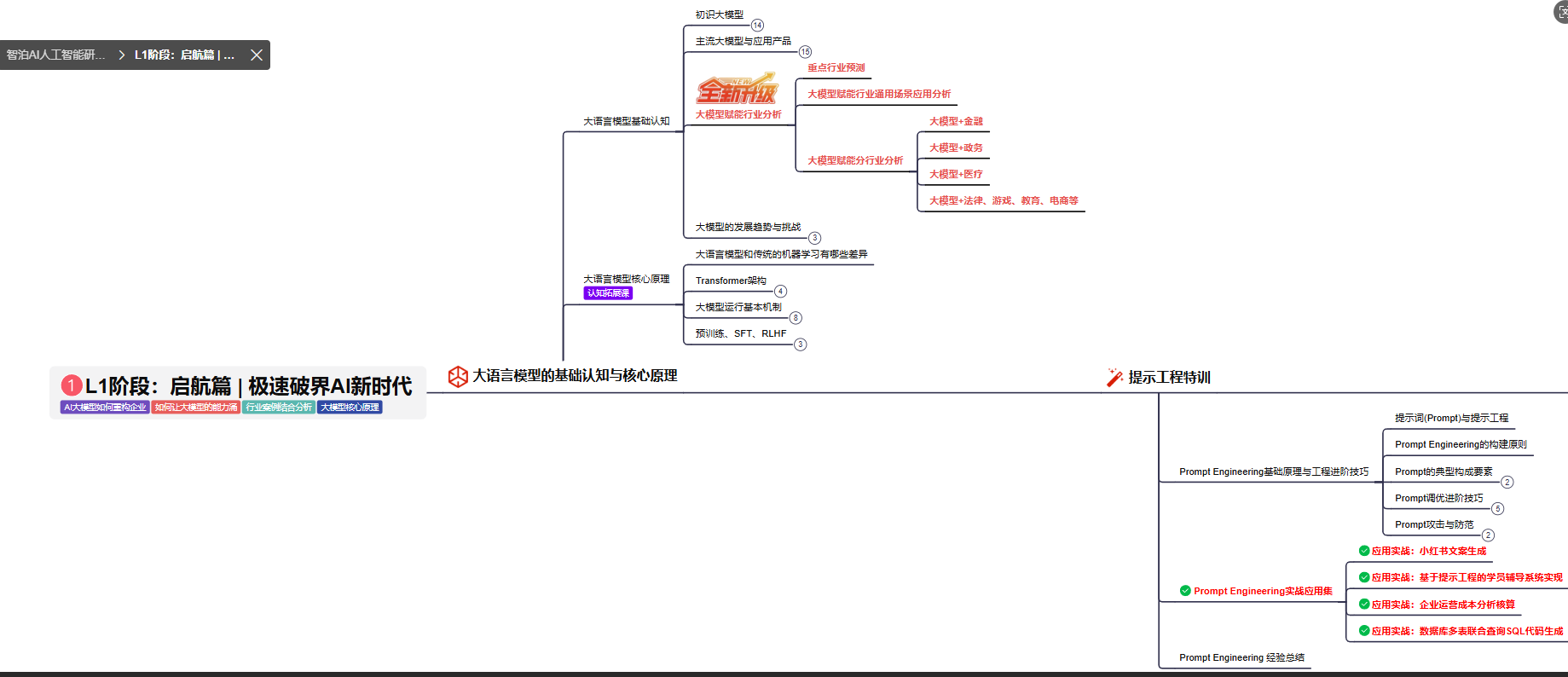

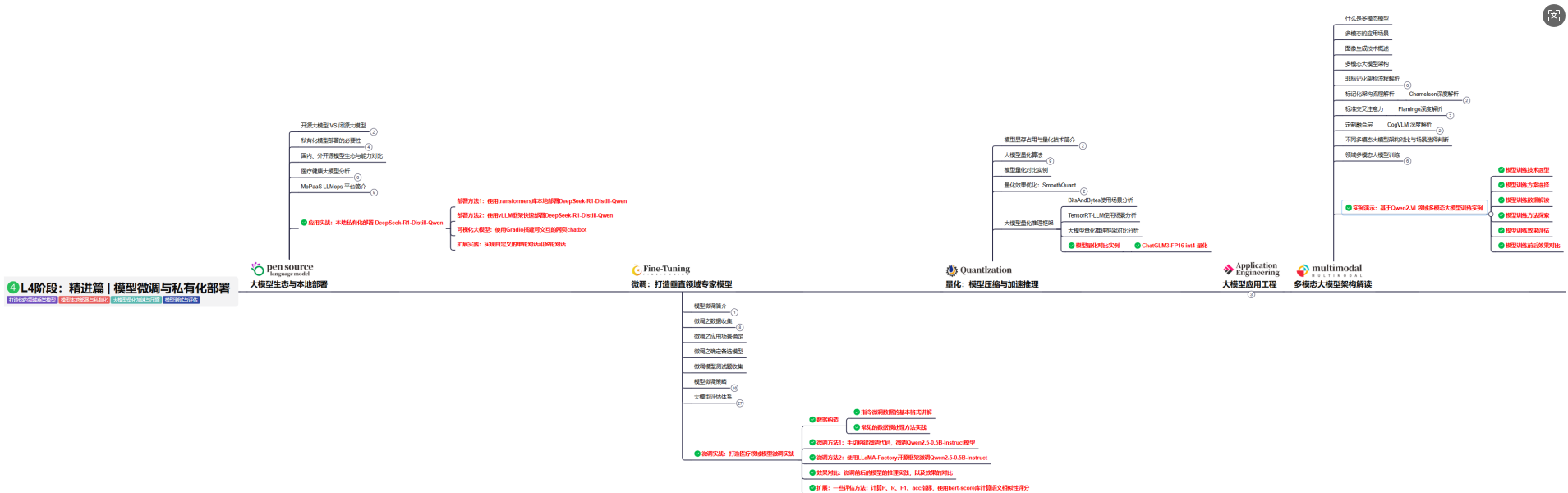

2.1、 AI大模型学习路线图,厘清要学哪些

对于刚接触AI大模型的小白来说,最头疼的问题莫过于“不知道从哪学起”,没有清晰的方向很容易陷入“东学一点、西补一块”的低效困境,甚至中途放弃。

为了解决这个痛点,我把完整的学习路径拆解成了L1到L4四个循序渐进的阶段,从最基础的入门认知,到核心理论夯实,再到实战项目演练,最后到进阶优化与落地,每一步都明确了学习目标、核心知识点和配套实操任务,带你一步步从“零基础”成长为“能落地”的大模型学习者。后续还会陆续拆解每个阶段的具体学习内容,大家可以先收藏起来,跟着路线逐步推进。

L1级别:大模型核心原理与Prompt

L1阶段: 将全面介绍大语言模型的基本概念、发展历程、核心原理及行业应用。从A11.0到A12.0的变迁,深入解析大模型与通用人工智能的关系。同时,详解OpenAl模型、国产大模型等,并探讨大模型的未来趋势与挑战。此外,还涵盖Pvthon基础、提示工程等内容。

目标与收益:掌握大语言模型的核心知识,了解行业应用与趋势;熟练Python编程,提升提示工程技能,为AI应用开发打下坚实基础。

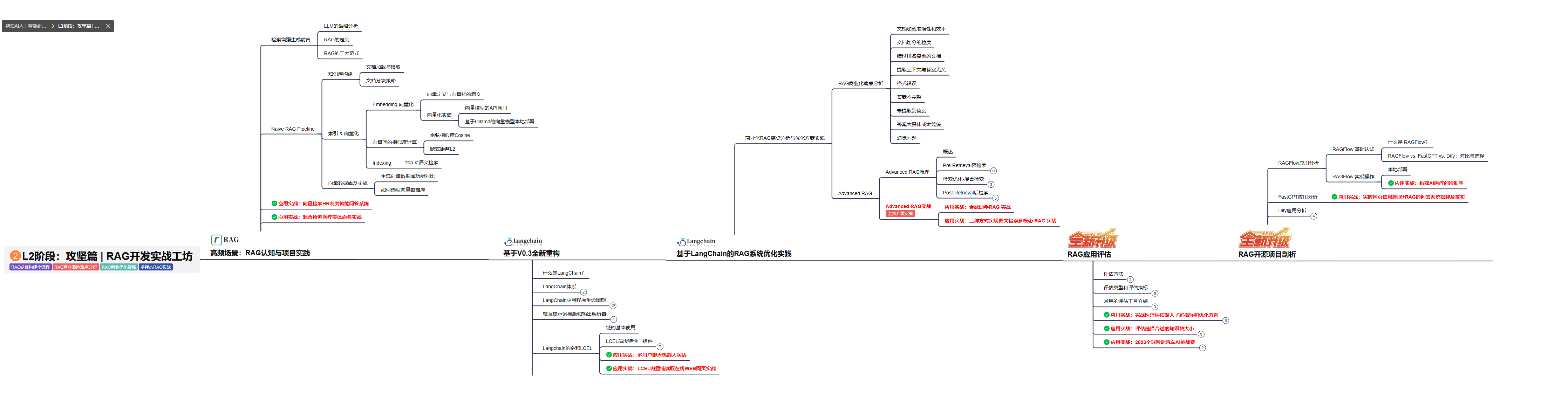

L2级别:RAG应用开发工程

L2阶段: 将深入讲解AI大模型RAG应用开发工程,涵盖Naive RAGPipeline构建、AdvancedRAG前治技术解读、商业化分析与优化方案,以及项目评估与热门项目精讲。通过实战项目,提升RAG应用开发能力。

目标与收益: 掌握RAG应用开发全流程,理解前沿技术,提升商业化分析与优化能力,通过实战项目加深理解与应用。

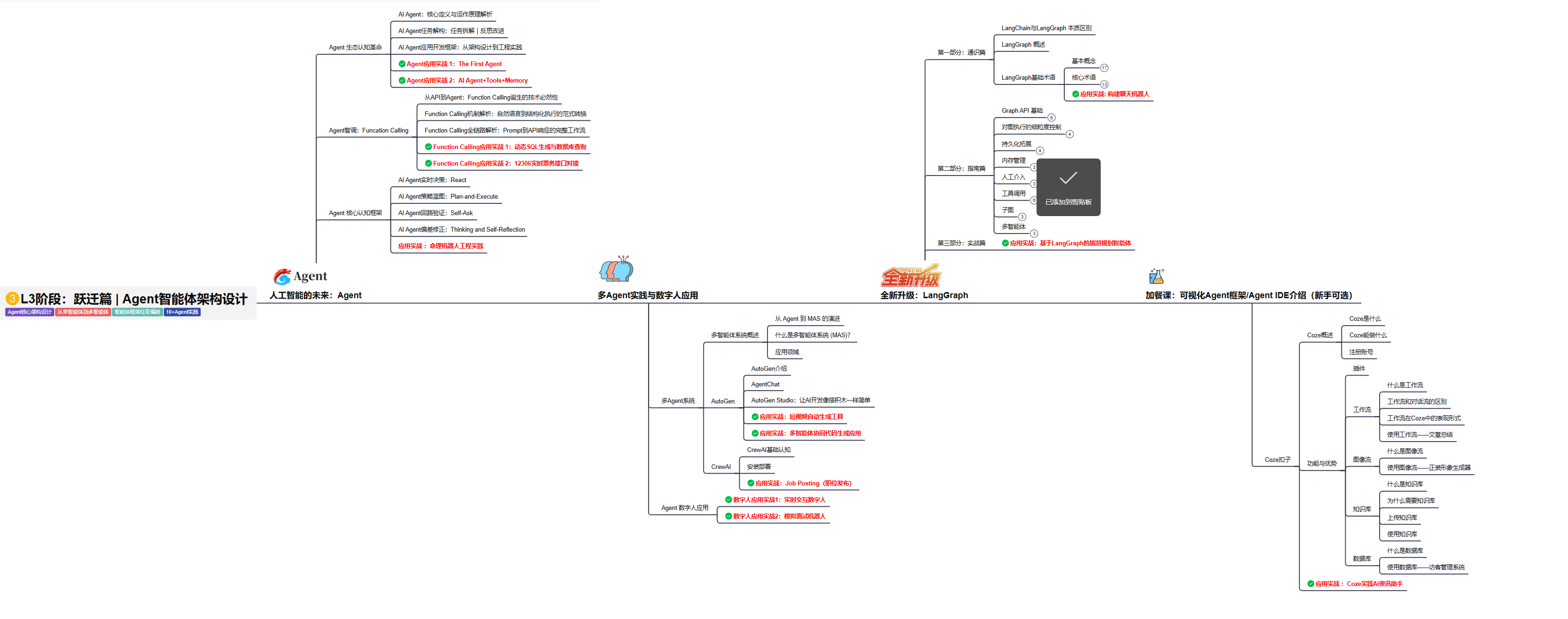

L3级别:Agent应用架构进阶实践

L3阶段: 将 深入探索大模型Agent技术的进阶实践,从Langchain框架的核心组件到Agents的关键技术分析,再到funcation calling与Agent认知框架的深入探讨。同时,通过多个实战项目,如企业知识库、命理Agent机器人、多智能体协同代码生成应用等,以及可视化开发框架与IDE的介绍,全面展示大模型Agent技术的应用与构建。

目标与收益:掌握大模型Agent技术的核心原理与实践应用,能够独立完成Agent系统的设计与开发,提升多智能体协同与复杂任务处理的能力,为AI产品的创新与优化提供有力支持。

L4级别:模型微调与私有化大模型

L4级别: 将聚焦大模型微调技术与私有化部署,涵盖开源模型评估、微调方法、PEFT主流技术、LORA及其扩展、模型量化技术、大模型应用引警以及多模态模型。通过chatGlM与Lama3的实战案例,深化理论与实践结合。

目标与收益:掌握大模型微调与私有化部署技能,提升模型优化与部署能力,为大模型项目落地打下坚实基础。

2.2、 全套AI大模型应用开发视频教程

从入门到进阶这里都有,跟着老师学习事半功倍。

2.3、 大模型学习书籍&文档

收录《从零做大模型》《动手做AI Agent》等经典著作,搭配阿里云、腾讯云官方技术白皮书,帮你夯实理论基础。

2.4、 AI大模型最新行业报告

2025最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

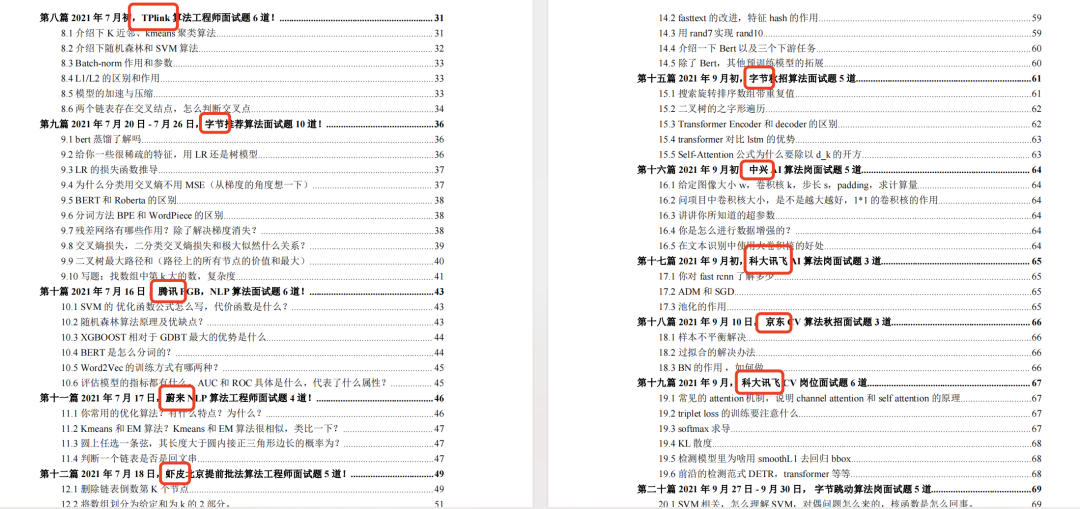

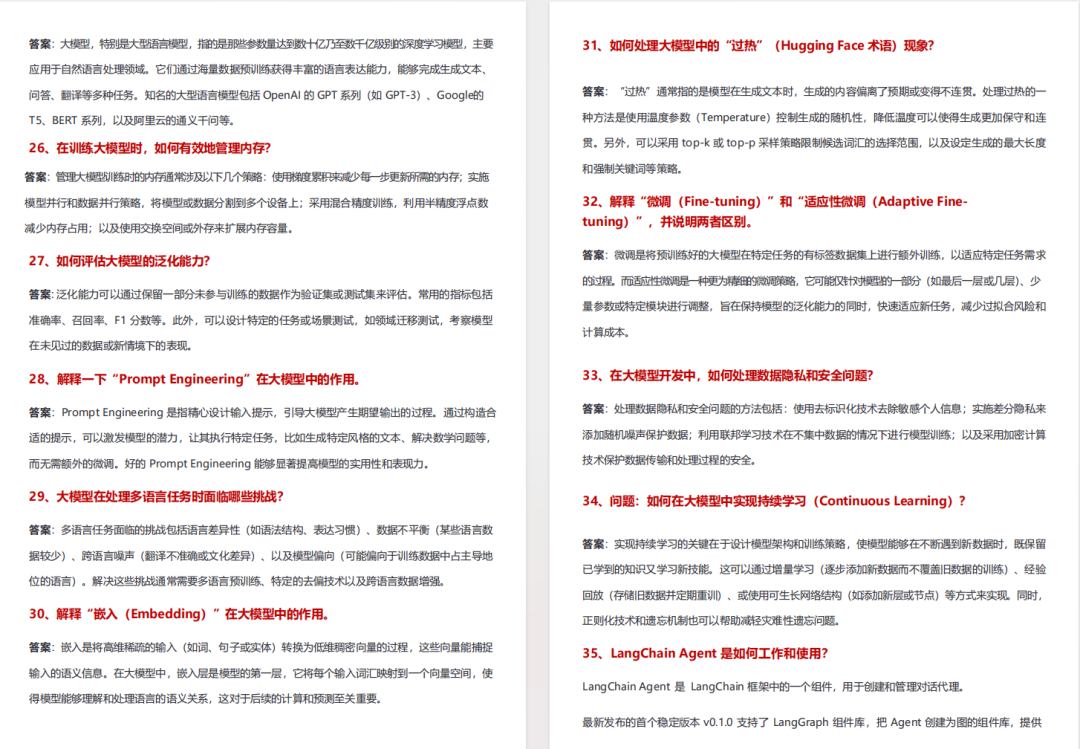

2.5、大模型大厂面试真题

整理了百度、阿里、字节等企业近三年的AI大模型岗位面试题,涵盖基础理论、技术实操、项目经验等维度,每道题都配有详细解析和答题思路,帮你针对性提升面试竞争力。

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

2.6、大模型项目实战&配套源码

学以致用,在项目实战中检验和巩固你所学到的知识,同时为你找工作就业和职业发展打下坚实的基础。

适用人群

四阶段学习规划(共90天,可落地执行)

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

-

硬件选型

-

带你了解全球大模型

-

使用国产大模型服务

-

搭建 OpenAI 代理

-

热身:基于阿里云 PAI 部署 Stable Diffusion

-

在本地计算机运行大模型

-

大模型的私有化部署

-

基于 vLLM 部署大模型

-

案例:如何优雅地在阿里云私有部署开源大模型

-

部署一套开源 LLM 项目

-

内容安全

-

互联网信息服务算法备案

-

…

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

2814

2814

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?