人在学习新知识的时候,能根据之前的知识很快的学习相似的知识,并且能不遗忘从前的知识。而机器,或者更准确一点说神经网络,在学习新任务的同时会出现一些问题——灾难性遗忘问题(catastrophic forgetting),意思是模型学习了新任务的b,而再回去预测旧任务a时发现预测不准确了。

因此,针对此现象,需要提出解决方案,以解决灾难性问题,我们将这种方法称之为持续学习(continual learning)

而本文,在阅读了关于continual learning的相关文献,对continual learning有一个大致的脉络,能为实际应用中的项目落地后的持续学习提供更好的帮助。

小编整理了一些持续学习论文合集,以下放出部分,论文原文+开源代码需要的同学关注“AI科研灵感”公号,那边回复“持续学习”获取。

论文1:

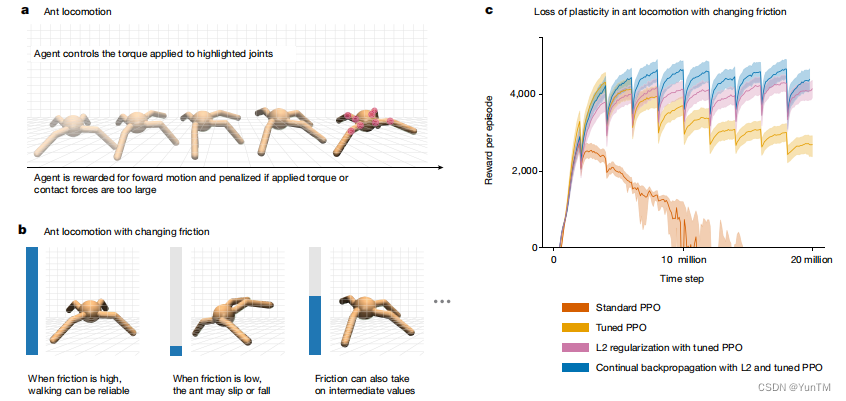

Loss of plasticity in deep continual learning

深度持续学习中塑性的丧失

方法

经典数据集应用:研究者使用经典的ImageNet数据集和强化学习问题,测试了在不同网络和学习算法变化下的塑性丧失。

网络和算法变化:在一系列变化的网络和学习算法中,展示了标准深度学习方法在持续学习环境中逐渐失去塑性。

持续学习算法:提出了一种持续反向传播算法,通过不断随机重新初始化一小部分不常用的单元来维持网络的多样性和塑性。

性能评估:通过在多个任务上的平均分类准确率来评估网络性能,观察网络是否在学习新任务时丧失了学习能力,以此直接证明塑性的丧失。

创新点

塑性丧失的证明:首次系统地证明了标准深度学习方法在持续学习中会逐渐丧失学习能力,表现为塑性的丧失。

持续学习算法的创新:提出了一种新的持续反向传播算法,通过随机重新初始化来维持网络的塑性,这在以往的研究中尚未出现。

深度学习适应性的提升:研究结果表明,为了维持深度学习的持续适应性,需要在其算法中加入随机的非梯度成分来维持多样性和塑性。

论文2:

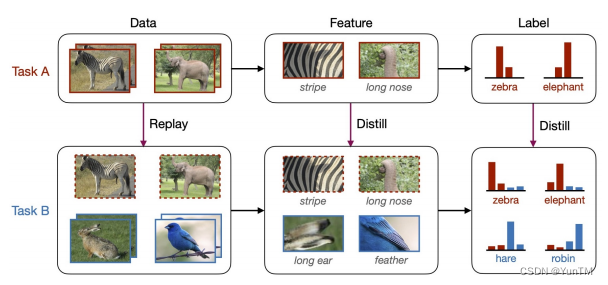

A Comprehensive Survey of Continual Learning: Theory, Method and Application持续学习的全面调查:理论、方法和应用

方法

理论基础总结:概述了持续学习的一般目标,包括稳定性-塑性权衡和足够的任务内/任务间泛化能力。

代表性方法分类:提供了一个最新的分类体系,详细分析了各种代表性方法如何应对持续学习的挑战。

实际应用适应性分析:探讨了持续学习方法如何适应特定挑战,如场景复杂性和任务特异性。

创新点

持续学习理论的系统化:首次系统总结了持续学习的最新进展,包括理论基础和方法论。

跨领域应用的广泛性:展示了持续学习在多个领域的应用,强调了其在现实世界中的广泛意义和复杂性。

全面调查的贡献:提供了一个全面的视角,促进了后续在该领域及其之外的探索。

论文3:

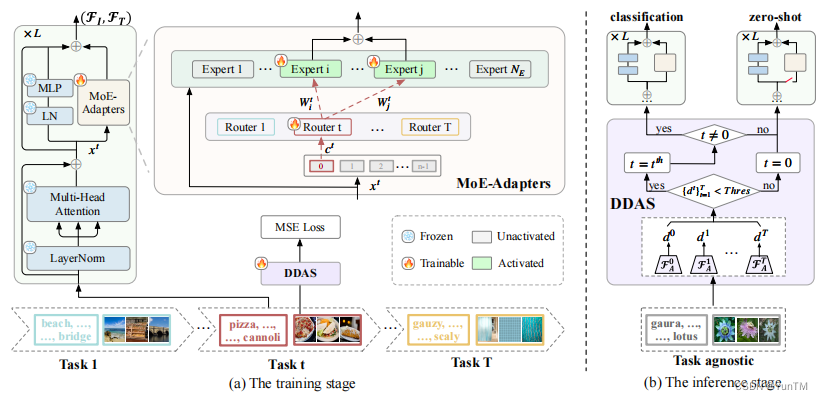

Boosting Continual Learning of Vision-Language Models via Mixture-of-Experts Adapters

通过专家混合适配器提升视觉-语言模型的持续学习能力

方法

参数高效框架:提出了一个参数高效的持续学习框架,通过动态扩展预训练的CLIP模型,整合Mixture-of-Experts (MoE)适配器来应对新任务。

零样本识别能力保持:为了保持视觉-语言模型的零样本识别能力,引入了分布判别式自动选择器(DDAS),自动将输入路由到MoE适配器或原始CLIP。

激活-冻结策略:在持续学习过程中,应用了一种新颖的激活-冻结策略,帮助专家学习任务内知识并鼓励任务间合作。

性能评估:通过在多种设置下进行广泛实验,证明了所提方法在解决灾难性遗忘问题上的有效性,同时减少了60%的参数训练负担。

创新点

MoE适配器的创新应用:将MoE适配器动态扩展架构应用于视觉-语言模型,提高了模型的适应性和效率。

分布判别式自动选择器(DDAS):提出了DDAS来自动分配测试数据,实现在统一框架内有效预测已见数据和零样本转移的能力。

参数负担和记忆需求的显著降低:在训练过程中,所提出的方法显著减少了参数负担和记忆需求,提高了持续学习的效率。

论文4:

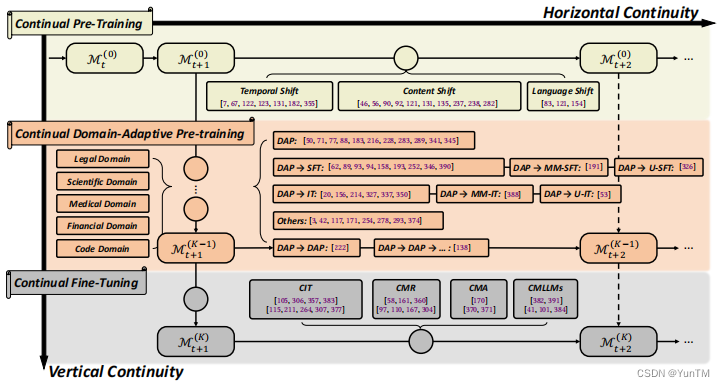

Continual Learning of Large Language Models: A Comprehensive Survey

用于持续学习的大型语言模型的综合调研

方法

研究结构:本调研首先介绍了持续学习(Continual Learning, CL)和大型语言模型(Large Language Models, LLMs)的基础知识,然后详细讨论了LLMs在CL领域的当前研究进展。

连续性方向:将LLMs的持续学习分为两个方向——垂直连续性(Vertical Continuity)和水平连续性(Horizontal Continuity),分别对应从一般到特定能力的持续适应。

学习阶段总结:总结了在现代CL背景下学习LLMs的三个阶段:持续预训练(Continual Pre-Training, CPT)、领域适应性预训练(Domain-Adaptive Pre-training, DAP)和持续微调(Continual Fine-Tuning, CFT)。

评估协议和数据源:提供了LLMs持续学习的评估协议概述,以及当前可用的数据源。

创新点

垂直和水平连续性的提出:首次将LLMs的持续学习分为垂直和水平两个方向,为分析和描述LLMs中的复杂学习范式提供了一个强有力的概念框架。

持续学习阶段的详细讨论:深入探讨了LLMs在持续学习中的三个关键阶段,为理解LLMs的适应性和遗忘问题提供了新的视角。

评估协议和数据集的整理:系统地整理了LLMs持续学习的评估协议和公开可用的数据集,为该领域的研究提供了宝贵的资源。

未来研究方向的探讨:讨论了LLMs在持续学习中的新兴属性、传统CL类型的角色变化、记忆约束的影响以及未来的研究方向,为LLMs的持续学习研究提供了新的思路。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?