神经概率语言模型(或称NNML 神经网络语言模型)中的数学原理

神经概率语言模型是word2vec中算法框架的前身,通过我看到的资料,神经概率语言模型和有的资料中的NNML (神经网络语言模型)应该是指的一个东西。看了《Word2Vec中的数学》中3.3节-神经概率语言模型,本人将其中的运算公式写了下来。本文将注重神经概率语言模型网络结构中各层级的运算,包括运算原理、公式以及各矩阵的维度,个人认为,如果能把整个过程中的公式写出来了,那么神经概率语言模型中的数学原理也就掌握了。

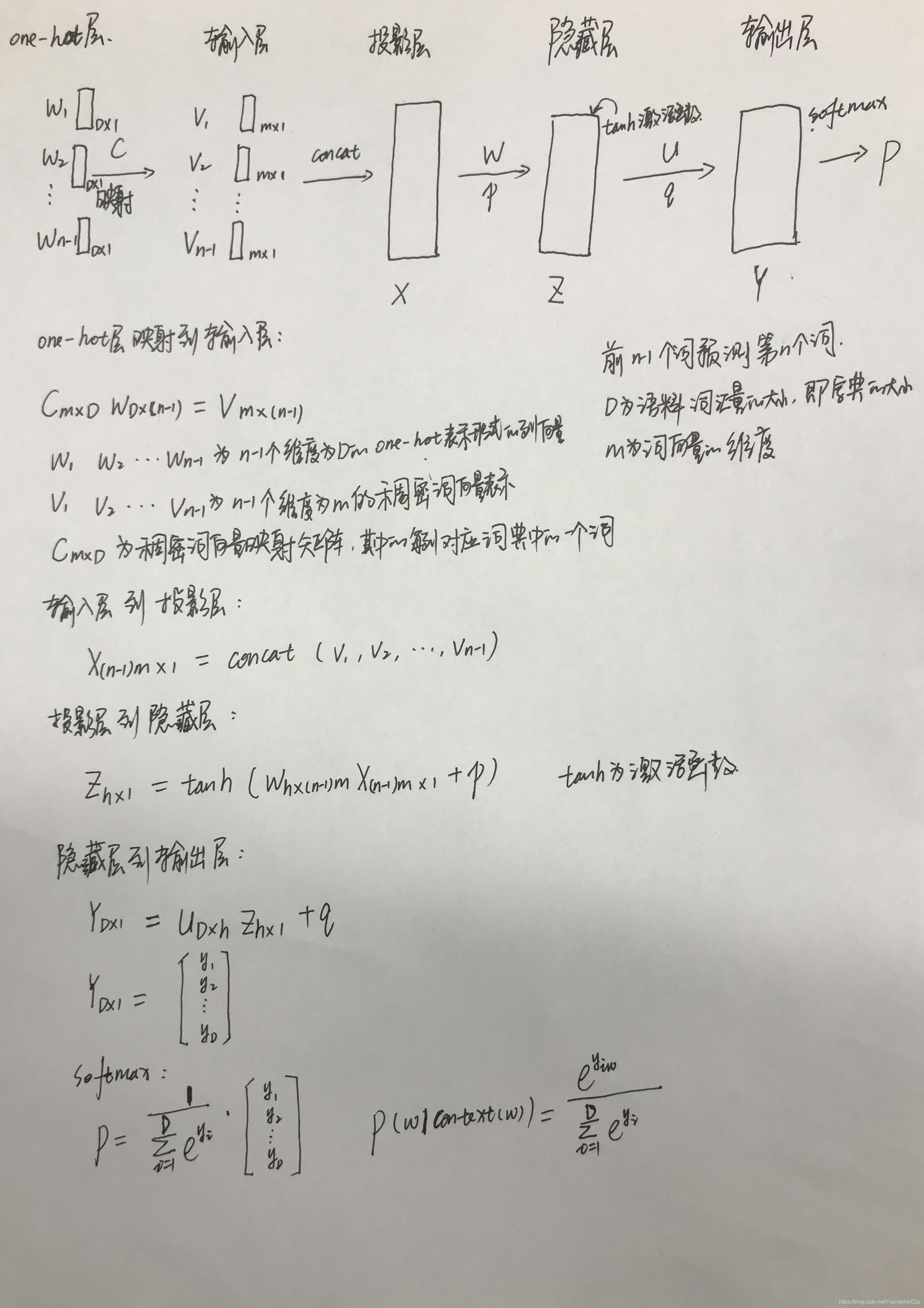

神经概率语言模型网络结构以及各层级之间的运算关系见下图:

其中,输入层有n-1个输入结点,投影层有(n-1)m个神经元,隐藏层有h个神经元,输出层有D个输出结点

参数量为(n-1)mxh+hxD+p+q。

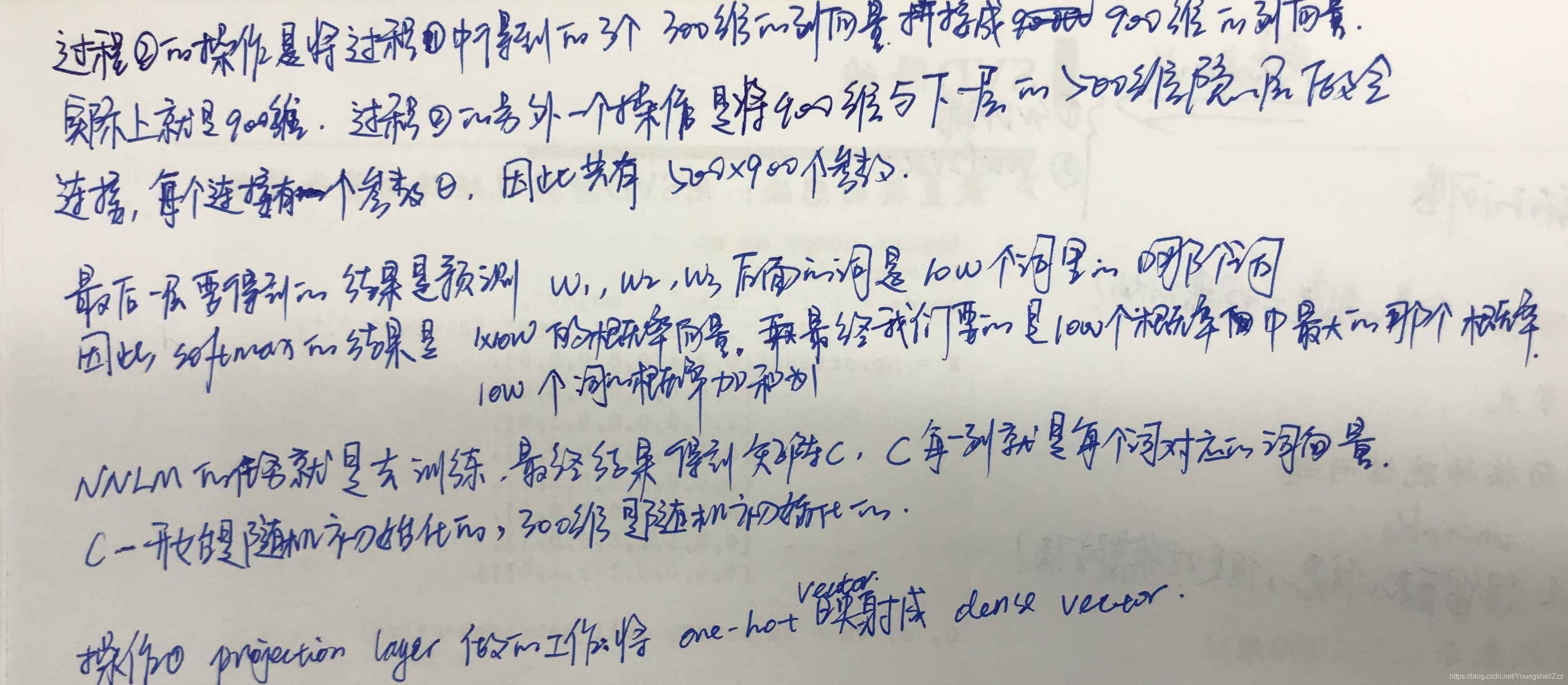

假设one-hot层到输入层的过程称为过程①,输入层到投影层的过程称为过程②,假设词向量维度m=300,前3个词去预测第4个词,则更详细的解释如下:

本文深入探讨了神经概率语言模型(NNML),即word2vec的前身,详细讲解了其网络结构、运算原理及数学公式,包括各层级的运算过程与参数量计算,适合对自然语言处理与深度学习感兴趣的读者。

本文深入探讨了神经概率语言模型(NNML),即word2vec的前身,详细讲解了其网络结构、运算原理及数学公式,包括各层级的运算过程与参数量计算,适合对自然语言处理与深度学习感兴趣的读者。

2187

2187

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?