前文

中文分词器下载

下载 elasticsearch-analysis 中文分词器,下载地址:https://github.com/medcl/elasticsearch-analysis-ik/releases/

安装中文分词器

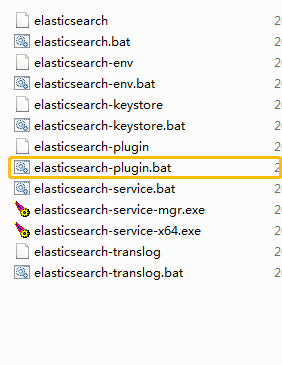

elasticsearch-plugin

elasticsearch 提供了一个安装插件的批处理文件,该 elasticsearch-plugin 文件在 elasticsearch 的 bin 目录中,该文件可以安装我们的中文分词器插件

安装

进入到 elasticsearch 的安装目录,cd 进入 bin 目录,执行以下命令安装中文分词器插件

elasticsearch-plugin install file:\\\\你下载的中文分词器压缩包路径

如:elasticsearch-plugin install

本文详细介绍了如何在ElasticSearch中安装和使用中文分词器,包括从下载分词器到通过elasticsearch-plugin命令进行安装的全过程,并演示了如何在Kibana中测试分词器的效果。

本文详细介绍了如何在ElasticSearch中安装和使用中文分词器,包括从下载分词器到通过elasticsearch-plugin命令进行安装的全过程,并演示了如何在Kibana中测试分词器的效果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

644

644

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?