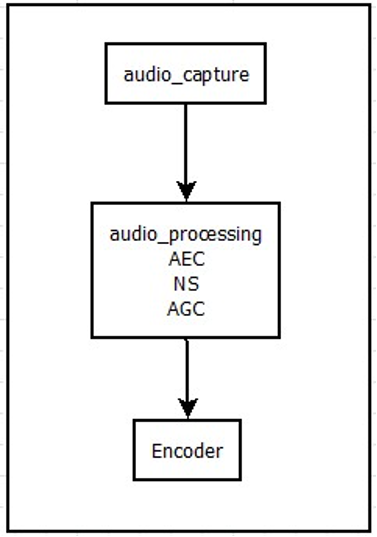

在 WebRTC 中,Audio 数据在被送入编码器之前,有 2 大部分需要特别关注,一是数据采集,二是 Audio Processing。

作者:方来,技术专家,从事 voip 应用开发。

数据采集

数据采集主要由 Audio Device 模块进行处理,而且是平台和配置相关。例如:

- Mac 电脑,使用的是 CoreAudio API,一般情况下使用默认内置的声卡参数 fs=48kHz,stero。

- Windows 电脑,WebRTC 中用的是 WASAPI。根据声卡参数不同,采样率等参数可选的比较多,例如有的电脑 builtInAEC 打开后,fs=16kHz,Mono,如果把声卡的 Audio Enhancement 关闭,则输出 fs=48kHz,stero。

- Android 一般使用 java 层的 AudioRecord 框架。

- iOS 一般使用 AudioUnit 框架。

另外,数据采集部分,还涉及到 USB 耳机,3.5mm 耳机,蓝牙耳机等外设,这些设备对音频链路上后续的 Audio Processing 也是有影响的,比如增加了 Audio 采集的delay,有 Speech Enhancement 处理的耳机会修改音频频谱,有的耳机外设使用不当可能会导致音频链路没有声音。

Audio Processing

Audio Processing 主要包括 AEC,AGC,NS 等等:

- AEC----Acoustic Echo Cancellation,即回音消除。

- AGC----Automatic Gain Control,即自动增益,用来调整输入信号的音量大小。

- NS----

本文聚焦WebRTC中的音频处理,介绍了数据采集和Audio Processing两大部分。数据采集与平台和配置相关,不同系统有不同处理方式,且外设会影响后续处理。Audio Processing包含AEC、AGC、NS等模块,还介绍了各模块算法及特点。最后提出采集适配和AEC区分平台等优化点。

本文聚焦WebRTC中的音频处理,介绍了数据采集和Audio Processing两大部分。数据采集与平台和配置相关,不同系统有不同处理方式,且外设会影响后续处理。Audio Processing包含AEC、AGC、NS等模块,还介绍了各模块算法及特点。最后提出采集适配和AEC区分平台等优化点。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

625

625

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?