最近在搞一个项目,涉及到大量的哈希数据扫描。大家都知道,哈希这东西,看似简单,但真要玩起来,还真不是那么容易。尤其是当数据量大了之后,性能问题就来了。于是,我决定写一个工具,专门用来处理这个问题,名字就叫 PHP HScan。

得明确一下,PHP HScan 是个啥东西。简单来说,它是一个用 PHP 写的哈希扫描工具,主要功能是遍历大量的哈希数据,找出符合特定条件的项。听起来好像挺简单的,对?但实际上,这里面有很多坑,稍不注意就会掉进去。

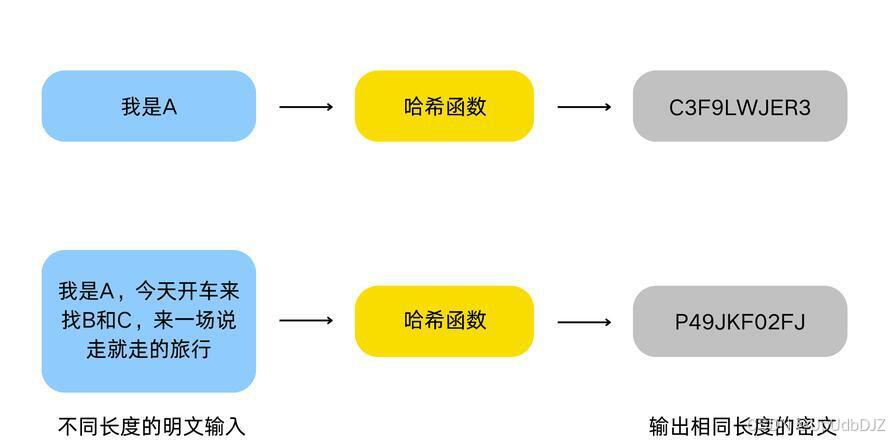

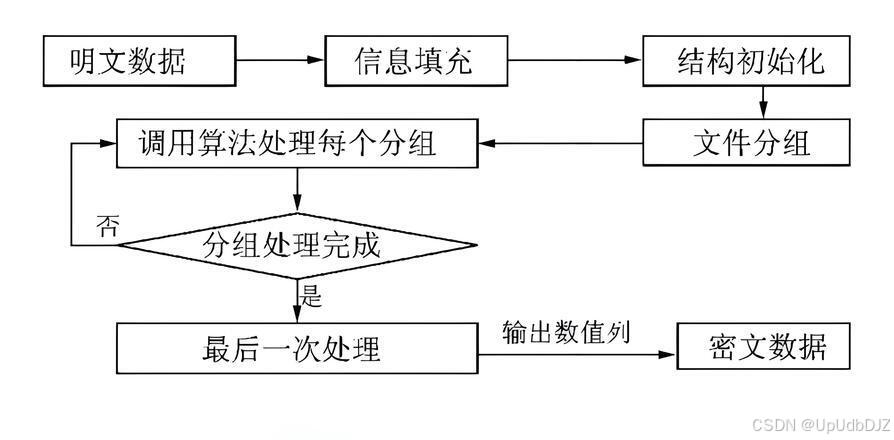

哈希扫描的基本原理

哈希扫描的基本原理其实很简单:你有一堆哈希值,你需要遍历这些哈希值,找出其中符合某些条件的项。比如说,你想找出所有哈希值以 "abc" 开头的项。听起来简单,但实际操作起来,你会发现,处理大量数据时,性能问题非常严重。

我们来看一下最基本的实现方式:

{code}$

$hashes = ['abc123', 'def456', 'abc789', 'xyz123'];

$prefix = 'abc';

foreach ($hashes as $hash) {

if (strpos($hash, $prefix) === 0) {

echo $hash . "\n";

}

}

${code}

这个代码的逻辑很简单:遍历哈希数组,找出所有以 "abc" 开头的哈希值。但是,当数据量很大时,这个代码的性能就会变得非常差。

为什么性能差?

性能差的原因主要有两个:

1. CPU 密集型操作:strpos 函数是一个 CPU 密集型操作,尤其是在数据量大的时候,它会消耗大量的 CPU 资源。

2. 内存消耗:如果你的哈希数组非常大,它会占用大量的内存。PHP 在处理大数组时,内存消耗是非常显著的。

如何优化?

既然知道了问题所在,那我们就得想办法优化。优化的思路主要有两个:

1. 减少 CPU 密集型操作:尽量减少 strpos 函数的调用次数。

2. 减少内存消耗:尽量使用迭代器而不是数组来遍历数据,这样可以减少内存的占用。

使用迭代器减少内存消耗

我们来看看如何使用迭代器来减少内存消耗。PHP 提供了一个叫 SplFileObject 的类,它可以让我们逐行读取文件,而不是一次性把整个文件加载到内存中。我们可以利用这个类来处理大文件。

{code}$

$file = new SplFileObject('hashes.txt');

foreach ($file as $hash) {

$hash = trim($hash);

}

}

${code}

这个代码的逻辑是逐行读取文件中的哈希值,而不是一次性加载整个文件。这样可以大大减少内存的消耗。但是,这个代码依然存在 CPU 密集型操作的问题。

减少 CPU 密集型操作

我们来看看如何减少 CPU 密集型操作。减少 CPU 密集型操作的方法有很多,其中一个比较简单的方法是通过字符串截取来替代 strpos 函数。

{code}$

$prefixLength = strlen($prefix);

if (substr($hash, 0, $prefixLength) === $prefix) {

}

}

${code}

这个代码的逻辑是用 substr 函数来截取字符串的前几位,而不是用 strpos 函数来判断字符串的开头。substr 函数比 strpos 函数更高效,尤其是在数据量大的时候,它的性能差距非常明显。

多线程处理

当然,如果你对性能的要求更高,你还可以考虑使用多线程处理。PHP 本身并不支持多线程,但你可以通过 pcntl_fork 函数来实现多进程处理。

{code}$

$processCount = 4; // 假设我们有 4 个 CPU 核心

$pids = [];

for ($i = 0; $i < $processCount; $i++) {

$pid = pcntl_fork();

if ($pid == -1) {

die('Could not fork');

} elseif ($pid) {

$pids[] = $pid;

} else {

while ($file->valid()) {

$hash = $file->fgets();

$hash = trim($hash);

if (substr($hash, 0, $prefixLength) === $prefix) {

echo $hash . "\n";

}

}

exit();

}

}

foreach ($pids as $pid) {

pcntl_waitpid($pid, $status);

${code}

这个代码的逻辑是通过 pcntl_fork 函数创建多个子进程,每个子进程负责处理一部分数据。这样可以充分利用多核 CPU 的性能。当然,多进程处理也有一些坑,比如进程间的同步问题、资源竞争问题等等,这些都需要特别小心。

其他优化技巧

除了上面提到的这些方法,还有一些其他的优化技巧。比如,你可以使用缓存来减少重复计算,或者使用更高效的哈希算法来加快查找速度。这些技巧都可以在不同的场景下发挥作用。

常见问题及解决方案

在实际使用过程中,你可能会遇到一些问题。下面列出了一些常见的问题及其解决方案。

1. 内存不足:如果你处理的数据量非常大,你可能会遇到内存不足的问题。解决这个问题的方法是使用迭代器而不是数组来遍历数据,或者使用 ini_set('memory_limit', -1) 来增加 PHP 的内存限制。

2. 性能瓶颈:如果你的代码性能很差,你可以通过减少 CPU 密集型操作、使用多线程处理等方法来提高性能。

3. 数据格式错误:如果你的数据格式不正确,可能会导致程序出错。解决这个问题的方法是使用正则表达式或者其他方法对数据进行预处理,确保数据的格式正确。

总结

PHP HScan 是一个非常实用的工具,尤其是在处理大量哈希数据时,它可以帮助你快速找到符合特定条件的项。通过优化代码,你可以大大提高它的性能,减少内存消耗和 CPU 占用。

当然,优化代码并不是一件容易的事情,它需要你深入了解 PHP 的工作原理,并且具备一定的调试技巧。希望这篇文章能够帮助你更好地理解 PHP HScan 的实现原理,并且在实际项目中发挥它的作用。

好了,今天的分享就到这里。如果你有任何问题,欢迎在评论区留言,我会尽力解答。下次见!

1249

1249

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?