BERT might be Overkill: A Tiny but Effective Biomedical Entity Linker based on Residual Convolutional Neural Networks [pdf]

- 论文状态:被EMNLP21-findings接收

- 作者:Tuan Lai, Heng Ji, ChengXiang Zhai

- TL;DR: 本文用ResCNN取代传统的BERT基础模型做Biomedical Entity Linking,可以取得相近的效果并大量减少参数和计算时间.

1. Motivation

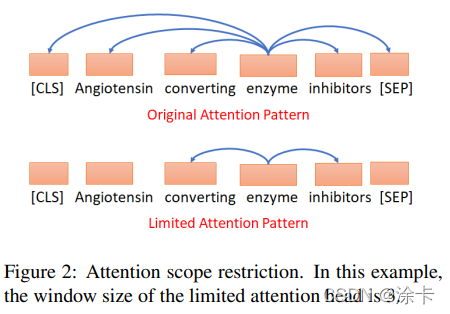

作者做了2个预实验,发现当输入的文本被打乱或者BERT的attention机制的window size被缩减之后,实体链接的效果并没有下降太多.

由此,作者认为对于Biomedical Entity Linking任务,local的上下文信息比global的信息更重要,于是就采用了对local信息捕捉能力强的ResCNN来建模.

2. Contribution

- 发明了一种简单且有效的Biomedical Entity Linking模型:ResCNN Entity Linker

- 证明了对于某些任务,BERT的过大参数量可能是没用的

3. Model

作者用于当做文本encoder的ResCNN,主要有:

- 采用GLoVe, 固定参数不变的token embedding层

- 由CNN模块构成的,且采用残差连接的encoding层

- 池化层:尝试了Max Pooling 与Self-Attention Pooling

4. Experiments

在5个主要的entity linking数据集上做了测试,GPU速度比SAPBERT快3-4倍,Top-1 Accuracy效果差不多.

5. Key takeaways

- 对于某些任务,BERT的过大参数量可能是没用的

1389

1389

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?