转载公众号 | 知识图谱科技

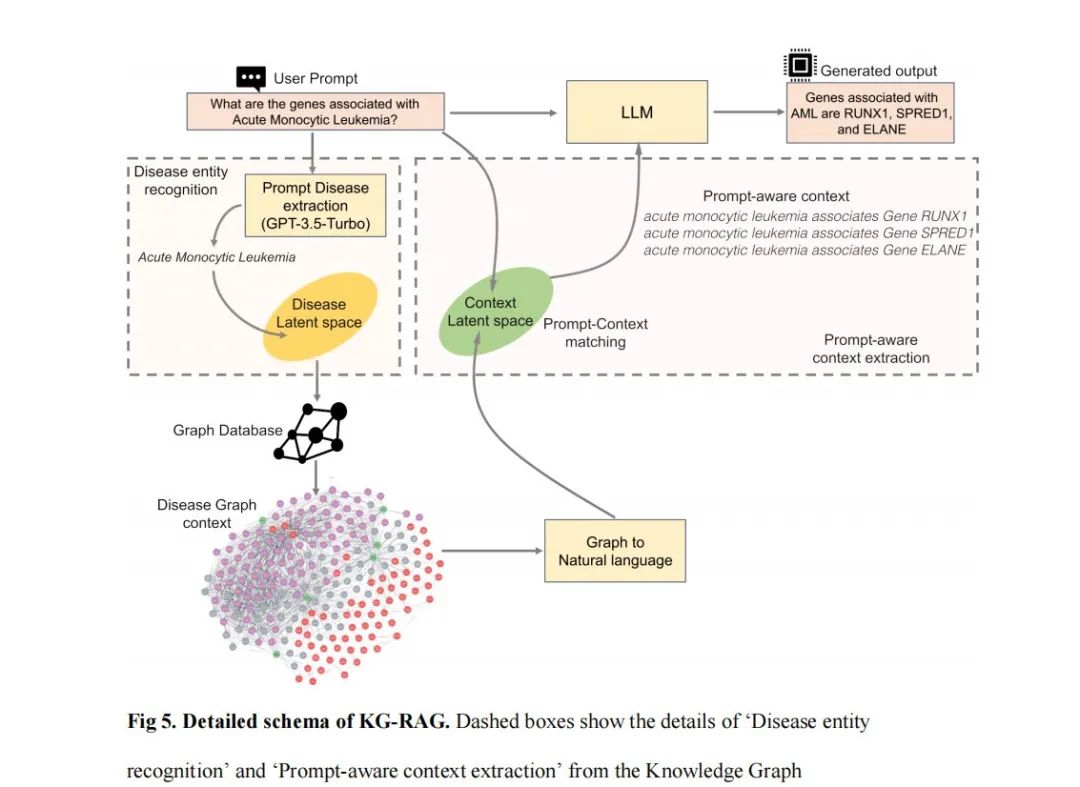

KG-RAG 表示基于知识图谱的RAG(Retrieval Augmented Generation)检索增强.

先看一下KG-RAG的视频

这是一个与任务无关的框架,它将知识图谱(KG)的显性知识与大型语言模型(LLM)的隐含知识结合起来。这是该工作的arXiv预印本 https://arxiv.org/abs/2311.17330 。

我们在这里利用一个名为SPOKE(https://spoke.ucsf.edu/)的大规模生物医学知识图谱作为生物医学背景的提供者。SPOKE已经整合了来自不同领域的40多个生物医学知识库,每个知识库都专注于生物医学概念,如基因、蛋白质、药物、化合物、疾病及其相关连接。

SPOKE由21种不同类型的超过2700万个节点和55种类型的5300万条边组成(https://doi.org/10.1093/bioinformatics/btad080)。

KG-RAG的主要特点是从SPOKE KG中提取“提示感知上下文”,其定义为:足以回答用户提示的最小上下文。

因此,这个框架通过从生物医学KG中获得的优化领域特定的“提示感知上下文”,赋予了一个通用型的LLM更强大的功能。

KG-RAG用户案例

下面的片段显示了FDA网站上关于由

FDA(https://www.fda.gov/drugs/news-events-human-drugs/fda-approves-treatment-weight-management-patients-bardet-biedl-syndrome-aged-6-or-older)批准用于巴代特-畢迪二氏综合征患者的减重药物“setmelanotide”的信息。

询问 GPT-4 关于上述药物:

没有KG-RAG

注意:此示例是使用KG-RAG v0.3.0运行的。我们是通过终端来启动GPT,而不是通过chatGPT浏览器。分析中的温度参数设置为0。参考此yaml文件进行参数设置,包括KG-RAG。

有KG-RAG

注意:此示例是使用KG-RAG v0.3.0运行的。分析过程中,温度参数设置为0。有关参数设置,请参阅此yaml文件。

你可以看到,KG-RAG能够提供关于FDA批准药物的正确信息。如何运行KG-RAG

注意:目前,KG-RAG专门为与疾病相关的提示运行而设计。我们正在积极努力改进其多功能性。

Step 1: 克隆repo

克隆此存储库。所有论文中使用的生物医学数据已上传到此存储库,因此您无需单独下载。

Step 2: 创建一个虚拟环境

注意:本存储库中的脚本是在Python 3.10.9版本下运行的。

conda create -n kg_rag python=3.10.9

conda activate kg_rag

cd KG_RAGStep 3: 安装依赖项

pip install -r requirements.txt

Step 4: 更新config.yaml

config.yaml保存了运行您机器上的脚本所需的所有必要信息。请确保相应地填充此yaml文件。

注意:还有另一个名为system_prompts.yaml的yaml文件。它已经填充好,并保存了KG-RAG框架中使用的所有系统提示。

Step 5: 运行设置脚本

注意:确保您位于KG_RAG文件夹中

设置脚本以交互方式运行。

运行设置脚本:

1.为KG-RAG创建疾病向量数据库

2.在您的机器上下载Llama模型(可选,您可以跳过此步骤,完全没有问题)

python -m kg_rag.run_setupStep 6: 从重点运行KG-RAG

注意:确保你处于KG_RAG文件夹中

你可以使用GPT和Llama模型来运行KG-RAG。

用GPT

python -m kg_rag.rag_based_generation.GPT.text_generation -g <your favorite gpt model - "gpt-4" or "gpt-35-turbo">示例:注意:以下示例在AWS p3.8xlarge EC2实例上运行,并使用KG-RAG v0.3.0。

用GPT的交互模式

这使用户可以以交互式方式逐步完成整个过程。

python -m kg_rag.rag_based_generation.GPT.text_generation -i True -g <your favorite gpt model - "gpt-4" or "gpt-35-turbo">用Llama

注意:如果您在安装设置步骤时没有下载Llama,那么当您运行下面的命令时,可能需要一些时间,因为它首先会下载模型。

python -m kg_rag.rag_based_generation.Llama.text_generation -m <method-1 or method2, if nothing is mentioned it will take 'method-1'>示例

注意:以下示例是在AWS p3.8xlarge EC2实例上运行,并使用KG-RAG v0.3.0。

用Llama交互模式

这样做可以让用户以互动方式逐步完成整个过程。

python -m kg_rag.rag_based_generation.Llama.text_generation -i True -m <method-1 or method2, if nothing is mentioned it will take 'method-1'>引用

@article{soman2023biomedical,

title={Biomedical knowledge graph-enhanced prompt generation for large language models},

author={Soman, Karthik and Rose, Peter W and Morris, John H and Akbas, Rabia E and Smith, Brett and Peetoom, Braian and Villouta-Reyes, Catalina and Cerono, Gabriel and Shi, Yongmei and Rizk-Jackson, Angela and others},

journal={arXiv preprint arXiv:2311.17330},

year={2023}

}SPOKE KG可以通过以下链接访问:

https://spoke.rbvi.ucsf.edu/neighborhood.html。也可以使用REST-API访问

(https://spoke.rbvi.ucsf.edu/swagger/)。

KG-RAG代码可在

https://github.com/BaranziniLab/KG_RAG 下载。本研究中使用的生物医学数据集(一跳问题、两跳问题、真假问题、多选题问题、药物重新定位问题、SPOKE KG中的疾病上下文)可供研究界使用,位于同一GitHub存储库中。

原文 - [2311.17330] Biomedical knowledge graph-enhanced prompt generation for large language models (arxiv.org)

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。

3674

3674

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?