Intel的Optane(傲腾)存储器,从标准PCIE插卡、U.2 SFF8639的NVMe SSD,到M.2消费类产品都有覆盖。利用3D Xpoint这种超高速非易失性存储介质,实现了接近SDRAM的速度以及大幅高于SDRAM的容量。在NAND Flash和SDRAM之间填补了空白区。

冬瓜哥,你为什么不信线下的性能测试数据?难道这都能有假么?

冬瓜哥,你为什么不信线下的性能测试数据?难道这都能有假么?

这里面的门道,需要比较深的技术基础才能参透。线下性能实测的时候人们往往采用高并发多线程方式来追求极高吞吐量。而往往忽略了I/O的延迟。要知道很多应用对延迟敏感,也就是应用发出更多比例的同步I/O,此时高吞吐量并没有性能加成,而低延迟才能解决问题。傲腾的低延迟是个万能药,包治百病。在queue depth=1的时候就已经可以达到较高吞吐量,所以标本兼治。

那么,傲腾这种存储器的最典型使用场景是什么?

那么,傲腾这种存储器的最典型使用场景是什么?

由于极低的延迟,天然适用于OLTP场景,一些经过定制的业务可以直接使用基于傲腾DIMM存储器的App Direct模式获取最优的延迟。另外,相比DDR RAM更大的容量,天然适合用作RAM与NAND Flash之间的缓存层,能够更广泛的提升性能。

数据存储占到了其一半以上的预算的俄罗斯最大的社交网络平台VK 引入全新数据分层架构,以 2:1 的比例整合服务器,采用英特尔® 傲腾™ 持久内存、英特尔® 傲腾™ 固态盘和英特尔® 非易失性存储器 (NVMe) 固态盘对原有的分层存储架构进行了现代化改造。最终,VK 成功省下数百万美元,预估将来整体上将节省数亿美元。

VK 是俄罗斯和独联体 (CIS) 地区最大的社交网络平台,且仍在快速增长。在 2018-2019 年度,VK 的月活用户为 9,700 万,远高于四年前的 6,600 万1。每天,VK 用户查看的帖子高达 90 亿条、观看的视频高达 6.5 亿个、发送的消息高达 100 亿条、点 “赞” 次数高达十亿次。在一年的时间里,用户上传了约 600 PB 的新数据,其中包括照片和视频,而这些数据必须永久存储。

由于所有数据都通过网络进行流传输,因此数据存储基础设施成为VK 最大的成本支出也不足为奇。存储成本已占到公司年度预算的 60% 至 65%,因此优化存储总体拥有成本 (TCO) 成了 VK 的当务之急。在整个存储空间中,共分布了 1.1 EB 的数据。数据存储在离上传位置较近的地方。VK 背后的 IT 基础设施是 19,000 台服务器。公司拥有三个主要的数据中心,并由 30 个内容分发网络 (CDN) 提供支持,以此加快最热数据的访问速度。

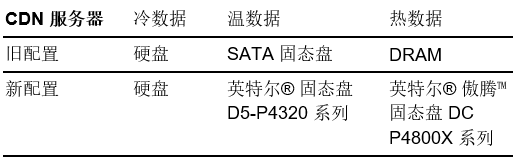

VK 在其 CDN 服务器上采用的是三层数据缓存结构。随着数据热度的下降,数据会向下层移动。热数据指的是最近上传到网络且仍被经常访问的数据。温数据则是已不再被频繁访问的数据。通常情况下,温数据是最长一个月前上传的数据。而冷数据是指很少被访问的数据。在采用新技术之前,CDN 中的冷数据存储在遍布俄罗斯的分布式数据网络中的硬盘上。温数据存储在 SATA 固态盘中,而热数据存储在 DRAM 中。此外,基于 Nginx Web 服务器的数据库服务器使用 SATA 固态盘和硬盘来存储数据,使用 DRAM 来存储索引。

VK面临的主要挑战

•降低数据存储(数据以每年 600 PB 的速度增长)的总体拥有成本 (TCO)。

•让 VK 用户能够快速访问最新、最热门的内容。

•支持数据分层,将访问频率较低的数据迁移到成本较低的存储器中。

•无需再为满足不同最终用户设备需求而存储同一图像的多种格式。

针对上述挑战,基于Intel的全方位存储加速方案,VK 对其存储架构进行了现代化改造。对于 CDN 服务器,热数据已从昂贵的 DRAM 移至英特尔® 傲腾™ 固态盘 DC P4800X 系列,并且通过引入英特尔® 傲腾™ 持久内存取代 DRAM 来处理相关工作负载,由此降低单位比特成本(见下图 )。如果工作负载支持英特尔® 傲腾™ 持久内存的 App Direct 模式,那么内存就具备了持久性。英特尔® 傲腾™ 固态盘 P4800X 系列可帮助消除数据中心存储的瓶颈,方便处理更大、更具性价比的数据集。在全新的存储方案中,温数据存储在非易失性存储器 (NVMe) 英特尔® 固态盘D5-P4320 系列上。

Podpriatov 表示:“现在,我们可以将热数据和温数据均存储在固态盘上,从而减少了我们的 DRAM 用量。之前我们的固态盘不够快,无法为热数据提供良好的用户体验,因此我们只能将某些数据存储在 DRAM 中。现在,我们可以将数据全部存储在比内存便宜得多的固态盘中。”

对于数据库服务器,VK 引入了英特尔® 傲腾™ 持久内存来存储数据库索引(见上图 )。英特尔® 傲腾™ 持久内存具有更强的内存寻址能力,可有效提升数据库性能。将数据从 DRAM 迁移到英特尔®傲腾™ 持久内存还可降低数据库索引的存储成本。数据库本身已从硬盘或 SATA 固态盘迁移到非易失性存储器 (NVMe) 英特尔®固态盘 D5-P4320 系列,有效地提高了性能和存储密度。

另外,为了进一步优化存储并提高能效,VK 正在部署采用英特尔® Arria® 10 GX FPGA 的英特尔® 可编程加速卡(英特尔® PAC)(见图 3),并运行 CTAccel 图像处理器工作负载

该解决方案的技术组件

• 英特尔® 傲腾™ 固态盘 DC P4800X 系列。VK 已将特定 CDN 服务器上的数据从 DRAM 迁移至英特尔® 傲腾™固态盘,从而降低了 DRAM 成本。

• 英特尔® 傲腾™ 持久内存。数据库索引对于性能高度敏感,因此 VK 采用英特尔® 傲腾™ 持久内存,以低于 DRAM 的单位比特成本来存储数据库索引。

• 英特尔® 固态盘 D5-P4320 系列。这类经济高效的固态盘为温数据提供所需的性能,并在 VK 的数据层级结构中发挥着重要作用。而该数据层级结构可将使用频率较低的数据从快速存储器迁移到速度较慢(但更便宜)的存储器。

• 采用英特尔® Arria® 10 GX FPGA 的英特尔® 可编程加速卡(英特尔® PAC)。这款基于PCI Express* (PCIe*) 的

数据中心级 FPGA 加速器卡支持内嵌和旁路加速,具备 FPGA 加速的强大性能和多功能性,并且是获得面向搭载 FPGA 的英特尔® 至强® CPU 的加速堆栈支持的几个平台之一。

展阅读展

VK 估计,通过引入全新的存储解决方案,可以节省总计数亿美元的成本。新的存储解决方案让 VK 能够在 1U 服务器中存储高达0.4 PB 的数据,只需更少的机架就能存储相同数量的数据,因此在空间、供电和散热方面将不断实现成本节约。

欢迎关注Intel商用频道

END

扫码入当当/京东直购《大话计算机》

扩展阅读

《大话计算机》序言⑦ by @去流浪

博主简介:冬瓜哥,《大话计算机》与《大话存储 终极版》、《大话存储 后传》图书作者。多项专利发明人。

现任某半导体公司高级资深架构师。

大话计算机 大话存储

大话计算机 大话存储

长按扫码可关注

5528

5528

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?