学习hadoop--安装Hadoop

一、 在/usr文件夹下新建hadoop文件夹(类似java)

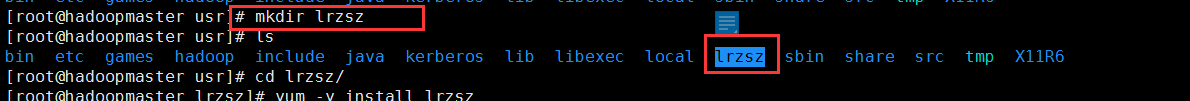

二、 主机安装lrzsz用于上传接受文件(tar包)

在/usr文件下新建lrzsz文件夹

上传lrzsz的rpm文件

安装

报警告(我也不知道原因,忽略之后能正常上传tar包)

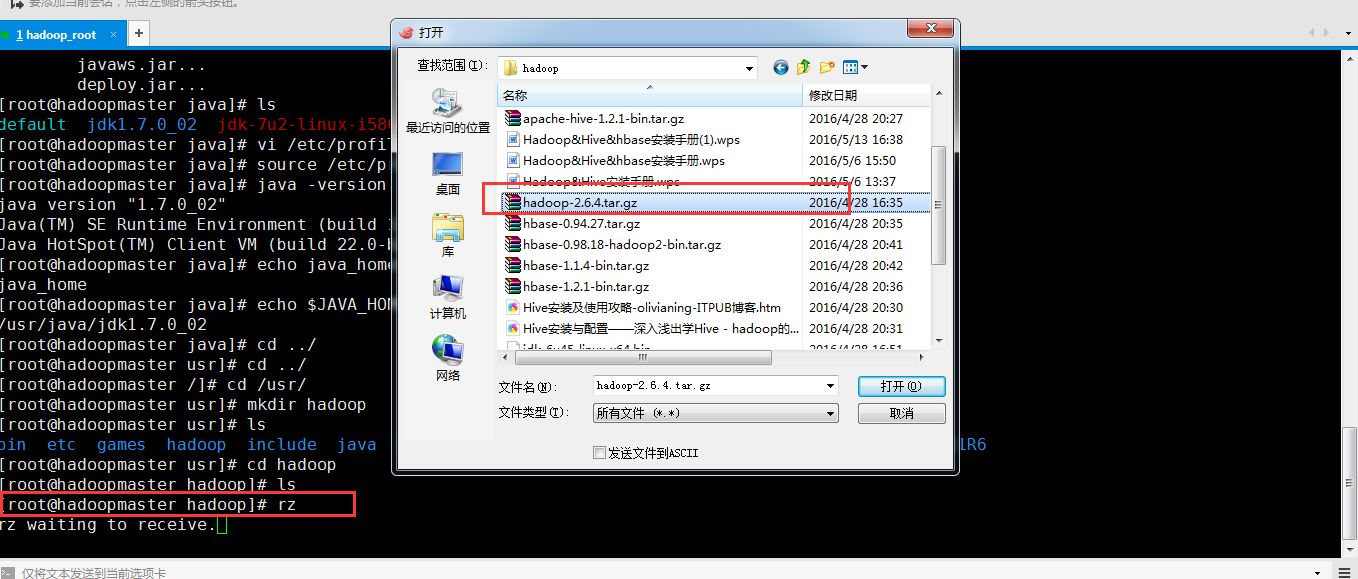

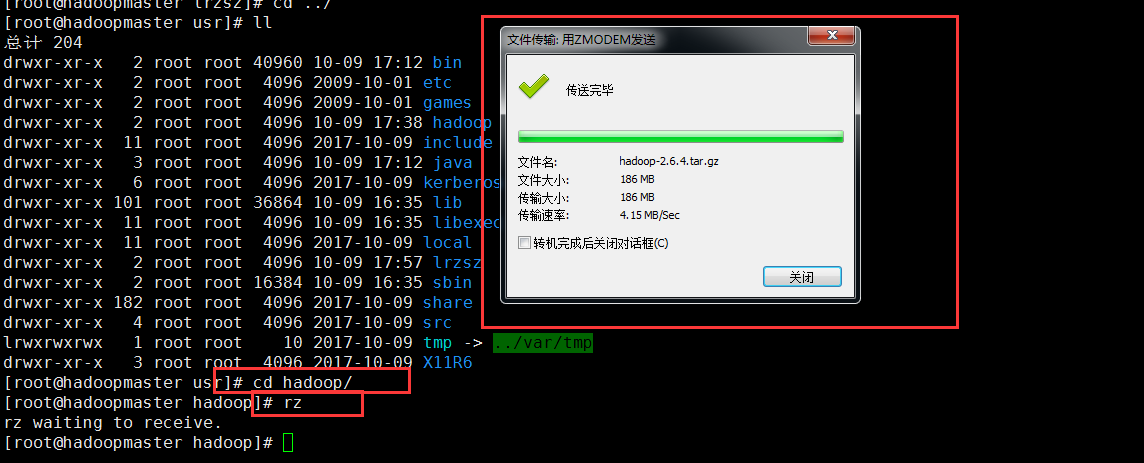

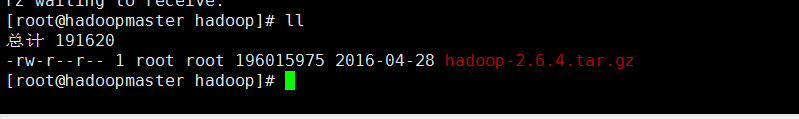

三、 上传hadoop安装包

四、 安装hadoop 使用 tar -zxvf hadoop-2.6.4.tar.gz

五、 修改hadoop的环境变量

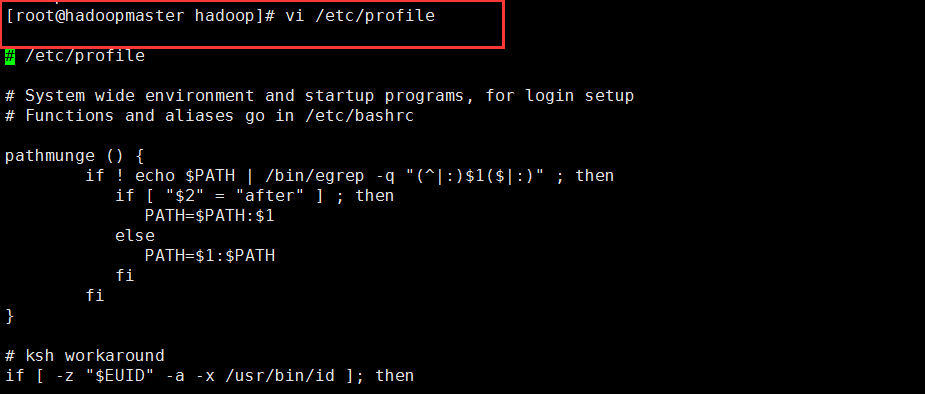

a.编辑/etc/profile

b.修改环境变量

export HADOOP_PREFIX=/usr/hadoop/hadoop-2.6.4

export PATH=$HADOOP_PREFIX/bin:$PATH

c.立即生效 source/etc/profile

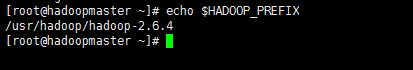

d.检查

六、 修改hadoop配置文件(hadoop-2.6.4下etc/hadoop中的文件)

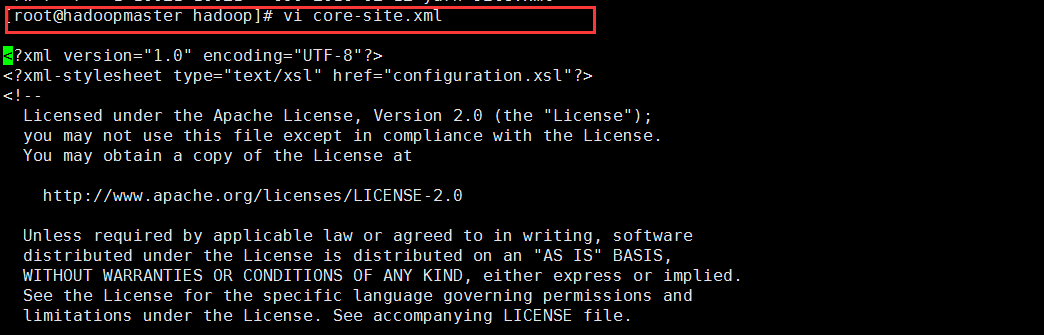

1) 修改 core-site.xml

<property>

<name>hadoop.tmp.dir</name>

<value>/hadoop/tmp</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://10.10.34.106:9000</value>

</property>

2) 修改hdfs-site.xml

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/hadoop/hadoop-2.6.4/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/hadoop/hadoop-2.6.4/dfs/data</value>

</property>

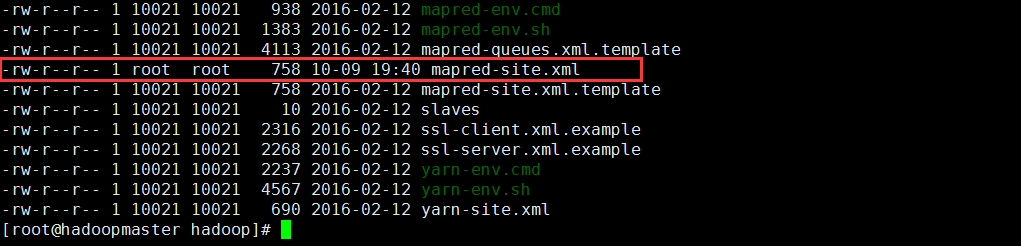

3) 用mapred-site.xml.template创建mapred-site.xml

修改mapred-site.xml

<property>

<name>mapred.job.tracker</name>

<value>10.10.34.106:9001</value>

</property>

4) 修改yarn-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

5) 修改hadoop-env.sh文件

添加exportJAVA_HOME=/usr/java/jdk1.7.0_02

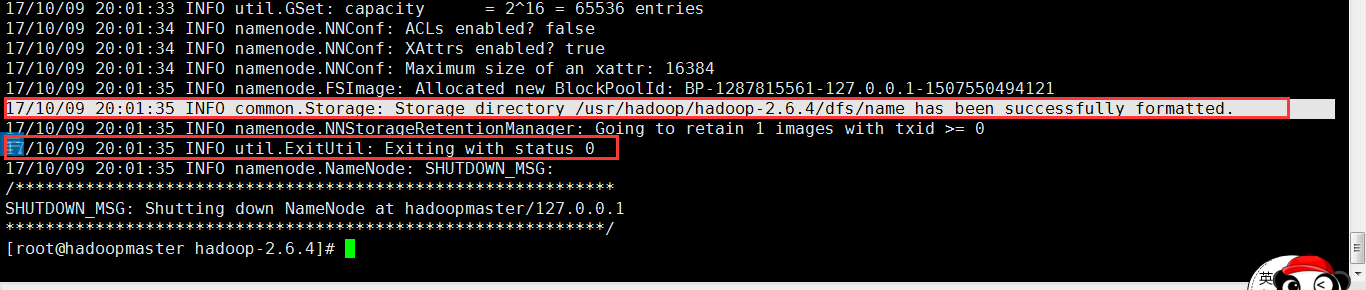

七、 格式化namenode

在hadoop的安装目录下执行命令

bin/hdfs namenode –format

输出下面日志就是格式化成功:

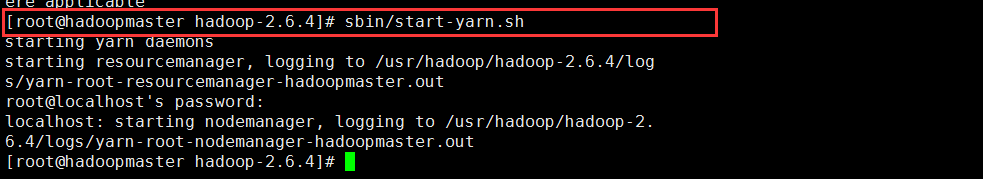

八、 启动Hadoop

进入hadoop文件目录cd/usr/hadoop/hadoop-2.6.4

启动start-dfs.sh文件:

启动start-yarn.sh文件:

九、 验证是否启动成功

进入hadoop安装文件的sbin目录输入命令jps

本文详细介绍Hadoop的安装步骤,包括环境搭建、配置文件修改、环境变量设置及启动验证等关键环节,帮助读者快速掌握Hadoop集群部署。

本文详细介绍Hadoop的安装步骤,包括环境搭建、配置文件修改、环境变量设置及启动验证等关键环节,帮助读者快速掌握Hadoop集群部署。

1394

1394

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?