Transformer 模型

Transformer 模型是一种基于注意力机制的深度学习模型,最初由 Vaswani 等人在 2017 年的论文《Attention is All You Need》中提出。

Transformer 彻底改变了自然语言处理(NLP)领域,并逐渐扩展到计算机视觉(CV)等领域。

Transformer 的核心思想是完全摒弃传统的循环神经网络(RNN)结构,仅依赖注意力机制来处理序列数据,从而实现更高的并行性和更快的训练速度。

以下是 Transformer 架构图,左边为编码器,右边为解码器。

Transformer 模型由 编码器(Encoder) 和 解码器(Decoder) 两部分组成,每部分都由多层堆叠的相同模块构成。

编码器(Encoder)

编码器由 NN 层相同的模块堆叠而成,每层包含两个子层:

- 多头自注意力机制(Multi-Head Self-Attention):计算输入序列中每个词与其他词的相关性。

- 前馈神经网络(Feed-Forward Neural Network):对每个词进行独立的非线性变换。

每个子层后面都接有 残差连接(Residual Connection) 和 层归一化(Layer Normalization)。

解码器(Decoder)

解码器也由 NN 层相同的模块堆叠而成,每层包含三个子层:

- 掩码多头自注意力机制(Masked Multi-Head Self-Attention):计算输出序列中每个词与前面词的相关性(使用掩码防止未来信息泄露)。

- 编码器-解码器注意力机制(Encoder-Decoder Attention):计算输出序列与输入序列的相关性。

- 前馈神经网络(Feed-Forward Neural Network):对每个词进行独立的非线性变换。

同样,每个子层后面都接有残差连接和层归一化。

在 Transformer 模型出现之前,NLP 领域的主流模型是基于 RNN 的架构,如长短期记忆网络(LSTM)和门控循环单元(GRU)。这些模型通过顺序处理输入数据来捕捉序列中的依赖关系,但存在以下问题:

-

梯度消失问题:长距离依赖关系难以捕捉。

-

顺序计算的局限性:无法充分利用现代硬件的并行计算能力,训练效率低下。

Transformer 通过引入自注意力机制解决了这些问题,允许模型同时处理整个输入序列,并动态地为序列中的每个位置分配不同的权重。

Transformer 的核心思想

1. 自注意力机制(Self-Attention)

自注意力机制是 Transformer 的核心组件。

自注意力机制允许模型在处理序列时,动态地为每个位置分配不同的权重,从而捕捉序列中任意两个位置之间的依赖关系。

-

输入表示:输入序列中的每个词(或标记)通过词嵌入(Embedding)转换为向量表示。

-

注意力权重计算:通过计算查询(Query)、键(Key)和值(Value)之间的点积,得到每个词与其他词的相关性权重。

-

加权求和:使用注意力权重对值(Value)进行加权求和,得到每个词的上下文表示。

公式如下:

其中:

- QQ 是查询矩阵,KK 是键矩阵,VV 是值矩阵。

- dkdk 是向量的维度,用于缩放点积,防止梯度爆炸。

多头注意力(Multi-Head Attention)

为了捕捉更丰富的特征,Transformer 使用多头注意力机制。它将输入分成多个子空间,每个子空间独立计算注意力,最后将结果拼接起来。

-

多头注意力的优势:允许模型关注序列中不同的部分,例如语法结构、语义关系等。

-

并行计算:多个注意力头可以并行计算,提高效率。

位置编码(Positional Encoding)

由于 Transformer 没有显式的序列信息(如 RNN 中的时间步),位置编码被用来为输入序列中的每个词添加位置信息。通常使用正弦和余弦函数生成位置编码:

其中:

pospos 是词的位置,ii 是维度索引。

编码器-解码器架构

Transformer 模型由编码器和解码器两部分组成:

- 编码器:将输入序列转换为一系列隐藏表示。每个编码器层包含一个自注意力机制和一个前馈神经网络。

- 解码器:

根据编码器的输出生成目标序列。每个解码器层包含两个注意力机制(自注意力和编码器-解码器注意力)和一个前馈神经网络。

前馈神经网络(Feed-Forward Neural Network)

每个编码器和解码器层都包含一个前馈神经网络,通常由两个全连接层组成,中间使用 ReLU 激活函数。

残差连接和层归一化

为了稳定训练过程,每个子层(如自注意力层和前馈神经网络)后面都会接一个残差连接和层归一化(Layer Normalization)。

Transformer 的优势

-

并行计算:Transformer 可以同时处理整个输入序列,充分利用现代硬件的并行计算能力。

-

长距离依赖:自注意力机制能够捕捉序列中任意两个位置之间的依赖关系,解决了 RNN 的梯度消失问题。

-

可扩展性:Transformer 模型可以通过堆叠更多的层来提升性能,例如 BERT 和 GPT 等模型。

Transformer 的应用

-

自然语言处理(NLP):

-

机器翻译(如 Google Translate)

-

文本生成(如 GPT 系列模型)

-

文本分类、问答系统等。

-

-

计算机视觉(CV):

-

图像分类(如 Vision Transformer)

-

目标检测、图像生成等。

-

-

多模态任务:

-

结合文本和图像的任务(如 CLIP、DALL-E)。

-

实例:

import torch

import torch.nn as nn

import torch.optim as optim

class TransformerModel(nn.Module):

def __init__(self, input_dim, model_dim, num_heads, num_layers, output_dim):

super(TransformerModel, self).__init__()

self.embedding = nn.Embedding(input_dim, model_dim)

self.positional_encoding = nn.Parameter(torch.zeros(1, 1000, model_dim)) # 假设序列长度最大为1000

self.transformer = nn.Transformer(d_model=model_dim, nhead=num_heads, num_encoder_layers=num_layers)

self.fc = nn.Linear(model_dim, output_dim)

def forward(self, src, tgt):

src_seq_length, tgt_seq_length = src.size(1), tgt.size(1)

src = self.embedding(src) + self.positional_encoding[:, :src_seq_length, :]

tgt = self.embedding(tgt) + self.positional_encoding[:, :tgt_seq_length, :]

transformer_output = self.transformer(src, tgt)

output = self.fc(transformer_output)

return output

# 超参数

input_dim = 10000 # 词汇表大小

model_dim = 512 # 模型维度

num_heads = 8 # 多头注意力头数

num_layers = 6 # 编码器和解码器层数

output_dim = 10000 # 输出维度(通常与词汇表大小相同)

# 初始化模型、损失函数和优化器

model = TransformerModel(input_dim, model_dim, num_heads, num_layers, output_dim)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 假设输入数据

src = torch.randint(0, input_dim, (10, 32)) # (序列长度, 批量大小)

tgt = torch.randint(0, input_dim, (20, 32)) # (序列长度, 批量大小)

# 前向传播

output = model(src, tgt)

# 计算损失

loss = criterion(output.view(-1, output_dim), tgt.view(-1))

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

print("Loss:", loss.item()

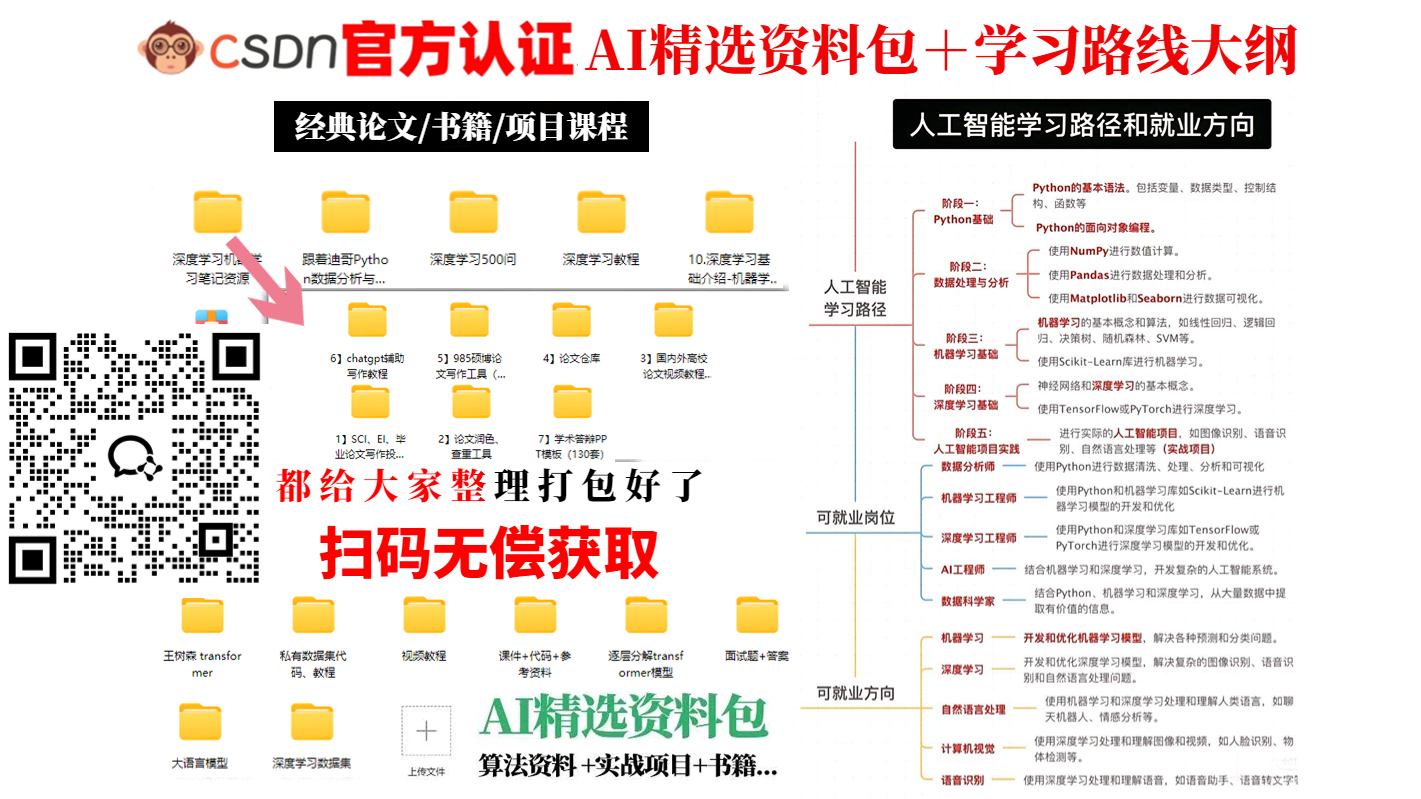

优快云粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传优快云,朋友们如果需要可以扫描下方二维码&点击下方优快云官方认证链接免费领取 【保证100%免费】

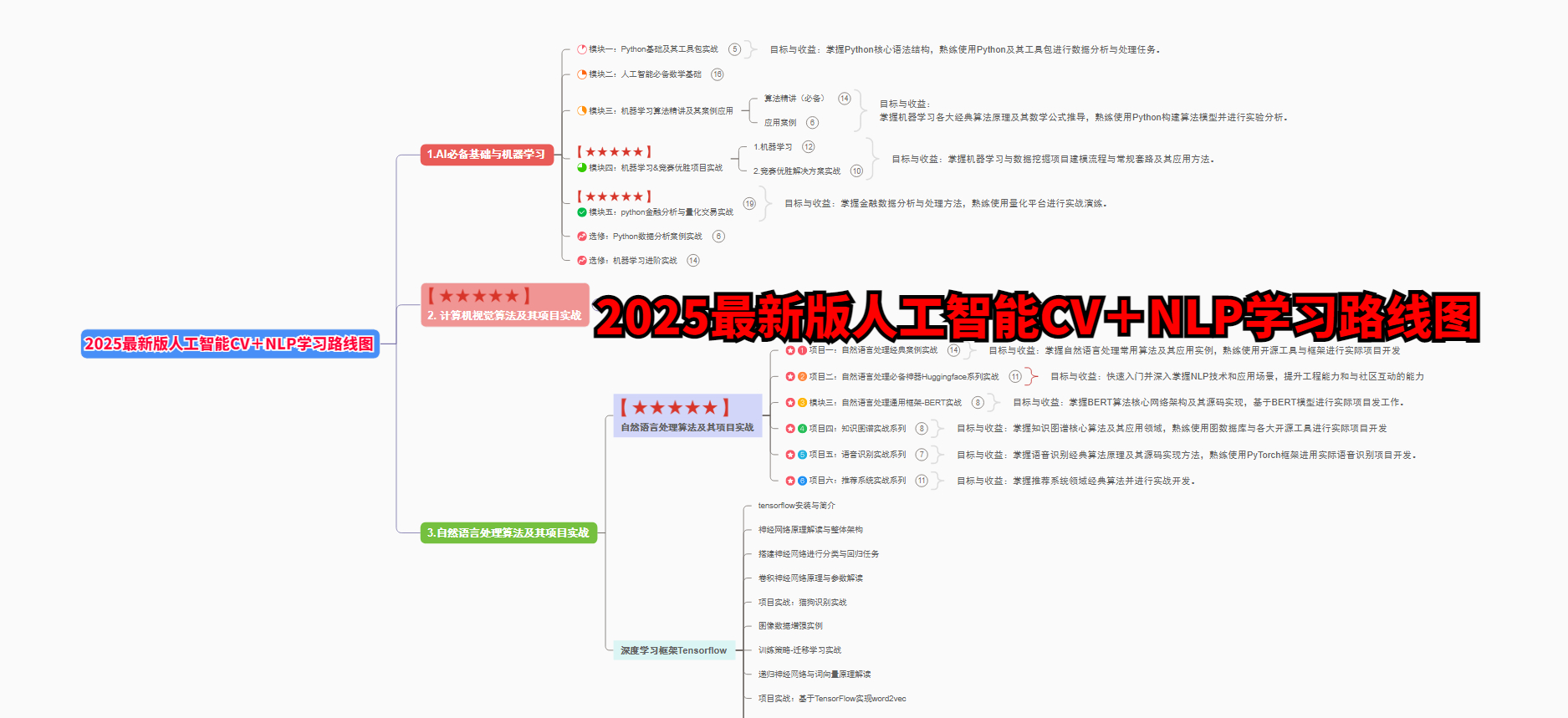

👉1.2025最新版人工智能CV+NLP入门学习思维导图👈

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

稍微导图链接:https://www.processon.com/view/link/650d85c2ec3841522691f8da

对于从来没有接触过人工智能CV+NLP的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

(全套教程文末领取哈)

————————————————

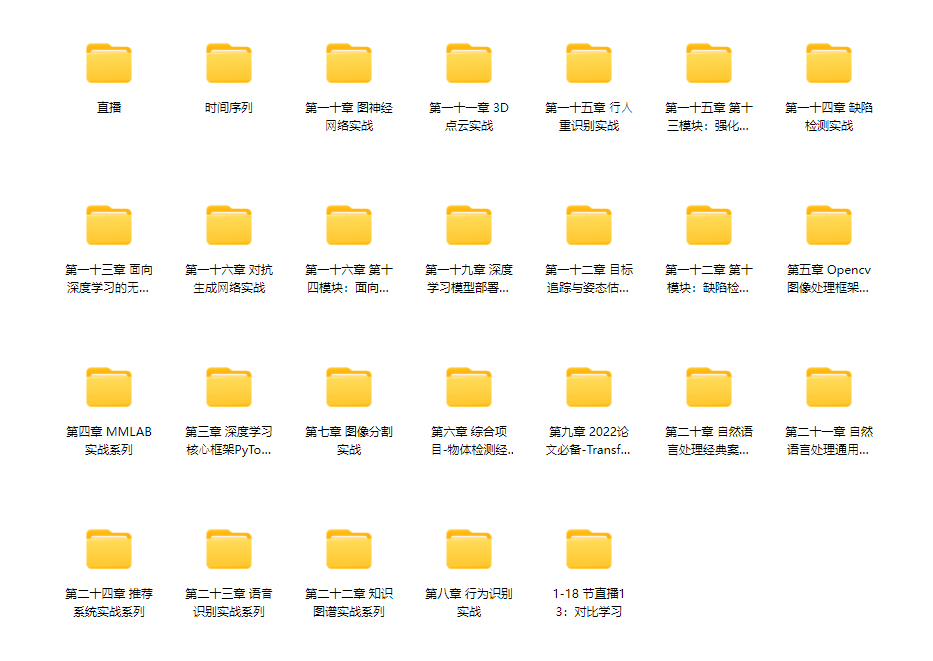

👉2.人工智能CV+NLP配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。

800G视频配套资料:

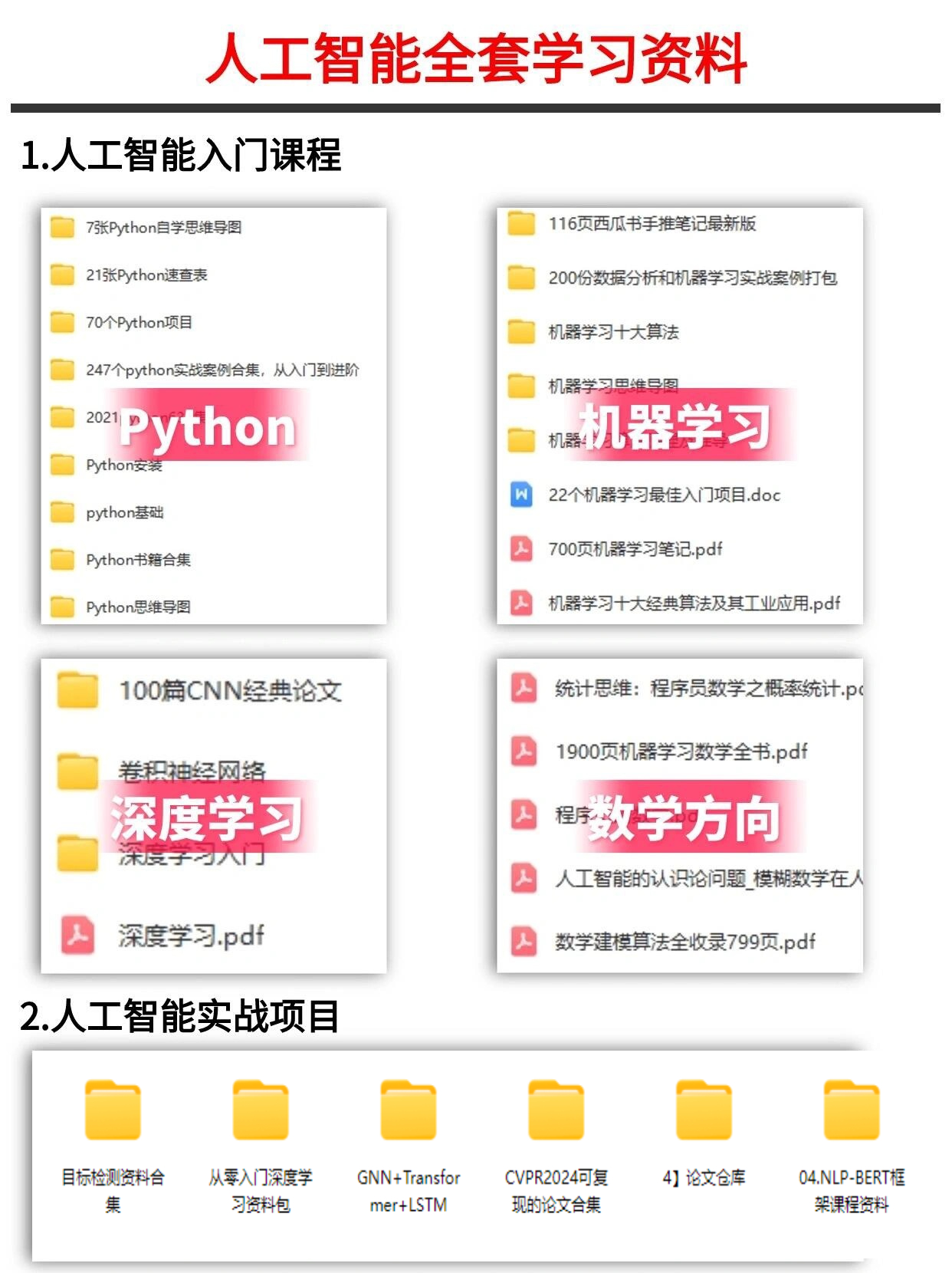

👉3.人工智能CV+NLP全套学习资料👈

1.python从入门到实战

2.机器学习从入门到项目实战

3.深度学习经典论文

4.数学方向知识汇总

5.人工智能项目实战

。。。。。。(全套教程文末领取哈)

👉4.人工智能CV+NLP+大模型经典学习电子书👈

随着人工智能技术的飞速发展,人工智能已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(全套教程文末领取哈)

👉5.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(全套教程文末领取哈)

优快云粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传优快云,朋友们如果需要可以扫描下方二维码&点击下方优快云官方认证链接免费领取 【保证100%免费】

————————————————

9万+

9万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?