文章目录

MAP:通过掩码自回归预训练释放混合Mamba-Transformer视觉主干的潜力

论文:https://openaccess.thecvf.com/content/CVPR2025/papers/Liu_MAP_Unleashing_Hybrid_Mamba-Transformer_Vision_Backbones_Potential_with_Masked_Autoregressive_CVPR_2025_paper.pdf

代码:https://github.com/yunzeliu/MAP

年份:2025

创新点

- 其团队的主要创新方向可从混合架构专属预训练策略创新、Mamba 预训练关键原理突破、跨场景通用性验证创新三方面总结:

- 第一,针对混合架构中 Mamba 与 Transformer 组件特征捕捉逻辑差异大、现有单一预训练策略无法兼容的问题,MAP 通过分层预训练目标融合 MAE 与 AR 的优势,在统一范式中同时优化两类组件,同时,平衡确定 50% 掩码比,平衡 MAE(Transformer 最优 75%)与 AR(Mamba 最优 20%)的需求,从而实现了两类组件性能协同提升。

- 第二,团队成员合作通过系统性实验,首次明确 Mamba 有效预训练的两个核心条件,为混合架构设计提供理论支撑,填补了 Mamba 预训练机制研究的空白,其一是预训练顺序与扫描顺序一致性:当 AR 预训练顺序与 Mamba 扫描顺序匹配时,性能提升显著;其二是最优掩码比例区间:Mamba 的 AR 预训练存在 20%-30% 的最优掩码比例区间。

- 第三,团队成员突破了现有预训练策略 “单架构适配” 局限,验证了 MAP 的跨架构、跨任务与跨数据格式通用性,证明 MAP 在多场景下的有效性,拓展了预训练方法的适用边界:1.跨架构适配;2.跨 2D 任务有效性;3.跨 3D 数据格式的适配。

思路模块

实验核心目标与逻辑

MAP论文实验主要围绕验证Masked Autoregressive Pretraining(MAP)策略的有效性展开,核心目标是来解决“混合 Mamba-Transformer 架构的预训练适配性” 问题,团队采取“先单组件分析(Transformer/Mamba 独立预训练特性)→ 然后再混合架构验证(MAP 对 HybridNet 的提升)→ 最后跨任务扩展(2D/3D 任务泛化性)”的逻辑,并通过消融实验验证 MAP 各组件的必要性。

掩码自回归预训练策略

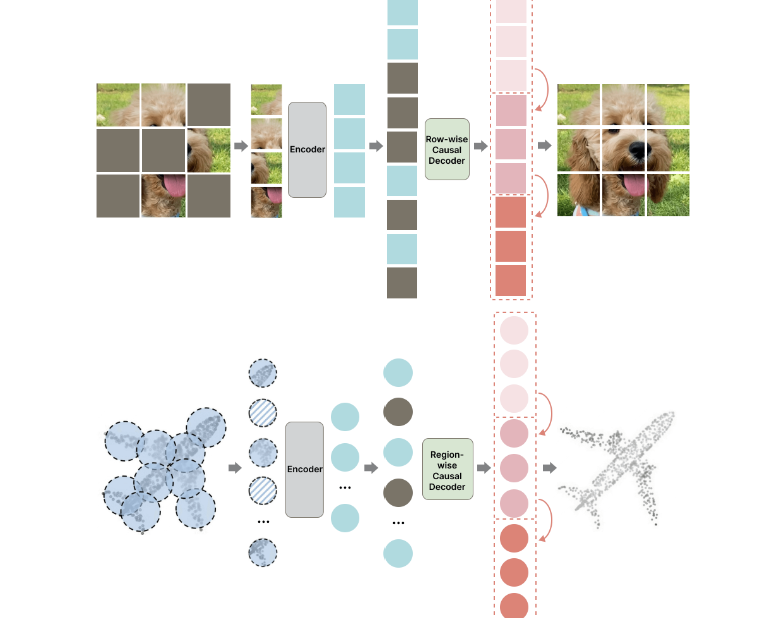

图1. 我们提出了掩码自回归预训练方法,用于预训练混合的Mamba-Transformer骨干网络。该方法在2D和3D任务上均表现出显著的性能提升

1.背景

现有的预训练方法,如掩码自编码器或自回归预训练,主要都只适配于单一类型的网络架构,因此需要追求一种对Mamba和Transformer组件都有效的混合架构的预训练,基于此,团队成员提出了掩码自回归预训练(MAP)方法,结合MAE和自回归预训练的优势,从而在统一框架下提升混合Mamba和Transformer模块的性能。

2.局部MAE

将图像划分为多个局部区域(如行),对每个区域内的 tokens 随机掩码;

要求网络基于区域内未掩码 tokens 的双向局部信息,预测该区域内所有掩码 tokens,强化 Transformer 捕捉局部特征关联的能力

3.全局自回归

以局部区域(如行)为单位,按顺序(如行优先,匹配 Mamba 默认扫描顺序) autoregressively 生成后续区域;

后续区域的预测需依赖所有先前已解码区域的信息,让 Mamba 学习全局上下文依赖关系。

4.掩码自回归预训练的优势

首先,MAP的核心点在于分层预训练目标,其通过 “局部 MAE + 全局自回归” 的双机制,分别适配 Transformer 与 Mamba 组件,实现二者协同优化。

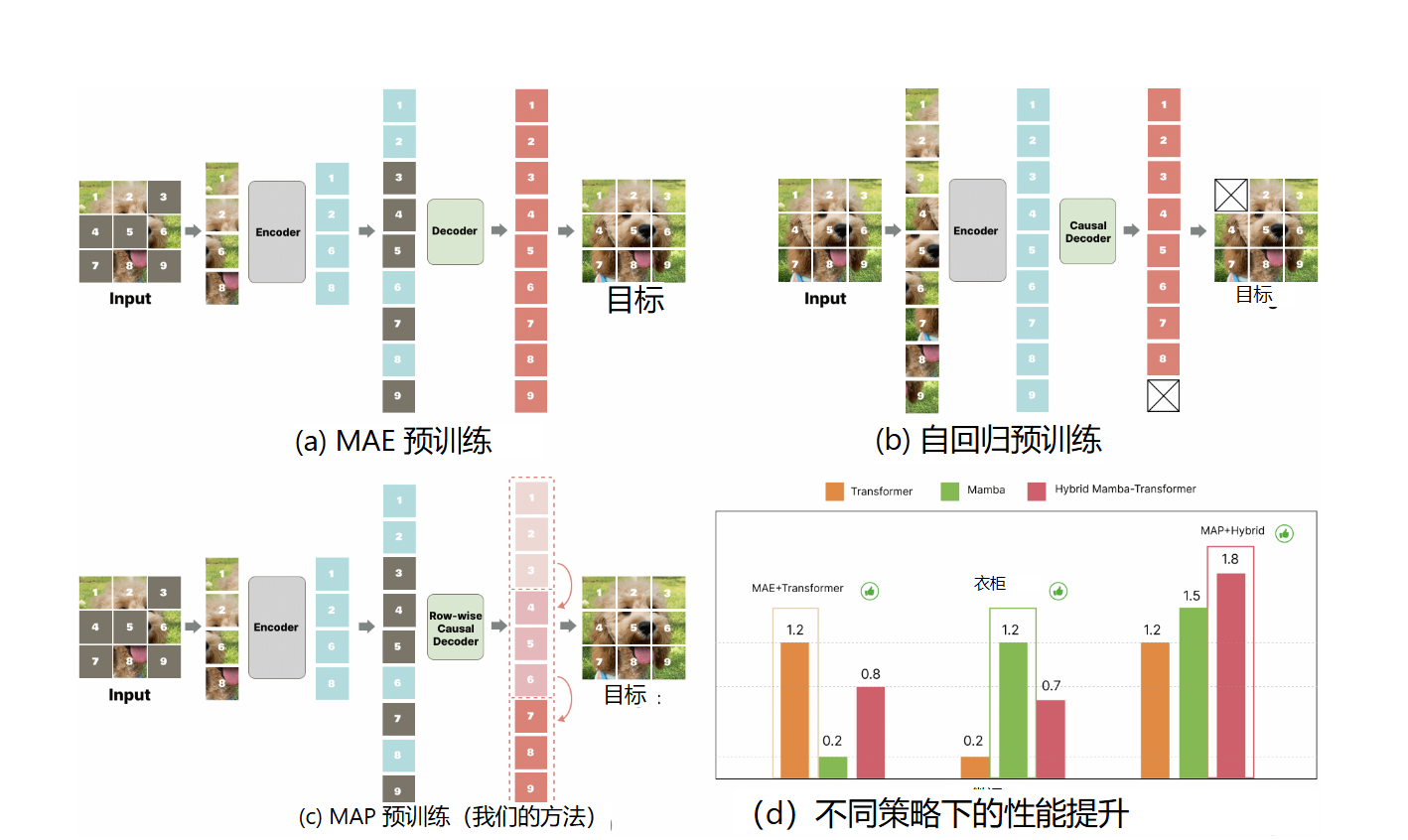

图2.(a)MAE预训练。其核心在于基于未掩码的标记重建掩码标记,以建立全局双向上下文理解。(b)AR预训练。它专注于建立上下文之间的关联,其可扩展性在大型语言模型领域已得到充分验证。(c)MAP预训练(我们提出的方法)。我们的方法首先随机掩码输入图像,然后以逐行自回归的方式重建原始图像。这种预训练方法在建模局部特征的上下文特征以及局部特征之间的关联方面表现出显著优势,使其与Mamba-Transformer混合架构高度兼容。(d)在ImageNet-1K上不同预训练策略下的性能提升

可以看出,我们的方法在两种预训练方法之间寻求到了平衡点。其中局部MAE用于让Transformer块学习良好的局部注意力,而全局自回归预训练则使Mamba块能够学习有意义的上下文信息。

- 局部MAE:让 Transformer 当 “局部拼图高手”,眼中没有其它行,专心练 “看同一行的局部信息,补同一行细节”的能力

- 自回归生成:以 “行” 为单位,让 Mamba 按 “第一行→第二行→第三行” 的顺序还原图像,生成下一行时必须参考前面所有行的内容

这样设计的原因:

Transformer擅长双向关联的优势,而Mamba的特点则是单向扫描、擅长长上下文关联的特点,避免逻辑断裂。

- 双向关联:这里可将Transformer比喻为“局部细节侦探”,双向关联就是它能同时看 “左边树叶纹理” 和 “右边叶脉走向”,局部 MAE 让它练会从这些双向细节里补全缺口,先把各个小部分处理好

- 单向扫描、长上下文关联:Mamba 就像按顺序读故事的人,只能从开头往后看(单向扫描),还特别会记前情(长上下文关联)。自回归生成就让它 “看完前几页,再写下一页”,不会出现 “前页说猫,后页突然写狗转场” 的逻辑断档。

策略研究

1.探索性实验

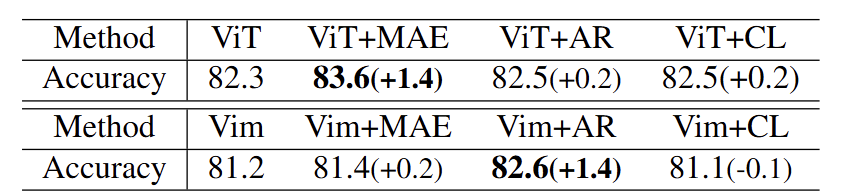

核心目标:MAE、AR、对比学习(CL)分别对哪种组件更有效?

- MAE:默认配置(全局随机掩码 75%,编码器 - 解码器重建);

- AR:行优先顺序处理图像 token,掩码 40 个 token(20% 掩码率);

- CL:仅用裁剪 / 缩放数据增强,基于 MoCov2 框架预训练;

- 统一条件:图像分辨率 224×224,均从 scratch 训练后评估下游分类准确率。

通过该实验来确定MAE是否同样适用Vim,或者自回归策略是否更合适:

表1. 试点研究。我们使用ViT-B和Vim-B作为默认配置。AR策略按行优先顺序处理图像令牌,而MAE则按照默认设置运行。对于对比学习,我们仅使用裁剪和缩放数据增强,并使用MoCov2进行预训练。所有实验均在224×224的分辨率下进行

这里,ViT-B(24 层 Transformer+8 层额外 Transformer)Vim-B(视觉 Mamba 基础版)

通过对比两种模型的准确率提升效果,发现:

- MAE 是 Transformer 的 “最优解”,AR 是 Mamba 的 “最优解”,但二者无法通用 —— 用 MAE 预训练混合架构会抑制 Mamba,用 AR 则会浪费 Transformer 的双向建模能力

- 需设计一种策略,既能保留 MAE 对 Transformer 的 “局部双向建模” 优势,又能继承 AR 对 Mamba 的 “长上下文时序建模” 优势

注:局部双向建模就像让模型同时看这版拼图 “左边没缺的块” 和 “右边没缺的块”

比如从 “树叶左边的纹路” 和 “右边的叶脉” 一起,补全中间缺的 “树叶边缘”。

2.Mamba 预训练关键因素诊断:为 MAP 提供设计依据

- Mamba 的核心是 “按固定顺序扫描序列”(如行优先、列优先),AR 预训练顺序需与 Mamba 扫描顺序一致

图3. AR预训练和Mamba扫描的不同顺序。行优先和列优先顺序使网络能够以不同的方式和序列感知局部信息

实验设计

- 变量:Mamba 扫描顺序(行优先 Vim ( R)、列优先 Vim ( C))、AR 预测顺序(行优先 AR ( R)、列优先 AR ( C));

- 任务:ImageNet-1K 分类,评估不同组合的准确率

核心结果

表2. AR阶数对下游任务的影响

分析总结

Mamba 的 AR 预训练必须满足 “预测顺序 = 扫描顺序”,否则无法发挥其长上下文建模优势 —— 这为 MAP 中 “以行为单位自回归”(匹配 Mamba 默认行优先扫描)提供了直接依据

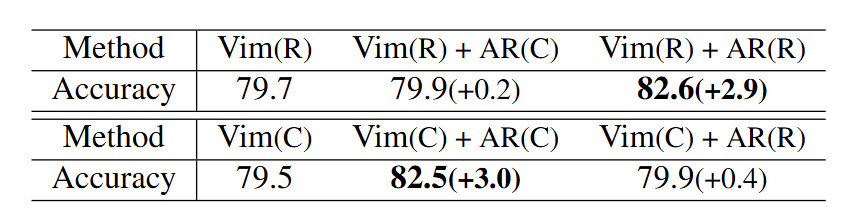

- 确定Mamba-AR 合适的掩码率

实验设计

- 变量:掩码 token 数量(1 个 = 0.5%、20 个 = 10%、40 个 = 20%、60 个 = 30%、100 个 = 50%、140 个 = 70%);

- 任务:ImageNet-1K 分类,记录不同掩码率下的下游准确率

核心结果

表3. 掩码比例对自回归预训练的影响

分析总结

Mamba-AR 的最优掩码率为20%:既鼓励模型学习丰富特征,又不会因上下文不足导致预测困难 —— 这为 MAP 中 “50% 全局掩码率”(平衡 Transformer-MAE 的 75% 和 Mamba-AR 的 20%)提供了参考依据

3.MAP的核心策略探究

-

- 分层预训练目标:局部 MAE(适配 Transformer)+ 全局 AR(适配 Mamba)

-

- 掩码策略:随机掩码 + 50% 掩码率:

-

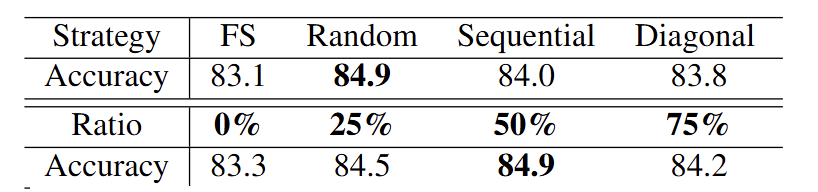

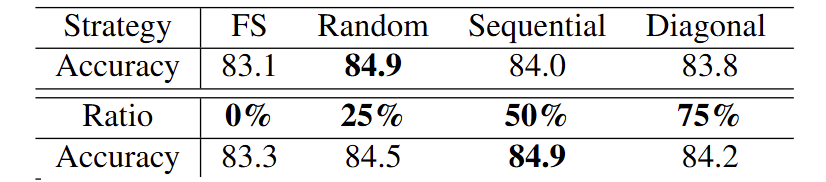

掩码方式:随机掩码最优 // 顺序掩码 / 对角线掩码会限制 Transformer 的双向注意力(只能看单侧 token),而随机掩码能保留双向建模能力,同时增强 Mamba 的序列泛化性

-

-

掩码率:50% 最优 // MAE 对 Transformer 的最优掩码率是 75%(高掩码强制学习全局特征),AR 对 Mamba 的最优是 20%(低掩码保证上下文充足),50% 作为折中,同时适配两种组件

MAP方法实现

基础阶段:混合网络(HybridNet)的确定

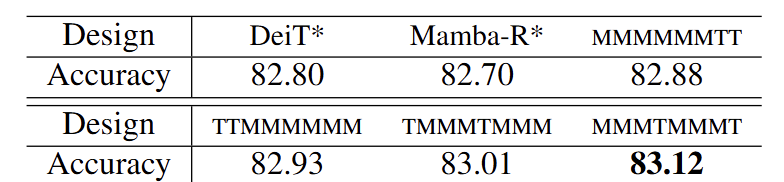

初步说明。本文的重点在于研究如何对混合Mamba-Transformer框架进行预训练,而非设计混合框架本身。因此,我们首先确定了一个混合网络作为研究的默认框架。我们尝试了一系列混合Mamba-Transformer视觉骨干网络,并对比了它们从零开始训练时的性能。结果表明,采用MMMTMMMT的混合方法表现最佳

从原论文中总结出目标:解决 “仅在 Mamba 后追加 Transformer(如 MMMMMMTT)无法充分利用局部特征” 的问题,需让 Transformer 尽早参与局部特征提取,同时保留 Mamba 的长上下文优势。

表4. Mamba-Transformer骨干网络的混合设计。所有实验均从头开始训练。Mamba-R表示24个MambaR[46] Mamba层加8个额外的Mamba层。DeiT表示24个DeiT[43] Transformer层加8个额外的Transformer层。MMMMMMTT表示24个Mamba层后接8个Transformer层。TTMMMMMM表示8个Transformer层后接24个Mamba层。TMMMTMMM表示由1个Transformer层和3个Mamba层组成的单元,重复8次。MMMTMMMT表示由3个Mamba层后接1个Transformer层组成的单元,重复8次

最终通过对比实验在 ImageNet-1K 上测试的分类准确率,确定采用 “MMMTMMMT” 作为默认混合网络(HybridNet),后续所有 MAP 相关实验均基于此架构展开。

注:MAP 同样也可以适配其他 Mamba-Transformer 混合架构,本论文当中并未把网络结构设计作为重点

分层预训练目标与实现逻辑

整体流程

- 随机掩码:对输入图像的 token 进行全局 50% 随机掩码(按行划分局部区域,每区域内随机掩码部分 token);

- 特征编码:HybridNet(Mamba+Transformer 混合架构)将掩码后的图像映射到特征空间;

- 行 - wise 重建:用 Transformer 解码器按 “行优先” 顺序 autoregressively 重建图像 —— 先基于前序行信息 + 当前行未掩码 token,预测当前行掩码 token,依次完成所有行重建

对应数学核心公式实现

MAP 关键设计组件与实验验证

在论文中我们通过控制变量实验,对MAP 中 “掩码策略、解码器类型、重建目标” 三大核心组件进行验证:

掩码策略:随机掩码 + 50% 掩码率

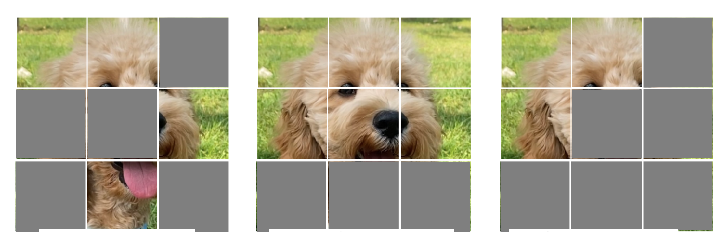

图5. 不同的掩码策略。从左至右依次为随机掩码、顺序掩码、对角线掩码

表5. 50%比例的随机掩码效果最佳

结果:

- 对比不同掩码方式与掩码率,在随机掩码方式下,准确率达84.9%在此方式下既保留 Transformer 双向注意力能力,同时增强 Mamba 的序列泛化性。

- 掩码率为50%时,达最优平衡:MAE 对 Transformer 最优掩码率 75%,AR 对 Mamba 最优 20%,50% 兼顾两者

解码器设计:Transformer 解码器 + 行 - wise 解码

图6. 不同的解码器掩码。绿色表示激活,白色表示未激活

在这里,解码器需实现 “逐行重建”,实验对比 4 种解码器类型,核心是 “能否同时适配局部 MAE 与全局自回归”:

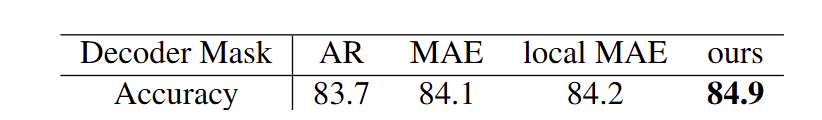

表6. 解码器掩码设计。我们的MAP解码器策略取得了最佳结果

- AR 解码器:仅适配 Mamba 单向扫描,无法同时重建一行内的局部 token,性能最低

- MAE 解码器:仅适配 Transformer 双向重建,无法捕捉行间长上下文,性能有限

- 局部 MAE 解码器:限制 MAE receptive field 在单行,局部建模有提升,但缺乏全局 AR,仍低于 MAP

- MAP 解码器(Transformer + 行 - wise):最优:Transformer 解码器支持行内双向重建(适配局部 MAE),行 - wise 顺序支持全局 AR(适配 Mamba)

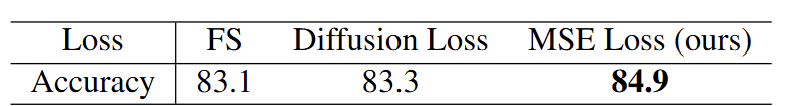

重建目标:归一化像素 + MSE 损失

在这里需要我们需引导模型学习有效特征:

表7. 重建目标

- 无预训练(FS):基线,无特征学习

- 扩散损失(Diffusion Loss):侧重 “生成图像质量”,与编码器预训练目标无关(预训练需特征关联而非视觉效果),提升微乎其微

- MSE 损失(MAP):最优:像素级 MSE 能有效引导模型学习 token 间的局部 / 全局关联,匹配预训练需求

实验

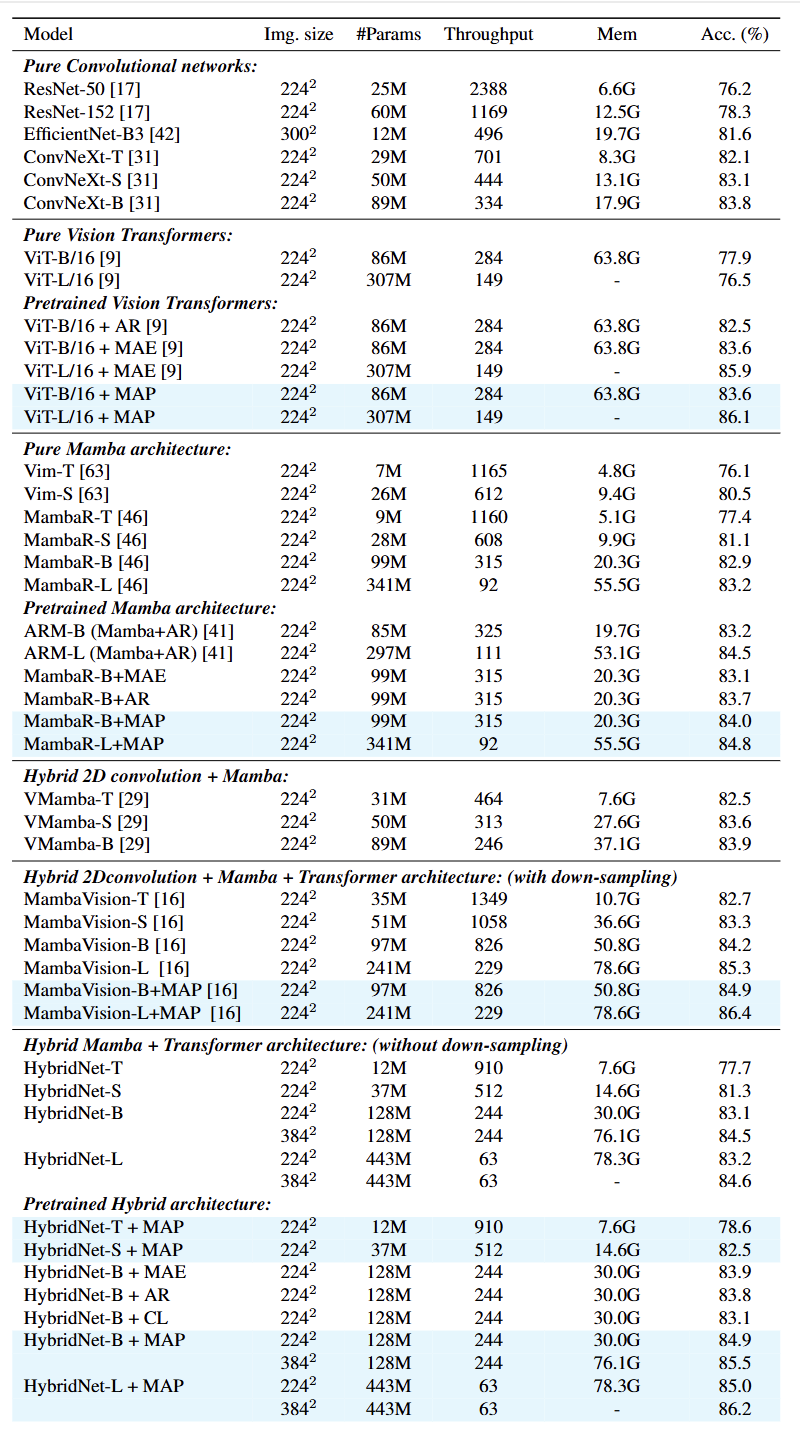

1.2D 分类实验:ImageNet-1K

- 数据集:ImageNet-1K(120 万训练图像,1000 类),预训练用训练集,微调用分类任务验证集;

- 图像分辨率:主要测试 224×224(基础分辨率),部分模型补充 384×384(长序列场景验证);

- 对比模型:覆盖纯卷积网络(ResNet、ConvNeXt)、纯 Vision Transformer(ViT)、纯 Mamba(Vim、MambaR)、混合架构(VMamba、MambaVision、HybridNet)四大类,确保横向可比

表8. ImageNet-1k分类结果。吞吐量在A100 GPU上计算。内存开销以128的批量大小测量。我们的结果以蓝色突出显示

关键结论:MAP 解决了混合架构 “MAE 适配 Transformer 但抑制 Mamba、AR 适配 Mamba 但浪费 Transformer” 的矛盾,且在高分辨率(长序列)场景下性能进一步提升,进而验证 Mamba 长上下文建模能力被 MAP 激活

- MambaVision-L+MAP 准确率 86.4%,较无预训(85.3%)提升 1.1%,证明 MAP 能迁移到其他 Mamba-Transformer 混合架构

- 纯 Vision Transformer(ViT):

ViT-B+MAP 准确率 83.6%,与 MAE 持平(无性能损失); - 纯 Mamba(MambaR-B):

MambaR-B+MAP 准确率 84.0%,优于 AR(83.7%)、MAE(83.1%),证明 MAP 的 “随机掩码 + 局部建模” 比传统 AR 更能增强 Mamba 的局部特征捕捉能力

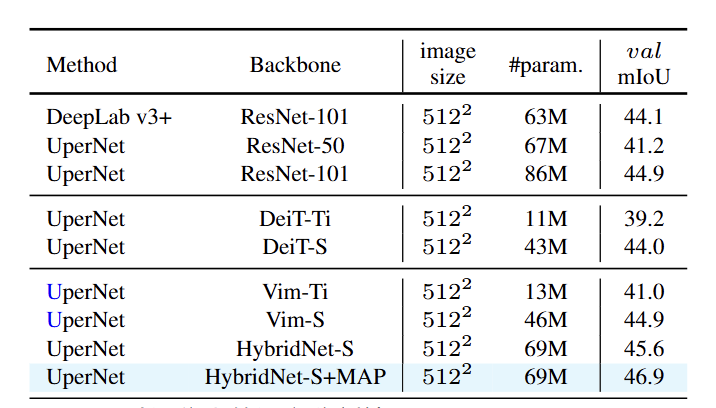

2.迁移学习实验:验证 MAP 在下游密集任务的泛化性

我们在迁移学习中聚焦语义分割(ADE20K) 和目标检测 / 实例分割(COCO 2017),均采用 “预训练 + 下游微调” 范式:

表9. ADE20K验证集上的语义分割结果

结论:MAP 预训练让混合架构在密集分割任务中进一步释放潜力,证明其提取的特征不仅能用于分类,还能捕捉细粒度的空间语义关联(如物体边缘、区域边界)

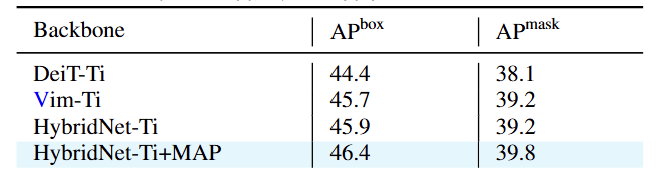

表10. 使用Cascade Mask R-CNN [2]框架在COCO验证集上进行目标检测和实例分割的结果

结论:单纯替换混合架构无法显著提升检测性能,但 MAP 预训练能激活混合架构的协同优势,证明其特征具备 “目标定位 + 实例区分” 的迁移能力

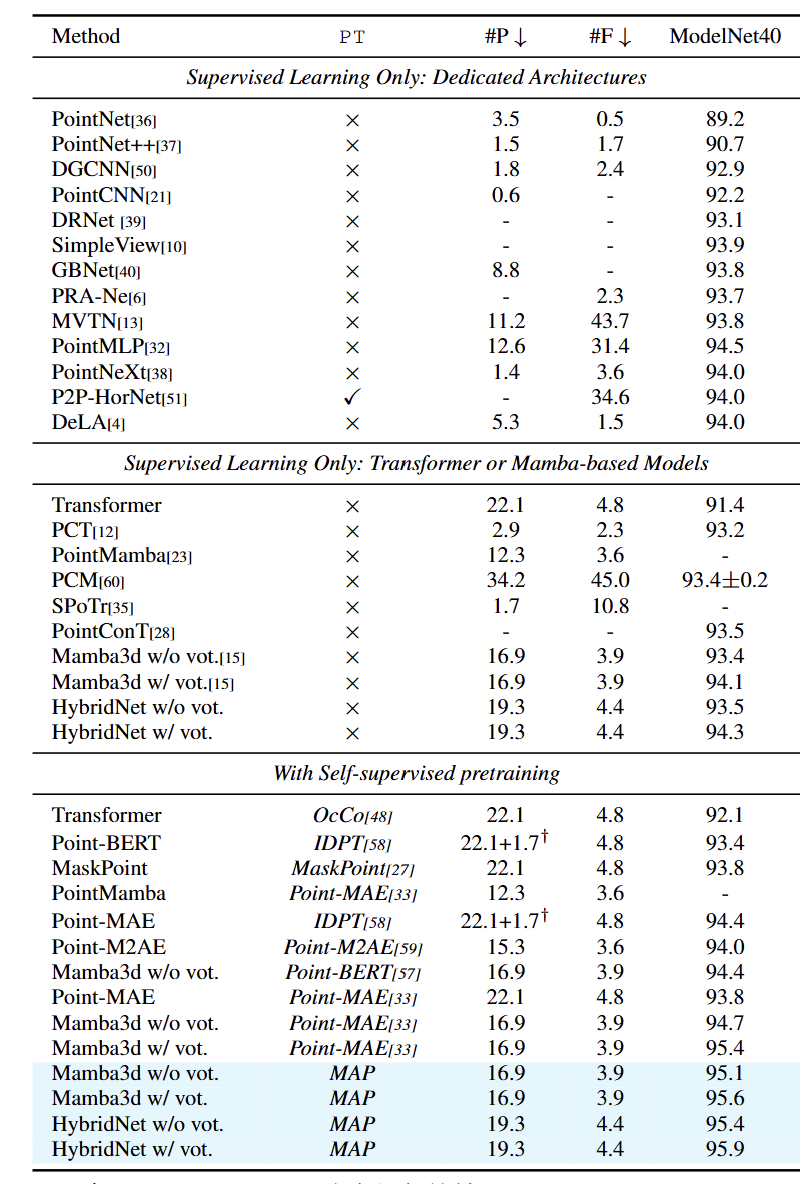

3.3D 分类实验:验证 MAP 跨模态适配性

数据集:

- 预训练:ShapeNet(1.2 万 3D 模型,用于无标签预训练);

- 下游任务:ModelNet40(40 类 3D 物体,评估分类准确率);

表11. 3D ModelNet分类任务的结果

- 真实场景点云(ScanObjectNN):在最具挑战性的 “PB T50 RS” 设置下,HybridNet+MAP 准确率 93.87%,超越 Mamba3d+Point-MAE(93.05%),证明 MAP 在真实噪声数据上的鲁棒性;

- 点云分割(ShapeNetPart):HybridNet+MAP 的类 mIoU(84.7%)和实例 mIoU(86.3%),均高于纯 Mamba+MAP(84.5%/86.0%),证明 MAP 特征适配细粒度 3D 分割任务

总结

当前研究的局限性

- 默认架构仅在静态图像任务(分类、分割)中验证,组件的扩展性受限

- 固定采用 “50% 随机掩码 + Transformer 行 - wise 解码”,未探索动态掩码或轻量化解码器

- 任务覆盖不全面,主实验集中于分类、分割、检测等基础视觉任务,未验证 MAP 在复杂专业领域的泛化性(如视频目标跟踪、3D 场景重建、病理切片分析)

未来研究方向

- 在医学影像(如 CT 图像肿瘤检测)、自动驾驶(如激光雷达点云目标识别)、工业质检(如零件缺陷分割)等专业场景中验证 MAP,分析其在小样本、高噪声、细粒度任务中的表现

结论

MAP 作为首个适配混合 Mamba-Transformer 架构的预训练策略,为视觉领域提供了 “局部双向建模 + 长上下文时序建模” 的优秀统一范式,同时未来通过动态架构设计、场景化策略优化、跨领域延伸等更深层次的研究,有望进一步释放混合 Mamba-Transformer 的潜力,推动视觉预训练技术在更广泛的工业与专业领域落地。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?