吴恩达深度学习笔记week3——浅层神经网络 One hidden layer Neural Network

- 3.1 神经网络概览 Neural Networks Overview

- 3.2 神经网络表示 Neural Network Representation

- 3.3 计算神经网络的输出 Computing a Neural Network's Output

- 3.4 多个例子中的向量化 Vectorizing across multiple examples

- 3.5 向量化实现的解释 Explanation for vectorized implementation

- 3.6 激活函数 Activation functions

- 3.7 为什么需要非线性激活函数?Why do you need non-linear activation functions?

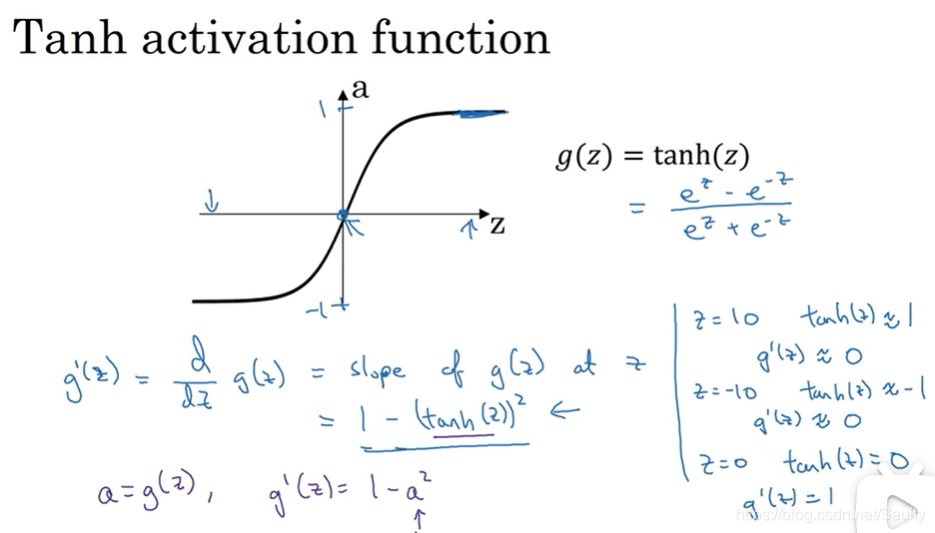

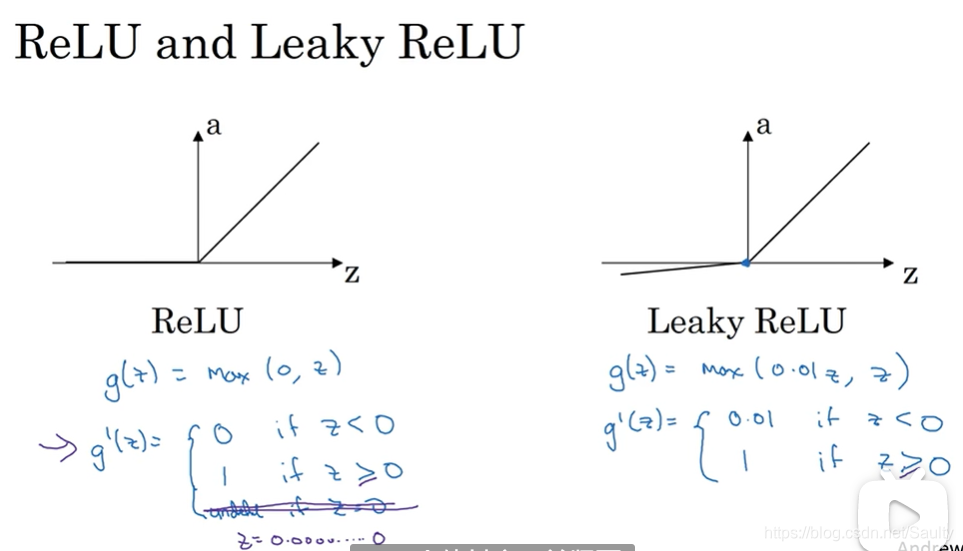

- 3.8 激活函数的导数 Derivatives of activation functions

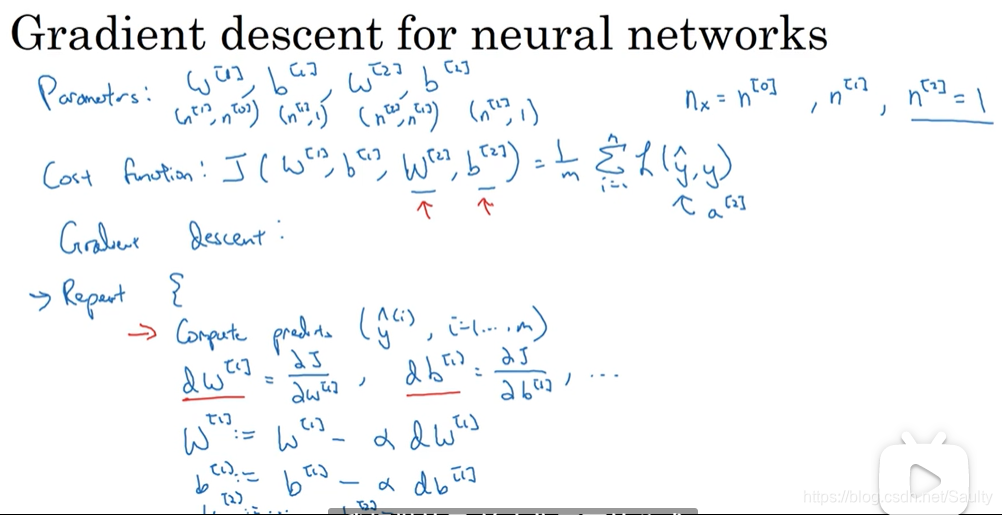

- 3.9 神经网络的梯度下降法 Gradient descent for neural networks

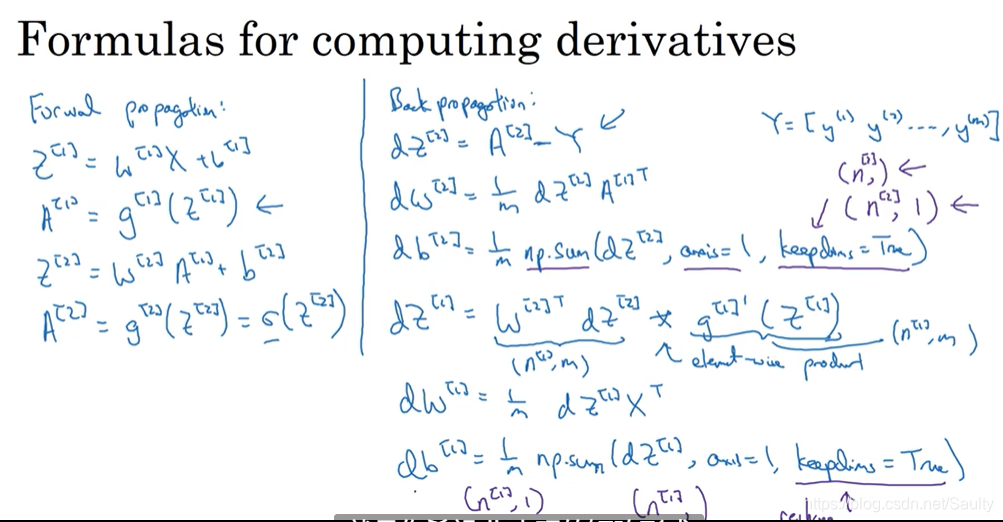

- 3.10 (选修)直观理解反向传播 Backpropagation intuition

- 3.11 随机初始化权重 Random Initialization

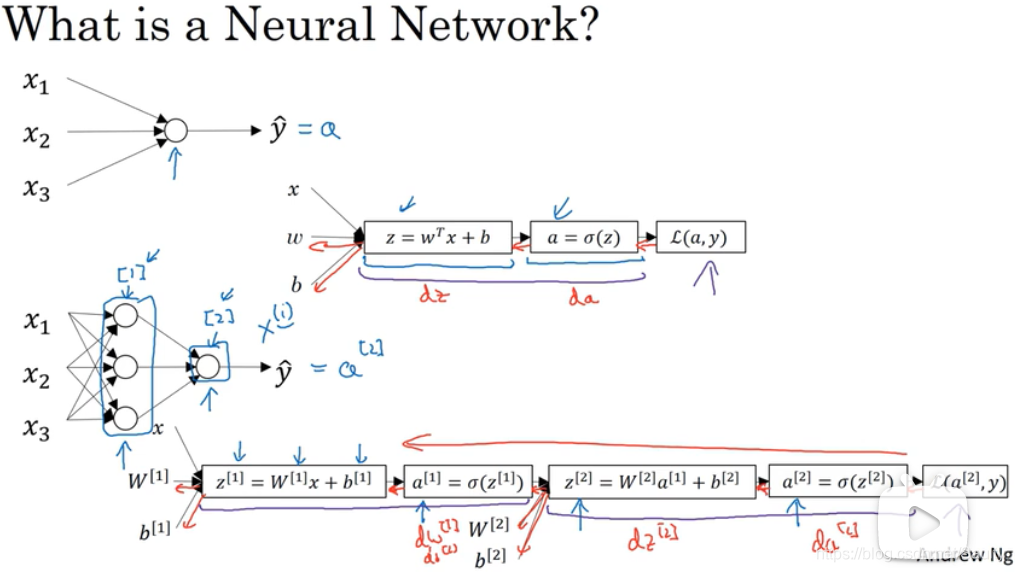

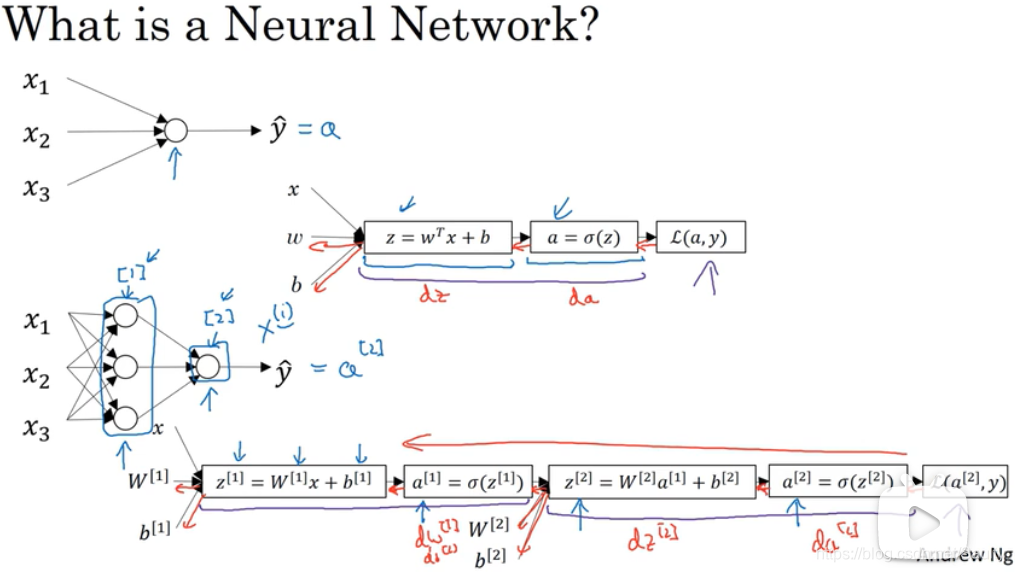

3.1 神经网络概览 Neural Networks Overview

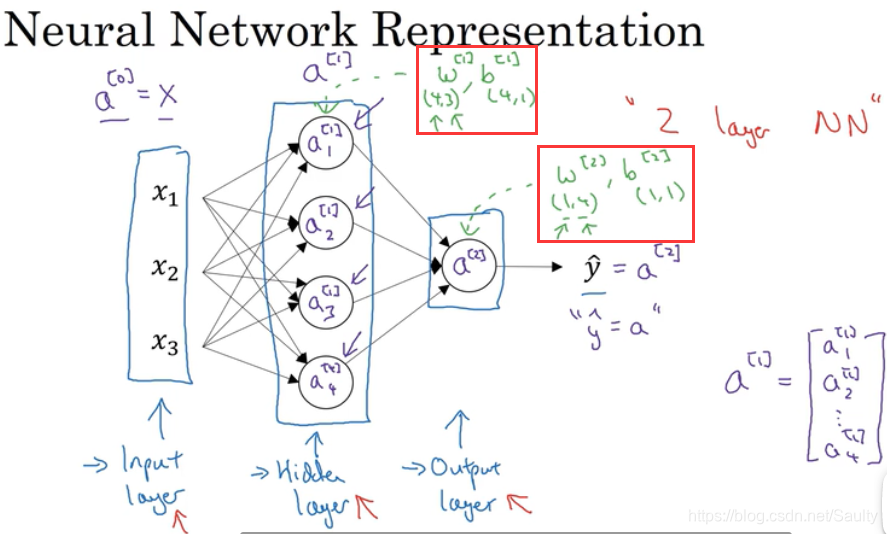

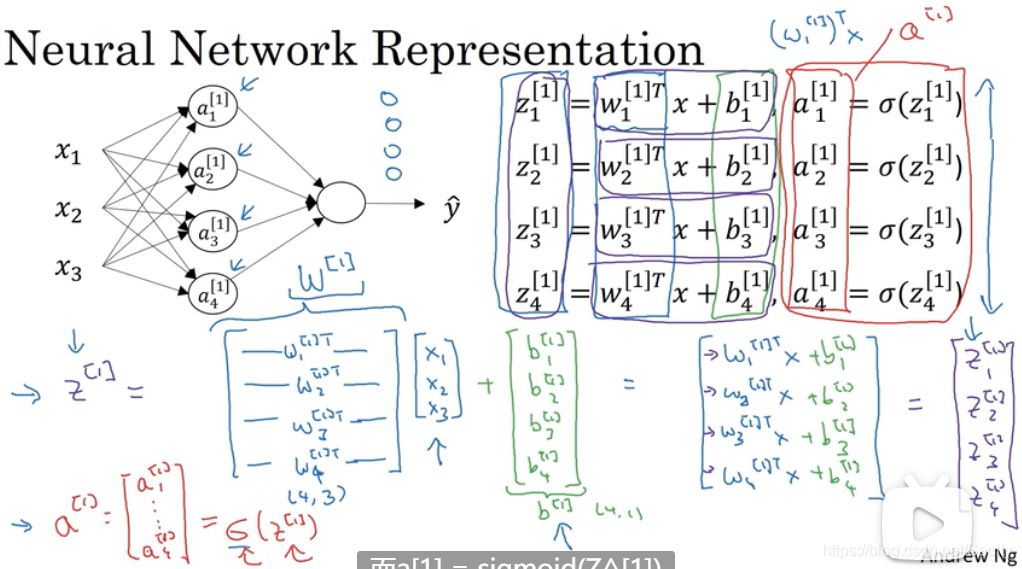

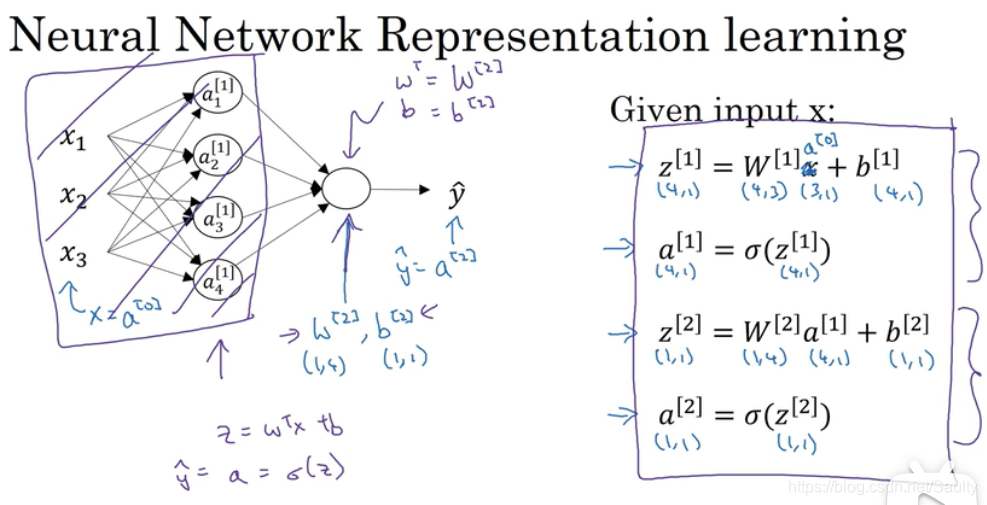

3.2 神经网络表示 Neural Network Representation

- 当我们计算网络层数的时候,一般不算上输入层

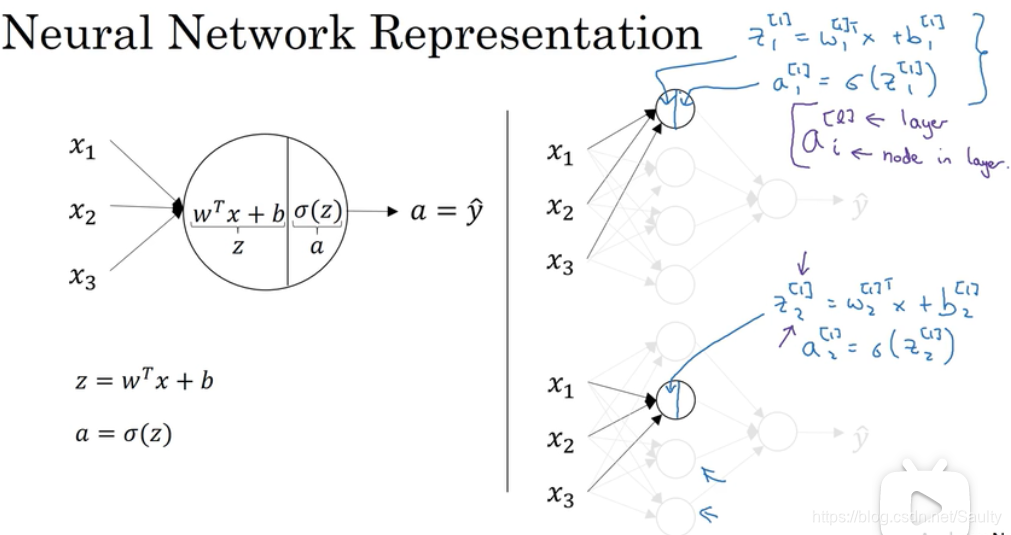

3.3 计算神经网络的输出 Computing a Neural Network’s Output

- 两步走

- 向量化

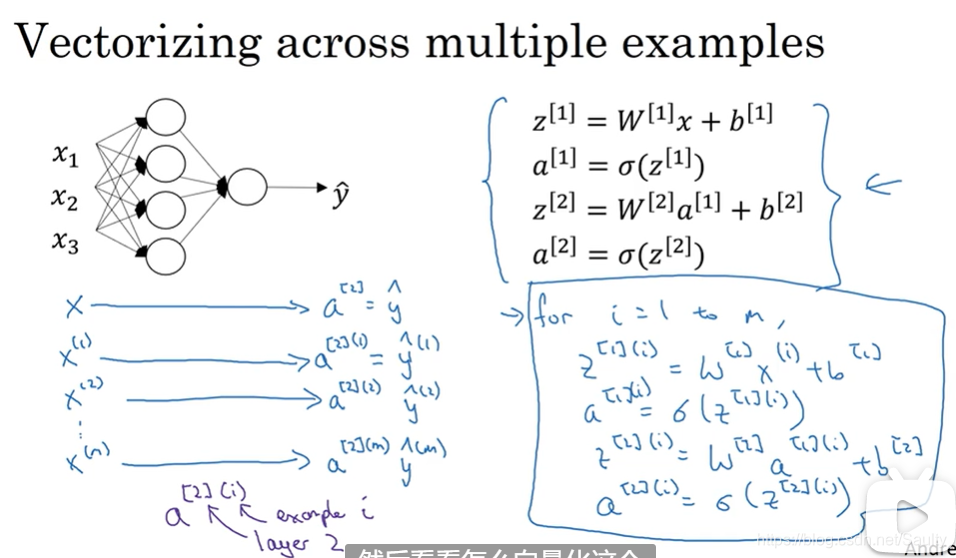

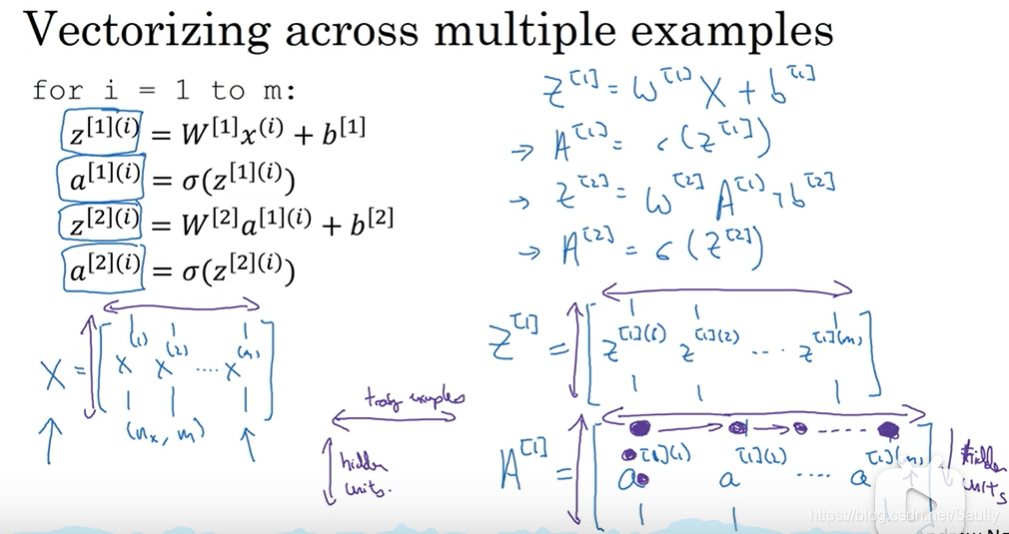

3.4 多个例子中的向量化 Vectorizing across multiple examples

- 注意上标 [ ] 和 ()

()代表第几个样本

[ ] 代表第几层

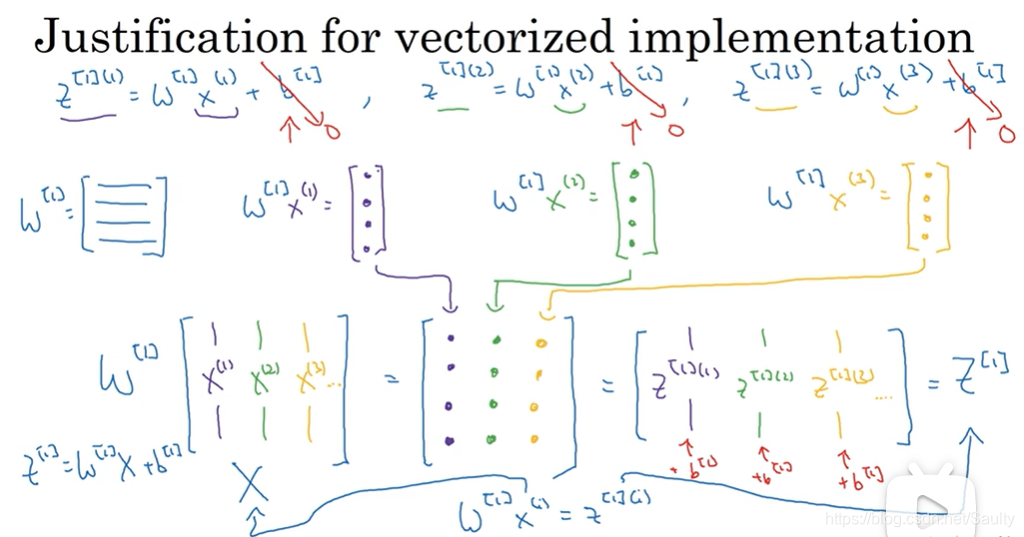

3.5 向量化实现的解释 Explanation for vectorized implementation

- 不同的样本在每一层的参数是相同的

- 同一样本不同特征在每一层的参数是不同的

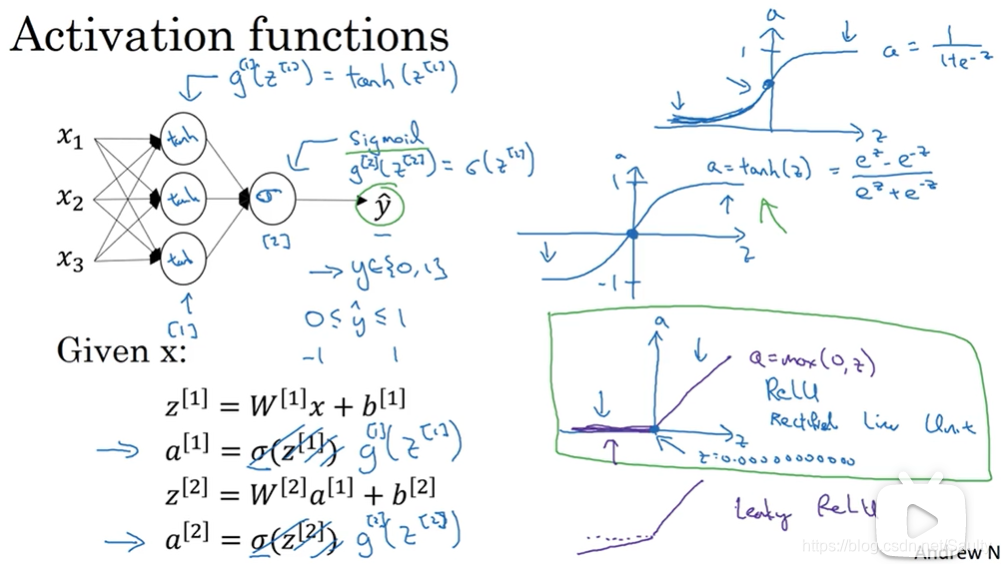

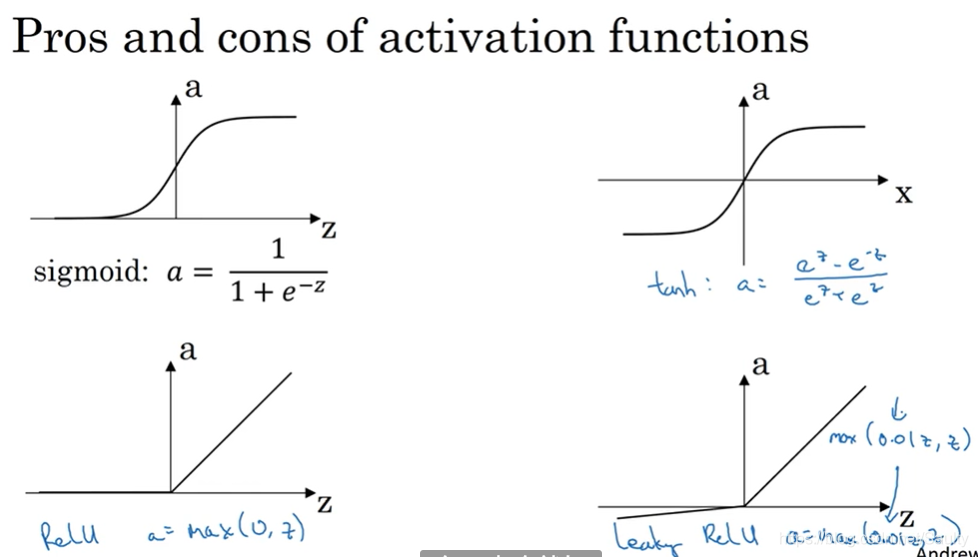

3.6 激活函数 Activation functions

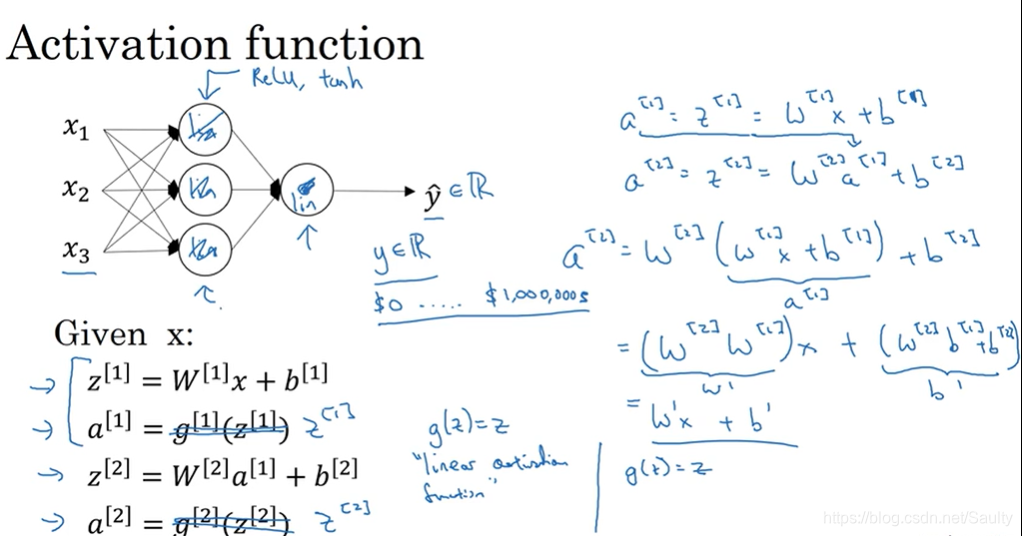

3.7 为什么需要非线性激活函数?Why do you need non-linear activation functions?

- 为了提高模型的复杂度

- 线性函数组合本身就是线性函数

- 若只使用线性激活函数,与不使用隐藏层的逻辑回归函数无异

3.8 激活函数的导数 Derivatives of activation functions

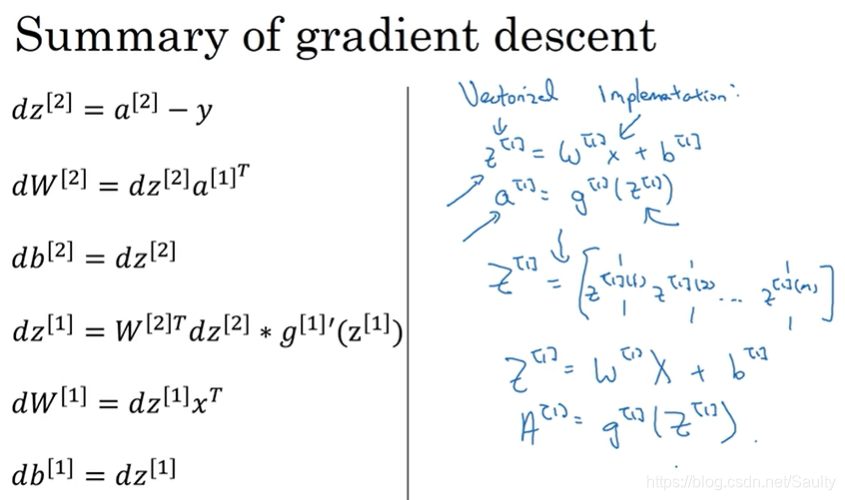

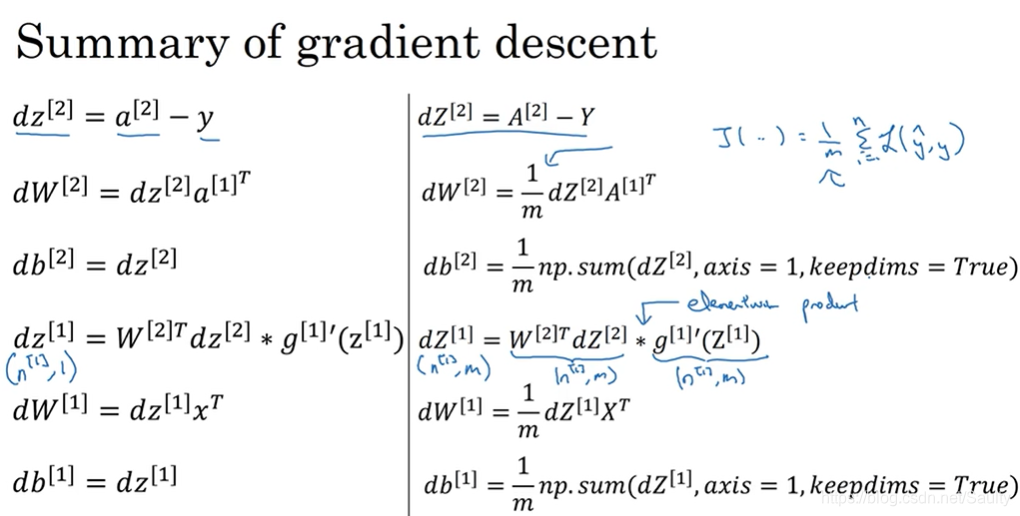

3.9 神经网络的梯度下降法 Gradient descent for neural networks

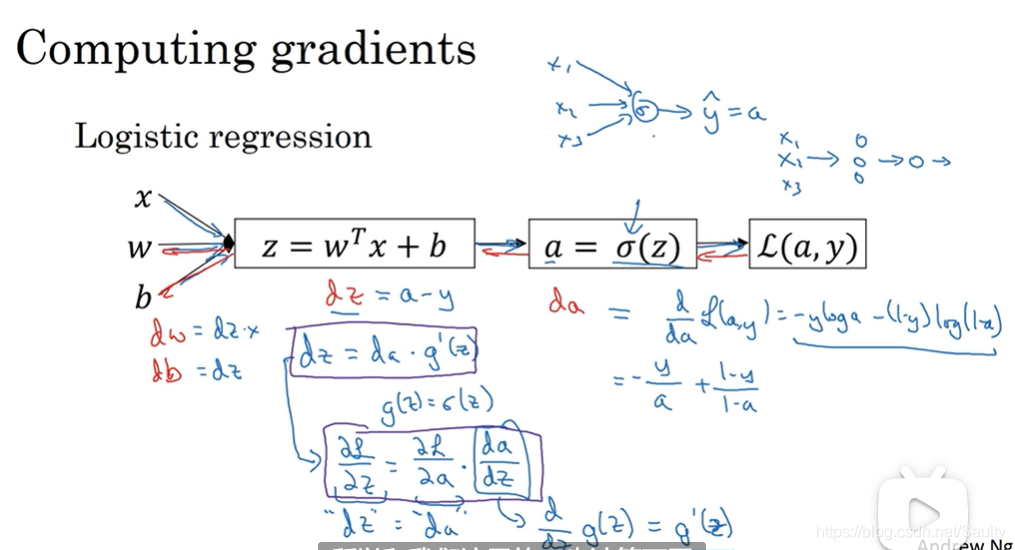

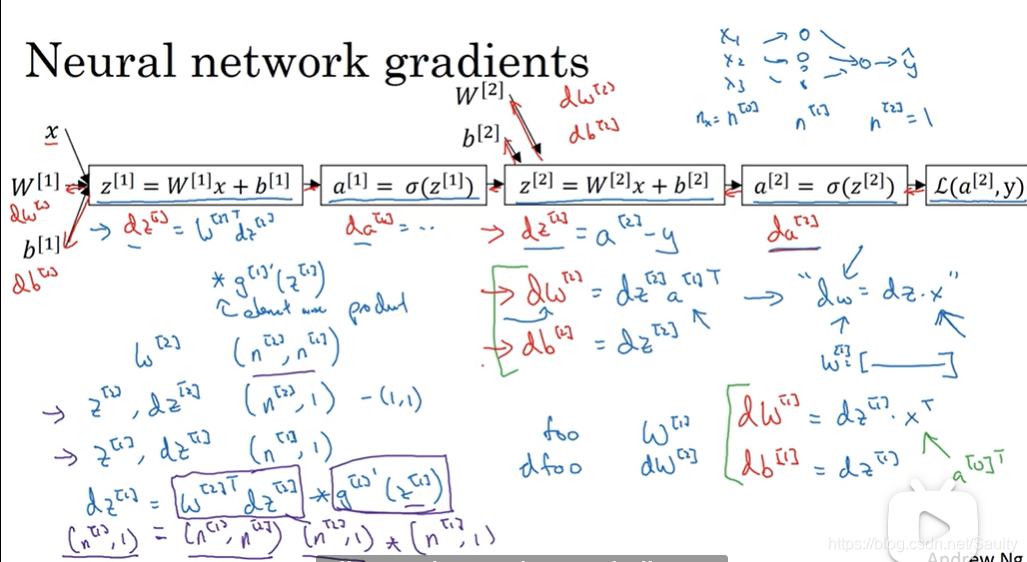

3.10 (选修)直观理解反向传播 Backpropagation intuition

- 单个样本

- 多个样本

前向传播

反向传播

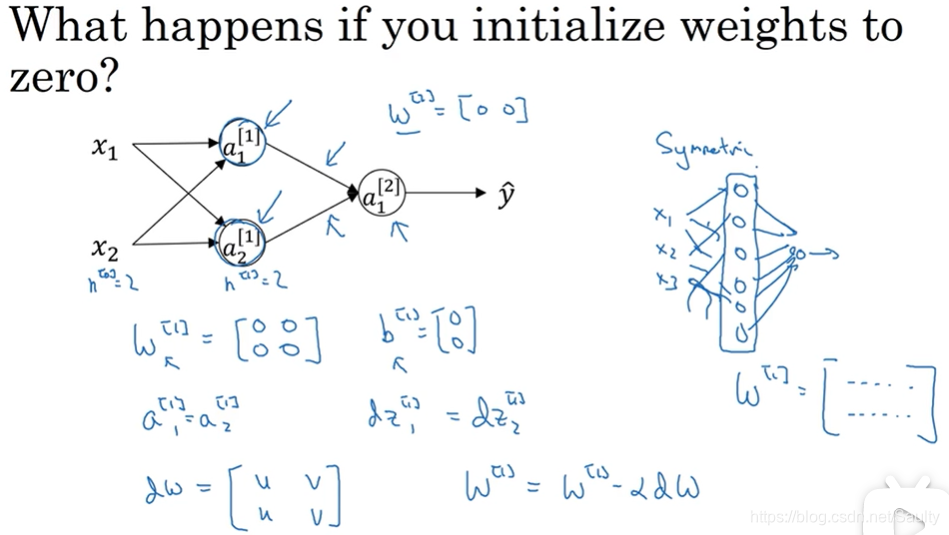

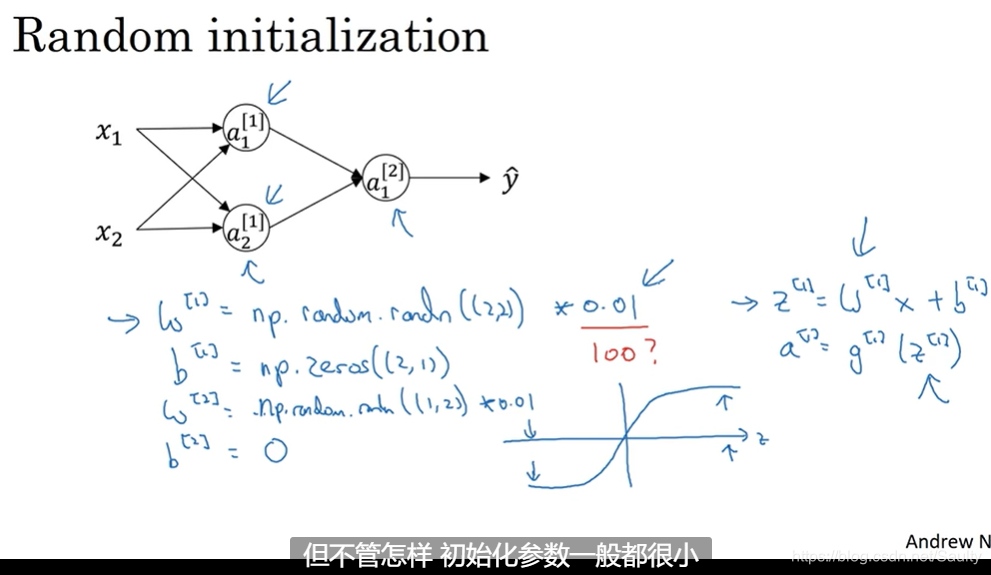

3.11 随机初始化权重 Random Initialization

- 对称性问题

本文为吴恩达深度学习课程第三周的学习笔记,主要介绍浅层神经网络的基本概念,包括神经网络的表示、计算输出的方法、向量化实现及激活函数的选择等。此外还探讨了非线性激活函数的重要性及其导数计算,并介绍了神经网络中的梯度下降法。

本文为吴恩达深度学习课程第三周的学习笔记,主要介绍浅层神经网络的基本概念,包括神经网络的表示、计算输出的方法、向量化实现及激活函数的选择等。此外还探讨了非线性激活函数的重要性及其导数计算,并介绍了神经网络中的梯度下降法。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?