一、非线性回归的定义

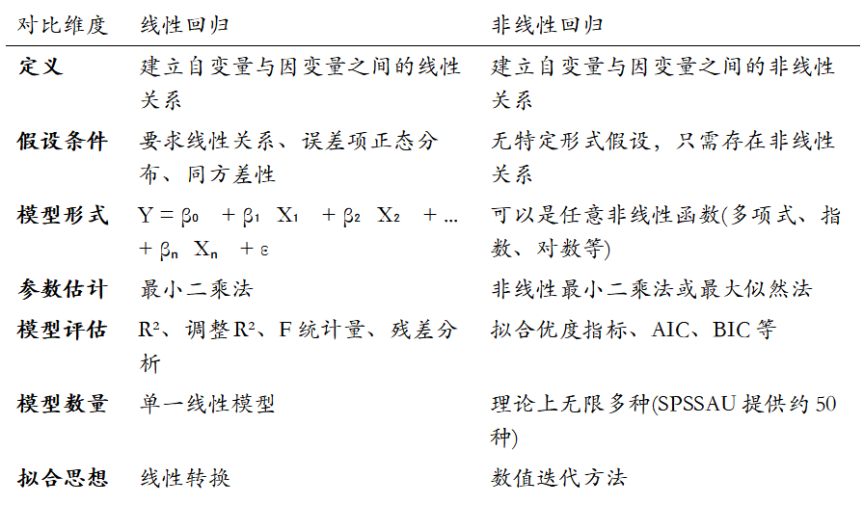

非线性回归是一种用于建立自变量与因变量之间非线性关系的回归分析方法。与线性回归不同,非线性回归允许预测变量与响应变量之间存在复杂的非线性关系,能够拟合更贴近现实世界的数据模式。

在SPSSAU(在线SPSS)平台上,非线性回归采用数值迭代的方法进行拟合,比曲线回归更具专业性和灵活性,一方面可选择更多的曲线模型(约50种),另一方面可解决一些无法线性转换的曲线模型问题。

二、线性回归与非线性回归的核心区别

三、实际应用中的关键区别

- 适用场景不同:

- 线性回归适用于变量间存在线性关系的情况

- 非线性回归适用于非线性关系,如:

- 人类生长曲线

- 药剂量与疗效反应率关系

- 人口增长模型(如Logistic S曲线)

- 模型复杂度:

- 线性回归简单易懂、计算效率高

- 非线性回归能处理更复杂的关系,但计算复杂度高

- 在SPSSAU(网页SPSS)中的实现:

- 线性回归:直接使用线性回归分析

- 非线性回归:需要选择特定非线性函数表达式(如二次曲线、指数函数等),并可设置参数初始值

四、如何选择回归方法

- 首先通过散点图观察变量间关系形态

- 如果呈现明显曲线关系,考虑非线性回归

- 在SPSSAU中,可以先尝试曲线回归(提供7种常见曲线模型)

- 对于更复杂的曲线关系,使用非线性回归功能

提示:SPSSAU平台同时提供线性回归和非线性回归分析功能,用户可以根据数据特征和研究目的灵活选择适当的分析方法。对于初学者,平台还提供了详细的操作指南和案例解读,帮助用户正确应用这些方法。

2983

2983

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?