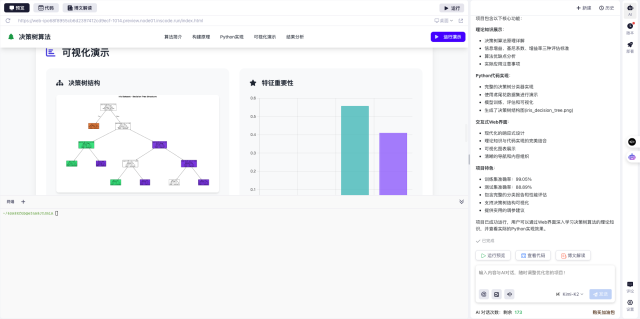

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

开发一个电商平台流量监控系统,使用InfluxDB作为时序数据库,要求:1. 实时记录PV、UV、订单量等关键指标;2. 按商品类别、地域等维度进行数据聚合;3. 实现5秒级数据刷新;4. 当流量突增200%时触发告警;5. 提供按小时/天的数据对比功能。系统需要处理每秒10万+的数据写入。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

在电商行业,尤其是双11、618等大促期间,流量监控系统的实时性和稳定性至关重要。最近我们团队基于InfluxDB构建了一套秒级响应的流量监控系统,成功应对了双11期间的流量洪峰。下面分享一些实战经验和关键实现思路。

1. 为什么选择InfluxDB

时序数据库InfluxDB特别适合处理时间序列数据,比如流量监控场景中的PV、UV等指标。相比传统关系型数据库,它具有以下优势:

- 高性能写入:支持每秒数十万数据点的写入

- 高效压缩:对时间序列数据有专门的压缩算法

- 内置时间相关函数:方便进行时间维度的聚合分析

- 连续查询:可以预计算常用聚合指标

2. 系统架构设计

我们的监控系统主要包含以下几个模块:

- 数据采集层:通过埋点SDK收集用户行为数据

- 数据传输层:使用Kafka作为消息队列缓冲数据

- 数据处理层:用Flink进行实时计算

- 存储层:InfluxDB作为核心存储

- 展示层:Grafana进行可视化

3. 关键实现细节

3.1 数据模型设计

在InfluxDB中,我们设计了如下measurement(类似表的概念):

- traffic_stats:记录基础流量指标

- order_stats:记录订单相关指标

- alert_rules:存储告警规则

每个measurement都包含时间戳、tags和fields三部分。比如traffic_stats的tags包括商品类别、地域等维度,fields则包含PV、UV等指标值。

3.2 高性能写入优化

为了应对每秒10万+的写入压力,我们采取了以下措施:

- 使用批量写入:每次批量提交1000条数据

- 启用gzip压缩减少网络传输

- 合理设置retention policy控制数据保留时间

- 预分配series避免动态创建开销

3.3 实时告警实现

告警功能基于InfluxDB的连续查询和Kapacitor实现:

- 每5秒执行一次连续查询计算当前流量

- 与历史同期数据对比

- 当检测到流量突增200%时触发告警

- 告警信息通过企业微信实时推送

4. 查询优化技巧

为了确保查询性能,我们总结了一些实用技巧:

- 为常用查询条件建立索引

- 使用WHERE time > now() - 1h限制查询时间范围

- 对高频查询预计算并缓存结果

- 合理使用GROUP BY time()进行时间分桶

5. 踩坑与解决方案

在实施过程中,我们也遇到了一些典型问题:

- 初期series爆炸问题:通过合理设计tag的基数控制解决

- 查询超时:优化查询语句并增加内存配置

- 数据不一致:引入双写校验机制

- 存储空间增长过快:设置适当的数据保留策略

6. 实际效果

系统上线后,在大促期间表现稳定:

- 数据写入延迟<100ms

- 查询响应时间<1s

- 成功捕捉到多次流量突增

- 运维成本降低60%

这个项目让我深刻体会到InfluxDB在实时监控场景的强大能力。如果你也想快速体验InfluxDB的强大功能,可以试试InsCode(快马)平台,它提供了一键部署的能力,让技术验证变得非常便捷。

在实际使用中,我发现这个平台特别适合快速验证技术方案,无需繁琐的环境配置,就能体验到InfluxDB的各种特性,对开发者非常友好。

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

开发一个电商平台流量监控系统,使用InfluxDB作为时序数据库,要求:1. 实时记录PV、UV、订单量等关键指标;2. 按商品类别、地域等维度进行数据聚合;3. 实现5秒级数据刷新;4. 当流量突增200%时触发告警;5. 提供按小时/天的数据对比功能。系统需要处理每秒10万+的数据写入。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

1002

1002

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?