OWL:优化型员工学习框架深度解析与复现指南

I. OWL 简介

A. 项目概览与核心理念

OWL (Optimized Workforce Learning) 是一个由 CAMEL-AI 社区开发的开源多智能体协作框架,旨在通过动态的智能体交互来自动化复杂任务。该框架于2025年3月公开发布,其愿景是革新人工智能(AI)智能体协作解决真实世界任务的方式。OWL 的核心理念在于模仿人类的协作模式,将复杂任务分解为可执行的子步骤,并通过拥有不同角色的智能体之间的劳动分工来完成这些子步骤。

其开源特性(采用 Apache 2.0 许可证)极大地促进了透明度和可定制性,允许研究人员和开发者自由地使用、修改和贡献代码,这对于推动多智能体系统领域的研究和应用至关重要。

B. 与 CAMEL-AI 框架的关系

OWL 的构建明确基于 CAMEL-AI 框架。CAMEL-AI 为 OWL 提供了多智能体系统的基础支持,包括角色扮演机制、工作流系统以及工具集成能力等核心功能。因此,要深入理解 OWL,必须首先了解 CAMEL-AI 的核心理念和贡献。

CAMEL-AI 的设计原则,如“代码即提示 (Code-as-Prompt)”、状态化和可演化智能体社会,深刻影响了 OWL 的架构和能力。这意味着 OWL 智能体并非简单执行预定义逻辑,而是通过交互动态引导和适应。CAMEL-AI 将“环境”视为智能体规模化扩展的关键维度之一,这进一步凸显了像 OWL 这样框架的重要性。

C. “优化型员工学习” (Optimized Workforce Learning) 概念解析

“优化型员工学习” (Optimized Workforce Learning) 这一名称本身即揭示了其设计哲学:使AI智能体团队能够以高效和优化的方式学习和执行任务,并通过交互和适应不断改进其策略,如同一个理想的人类工作团队。这不仅指任务的执行,更强调了在交互过程中不断改进和提升的能力,模仿人类员工在实践中积累经验、优化流程的模式。

“通用多智能体辅助” (General Multi-Agent Assistance) 则强调了OWL作为一种普适性框架的能力,它通过模块化设计、多样化的工具包支持以及与模型上下文协议 (MCP) 的集成,实现了跨不同领域和应用需求的适应性,而非局限于特定类型的任务。

D. 关键能力与成就 (GAIA Benchmark)

OWL 具备一系列强大的核心功能,包括在线搜索、多模态处理(视频、图像、音频)、浏览器自动化、文档解析和代码执行,并集成了一套丰富的内置工具包。

自发布以来,OWL 在业界权威的 GAIA (Generalized AI Agent) 基准测试中表现卓越。

- 最初以 58.18% 的平均分在开源框架中排名第一。

- 后续进一步提升至 69.09%。

这一成就不仅证明了其强大的任务自动化能力,也反映了其在复杂场景下进行推理和协作的潜力。

II. 系统架构与核心组件

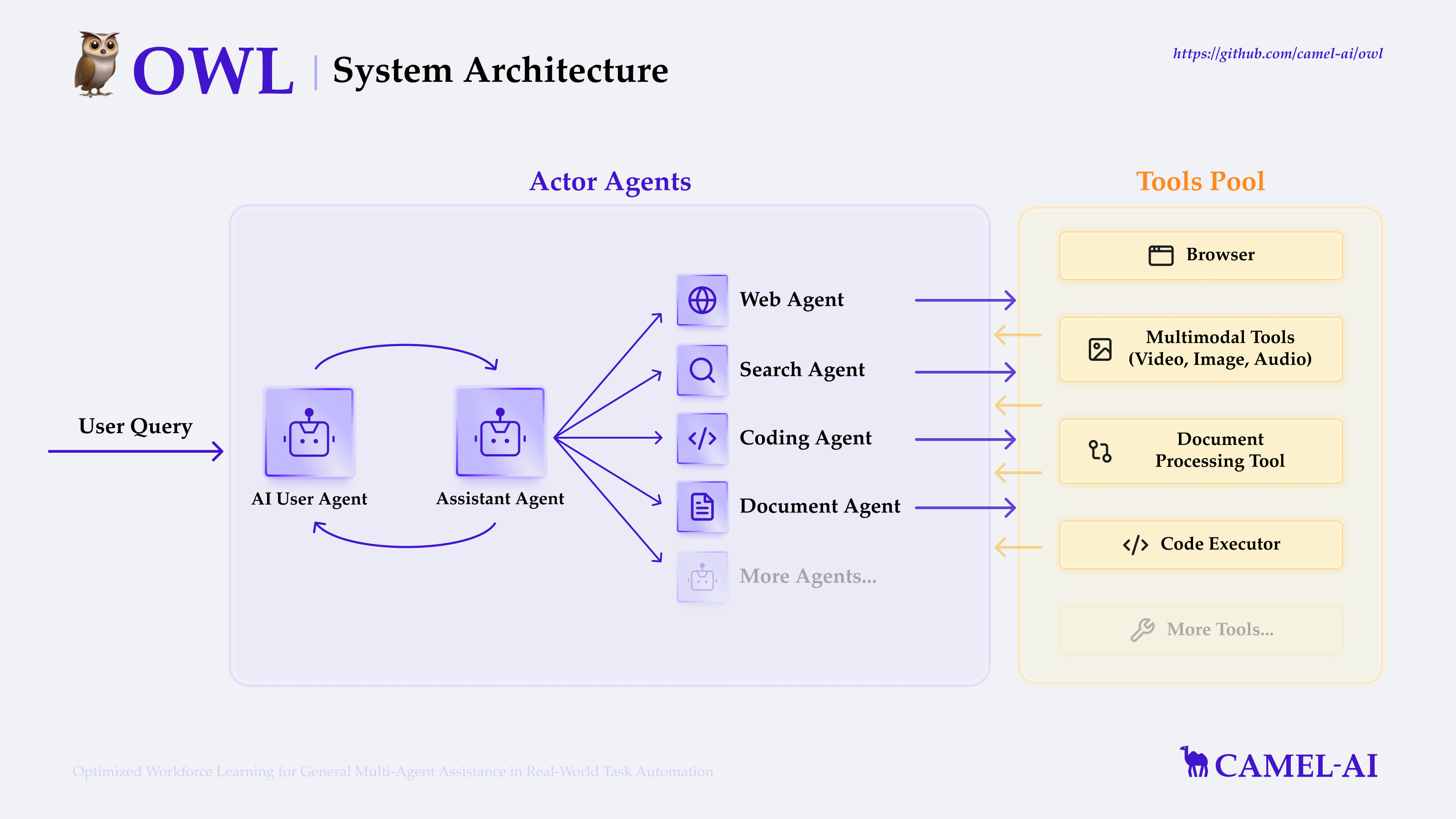

OWL 的架构设计旨在支持其核心的多智能体协作和任务自动化能力。根据其功能特性、assets/owl_architecture.png 的描述(一个中心 “OWL Agent” 与 “Toolkits” 和 “LLM” 交互)以及典型的多智能体系统设计模式,可以勾勒出其主要组成部分。

A. 高层架构蓝图

OWL 系统可以理解为包含以下几个关键层面:

- 用户交互层 (User Interaction Layer):

- Web UI: 基于 Gradio 构建,提供用户友好的界面进行任务输入、配置管理和结果查看。

- 脚本接口: 允许通过 Python 脚本(如 examples/ 中的脚本)与系统交互。

- 任务编排与规划层 (Task Orchestration & Planning Layer):

- OWL Agent (Coordinator/Main Agent): 作为系统的核心协调者,接收用户任务。

- 规划智能体 (Planning Agents): 负责理解用户意图,将复杂任务分解为子任务,并制定执行策略。

- 执行与工具使用层 (Execution & Tool Usage Layer):

- 执行智能体 (Execution Agents): 接收规划智能体分配的子任务,通过调用工具包来完成具体操作。例如,专门的 Web Agent 负责浏览器自动化。

- 工具包库 (Toolkit Library): 提供一系列预置和可扩展的工具,如 BrowserToolkit, SearchToolkit 等。

- 模型上下文协议 (MCP) 子系统: 实现与外部工具和数据源的标准化交互。

- 智能体协作与通信层 (Agent Collaboration & Communication Layer):

- 动态协作引擎: 管理智能体间的交互、信息共享和协作流程。

- 角色扮演框架 (CAMEL-AI): 定义智能体角色和行为模式。

- 基础模型与环境层 (Underlying Model & Environment Layer):

- 大型语言模型 (LLM) 接口: 与底层的 LLM (如 GPT-4, Claude) 进行交互,获取推理和决策能力。

- 外部环境: 包括互联网、本地文件系统等智能体需要交互的真实世界环境。

[图片:OWL 架构图 (assets/owl_architecture.png 中描绘的中心 OWL Agent、工具包和 LLM 交互示意图)]

B. 动态协作引擎

OWL 的核心是一个动态协作引擎,其关键在于智能体角色机制和实时决策优化。

- 智能体角色机制 (Agent Role Mechanism):OWL 采用了一种双重角色协作框架,主要包括:

- 规划智能体 (Planning Agents):负责任务的分解和策略的制定。它们分析总体目标,并将其拆解成一系列可管理的子任务。

- 执行智能体 (Execution Agents):通过调用工具来完成具体的操作和子任务。例如,网页智能体 (Web Agents) 专注于浏览器相关的操作。

- 一些资料也提及了 用户智能体 (UserAgent) 和 助手智能体 (AssistantAgent) 的概念。UserAgent 负责分解任务和提供指令,而 AssistantAgent 则使用各种工具执行这些指令。这可以看作是规划/执行范式的一种更高级别的抽象或特定实现模式。UserAgent 作为人机交互或高级目标的接口,其意图由规划智能体处理,然后由 AssistantAgent 或更专业的执行智能体完成具体的子任务。

- 实时决策优化 (Real-time Decision Optimization):该引擎据称基于部分可观察马尔可夫决策过程 (POMDP) 理论,能够根据外部环境(如网页内容)的变化动态调整执行路径。这种自适应能力对于在如互联网这样动态变化的环境中保持鲁棒的性能至关重要。

C. 多智能体系统支持 (Leveraging CAMEL-AI)

OWL 深度整合并扩展了 CAMEL-AI 框架在多智能体系统方面的支持能力。

- 角色扮演框架 (Role-Playing Framework):智能体根据预设的角色和任务需求进行协作,并基于自身能力和任务定位做出优化决策。CAMEL-AI 的角色扮演机制通过“初始提示 (Inception Prompting)”来引导聊天智能体完成任务,同时保持与人类意图的一致性。一个“AI 用户”智能体持续地向一个“AI 助手”智能体提供指令以解决任务。这种结构化的对话是实现自主协作和任务完成的关键。

- 实现细节:初始提示技术的核心在于智能体之间相互提示以解决任务。规划智能体可能扮演“AI 用户”的角色,而执行智能体或其子智能体则扮演“AI 助手”的角色。初始提示启动并构建了它们之间的对话结构,“AI 用户”智能体并非一次性给出所有指令,而是“持续提供指令”。这种持续的、结构化的对话使得复杂任务得以分解,进度得以监控,调整得以自主进行。

- 工作流系统 (Workflow System):CAMEL 提供了强大的工作流管理系统,支持多个智能体协同解决复杂任务,确保了高效协作和合理的劳动分工。OWL 继承并应用了这一系统来实现任务自动化。

- 上下文隔离 (Context Isolation for Long-Horizon Tasks):为了有效处理需要长时间执行的复杂任务,OWL 采用了上下文隔离机制。系统中的专业化子智能体(如 WebAgent、SearchAgent、CodingAgent、DocumentAgent)会为各自负责的领域维护独立的上下文窗口。这种模块化的上下文管理方式,可以防止主智能体的上下文变得混乱或超出大型语言模型的处理极限,确保了在执行长程任务时能够保持专注和高效。

D. 模型上下文协议 (MCP) 子系统

模型上下文协议 (MCP) 由 Anthropic 提出,旨在解决 AI 信息孤岛问题,它定义了应用程序和 AI 模型交换上下文信息的标准方式。

- 功能: MCP 被形象地比喻为 LLM 领域的“USB接口”,能够以标准化的方式将模型连接到各种数据源和工具。OWL 支持使用 MCP 来调用其生态系统内的 MCP 服务器。

- 实现流程:

- 配置 MCP 服务器: 在 OWL 项目的 mcp_servers_config.json 文件中定义 MCP 服务的名称和启动命令。

- 初始化 MCPToolkit: 在 OWL 代码中,使用该配置文件路径来初始化 MCPToolkit 实例。

- 连接服务: 调用该实例的连接方法,建立与 MCP 服务器的通信。

- 工具调用: AssistantAgent (或执行智能体) 通过 MCPToolkit 调用由 MCP 服务器提供的工具。

- 断开连接: 任务完成后,调用断开方法。

- 优势: 标准化的工具访问、不断扩展的生态系统、增强的安全性、模型选择的灵活性以及开发效率的提升。

E. 用户界面 (Web UI)

OWL 提供了一个基于 Web 的用户界面 (UI),旨在简化与系统的交互过程,降低使用门槛。

- 技术栈: UI 很可能是基于 Gradio 构建的,因为 gradio 出现在项目的依赖中。FastAPI 可能用于构建后端 API。

- 特性:

- 交互式任务提交: 用户可以通过界面输入任务描述。

- 实时日志与状态显示: 显示智能体执行过程中的日志、当前状态、工具调用情况和中间结果。

- 结果展示与导出: 友好地展示最终结果,并可能提供导出选项。

- 配置管理: 可能允许用户管理环境变量或选择模型。

- 启动方式: 通常通过一个主运行脚本(如 app.py 或 run.py 带有特定参数)启动。启动后,会在控制台输出一个本地 URL (如 http://127.0.0.1:7860)。

- 稳定性: 开发团队对 Web UI 的架构进行了重构,以提升其运行的稳定性。

III. “优化型员工学习” 深度解析

A. 概念基础与目标

“优化型员工学习”的核心思想是使 AI 智能体能够作为一个协同工作的“员工队伍”,通过学习和适应来高效地完成任务。这不仅指任务的执行,更强调了在交互过程中不断改进和提升的能力,模仿人类员工在实践中积累经验、优化流程的模式。

B. "学习"在 OWL 中的体现

OWL 中的“学习”并非单一机制,而是通过多种方式得以体现:

- 动态协作引擎的适应性:基于 POMDP 的实时决策优化,使得智能体能够根据环境反馈和任务结果动态调整其策略和执行路径。这种“行动-观察-调整”的循环本身就是一种学习形式。

- 环境中的自我优化:框架具备的高级协作特性,允许系统在面对多变和复杂的环境时进行自我调整和优化,以达到更好的协作效果和任务完成度。

- 对未来学习能力的支撑:OWL 旨在提供一个能够支持高级学习能力(如抽象能力、适应机制、迁移学习、元学习)发展的环境和基础。

C. POMDP 的角色与实现

部分可观察马尔可夫决策过程 (POMDP) 是 OWL 实现动态决策和适应性的关键理论基础。

- POMDP 理论: POMDP 是一个用于在不确定性下进行决策建模的数学框架,特别适用于智能体无法完全观察其所处环境状态的场景。在这种模型中,智能体需要基于其历史动作和观察来维持对当前状态的信念(概率分布)。

- OWL 中的应用: OWL 利用 POMDP 进行实时决策优化。例如,当网页内容发生变化时,智能体能够动态调整其后续的操作路径。这使得智能体即便在信息不完整或环境动态变化的情况下,也能做出更为明智的决策。

- 实现推测: 虽然具体实现细节不多,但 POMDP 的引入意味着智能体的决策不仅仅是启发式的。LLM 可能通过特定的提示结构来抽象和实现 POMDP 的状态、动作、观察以及转移/奖励函数的表示和计算。

D. 与多智能体强化学习 (MARL) 及微调的潜在联系

“优化型员工学习”的愿景与多智能体强化学习 (MARL) 和模型微调技术的发展方向不谋而合。

- MARFT 范式 (Multi-Agent Reinforcement Fine-Tuning):

- MARFT 旨在融合 MARL 与基于 LLM 的多智能体系统 (LaMAS)(如 OWL),解决两者结合时面临的特有挑战,例如智能体间的异步交互和异构架构问题。

- 该研究讨论了强化微调 (RFT) 的概念,即使用高质量的交互轨迹数据对预训练的 LLM 进行微调,以增强其推理和决策能力。

- MARFT 论文明确将 CAMEL-AI OWL 列为一个杰出的 LaMAS 框架,强烈暗示了 OWL 中“优化型员工学习”的未来发展方向可能包括引入此类 MARFT 方法。

- 微调模型的应用:

- Hugging Face 上的 owl-agent 组织托管了一些模型,例如 DPO_imm_wtq_math_all_qwen2_32B_planner。DPO (Direct Preference Optimization) 是一种基于偏好数据微调 LLM 的技术。

- 在 owl-agent 名下存在这类模型,表明微调模型确实是 OWL 生态系统的一部分,可能用于规划智能体或专门的执行智能体,以提升其“优化”性能。这与 RFT 的理念是一致的。

- 实现推测: “学习”可以设想为基于智能体在协作任务中的表现(如成功/失败的轨迹、用户反馈),对其背后的 LLM 进行微调。可以利用 CAMEL-AI 强大的数据生成能力,或记录 OWL 在执行任务时的详细交互日志,来创建专门用于微调的数据集。

IV. 环境搭建与安装复现指南

A. 系统必备条件

-

Python: 支持 Python 3.10, 3.11 和 3.12。推荐 Python 3.10。

-

Node.js 和 npm: 如果需要使用 Playwright MCP 服务(用于浏览器自动化)。

-

Linux (Ubuntu):

sudo apt update && sudo apt install nodejs npm -y -

macOS:

brew install node

-

-

Docker 和 Docker Compose: 对于容器化部署 (推荐 Docker Compose v2.x)。

-

操作系统: Linux, macOS, Windows。特定依赖(如 Playwright 浏览器依赖)可能需额外步骤。

B. 详细安装步骤

1. 使用 uv (推荐方式)

uv 是一个快速的 Python 包安装和管理工具。

-

克隆仓库

git clone https://github.com/camel-ai/owl.git

cd owl -

安装 uv (如果尚未安装)

pip install uv -

创建并激活虚拟环境 (以 Python 3.10 为例)

uv venv .venv --python=3.10

source .venv/bin/activate # macOS/Linux

# .venv\Scripts\activate # Windows -

安装 OWL 及其所有依赖

uv pip install -e .

2. 使用 venv 和 pip

-

克隆仓库并进入目录 (同上)

cd owl -

创建虚拟环境

python3.10 -m venv .venv # 确保使用兼容的 Python 版本 -

激活虚拟环境

source .venv/bin/activate # macOS/Linux

# .venv\Scripts\activate # Windows -

安装依赖

pip install -e .

# 或者

# pip install -r requirements.txt --use-pep517

3. 使用 conda

-

克隆仓库并进入目录 (同上)<

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

555

555

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?