apache版本的hadoop三种运行环境的介绍

1.standAlone:单机版的hadoop运行环境,所有都跑在一台环境上

2.伪分布式:主节点都在一台机器上,从节点分开到其他机器上,借助3台机器实现

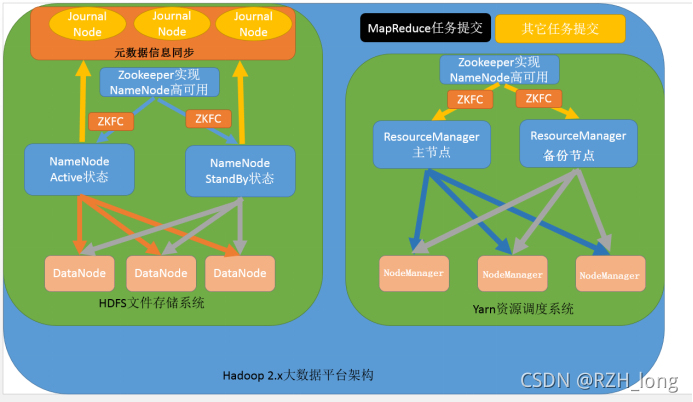

3.完全分布式:主节点全部分散到不通的机器上

namenode active 占用一台机器

namenodestandBy占用一台机器

resourceManager active 占用一台机器

resoureceManagerstandby 占用一台机器

standAlone环境的hadoop环境搭建

下载hadoop安装包:Index of /dist/hadoop/common/hadoop-2.7.5

前提:1.一台联网的linux服务器

1.解压安装包:

tar -zxvf hadoop-2.7.5.tar.gz -C /export/servers/

目录介绍:

bin,sbin 脚本文件

lib/native 这个很重要,里面集成了一些C程序,包括一些压缩文件

2.

#查看此hadoop本地库,是否支持

bin/hadoop checknative

21/10/31 11:52:47 WARN bzip2.Bzip2Factory: Failed to load/initialize native-bzip2 library system-native, will use pure-Java version #加载本地bzip2失败,将使用纯java方式进行压缩

21/10/31 11:52:47 INFO zlib.ZlibFactory: Successfully loaded & initialized native-zlib library

Native library checking: #本地库检测

hadoop: true /export/servers/hadoop-2.7.5/lib/native/libhadoop.so.1.0.0 #支持C语言访问集群

#以下都是压缩方式的支持情况

zlib: true /lib64/libz.so.1

snappy: false

lz4: true revision:99

bzip2: false

openssl: false Cannot load libcrypto.so (libcrypto.so: cannot open shared object file: No such file or directory)!

#apche默认snappy压缩方式不支持,snappy是google提供的一种压缩算法,最厉害的,需要重新编译才能使用

snappy: false

3.配置文件修改6个文件

core-site.xml 核心配置文件,主要定义我们的集群是分布式还是本机运行

hdfs-site.xml 分布式文件系统的核心配置 决定了我们数据存放在哪个路径,数据的副本,数据的block块大小。

hadoop-env.sh 配置jdk的路径

本文详细介绍了Apache Hadoop的三种运行环境:standAlone、伪分布式和完全分布式,并重点讲解了standAlone环境的安装步骤。包括下载Hadoop安装包,配置核心、HDFS、MapReduce和YARN的设置文件,以及启动和测试Hadoop集群的过程。

本文详细介绍了Apache Hadoop的三种运行环境:standAlone、伪分布式和完全分布式,并重点讲解了standAlone环境的安装步骤。包括下载Hadoop安装包,配置核心、HDFS、MapReduce和YARN的设置文件,以及启动和测试Hadoop集群的过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3919

3919

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?