使用IDEA打Spark jar包

我们使用Scala编写Spark程序代码,需要将编译好的jar放到集群环境中跑任务,但是集群中大部分的依赖包已经存在了,我们就不需要将其再次打入到Spark程序包中,这个操作类似于用Maven打包的<scope>provided</scope>

今天抽空写一下用IDEA build Artifact包。

PS :Scala开发环境以及使用Maven创建Scala项目得准备好,这里不做教程

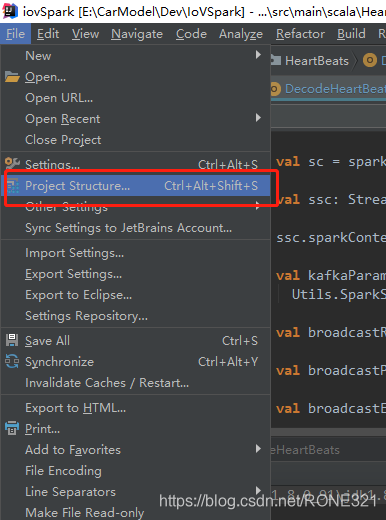

第一步、

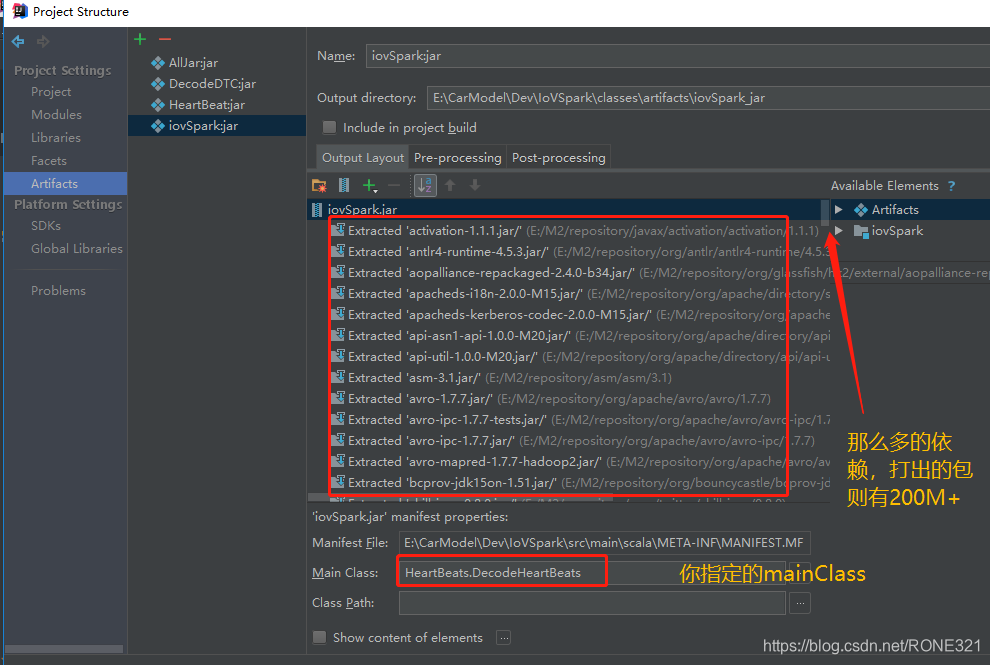

第二步、

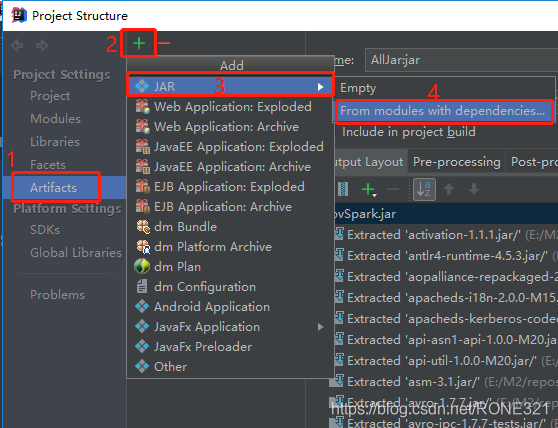

第二步、

第三步、

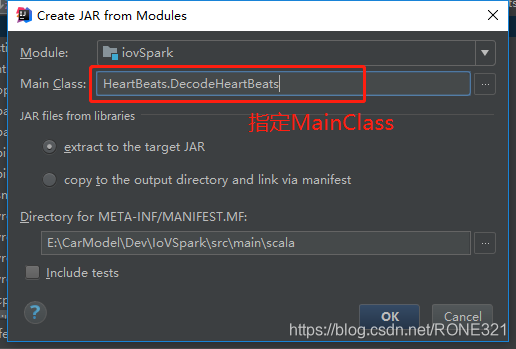

第三步、

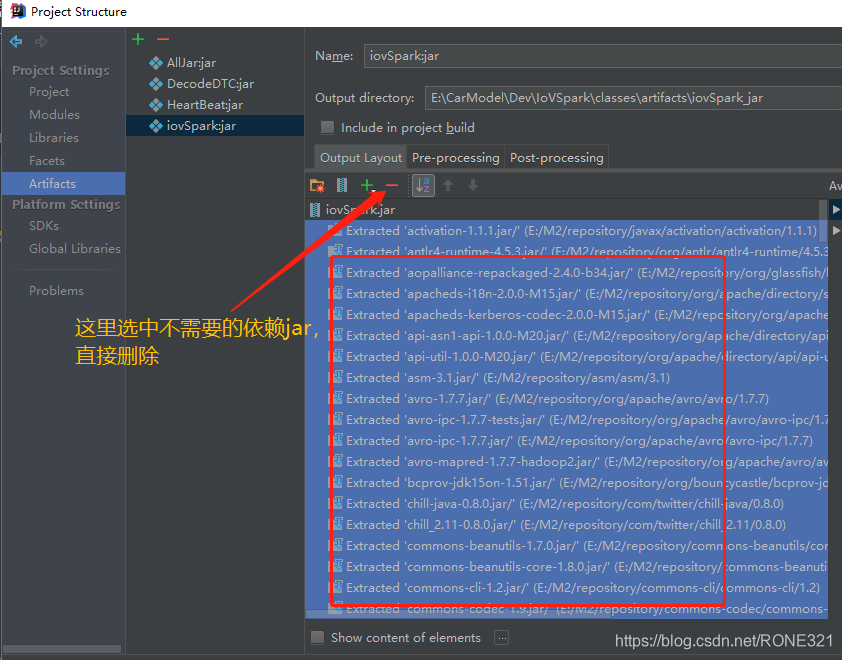

第四步、

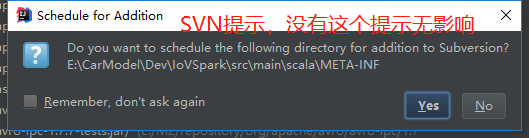

第四步、

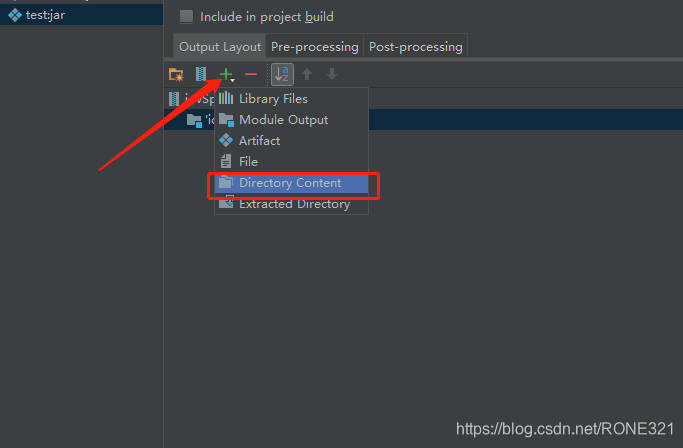

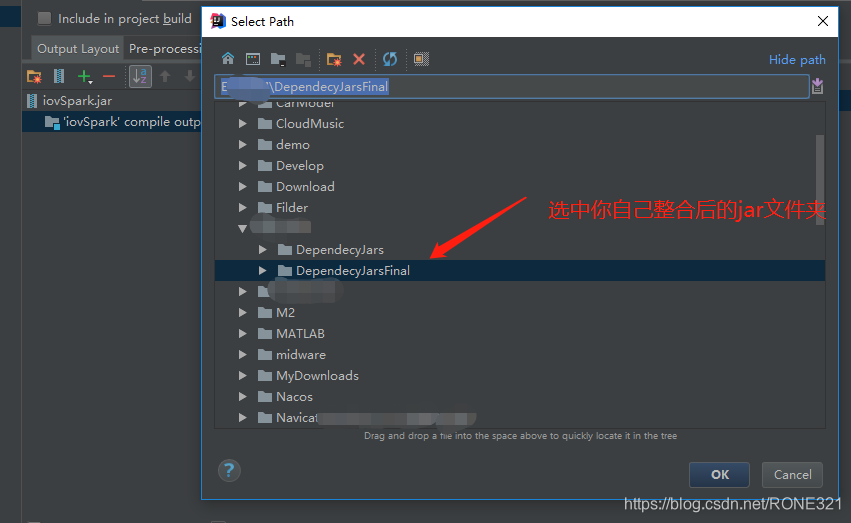

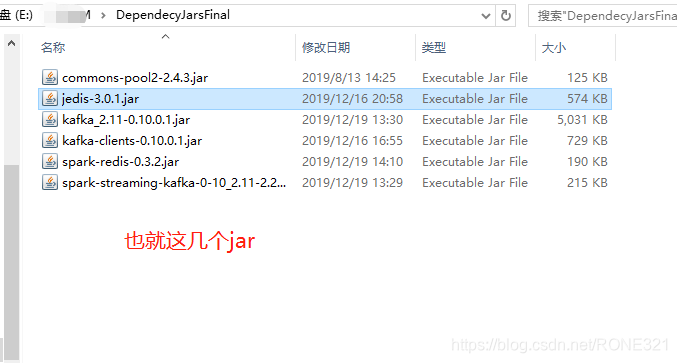

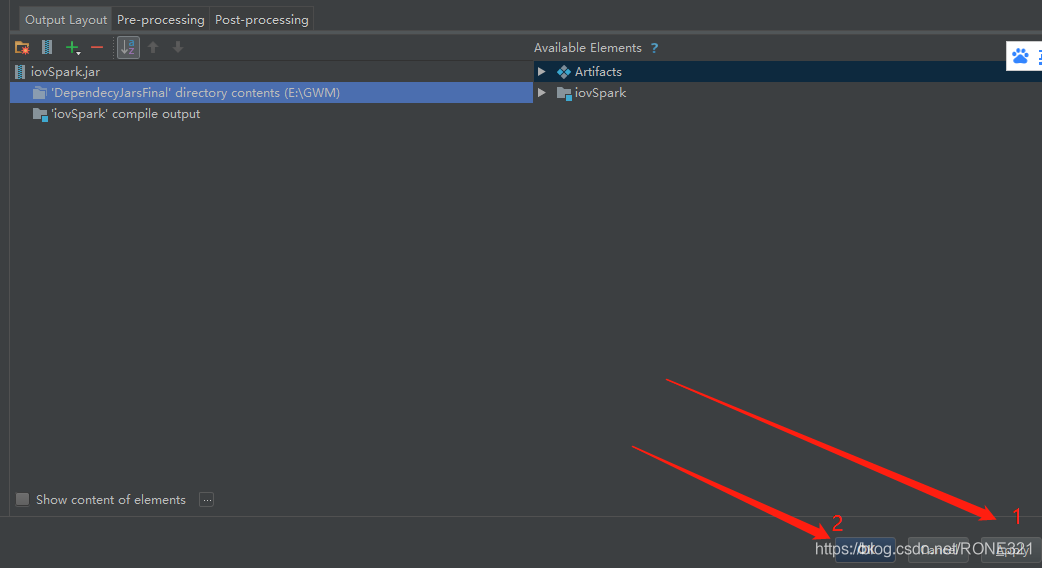

我在第四步骤的做法是把所有的依赖全部删除,我去maven本地库中寻找我需要的依赖jar 将它们整合在一起放到一个文件夹下面,然后点击左边的 “+”将它们再次引进过来,具体看下面的截图。

我在第四步骤的做法是把所有的依赖全部删除,我去maven本地库中寻找我需要的依赖jar 将它们整合在一起放到一个文件夹下面,然后点击左边的 “+”将它们再次引进过来,具体看下面的截图。

第五步、

第五步、

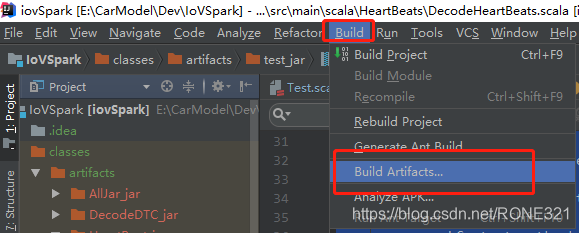

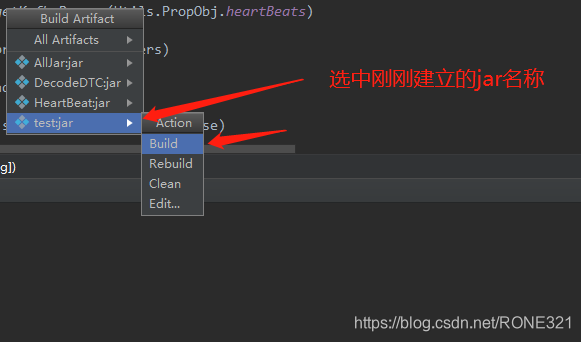

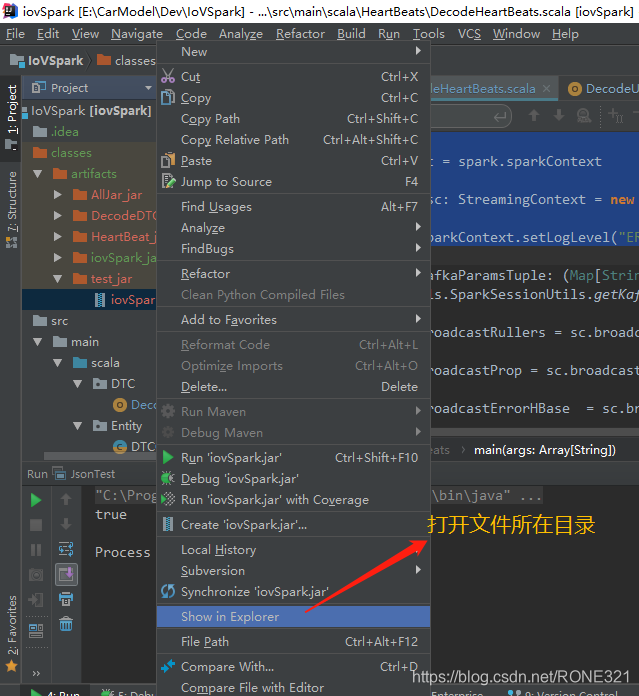

开始build 了

build结束后我们就能看到

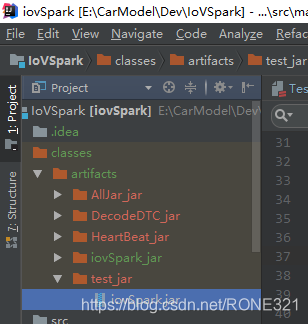

build结束后我们就能看到artifacts文件夹了,下面是我们所有build jar

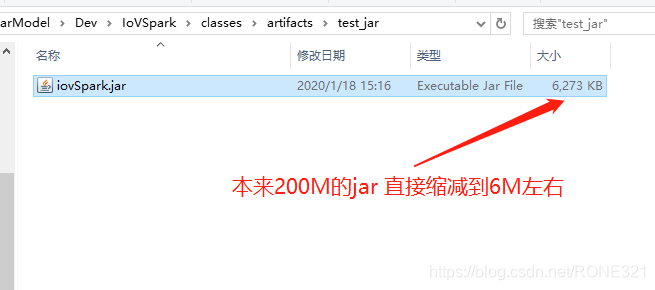

到此结束,此种打包方式放到CDH环境上是没问题的,亲测有效。

到此结束,此种打包方式放到CDH环境上是没问题的,亲测有效。

核心就是找出你哪些引用的jar在CDH环境上是没有的,将其整合在一起。

本文介绍如何在IDEA中为Spark程序打Jar包,特别适用于CDH环境。通过排除集群已有的依赖,减少Jar包大小,提高部署效率。核心在于识别并整合外部环境中缺失的依赖。

本文介绍如何在IDEA中为Spark程序打Jar包,特别适用于CDH环境。通过排除集群已有的依赖,减少Jar包大小,提高部署效率。核心在于识别并整合外部环境中缺失的依赖。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?