本文并非逐句翻译,添加个人理解与疑惑,如有需要,请自行阅读原文

CMAMBA: CHANNEL CORRELATION ENHANCED STATE SPACE MODELS FOR MULTIVARIATE TIME SERIES FORECASTING

标题: CMAMBA:用于多变量时间序列预测的通道相关性增强状态空间模型

实验环境:NVIDIA GeForce RTX 4090

代码地址:https://github.com/zclzcl0223/CMamba

0、Abstract

- 基于线性、基于 Transformer 和基于卷积的模型推动了多变量时间序列预测的最新进展,基于 Transformer 的架构因其在时间和跨通道混合方面的功效而越来越突出。最近,状态空间模型 Mamba 出现了,

具有强大的序列和特征混合功能。然而,原版 Mamba 设计对时间序列预测的适用性仍然是一个悬而未决的问题,特别是因为它对跨通道依赖关系的处理不充分。捕获跨通道依赖关系对于提高多变量时间序列预测的性能至关重要。最近的研究结果表明,自注意机制擅长捕获跨通道依赖关系,而其他更简单的机制(如 MLP)可能会降低模型性能。这是违反直觉的,因为 MLP 作为一种可学习的架构,理论上应该同时捕获相关性和不相关性,从而可能导致中性或改进的性能。深入研究自我注意机制,我们将观察到的 MLP 性能下降归因于其缺乏数据依赖性和全局感受野,这导致 MLP 缺乏泛化能力。考虑到 Mamba 强大的序列建模能力和 MLP 的高效率,两者的结合是解决多元时间序列预测的有效策略。基于上述见解,我们引入了一个为时间序列预测量身定制的优化 Mamba 变体。我们提出的模型 CMamba 结合了一个改进的 Mamba (M-Mamba) 模块用于时间依赖性建模,一个全局数据依赖性 MLP (GDD-MLP) 来有效捕获跨通道依赖性,以及一个通道混合机制来减少过拟合。在 7 个真实数据集上进行的综合实验证明了我们的模型在提高预测性能方面的有效性。

1、Introduction

-

多元时间序列预报 (MTSF) 在各种应用中起着至关重要的作用,例如天气预报(Chen et al., 2023)、交通管理(Liu et al., 2023b;c)、经济学(Xu & Cohen,2018)和事件预测(Xue et al., 2023)。MTSF 旨在根据历史观测预测时间变化的未来值。鉴于其实际重要性,近年来开发了许多深度学习模型,特别是基于线性的深度学习模型(Zeng et al., 2023;Li et al., 2023;Das 等人,2023 年;Wang et al., 2023), 基于变压器 (周 et al., 2022;Zhang & Yan, 2022;Wu et al., 2021;Nie et al., 2022;Liu et al., 2023a) 和基于卷积 (Liu et al., 2022;Wang et al., 2022;Wu et al., 2022;Luo & Wang, 2024)模型,这些模型已经显示出显著的进步。其中,基于 Transformer 的模型特别突出的是它们能够使用 MLP 或自我注意等机制分别混合时间嵌入和通道嵌入。最近引入的Mamba模型(Gu&Dao,2023)在状态空间框架内运行,表现出显著的序列和特征混合能力。曼巴没有表现出进步不仅在自然语言处理方面,而且在其他领域,包括计算机视觉(Liu et al., 2024;Zhu et al., 2024) 和基于图的应用 (Wang et al., 2024a)。然而,就时间序列预测中的跨时间依赖性建模而言,Mamba 中的每个组件是否对性能做出贡献仍然是一个值得讨论的问题(Wang et al., 2024d;胡 et al., 2024),更不用说它缺乏跨通道依赖建模能力了。 -

捕获跨通道依赖关系对于提高多变量时间序列预测的性能至关重要。最近的研究结果(Liu et al., 2023a)表明,自我注意在捕获跨渠道依赖性方面表现出色。生成的模型 iTransformer 在多个数据集上实现了出色的性能。

然而,作为 Transformer 的另一个重要组成部分,使用 MLP 对跨通道依赖关系进行建模会降低模型性能(Liu et al., 2023a;Nie et al., 2022)。作为一种轻量级且可学习的架构,MLP 应该是捕获跨渠道依赖关系的理想结构,因为它理论上可以捕获相关性和不相关性,从而实现中性或改进的性能。 -

在 iTransformer 的设计中,跨通道依赖关系以数据依赖和全局的方式捕获。即每个通道都以其历史序列为特征,自注意力机制根据数据自适应地捕获通道之间的依赖关系。相比之下,对于原始 MLP 中的不同输入,通道混合的参数是相同的。此外,由于每个时间点的数据在训练过程中都是独立混合的,因此该模型过于关注通道之间的局部依赖关系,而忽略了全局依赖关系。缺乏数据依赖性和全局感受野,这对于在真实世界数据中观察到的复杂、长期的依赖性至关重要,导致 MLP 和自我注意之间的差异。为了验证我们的主张,我们在图 1 中的 ETT 数据集中描述了两个变量(通道)随时间变化的曲线。

我们发现:(i) 尽管存在波动,但这两个变量之间的关系在很长一段时间内保持稳定,即 MULL (Middle UseLess Load) 大致相当于 HULL (High UseLess Load) 的一半。(ii) 这种关系在不同时期可能会有所不同。上述观察结果表明,多元时间序列在不同时期具有相对稳定的长期通道依赖关系。因此,数据依赖型全局通道建模方法更适合捕获跨通道依赖关系。

- 基于上述动机,我们提出了对 Mamba 的增强,用于多变量时间序列预测,结合改进的 Mamba (M-Mamba) 模块进行时间依赖性建模,并结合全局数据依赖性 MLP (GDD-MLP) 来更有效地建模通道依赖性。GDD-MLP 赋予了原始 MLP 数据依赖性和全局感受野的优势。使用 Electricity 数据集的案例研究,我们将 GDD-MLP 的性能与传统 MLP 进行了比较结果表明 GDD-MLP 显著提高了预测准确性。如图 2 所示,我们简单地使用一个实例范数的线性层,即 RLinear (Li et al., 2023) 作为主干,并在线性层之前将通道与 GDD-MLP 或 MLP 混合。

- 此外,为了缓解与通道相关 (CD) 模型相关的过拟合和泛化问题(Han et al., 2023),我们引入了通道混淆策略。这种方法在训练过程中线性地组合通道,以创建虚拟通道,这些通道集成了来自多个通道的特征,同时保留了它们共享的时间依赖关系,这有望提高模型的泛化性。 总之,我们通过评估 Mamba 组件的有效性并为其配备通道混合功能,使 Mamba 适应多变量时间序列预测。生成的模型 CMamba 利用跨时间和跨通道依赖关系,在 7 个实际数据集中实现了一致的一流性能。从技术上讲,我们的主要贡献总结如下:• 我们为

多变量时间序列预测定制了原版 Mamba 模块。提出了一个改进的 Mamba (M-Mamba) 模块,以实现更好的跨时间依赖关系建模。 • 我们使 Mamba 能够使用提出的全局数据依赖性 MLP(GDD-MLP) 和通道混淆来捕获多元相关性。结合 M-Mamba 模块,所提出的 CMamba 可以捕获跨时间和跨通道的依赖关系,以学习更好的多变量时间序列预测表示。 • 对 7 个实际基准的实验表明,我们提出的框架实现了卓越的性能。我们将提出的 GDD-MLP 和 Channel Mixup 广泛应用于其他模型。预测性能的提高表明我们的框架具有广泛的多功能性。

2、Related work

2.1 用于序列建模的状态空间模型

- 传统的状态空间模型 (SSM),例如隐藏马尔可夫模型和递归神经网络 (RNN),通过将消息存储在隐藏状态中并使用这些状态和当前输入来更新输出来处理序列。这种反复出现的机制限制了他们的训练效率,并导致了梯度消失和爆炸等问题(Hochreiter & Schmidhuber, 1997)。最近,已经提出了几种具有线性时间复杂度的 SSM,包括 S4(Gu et al., 2021)、H3(Fu et al., 2022)和 Mamba(Gu & Dao,2023)。其中,Mamba 通过引入平衡短期和长期依赖关系的数据依赖性选择机制,进一步增强了 S4。Mamba 已经展示了强大的长序列建模能力,并已成功扩展到视觉领域(Liu et al., 2024;Zhu et al., 2024)和图域(Wang et al., 2024a),而时间序列域仍需要更多探索。

2.2 MTSF 中的通道策略

- 通道策略是确定如何处理

多变量时间序列预测(MTSF) 中变量之间关系的基础。从广义上讲,有两种主要方法:通道无关 (CI) 策略,它忽略了跨通道的依赖关系,以及 Channel Dependent 通道依赖(CD) 策略,它根据特定机制集成通道。每种策略都有其各自的优点和缺点。CD 方法提供了更大的表示能力,但在面对时间序列数据的分布变化时往往不那么稳健,而 CI 方法牺牲了能力以获得更稳定、更稳健的预测(Han et al., 2023)。 大量最先进的模型都遵循 CI 策略。这些模型(Zeng等人,2023 年;Nie et al., 2022;Wang et al., 2023)将多变量时间序列视为独立单变量时间序列的集合,并简单地将不同的通道视为不同的训练样本。然而,最近的工作已经证明了通过自我注意(Liu et al., 2023a)和卷积(Luo & Wang, 2024)等机制明确捕捉多元相关性的有效性。这些方法取得了强有力的实证结果,强调了跨通道依赖建模在 MTSF 中的重要性。尽管取得了这些进步,但仍需要更有效和高效的机制来捕获和建模跨通道依赖关系。

2.3 泛化性的 MIXUP

- MIXUP 是一种广泛用于视觉的有效数据增强技术(Zhang et al., 2017;Yun et al., 2019;Verma等人,2019 年)、自然语言处理(Guo 等人,2019 年;Sun et al., 2020),以及最近的时间序列分析(周 et al., 2023;Ansari et al., 2024)。原版 mixup 技术通过线性插值随机混合两个输入数据样本。它的变体通过混合 input 样本或隐藏嵌入来扩展这一点,以获得更好的泛化。在多变量时间序列中,每个样本都包含多个时间序列。因此,我们提出的 Channel Mixup 不是混合两个样本,而是混合同一样本的时间序列。这种策略不仅增强了模型的泛化,还促进了 CD 方法。

3、Preliminary

3.1 多变量时间序列预测

- 在多变量时间序列预测中,我们得到一个历史时间序列 X = {x1, …, xL} ∈ RL×V,回溯窗口为 L,通道数为 V。目标是预测 T 未来值 Y = {xL+1, …, xL+T } ∈ RT ×V .在以下部分中,我们将 Xt表示为时间步 t 上所有通道的值,将 X:,v 表示为由 v 索引的通道的整个序列。相同的注释也适用于 Y。在本文中,我们重点介绍了预测长度大于或等于 96 的长期时间序列预测任务。

h ′ ( t ) = A h ( t ) + B x ( ^ t ) , ( t ) = C h ( t ) + D ⋅ x ( ^ t ) , h'(t)=Ah(t)+Bx\hat(t), (t)=Ch(t)+D·x\hat(t), h′(t)=Ah(t)+Bx(^t),(t)=Ch(t)+D⋅x(^t),

- 其中 A ∈ R S×S 是状态转换矩阵,B ∈ RS×1 和 C ∈ R1×S 是投影矩阵,D ∈ R 是跳过连接参数。当输入和响应都包含 E 个特征时,即 x(t) ∈ RE 和 y(t) ∈ RE,则 SSM 将独立应用于每个特征,即 A ∈ RE×S×S,B ∈ RE×S,C ∈ RE×S,D ∈ RE。为了有效地利用内存,可以将 A 压缩为 RE×S。此后,除非另有说明,否则我们只考虑多功能系统和 A 的压缩形式。对于离散系统,方程 1 可以离散化为:

- 其中德塔 为 采样时间间隔

选择性扫描策略是一种在信息处理、注意力分配或问题解决过程中,通过选择性地关注特定信息区域或内容的策略。其核心思想是避免对全部信息进行全面处理,而是根据目标和需求选择对某些信息进行深入扫描,从而提高效率和准确性。

- 选择性扫描机制传统方法 (Gu et al., 2021) 在序列处理过程中保持传递参数(例如 B 和 C)不变,忽略了它们与输入的关系。Mamba (Gu & Dao, 2023) 采用选择性扫描策略,其中 B ∈ RL×S、C ∈ RL×S 和 ∆ ∈ RL×E 是从输入 X ∈ RL×E 动态派生的。因此,RL×E×S ∈ A 和 B 都依赖于时间步长和特征。这种依赖于数据的机制允许 Mamba 整合上下文信息并有选择地执行状态转换。

这里的循环计算非RNN表示的计算,而是特指下文即将提到的——“并行扫描算法”parallel scan algorithm。并行扫描算法是一种允许在保持循环计算特性的同时,对序列数据进行并行处理的技术。这种方法可以在处理序列时,对序列的各个部分同时进行计算——而不是一个接一个地处理,从而实现并行化)

CMamba 的整体框架。

(a) 通道混合模块在训练期间处于活动状态,它融合样本的不同通道以创建虚拟样本。新样本通过实例规范进行标准化,并在输入模型之前分割成补丁。

(b) CMamba 块由两部分组成:M-Mamba 模块和残差连接前的 GDD-MLP。

(c) M-Mamba 模块捕获跨时间依赖关系。

(d) GDD-MLP 模块捕获跨通道依赖关系。

4、Methodology

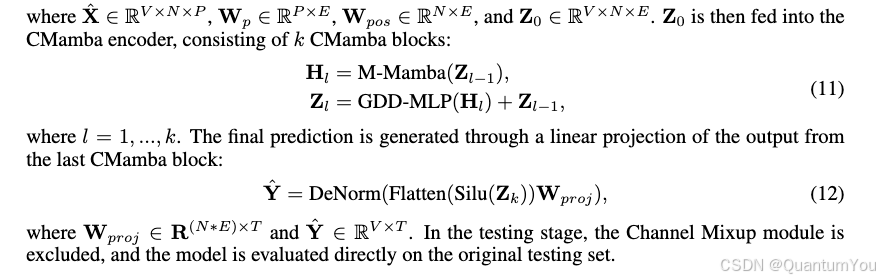

- CMamba 的整体结构如图 3 所示。在训练之前,Channel Mixup 模块沿通道维度混合输入的多元时间序列。接下来是核心架构,包括改进的 Mamba (M-Mamba) 模块和全局数据依赖型 MLP (GDD-MLP) 模块,旨在

捕获跨时间和跨通道依赖关系。这两个模块共同构成了 CMamba 块。CMamba 将 patch-wise 序列作为输入,并使用单个线性层进行预测。以下部分提供了这些组件的详细说明

4.1 CMAMBA 块

- CMamba 块由两个关键组件组成:M-Mamba 模块和 GDD-MLP 模块,分别负责跨时间和跨通道依赖关系的建模。

4.1.1 M-MAMBA

-

Mamba在NLP(Gu & Dao,2023)、CV(Zhu et al.,2024;Liu et al., 2024) 和股票预测 (Shi, 2024)。在这些字段中,特征的语义一致性允许将单词、图像补丁或财务指标等元素视为标记。相比之下,在多变量时间序列中,不同的通道通常代表不同的物理量(Liu et al., 2023a),因此不适合将同一时间点的通道视为标记。虽然每个通道的单个时间步长缺乏语义意义,但修补(Dosovitskiy等人,2020 年;Nie et al., 2022)将时间点聚合为子系列级的补丁,丰富了标记的语义信息和局部感受野。因此,我们将输入时间序列划分为多个块,作为模型的输入。 修补 给定多变量时间序列 X,对于每个单变量序列 X:v ∈ RL,我们通过移动窗口将其分割成补丁长度为 P 和步幅 S 的补丁: X : v = P a t c h i n g ( X : v ) , \mathbf{X}_{:v}=\mathrm{Patching}(\mathbf{X}_{:v}), X:v=Patching(X:v),

-

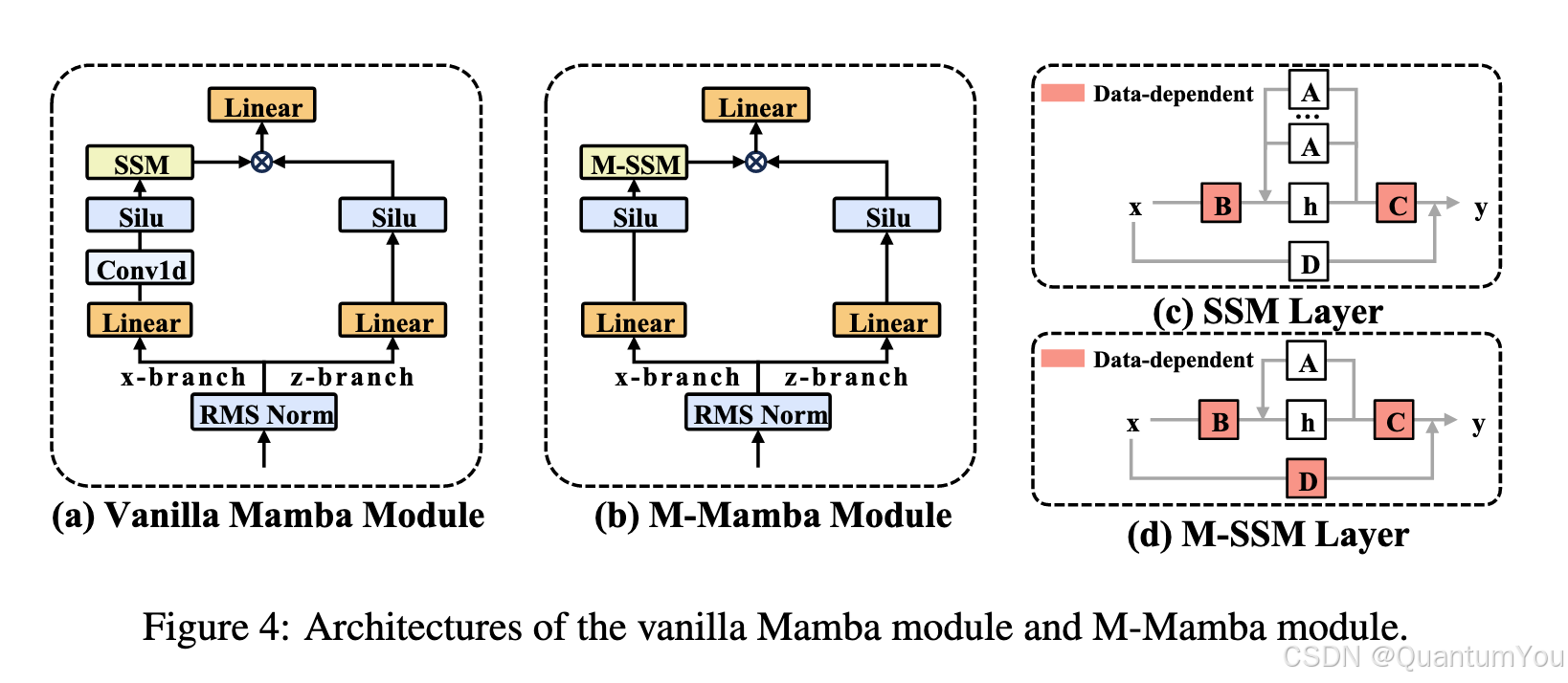

除了修改输入结构外,Mamba 的模型架构还需要进行调整,以适应多变量时间序列数据的特性。我们的 Mamba 变体称为 M曼巴,如图 4 (b) 所示。与原版 Mamba 模块相比,我们的模块有以下不同之处:(1) 我们去掉了 x-branch 卷积操作。(2) 我们不再学习每个特征的过渡矩阵 A,即 M-Mamba 中的 A ∈ RS。(3) 跳跃连接矩阵 D 源自输入时间序列,这意味着 D 也是数据相关的。我们设计的原因将在 Section 5.2 中详细讨论。

曼巴,如图 4 (b) 所示。与原版 Mamba 模块相比,我们的模块有以下不同之处:(1) 我们去掉了 x-branch 卷积操作。(2) 我们不再学习每个特征的过渡矩阵 A,即 M-Mamba 中的 A ∈ RS。(3) 跳跃连接矩阵 D 源自输入时间序列,这意味着 D 也是数据相关的。我们设计的原因将在 Section 5.2 中详细讨论。

4.1.2 GDD-MLP

- 为了尽可能简单有效地模拟跨通道依赖关系,我们提出了全局数据依赖型 (GDD-MLP) 模块。图 3 (b) 和 (d) 说明了它的结构和管道对于1M-Mamba模块后生成的多变量时间序列嵌入,记为H∈RYXNXE,则GDD-MLP的数据依赖权重和偏置可表示为:

W e i g h t l = s i g m o i d ( M L P 1 ( P o o l i n g ( H l ) ) ) , B i a s l = s i g m o i d ( M L P 2 ( P o o l i n g ( H l ) ) ) . \mathbf{Weight}_{l}=\mathrm{sigmoid}(\mathrm{MLP}_{1}(\mathrm{Pooling}(\mathbf{H}_{l}))),\\\mathbf{Bias}_{l}=\mathrm{sigmoid}(\mathrm{MLP}_{2}(\mathrm{Pooling}(\mathbf{H}_{l}))). Weightl=sigmoid(MLP1(Pooling(Hl))),Biasl=sigmoid(MLP2(Pooling(Hl))).

在这里,沿着嵌入维度应用池化,生成描述符F∈RV×N,该描述符封装了每个通道的每个

补丁的总体特征。为了改善每个通道的全局信息提取,我们采用了平均池化和最大池化。

平均和最大描述符共享相同的MLP,其输出被相加以产生潜在空间中的最终通道表示。然

后将权重和偏置应用于输入特征以嵌入跨通道依赖关系:

H

l

′

=

W

e

i

g

h

t

l

⊙

H

l

+

B

i

a

s

l

.

\mathbf{H}_l^{\prime}=\mathbf{Weight}_l\odot\mathbf{H}_l+\mathbf{Bias}_l.

Hl′=Weightl⊙Hl+Biasl.

4.2 通道混淆

以前的混合策略(Zhang等,2017)通过在两个现有样本之间进行线性插值来生成新的训练样

本。对于从训练集中随机抽取的两个特征-目标对(x,y)和(x,y),其过程描述为:

x

~

=

λ

x

i

+

(

1

−

λ

)

x

j

,

y

~

=

λ

y

i

+

(

1

−

λ

)

y

j

,

\tilde{x}=\lambda x_i+(1-\lambda)x_j,\\\tilde{y}=\lambda y_i+(1-\lambda)y_j,

x~=λxi+(1−λ)xj,y~=λyi+(1−λ)yj,

其中(x,y)为合成的虚拟样本,入∈[0,1]为混合系数。在多元时间序列的背景下,直接

应用这种mixup方法可能会产生次优结果,甚至会降低模型性能(Zhou et al…,2023),因为来

自不同时间间隔的混合样本可能会破坏周期性等时间特征。相比之下,多变量时间序列中

的不同通道通常表现出相似的时间特征,这解释了CI策略的有效性(Han等人,2023)。混合不同的通道可以在保留其共享的时间特征的同时引入新的变量。考虑到CD策略由于对分布漂移的时间序列缺乏鲁棒性而容易导致过拟合Han等人,2023),使用未见通道进行训练应该可以缓解这一问题。一般来说,通道混淆可以表述为:

X

′

=

X

:

,

i

+

λ

X

:

,

j

,

i

,

j

=

0

,

.

.

.

,

V

−

1

,

Y

′

=

Y

:

,

i

+

λ

Y

:

,

j

,

i

,

j

=

0

,

.

.

.

,

V

−

1

,

\mathbf{X}^{\prime}=\mathbf{X}_{:,i}+\lambda\mathbf{X}_{:,j}, i,j=0,...,V-1,\\\mathbf{Y}^{\prime}=\mathbf{Y}_{:,i}+\lambda\mathbf{Y}_{:,j}, i,j=0,...,V-1,

X′=X:,i+λX:,j,i,j=0,...,V−1,Y′=Y:,i+λY:,j,i,j=0,...,V−1,

其中,X’∈RL×1和Y’∈RT×1是由通道和通道线性组合而成的混合通道。入~N(O,σ)是

以σ为标准差的线性组合系数。我们使用均值为0的正态分布,确保每个通道的整体特征保持

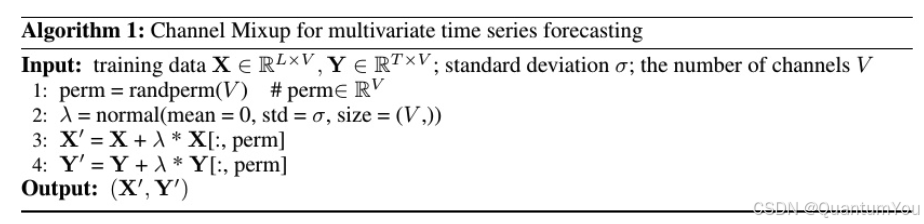

不变。在实践中,如图1所示,我们混合了每个样本的通道,并用构造的虚拟样本替换原始样本,其中randperm(V)生成0~V-l的随机排列数组。

4.3整体管道

在本节中,我们总结了上述流程,并概述了我们模型的训练和测试过程。在训练阶段,给定一个样本(X,Y),首先使用通道混淆技术将其转换为虚拟样本,然后进行实例规范化,以减轻分布偏移:

X

′

,

Y

′

=

C

h

a

n

n

e

l

M

i

x

u

p

(

X

,

Y

)

,

X

n

o

r

m

′

=

I

n

s

t

a

n

c

e

N

o

r

m

(

X

′

)

.

\mathbf{X}^{\prime},\mathbf{Y}^{\prime}=\mathrm{ChannelMixup}(\mathbf{X},\mathbf{Y}),\\\mathbf{X}_{norm}^{\prime}=\mathrm{InstanceNorm}(\mathbf{X}^{\prime}).

X′,Y′=ChannelMixup(X,Y),Xnorm′=InstanceNorm(X′).

随后,将每个通道划分为补丁长度P和补丁编号相等的补丁,然后将这些补丁标记线性投影到大小为E的向量中,然后添加位置编码W。这个过程可以描述为:

X

^

=

P

a

t

c

h

i

n

g

(

X

n

o

r

m

′

)

,

Z

0

=

X

^

W

p

+

W

p

o

s

,

\hat{\mathbf{X}}=\mathrm{Patching}(\mathbf{X}_{norm}^{\prime}),\\\mathbf{Z}_{0}=\hat{\mathbf{X}}\mathbf{W}_{p}+\mathbf{W}_{pos},

X^=Patching(Xnorm′),Z0=X^Wp+Wpos,

5、Experiments

6、CONCLUSION

- 我们提出了一种新的用于多元时间序列预测的状态空间模型CMamba。为了平衡跨时间和跨通道依赖关系,CMamba由三个关键组件组成:一个M-Mamba模块,它为跨时间依赖关系建模提供便利;一个GDD-MLP模块,它捕获跨通道依赖关系;以及一个通道Mixup训练策略,它增强了泛化并促进了cD方法。大量的实验表明,CMamba在七个真实世界的数据集上达到了最先进的性能。值得注意的是,GDD-MLP和通道Mixu模块可以以最小的成本无缝插入到其他模型中,展示了框架的卓越多功能性。在未来,我们的目标是探索更有效的技术来捕获跨时间和跨通道依赖关系。

1019

1019