青稞社区:https://qingkeai.online/

原文:https://mp.weixin.qq.com/s/kSbzGpiyclL0OFb9Ncpl5w

大语言模型(LLM)的强化学习(RL)微调常因训练与推理策略间的数值不匹配而面临训练不稳定的问题。相比在算法上引入重要性采样来打补丁,SeaAI Lab的研究者发现直接从根源上提高浮点数的精度更加有效。

更多论文解读参考:RL训练总是崩?Sea AI Lab 最新成果:只需从 BF16 切换到 FP16 就行

论文:Defeating the Training-Inference Mismatch via FP16

链接:https://arxiv.org/pdf/2510.26788

代码:https://github.com/sail-sg/Precision-RL

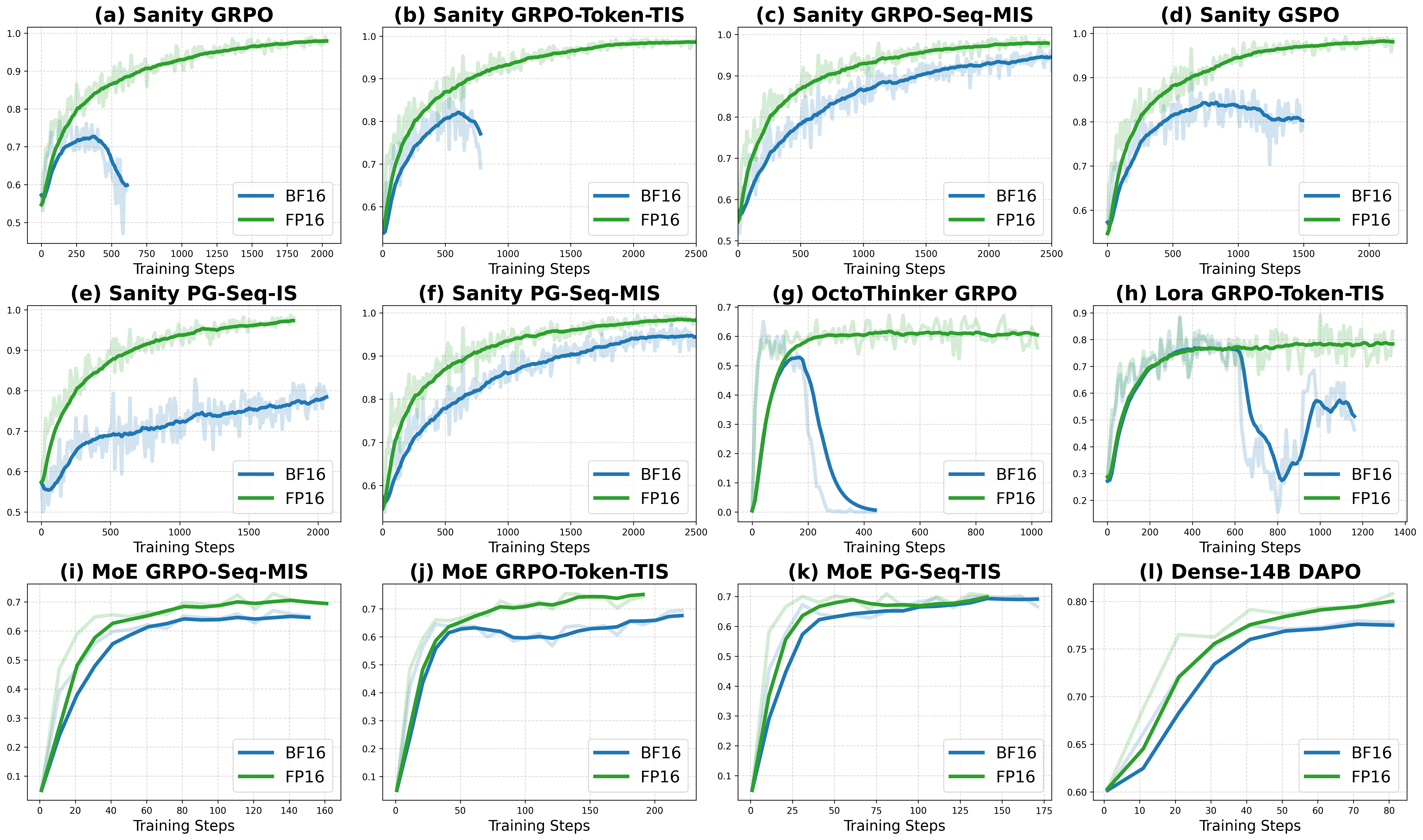

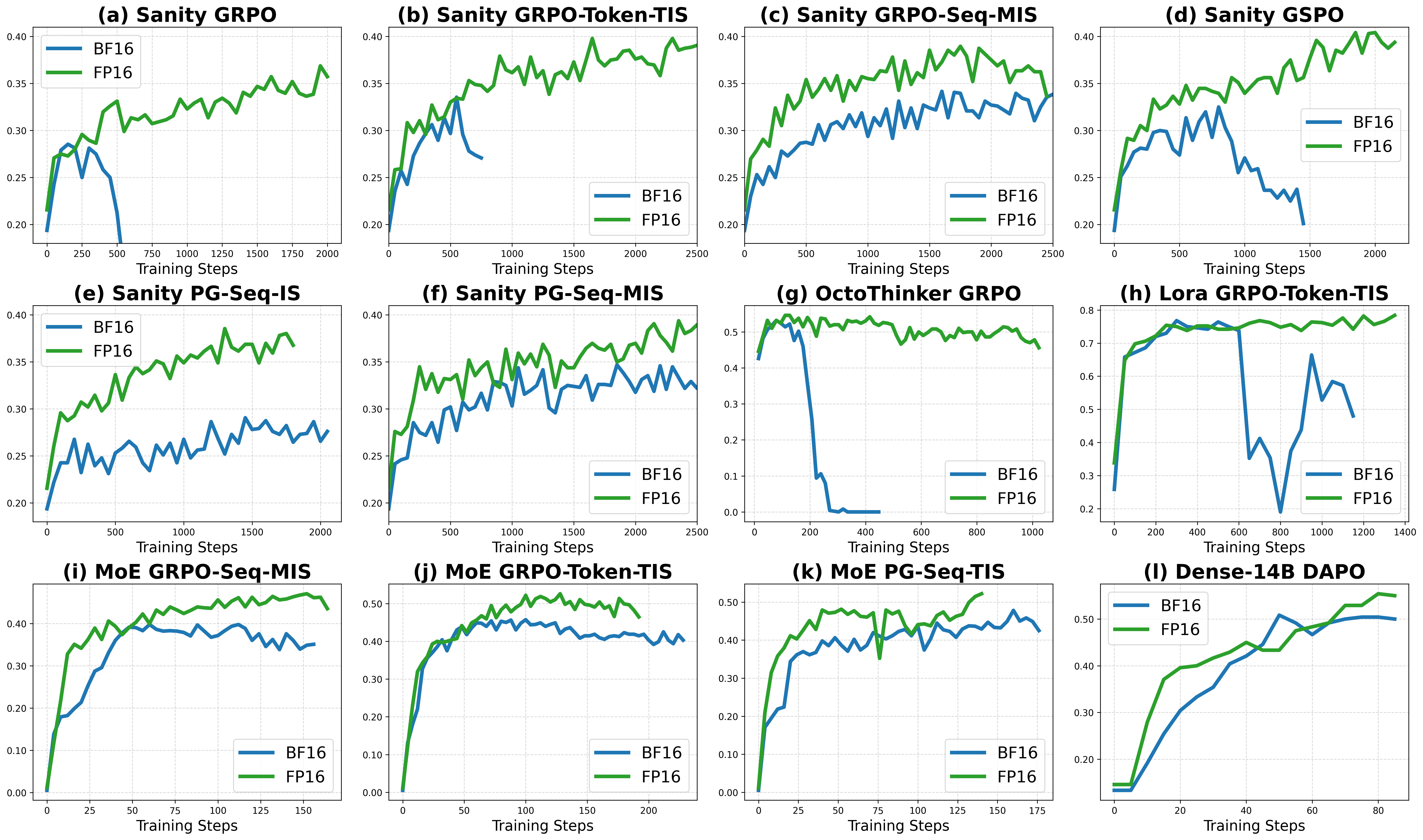

通过将当前主流的 BFloat16 (BF16) 替换为 Float16 (FP16),强化学习的训练稳定性和效率可以大幅度提升。我们希望通过这项研究,可以推动社区重新审视强化学习微调中的精度权衡问题。

12月13日(周六)上午10点,青稞Talk 第97期,SeaAI Lab 研究工程师、新加坡国立大学博士生齐朋辉,将直播分享《从 BF16 到 FP16:如何解决RL训练-推理不匹配问题》。

分享嘉宾

齐朋辉,SeaAI Lab 研究工程师,新加坡国立大学博士生。研究方向为 MLSys 和 RL,主要工作包括:

- 大语言模型推理:Dr.GRPO, AnytimeReasoner, PrecisionRL 等

- 流水线并行优化:Zero-Bubble,V-Shape, PipeOffload 等

- 强化学习:SCC(国内第一个击败职业选手的星际争霸 AI)

主题提纲

从 BF16 到 FP16:如何解决RL训练-推理不匹配问题

1、RL 为什么会出现训练-推理不匹配问题?

2、从 BF16 到 FP16:为什么 FP16 反而更一致

3、FP16 的效果验证及启发探讨

4、AMA (Ask Me Anything)环节

直播时间

12月13日(周六)10:00 - 11:00

如何观看

Talk 将在青稞社区【视频号:青稞AI、Bilibili:青稞AI】上进行进行直播,欢迎预约!!!

461

461

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?