作者:南门子(已授权)

原文:https://zhuanlan.zhihu.com/p/49358536242

>> 加入青稞AI技术交流群,与青年AI研究员/开发者交流最新AI技术

论文:A SURVEY ON POST-TRAINING OF LARGE LANGUAGE MODELS

链接:https://arxiv.org/pdf/2503.06072v1

普遍认为,真正的智能赋予我们推理能力,使我们能够检验假设,并为未来的可能性做好准备。—— Jean Khalfa,《什么是智能?》,1994

摘要

大型语言模型(LLMs)的出现从根本上改变了自然语言处理,使其在从对话系统到科学探索等多个领域不可或缺。然而,它们的预训练架构在特定情境下常常暴露出局限性,包括推理能力有限、伦理不确定性以及领域特定性能不佳等问题。这些挑战需要先进的后训练语言模型(PoLMs)来解决这些不足,例如 OpenAI-o1/o3 和 DeepSeek-R1(统称为大型推理模型,或 LRMs)。

本文首次全面综述了 PoLMs,系统地追溯了它们在五个核心范式中的演变:微调(Fine-tuning),提高任务特定准确性;对齐(Alignment),确保伦理一致性和与人类偏好的对齐;推理(Reasoning),尽管在奖励设计方面存在挑战,但仍推进多步推理;效率(Efficiency),在复杂性不断增加的情况下优化资源利用;以及集成与适应(Integration and Adaptation),扩展跨多种模态的能力,同时解决一致性问题。

从 2018 年 ChatGPT 的基础对齐策略到 2025 年 DeepSeek-R1 的创新推理进展,我们展示了 PoLMs 如何利用数据集减轻偏差、深化推理能力和增强领域适应性。我们的贡献包括对 PoLM 演变的开创性综合、对技术和数据集的结构化分类,以及强调 LRMs 在提高推理能力和领域灵活性方面的战略议程。

作为这一范围内的首个综述,本研究整合了最近的 PoLM 进展,并为未来的研究建立了严格的理论框架,促进在科学和社会应用中精确、伦理稳健且多功能的 LLMs 的发展。

一、引言

语言模型(LMs) 是设计用于建模和生成人类语言的复杂计算框架。这些模型通过使机器能够以接近人类认知的方式理解、生成和与人类语言互动,彻底改变了自然语言处理(NLP) 领域。与人类通过与环境的交互和接触自然习得语言技能不同,机器必须经过广泛的数据驱动训练才能发展出类似的能力。这提出了一个重要的研究挑战,因为使机器能够理解并生成人类语言,同时进行自然、上下文恰当的对话,不仅需要巨大的计算资源,还需要精细的模型开发方法。

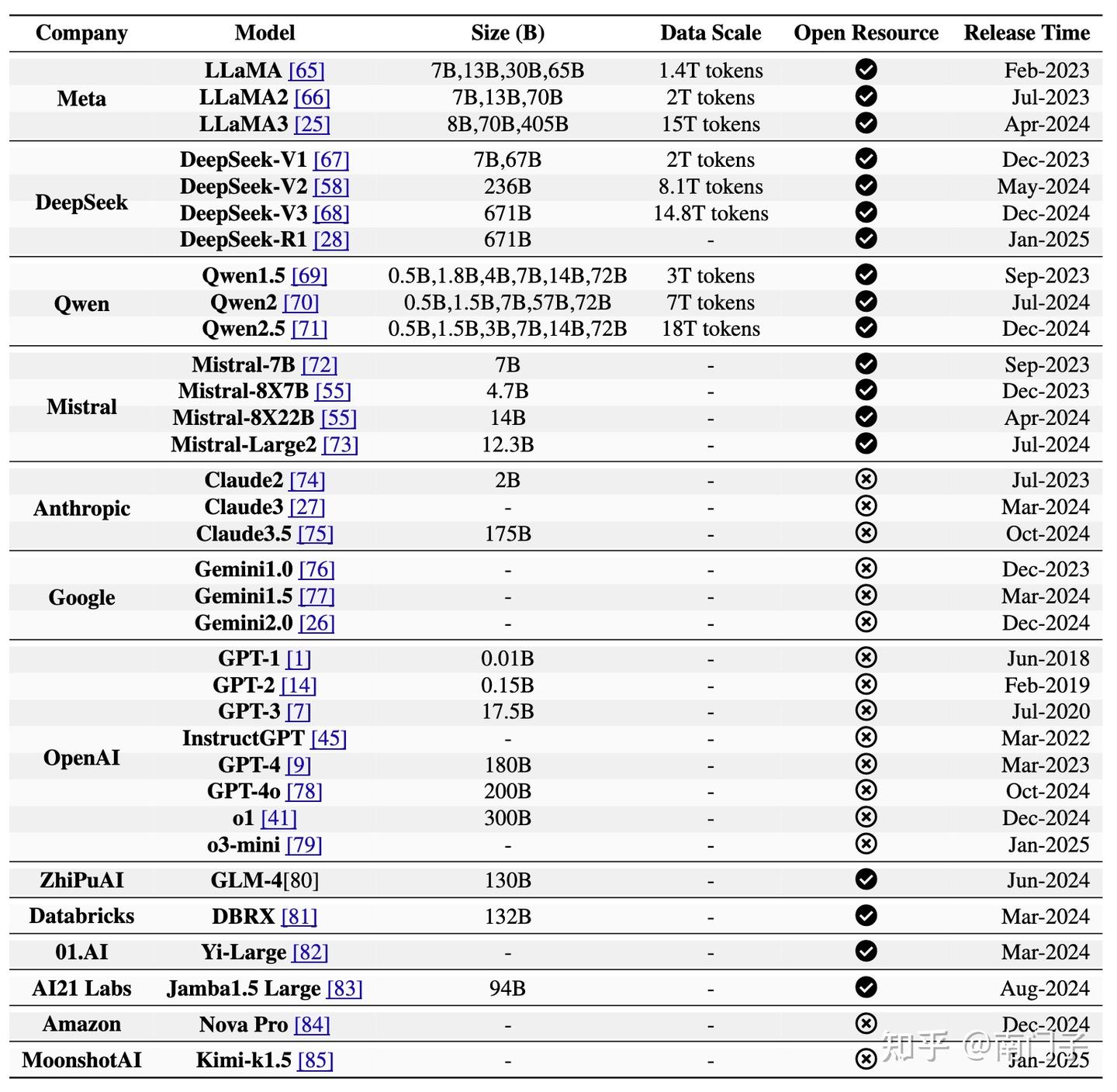

大型语言模型(LLMs) 的出现,如 GPT-3、Instruct GPT 和 GPT-4,标志着语言模型进化的一个变革阶段。这些模型以其广泛的参数化和先进的学习能力为特征,旨在捕捉复杂的语言结构、上下文关系和大规模数据集中的细微模式。这使得 LLMs 不仅能够预测后续单词,还能在包括翻译、问答和摘要在内的各种任务中生成连贯且上下文相关的文本。LLMs 的发展引发了广泛的学术兴趣,可以分为两个主要阶段:预训练(pre-training) 和后训练(post-training)。

预训练

预训练的概念源自计算机视觉(CV)任务中的迁移学习。其主要目标是使用大量数据集开发一个通用模型,以便轻松微调以适应各种下游应用。预训练的一个重要优势是能够利用任何未标注的文本语料库,从而提供丰富的训练数据来源。

然而,早期的静态预训练方法,如神经网络语言模型(NNLM) 和 Word2vec,难以适应不同的文本语义环境,促使了动态预训练技术的发展,如 BERT 和 XLNet。BERT 通过利用 Transformer 架构并在大规模未标注数据集中使用自注意力机制,有效解决了静态方法的局限性。这项研究建立了“预训练和微调”的学习范式,启发了众多后续研究,引入了多种架构,包括 GPT-2 和 BART。

后训练

后训练是指模型经过预训练后所采用的技术和方法,旨在细化和适应特定任务或用户需求。随着具有 1750 亿个参数的 GPT-3 的发布,后训练领域经历了显著的兴趣和创新激增。出现了多种方法来提高模型性能,包括:

- 微调(fine-tuning),即使用标注数据集或特定任务数据调整模型参数;

- 对齐策略(alignment strategies),即优化模型以更好地与用户偏好对齐;

- 知识适配技术(knowledge adaptation techniques),即使模型能够纳入领域特定知识

- 推理改进(reasoning improvements),即增强模型的逻辑推理和决策能力。

这些技术统称为后训练语言模型(PoLMs),催生了如 GPT-4、LLaMA-3、Gemini-2.0 和 Claude-3.5 等模型的开发,标志着 LLM 能力的重大进展。然而,后训练模型通常难以不经重新训练或重大参数调整而适配新任务,这使得 PTM 开发成为活跃的研究领域。

正如所强调的,预训练语言模型(PLMs) 主要旨在提供一般知识和能力,而 PoLMs 则专注于将这些模型适应特定任务和需求。一个显著的例子是最新一代的 LLM,DeepSeek-R1,它展示了 PoLMs 在增强推理能力、与用户偏好对齐以及提高跨领域适应性方面的演变。

此外,开源 LLMs(例如 LLaMA、Gemma 和 Nemotron)和领域特定的大规模数据集(例如 Prompt Source 和 Flan)的日益可用,正在推动学术研究人员和行业从业者开发 PoLMs 的趋势。这一趋势突显了在 PoLMs 领域中定制适应性的重要性。

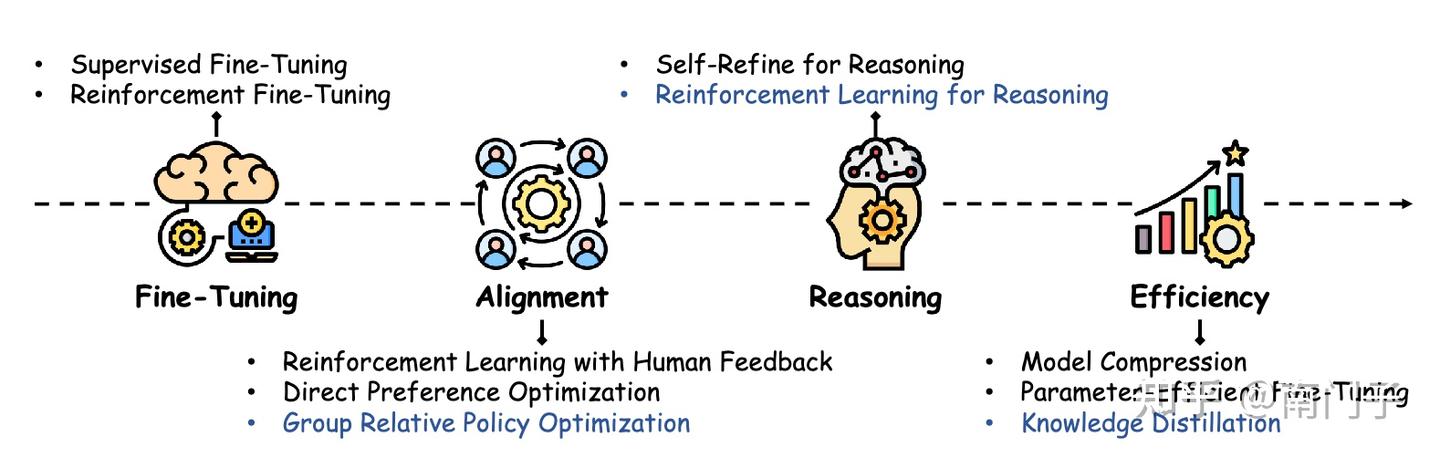

在现有文献中,PLMs 已被广泛讨论和综述,而 PoLMs 很少被系统地审查。为了推进这些技术,有必要彻底审查现有的研究成果,以识别关键挑战、差距和进一步改进的机会。本调查旨在填补这一空白,通过提供一个结构化的框架来研究后训练的演变。如图1所示,它探讨了后训练的多个阶段,特别关注从 ChatGPT 到 DeepSeek 所采用的方法。这些技术涵盖了广泛的 方法,包括微调、LLM 对齐、推理增强和效率改进。图中的蓝色部分特别突出了 DeepSeek 应用的一组后训练方法,强调了为其成功适应用户偏好和领域特定需求做出贡献的创新策略。

1.1 主要贡献

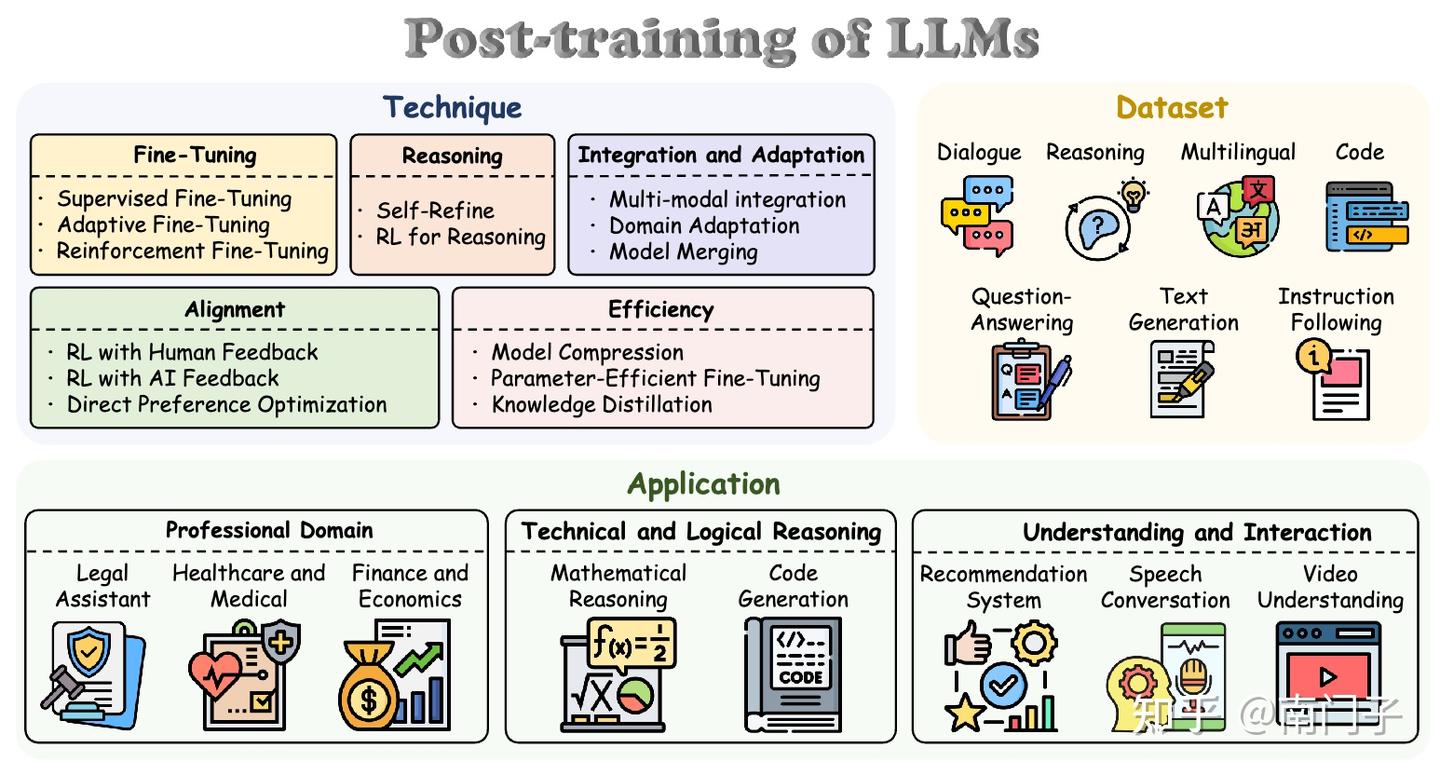

本文是关于PoLMs的首个全面综述,提供了该领域最新进展的详尽、结构化的探索。尽管先前的综述通常集中于LLM开发的具体方面,例如偏好对齐、参数高效的微调[39]和LLM的基础技术[40],但它们大多集中在狭窄的子主题上。相比之下,本综述采取了整体方法,全面回顾了后训练中常用的核⼼技术,并系统地对这些技术进行了分类。此外,我们研究了这些方法所依赖的数据集和实际应用,如图2所示,并指出了未来研究的开放挑战和有前景的方向。本综述的主要贡献如下:

全面的历史综合

我们首次深入综合了PoLMs的发展历程,从ChatGPT最初的基于人类反馈的强化学习(RLHF)到DeepSeek-R1创新的冷启动RL方法。这一综合涵盖了关键技术(即微调(Fine-tuning)、对齐(Alignment)、推理(Reasoning)、效率(Efficiency)和集成与适应(Integration and Adaptation)),分析了它们的发展及相关的挑战,如计算复杂性和伦理考虑。通过将这一发展过程呈现为一个连贯的叙述,并辅以必要的参考文献,我们为研究人员提供了近年来后训练发展的全面概述,成为该领域的基础资源。

结构化的分类和框架

我们引入了一个结构化的分类体系,如图2所示,将后训练方法分为五个不同的类别,并将数据集组织成七种类型,同时在专业、技术和交互领域框定了应用。这一框架明确了这些方法之间的相互关系及其实际意义,提供了对其发展的系统视角。通过提供明确定义的类别和分析见解,我们提高了初学者和专家的访问和理解能力,建立了一本全面的指南,帮助他们应对后训练研究的复杂性。

未来方向

我们突出了新兴趋势,特别是大型推理模型(LRMs)如 o1 和 DeepSeek-R1 的兴起,这些模型利用大规模的强化学习推动了推理能力的边界。我们强调,持续的技术进步对于进一步提升推理能力和领域适应性至关重要。我们的分析识别了关键挑战,包括可扩展性限制、伦理对齐风险和多模态集成障碍。我们提出了自适应RL框架和公平性优化等研究方向。这些方向旨在推动后训练的发展,确保LLMs实现更高的精确度和可信度,以满足未来的需求。

1.2 本文组织

本综述系统地组织,全面探讨了后训练语言模型(Post-training Language Models, PoLMs),涵盖了其历史演变、方法论、数据集、应用及未来趋势。

第2节提供了PoLMs的历史概述。第3节考察了微调技术,包括第3.1节的监督微调(Supervised Fine-Tuning, SFT)和第3.3节的强化微调(Reinforcement Fine-Tuning, RFT)。

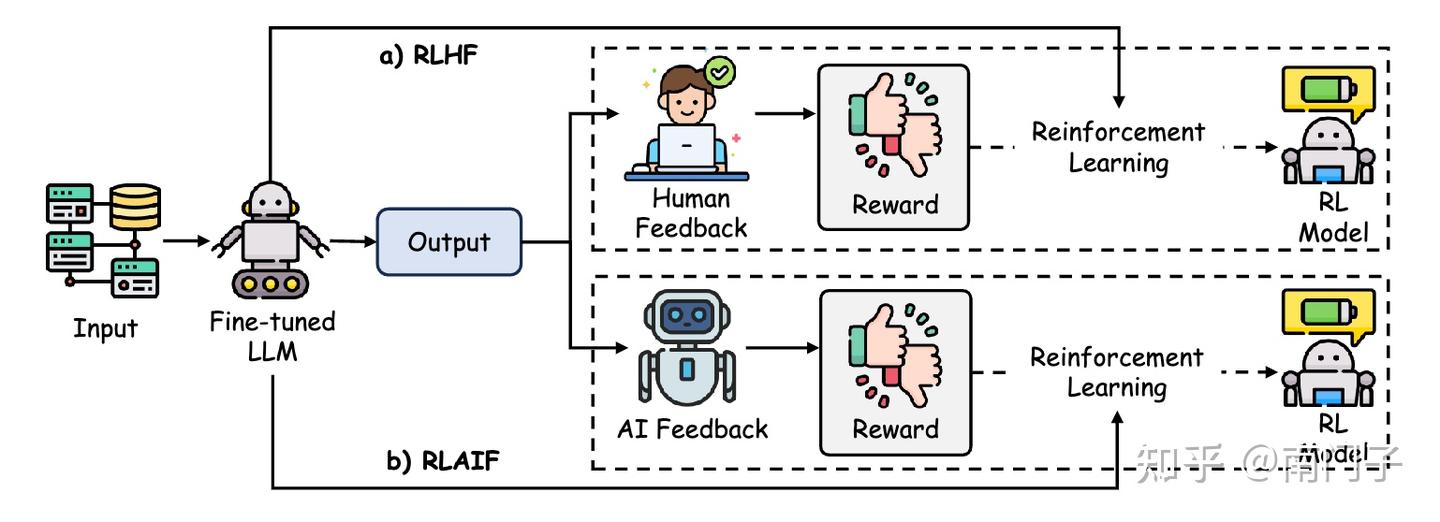

第4节讨论了对齐问题,涵盖第4.1节的人类反馈强化学习(Reinforcement Learning from Human Feedback, RLHF)、第4.2节的人工智能反馈强化学习(Reinforcement Learning from AI Feedback, RLAIF)以及第4.3节的直接偏好优化(Direct Preference Optimization, DPO)。

第5节聚焦推理能力,包括第5.1节的自精炼方法(Self-Refinement Methods)和第5.2节的推理强化学习(Reinforcement Learning for Reasoning)。

第6节调查了提高效率的方法,包括第6.1节的模型压缩(Model Compression)、第6.2节的参数高效微调(Parameter-Efficient Fine-Tuning, PEFT)和第6.3节的知识蒸馏(Knowledge Distillation)。

第7节研究了集成与适应技术,涉及多模态方法、领域适应和模型融合。第8节回顾了后训练中使用的数据集。第9节探索了大型语言模型的应用。第10节评估了开放问题和未来方向。最后,第11节以总结和研究展望作为结尾。

2 概览

2.1 PoLMs 的历史

大型语言模型(LLM)的发展构成了自然语言处理(NLP)领域的一个重要篇章,其中后训练方法作为关键催化剂,推动了这些模型从通用预训练架构向专门化任务适应系统的演变。

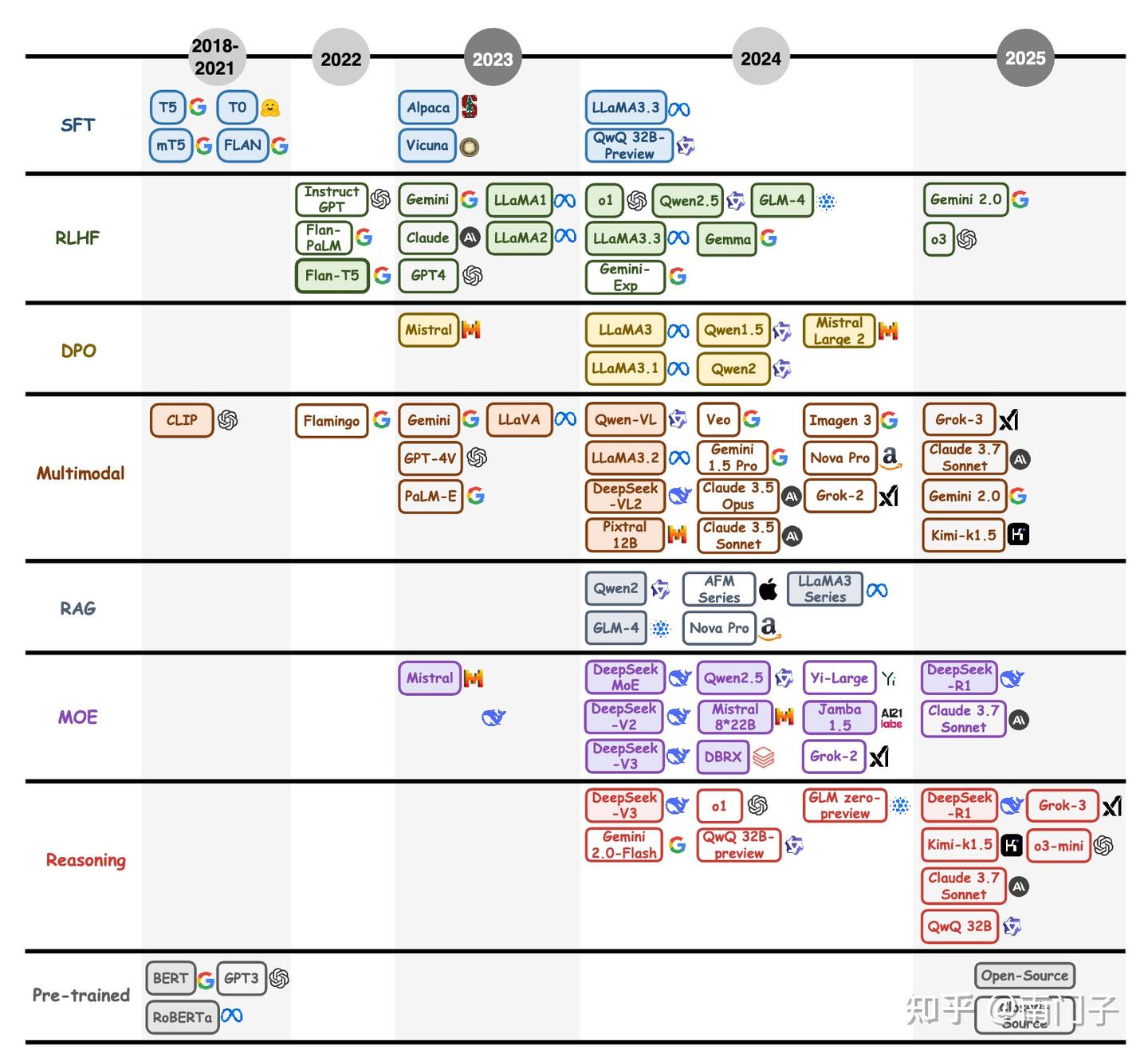

本节概述了后训练语言模型(PoLM)的历史轨迹,追溯其发展从以 BERT 和 GPT 代表的预训练里程碑到现代模型如 o1 和 DeepSeek-R1 所体现的复杂后训练范式。如图3所示,这一进展反映了从建立广泛的语言能力到增强任务特定适应性、伦理一致性、推理复杂性和多模态整合的转变,标志着LLM能力的变革之旅。

现代PoLM历史的开端与2018年的预训练革命相吻合,当时 BERT 和 GPT 的发布重新定义了NLP基准。BERT的双向自动编码框架利用了Transformer架构和自注意力机制,在诸如问答等任务中出色地捕捉了上下文依赖关系;而GPT的自回归设计则侧重于生成连贯性,为文本生成设定了先例。这些模型确立了“预训练和微调”范式,随后在2019年通过T5 进一步完善,该模型统一了多种任务的文本到文本框架,促进了多任务学习并为后训练进步奠定了坚实基础。

从2020年起,PoLM的格局开始显著演变,这主要是由于需要高效地将预训练模型适应于各种任务并在数据有限的情况下进行。早期创新如前缀调优和提示调优引入了轻量级适应策略,通过修改模型输入而不是重新训练整个架构来实现多任务灵活性,从而节省计算资源并扩大应用范围。

这一时期还见证了以用户为中心优化的关键转变,即2021年引入的人类反馈强化学习(RLHF),该技术利用人类评估使模型输出与主观偏好对齐,增强了对话场景中的实用性。到2022年,随着近端策略优化(PPO)的采用,RLHF进一步成熟,改进了对齐稳定性和减轻了对噪声反馈的过拟合。

2022年底 ChatGPT 的发布凝聚了这些进步,展示了RLHF在创建响应迅速且用户对齐的LLM方面的变革潜力,并催化了 PoLM 研究的激增。同时,思维链(Chain-of-Thought, CoT)提示作为一种推理增强策略出现,鼓励模型在复杂任务中阐述中间步骤,从而提高了透明度和准确性,特别是在逻辑推理和问题解决领域。

2022年至2024年间,PoLM多样化发展,以应对领域特异性、伦理稳健性和多模态整合的需求,反映出对LLM改进越来越细致的方法。领域适配技术如检索增强生成(Retrieval-Augmented Generation, RAG)出现,旨在集成外部知识库,使专门领域的输出更加丰富,而无需进行全面再训练——这对于需要最新信息的专业应用至关重要。伦理对齐努力加强,2023年直接偏好优化(Direct Preference Optimization, DPO)简化了RLHF,直接针对人类偏好优化模型输出,绕过了中间奖励建模,提高了效率和稳健性。

与此同时,多模态能力的追求也取得了进展,PaLM-E 和 Flamingo 等模型开创了视觉-语言整合的先河,随后 BLIP-2 和 LLaVA 将这些努力扩展到了更广泛的领域,如医学成像。效率创新与这些发展并行,特别是通过专家混合(Mixture of Experts, MoE)架构;

2022年,Google 的 Switch-C Transformer 引入了1.6万亿参数跨2048个专家的稀疏激活,而 Mixtral 进一步完善了这一范式,平衡了可扩展性和性能。期间的推理增强,如自我博弈和蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)与CoT的结合,通过模拟迭代推理路径进一步增强了LLM的决策能力,为高级推理导向模型奠定了基础。

一个重要的架构进步是专家混合(MoE)模型的兴起,这些模型通过动态激活选择性的参数子集,从传统的密集架构中脱颖而出,从而优化计算效率并容纳庞大的参数规模。这一范式由 Google 的 Switch-C Transformer 在2022年率先提出,该模型拥有1.6万亿参数分布在2048个专家中,这是一种平衡资源需求与性能提升的开创性方法。后续迭代,如Mixtral 和 DeepSeek V2.5 ——后者利用2360亿总参数,其中21亿活跃于160个专家中——进一步完善了这一框架,在LMSYS基准上取得了最先进的结果,并证明稀疏MoE架构可以在可扩展性和效能方面与密集模型相媲美。

这些发展突显了向效率导向的PoLM的转变,使LLM能够以较低的计算开销处理复杂任务,这是扩大其实用性的关键一步。到2025年,DeepSeek-R1 成为了PoLM创新的里程碑,它摆脱了传统监督微调(SFT)的依赖,转而采用链式思维(CoT)推理和探索性RL策略。

以DeepSeek-R1-Zero为例,该模型集成了自我验证、反思和扩展的CoT生成,验证了在开放研究范式中RL驱动的推理激励,引入了蒸馏技术将复杂的推理模式从较大的架构转移到较小的架构。这种方法不仅比单独的RL训练表现出更高的性能,还预示了一种可扩展的、以推理为中心的LLM范式,旨在解决后训练方法中持续存在的计算效率和任务适应性挑战。

2.2 PoLM的公式基础

2.2.1 策略优化原理

近端策略优化(PPO)算法是一种关键的强化学习技术,特别适用于需要保持稳定性和效率的场景,例如基于人类反馈的强化学习(RLHF)。PPO通过限制策略更新的幅度来实现这些目标,确保模型行为的变化是渐进和可控的,从而防止性能的灾难性下降。这在微调大规模语言模型时尤为重要,因为剧烈的策略更新可能导致不可取或不可预测的行为。

定义。 在PPO的上下文中,状态 s t ∈ S s_{t}\in\mathcal{S} st∈S 表示时间 t t t 的状态,包括模型做出决策所需的所有相关信息。动作 a t ∈ A ( s t ) a_{t}\in\mathcal{A}(s_{t}) at∈A(st) 表示模型在给定状态 s t s_{t} st 时所做的选择。这个动作是模型所做的一系列决策的一部分。

执行动作后,智能体接收奖励 r t ∈ R r_{t}\in\mathbb{R} rt∈R ,这是来自环境的反馈,表明所采取行动的成功或失败。优势函数 A π ( s , a ) A^{\pi}(s,a) Aπ(s,a) 衡量在当前策略 π \pi π 下,在状态 s s s 中采取动作 a a a 的优势,相对于该状态下所有动作的期望值。它正式定义为动作价值函数 Q π ( s , a ) Q^{\pi}(s,a) Qπ(s,a) 和状态价值函数 V π ( s ) V^{\pi}(s) Vπ(s) 之间的差异:

A π ( s , a ) = Q π ( s , a ) − V π ( s ) A^{\pi}(s,a)=Q^{\pi}(s,a)-V^{\pi}(s) Aπ(s,a)=Qπ(s,a)−Vπ(s)

其中 Q π ( s , a ) Q^{\pi}(s,a) Qπ(s,a) 表示在状态 s s s 中采取动作 a a a 并遵循策略 π \pi π 所获得的预期累积奖励,而 V π ( s ) V^{\pi}(s) Vπ(s) 是从状态 s s s 开始并遵循策略 π \pi π 所获得的预期累积奖励。这两个函数都考虑了未来的奖励,并通过因子 γ \gamma γ 进行折现。

策略更新。 PPO算法通过基于优势函数进行增量更新来优化策略 π θ \pi_{\theta} πθ。策略更新使用剪切目标函数:

L C L I P ( θ ) = E ^ t [ min ( r t ( θ ) A ^ t , clip ( r t ( θ ) , 1 − ϵ , 1 + ϵ ) A ^ t ) ] L^{C L I P}(\theta)=\hat{\mathbb{E}}_{t}\left[\operatorname*{min}\left(r_{t}(\theta)\hat{A}_{t},\operatorname{clip}\left(r_{t}(\theta),1-\epsilon,1+\epsilon\right)\hat{A}_{t}\right)\right] LCLIP(θ)=E^t[min(rt(θ)A^t,clip(rt(θ),1−ϵ,1+ϵ)A^t)]

其中 r t ( θ ) r_{t}(\theta) rt(θ) 表示在当前策略 π θ \pi_{\theta} πθ 下采取动作 a t a_{t} at 的概率与旧策略 π θ o l d \pi_{\theta_{\mathrm{old}}} πθold 下采取动作 a t a_{t} at 的概率之比。该比率定义为:

r t ( θ ) = π θ ( a t ∣ s t ) π θ o l d ( a t ∣ s t ) r_{t}(\theta)=\frac{\pi_{\theta}(a_{t}|s_{t})}{\pi_{\theta_{\mathrm{old}}}(a_{t}|s_{t})} rt(θ)=πθold(at∣st)πθ(at∣st)

A ^ t \hat{A}{t} A^t 是在时间步 t t t 的估计优势,而剪切函数 c l i p ( r t ( θ ) , 1 − ϵ , 1 + ϵ ) \mathrm{clip}(r{t}(\theta),1-\epsilon,1+\epsilon) clip(rt(θ),1−ϵ,1+ϵ) 将策略更新限制在一个安全范围内,由超参数 ϵ \epsilon ϵ 控制。这种剪切机制确保更新不会与之前的策略相差太大,从而在训练过程中保持稳定性。

价值函数更新。 价值函数 V ϕ V_{\phi} Vϕ 估计在给定状态 s t s_{t} st 下,根据策略 π θ \pi_{\theta} πθ 获得的预期累积奖励。为了确保价值函数提供准确的估计,它通过最小化预测值与实际奖励之间的均方误差来优化:

ϕ k + 1 = arg min ϕ E s t ∼ π θ k [ ( V ϕ ( s t ) − R ( s t ) ) 2 ] \phi_{k+1}=\arg\operatorname*{min}_{\phi}\mathbb{E}_{s_{t}\sim\pi_{\theta_{k}}}\left[\left(V_{\phi}(s_{t})-R(s_{t})\right)^{2}\right] ϕk+1=argϕminEst∼πθk[(Vϕ(st)−R(st))2]

其中 R ( s t ) R(s_{t}) R(st) 是从状态 s t s_{t} st 获得的实际累积奖励,而 V ϕ ( s t ) V_{\phi}(s_{t}) Vϕ(st) 是当前策略下的估计值。目标是调整参数 ϕ \phi ϕ 以最小化预测值与实际奖励之间的差异,提高价值函数的准确性。

2.2.2 RLHF 原理

强化学习结合人类反馈(Reinforcement Learning with Human Feedback, RLHF)是通过在学习过程中利用人类生成的反馈来使模型与人类偏好对齐的关键方法。这种方法引入了一个奖励函数,该函数显式地捕捉了人类输入,使得模型能够更好地适应用户偏好和实际应用。

定义。 在 RLHF 中,语言模型 ρ \rho ρ 生成一个关于词汇表 Σ \Sigma Σ 的序列的概率分布。模型 ρ \rho ρ 从输入空间 X = Σ ≤ m X=\Sigma^{\leq m} X=Σ≤m中生成一系列的标记 x 0 , x 1 , … , x n − 1 x_{0},x_{1},\dotsc,x_{n-1} x0,x1,…,xn−1 ,其中每个标记都条件依赖于之前的标记。模型的输出由以下条件概率分布定义:

ρ ( x 0 ⋅ ⋅ ⋅ x n − 1 ) = ∏ 0 ≤ k < n ρ ( x k ∣ x 0 ⋅ ⋅ ⋅ x k − 1 ) \rho\left(x_{0}\cdot\cdot\cdot x_{n-1}\right)=\prod_{0\leq k<n}\rho\left(x_{k}\mid x_{0}\cdot\cdot\cdot x_{k-1}\right) ρ(x0⋅⋅⋅xn−1)=0≤k<n∏ρ(xk∣x0⋅⋅⋅xk−1)

模型 ρ \rho ρ 在一个由输入空间 X X X 、数据分布 D D D 和输出空间 Y = Σ ≤ n Y=\Sigma^{\leq n} Y=Σ≤n 定义的任务上进行训练。例如,在文本摘要任务中,如文献 [16] 所示,GPT-2 模型使用 RLHF 进行训练,任务涉及基于 CNN/DailyMail 和 TL;DR 等数据集预测文本摘要。

目标函数。 策略 π \pi π 是一个与原始模型 ρ \rho ρ 结构相同的语言模型。最初,策略 π \pi π 被设置为等于 ρ \rho ρ 。目标是通过优化策略来最大化输入输出对 ( x , y ) (x,y) (x,y) 的预期奖励 R ( x , y ) R(x,y) R(x,y) 。奖励函数 R ( x , y ) : X × Y → R R(x,y):X\times Y\rightarrow\mathbb{R} R(x,y):X×Y→R 为每个输入输出对分配一个标量值,最优策略 π ∗ \pi^{*} π∗ 通过解决以下最大化问题获得:

π ∗ = max π E [ R ] = E x ∼ D , y ∼ π ( ⋅ ∣ x ) [ R ( x , y ) ] \pi^{*}=\operatorname*{max}_{\pi}\mathbb{E}[R]=\mathbb{E}_{x\sim\mathcal{D},y\sim\pi(\cdot|x)}[R(x,y)] π∗=πmaxE[R]=Ex∼D,y∼π(⋅∣x)[R(x,y)]

这个目标函数代表了一个标准的强化学习问题,其中模型通过与环境的交互并在人类反馈的引导下学习最大化预期奖励。

2.2.3 DPO 原理

直接偏好优化(Direct Preference Optimization, DPO) 基于强化学习与人类反馈(RLHF),通过直接根据人类偏好优化模型的输出来改进模型。这些偏好通常以成对比较的形式表达。DPO 消除了传统奖励函数的需要,而是通过最大化基于偏好的奖励来优化模型行为。

目标函数。在一般奖励函数 r r r 下,KL 约束下的奖励最大化目标的最优解由下式给出:

π r ( y ∣ x ) = 1 Z ( x ) π r e f ( y ∣ x ) exp ( 1 β r ( x , y ) ) \pi_{r}(y\mid x)=\frac{1}{Z(x)}\pi_{\mathrm{ref}}(y\mid x)\exp\left(\frac{1}{\beta}r(x,y)\right) πr(y∣x)=Z(x)1πref(y∣x)exp(β1r(x,y))

其中 Z ( x ) Z(x) Z(x) 是确保输出在所有可能动作上归一化的分区函数。即使使用真实奖励 Z ( x ) Z(x) Z(x) 的最大似然估计 r ϕ r_{\phi} rϕ ,分区函数 Z ( x ) Z(x) Z(x) 也可以近似,从而简化优化过程。这种表述通过直接根据人类反馈调整策略,使得偏好优化更加高效。

偏好模型。使用 Bradley-Terry 模型,该模型描述了两个输出 y 1 y_{1} y1 和 y 2 y_{2} y2 之间的偏好,最优策略 π ∗ \pi^{*} π∗ 满足以下偏好模型:

p ∗ ( y 1 ≻ y 2 ∣ x ) = 1 1 + exp ( β log π ∗ ( y 2 ∣ x ) π r e f ( y 2 ∣ x ) − β log π ∗ ( y 1 ∣ x ) π r e f ( y 1 ∣ x ) ) p^{*}(y_{1}\succ y_{2}\mid x)={\frac{1}{1+\exp\left(\beta\log{\frac{\pi^{*}(y_{2}\mid x)}{\pi_{\mathrm{ref}}(y_{2}\mid x)}}-\beta\log{\frac{\pi^{*}(y_{1}\mid x)}{\pi_{\mathrm{ref}}(y_{1}\mid x)}}\right)}} p∗(y1≻y2∣x)=1+exp(βlogπref(y2∣x)π∗(y2∣x)−βlogπref(y1∣x)π∗(y1∣x))1

其中 p ∗ ( y 1 ≻ y 2 ∣ x ) p^{*}(y_{1}\succ y_{2}\mid x) p∗(y1≻y2∣x) 表示在给定输入 x x x 的情况下,人类更喜欢输出 y 1 y_{1} y1 而不是 y 2 y_{2} y2 的概率。这种方法有效地将人类偏好纳入模型的优化过程中。

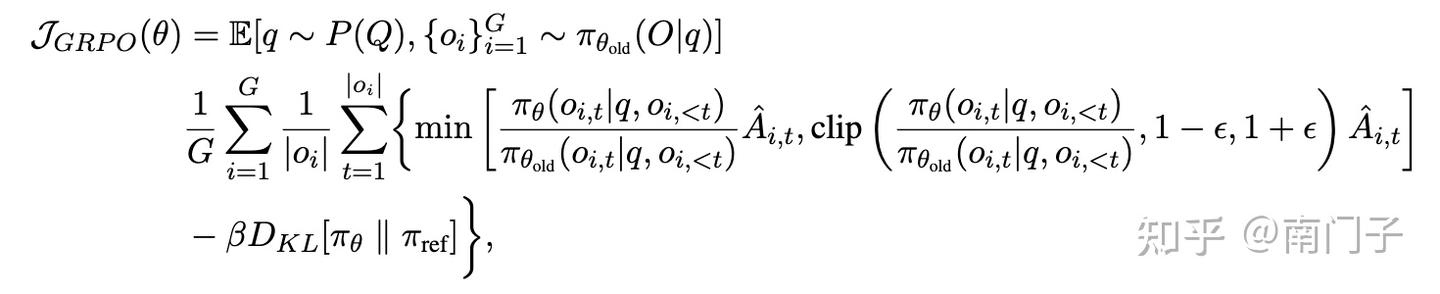

2.2.4 GRPO 原理

组相对策略优化(Group Relative Policy Optimization, GRPO)算法是强化学习中近端策略优化(Proximal Policy Optimization, PPO)算法的一种变体,首次在 DeepSeek 的前期工作《DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models》中提出。GRPO 省略了评估模型(critic model),而是使用组得分来估计基线,这与 PPO 相比显著减少了训练资源消耗。

定义。GRPO 和 PPO 算法之间最显著的区别在于优势函数的计算方法。从第 2.2.1 节中的公式 1 可以看出,PPO 中优势函数 A π ( s , a ) A^{\pi}(s,a) Aπ(s,a) 的值是从 Q Q Q 值和 V V V 值之间的差异得出的。

目标函数。具体来说,对于每个问题 q q q ,GRPO 从旧策略 π θ o l d \pi_{\theta_{\mathrm{old}}} πθold 中采样一组输出 o 1 , o 2 , … , o G {o_{1},o_{2},\ldots,o_{G}} o1,o2,…,oG,然后通过最大化以下目标来优化策略模型:

其中 ϵ \epsilon ϵ 和 β \beta β 是超参数, A ^ i , t \hat{A}_{i,t} A^i,t 是基于每组内部输出的相对奖励计算的优势,详细内容将在第 5.2 节中介绍。

三、PoLMs 微调

微调构成了将预训练大型语言模型(LLMs)适应特定任务的核心,通过有针对性的参数调整来优化其能力。这一过程利用标注数据集或任务特定数据集来优化性能,弥合通用预训练与领域特定需求之间的差距。本章探讨三种主要的微调范式:

- 监督微调(§3.1),使用标注数据集来提高任务特定的准确性;

- 自适应微调(§3.2),通过指令微调和基于提示的方法来定制模型行为;

- 强化微调(§3.3),将强化学习整合进来,根据奖励信号迭代地优化输出,通过动态交互促进持续改进。

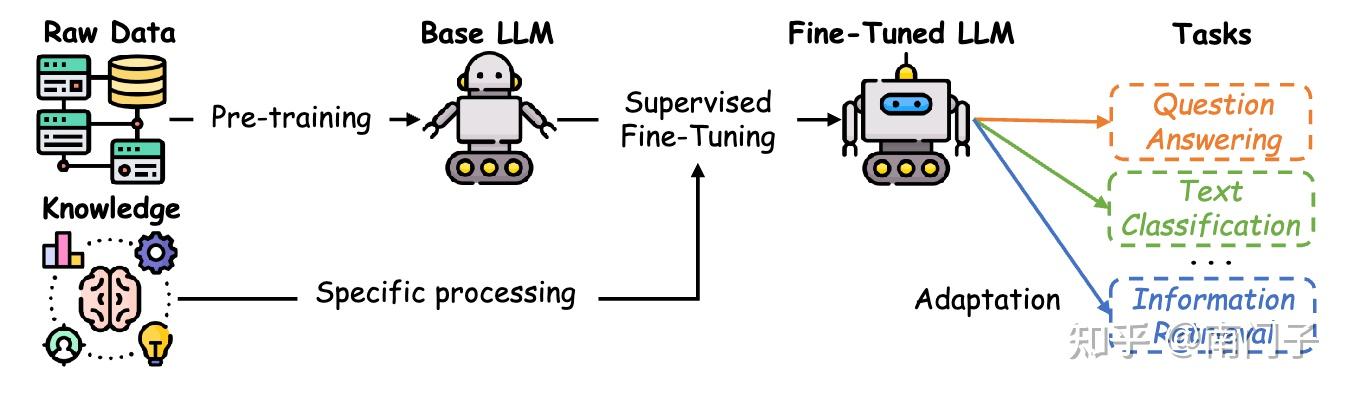

3.1 有监督微调

监督微调(Supervised Fine-Tuning, SFT) 通过利用特定任务的标注数据集,将预训练的大型语言模型(LLMs)适应于特定任务。不同于依赖指令提示的指令微调,SFT直接使用标注数据调整模型参数,生成既精确又具有上下文感知能力的模型,同时保留广泛的泛化能力。

SFT弥合了预训练期间编码的广泛语言知识与目标应用的细微需求之间的差距。预训练的LLMs通过接触大量语料库,获得了一般的语言模式,减少了对大量领域特定数据进行微调的依赖。模型选择至关重要:较小的模型如 T5 在资源受限且数据集有限的环境中表现出色,而较大的模型如 GPT-4 则利用其卓越的容量,在复杂且数据丰富的任务中表现出色。

3.1.1 SFT 数据准备

构建高质量的SFT数据集是一个多方面的过程,对于微调的成功至关重要。

SFT 数据集构建

SFT 数据集通常结构化为 D = ( I k , X k ) k = 1 N \mathcal{D}\,=\,{(I_{k},X_{k})}{k=1}^{N} D=(Ik,Xk)k=1N ,其中 I k I_{k} Ik 是一条指令, X k X_{k} Xk 是其对应的实例。这种配对使大语言模型(LLM)能够识别任务特定的模式并生成相关输出。诸如 Self-Instruct 等方法通过合成新的指令-输出对来丰富多样性,并使用如 ROUGE-L 等指标过滤重复项以保持多样性。

SFT 数据集筛选

筛选确保只有高质量的指令-实例对保留在最终的数据集中。使用筛选函数 r ( ⋅ ) r(\cdot) r(⋅) 来评估每对 ( I k , X k ) (I_{k},X_{k}) (Ik,Xk) 的质量,从而得到一个精选子集 D ′ \mathcal{D}^{\prime} D′ :

D ′ = { ( I k , X k ) ∈ D ∣ r ( I k , X k ) ≥ τ } \mathcal{D}^{\prime}=\{\,(I_{k},X_{k})\in\mathcal{D}\;|\;r(I_{k},X_{k})\geq\tau\} D′={(Ik,Xk)∈D∣r(Ik,Xk)≥τ}

其中 τ \tau τ 是用户定义的质量阈值。例如,指令跟随难度(Instruction Following Difficulty, IFD)度量量化了一条给定的指令如何有效地引导模型生成预期响应。IFD 函数表示为:

r θ ( Q , A ) = ∑ i = 1 N log P ( w i A ∣ Q , w 1 A , . . , w i − 1 A ; θ ) ∑ i = 1 N log P ( w i A ∣ w 1 A , . . , w i − 1 A ; θ ) r_{\theta}(Q,A)=\frac{\sum_{i=1}^{N}\log P\big(w_{i}^{A}\mid Q,\:w_{1}^{A},\:.\:.\:,\:w_{i-1}^{A};\:\theta\big)}{\sum_{i=1}^{N}\log P\big(w_{i}^{A}\mid w_{1}^{A},\:.\:.\:,\:w_{i-1}^{A};\:\theta\big)} rθ(Q,A)=∑i=1NlogP(wiA∣w1A,..,wi−1A;θ)∑i=1NlogP(wiA∣Q,w1A,..,wi−1A;θ)

其中 Q Q Q 表示指令, A A A 是预期响应, θ \theta θ 代表模型的学习参数。该度量通过比较在有无指令的情况下生成响应的可能性,提供了一个归一化的度量,表明指令在促进响应生成方面的有效性。未达到选定IFD阈值的指令-实例对将被排除在外,从而得到一个精炼的数据集 D ′ \mathcal{D}^{\prime} D′ 。

SFT 数据集评估

评估SFT数据集涉及选择一个高质量的子集 D e v a l \mathcal{D}_{\mathrm{eval}} Deval 作为模型性能的基准。这个子集可以从精选数据集 D \mathcal{D} D 中抽样,或从独立部分中派生以确保公正性。传统的SFT评估方法,如 FewShot GPT 和微调策略,资源密集型,而指令挖掘提供了一种更高效的替代方案。指令挖掘使用线性质量规则和一组度量来衡量数据集质量,如响应长度和平均奖励模型得分,以评估这些度量与整体数据集质量之间的相关性。

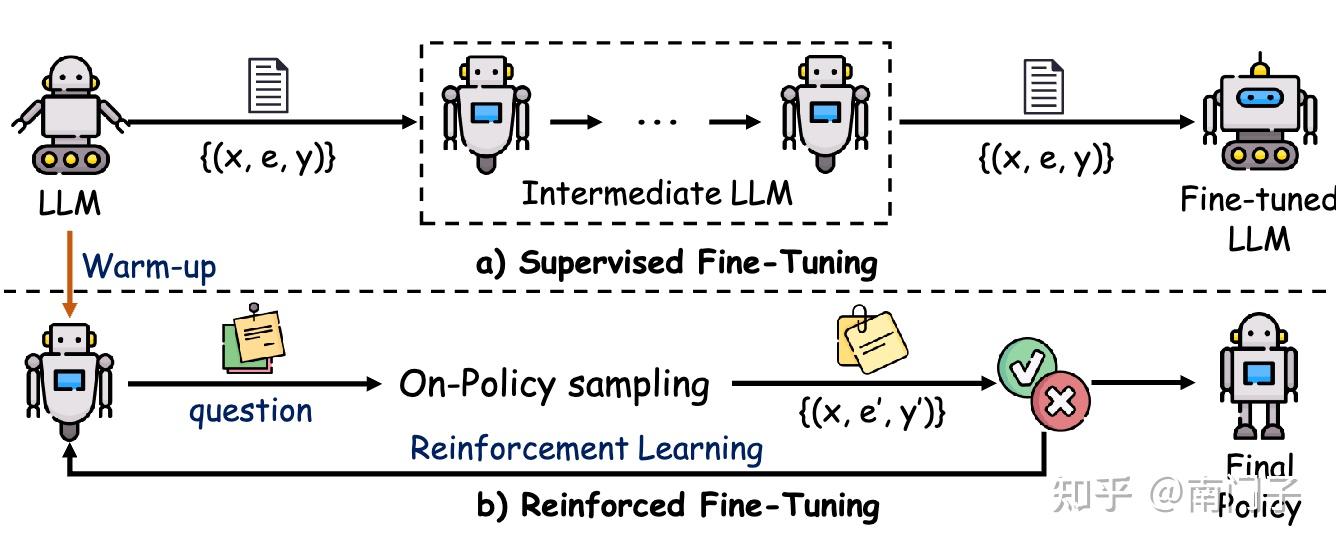

3.1.2 SFT 过程

如图4所示,一旦数据集准备就绪,微调过程便从一个预训练的语言模型开始,该模型通常通过在大规模原始数据集上进行无监督或自监督预训练获得。此预训练阶段的目标是获取适用于各种任务的一般特征表示。随后,在微调阶段,使用特定任务的标注数据调整模型参数,使模型与给定应用的需求对齐。此阶段常用的优化目标函数是交叉熵损失。对于一个具有 N N N 个样本和 C C C 个类别的分类任务,它可以表示为:

L f i n e − t i m e ( θ ) = − 1 N ∑ i = 1 N ∑ j = 1 C y i j log P ( y j ∣ x i ; θ ) L_{\mathrm{fine-time}}(\theta)=-{\frac{1}{N}}\sum_{i=1}^{N}\sum_{j=1}^{C}y_{i j}\log P{\big(}y_{j}\mid x_{i};\theta{\big)} Lfine−time(θ)=−N1i=1∑Nj=1∑CyijlogP(yj∣xi;θ)

其中 y i j y_{i j} yij 是样本 i i i 在类别 j 中的真实标签,而 P ( y j ∣ x i ; θ ) P\big(y_{j}\mid x_{i};\theta\big) P(yj∣xi;θ) 表示模型预测样本 i i i 属于类别 j j j 的概率。最小化这个损失函数促使模型更好地与真实标签对齐,从而提高在目标任务上的性能。

一个显著的例子是 BERT 模型,它在广泛的语料库(如Books Corpus和Wikipedia)上进行了广泛的预训练。在微调阶段,这些广泛表示通过使用特定任务的数据(例如,用于情感分析的IMDB数据集)进行细化,使BERT能够专门处理诸如情感分类和问答等任务。

3.1.3 全参微调

全参数微调指的是调整预训练模型所有参数的过程,与LoRA 或Prefix-tuning 等参数高效方法形成对比,后者仅修改部分参数。全参数微调通常用于需要高精度的任务,例如医疗和法律领域,但其计算开销较大。

例如,微调一个650亿参数的模型可能需要超过100 GB的GPU内存,这在资源受限的环境中构成了挑战。为了缓解这些约束,引入了LOMO 等内存优化技术,这些技术减少了梯度计算和优化器状态的内存占用。模型参数根据以下规则更新:

θ t + 1 = θ t − η ∇ θ L ( θ t ) \theta_{t+1}=\theta_{t}-\eta\nabla_{\theta}L(\theta_{t}) θt+1=θt−η∇θL(θt)

其中, θ t \theta_{t} θt 表示第 t t t 次迭代时的模型参数, η \eta η 是学习率, ∇ θ L ( θ t ) \nabla_{\theta}L(\theta_{t}) ∇θL(θt) 表示损失函数的梯度。内存优化技术包括混合精度训练和激活检查点,这些技术有助于减少内存需求,使大型模型能够在硬件资源有限的系统上进行微调。

从GPT-3到InstructGPT。全参数微调的一个显著例子是从 GPT-3 到 InstructGPT 的过渡,其中使用设计用于指令跟随任务的数据集对模型的整个参数集进行了微调。这种方法能够实现最佳性能,但由于需要更新所有参数,因此计算成本较高。

3.2 自适应微调

自适应微调(Adaptive Fine-tuning)修改了预训练模型的行为,以更好地满足用户特定需求并处理更广泛的任务。这种方法引入了额外的线索来指导模型的输出生成,提供了一个灵活的框架来定制模型的响应。自适应微调中值得注意的方法包括指令微调和基于提示的微调,这两种方法通过引入任务特定的指导,显著增强了大语言模型的适应性。

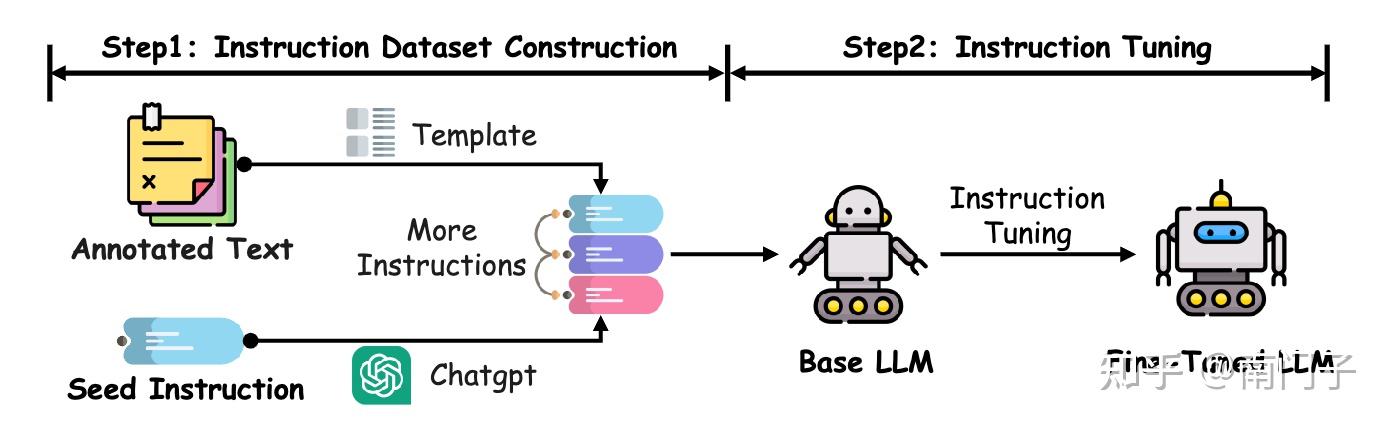

3.2.1 指令微调

指令微调是一种通过在专门构建的指令数据集上对基础大语言模型(LLM)进行微调来改进其性能的技术。这种方法显著提升了模型在各种任务和领域中的泛化能力,提高了其灵活性和准确性。如图5所示,该过程首先将现有的自然语言处理(NLP)数据集(例如,文本分类、翻译和摘要数据集)转换为包含任务描述、输入示例、预期输出和示例演示的自然语言指令。

自动生成更多指令-输出对的技术,如Self-Instruct ,进一步增强了这些数据集的多样性,扩展了模型对更广泛任务的接触。微调过程调整模型的参数以适应这些特定任务的指令,从而生成一个在熟悉和先前未见过的任务中均表现出色的大语言模型。例如,Instruct GPT 和 GPT-4 在广泛的应用中展示了指令跟随能力的显著提升。

指令微调的有效性很大程度上取决于指令数据集的质量和广度。高质量的数据集应涵盖广泛的语言、领域和任务复杂性,以确保模型具有广泛的适用性。此外,指令的清晰性和组织性在使模型能够有效解释和执行任务方面发挥着关键作用。整合示例演示,包括思维链提示(Chain-of-Thought prompting)等技术,可以显著提高需要复杂推理的任务的性能。

此外,在微调阶段确保任务分布的平衡是避免过拟合或因任务覆盖不平衡而导致模型性能下降的关键。比例任务采样或加权损失函数等技术有助于解决这些问题,确保每个任务在微调过程中做出公平的贡献。因此,通过精心构建和管理指令数据集,研究人员可以大大增强微调后大语言模型的泛化能力,使其在广泛的任务和领域中表现出色。

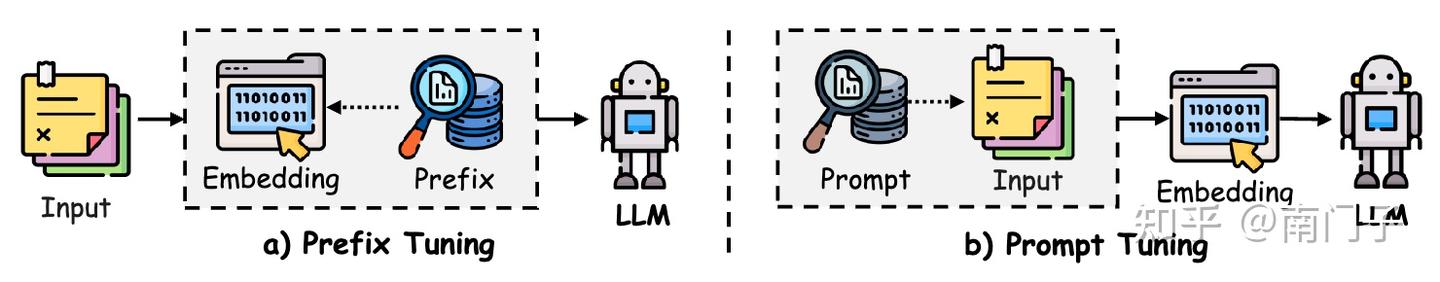

3.2.2 前缀微调

前缀调优(Prefix-tuning) 是一种参数高效的微调方法,涉及在语言模型的每个 Transformer 层中添加一系列可训练的前缀标记(连续向量),同时保持核心模型参数不变。如图 6(a) 所示,这些前缀向量是任务特定的,并充当虚拟标记嵌入。为了优化前缀向量,使用了一种重新参数化技巧,即学习一个小的多层感知器(MLP)函数,将一个较小的矩阵映射到前缀参数,而不是直接优化前缀向量。这种方法已被证明可以稳定训练过程。一旦前缀向量被优化,映射函数将被丢弃,只保留导出的前缀向量以增强任务特定性能。

通过在输入序列前附加一个已学习的连续提示并利用分层提示,模型的行为可以被引导到任务特定的输出,而无需对整个模型进行微调。由于只有前缀参数被调整,这导致了一种更参数高效的方法。

在此基础上,P-Tuning v2 在 Transformer 架构中引入了分层提示向量,专门用于自然语言理解任务。该方法还利用多任务学习来优化跨任务的共享提示,提高不同参数规模下的模型性能。前缀调优在促进大型语言模型快速高效地适应特定任务方面的潜力显而易见,使其成为需要灵活性和效率的应用中的一个有吸引力的策略。

3.2.3 提示微调

提示调优(Prompt-Tuning)是一种旨在通过优化输入层的可训练向量而非修改模型内部参数来高效适应大规模语言模型的方法。如图6(b)所示,该技术在离散提示方法的基础上引入了软提示标记,这些标记可以以无限制格式或前缀的形式进行结构化。这些学习到的提示嵌入与输入文本嵌入结合后被模型处理,从而在保持预训练权重不变的情况下引导模型的输出。两种代表性的提示调优实现是 P-tuning 和标准prompt-tuning。

Ptuning 使用灵活的方法结合上下文、提示和目标标记,使其适用于理解和生成任务。该方法通过双向 LSTM 架构增强软提示表示的学习。相比之下,标准提示调优采用了更简单的设计,其中前缀提示附加到输入中,并且仅在训练过程中根据任务特定的监督更新提示嵌入。

研究表明,提示调优在许多任务上可以达到与全参数微调相当的性能,同时需要的可训练参数显著减少。然而,其成功与底层语言模型的容量密切相关,因为提示调优仅修改输入层的一小部分参数。在此基础上,诸如 P-Tuning v2 等新方法已经证明,提示调优策略可以在各种模型大小上有效扩展,处理以前认为需要全微调的复杂任务。这些发现确立了提示调优作为传统微调的高度高效替代方案,提供相当的性能并降低计算和内存成本。

3.3 强化学习微调

强化微调(Reinforcement Fine-Tuning, ReFT)是一种先进的技术,它将强化学习(RL)与监督微调(SFT)相结合,以增强模型解决复杂动态问题的能力。与传统的 SFT 不同,后者通常为每个问题使用单个链式思维(CoT)注释,而 ReFT 使模型能够探索多个有效的推理路径,从而提高其泛化能力和问题解决技能。

ReFT 过程从标准的 SFT 阶段开始,在此阶段,模型通过监督注释在标注数据上进行初步训练,以学习基本的任务解决能力。经过这一初始微调后,模型使用强化学习算法(如近端策略优化(Proximal Policy Optimization, PPO))进行进一步的精炼。在强化阶段,模型为每个问题生成多个 CoT 注释,探索不同的潜在推理路径。这些生成的路径通过将模型预测的答案与真实答案进行比较来评估,正确输出会获得奖励,错误输出则受到惩罚。这一迭代过程促使模型调整其策略,最终改进其推理策略。

如图 7 所示,ReFT 过程分为两个阶段。上部表示 SFT 阶段,模型在训练数据上迭代,通过多个周期学习每个问题的正确 CoT 注释。下部引入了 ReFT 阶段:从 SFT 训练的模型开始,模型根据当前策略生成替代的 CoT 注释 ( e ′ e^{\prime} e′) ,并将其预测的答案 ( y ′ y^{\prime} y′) 与真实答案 ( y y y) 进行比较。正确答案会获得正向奖励,错误答案则受到负向奖励,这促使模型提高性能。这些奖励信号随后用于通过强化学习更新模型的策略,增强其生成准确和多样化的 CoT 注释的能力。

最近的研究表明,ReFT 显著优于传统的 SFT 方法。此外,集成推理时间策略(如多数投票和重新排序)可以进一步提升性能,使模型在训练后能够优化其输出。值得注意的是,ReFT 在不增加或增强训练数据的情况下实现了这些改进,仅从 SFT 阶段使用的现有数据集中学习。这突显了模型的优越泛化能力,因为它能够更高效和有效地从可用数据中学习。

4 PoLMs 对齐

在大语言模型中实现对齐涉及引导模型输出以符合人类期望和偏好,特别是在安全关键或面向用户的应用中。本章讨论了实现对齐的三种主要范式:

- 基于人类反馈的强化学习(§4.1),该方法使用人工标注的数据作为奖励信号;

- 基于人工智能反馈的强化学习(§4.2),该方法利用人工智能生成的反馈来解决可扩展性问题;

- 直接偏好优化(§4.3),该方法直接从成对的人类偏好数据中学习,而无需显式的奖励模型。

每种范式在其追求稳健对齐的过程中都提供了不同的优势、挑战和权衡。这些及相关方法的简要比较总结在表2中。

表2:大语言模型对齐方法的比较概述(2022–2024)。该表评估了八项指标下的主要对齐技术:RM1(显式或隐式奖励模型)、RM2(点奖励或偏好概率模型)、RM3(响应级或令牌级奖励)、RM4(正或负奖励模型)、F(反馈类型:人类或AI)、RL1(参考模型或无参考模型的强化学习)、RL2(在线策略或离线策略的强化学习)和O(在线/迭代或离线/非迭代优化)。

4.1 人工反馈的强化学习

监督微调(Supervised Fine-Tuning, SFT) 一直作为指导大语言模型(LLMs)遵循人类指令的基础技术。然而,在纯监督场景中,标注数据的多样性和质量可能参差不齐,且监督模型捕捉更细微或适应性更强的人类偏好的能力往往有限。为此,基于强化学习(Reinforcement Learning, RL)的微调方法被提出以解决这些不足。在RL方法中,基于人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF) 作为最早且最具影响力的RL后训练对齐方法之一脱颖而出。

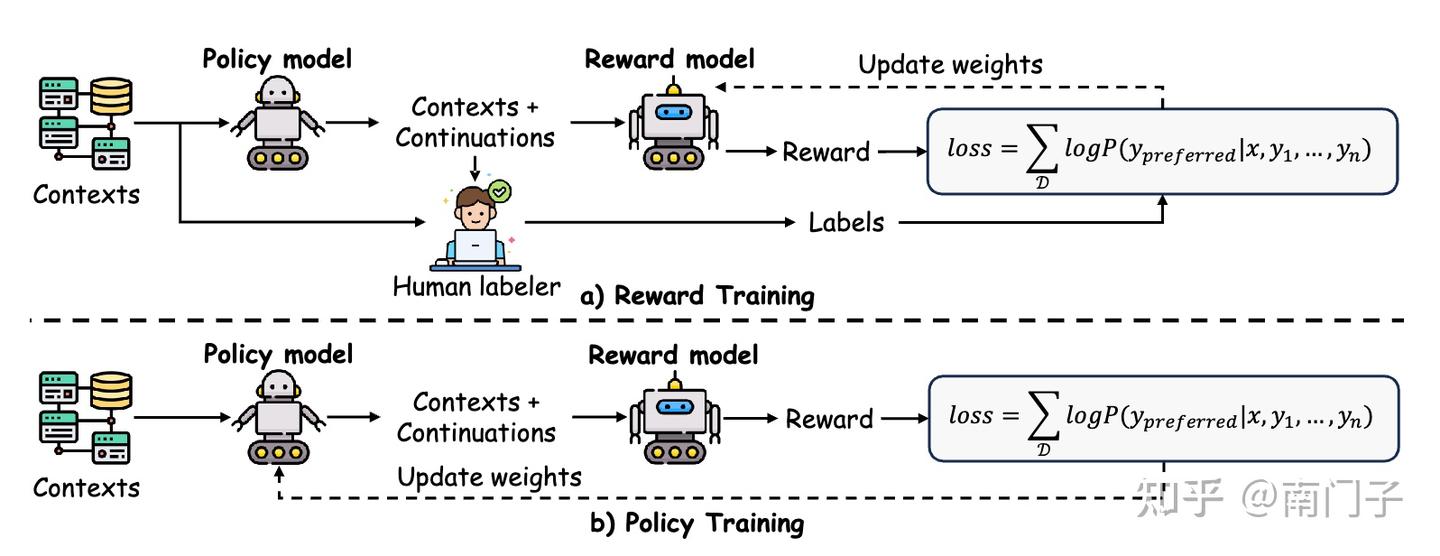

如图8所示,RLHF首先收集以偏好标签或奖励信号形式的人类反馈,然后利用这些信息训练奖励模型。在该奖励模型的引导下,策略通过迭代调整以更好地匹配人类偏好。与SFT相比,RLHF融入了连续的、偏好驱动的更新,从而实现更强的对齐效果。值得注意的是,现代大语言模型如 GPT-4、Claude 和 Gemini 均受益于这些机制,展示了在指令遵循、事实一致性及用户相关性方面的改进。以下,我们将讨论RLHF的主要组成部分,包括反馈机制、奖励建模及策略学习策略。

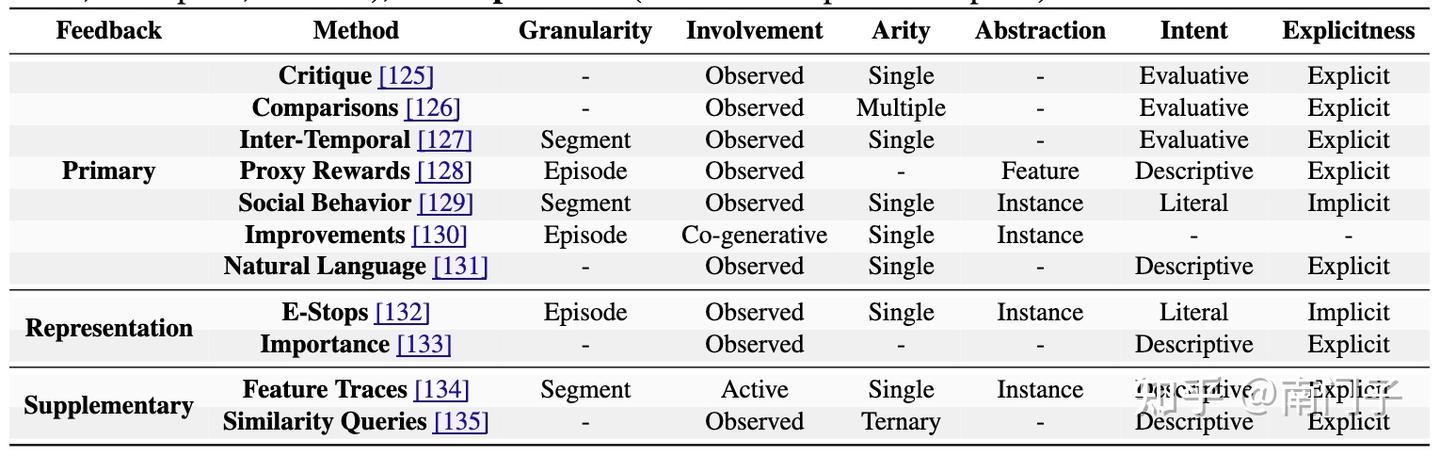

4.1.1 RLHF 的反馈机制

人类反馈是基于人类反馈的强化学习(RLHF)的核心,它向奖励模型传达用户偏好,并指导策略更新。本小节采用了文献[124]的分类法来对常见的人类反馈形式进行分类。表3展示了这些反馈类型在粒度、参与程度和明确性等维度上的分布。每种反馈模式对模型优化的不同方面都有贡献,提供了不同水平的可解释性、可扩展性和噪声容忍度。

主要反馈。这一类别包括最直接塑造RLHF中奖励模型的反馈类型。例如,批评(Critique)专注于对代理行为的显式人类评估,通常通过二元或多标签注释来减轻噪声。比较(Comparisons)允许评估器比较多个输出或轨迹;虽然更大的选择集可以提供更丰富的信号,但也可能导致因果混淆。

时间反馈(Inter-Temporal Feedback)通过在不同时间步长提供判断来细化轨迹评估,而代理奖励(Proxy Rewards)则结合近似奖励函数,引导模型朝向用户定义的目标。社会行为(Social Behavior)利用隐含线索(如面部表情)来使代理目标与用户情感对齐。改进(Improvements)强调实时人类干预以逐步完善策略。最后,自然语言反馈(Natural Language Feedback)利用文本信息传达偏好和改进建议。

补充反馈。除了主要反馈之外,还有两类进一步加强奖励建模过程。紧急停止(Emergency stops, e-stops)允许人类在代理行为中进行干预,通过停止其轨迹而不提供替代方案来防止不良行为。这种反馈的特点是隐含参与和单一的防止不良行为的焦点。相比之下,重要性标签(Importance labels)指示特定观察对于实现目标的重要性,提供不直接改变行为的显式反馈。这种反馈因上下文而异,作为补充输入,加强奖励模型的整体学习过程。

表示特定反馈。某些反馈类型主要增强表示学习,而不是直接塑造奖励函数。特征轨迹(Feature Traces)提示人类操作员展示给定特征的单调变化,从而实现特征集的动态扩展。相似性查询(Similarity Queries)比较轨迹的三元组,通过轨迹空间中的成对距离引导表示学习。通过利用这些表示特定的反馈形式,RLHF可以实现对新任务和上下文的更鲁棒泛化。

4.1.2 RLHF 的奖励模型

真正的奖励函数 r ( x , y ) r(x,y) r(x,y) 通常未知,因此需要基于人类提供的偏好构建一个可学习的奖励模型 r θ ( x , y ) \boldsymbol{r}_{\theta}(x,y) rθ(x,y) 。该模型预测候选输出 y y y 在给定输入 x x x 下与人类期望的一致程度。为了获得训练数据以训练 r θ ( x , y ) \boldsymbol{r}_{\theta}(x,y) rθ(x,y) ,人类评估者根据输出对的相对适宜性进行比较或标注,模型通常使用这些比较上的交叉熵损失进行训练。为了防止策略 π \pi π 过度偏离初始模型 ρ \rho ρ ,引入了一个由超参数 β \beta β 控制的惩罚项到奖励函数中:

r θ ( x , y ) = r ( x , y ) − β log π ( y ∣ x ) ρ ( y ∣ x ) r_{\theta}(x,y)=r(x,y)-\beta\log\frac{\pi(y\mid x)}{\rho(y\mid x)} rθ(x,y)=r(x,y)−βlogρ(y∣x)π(y∣x)

其中 π ( y ∣ x ) \pi(y\mid x) π(y∣x) 是微调后的策略 π \pi π 在给定输入 x x x 时生成输出 y y y 的概率,而 ρ ( y ∣ x ) \rho(y\mid x) ρ(y∣x) 是在初始模型 ρ \rho ρ 下相应的概率。这一项确保了在 π \pi π 适应人类反馈的同时,仍受到 ρ \rho ρ 中捕获的先验知识的约束。

评估奖励函数 r θ ( x , y ) \boldsymbol{r}_{\theta}(x,y) rθ(x,y) 至关重要,因为它直接影响学习效果和策略性能。准确评估此函数有助于识别适合将模型输出与人类偏好对齐的奖励结构。然而,在安全敏感领域,由于在线交互的风险、偏差以及对真实奖励的需求,标准的滚动方法和离策略评估可能不可行。为了解决这些挑战,通常采用两种主要方法:

距离函数。最近的研究集中在考虑潜在变换(如潜在塑形)的奖励评估距离函数上。例如,EPIC 测量在各种变换下的奖励函数等价性,而 DARD 通过细化规范化确保评估基于可行的转换。EPIC 类似的距离通过允许规范化、标准化和度量函数的变化来推广 EPIC 的方法论,而 STARC 保留了 EPIC 的理论性质,同时提供了额外的灵活性。

可视化和人工检查。其他方法依赖于解释性和精心策划的数据集来评估学习到的奖励函数的有效性。PRFI 使用预处理步骤简化奖励函数,同时保持等价性,从而增强其透明度。与此同时,CONVEXDA 和 REWARDFUSION 提出了设计用于测试奖励模型对提示语义变化响应一致性的数据集。这些技术共同促进了对奖励函数更可靠的评估,强化了大语言模型与人类偏好的对齐。

4.1.3 RLHF 的策略学习

强化学习中的人类反馈策略学习(Reinforcement Learning with Human Feedback, RLHF),如图9所示,涉及通过在线和离线环境中的真人反馈优化策略。

在线学习。在在线RLHF中,系统实时收集人类对新生成模型轨迹的偏好。DPS 等算法使用贝叶斯更新来管理对抗过程,而PPS和PEPS 将动态规划和多臂赌博机思想结合以改进策略行为。在LPbRL 中,特征嵌入捕捉奖励结构的变化,PbOP 集成最小二乘估计方法,用于转换动态和偏好信号的估计。最近,PARL 通过将反馈获取视为策略优化的组成部分,提高了数据收集效率。

离线学习。在离线RLHF中,使用先前收集的带有偏好标签的轨迹来学习或优化策略。例如,文献 [151] 研究了基于成对比较数据的悲观最大似然估计策略学习,并建立了性能界限。FREEHAND 和DCPPO 等扩展方法适用于未知偏好模型,探讨了离线数据覆盖范围与策略泛化之间的相互作用。此外,文献 [154] 解决了成对比较中Boltzmann模型的过拟合问题,而DCPPO 进一步研究了动态离散选择模型,以提高反馈效率。

在线与离线学习的融合。混合方法结合了离线预训练和在线偏好聚合,充分利用已收集的数据,同时仍能纳入实时更新。PFERL 采用两阶段方法以减少人类查询次数,而PERL 探索了乐观最小二乘策略以进行主动探索。Dueling RL 及其扩展(如PRPRL 中的REGIME)通过仔细划分数据获取与反馈收集,减少了人类标注需求,从而优化了样本效率、标注成本和策略性能之间的权衡。

4.2 AI 反馈的强化学习

强化学习与人工智能反馈(Reinforcement Learning with AI Feedback, RLAIF)扩展了RLHF范式,通过使用大语言模型(LLMs)生成反馈信号。这种方法可以补充或替代人类反馈,在人类标注稀缺、昂贵或不一致的任务中提供更具可扩展性和成本效益的偏好数据。

4.2.1 RLAIF vs RLHF

在大规模应用强化学习与人类反馈(RLHF)时,一个主要挑战在于其依赖于人工生成的偏好标签,这需要大量资源来收集、整理和标注数据。数据标注过程既耗时又昂贵,且人工评估者可能会引入不一致性,从而使得在整个模型输出中实现大规模、一致的标注变得复杂。这些限制显著影响了RLHF的可扩展性和效率。

为了解决这些挑战,[105] 提出了强化学习与人工智能反馈(RLAIF),该方法结合了人类反馈和人工智能生成的反馈,通过强化学习训练模型。通过利用大语言模型(LLM)作为反馈来源,RLAIF减少了对人工标注者的依赖,提供了一种传统RLHF的可行替代方案。这种方法实现了连续的反馈生成,显著增强了可扩展性,同时保留了人类指导下的模型优化灵活性。

如图10所示,RLHF和RLAIF之间的关键区别在于反馈来源:RLHF依赖于人工生成的偏好,而RLAIF使用人工智能生成的反馈来引导策略更新。实证研究,例如[157]的研究表明,RLAIF可以达到与RLHF相当甚至更优的性能,经由人工评分员评估。值得注意的是,RLAIF不仅超越了传统的监督微调基线,而且在偏好标签器规模与策略模型相同的情况下实现了这一点,突显了该方法的高效性。

4.2.2 RLAIF 训练流水线

RLAIF 训练流程遵循几个关键阶段,在这些阶段中,利用 AI 生成的反馈迭代地改进模型的行为。该流程促进了 LLM 输出与人类期望的对齐,并且能够扩展到各种任务,如 [108] 所详述。这些阶段如下:

- AI 反馈收集:在这一阶段,AI 系统根据预定义的标准生成反馈,这些标准可能包括特定任务的指标、响应的正确性或模型输出的适当性。与需要解释和手动标注的人类反馈不同,AI 反馈可以在广泛的模型输出中一致生成。这一特性使得 AI 反馈可以持续提供,显著扩展了反馈循环。

- 奖励模型训练:随后,使用 AI 生成的反馈来训练或优化奖励模型。该模型将输入-输出对映射到相应的奖励,使模型的输出与反馈所指示的期望结果对齐。传统的基于人类反馈的强化学习 (RLHF) 依赖于直接的人类反馈来评估输出,而 RLAIF 则利用 AI 生成的标签,尽管这可能会引入一致性问题和偏见,但在可扩展性和独立于人力资源方面具有优势。

- 策略更新:最后阶段涉及根据前一步骤中训练的奖励模型更新模型的策略。使用强化学习算法调整模型的参数,优化策略以在多种任务中最大化累积奖励。这一过程是迭代的,奖励模型指导模型的输出向更高的目标对齐度发展。

RLAIF 的主要优势在于其能够在不需持续人类干预的情况下扩展反馈循环。通过用 AI 生成的反馈替代人类反馈,RLAIF 促进了 LLM 在多个任务中的持续改进,缓解了人类标注工作带来的瓶颈。

4.3 直接偏好优化

如前所述,基于人类反馈的强化学习(RLHF) 通常包括三个阶段:监督微调(Supervised Fine-Tuning)、奖励建模和强化学习(通常通过近端策略优化(PPO)实现)。尽管其效果显著,RLHF 可能会变得复杂且不稳定,特别是在拟合奖励模型并用于微调大型语言模型的阶段。难点在于创建一个能够准确反映人类偏好的奖励模型,以及在优化这一估计奖励的同时,使语言模型保持接近原始模型的挑战。

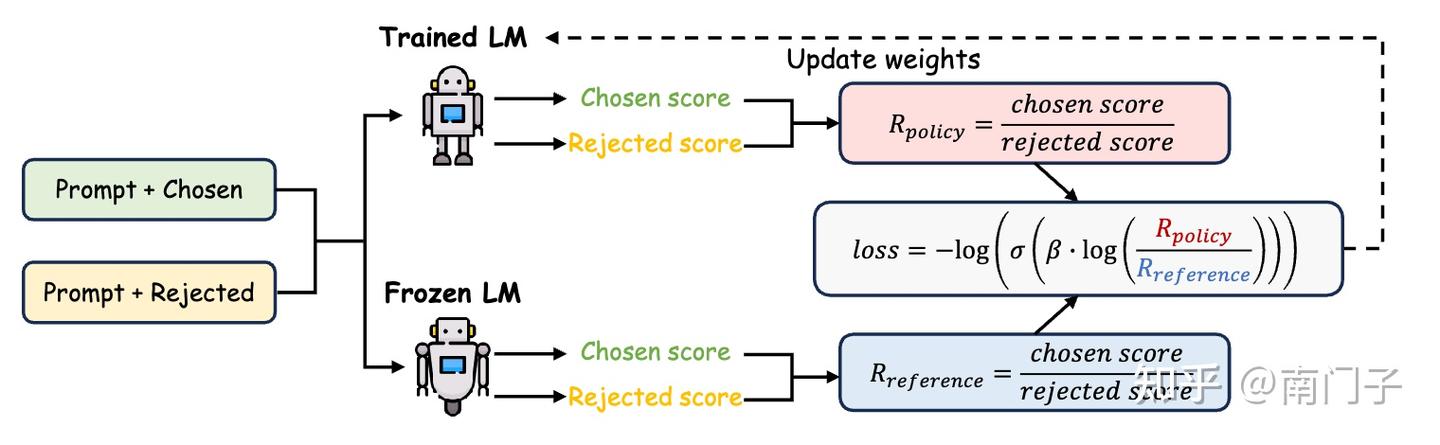

为了解决这些问题,直接偏好优化(Direct Preference Optimization, DPO) 被引入作为一种更稳定且计算效率更高的替代方案。DPO 通过直接将奖励函数与最优策略联系起来,简化了奖励优化过程。它将奖励最大化问题视为基于人类偏好数据的单阶段策略训练问题,从而避免了奖励模型拟合的复杂性和布拉德利-特里模型(Bradley-Terry model) 的依赖性。

4.3.1 DPO 基础

强化学习与人类反馈(RLHF)涉及训练一个奖励模型(RM)和通过强化学习微调一个语言模型(LM)。直接偏好优化(DPO)简化了这一过程,通过直接使用人类偏好数据训练LM,隐式地在策略中捕捉奖励模型。

KL正则化奖励最大化目标

DPO从已建立的KL正则化奖励最大化框架开始,如下目标函数所示:

π ∗ = arg max π E x ∼ D , y ∼ π ( ⋅ ∣ x ) [ r ( x , y ) − β K L ( π ( ⋅ ∣ x ) ∥ π r e f ( ⋅ ∣ x ) ) ] \pi^{*}\;=\;\arg\operatorname*{max}_{\pi}\;\mathbb{E}_{x\,\sim\,\mathcal{D},\,y\,\sim\,\pi(\cdot\,\mid\,x)}\Big[r(x,y)\;-\;\beta\,\mathrm{KL}\Big(\pi(\cdot\mid x)\,\big\|\,\pi_{\mathrm{ref}}(\cdot\mid x)\Big)\Big] π∗=argπmaxEx∼D,y∼π(⋅∣x)[r(x,y)−βKL(π(⋅∣x) πref(⋅∣x))]

其中 r ( x , y ) r(x,y) r(x,y) 表示奖励函数, β > 0 \beta\,>\,0 β>0 是一个控制接近参考策略 π r e f \pi_{\mathrm{ref}} πref 程度的系数, KL ( ⋅ ∣ ∣ ⋅ ) \operatorname{KL}(\cdot||\cdot) KL(⋅∣∣⋅) 表示Kullback-Leibler散度。这里, x ∼ D x\sim\mathcal{D} x∼D 表示从数据分布中抽取的输入, y ∼ π ( ⋅ ∣ x ) y\sim\pi(\cdot\mid x) y∼π(⋅∣x) 表示从策略中采样的输出。

导出最优策略

在适当的假设下,方程 (14) 的解以玻尔兹曼分布的形式给出:

π ∗ ( y ∣ x ) = 1 Z ( x ) π r e f ( y ∣ x ) exp ( 1 β r ( x , y ) ) \pi^{*}(y\mid x)\;=\;{\frac{1}{Z(x)}}\,\pi_{\mathrm{ref}}(y\mid x)\exp\Bigl({\frac{1}{\beta}}\,r(x,y)\Bigr) π∗(y∣x)=Z(x)1πref(y∣x)exp(β1r(x,y))

其中配分函数

Z ( x ) = ∑ y π r e f ( y ∣ x ) exp ( 1 β r ( x , y ) ) Z(x)\;=\;\sum_{y}\,\pi_{\mathrm{ref}}(y\mid x)\exp\Bigl(\frac{1}{\beta}\,r(x,y)\Bigr) Z(x)=y∑πref(y∣x)exp(β1r(x,y))

作为归一化项,确保 y ∼ π ( ⋅ ∣ x ) y\sim\pi(\cdot\mid x) y∼π(⋅∣x) 仍然是一个有效的概率分布(即其概率之和为1)。

重参数化奖励

取方程 (15) 两边的自然对数,可以将奖励 r ( x , y ) r(x,y) r(x,y) 与最优策略 π ∗ \pi^{*} π∗ 联系起来。得到:

r ∗ ( x , y ) = β [ log π ∗ ( y ∣ x ) − log π r e f ( y ∣ x ) ] + β log Z ( x ) r^{*}(x,y)\;=\;\beta\Bigl[\log\pi^{*}(y\mid x)\;-\;\log\pi_{\mathrm{ref}}(y\mid x)\Bigr]\;+\;\beta\,\log Z(x) r∗(x,y)=β[logπ∗(y∣x)−logπref(y∣x)]+βlogZ(x)

其中 β log Z ( x ) \beta\log Z(x) βlogZ(x) 是一个不影响奖励成对比较的常数。如果已知最优策略 π \pi^{} π ,则可以确定真实奖励 r ( x , y ) r^{}(x,y) r(x,y) ,最大为这个常数。

布拉德利-特里偏好

根据布拉德利-特里模型,两个输出 y 1 y_{1} y1 和 y 2 y_{2} y2 之间的人类偏好由它们的奖励值差异决定。偏好 y 1 y_{1} y1 而非 y 2 y_{2} y2 的概率为

p ∗ ( y 1 ≻ y 2 ∣ x ) = exp ( r ∗ ( x , y 1 ) ) exp ( r ∗ ( x , y 1 ) ) + exp ( r ∗ ( x , y 2 ) ) p^{*}\big(y_{1}\succ y_{2}\mid x\big)\;=\;\frac{\exp\bigl(r^{*}(x,y_{1})\bigr)}{\exp\bigl(r^{*}(x,y_{1})\bigr)\;+\;\exp\bigl(r^{*}(x,y_{2})\bigr)} p∗(y1≻y2∣x)=exp(r∗(x,y1))+exp(r∗(x,y2))exp(r∗(x,y1))

将方程 (17) 代入方程 (18),我们得到最终的偏好模型:

p ∗ ( y 1 ≻ y 2 ∣ x ) = 1 1 + exp ( β [ log π ∗ ( y 2 ∣ x ) π r e f ( y 2 ∣ x ) − log π ∗ ( y 1 ∣ x ) π r e f ( y 1 ∣ x ) ] ) . p^{*}\big(y_{1}\succ y_{2}\ |\ x\big)\ =\ \frac{1}{1\ +\ \exp\Bigl(\beta\left[\log\frac{\pi^{*}(y_{2}|x)}{\pi_{\mathrm{ref}}(y_{2}|x)}\ -\ \log\frac{\pi^{*}(y_{1}|x)}{\pi_{\mathrm{ref}}(y_{1}|x)}\right]\Bigr)}. p∗(y1≻y2 ∣ x) = 1 + exp(β[logπref(y2∣x)π∗(y2∣x) − logπref(y1∣x)π∗(y1∣x)])1.

该表达式将成对的人类偏好概率与最优策略 π ∗ \pi^{*} π∗ 和参考策略 π r e f \pi_{\mathrm{ref}} πref 的比值联系起来。

DPO的目标

DPO通过直接从偏好数据中学习策略,避免了显式的奖励建模。给定一组偏好三元组 ( x , y w , y l ) {(x,y_{w},y_{l})} (x,yw,yl) ,其中 y w y_{w} yw 是首选输出, y l y_{l} yl 是次选输出,对于提示 x x x,DPO最大化观察到的偏好的似然。形式上,DPO采用以下目标函数:

L D P A ( π θ ; π r e f ) = − E ( x , y w , y l ) ∼ D [ log σ ( β [ log π θ ( y w ∣ x ) π r e f ( y w ∣ x ) ] − β [ log π θ ( y l ∣ x ) π r e f ( y l ∣ x ) ] ) ] , \begin{array}{r}{\mathcal{L}_{\mathrm{DPA}}\big(\pi_{\theta};\pi_{\mathrm{ref}}\big)\ =\ -\,\mathbb{E}_{(x,y_{w},y_{l})\sim\mathcal{D}}\Bigg[\log\sigma\Big(\beta\left[\log\frac{\pi_{\theta}(y_{w}|x)}{\pi_{\mathrm{ref}}(y_{w}|x)}\right]\ -\ \beta\left[\log\frac{\pi_{\theta}(y_{l}|x)}{\pi_{\mathrm{ref}}(y_{l}|x)}\right]\Big)\Bigg],}\end{array} LDPA(πθ;πref) = −E(x,yw,yl)∼D[logσ(β[logπref(yw∣x)πθ(yw∣x)] − β[logπref(yl∣x)πθ(yl∣x)])],

其中 σ ( ⋅ ) \sigma(\cdot) σ(⋅) 是sigmoid函数, β log π θ ( y ∣ x ) π r e f ( y ∣ x ) \beta\log{\frac{\pi_{\theta}\left(y|x\right)}{\pi_{\mathrm{ref}}\left(y|x\right)}} βlogπref(y∣x)πθ(y∣x) 表示 π θ \pi_{\theta} πθ 和参考策略 π r e f \pi_{\mathrm{ref}} πref 之间的重参数化奖励差异。通过最大化 L D P A \mathcal{L}_{\mathrm{DPA}} LDPA ,策略 $\pi_{\theta} $在不需单独奖励模型的情况下与人类偏好对齐。由于DPO目标继承了来自RLHF的KL正则化公式,它保留了重要的理论保证——例如,在明确定义的偏好假设下的一致性——同时将训练过程统一为一个阶段。因此,DPO为使语言模型与人类评估对齐提供了更直接的路径,减少了系统复杂性并提高了训练稳定性。

4.3.2 DPO 的训练细节

DPO框架建立在两个核心模型之上:参考策略 π r e f \pi_{\mathrm{ref}} πref 和目标策略 π t a r \pi_{\mathrm{tar}} πtar 。参考策略通常是一个预先训练并经过监督微调的语言模型,在整个训练过程中保持不变。相比之下,目标策略从 π r e f \pi_{\mathrm{ref}} πref 初始化,并通过基于偏好的反馈进行迭代更新,从而提高与人类判断的一致性。图11展示了这一整体流程。

数据收集和准备:DPO依赖于一个精心策划的偏好数据集,该数据集通过从 π r e f \pi_{\mathrm{ref}} πref 中为每个提示 x x x 抽取多个候选响应而获得。人类标注者随后根据连贯性、相关性和清晰度等标准对这些响应进行比较或排名。由此产生的偏好标签作为优化 π t a r \pi_{\mathrm{tar}} πtar 的核心训练信号。

训练过程:目标策略通过一系列旨在最小化损失 L D P C O L_{\mathrm{DPCO}} LDPCO 的梯度更新进行精炼。具体步骤如下:

- 1)生成: π r e f \pi_{\mathrm{ref}} πref 为每个提示 x 生成候选输出。

- 2)标注:人类标注者比较生成的输出,确定它们的相对偏好。

- 3)优化:利用这些成对偏好, π t a r \pi_{\mathrm{tar}} πtar 进行迭代更新,以更好地模仿人类偏好的输出。

在整个过程中, π r e f \pi_{\mathrm{ref}} πref 保持不变,提供一个稳定的基线,以便衡量改进。

实践考虑:选择一个稳健的参考策略通常是有效初始化DPO的关键。监督微调(SFT)通常会产生一个表现良好的 π r e f \pi_{\mathrm{ref}} πref 基线,确保后续基于偏好的更新可以集中在精炼而非基本技能的获取上。此外,偏好数据必须足够多样,以捕捉用户期望的变化,从而促进模型的适应性并防止过度拟合到狭义定义的任务中。

4.3.3 DPO 的变种

多种DPO变体已经出现,以应对特定的对齐挑战并优化文本生成的不同方面。表2概述了这些方法,范围从词元级生成优化到控制冗长性和处理列表或负面偏好。

优化生成的DPO:词元级和迭代DPO策略有助于更精细地或连续地与人类偏好对齐。将问题重新表述为一个强盗问题,词元级DPO 采用了由 (S,A,f,r,\rho_{0}) 定义的马尔可夫决策过程(Markov Decision Process, MDP)。这种方法缓解了诸如对不受欢迎的词元产生过高的KL散度等问题。

TDPO 应用了顺序前向KL散度而不是逆向KL散度,从而在文本生成中同时提高了对齐性和多样性保持。迭代DPO 采用多轮方法,通过重复的偏好评估不断优化输出,通常由模型本身执行。成对厌恶优化(Pairwise Cringe Optimization, PCO) 将二元反馈扩展到成对设置,使用软边界来平衡探索和利用。逐步DPO (Step-wise DPO) 将偏好数据集划分为多个部分,并应用迭代更新,每一轮更新后的策略作为下一轮的基线。

可控且灵活的DPO:一些DPO变体旨在管理冗长性并减少对固定参考策略的需求。R-DPO 通过在目标函数中引入正则化项来惩罚输出长度,解决了过于冗长或冗余的响应问题。SimPO 通过规范化响应长度并简化损失函数来处理期望和不期望的输出,消除了对参考策略的需求。RLOO 利用REINFORCE算法而无需训练价值模型,大幅减少了计算开销。它将整个响应视为单个动作,并从稀疏奖励中学习,相比传统的基于PPO的方法简化了实现。

列表DPO:与将偏好数据限制为成对比较不同,列表DPO方法在一组输出上进行优化。列表偏好优化(Listwise Preference Optimization, LiPO) 直接在候选响应的排名列表上应用排序学习技术,相对于重复的成对比较提高了效率。RRHF 将偏好对齐整合到SFT中,消除了对单独参考模型的需求。PRO 将列表偏好分解为更简单的二元任务,简化了SFT期间的对齐。

负面DPO:某些任务需要从不期望或有害的输出中学习:否定负例(Negating Negatives, NN) 丢弃积极响应并最大化与较少偏好的输出之间的差异。负面偏好优化(Negative Preference Optimization, NPO) 对负面偏好应用梯度上升,有效减少了有害输出并缓解了灾难性崩溃。

五、PoLMs 推理

推理是使大语言模型(LLM)能够处理涉及多步骤逻辑、复杂推理和复杂决策任务的核心支柱。本章探讨了两种增强模型推理能力的核心技术:

- 自精炼推理(Self-Refine for Reasoning)(§5.1),该方法指导模型自主检测并修正其推理步骤中的错误;

- 强化学习推理(Reinforcement Learning for Reasoning)(§5.2),该方法通过基于奖励的优化来提高模型思维链的一致性和深度。

这些方法共同使得模型在长期决策、逻辑证明、数学推理等具有挑战性的任务中能够更加稳健地处理。

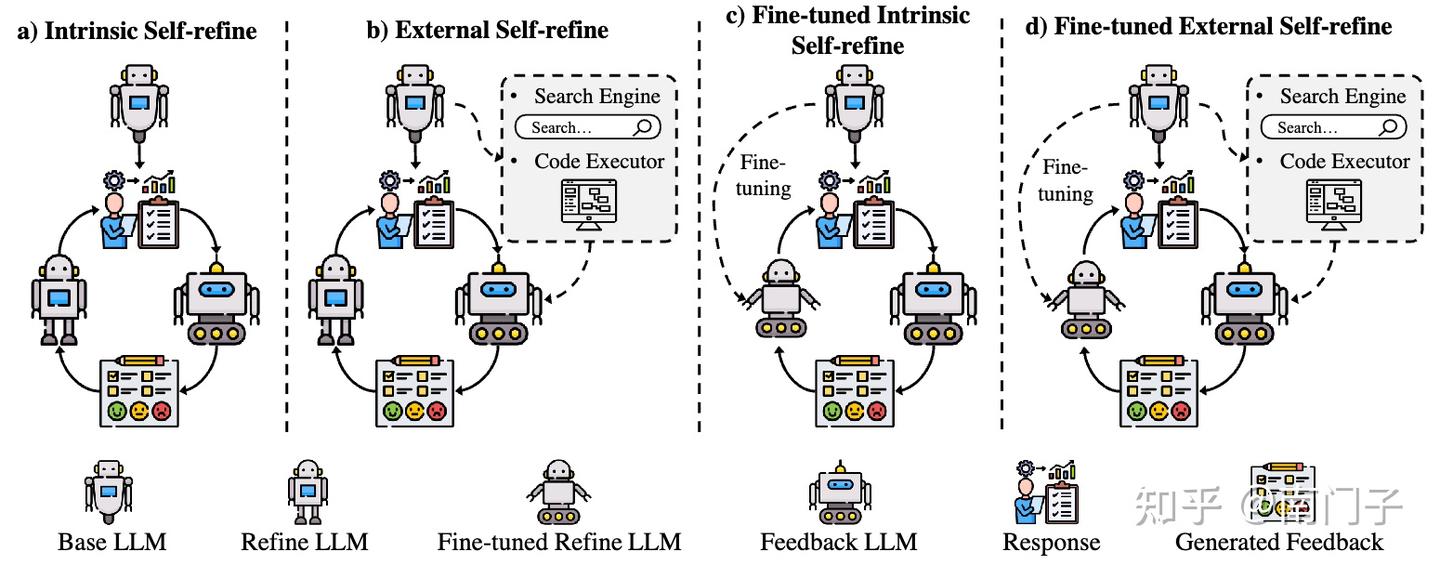

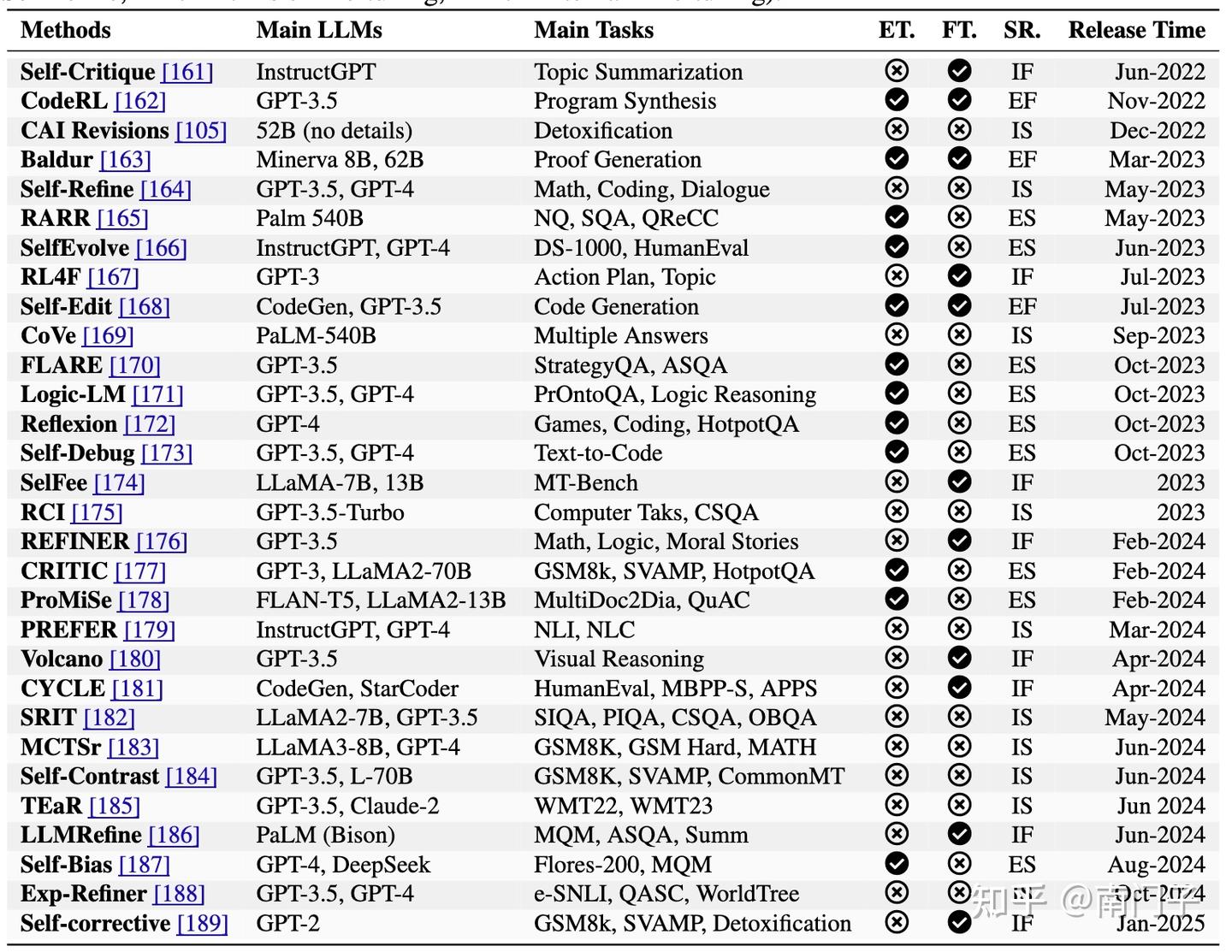

5.1 自精炼推理

推理仍然是优化大语言模型(LLMs)以应对需要复杂逻辑推理和情境依赖决策任务的核心挑战。在这一背景下,自精炼(self-refine)作为一种强大的机制,能够在文本生成过程中或之后迭代地识别和纠正错误,显著提高推理深度和整体可靠性。如图12所示,自精炼方法可以分为四类:

- 内在自精炼(Intrinsic Self-refine),依赖于模型内部的推理循环;

- 外在自精炼(External Self-refine),结合外部反馈资源;

- 微调内在自精炼(Fine-tuned Intrinsic Self-refine),基于自动生成的校正迭代更新模型的推理过程;

- 微调外在自精炼(Fine-tuned External Self-refine),利用外部信号和微调以更适应性、长期的方式改进推理。

表4进一步展示了每种类别如何在各种任务中增强LLM的推理能力。

内在自精炼

内在自精炼方法侧重于使模型本身能够检测并内部修复错误,而无需借助外部工具。例如,RCI Prompting [190] 只在检测到矛盾或错误时触发校正,避免对轻微不确定性做出过度反应。CAI Revisions [105] 纠正不希望的输出(例如,冒犯性文本),同时教导模型自我调节其响应。

同样,Self-Refine [164] 通过从低质量提示过渡到高保真指令来改进中间逻辑,提高一致性。CoVe [169] 通过将多答案问题分解为子任务,并分别验证每个子任务,确保整个推理链的精确性和一致性。弱到强泛化(Weak-to-Strong Generalization, W2SG)方法利用高级算法,使强大的学生模型能够从较弱的教师模型产生的嘈杂演示中有效学习 [191]。

该框架已在不同领域看到了几个关键的发展和应用。最近的研究通过各种创新增强了W2SG。例如,集成学习技术已成功应用于提高W2SG方法的鲁棒性和有效性 [192]。[193] 采用弱到强外推法来增强LLM的对齐。

外在自精炼

这些方法涉及外部反馈源或计算工具来指导和纠正模型的推理。CRITIC [177] 系统地检查逐步输出,提高复杂推理任务的可靠性。Reflexion [172] 和 Self-Debug [173] 分别将生成的答案与参考解决方案或少量示例进行比较,迭代地改进逻辑。

像 FLARE [170] 和 Logic-LM [171] 这样的技术通过引用外部文档或符号求解器,从而减少逻辑错误。RARR [165] 和 SelfEvolve [166] 显示,验证中间状态(例如,编译器消息或相关知识来源)是早期修剪错误路径并引导模型向正确解决方案发展的强大方法。

文献 [194] 提出了一种基于人类反馈的迭代偏好学习方法,包括在线设置下的直接偏好优化(DPO)算法的迭代版本,以及离线场景下的多步拒绝采样策略。PIT [195] 从人类偏好数据中隐式学习改进目标。

微调内在自精炼

通过专门针对内部修订对基础模型进行微调,这些方法系统地加强了LLM的自我校正循环。Self-Critique [161] 旨在通过自我审查改进总结,而 SelFee [174] 使用迭代反馈循环以确保更高的逻辑一致性。

Volcano [180] 通过在LLM架构中微调一个专用校正模块来减少多模态幻觉,RL4F [167] 利用基于强化学习的批评循环,在需要深入推理的基准测试中平均提高了 10 % 10\% 10% 的性能。REFINER [176] 同样专注于中间推理路径,而不改变模型的原始生成过程,表明通过训练模型仔细重新检查其部分输出,可以实现一致的改进。

此外,从易到难泛化的概念作为W2SG的一个有前途的变体,已经出现,其中模型最初在易于验证的示例上进行训练,然后处理更复杂的任务 [196]。一种值得注意的实现方法是在人类可验证的示例上训练一个强大的奖励模型,然后引导更强大的模型处理具有挑战性的任务 [197]。此外,W2SG的有效性超越了LLM,在计算机视觉任务中也有成功的应用[198]。

微调外在自精炼

在需要长期改进的情况下,模型参数通过外部反馈机制进行更新。例如,Self-Edit [168] 基于执行结果重新生成代码输出,从而逐步提高正确性。Baldur [163] 通过添加或修改上下文来加强定理证明,而 CodeRL [162] 利用基于测试的批评来验证程序合成任务的功能准确性。这些技术共同表明,将外部资源与有针对性的微调相结合,可以促进模型整体推理性能的可靠、逐步提升。

5.2 用于推理的强化学习

在第5.1小节中,我们探讨了自精炼方法,这是一种广泛使用的方法,通过局部调优和优化来改进大语言模型的推理能力。这种技术通常应用于单步任务或输出精炼,例如文本生成和问答,能够提供快速的推理增益。然而,它在处理需要多步逻辑的复杂长期推理任务时显得力不从心。

OpenAI发布的o1系列[41]突显了强化学习(Reinforcement Learning, RL)作为一种强大的替代方案,通过基于奖励的反馈来训练大语言模型进行高级推理,优化内部的长链因果关系(Chain of Thought, CoT)。这在数学证明和战略规划等复杂任务中显著提升了性能。o1的成功激发了对大规模强化学习的研究,诸如QwQ-32B-Preview [199]在数学和编程方面表现出色,而DeepSeekR1 [28]则与o1的能力相当。

本小节将考察强化学习在增强推理能力中的作用,重点关注领先的开源模型DeepSeek-R1和DeepSeek-R1-Zero。

5.2.1 将推理表述为MDP

在大语言模型(LLMs)中的推理可以被优雅地建模为一个顺序决策过程,在该过程中,模型针对输入查询 x x x 迭代地构建一系列中间步骤 a 1 , a 2 , ⋯ , a T a_{1},a_{2},\cdots,a_{T} a1,a2,⋯,aT ,以优化到达正确最终答案的可能性。这种概念化将推理转化为一个适合强化学习(RL)的结构化框架,特别是通过马尔可夫决策过程(MDP)的视角,记为$ \mathcal{M}=(\mathcal{S},\mathcal{A},P,R,\gamma)$ 。

MDP封装了状态、动作、转换、奖励和时间折现之间的动态相互作用,为训练LLMs处理复杂推理任务提供了坚实的数学基础。通过将推理视为一系列有意的选择,这种方法使模型能够系统地探索并精炼其逻辑路径,类似于游戏或机器人领域中的决策制定,但适应了语言和概念推理的独特挑战。最终目标是推导出一个最优策略 π ∗ ( a t ∣ s t ) \pi^{*}(a_{t}|s_{t}) π∗(at∣st) ,以最大化预期累积奖励,表示为

J ( θ ) = E π θ [ ∑ t = 1 T γ t R ˉ ( s t , a t ˉ ) ] \begin{array}{r}{J(\theta)=\mathbb{E}_{\pi_{\theta}}\left[\sum_{t=1}^{T}\gamma^{t}\bar{R}(s_{t},\bar{a_{t}})\right]}\end{array} J(θ)=Eπθ[∑t=1TγtRˉ(st,atˉ)]

利用RL技术如近端策略优化(Proximal Policy Optimization, PPO)或优势行动者-评论家(Advantage Actor-Critic, A2C)来根据环境反馈迭代地增强推理能力。

- 状态空间

状态空间 s s s 构成了这个MDP的骨干,每个状态 s t ∈ S s_{t}\in\mathcal{S} st∈S 代表了在时间步 t t t处的当前推理轨迹,这是一个由语言和结构元素组成的丰富复合体,对推理过程至关重要。

具体而言, s t s_{t} st 包括初始查询 x x x 、先前的推理步骤序列 a 1 , … , a t − 1 {a_{1},\dotsc,a_{t-1}} a1,…,at−1 以及编码逻辑依赖和中间结论的内部记忆表示,例如部分解决方案或推断的关系。随着推理的展开,这种状态会动态演变,通过整合生成步骤中明确表述的路径和从上下文中提炼的潜在知识,反映了思维的进展。

例如,在数学证明中, s t s_{t} st 可能包括问题陈述、先前推导的方程和适用定理的记忆,使模型能够在步骤之间保持连贯性。这种多方面的状态表示确保了LLM能够自适应地跟踪其推理上下文,这是处理需要持续逻辑连续性的任务(如多步骤问题解决或文本生成中的叙事连贯性)的前提。

-** 动作空间**

动作空间 A \mathcal{A} A 定义了每个步骤中可能的决策范围,其中动作 a t ∈ A a_{t}\in\mathcal{A} at∈A 对应于选择下一个推理步骤,为推进推理过程提供了灵活的工具包。这些动作可能包括生成自然语言中的一个词或短语来表达推理段落、应用预定义的逻辑或数学变换(如代数简化)、从知识库中选择相关定理或规则以扩展推理链,或在达到结论性答案时停止过程。

动作空间的性质因任务而异:在形式证明中选择有限逻辑规则集时可能是离散的,而在开放性推理场景中产生自由形式文本时则是连续的,反映了LLM的生成灵活性。这种双重性使模型能够在结构化领域(如符号逻辑)和非结构化领域(如常识推理)之间导航,同时适应任务需求,保持向解决方案的连贯轨迹。

- 转移函数

转移动力学由函数 P ( s t + 1 ∣ s t , a t ) P(s_{t+1}|s_{t},a_{t}) P(st+1∣st,at) 封装,决定了每次动作后状态如何演变,界定了推理轨迹在MDP框架内的进展。与传统RL环境中由于外部变量(如环境噪声)引起的随机性不同,LLMs中的推理转移主要是确定性的,由模型的自回归输出或结构化推理规则驱动,例如在证明中应用演绎步骤。

然而,不确定性源于模型固有的局限性——如不完美的知识、模糊的中间状态或文本生成中的概率采样——引入了RL必须应对的变化。对于自回归LLMs,转移遵循可预测的序列生成过程,但错误累积或解释分歧的可能性需要稳健的设计以确保可靠性。这种确定性但不确定的动力学强调了需要适应性策略,以在从精确数学推导到细致入微的叙事构造的各种情境中稳定推理。

- 奖励函数

奖励函数 R ( s t , a t ) R(s_{t},a_{t}) R(st,at) 作为MDP的评估核心,提供了对每个推理步骤质量的关键反馈,以指导模型的学习过程。与具有显式奖励(如游戏中得分)的传统RL任务不同,推理奖励必须精心设计以平衡稀疏性和密集性,反映任务的复杂性和目标。

稀疏奖励,如仅在达到正确最终答案时分配值,提供简单性但可能在多步骤情景中延迟学习;而密集奖励,如评估逐步正确性、逻辑有效性或与人类偏好的一致性,则提供详细的指导,如§5.2.2所述。这种灵活性使奖励函数能够适应多样化的推理需求——无论是奖励证明中有效推理规则的应用还是叙事段落的一致性——确保模型接收到有意义的信号,以在其即时和扩展推理范围内精炼其策略。

- 折扣因子

γ \gamma γ :一个标量 γ ∈ [ 0 , 1 ] \gamma\in[0,1] γ∈[0,1] ,决定了即时奖励和未来奖励之间的权衡。较高的γ鼓励多步骤推理优化,促进深度推理链而非短期启发式。基于这种MDP公式,目标是学习一个最优推理策略 π ∗ ( a t ∣ s t ) \pi^{*}(a_{t}|s_{t}) π∗(at∣st) ,以最大化预期累积奖励:

J ( θ ) = E π θ [ ∑ t = 1 T γ t R ( s t , a t ) ] J(\theta)=\mathbb{E}_{\pi_{\theta}}\left[\sum_{{t=1}}^{T}\gamma^{t}R(s_{t},a_{t})\right] J(θ)=Eπθ[t=1∑TγtR(st,at)]

这一框架使得可以应用强化学习技术,如近端策略优化(PPO)或优势行动者-评论家(A2C),通过根据推理环境的反馈迭代调整策略 π θ \pi_{\theta} πθ 来精炼LLM的推理能力。

5.2.2 推理奖励设计

与具有明确奖励(如游戏得分)的传统强化学习任务不同,大型语言模型(LLM)中的推理需要结构化的奖励设计,以反映正确性、效率和信息量。常见的方法包括:

- 二元正确性奖励,对于正确的最终答案分配 r T = 1 r_{T}=1 rT=1 ,否则分配 r T = 0 r_{T}=0 rT=0,这种方法简单但因稀疏反馈而引入高方差;

- 分步准确度奖励,基于推理规则的有效性或中间步骤的一致性等指标提供增量反馈,以引导多步推理;

- 自一致性奖励,测量多个推理路径的稳定性,并对一致性强的情况分配更高的奖励,以增强鲁棒性;

- 基于偏好的奖励,从基于人类反馈的强化学习(RLHF)或基于人工智能反馈的强化学习(RLAIF)中得出,其中模型 r ϕ ( s t , a t ) r_{\phi}(s_{t},a_{t}) rϕ(st,at) 经过人类或人工智能反馈训练,评估推理质量,为复杂任务提供细致的指导。

5.2.3 基础模型上的大规模 RL

大规模强化学习作为提升大型语言模型(LLM)推理能力的一种变革性后训练范式,已经崭露头角。这一方法将重点从传统的监督微调(SFT)转向动态、自我演化的优化策略。通过利用广泛的计算框架和基于奖励的迭代反馈,该方法能够直接精炼基础模型,无需预先标注的数据集,从而实现复杂推理技能的自主发展。

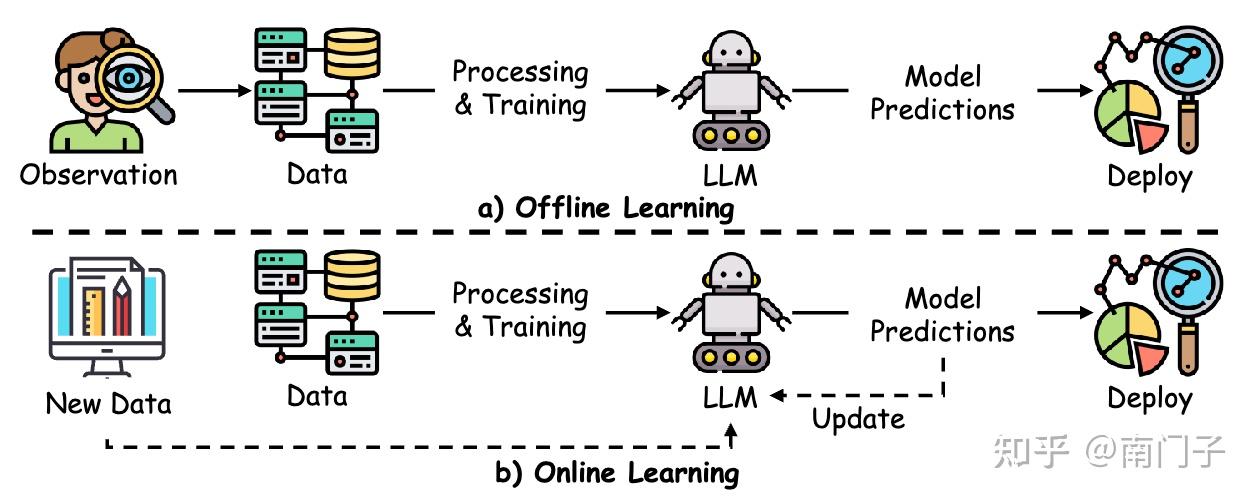

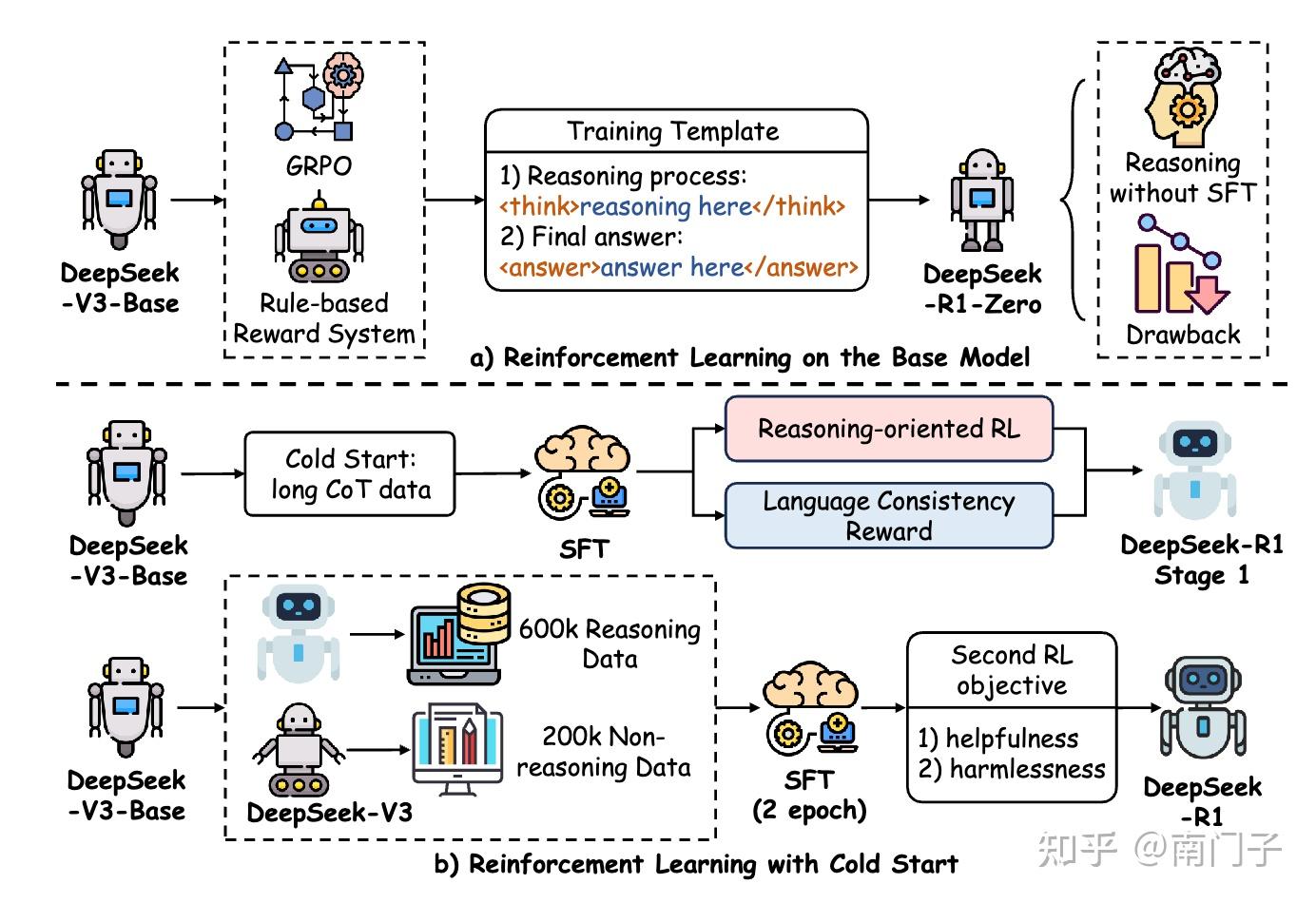

通过整合大规模强化学习,LLMs可以解决复杂的多步推理任务(例如数学问题求解、逻辑演绎和战略规划),而传统SFT由于依赖静态、人工策划的数据往往难以胜任这些任务[45]。DeepSeek-R1 模型是这一范式的典型代表,它采用了先进的强化学习技术,在优化资源效率的同时实现了顶级的推理性能,如图13所示。

本小节概述了支撑 DeepSeek-R1 成功的关键方法,包括新颖的优化算法、自适应探索和轨迹管理,这些共同重新定义了强化学习驱动的LLM推理潜力。

- 组相对策略优化

DeepSeek-R1-Zero 模型利用了一种复杂的近端策略优化(PPO)变体,称为组相对策略优化(GRPO),以减轻传统强化学习训练中对大规模计算和资源的需求。与依赖于广泛批评网络的标准PPO不同,GRPO采用基于组的基线估计来简化优化过程,显著减少训练开销,同时保持策略更新的稳健性。

这种效率使得在资源受限系统上部署大规模强化学习成为可能,促进跨长时间段的推理策略迭代优化。通过在可控计算范围内优化策略,GRPO使 DeepSeek-R1-Zero 成为增强推理能力的可扩展解决方案,如图13所示,使其成为当代强化学习驱动推理研究的基石。

- DeepSeek-R1-Zero

DeepSeek-R1-Zero 展现了大规模强化学习在不依赖传统SFT作为初始步骤的情况下提升LLM推理能力的巨大潜力,而是采用纯强化学习驱动的自我演化范式。这种方法使模型能够通过奖励反馈迭代地优化其内部链式思维(CoT),从而自主发展复杂的推理技能,避免了SFT通常需要的预标注数据集。

结果是在复杂的多步推理任务(例如数学问题求解和逻辑推导)中表现出显著的性能提升,展示了强化学习从基础模型中解锁高级推理能力的能力。作为最强大的开源推理模型之一,DeepSeek-R1-Zero 的成功证明了冷启动强化学习策略的可行性,提供了一种资源高效的替代传统训练管道的方法,同时达到了与顶级基准相当的水平。

- 分步奖励建模

为了引导轨迹 τ = ( s 1 , a 1 , … , s T , a T ) \tau = (s_1, a_1, \ldots, s_T, a_T) τ=(s1,a1,…,sT,aT) 上的推理,DeepSeek-R1 采用了一个分步奖励模型 f θ f_\theta fθ ,在每个时间步提供详细的反馈,定义为 r t = f θ ( s t , a ˉ t ∣ D reasoning ) r_t = f_\theta(s_t, \bar{a}t \mid \mathcal{D}{\text{reasoning}}) rt=fθ(st,aˉt∣Dreasoning) ,其中 D reasoning \mathcal{D}_{\text{reasoning}} Dreasoning 包含带有步骤级正确性标签的人工标注CoT序列。

这种密集的奖励结构与稀疏的序列末尾奖励形成对比,通过提供即时、可操作的关于单个推理步骤质量的见解,使模型能够精确地调整其策略。通过利用专家策划的数据,奖励模型确保反馈与人类推理标准一致,促进在扩展推理链中的连贯性和准确性,这是处理需要长时间逻辑合成的任务的关键特征。

- 自适应探索

DeepSeek-R1 通过集成自适应探索机制来增强策略优化,其目标函数如下:

L PPO+ = E τ [ min ( π ϕ ( a ∣ s ) π old ( a ∣ s ) A t , clip ( π ϕ ( a ∣ s ) π old ( a ∣ s ) , 1 − ϵ , 1 + ϵ ) A t ) ] + λ t H ( π ϕ ( ⋅ ∣ s ) ) , \begin{array}{r l} &{\mathcal{L}_{\text{PPO+}} = \mathbb{E}_\tau \left[\operatorname*{min}\left(\frac{\pi_\phi(a \mid s)}{\pi_{\text{old}}(a \mid s)} A_t, \operatorname{clip}\left(\frac{\pi_\phi(a \mid s)}{\pi_{\text{old}}(a \mid s)}, 1 - \epsilon, 1 + \epsilon\right) A_t\right)\right]}\\ &{\qquad\qquad + \left.\lambda_t \mathcal{H}(\pi_\phi(\cdot \mid s)),\right.} \end{array} LPPO+=Eτ[min(πold(a∣s)πϕ(a∣s)At,clip(πold(a∣s)πϕ(a∣s),1−ϵ,1+ϵ)At)]+λtH(πϕ(⋅∣s)),

其中熵项 H \mathcal{H} H 由一个自适应系数 λ t = α ⋅ exp ( − β ⋅ V a r ( R ( τ 1 : t ) ) ) \lambda_t = \alpha \cdot \exp(-\beta \cdot \mathrm{Var}(R(\tau_{1:t}))) λt=α⋅exp(−β⋅Var(R(τ1:t))) 调制,根据轨迹上的奖励方差动态调整。这种方法平衡了探索和利用,鼓励模型在训练早期探索多样化的推理路径,随着方差减小逐渐收敛到最优策略,从而在推理优化中提高鲁棒性和效率。

- 轨迹剪枝

为了在推理过程中优化计算效率,DeepSeek-R1 实现了一个双注意力批评器 V ψ ( s t ) − = L o c a l A t t n ( s t ) + G l o b a l A t t n ( s 1 : t ) V_\psi(s_t)^- = \mathrm{LocalAttn}(s_t) + \mathrm{GlobalAttn}(s_{1:t}) Vψ(st)−=LocalAttn(st)+GlobalAttn(s1:t) ,评估每个状态的局部步骤评估和全局轨迹上下文。当 V ψ ( s t ) < γ ⋅ max k ≤ t V ψ ( s ˉ k ) V_\psi(s_t) < \gamma \cdot \operatorname*{max}{k \leq t} V\psi(\bar{s}_k) Vψ(st)<γ⋅maxk≤tVψ(sˉk) 时,剪枝低价值的推理路径,集中资源于有前景的轨迹。这一机制减少了无效探索,加速了收敛,并确保模型优先考虑高质量的推理序列,从而在其复杂推理任务中表现出色。

5.2.4 冷启动推理强化学习

DeepSeek-R1-Zero 进一步推进了强化学习(RL)的应用,通过采用冷启动方法,放弃了监督微调(SFT),完全依赖于从未经训练的基础模型进行大规模RL。这种自我进化策略通过迭代反馈来优化推理,生成强大的链式思维(CoT)序列,而无需依赖预标注数据。通过直接在推理任务上进行训练,DeepSeek-R1-Zero 展示了RL的灵活性,其性能可与使用SFT初始化的模型(如其DeepSeek-R1对等模型)相媲美甚至超越。

这种方法不仅减少了对大量标注数据集的依赖,还展示了RL自主开发复杂推理能力的潜力,为未来的大型语言模型(LLM)发展提供了一个可扩展的范式。总体而言,RL为增强推理提供了一个有前景的框架,有效的奖励设计、策略优化(例如GRPO)和探索策略仍然是关键。未来的研究可以探索结合模仿学习或自监督目标的混合方法,以进一步完善这些能力,巩固RL在推进LLM推理中的作用。

六、PoLMs 效率

基于前几章讨论的后训练优化技术,后训练效率特别针对大型语言模型(LLMs)在初始预训练后的操作性能。主要目标是优化关键部署指标(例如处理速度、内存使用和资源消耗),从而使 LLMs 更适用于实际应用。实现后训练效率的方法主要分为三类:

- 模型压缩(§6.1),通过剪枝和量化等技术减少整体计算足迹;

- 参数高效微调(§6.2),仅更新模型的一部分参数或采用专用模块,从而最小化再训练成本并加速对新任务的适应;

- 知识蒸馏(§6.3),将较大预训练模型的知识转移到较小的模型上,使较小模型能够在减少资源需求的情况下实现相当的性能。

6.1 模型压缩

模型压缩包括一系列旨在减少大语言模型(LLMs)的大小和计算需求的技术,其中包括训练后量化、参数剪枝和低秩近似。

6.1.1 后训练量化

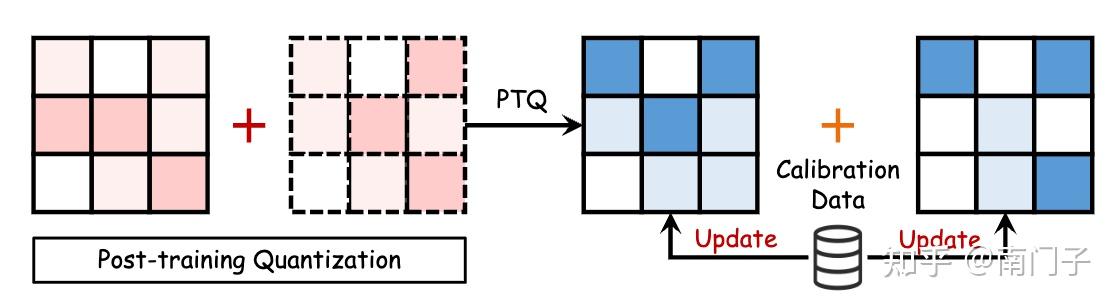

对于大语言模型(LLMs)而言,一种关键的压缩方法是量化,它将高精度数据类型 X^{H} (30位浮点数)转换为低精度格式 X ˙ L \mathit{\dot{X}}^{L} X˙L (8位整数)[201]。这种转换可以表示为:

X L = Round ( a b s m a x ( X L ) a b s m a x ( X H ) X H ) = Round ( K ⋅ X H ) X^{L}=\operatorname{Round}\left(\frac{\mathrm{absmax}(X^{L})}{\mathrm{absmax}(X^{H})} X^{H}\right)=\operatorname{Round}(\mathcal{K} \cdot X^{H}) XL=Round(absmax(XH)absmax(XL)XH)=Round(K⋅XH)

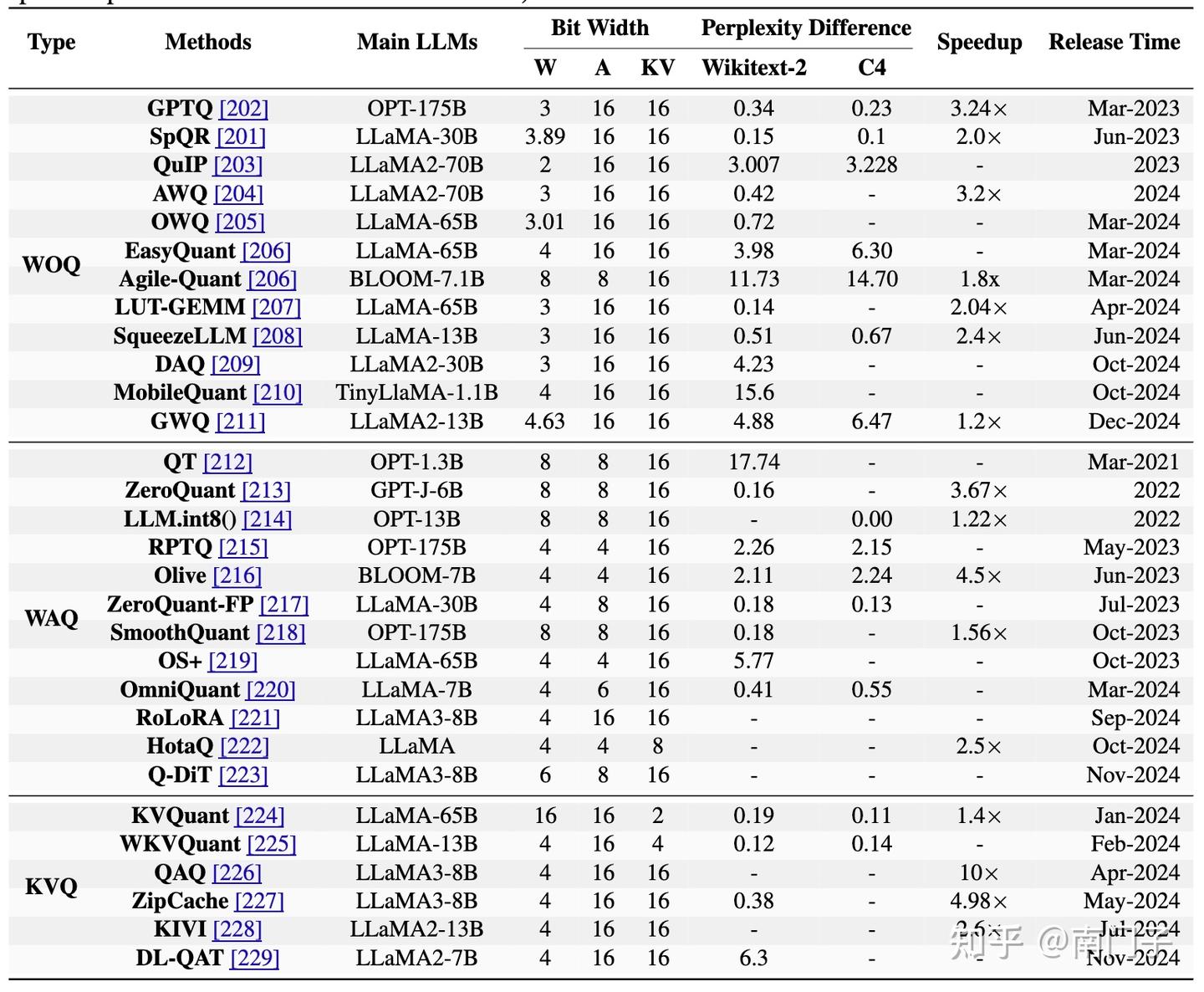

其中 K \mathcal{K} K 表示量化常数,absmax 指的是元素的最大绝对值。函数 Round 将浮点数转换为整数。大语言模型的量化包括训练后量化(PTQ)和量化感知训练(QAT)。PTQ 使模型权重和激活在预训练后进行调整,使用一个小的校准数据集来优化计算效率和性能,如图14所示。此外,表5列出了几种主要的大语言模型量化方法的性能指标。

仅权重量化(WOQ)。WOQ 专注于压缩模型权重以提高效率。GPTQ [230] 使用逐层量化和最优大脑量化(Optimal Brain Quantization, OBQ),将权重减少到3或4位,以降低内存使用和处理时间。为了进一步提高效率,QuIP [203] 引入了不一致性处理,实现2位量化,提供更紧凑的表示。同样,AWQ [204] 和 OWQ [205] 通过保持对特别敏感权重的高精度,来最小化推理过程中的潜在精度损失。最后,SpQR [201] 结合稀疏量化和解码,实现在保持模型响应性的前提下高效地逐令牌推理。

权重-激活共量化(WAQ)。WAQ 将权重和激活集成在一起以提高效率。LLM.int8() [214] 通过精确存储解决激活异常值问题,并量化为8位,同时保持性能。Smooth Quant [218] 实现每通道缩放,将量化难题从激活转移到权重,实现无损结果。此外, O S + {\mathrm{OS+}} OS+ [219] 通过通道级移位和缩放减轻异常值的影响,从而提高效率。OmniQuant [220] 将量化难题从激活转移到权重,并微调极端值的裁剪阈值。为了进一步提高效率,RPTQ [231] 对相似通道进行分组,确保量化参数的一致性。

键值缓存量化(KVQ)。键值缓存量化解决了大语言模型中输入令牌数量增加带来的内存优化挑战。KVQuant [224] 引入了针对长上下文长度高效推理的定制方法,保持性能的同时最小化损失。KIVI [228] 通过应用不同的量化策略来优化键和值缓存的内存节省,实现2位量化而无需微调。WKVQuant [225] 进一步改进了这一点,采用了二维量化策略和跨块正则化,实现了与权重-激活量化相当的内存效率,且性能几乎相同。

6.1.2 参数剪枝

参数剪枝[232]是提高大语言模型(LLMs)效率的关键技术,通过最小化模型大小和复杂度而不牺牲精度。如图15所示,剪枝可以分为非结构化剪枝和结构化剪枝。

- 非结构化剪枝

非结构化剪枝通过消除不重要的权重来增强大语言模型的稀疏性。已知的方法SparseGPT[230]通过一次剪枝实现了高达 60% 的稀疏性,同时保持最小的损失。Wanda[233]基于权重大小和激活值进行剪枝,无需重新训练。与此同时,SAMSP[234]利用Hessian矩阵的敏感性进行动态调整稀疏性,旨在最小化误差。DSnoT[235]通过使用迭代剪枝周期提高了性能。最后,Flash-LLM[236]从全局内存中检索稀疏权重,并在芯片上的缓冲区中重建为密集形式,以促进高效计算。

- 结构化剪枝

这种方法侧重于修剪大语言模型中的整个参数组,以提高硬件效率并简化结构。例如,LLM-runer[237]评估了LLaMA[65]的重要性,并使用LoRA[92]在剪枝后恢复精度。FLAP[238]使用结构化指标优化压缩,无需微调。此外,SliceGPT[239]使用PCA进行剪枝,同时保持效率。Sheared LLaMA[240]通过基于正则化的剪枝优化模型形状。LoRAPrune[241]通过基于LoRA重要性的迭代结构化剪枝提高效率。此外,Deja Vu[242]通过预测关键注意力头和MLP参数,使用上下文稀疏性减少延迟,同时保持精度。

- 低秩近似

低秩近似通过将权重矩阵 W W W 近似为较小的矩阵 U U U 和 V V V ,即 W ≈ U V ˙ ⊤ {W}\approx{U}{\dot{V}}^{\top} W≈UV˙⊤ ,从而压缩大语言模型。这种方法不仅减少了参数数量,还提高了操作效率。例如,TensorGPT[243]使用张量列车分解(Tensor-Train Decomposition, TTD)开发了更高效的嵌入格式。LoSparse[244]将低秩近似与剪枝结合,特别针对压缩连贯神经元组件。FWSVD[245]实现了一种加权SVD方法,而ASVD[246]提供了一种无训练的SVD替代方案,两者均针对训练后的效率。最后,SVD-LLM[247]通过建立奇异值与压缩损失之间的直接关系进一步改进了压缩效果。

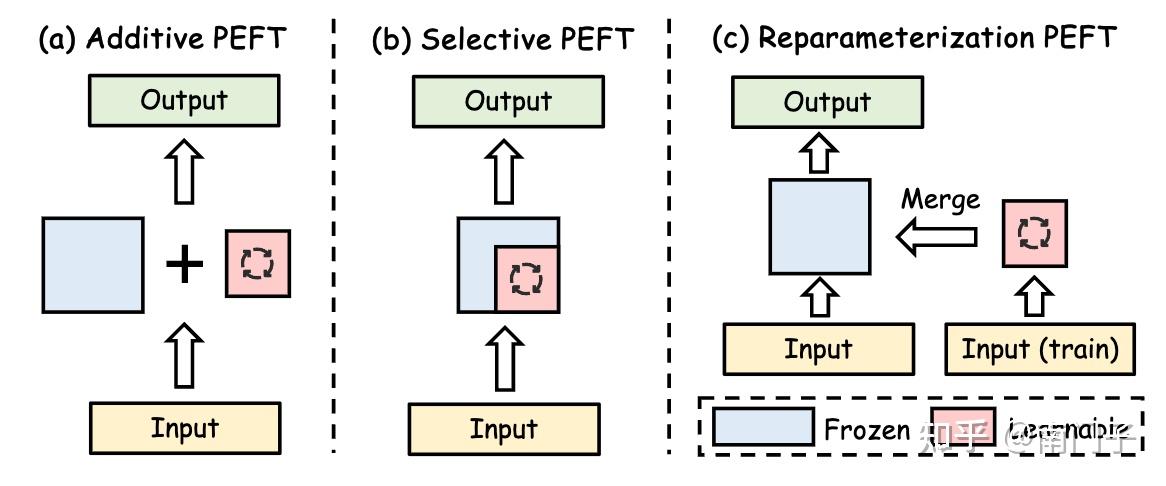

6.2 参数高效微调

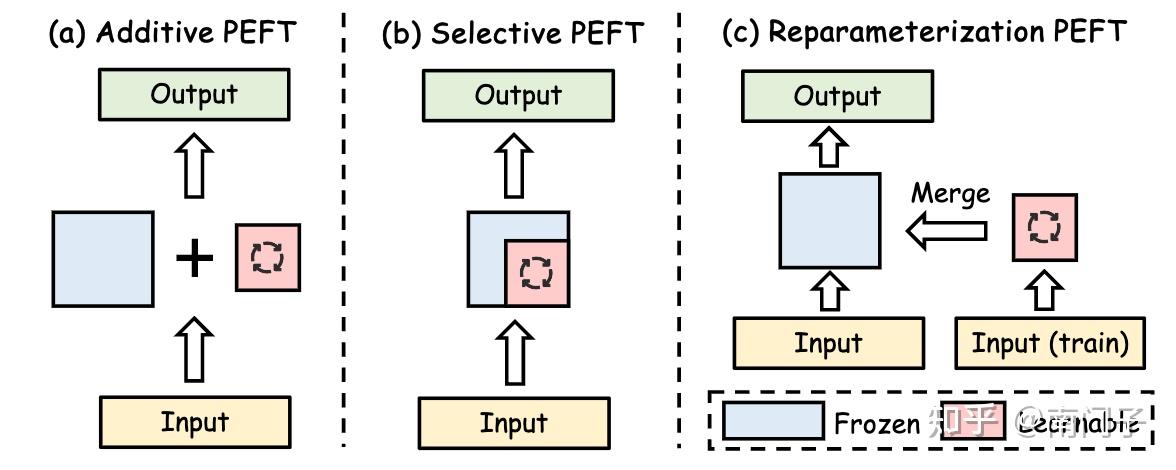

参数高效微调(PEFT)的过程包括冻结完整的LLM主干,同时仅修改少量新增的参数。如图16所示,PEFT方法分为四类:加法PEFT、选择性PEFT、重参数化PEFT和混合PEFT。

6.2.1 加性 PEFT

加法式参数高效微调(Additive PEFT)在大型语言模型(LLM)中引入新的可训练模块,而不改变原有参数,从而实现在保留基础模型知识的同时进行特定任务的调整,这对于微调来说非常高效。

适配器(Adapters)。适配器在变压器块内集成紧凑层,定义为:

A d a p t o r ( x ) = W u p σ ( W d o w n x ) + x \mathrm{Adaptor}(x)=W_{\mathrm{up}}\sigma(W_{\mathrm{down}}x)+x Adaptor(x)=Wupσ(Wdownx)+x

其中, W d o w n ∈ R r × d W_{\mathrm{down}} \in \mathbb{R}^{r \times d} Wdown∈Rr×d 是下投影矩阵, σ \sigma σ 是非线性激活函数, W u p ∈ R d × r W_{\mathrm{up}} \in \mathbb{R}^{d \times r} Wup∈Rd×r 是上投影矩阵。这里, d d d 是隐藏层维度, r r r 是瓶颈维度,通过减少复杂度同时保持性能。基于这种结构,Serial Adapter [248] 在每个变压器块中引入了两个模块。Adapter Fusion [249] 通过在 Add & Norm 之后放置适配器来提高效率。Parallel Adapter (PA) [250] 并行运行适配器和子层,而 CoDA [251] 通过并行运行适配器和子层来优化性能。与 Adapter Fusion 不同,MerA [252] 使用最优传输技术统一适配器的权重和激活。

软提示(Soft Prompt)。软提示通过在输入序列中添加可调向量而不是优化离散令牌来增强模型性能 [253]。这种方法的形式化表示为:

X ( l ) = [ s 1 ( l ) , … , s N S ( l ) , x 1 ( l ) , … , x N X ( l ) ] X^{(l)} = [s_{1}^{(l)}, \ldots, s_{N_{S}}^{(l)}, x_{1}^{(l)}, \ldots, x_{N_{X}}^{(l)}] X(l)=[s1(l),…,sNS(l),x1(l),…,xNX(l)]

其中, s i ( l ) s_{i}^{(l)} si(l) 表示软提示令牌, x i ( l ) x_{i}^{(l)} xi(l) 表示原始输入令牌。 N S N_{S} NS 和 N X N_{X} NX 分别是软提示和原始输入令牌的数量。Prefix Tuning [254] 在变压器层之间引入可学习向量,并通过重新参数化和 P-Tuning v2 [99] 及 APT [255] 进行优化。与此同时,Prompt Tuning [44] 专注于初始嵌入层,以低计算成本优化大型模型。Xprompt [256] 和 IDPG [257] 简化了提示生成和插入。SPoT [258] 和 PTP [259] 解决了稳定性和收敛速度问题,而 DePT [260] 和 SMoP [261] 通过优化提示结构减少了计算需求。

其他加法式方法。除了早期的技术,诸如 ( L A ) 3 \mathrm{(LA)^{3}} (LA)3 [262] 和 SSF [263] 等方法通过引入最小但强大的模型参数调整来关注训练后的效率。自注意力和前馈网络(FFN)操作在数学上定义为:

S A ( x ) = Softmax ( Q ⋅ ( l k ⊙ K ) T d h e a d ) ⋅ ( l v ⊙ V ) S A(x) = \operatorname{Softmax}\left(\frac{Q \cdot (l_{k} \odot K)^{T}}{\sqrt{d_{head}}}\right) \cdot (l_{v} \odot V) SA(x)=Softmax(dheadQ⋅(lk⊙K)T)⋅(lv⊙V)

F F N transformer ( x ) = W u p ⋅ ( l f f ⊙ σ ( W d o w n x ) ) F F N_{\text{transformer}}(x) = W_{up} \cdot (l_{ff} \odot \sigma(W_{down}x)) FFNtransformer(x)=Wup⋅(lff⊙σ(Wdownx))

其中, ⊙ \odot ⊙ 表示哈达玛积,尺度向量 l k l_{k} lk 和 l v l_{v} lv 可以平滑地融入 A Q A_{Q} AQ 和 A W A_{W} AW 的权重矩阵中。此外,IPA [264] 使像 GPT-4 这样的大型语言模型与用户特定需求对齐。此外,它不需要对底层模型进行更改,因此在微调过程中保持了效率。

6.2.2 选择式 PEFT

选择性参数高效微调(Selective PEFT)通过仅对参数的一个子集进行微调来提高效率,如图16(b)所示。这涉及到将一个二元掩码 M = . m 1 , m 2 , … , m n M\,\stackrel{.}{=}\,{m_{1},m_{2},\ldots,m_{n}} M=.m1,m2,…,mn 应用到参数 θ = θ 1 , θ 2 , … , θ n \theta\,=\,{\theta_{1},\theta_{2},\ldots,\theta_{n}} θ=θ1,θ2,…,θn 上,其中每个 m i m_{i} mi 表示 θ i \theta_{i} θi 是否被选中进行微调。更新后的参数集表示为:

θ i ′ = θ i − η ⋅ m i ⋅ ∂ L ∂ θ i \theta_{i}^{\prime}=\theta_{i}-\eta\cdot m_{i}\cdot\frac{\partial\mathcal{L}}{\partial\theta_{i}} θi′=θi−η⋅mi⋅∂θi∂L

其中 η \eta η 是学习率, ∂ L ∂ θ i \frac{\partial\mathcal{L}}{\partial\theta_{i}} ∂θi∂L 是损失函数的梯度。只有被选中的参数(即 m i = 1 m_{i}\,=\,1 mi=1 )会被更新,从而在保持效果的同时减少计算成本。早期的方法包括差分剪枝(Diff pruning)[265],该方法使用可微的 L 0 L_{0} L0 -范数对可学习的二元掩码进行正则化;以及 FishMask [266],该方法基于 Fisher 信息选择参数以提高相关性。LT-SFT [267] 应用了彩票假设(Lottery Ticket Hypothesis)来识别重要的参数。SAM [268] 使用二阶近似进行选择,而 Child-tuning [269] 在子网络中动态选择参数。此外,FAR [270] 和 BitFit [271] 进一步展示了选择性参数高效微调(Selective PEFT),通过专注于优化特定的参数组。

6.2.3 重参数 PEFT

重新参数化的PEFT(Parameter-Efficient Fine-Tuning)主要采用低秩参数化来提高效率,如图16©所示。LoRA(低秩适应)[92]引入了两个可训练矩阵,

W u p ∈ R ˙ d × r 和 W d o w n ∈ R r × k W_{\mathrm{up}} \in \dot{\mathbb{R}}^{d \times r} 和 W_{\mathrm{down}} \in \mathbb{R}^{r \times k} Wup∈R˙d×r和Wdown∈Rr×k

修改输出为:

h o u t = W 0 h i n + α ( W u p W d o w n h i n ) h_{\mathrm{out}} = W_{0} h_{\mathrm{in}} + \alpha \big(W_{\mathrm{up}} W_{\mathrm{down}} h_{\mathrm{in}}\big) hout=W0hin+α(WupWdownhin)

其中 α \alpha α 是一个缩放因子。这种方法允许在保持核心知识的同时高效地适应新任务。基于LoRA,Intrinsic SAID [272] 最小化微调参数空间,进一步减少计算需求。动态变体包括DyLoRA [273] 和AdaLoRA [274],根据特定任务的需求动态调整秩,而AdaLoRA还结合了基于SVD的剪枝以提高效率。

SoRA [275] 通过去除正交性约束简化过程,Laplace-LoRA [276] 应用贝叶斯校准进行微调。Compacter [277] 和VeRA [278] 进一步减少了参数复杂度。此外,DoRA [279] 在方向分量中优化更新,HiRA [280] 使用Hadamard积进行高秩更新,从而提高了效率和性能。为了处理多个任务和不断变化的领域,Terra [281] 集成了一个时变矩阵,ToRA [282] 利用Tucker分解进一步改进LoRA结构。

除了结构设计,PiSSA [283] 和LoRA-GA [284] 使用SVD和梯度对齐优化LoRA的初始化。同时, LoRA ^+ [285]、LoRA-Pro [286] 和CopRA [287] 进一步细化了梯度更新策略。此外,ComLoRA [288] 采用竞争学习选择表现最佳的LoRA组件。

6.2.4 混合 PEFT

混合 PEFT 方法通过整合或优化各种微调策略来提高训练后效率。一种突出的技术是 UniPELT [289],它在变压器块中集成了 LoRA、前缀调优和适配器。该方法通过由前馈网络 (FFNs) 管理的门控机制动态激活组件,这些 FFNs 生成标量 G ∈ [ 0 , 1 ] G\in {[0,1]} G∈[0,1] ,最终优化参数利用。

另一种创新方法是 MAM Adapter [250],它通过在自注意力层中战略性地定位前缀调优,并在前馈层中使用缩放并行适配器来改进这一技术。此外,基于 NAS 的方法如 NOAH [290] 和 AUTOPEFT [291] 通过识别特定任务的最佳 PEFT 配置来提高训练后效率。HeadMap [292] 使用贪婪方法识别一系列在某些任务中起关键作用的注意力头(即知识电路),并通过将这些注意力头的输出映射回 LLM 的残差流中,高效地提升模型性能。

最后,LLM-Adapters [293] 提供了一个框架,用于在 LLM 中集成各种 PEFT 技术,确保最有效的模块放置以维持不同模型规模下的效率。

6.3 知识蒸馏

知识蒸馏(KD)是大型语言模型(LLM)后训练优化中的关键技术,能够将大型预训练教师模型的知识转移到紧凑的学生模型中,从而提高效率而不牺牲性能。最初在模型压缩背景下提出,KD因其能够将复杂知识提炼到资源高效的架构中而受到广泛关注,使得其能够在边缘设备和嵌入式系统等受限制环境中部署。

通过利用教师模型的细腻输出分布——比传统的硬标签更丰富——KD使学生不仅能够复制类别预测,还能复制类间关系和教师表示中固有的细微模式。这一过程通常涉及优化一个复合损失函数,该函数平衡监督学习目标与蒸馏特定目标,显著减少计算和内存需求,同时保持泛化能力。

KD的基本机制在于最小化一个混合损失,该损失集成了传统分类损失与蒸馏项。形式上,给定教师模型的软输出概率 p t \mathbf{p}_{\mathbf{t}} pt 和学生模型的预测 p s \mathbf{p_{s}} ps ,以及真实标签 y \mathbf{y} y 和学生输出 y s \mathbf{y_{s}} ys ,KD损失表示为:

L K D = α L C E ( y , y s ) + ( 1 − α ) L K L ( p t , p s ) \mathcal{L}_{K D}=\alpha\mathcal{L}_{C E}(\mathbf{y},\mathbf{y_{s}})+(1-\alpha)\mathcal{L}_{K L}(\mathbf{p_{t}},\mathbf{p_{s}}) LKD=αLCE(y,ys)+(1−α)LKL(pt,ps)

其中 L C E \mathcal{L}_{C E} LCE 表示捕捉与真实标签对齐的交叉熵损失, L K L \mathcal{L}_{K L} LKL 表示测量教师和学生分布之间差异的Kullback-Leibler散度[294], α ∈ [ 0 , 1 ] \alpha\,\in\,[0,1] α∈[0,1]是一个调节目标的超参数。软目标 p t \mathbf{p_{t}} pt 通常由温度参数 T 调整(即 p t = s o f t m a x ( z t / T ) \mathbf{p_{t}}=\mathrm{softmax}(\mathbf{z_{t}}/T) pt=softmax(zt/T) ,其中 z t \mathbf{z_{t}} zt 是教师的logits),编码了更丰富的概率信息,使学生能够模拟教师的决策细微之处,而不仅仅是标签准确性。

KD广泛用于资源受限环境下的模型压缩和迁移学习,其中预训练的教师指导特定任务的学生。其有效性取决于教师容量、学生架构和蒸馏损失设计等因素。最近的进展将KD扩展到输出蒸馏之外,使得在后训练优化中实现更高效和适应性强的LLM。根据对教师模型内部参数和中间表示的访问程度,KD方法大致可以分为黑盒KD和白盒KD。

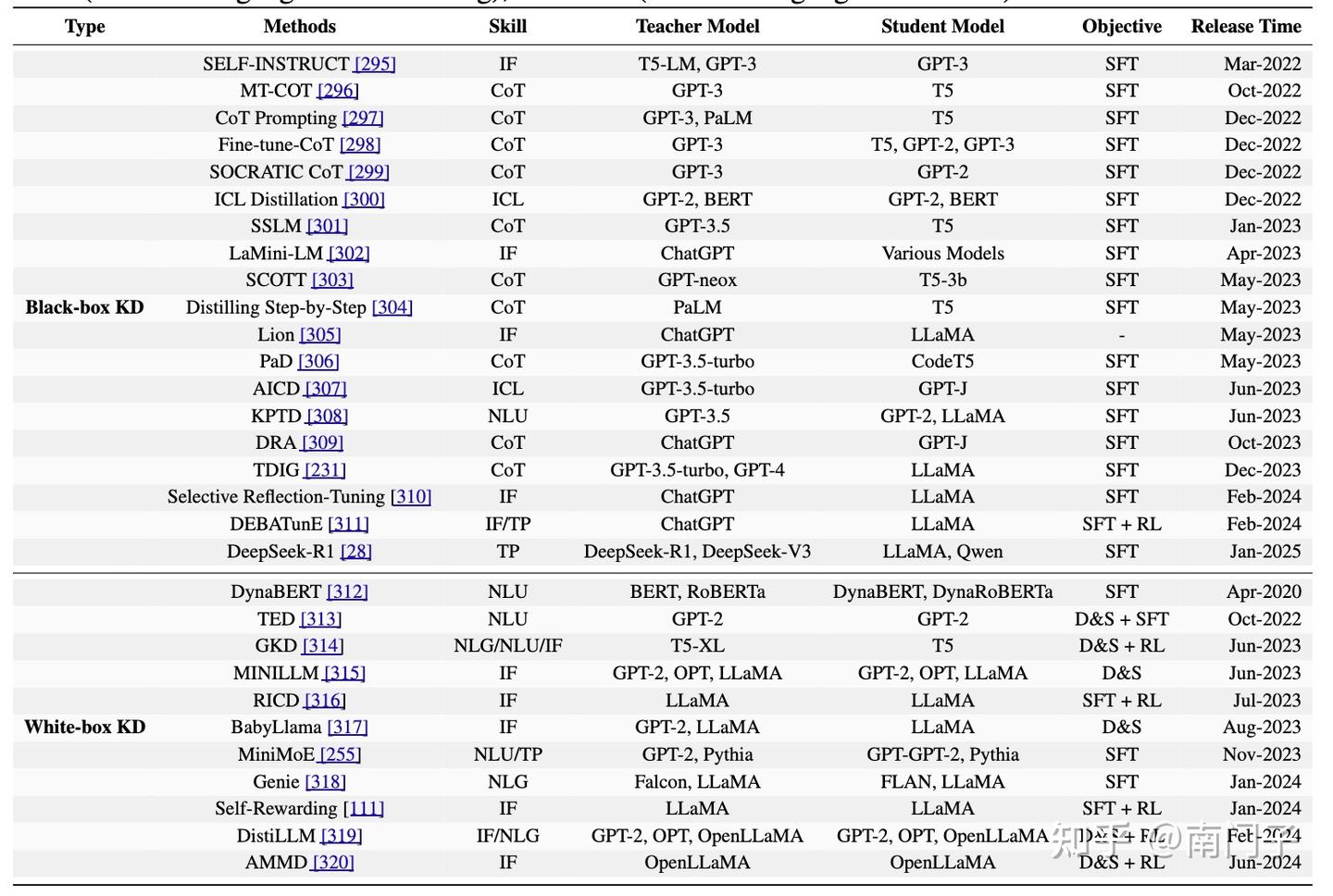

表6:大型语言模型(2020–2025年)知识蒸馏方法总结。此表概述了关键的蒸馏技术,详细列出了它们的技能、教师和学生模型、目标及发布时间线,并按黑盒KD(访问限于教师输出,通常来自闭源LLM)和白盒KD(访问教师参数或分布,通常来自开源LLM)分类。指标包括IF(指令跟随)、CoT(链式思维)、ICL(上下文学习)、SFT(监督微调)、D&S(差异与相似性)、RL(强化学习)、TP(思考模式)、NLU(自然语言理解)和NLG(自然语言生成)。

如表6所示,知识蒸馏方法大致可以分为两类:黑盒KD和白盒KD。我们提供了各种大型语言模型(LLMs)中的知识蒸馏技术的系统总结,以及它们相应的技能、教师模型和学生模型。

黑盒KD

黑盒KD是指学生模型仅从教师的输出logits学习,而无法访问其内部表示或架构细节的情况。这种方法最初由Hinton[321]提出,符合经典的KD范式,由于其灵活性而被广泛采用。黑盒KD的一个关键优势是将教师模型视为不透明函数,即使教师是一个专有或预训练模型且访问受限,也能实现知识转移。

实际上,大型教师LLM(如ChatGPT和GPT-4[9])通常用于生成高质量输出。与此同时,较小的语言模型(SLM),包括GPT-2[14]、T5[322]、Flan-T5[323]和CodeT5[324],作为学生模型。这些SLM经过优化以提高效率,同时保持强大的泛化能力,使其适合在资源受限环境中部署。

白盒KD

白盒KD通过利用教师模型的内部表示,扩展了传统的蒸馏范式。当教师模型的架构已知且可访问时,这种方法是有益的,允许进行更丰富的监督形式。与将教师视为不透明函数的黑盒KD不同,白盒KD允许学生模型不仅从教师的输出logits学习,还可以从中间激活、隐藏层甚至注意权重[325]学习。

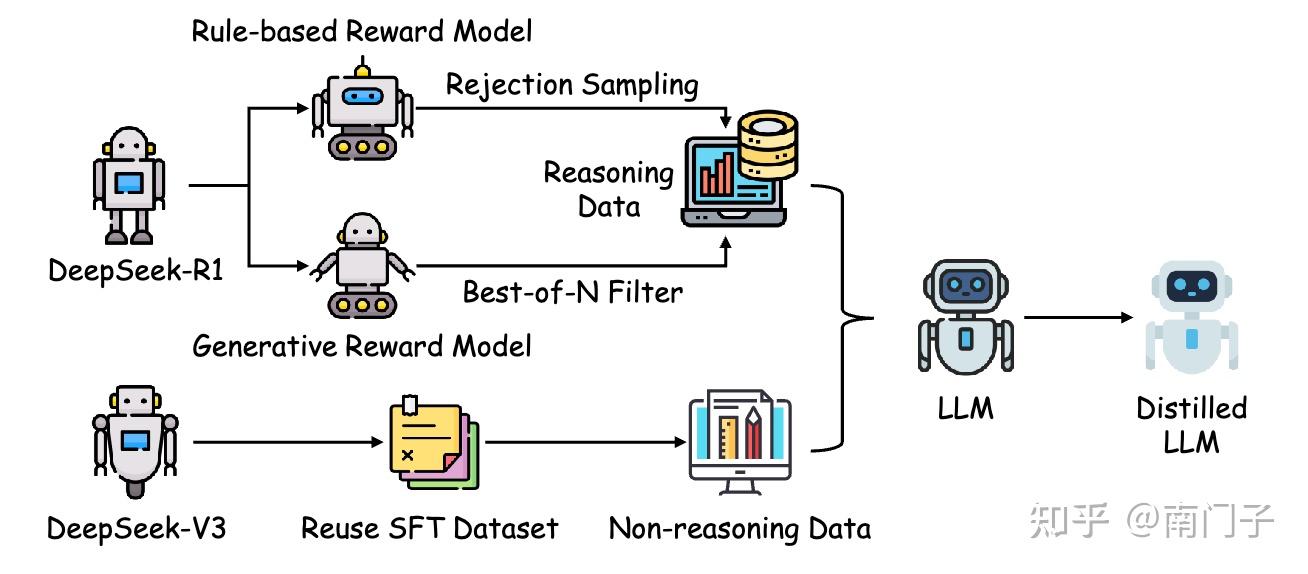

DeepSeek-R1:推理模式的直接蒸馏

DeepSeek-R1展示了KD通过将大规模模型中的复杂推理模式蒸馏到紧凑架构中,显著增强了小型LLM的推理能力,而无需承担直接在这些模型上进行强化学习(RL)的计算负担。这种方法称为直接蒸馏,利用由大型教师模型生成的大约80万样本的精心策划数据集,其中包括从DeepSeek-V3派生的20万非推理实例和由DeepSeek-R1-Stage1检查点生成的60万推理实例。这些样本构成了应用于开源基础模型(如Qwen和LLaMA的小型变体)的SFT的基础,使学生模型能够继承通常为其较大对应物保留的复杂推理能力。

DeepSeek-R1中的直接蒸馏过程如图17所示,展开在一个结构化的管道中。最初,教师模型——在大量数据集上预训练——生成一个包含推理和非推理输出的多样化语料库,捕捉逻辑模式和事实知识的谱系。非推理数据(约20万样本)提供了一般知识的基线,而推理数据(约60万样本)封装了多步推理链,通过教师的高级功能进行了细化。

然后,在SFT阶段使用该数据集,学生模型在此过程中被训练以使其输出分布与教师对齐,使用推理数据直接微调较小模型以蒸馏出紧凑的推理模型。与直接应用于小模型的传统RL不同,后者可能因容量有限而导致次优推理,DeepSeek-R1的直接蒸馏通过转移预先优化的推理行为,克服了这些限制,实现了更高的性能并减少了资源需求。

DeepSeek-R1的KD方法的一个显著特点是强调在不同模型规模下保持推理完整性。通过集成从DeepSeek-R1-Stage1——通过大规模RL精炼的检查点——提取的推理轨迹,学生模型不仅复制了事实准确性,还模拟了复杂的推理过程,例如数学问题解决或逻辑演绎所需的推理过程。这种有针对性的转移与传统的KD形成对比,后者通常优先考虑分类任务,突显了DeepSeek-R1在面向推理的蒸馏方面的创新。

此外,该方法减少了对学生进行大量RL迭代的需求,利用教师预先计算的推理输出简化训练,从而提高效率和可扩展性。这一方法论将DeepSeek-R1定位为将高级推理蒸馏到紧凑LLM的典范,为未来的后训练优化工作提供了蓝图。

七、PoLMs 集成和适配

集成和适应技术对于增强大语言模型(LLMs)在各种实际应用中的灵活性和有效性至关重要。这些方法使 LLMs 能够无缝处理异构数据类型,适应特定领域,并利用多种架构优势,从而应对复杂、多方面的挑战。本章详细介绍了三种主要策略:

- 多模态集成 (\S7.1) ,使模型能够处理文本、图像和音频等不同的数据模态;

- 领域适应 (\S7.2) ,对模型进行优化以适用于特定行业或用例;

- 模型合并 (§7.3),将不同模型的能力融合在一起以优化整体性能。

总体而言,这些方法增强了 LLMs 的适应性、效率和鲁棒性,拓宽了它们在不同任务和场景中的应用范围。

7.1 多模态集成

在前几章阐述的后训练优化策略基础上,本节探讨旨在增强大型语言模型(LLMs)和大型多模态模型(LMMs)有效处理多模态数据的高级方法。虽然监督微调提高了LLMs在特定任务上下文中的能力,但其在充分利用多模态能力方面的局限性需要更复杂的后训练方法。

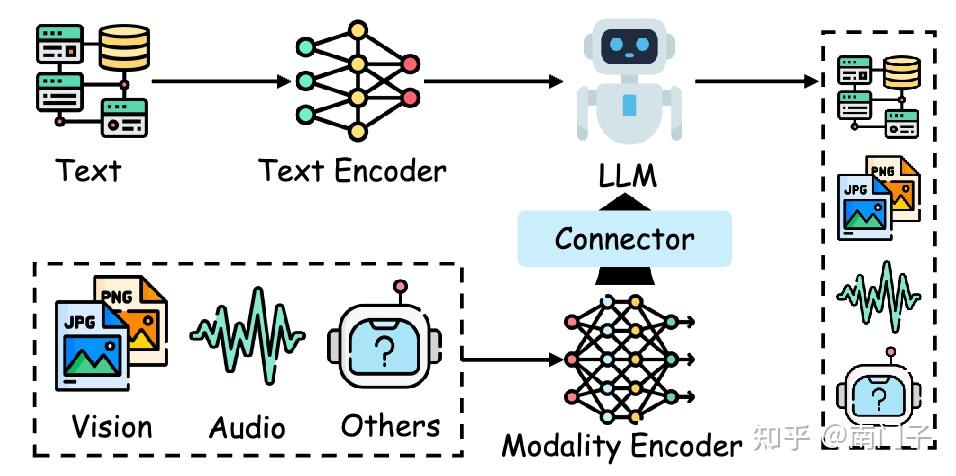

这些技术通过将不同数据类型整合到统一框架中,使LMMs能够应对复杂的跨模态任务(例如,从视觉输入生成网页代码[326]、解释复杂的文化符号如表情包[327]以及在不依赖光学字符识别的情况下进行数学推理[50])。通常,LMMs包括一个模态编码器、预训练的LLM主干和一个模态连接器[328],如图18所示。这种架构构成了后训练方法的基础,这些方法通过优化每个组件,促进稳健的多模态集成和性能提升。

7.1.1 模态连接

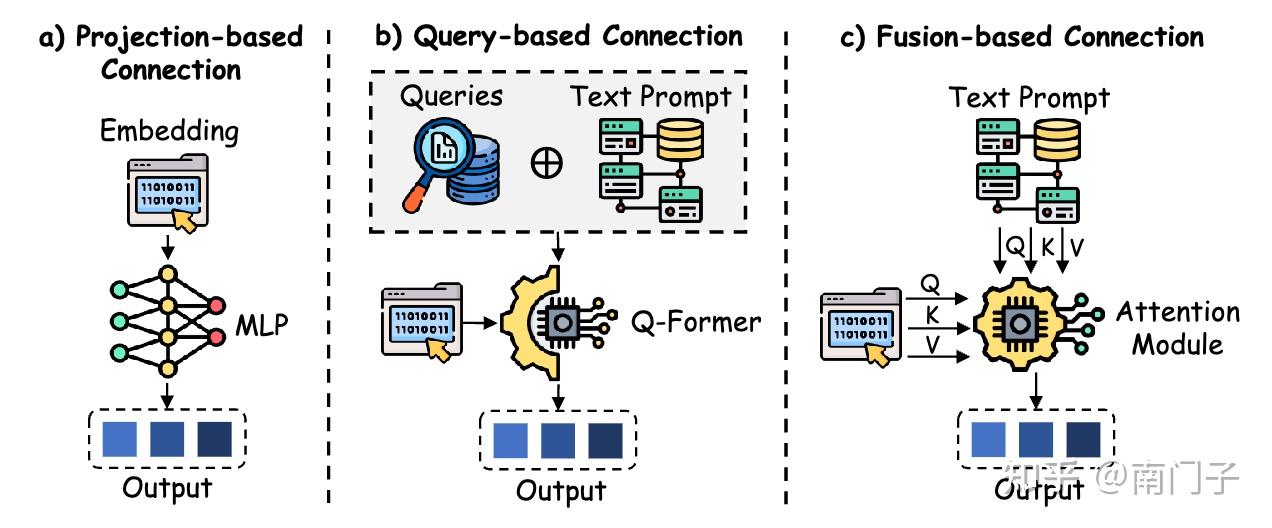

模态连接方法在将多模态数据综合成一个连贯的表示框架中起着关键作用,可以分为三种主要策略:基于投影的方法、基于查询的方法和基于融合的方法[328],如图19所示。

-** 基于投影的模态连接**

基于投影的方法将不同的模态输入转换为统一的文本嵌入空间,使它们的特征与大语言模型(LLMs)的语言维度对齐,实现无缝集成。LLaMA-Adapter[329]通过引入图像编码器,将LLMs扩展到多模态系统中,实现了图像条件下的指令跟踪。其后续版本LLaMA-Adapter V2[330]通过将视觉标签嵌入到早期LLM层中,进一步改进了这一过程,促进了视觉知识的更好吸收。

FROMAGe[331]通过对冻结的LLM和视觉编码器框架中的输入和输出层进行微调,实现了跨模态交互,而LLaVA-1.5[332]则利用双线性多层感知机(MLP)增强了多模态处理的鲁棒性。最近的发展,如Shikra[333],通过整合空间坐标来增强自然语言对话,而VILA[334]优化了视觉-语言预训练,以实现卓越的零样本能力。DetGPT[335]通过将推理驱动的对象检测与自然语言交互相结合,进一步推进了这一范式,利用投影技术促进了有效的多模态通信。

SOLO[336]使用单一的Transformer架构进行统一和端到端的视觉-语言建模,接受原始图像块(以像素形式)和文本作为输入,而无需使用单独的预训练视觉编码器。MiniGPT-4[326]通过单个投影层将冻结的视觉编码器与Vicuna对齐,实现了类似GPT-4的能力,并采用了两阶段训练过程。Idefics[337]凭借自回归设计和多阶段预训练,在高效推理方面表现出色。

LaVIT[338]通过离散视觉分词器统一了视觉和语言,实现了无缝生成。DeepSeek-VL2[339]通过动态平铺和多头潜在注意力增强了高分辨率图像理解。最后,Qwen2.5-VL[340]通过重新设计的视觉Transformer,提高了多模态任务的性能,在感知和视频理解方面表现出色。

- 基于查询的模态连接

基于查询的方法通过使用可学习的查询令牌从不同模态中提取结构化信息,弥合文本和非文本数据之间的差距,从而增强多模态集成。BLIP-2[52]率先采用了查询Transformer,实现了文本和视觉输入的有效集成。

Video-LLaMA[341]通过组合视觉编码器将这一技术扩展到视频理解,而Instruct BLIP[342]通过改进查询机制确保了对指令的精确遵循。X-LLM[343]通过专用接口对齐多模态输入,而随后的创新如mPLUG-Owl[344]和Qwen-VL[345]优化了Q-Former架构以提高计算效率。LION[346]进一步展示了基于查询方法的有效性,通过提升视觉知识集成,强调了其在各种任务中增强LMM性能的实用性。

Qwen-VL[345]是一系列大规模视觉-语言模型,基于Qwen-7B构建,集成了视觉接收器、位置感知适配器和三阶段训练管道,实现了多语言、细粒度的视觉-语言理解。Lyrics[347]是一个细粒度的视觉-语言预训练和指令微调框架,通过视觉细化器(图像标注、对象检测和语义分割)和多尺度查询Transformer(MQ-Former),增强了大型视觉-语言模型(LVLMs)的功能。

- 基于融合的模态连接

基于融合的技术通过直接将多模态特征嵌入到LLM架构中,加深了跨模态交互,促进了推理层面更丰富的集成。Flamingo[51]通过交叉注意力层在标记预测过程中融合视觉特征,实现了动态多模态处理。

Open Flamingo[348]在此基础上,允许冻结的LLMs关注视觉编码器的输出,增强了灵活性。Otter[349]引入了指令调优,以改善多模态指令的遵循,而CogVLM[350]通过在Transformer层中集成视觉专家模块,实现了无缝特征合成。Obelics[351]利用交错的图像-文本训练数据,突显了基于融合的方法在实现连贯多模态性能方面的稳健性。

InternVL[352]是一个大规模的视觉-语言基础模型,将视觉编码器扩展到60亿参数,并通过语言中间件(QLLaMA)逐步与LLMs对齐。Llama 3[25]是Meta开发的一系列多语言、工具使用的基础模型,参数规模达到4050亿,具有128K标记上下文窗口,通过改进的数据质量、更大规模的训练和结构化的后训练策略进行了优化。

表7:2022-2025年各模态编码器和大规模多模态模型概览。该表总结了关键的多模态模型,详细列出了它们的编码器类别、大小、输入投影器、LLM骨干和发布时间线,涵盖了视觉、音频和其他模态。指标包括C-a(交叉注意力)、Q-F(Q-Former)、MQ-F(多查询Q-Former)和LP(线性投影器),代表输入投影机制。

7.1.2 模态编码器

模态编码器将原始多模态输入压缩成紧凑且语义丰富的表示,使各种任务和模态的处理更加高效。这些组件对于将异构数据转换为与大语言模型(LLM)主干兼容的格式至关重要,支持从视觉推理到音频理解的各种应用。表7提供了在视觉、音频及其他模态中广泛使用的编码器的全面总结,详细描述了它们的特点及其对多模态集成的贡献。

- 视觉编码器

视觉编码器是多模态学习的基础,有助于在大规模多模态模型(LMMs)中解释和生成视觉数据。CLIP [372] 通过对比学习建立了图像-文本的联合表示,增强了跨模态对齐。EVA [373] 优化了视觉注意力机制,提高了效率;

而 ImageBind [374] 创建了一个统一的嵌入空间,跨越多个模态,提升了零样本识别能力。SigLIP [375] 引入了一种配对的Sigmoid损失来优化图像-文本预训练,DINOv2 [376] 则利用无监督学习从多样化的来源中提取鲁棒的视觉特征。LLaVA [53] 采用自指导策略将图像转换为文本描述,使用先进的大语言模型生成新的数据集。

Video-ChatGPT [354] 支持大规模指令数据集下的对话视频理解,BT-Adapter [355] 通过高效的时序建模优化了视频理解。VideoChat [353] 专注于时空推理,利用专门的数据集和模型,如 CoDi-2 [369] 和 Mipha [358],在多模态处理中实现了效率提升。VL-Mamba [357] 和 Cobra [359] 引入了状态空间模型以优化推理,SPHINX-Tiny [356] 则强调数据多样性和训练效率。

- 音频编码器

音频编码器增强了大规模多模态模型(LMMs)处理和解释听觉输入的能力,扩展了其多模态范围。SpeechGPT [364] 将大规模语音数据集与卷积和变换器架构 [377] 结合,实现了强大的指令跟随能力。AudioPaLM [363] 结合了文本和语音处理,使用通用语音模型(USM)编码器 [378],在零样本语言翻译等任务中表现出色。

WavCaps [379] 使用 CNN14 [380] 和 HTSAT [381] 来缓解音频-语言数据的稀缺问题,利用先进的大语言模型改进数据集质量和增强学习效果,突显了音频模态在多模态系统中的关键作用。

- 其他编码器

除了视觉和音频,其他模态的编码器,如3D理解和多模态融合,也是全面的大规模多模态模型(LMMs)的重要组成部分。NEXT-GPT [368] 促进了文本、图像、视频和音频之间的跨模态内容生成,通过最小的参数调整推进了类人AI能力的发展。

ImageBind-LLM [366] 对齐了视觉和语言嵌入,以提高跨模态的指令跟随能力。LL3DA [370] 处理点云数据,用于3D推理和规划,引入了新的空间理解方法。X-LLM [343] 使用 Q-Former [52] 处理图像和视频输入,使用 C-Former [343] 处理语音,将音频特征压缩成词级别的嵌入,以提高多模态学习的效率。

7.2 领域适配

领域适应(DA)是优化大型语言模型(LLMs)以在特定领域内表现出色的关键后训练策略,确保其在目标应用中的有效性。基于迁移学习[382, 383]的原则,DA通过适应函数 F a d a p t F_{\mathrm{adapt}} Fadapt 将初始模型 M s o u r c e M_{\mathrm{source}} Msource 转换为领域特定模型 M t a r g e t M_{\mathrm{target}} Mtarget ,如图所示:

![]https://pica.zhimg.com/v2-0df84ae57edc9fa6ce0e8fa0ff85f70a_1440w.jpg)

这一过程使 M t a r g e t M_{\mathrm{target}} Mtarget 能够应对指定领域的独特需求和复杂性,从而优化其性能和相关性。通过提高LLMs在编程[384, 385]和数学推理[386]等领域的熟练度,DA不仅提升了领域特定能力,还提高了计算效率,缓解了通用模型在处理领域特定术语和推理范式时的局限性。此外,DA显著减少了从头开始训练领域特定模型通常所需的大量标注数据集和计算资源[387],使其成为后训练方法的核心。

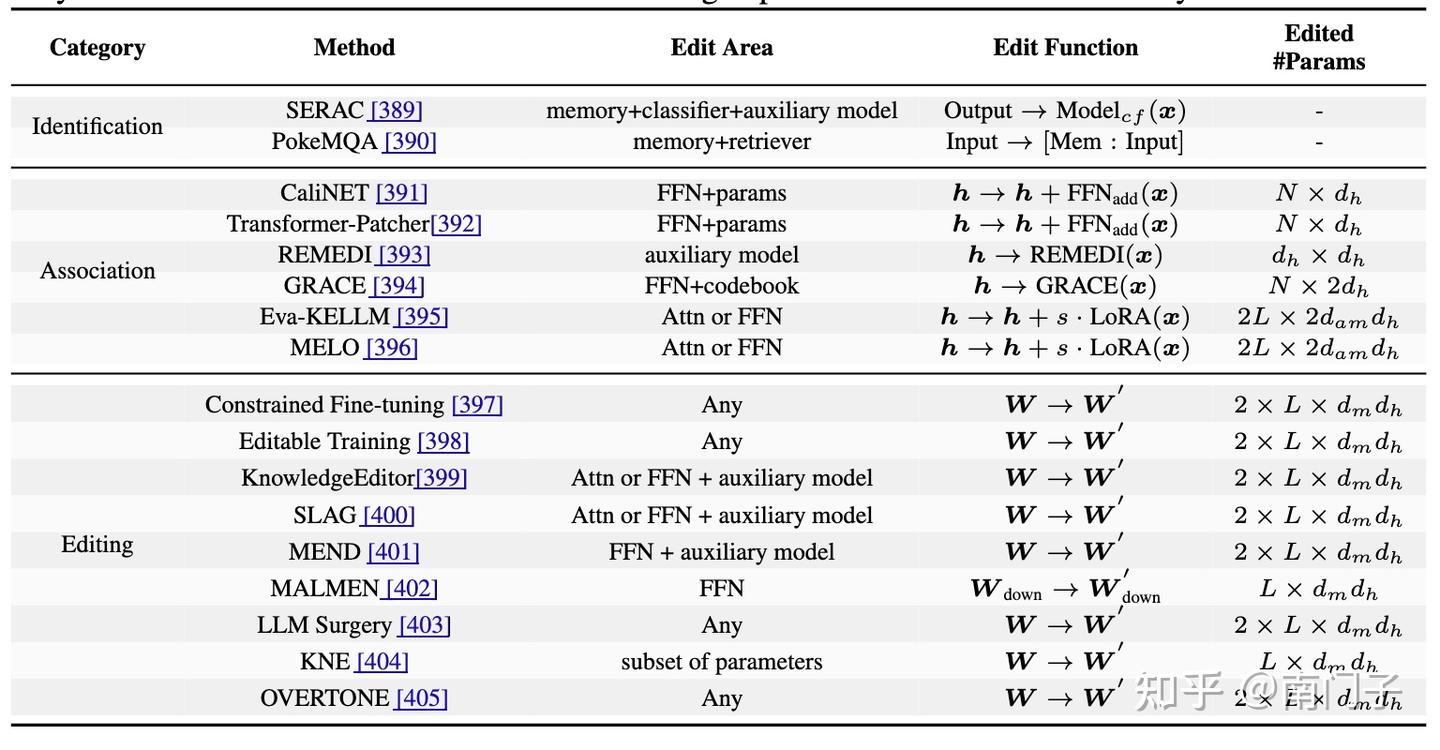

7.2.1 知识编辑

知识编辑代表了一种复杂的后训练方法,旨在修改大语言模型(LLMs)以满足特定领域的需求,同时不损害其基础能力。该技术促进了目标参数调整,保留了模型的现有性能,同时整合了新的或更新的领域知识[388]。通过实现对不断变化的知识景观的快速适应,知识编辑成为了后训练管道中不可或缺的组成部分。表8展示了主要方法的概述(例如,包括外部知识利用、集成和内在编辑)。

知识编辑的形式定义。考虑一个由 θ \theta θ 参数化的原始LLM,预先在数据集 D o l d \mathcal{D}_{\mathrm{old}} Dold 上训练。令 D n e w \mathcal{D}_{\mathrm{new}} Dnew表示包含新或更新的信息 Δ K \Delta K ΔK 的数据集。知识编辑的目标是通过应用调整 Δ θ \Delta\theta Δθ 来推导出修订后的参数集 θ ′ \theta^{\prime} θ′ ,有效地同化 Δ K \Delta K ΔK 同时最小化对 D o l d \mathcal{D}_{\mathrm{old}} Dold 的退化。正式地,这被表述为一个约束优化问题,其中更新后的参数定义为:

θ ′ = θ + Δ θ , w h e r e L ( θ ′ ; D n e w ) → min , \theta^{\prime}=\theta+\Delta\theta,\mathrm{where\;\mathcal{L}\left(\theta^{\prime};\mathcal{D}_{\mathrm{new}}\right)\;\rightarrow\;\operatorname*{min},} θ′=θ+Δθ,whereL(θ′;Dnew)→min,

其中 L \mathcal{L} L 表示评估模型在 D n e w {\mathcal{D}}_{\mathrm{new}} Dnew 上质量的损失函数(例如,交叉熵)。为了保护在原始数据集上的性能,施加了一个约束:

L ( θ ′ ; D o l d ) ≤ L ( θ ; D o l d ) + ϵ \mathcal{L}\big(\theta^{\prime};\mathcal{D}_{\mathrm{old}}\big)\ \leq\ \mathcal{L}\big(\theta;\mathcal{D}_{\mathrm{old}}\big)\ +\ \epsilon L(θ′;Dold) ≤ L(θ;Dold) + ϵ

其中 ϵ \epsilon ϵ 是一个小的正常数,限制在 D o l d \mathcal{D}_{\mathrm{old}} Dold 上的性能损失。这种公式确保了 θ ′ \theta^{\prime} θ′ 同化了 Δ K \Delta K ΔK 同时保留了模型的先前知识库。实际上, Δ θ \Delta\theta Δθ 可能被限制在特定的架构组件(例如,注意力层 (Attn) 或前馈网络 (FFN)),减少了计算开销并避免了全面重新训练,从而保留核心功能。

知识识别。知识编辑的初始阶段集中在检测并将新信息融入模型。PokeMQA [390] 使用可编程范围检测器和知识提示来解析查询,高效检索相关事实。相反,SERAC [389] 集成了反事实模型和分类器来确定新知识源的适用性,提供了一种最小侵入的方法,无需广泛的结构修改即可保留基础模型的完整性。[406] 分析了为什么LLM知识更新会创建混乱的连锁反应。现实世界中的编辑通常源自新兴事件,这些事件涵盖了新事实与过去事实之间的逻辑联系。基于这一观察,EvEdit [407] 提出了一种基于事件的知识编辑方法,用于确定知识锚点和知识更新边界。

知识关联。在识别之后,这一阶段将新获取的信息与模型现有的知识框架关联起来。Transformer-Patcher [392] 适应变压器架构以整合更新的事实,而CaliNET [391] 重新校准参数以与事实内容对齐。诸如Eva-KELLM [395]、MELO [396] 和REMEDI [393] 等方法精炼特定行为以进行精确更新,GRACE [394] 在知识插入后增强预测准确性,确保与先前表示的无缝集成。

内在知识编辑。最后阶段将关联的事实嵌入模型的内部结构,确保全面同化。虽然传统的微调可能资源密集,但先进的技术减轻了这一负担。约束微调 [397] 和元学习 [399] 最小化了知识损失和过拟合风险。可编辑训练 [398] 和知识编辑器 [399] 能够迅速调整参数,同时最小化性能影响,而SLAG [400]、MEND [401] 和MALMEN [402] 解决编辑冲突并支持大规模更新,同时保持基础能力并纳入新的领域见解。

LLM Surgery [403] 通过应用逆梯度移除过时数据、梯度下降整合新事实,并引入KL散度项以保留现有知识,实现了显著的计算效率。KNE [404] 引入了一种知识神经元集合方法,该方法仅定位和更新与新插入事实强烈相关的神经元,实现更准确的编辑同时保留无关知识。OVERTONE [405] 通过引入一种逐词平滑技术解决知识编辑中的异构词过拟合问题,自适应地细化训练目标,从而保留预训练知识并提高模型对新插入事实的推理能力。这些有针对性的技术确保了模型在整合新获取信息的同时保留其基础能力。

7.2.2 检索增强生成

检索增强生成(Retrieval-Augmented Generation, RAG)将传统信息检索与现代大语言模型(LLMs)结合,以提高生成输出的相关性和事实准确性[48, 408, 409]。通过动态地从外部源检索相关信息并将其嵌入生成过程,RAG解决了LLMs在特定领域知识上的不足,并减少了生成幻觉内容的倾向。

这种方法在需要精确、最新信息的领域特别有效,例如问答系统[48]、科学研究[410]和医疗保健[411],这些领域能够处理复杂的查询和知识密集型任务。此外,RAG减少了对话系统中误导性响应的频率,提高了基于知识的自然语言生成的保真度[411, 412]。

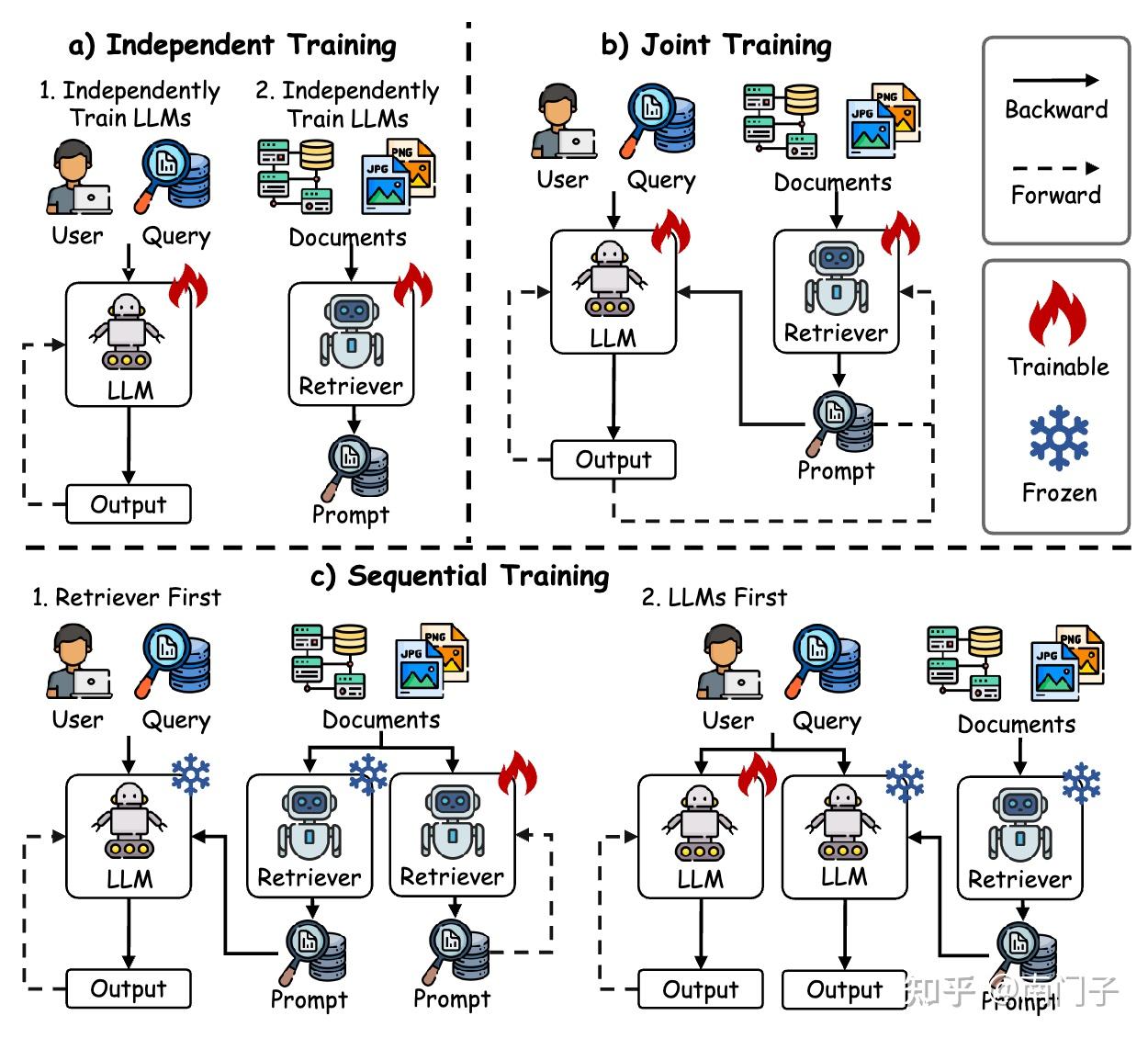

本小节重点介绍基于训练的RAG方法[413],认识到无训练的RAG方法[414, 415, 416]可能因缺乏任务特定优化而影响知识利用效率。三种主要的训练策略——独立训练(Independent Training)、顺序训练(Sequential Training)和联合训练(Joint Training)——增强了模型的适应性和集成能力,如图20所示。

- 独立训练

该策略将检索器和生成器作为独立模块进行训练,使根据任务需求灵活使用稀疏或密集检索器成为可能。例如,DPR[417]使用双BERT网络分别对查询和段落进行编码,通过对比学习优化检索,而不涉及生成器的交互。同样,[418]提出了Reward-RAG,利用奖励模型根据GPT反馈仅微调检索器,而不改变生成器。

- 顺序训练

顺序训练通过一次优化一个模块来提高效率,促进检索器和生成器之间的协同作用。它包括检索器优先方法[419, 420, 421, 422, 423],

如RETRO[424],它首先预训练一个基于BERT的检索器,然后训练一个编码器-解码器以无缝集成检索到的内容,从而提高性能。另一种方法是语言模型优先方法[425, 426, 427],如RA-DIT[428],首先微调语言模型以有效利用检索到的知识,然后再优化检索器以实现更好的对齐和连贯性[419, 425]。

- 联合训练

联合训练在一个端到端框架中同步优化检索器和生成器。RAG[48]通过最小化负对数似然来共同训练这两个组件,而REALM[429]则通过最大内积搜索(MIPS)[430]提高检索精度。这些方法适应特定任务的需求,最大化外部知识的好处,同时最小化生成错误。

7.3 模型合并

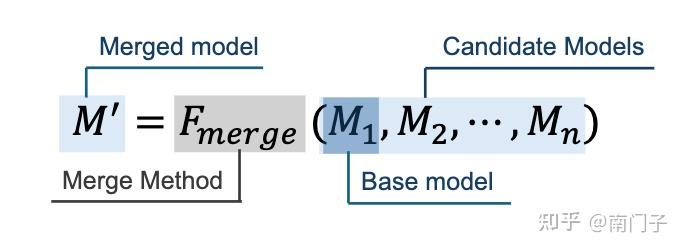

模型合并已成为提高大语言模型(LLM)在训练和推理阶段性能和效率的重要后训练策略[431, 432]。这种方法将专门化的模型整合到一个统一的架构中,避免了大量重新训练的需求,并解决了大型模型尺寸和计算需求带来的挑战。与在混合数据集上进行训练不同,模型合并将单任务模型整合为一个多任务能力的协调实体,提供了一种资源高效的多任务学习范式。通过简化训练管道并促进在各种应用中具有强大泛化能力的多功能模型的开发,该技术优化了LLM在不同场景中的部署。

给定一组候选模型 M ˉ = M 1 , M 2 , . . . , M n \bar{M}={M_{1},M_{2},.\,.\,.\,,M_{n}} Mˉ=M1,M2,...,Mn ,目标是设计一个合并函数 F m e r g e F_{\mathrm{merge}} Fmerge ,生成一个统一模型 M ′ M^{\prime} M′ ,可能以基础模型 M 1 M_{1} M1 为锚点,如图所示:

7.3.1 分层模型合并

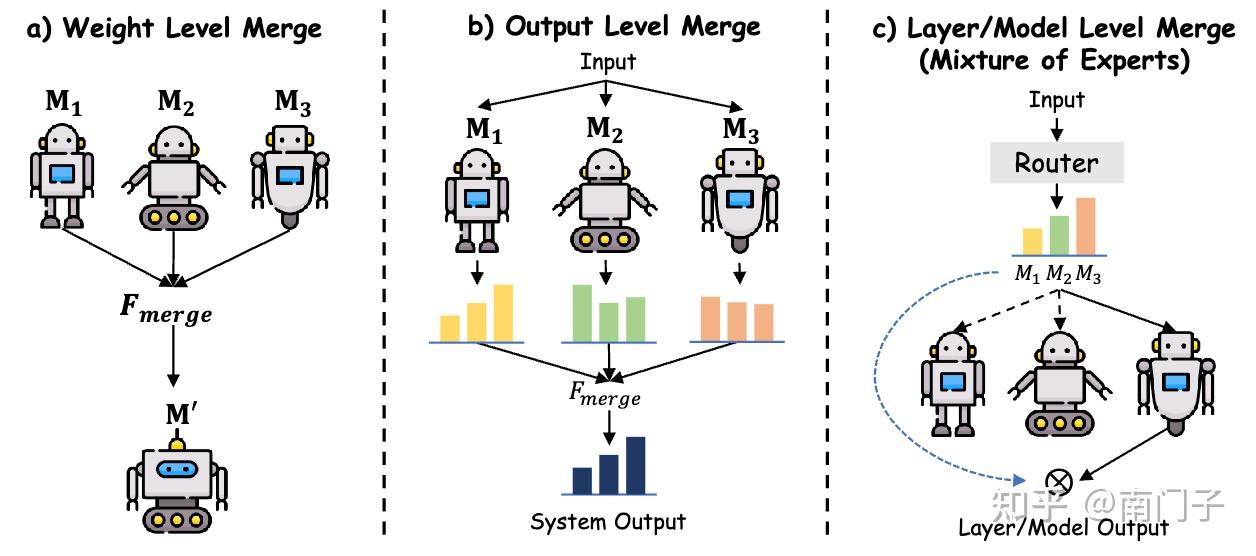

模型融合技术被系统地划分为三个层次——权重级、输出级和模型级融合——如图21所示。

- 权重级模型融合

权重级融合直接操作参数空间,对于具有相似架构或在相关任务上训练的模型特别有效。形式上,给定参数集 θ 1 , θ 2 , … , θ n ∈ R d \theta_{1},\theta_{2},\ldots,\theta_{n}\in\mathbb{R}^{d} θ1,θ2,…,θn∈Rd ,线性融合方案将这些参数集聚合为统一的集合 θ ′ \theta^{\prime} θ′ ,表示为:

θ ′ = α 1 θ 1 + α 2 θ 2 + . . . + α n θ n , s u b j e c t t o α k ≥ 0 , ∑ k = 1 n α k = 1. \theta^{\prime}\;=\;\alpha_{1}\,\theta_{1}\;+\;\alpha_{2}\,\theta_{2}\;+\;.\;.\;.\;+\;\alpha_{n}\,\theta_{n},\;\;\;\;{\mathrm{subject}}\;{\mathrm{to}}\;\;\;\;\alpha_{k}\;\geq\;0,\;\sum_{k=1}^{n}\alpha_{k}\;=\;1. θ′=α1θ1+α2θ2+...+αnθn,subjecttoαk≥0,k=1∑nαk=1.

Model Soup [433, 434] 通过线性组合在不同任务上微调的模型权重,生成一个单一且高效的模型,体现了这一点。Task Arithmetic (TA) [435] 通过参数的算术运算扩展了这种灵活性,提高了性能适应性。为了缓解对齐问题,TIESmerging [436] 确保参数的一致性,而 DARE [437] 通过概率调整参数增量来最小化干扰,优化融合过程的连贯性和效率。

- 输出级模型融合

当模型在架构或初始化上存在差异,使得权重级方法不切实际时,输出级融合变得有利。这种方法聚合输出分布而非内部参数,表示为:

y ′ = α y 1 + ( 1 − α ) y 2 , α ∈ [ 0 , 1 ] y^{\prime}\;=\;\alpha\,y_{1}\;+\;\left(1-\alpha\right)y_{2},\quad\alpha\in[0,1] y′=αy1+(1−α)y2,α∈[0,1]

其中 y 1 y_{1} y1 和 y 2 y_{2} y2 分别代表来自模型 M 1 M_{1} M1 和 M 2 M_{2} M2 的概率分布。类似于集成策略,此方法将模型预测综合为统一输出。LLMBlender [438] 通过生成独立输出并使用排名和生成过程进行融合来实现这一点,而 FuseLLM [439] 将组合输出概率蒸馏到单个网络中以保持分布的保真度。FuseChat [440] 通过将多个大型语言模型的知识转移到一个整合的目标模型中,结合了权重级和输出级融合,增强了跨模型的协同效应。

- 模型级模型融合

模型级融合通过路由机制整合子模型或层,通常在混合专家(MoE)框架内实现,表示为:

M ′ = M e r g e ( M 1 , M 2 ) M^{\prime}\;=\;\mathrm{Merge}\big(M_{1},\,M_{2}\big) M′=Merge(M1,M2)

其中 Merge 表示硬路由或软路由函数。Switch Transformer [54] 通过离散门控选择性激活专家层,减少了计算负载,但可能因刚性路由而导致性能折衷。SoftMoE [441] 和 SMEAR [442] 利用连续门控促进专家之间的平滑过渡,增强组件集成和模型一致性。

7.3.2 预合并方法

预合并方法通过优化独立模型的权重空间、架构一致性及参数对齐,为模型合并建立兼容基础,从而减少后续融合阶段中的冲突和干扰。这些技术提高了合并过程的有效性,确保最终统一的模型保留其组成部分的优势,同时减轻潜在的性能下降。

线性化微调。这种方法在预训练模型的切线空间内精炼模型,避免使用原始的非线性参数空间以实现权重解耦,从而减少合并过程中的干扰。例如,部分适配器的线性化(如TAFT [443])或注意力层 [444] 将权重更新对齐到不相交的输入区域,保持合并模型中的独立功能 [445]。通过将更新限制在线性框架内,该方法促进了不同模型之间的无缝集成。

架构转换。这种策略将具有不同架构的异构模型转换为适合直接参数合并的同质形式。方法包括知识蒸馏,如FuseChat [440] 所示,以及身份层插入,如CLAFusion [446]。GAN Cocktail [447] 初始化目标模型以吸收来自不同架构的输出,实现有效桥接结构差异的统一合并过程。

权重对齐。此方法通过置换将模型对齐到共享的权重盆地,利用线性模式连通性(LMC)属性增强兼容性。技术包括最优传输(OTFusion [448])、启发式匹配(Git re-basin [449])和基于学习的对齐(DeepAlign [450])。REPAIR [451] 减轻了缺乏归一化层的模型中的对齐失败,确保在融合前实现稳健的参数收敛。

7.3.3 合并中方法

在合并过程中,动态优化参数融合策略的方法旨在解决任务冲突,减轻干扰,并提升合并后模型的性能和泛化能力。这些方法应对实时整合不同模型的挑战,增强统一架构的适应性和鲁棒性。

- 基本合并

该方法利用简单的参数平均或任务向量算术,定义任务向量 τ t \tau_{t} τt 为第 t t t 个任务微调后的参数 Θ ˉ ( t ) \bar{\Theta}^{(t)} Θˉ(t) 与初始预训练参数 Θ ( 0 ) \Theta^{(0)} Θ(0) 之间的偏差:

τ t = Θ ( t ) − Θ ( 0 ) \tau_{t}=\Theta^{(t)}-\Theta^{(0)} τt=Θ(t)−Θ(0)

并通过以下公式促进多任务学习:

Θ ( m e r g e ) = Θ ( 0 ) + λ ∑ t = 1 T τ t \Theta^{(\mathrm{merge})}=\Theta^{(0)}+\lambda\sum_{t=1}^{T}\tau_{t} Θ(merge)=Θ(0)+λt=1∑Tτt

虽然计算效率高且概念简洁,但这种方法通常会遇到未缓解的参数交互导致的任务干扰,限制了其在需要复杂任务协调场景中的实用性。

- 加权合并

该策略根据各个模型的重要性动态分配合并系数,调整贡献以优化融合结果。MetaGPT [452] 通过归一化每个任务向量的平方 L2 范数来计算最优权重:

λ t ∗ = ∥ τ t ∥ 2 ∑ k = 1 T ∥ τ k ∥ 2 \lambda_{t}^{*}=\frac{\Vert\tau_{t}\Vert^{2}}{\sum_{k=1}^{T}\Vert\tau_{k}\Vert^{2}} λt∗=∑k=1T∥τk∥2∥τt∥2

从而赋予具有较大参数变化的任务更大的影响,如较高的 ∥ τ t ∥ 2 \lVert\tau_{t}\rVert^{2} ∥τt∥2 所示。SLERP [432] 使用球面插值确保平滑的参数过渡,保持模型连续性,而 Layer-wise AdaMerging [453] 通过逐层优化系数来改进这一过程,提高合并架构中任务特定的精度。

- 子空间合并

该方法将模型参数投影到稀疏子空间,以最小化干扰并保持计算效率,解决参数贡献的重叠问题。TIESMerging [436] 保留按大小排序的前 20% 的参数,解决符号冲突以保持一致性,DARE [437] 缩放稀疏权重以减少冗余,而 Concrete [454] 利用双层优化创建自适应掩码,确保任务间干扰减少的模型组件细致集成。

- 基于路由的合并

该技术根据输入特定属性动态融合模型,实现上下文响应的集成过程。SMEAR [442] 计算样本依赖的专家权重以优先考虑相关特征,Weight-Ensembling MoE [455] 采用输入驱动的线性层路由进行选择性激活,而 Twin-Merging [456] 融合任务共享和任务私有知识,构建一个灵活的合并框架,适应多样化的输入需求并增强多任务鲁棒性。

- 后校准

该技术通过将统一模型的隐藏表示与独立组成部分的隐藏表示对齐,纠正合并后的表示偏差,减轻性能下降。Representation Surgery [319] 通过改进表示一致性,增强了合并模型的鲁棒性和准确性。

八、数据集

训练后技术精心设计以优化大语言模型(LLM)对特定领域或任务的适应性,利用数据集作为这一优化过程的基石。对先前研究[457, 82]的深入审查表明,数据的质量、多样性和相关性深刻影响模型的有效性,通常决定着训练后工作的成败。为了阐明数据集在这一背景下的关键作用,我们对用于训练后阶段的数据集进行了全面回顾和深入分析,并根据其收集方法将其归类为三种主要类型:人工标注数据、蒸馏数据和合成数据。

这些类别反映了不同的数据管理策略,模型可以采用单一方法或结合多种类型的混合方法,以平衡可扩展性、成本和性能。表9提供了这些数据集类型的详细概述,包括它们的来源、大小、语言、任务和训练后阶段(例如SFT和RLHF),我们在后续部分中探讨了它们在提升LLM能力方面的贡献和挑战。

8.1 人工标注的数据集

人类标注的数据集以其卓越的准确性和上下文保真度而著称,这些属性源自标注者的任务复杂性的细致理解及其能够做出精确、上下文敏感的调整的能力。这些数据集是优化指令微调的基础,通过提供高质量、专家策划的训练信号,显著提升了大型语言模型在多种任务中的性能。在这个类别中,Flan [17]、P3(公共提示池)[459]、Sup-Natinst(超级自然指令)[462] 和 Dolly-15K [468] 等突出资源被广泛应用于大型语言模型的后训练阶段,每个资源都通过人类专业知识为模型能力的优化贡献了独特的优势。

用于 SFT 的人类标注数据

在 SFT 阶段,人类标注的数据集发挥着不可或缺的作用,这一点从 Flan、Sup-Natinst 和 Dolly-15K 的贡献中得到了体现,这些数据集提供了精心设计的提示-响应对和任务特定的指令,以提升大型语言模型在各种自然语言处理基准测试中的效能。

- Flan. Flan 数据集 [17] 是一个基础资源,最初涵盖了 62 个广受认可的自然语言处理基准测试——如 HellaSwag [482]、MRPC [483] 和 ANLI [484]——通过其 180 万个示例促进英语中的稳健多任务学习。最近,FlanV2 [34] 作为其前身的高级迭代版本,通过整合 Flan [17]、P3 [459]、Sup-Natinst [462] 和大量其他数据集,形成了一个综合全面的语料库,从而增强了其在多样化语言和任务领域中的 SFT 实用性。

- Sup-Natinst. 超级自然指令(Sup-Natinst)[462] 提供了涵盖 55 种语言的 76 种任务类型的广泛多样资源,成为多语言大型语言模型后训练的多功能资源。每种任务都精心配有一个包含明确任务定义的指令——概述了从输入文本到期望输出的映射关系——以及一组示例,展示了正确和错误的响应,为指导模型进行精确的任务执行并增强跨语言适应性提供了强大的框架。

- Dolly-15K. 由 Databricks 员工开发的 Dolly-15K [468] 是一个精选的包含 15,000 个高质量、人类生成的提示-响应对的语料库,专门设计用于大型语言模型的指令微调。该数据集涵盖了广泛的主题和场景——包括头脑风暴、内容生成、信息提取、开放式问答和总结——反映了丰富的任务类型多样性,使模型能够灵活适应各种教学情境,并提高上下文相关性。

人类标注数据集在 SFT 中的强大作用源于其对任务和场景的广泛覆盖,这一特点在上述语料库中得到了充分体现。此外,Open Assistant [466] 提供了一个来自全球众包努力的多语言对话语料库,免费用于推进研究,而 OpenOrca [472] 在 FlanV2 [34] 的基础上增加了数百万个 GPT-3.5 和 GPT-4 的完成结果,构成了一个动态扩展的资源,用于微调和任务对齐。然而,尽管它们对模型泛化做出了重要贡献,确保一致的标注质量和多样性仍然是一个挑战,需要严格的质量控制以最大化其影响。

用于 RLHF 的人类标注数据

对于 RLHF,人类标注的数据集如 P3、其多语言扩展 xP3 [463] 和 SHP [460] 提供了关键的人类标注评估,优化了大型语言模型与用户偏好的对齐,提供了奖励建模的细致反馈机制。

- P3: P3 数据集 [459] 是一个精心策划的指令调优资源,汇集了来自 Hugging Face Hub 的 2300 万个多任务提示,每个提示都配有手动编写的指令,涵盖了多样化的自然语言处理任务,为 RLHF 提供了丰富的基础,以增强大型语言模型在不同应用中的适应性和精确性。

- xP3:xP3(跨语言公共提示池)[463] 将 P3 扩展到多语言框架中,涵盖了 46 种语言和 16 个自然语言处理任务的提示和监督数据,旨在支持像 BLOOMZ 和 mT0 这样的模型的多任务提示微调。其内容整合了英语 P3 数据集、四个新的英语任务(如翻译、程序合成)和 30 个多语言自然语言处理数据集,为跨语言 RLHF 优化提供了全面的资源。

- SHP:SHP [460] 包含了 349,000 个人类偏好注释,涉及 18 个主题领域的提问和指令的响应评估,用于训练 RLHF 奖励模型并评估自然语言生成(NLG)的质量,其独特之处在于完全依赖于人类编写的注释,使其区别于 HH-RLHF 等混合数据集。

这些数据集通过提供多样化的、人类标注的评估,增强了 RLHF,精炼了模型与用户偏好的对齐。OpenAI 总结 [458] 和 WebGPT [461] 提供了结构化的、基于比较的反馈和李克特量表评分,有助于更紧密地将模型输出与人类期望对齐。HH-RLHF [104] 进一步强化了这一框架,包括了对有用性和无害性的评估,为旨在确保安全和道德响应的模型奠定了坚实的基础。

同时,StackExchange [473] 贡献了特定领域的用户生成内容,丰富了训练数据,特别有利于需要技术领域专业知识的模型。然而,这些数据集面临诸如可扩展性、人类标注中的潜在偏差以及在其特定领域之外的有限适用性等挑战。因此,尽管它们非常有价值,但可能需要补充更广泛的数据集,以实现跨多样化现实任务的全面模型对齐。

8.2 蒸馏数据集

蒸馏数据(distilled dataset)源自将庞大的原始数据集提炼成紧凑、优化的子集的复杂过程,这些子集保留了对大语言模型训练至关重要的信息,同时在保持性能的前提下提高了训练效率并减少了计算需求。

该方法生成的数据集通常在效能上能匹敌甚至超越未经过精炼的原始数据集,加速模型收敛并减少资源消耗,特别是在强化学习人类反馈(RLHF)阶段。关键示例包括 ShareGPT [469] 和 HC3(人类-ChatGPT 对比语料库)[467],这些数据集通过将真实世界互动和比较见解提炼成有效的训练信号,成为广泛采用的大语言模型微调资源。

- ShareGPT:ShareGPT [469] 作为一个动态数据收集平台,通过其 API 收集了约 90,000 次来自用户与 ChatGPT 或 GPT-4 的真实交互对话。该数据集包含了真实的人类指令和查询及其对应的 AI 回答,将自然对话模式浓缩成一个集中资源,使 RLHF 能够以高相关性和高质量改进大语言模型的对话流畅性和上下文响应能力。

- HC3: HC3 数据集 [467] 是专门设计用于对比 ChatGPT 生成的 AI 回答与人类撰写的答案,包含跨开放性话题、金融、医学、法律和心理学等领域的 161,000 个问题-回答对。这个精炼的语料库有助于分析回答特征和质量的差异,使研究人员能够在 RLHF 过程中提升大语言模型输出的真实性和领域特定准确性,同时突出人类与 AI 生成内容之间的区别。

8.3 合成数据集

合成数据(Synthetic Datasets)在大型语言模型(LLM)后训练的SFT阶段中构成了一种变革性的资产,通过AI模型生成,提供成本效益高、可扩展且保护隐私的人类标注数据集替代方案。通过自动化创建指令-响应对和对话,合成数据能够生成广泛的训练语料库,增强模型的适应性,Self-Instruct-52K [86]、Vicuna [465] 和Baize [478] 是广泛用于提升LLM指令跟随和对话生成能力的主要示例。

基于自我指令方法的数据集

使用自我指令方法的合成数据集从少量手工制作的种子示例开始,利用LLM生成大量指令跟随数据,增强模型对多样化指令的响应能力,例如Self-Instruct-52K、Alpaca和Magpie系列,这些数据集共同通过可扩展的自动化推进指令调优。

- Self-Instruct-52K: Self-Instruct-52K [86] 为指令跟随模型建立了基础基准,使用多种提示模板从手工制作的种子生成52,000个示例,指导LLM,从而提高其解释和执行特定任务指令的精确性和一致性。

- Alpaca: Alpaca [464] 和Alpaca-GPT4 [18] 分别使用GPT-3和GPT-4将初始175个种子对扩展为52,000个高质量的指令-响应对,提高指令跟随能力,而InstInWild [477] 将这种方法应用于多语言环境,生成英语和中文数据集,以增强跨语言适应性。

- Magpie 数据集: Magpie数据集 [481] 利用对齐的LLM从预定义的模板生成指令-响应对,产生专门的系列,如Magpie Reasoning V2(强调链式思维推理)、Magpie Llama-3和Qwen-2系列(针对流行模型定制)、Magpie Gemma-2(适用于Gemma架构)以及结合偏好优化信号的变体如Magpie-Air-DPO,这些数据集共同增强了SFT和指令调优在对话和推理任务中的应用。

除了这些数据集之外,如Unnatural Instructions [97](240,000个示例)、Evol-Instruct [470](通过迭代复杂度增强生成70,000至143,000个改进条目)和Belle [471](从ChatGPT生成500,000至1,100,000个中文对话)显著扩大了指令生成规模,尽管在质量保证、复杂度校准和偏见缓解方面仍存在挑战,需要持续改进以确保在复杂应用中的可靠性。

基于自我对话方法的数据集

自我对话数据集采用一种技术,使模型内部或与同伴模拟多轮对话,增强对话生成能力并解决现有语料库的不足,Baize、UltraChat和OpenHermes通过自动交互策略展示了这一方法。

- Baize: Baize [478] 利用ChatGPT的自我对话技术生成653,000个多轮对话,整合来自Quora、Stack Overflow和Alpaca的种子数据,丰富指令跟随质量,从而优化LLM的对话连贯性和任务遵循性,用于SFT。

- UltraChat: UltraChat [476] 使用多个ChatGPT API生成超过1200万条高质量的对话记录,涵盖各种主题,克服了多轮数据集中常见的低质量和不准确注释问题,为对话增强提供了强大的SFT资源。

- OpenHermes: OpenHermes由Teknium开发,包括OpenHermes-1 [474](243,000条记录)及其扩展后续版本OpenHermes-2.5 [475](100万条记录),提供高质量的SFT数据集,增加了数量和多样性,涵盖广泛的主题和任务类型,增强对话和指令跟随能力。

这些自我对话数据集使模型通过自我互动构建多轮对话,如Baize使用具有多样种子的ChatGPT和UltraChat通过API驱动的广泛对话,显著提高了对话质量和填补了训练数据可用性的关键空白。

基于真实用户交互的数据集

基于真实用户交互的数据集利用与LLM的真实对话交流,捕捉多样且真实的输入,增强模型处理现实场景的能力,Vicuna、WildChat和GenQA是这一方法的关键示例。

- Vicuna: Vicuna [465] 在ShareGPT的公共API上约70,000次用户共享的对话上进行微调,通过将HTML转换为Markdown、过滤低质量样本和分割长对话以适应模型上下文长度,确保高质量的SFT数据,用于现实交互建模。

- WildChat: WildChat [479] 包含100万次真实世界用户与ChatGPT的多语言和多种提示类型的交互,包括独特的交换如模糊请求和代码切换,既作为SFT资源又作为分析用户行为的工具。

- GenQA: GenQA [480] 提供一个超过1000万个清理和过滤的指令样本的庞大SFT数据集,完全由LLM生成,无需人工输入或复杂管道,补充现有语料库,通过快速生成合成数据来解决覆盖缺口。

合成数据在成本、可扩展性和隐私方面的优势受到与人类标注数据相比深度和真实性潜在不足的限制,存在偏差传播和过度简化的风险。依赖AI生成的内容可能延续模型固有的错误,强调了整合合成数据和人类生成数据以增强LLM鲁棒性和在不同情境下适用性的必要性。

九、应用

尽管预训练赋予了大型语言模型(LLMs)强大的基础能力,但在特定领域部署时,这些模型仍经常面临持续的限制,包括上下文长度受限、倾向产生幻觉、推理能力欠佳以及固有的偏见。这些不足在实际应用中显得尤为重要,因为精确性、可靠性和伦理一致性是至关重要的。这些挑战引发了根本性的疑问:

- (1)如何系统地提升 LLM 的性能以满足特定领域的需求?

- (2)哪些策略可以有效缓解应用环境中固有的实际障碍?

后训练作为关键解决方案,通过优化 LLM 对特定领域术语和推理模式的识别,增强其适应性,同时保留其广泛的综合能力。本章阐述了后训练 LLM 在专业、技术和互动领域的变革性应用,阐明了定制化后训练方法如何应对这些挑战并提升模型在不同背景下的实用性。

9.1 专业领域

法律助理

法律领域是利用后训练赋予大语言模型(LLMs)专门知识的一个引人注目的领域,使它们能够驾驭复杂的法律知识并应对法学中固有的多方面挑战。越来越多的研究[485, 486, 487]探讨了这一领域中LLMs的应用,涵盖了法律问答[488, 489]、判决预测[490, 491]、文档摘要[492, 493]以及检索增强和司法推理等更广泛的任务[494, 495, 496]。

以LawGPT[497]和Lawyer-LLaMA[498]为代表的后训练法律助手展示了显著的熟练度,不仅在各种法律事务中提供可靠的指导,还在专业资格考试中取得成功,这证明了其先进的解释和分析能力。多语言支持,如LexiLaw[499]和SAUL[500]等模型,扩展了这种实用性的语言范围,包括英语和中文,从而扩大了可访问性。这些进展的核心是在精选的法律语料库上进行后训练,例如ChatLaw[501],它将广泛的法律文本整合到对话数据集中,使模型能够精炼其推理能力和术语识别能力。

医疗保健和医学

后训练显著提升了LLMs在医疗保健和医学应用中的性能,通过特定领域的数据精确地满足临床和学术需求。在临床环境中,LLMs促进了药物发现[502]、药物协同预测[503]和催化剂设计[504]、诊断支持、病历生成和患者互动等任务;在学术界,它们在医疗报告合成[505]和问答[506]中表现出色,这得益于定制后训练带来的性能提升。

例如,基于50万条医疗咨询记录训练的ChatMed[507]展示了增强的诊断和咨询服务准确性;而PULSE[508]则通过400万条涵盖中文医疗和通用领域的指令进行了微调,展示了卓越的多任务能力。这些模型通过利用后训练适应嵌入细致的医学知识,超越了通用模型的表现,突显了定制数据集在实现实际效用中的不可或缺性。

这些进展不仅提高了特定任务的结果,还为将LLMs集成到医疗工作流程中铺平了道路,在这些工作中,精度和上下文相关性是不可妥协的,突显了后训练对现实世界医疗应用的变革影响。

金融和经济学

在金融和经济学领域,LLMs在情感分析[509]、信息提取[510]和问答[511]等任务中展现出巨大的潜力,后训练通过特定领域的改进增强了其有效性。尽管通用LLMs提供了坚实的基础,但像FinGPT[512]和DISC-FinLLM[513]这样的专用模型在经过金融语料库的后训练后表现出显著的改进,擅长需要细致理解市场动态和术语的任务。同样,XuanYuan[514]利用广泛的金融数据集和先进的后训练技术,提高了经济建模和预测的准确性,超过了未调优的基准。这些发展展示了后训练在适应LLMs以满足金融应用复杂需求中的关键作用,其中精确解释定量数据和定性见解至关重要,确保模型提供可靠且符合行业标准和期望的领域信息输出。

移动代理

大型多模态模型(LMMs)的发展推动了一个新兴的代理研究领域,专注于基于LMM的图形用户界面(GUI)代理[515]。该领域旨在开发能够在多种GUI环境中执行任务的AI助手,涵盖网络界面[516, 517, 518, 519, 520]、个人计算平台[521, 522, 523, 524, 525]和移动设备[526, 527, 528, 529, 530]。

在移动环境中,一个研究方向通过工具集成[526]和额外的探索阶段[527, 528]来增强单个代理的感知和推理能力。最近的进展通过使用多代理系统进行决策和反思[531, 529],显示出巨大的潜力,从而提高了任务效率。特别是,Mobile Agent-E[532]引入了代理之间的分层结构,促进了稳健的长期规划,并提高了低级动作的精度。这些发展突显了多模态后训练策略在培养适应性强、高效的复杂移动环境代理中的变革作用。

9.2 技术和逻辑推理

数学推理

大语言模型(LLM)在数学推理方面展现出显著潜力,涵盖代数操作、微积分和统计分析。通过后训练,这些模型能够弥合计算能力和人类水平之间的差距。GPT-4 [9] 在标准化数学测试中取得了高分,这归功于其多样化的预训练语料库,但后训练进一步提升了这一能力。

例如,Deep Seek Math [64] 利用专门的数学数据集和技术,如监督微调(Supervised Fine-Tuning, SFT)和组相对策略优化(Group Relative Policy Optimization, GRPO)[64],以提高其推理精度,通过结构化的思维链(Chain of Thought, CoT)解决复杂问题。

OpenAI 的 o1 [41] 通过强化学习(Reinforcement Learning, RL)进一步推进了这一领域,逐步优化推理策略,以在多步骤推导和证明中实现卓越性能。这种通过后训练的持续改进不仅提高了准确性,还使 LLM 的输出与严格的数学逻辑对齐,使其成为教育和研究领域中不可或缺的工具,特别是在需要高级推理的场景中。

代码生成

后训练彻底改变了代码生成,使 LLM 能够在自动化编码、调试和文档生成方面表现出色,从而变革了软件开发工作流程。Codex [533] 基于庞大的多样化代码库进行训练,支持 GitHub Copilot * ,提供实时编码辅助,准确率极高。

专门的模型如 Code Llama [384] 进一步提升了这一能力,通过针对编程特定数据集的后训练,帮助开发者跨语言和框架进行开发。OpenAI 的 o1 [41] 将其数学推理能力扩展到代码生成,生成高质量且上下文感知的代码片段,与人类输出相当。当前的研究重点是增强个性化、深化上下文理解,并嵌入伦理保障措施,以减轻代码滥用等风险,确保 LLM 在技术领域内最大化生产力的同时,遵循负责任的开发原则。

9.3 理解和交互

推荐系统

大型语言模型(LLMs)作为变革者出现在推荐系统中,通过分析用户交互、产品描述和评论,以前所未有的细致程度提供个性化建议 [534, 535, 536]。后训练增强了它们整合情感分析的能力,使内容和情感细微差别的理解更加细腻,这一点在 GPT4 [9] 和专门系统如 LLaRA [537] 和 AgentRec [538] 中得到了证明。

亚马逊和淘宝等电子商务巨头利用这些能力处理评论情感、搜索查询和购买历史,优化客户偏好模型并高精度地预测兴趣 [535]。除了对项目进行排名,后训练的 LLM 还参与对话推荐、规划和内容生成,通过提供动态、上下文敏感的互动来适应不断变化的偏好,从而提升用户体验,这证明了后训练在连接数据分析与实际应用中的作用。

语音对话

后训练的 LLM 重新定义了语音处理,将识别、合成和翻译推进到自然度和准确性的新高度 [539]。这些模型处理诸如文本转语音 [540]、文本转音频生成 [541] 和语音识别 [542] 等任务,支持了亚马逊的 Alexa、苹果的 Siri 和阿里巴巴的天猫精灵等普遍工具。

Whisper [543] 以其高保真转录展示了这一进步,而 GPT-4o [78] 引入了实时语音交互,无缝融合多模态输入。未来的发展方向包括多语言翻译和个人化语音合成,其中后训练使 LLM 能够打破语言障碍并根据个人用户档案定制响应,增强全球背景下人机交互的可访问性和参与度。

视频理解

LLM 在视频理解领域的扩展标志着一个重要的前沿,后训练使像 Video-LLaMA [341] 这样的模型能够执行字幕生成、总结和内容分析,简化多媒体创作和理解。Sora [544] 进一步革新了这一领域,通过文本提示生成复杂视频,降低了技术门槛并促进了创新故事讲述,使内容生产更加民主化。

这些进展利用后训练使 LLM 适应视觉-时间数据,提高了其解释深度和在教育到娱乐等各种应用中的实用性。然而,它们也带来了计算可扩展性、隐私保护和伦理治理方面的挑战,尤其是在生成内容的滥用问题上。随着后训练方法的演变,解决这些问题将是确保视频相关应用可持续、负责任部署的关键,平衡创新与社会考虑。

十、开放问题和未来方向

在本节中,我们批判性地评估了大型语言模型(LLMs)后训练方法中存在的未解决挑战和未来的发展轨迹,将分析置于由OpenAI的o1 [41] 和DeepSeek-R1 [28] 的发布所带来的变革性进展的背景下。

这些模型通过大规模强化学习(RL)重新定义了推理基准,但它们的出现也加剧了对后训练技术中持续存在的限制进行解决的紧迫性。以下小节详细阐述了六个关键的开放问题,每个问题都突显了其对领域进展的重要性和迫切需要解决的问题,并提出了推动未来研究和确保LLM在各种应用中负责任发展的可行策略。

推理能力超越大规模RL

o1和DeepSeek-R1的引入标志着LLM推理能力的范式转变,利用了如RLHF和Group Relative Policy Optimization (GRPO)等广泛的RL框架,在多步问题解决(如数学证明和逻辑推导)中实现了前所未有的准确性。

然而,依赖二元奖励信号和大量人工反馈暴露了一个关键限制:它们无法在复杂的开放式任务中有效泛化,例如科学假设生成或动态环境中的战略决策。这一差距亟待解决,因为对LLM在现实世界情境中模拟人类推理的需求日益增长,其重要性在于解锁其作为自主智能代理的潜力,超越当前的基准。

当前的RL方法在奖励稀疏性和缺乏适应任务复杂性的能力方面存在困难,需要创新框架。可行的解决方案包括开发多目标RL系统,整合自监督一致性检查(例如,验证推理步骤之间的逻辑连贯性)和领域特定先验知识,如数学公理或科学原理,以在无需详尽的人工注释的情况下指导推理 [545, 546]。这些进展可以减少对昂贵反馈循环的依赖,增强可扩展性,并使LLM能够应对未知的推理领域,这一前景由DeepSeek-R1的冷启动RL创新得以实现。

下一代LLM的后训练可扩展性

随着LLM规模和复杂性的增加,以下一代模型的参数密集型架构为例,后训练的可扩展性成为了一个严峻而紧迫的挑战。基于RL的方法的资源密集性,如DeepSeek-R1的冷启动方法需要大量的计算基础设施,这限制了其对资金充足的实体的可访问性,并引发了显著的可持续性问题,特别是在多模态应用(如视频分析)和实时系统(如对话代理)中。

这个问题至关重要,因为它威胁到资源丰富和资源受限的研究社区之间的差距扩大,阻碍了LLM发展的公平进步。虽然参数高效微调(PEFT)[92] 减轻了一些开销,但其性能在大规模数据集上往往会下降,突显了对可扩展替代方案的需求。

可行的未来方向 [547, 548, 549] 包括设计轻量级RL算法——可能通过调整GRPO以减少内存占用——联邦后训练框架,将计算负载分布在去中心化的网络中,以及先进的蒸馏技术,保留推理和适应性的同时最小化资源需求。如果这些解决方案得以实现,将有助于民主化后训练,与领域内对可持续和包容性创新的迫切需求相一致。

基于RL的模型的伦理对齐和偏见缓解

通过RL进行后训练,如o1的谨慎对齐策略所展示的,放大了伦理风险,可能会强化嵌入在训练数据集(如HH-RLHF [104] 或合成语料库)中的偏见。鉴于LLM在敏感领域(如医疗诊断和司法决策)中的部署,这是一个极其紧迫的挑战。

伦理对齐的动态变化——在一种文化背景下被认为是公平的,在另一种文化背景下可能构成偏见——是实现普遍可信的LLM的重大障碍,这使得确保公平和安全的AI系统变得至关重要。当前的方法存在过度审查的风险,损害实用性(例如,抑制创造性输出),或纠正不足,延续有害的偏见(例如,种族或性别差异)。

解决这一问题需要开发公平意识的RL目标,纳入多利益相关者的偏好模型(例如,聚合多样化的人类判断)和对抗性去偏技术,以在训练过程中中和数据集偏见。这些方法的可行性 [550] 得到了最近解释工具和多目标优化进展的支持,能够在伦理稳健性和实际功能之间实现平衡,这是由o1在现实世界部署挑战中强调的必要性。

无缝多模态集成以实现整体推理

向多模态LLM的轨迹,预示着o1的推理增强和GPT-4o的综合能力 [78],突显了对后训练方法的迫切需求,这些方法能够无缝集成文本、图像、音频和其他数据类型,以实现整体推理——这对于实时视频分析、增强现实和跨模态科学研究等应用至关重要。

当前的方法在实现稳健的跨模态对齐方面失败,主要是由于数据异质性和全面多模态训练语料库的稀缺,限制了LLM在不同输入之间协同推理的能力。这一挑战的重要性在于其潜在的变革应用,但在没有可扩展框架的情况下,其解决仍然难以捉摸。DeepSeek-R1的冷启动RL提供了一个有希望的起点,表明统一的模态编码器(例如,能够将异构数据编码到共享的潜在空间中)和动态RL策略,能够自适应地加权模态贡献,可以弥合这一差距。

未来的研究应优先创建多模态基准和合成数据集,建立在Magpie [481] 等努力的基础上,以推动进展,鉴于最近在多模态预训练和RL优化方面的进展,这是一个可行的努力。

上下文适应的信任框架

后训练LLM的信任度越来越被视为一个动态的、上下文依赖的属性,而不是静态的质量,这一点在o1在教育等敏感领域谨慎的输出与其在创意任务中更自由的响应之间的对比中得到了证明。这种变异性——在安全要求(例如,避免教育设置中的错误信息)可能与实用需求(例如,促进写作中的创造力)冲突的情况下——是一个紧迫的挑战,鉴于其对用户信任和LLM在各种现实场景中适用性的关键重要性。

当前的后训练方法往往过于重视安全,导致实用性的折衷,从而降低实际价值,或者未能适应特定上下文的需求,削弱可靠性。解决这一问题需要上下文敏感的RL模型,能够动态调整安全与实用性的权衡,利用实时用户反馈和可解释的安全指标(例如,生成输出的透明度分数)来确保适应性。这种方法的可行性 [551] 得到了自适应学习系统和实时监控进展的支持,提供了一条在信任度与功能性之间取得平衡的路径,这是随着o1等LLM扩展到高风险应用而迫切需要的。

后训练创新的可访问性和民主化

先进后训练方法的计算强度,以DeepSeek-R1的RL驱动方法为代表,将其应用限制在资源丰富的实体中,成为一个阻碍可访问性的紧迫障碍,抑制了小型研究社区和行业部门内的创新(即,对于促进AI领域的公平进步而言,这是一个极其重要的问题)。这种排他性不仅限制了贡献的多样性,还阻碍了领域应对全球挑战的合作能力。

民主化这些创新需要开发高效的开源工具和框架,降低进入门槛而不牺牲质量,这一目标通过可扩展的PEFT适应RL [92]、协作平台共享后训练模型(例如,Hugging Face枢纽)和类似于Magpie [481]的简化合成数据生成管道得以实现。未来的工作应专注于优化这些解决方案,以实现广泛采用,确保后训练的变革潜力——由o1和DeepSeek-R1所体现——超越精英机构,丰富更广泛的AI生态系统。

创造性智能与系统2思维

将创造性智能融入系统2推理代表了LLM演进的一个新兴前沿,如 [552] 所强调的。尽管像OpenAI的o1和DeepSeek的R1这样的推理LLM在刻意、逐步的逻辑分析中表现出色——模仿系统2思维——它们在创造性智能方面的能力仍处于探索阶段,创造性智能涉及生成新想法、综合不同概念和灵活应对非结构化问题。

这一差距至关重要,因为创造性智能支撑了艺术创作、科学发现和战略创新等领域中的人类问题解决,这些领域中仅靠僵化的逻辑框架是不够的。这一挑战的紧迫性在于其潜力,可以将LLM从分析工具提升为自主创造代理,这是向通用人工智能(AGI)迈出的变革性一步。下面,我们概述了这一开放问题,并提出了未来的方向,借鉴了调查的见解。

十一、总结

本文首次全面综述了后训练语言模型(Post-training Language Models, PoLMs),系统地追溯了从2018年ChatGPT的对齐起源到2025年DeepSeek-R1的推理里程碑的轨迹,并肯定了它们在推理精度、领域适应性和伦理完整性方面的变革性影响。

我们评估了一系列广泛的技术(即微调(Fine-tuning)、对齐(Alignment)、推理(Reasoning)、效率(Efficiency)和集成与适应(Integration and Adaptation)),综合了这些技术在专业、技术和交互领域(从法律分析到多模态理解)的贡献。

我们的分析强调,PoLMs显著提升了大语言模型(LLMs)的能力,从最初的对齐创新演变为复杂的推理框架;然而,它也揭示了持续存在的挑战,包括偏见持续存在、计算可扩展性和情境变量的伦理对齐问题。这些发现被纳入一个新颖的分类体系中,强调了将推理进展与效率和伦理要求相结合的综合性方法的必要性。

我们得出结论,实现LLMs作为可靠、负责任工具在各种应用中的潜力,需要持续的跨学科合作、严格的方法论评估以及适应性和可扩展框架的开发。作为此类研究的开创性综述,本工作整合了近年来PoLMs的进步,奠定了坚实的知识基础,激励未来的研究培养能够灵活结合精度、伦理稳健性和多功能性的LLMs,以满足科学和社会背景不断变化的需求。

1390

1390

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?