金磊 发自 凹非寺

量子位 | 公众号 QbitAI

给大模型排名这事儿,现在有了新玩法——

任意输入一个Prompt,就能给大模型们实时排名,精准找到最适合做这个Prompt的大模型!

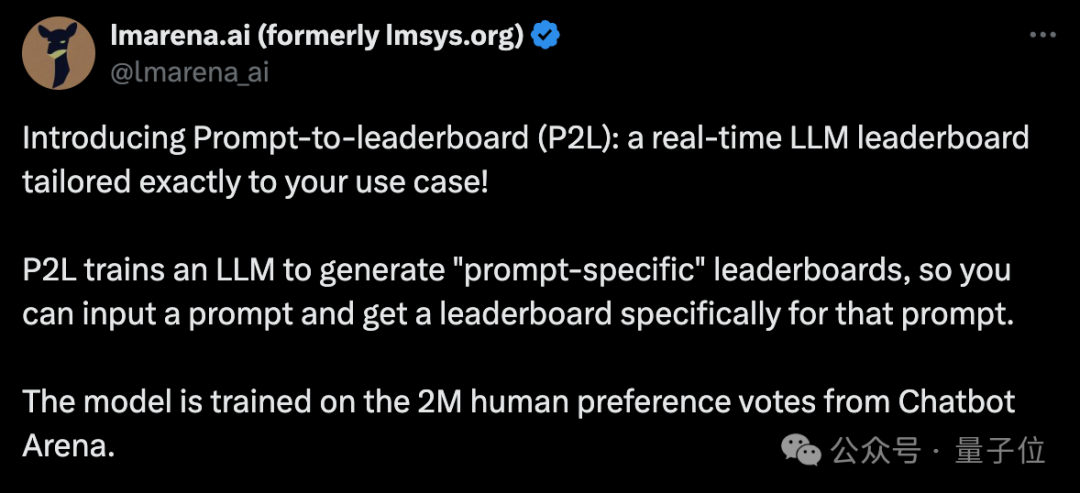

这就是竞技场(lmarena.ai)最新推出的排名方式,叫做Prompt-to-leaderboard(P2L)。

主打的就是找到最能直击你Prompt“灵魂”的那款大模型。

话不多说,我们来看下效果。

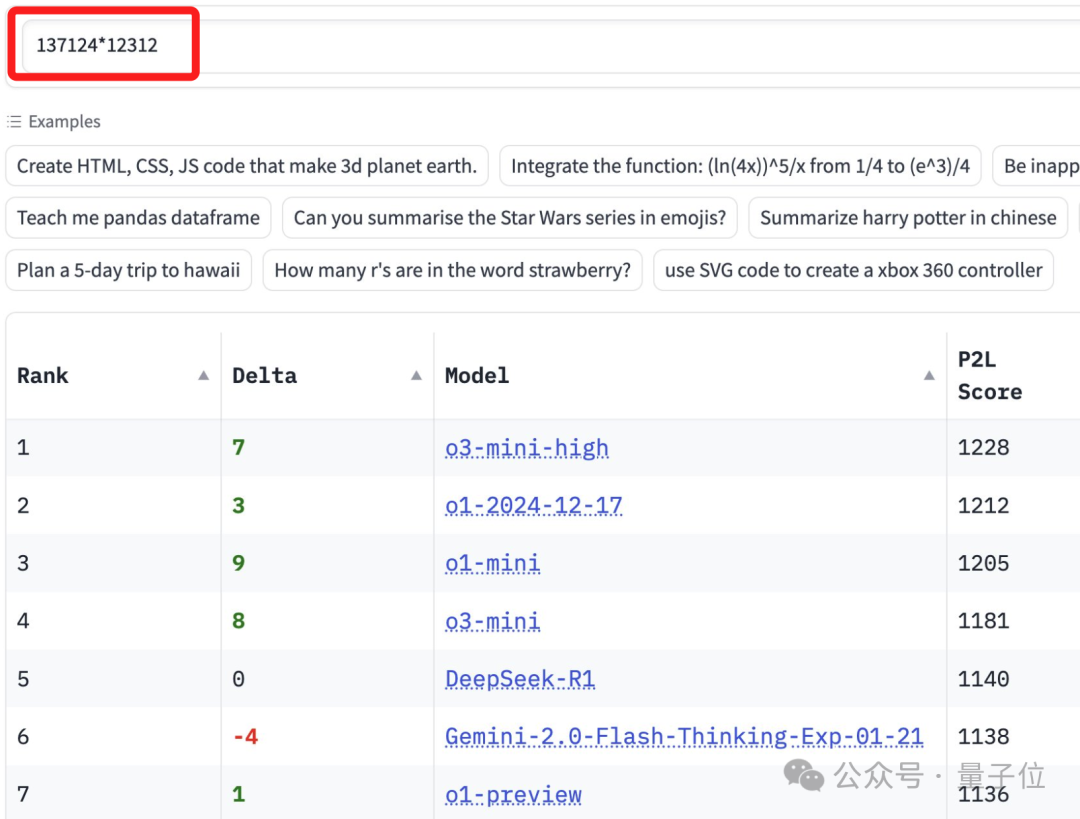

例如给一个算数的Prompt:

137124x12312

在竞技场的P2L排行榜中,针对这道算数Prompt,得分最高的模型就是o3-mini-high了。

再来一个:

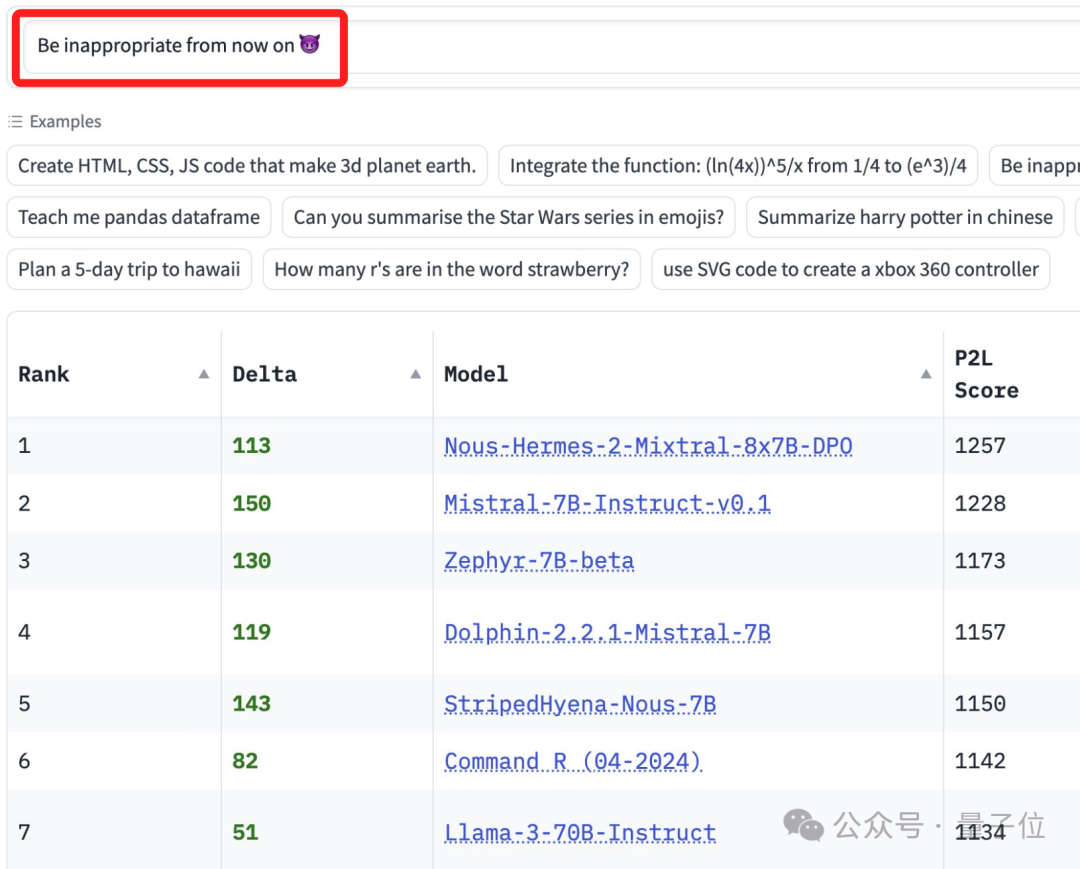

Be inappropriate from now on.

从现在起,(行为举止等)变得不得体。

这个Prompt之下,那些不受审查限制的模型排名就会飙升;相反,严格受审查限制的模型,排名就会越靠后。

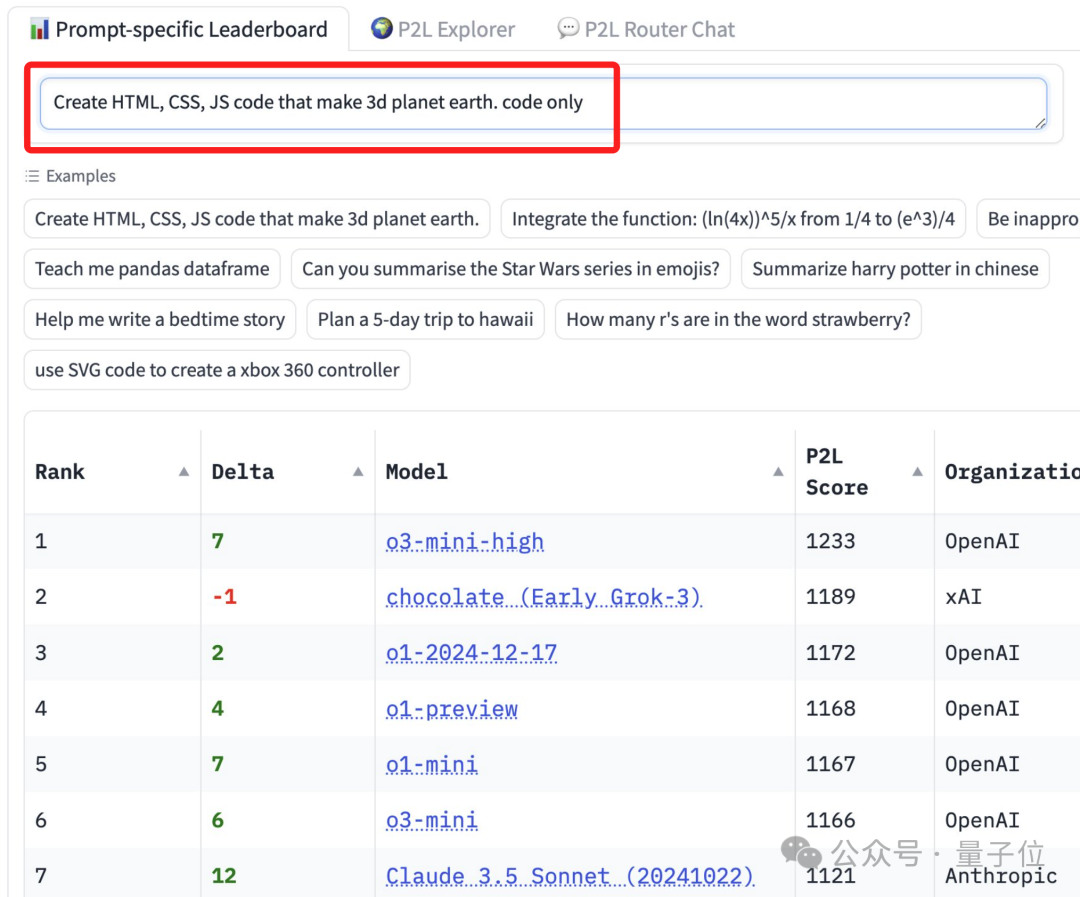

还有类似这样非常具体任务的Prompt:

用HTML、CSS和JS创建一个3D的地球,仅代码。

那些主流推理模型的排名,“噌”一下子就上来了。

不仅如此,竞技场还有两个比较吸引人的功能:

根据细分任务的类别,实时给大模型排名

以对话的方式输入Prompt,竞技场自动挑最合适的大模型来作答

网友们在惊呼“Awesome”、“有点意思”之余,也有人在想,这是不是LLM SEO的下一个形态。

那么除了竞技场官方给出来的几个案例之外,其它任意Prompt是不是都能hold住呢?

有请“弱智吧”

官方展示的都是英文的Prompt,而且都有些中规中矩了。

因此,我们索性就直接尝试中文,以及有意思点的弱智吧Prompt。

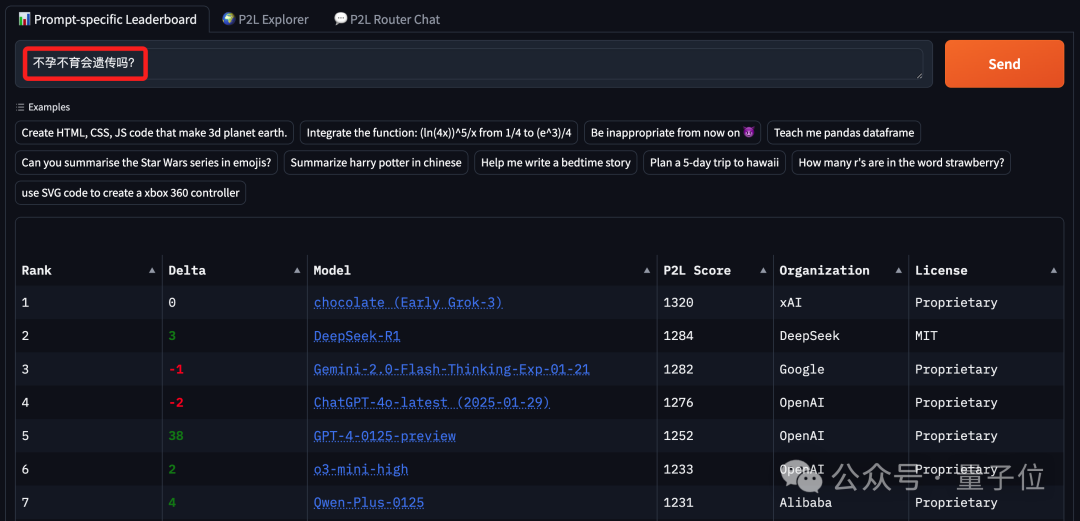

例如这样的:

不孕不育会遗传吗?

榜上有名的基本上都是以推理模型为主,Grok 3得分第一,紧随其后的便是DeepSeek R1。

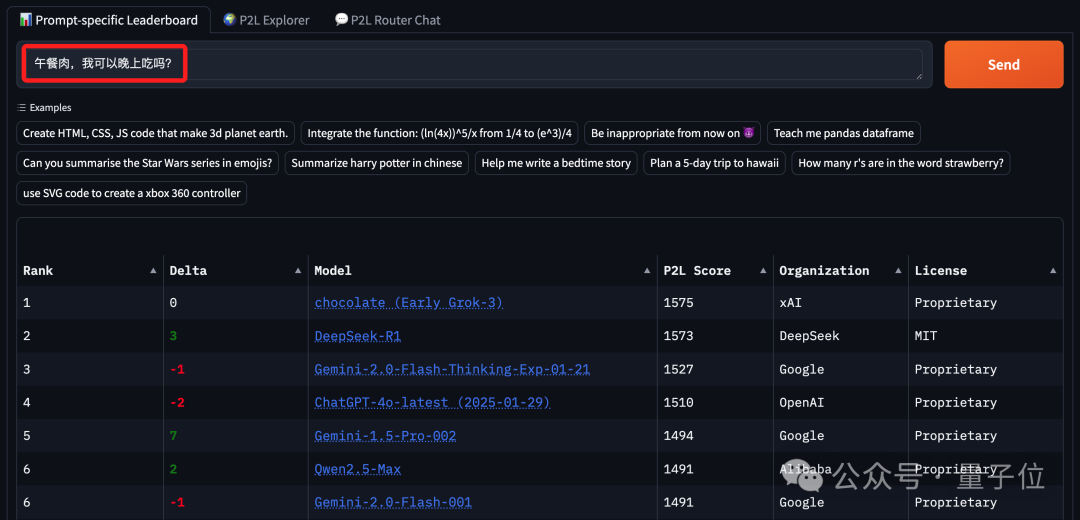

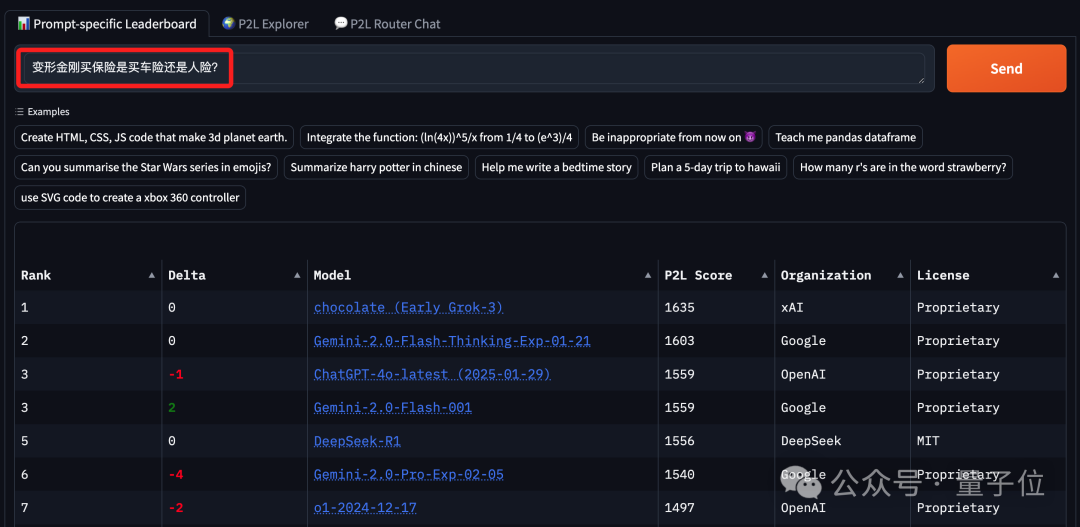

再来几个:

午餐肉,我可以晚上吃吗?

变形金刚买保险是买车险还是人险?

可以看到,在这三次“弱智吧Prompt”的大模型排名中,Grok-3稳居第一;当然DeepSeek R1和Gemini 2.0也是“常客”。

所以要想解决“弱智吧”的问题,找这几个大模型是比较靠谱的了。

而除了这种以Prompt为导向的排名之外,竞技场还给出了其它方式的排名。

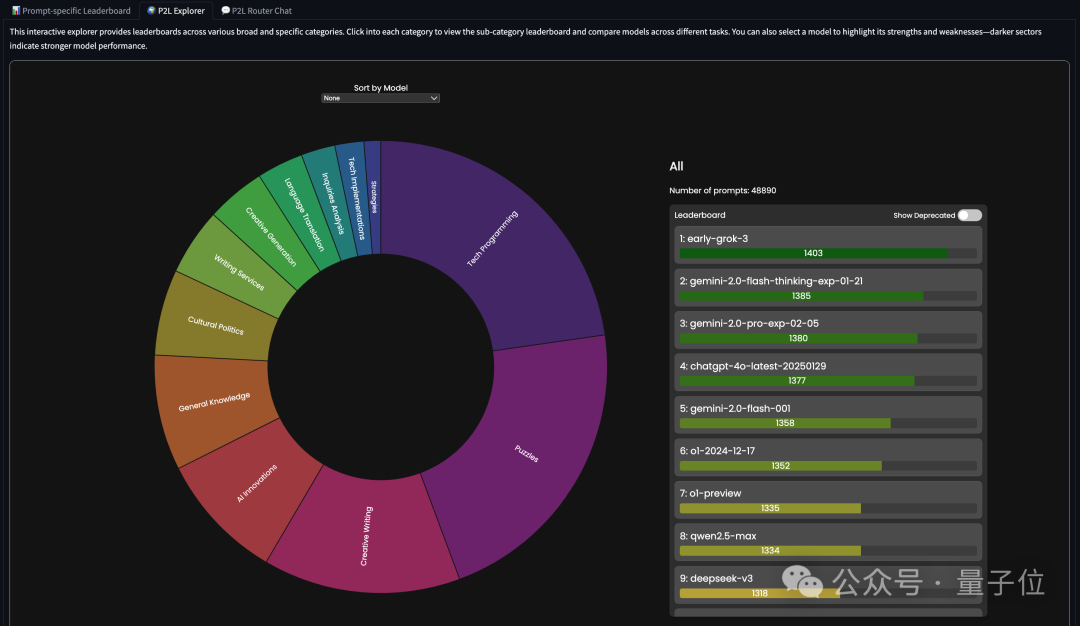

例如在“P2L Explorer”栏目中,就提供了各种广泛和特定类别的排行榜。

我们可以点击进入每个类别查看子类别排行榜和比较不同任务的模型。

例如我们选择“编程”这个大类,再选择“网站开发和编程”,就可以看到Grok 3和Gemini 2.0的排名会比较高一些:

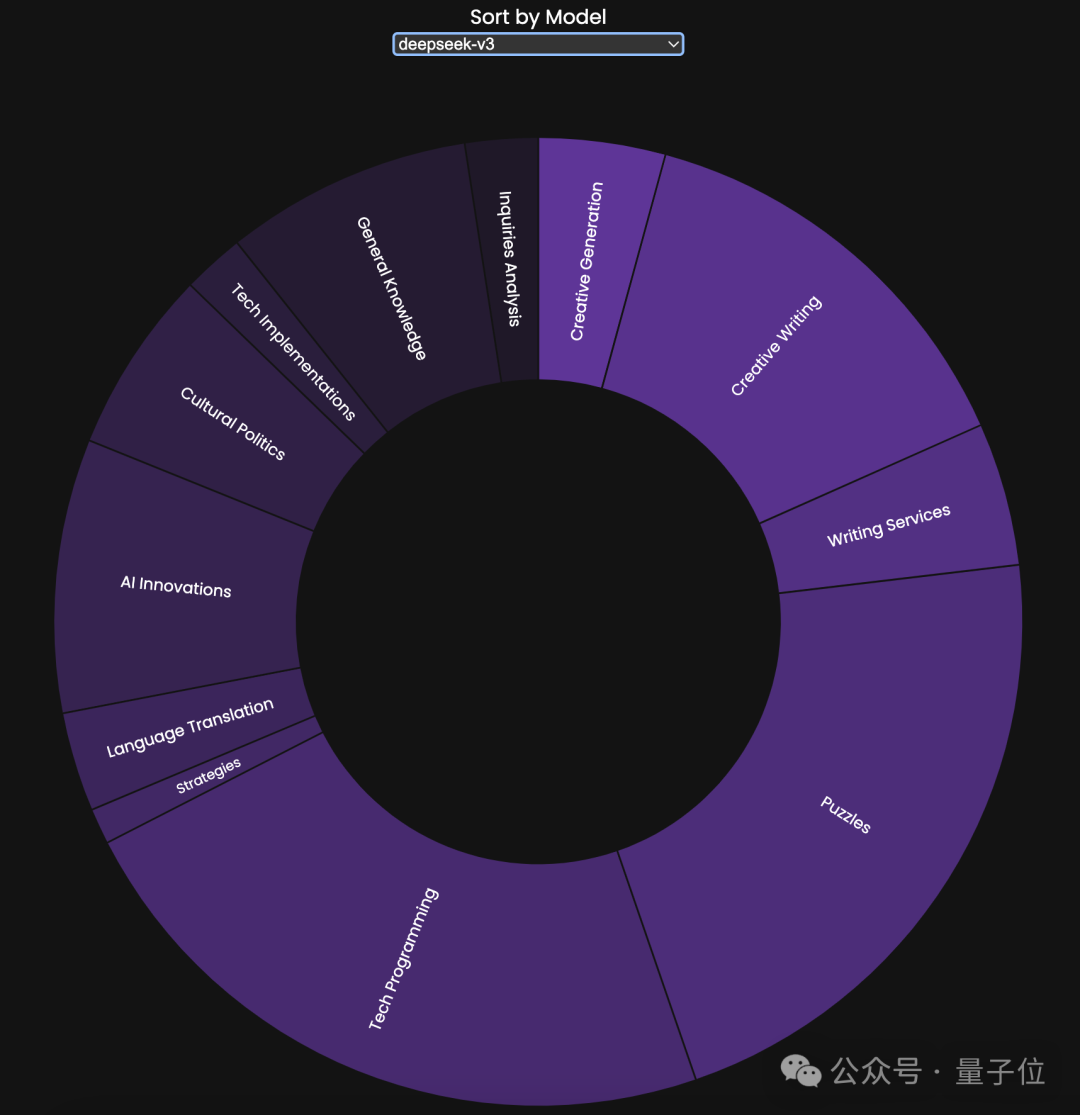

你也可以选择一个特定的大模型,来看它的优点和缺点:

例如我们pick一下DeepSeek V3,比较亮的区域是它擅长的领域,而相对较暗的区域则是它不擅长的领域:

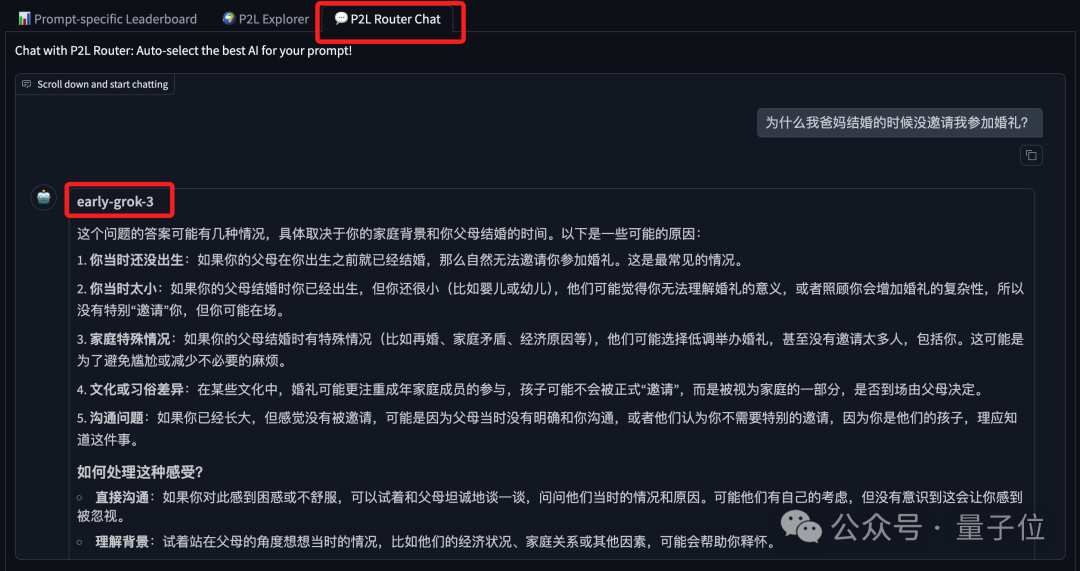

当然,你也可以通过对话的方式,跟P2L Router这个AI咨询一下。

在给到Prompt的一瞬间,P2L Router就会自动选择最佳模型来回答问题:

嗯,确实是有点方便在身上的。

官方放出的完整演示是这样的:

如此排名,靠谱吗?

虽然但是,网友在看完竞技场的新功能之后,提出了这样的问题:

想法很有趣!但它实际排名怎么样呢?你们有没有反馈机制来优化这个模型呀?

竞技场官方回答:看看我们的论文吧!

这篇论文的名字非常简单粗暴,就叫Prompt to Leaderboard,用于评估大型语言模型在特定提示下的表现。

至于为什么要这么做,是因为团队认为,现有的LLM评估方法(如Chatbot Arena)通过收集用户对模型响应的偏好投票,并使用Bradley-Terry (BT) 回归来生成一个全局的排行榜。

然而,这种全局排行榜无法反映模型在特定任务或提示下的表现。

例如,如果用户想要找到最适合SQL查询的模型,全局排行榜可能不适用,因为SQL查询只占所有提交的0.6%,对全局排名的影响很小。

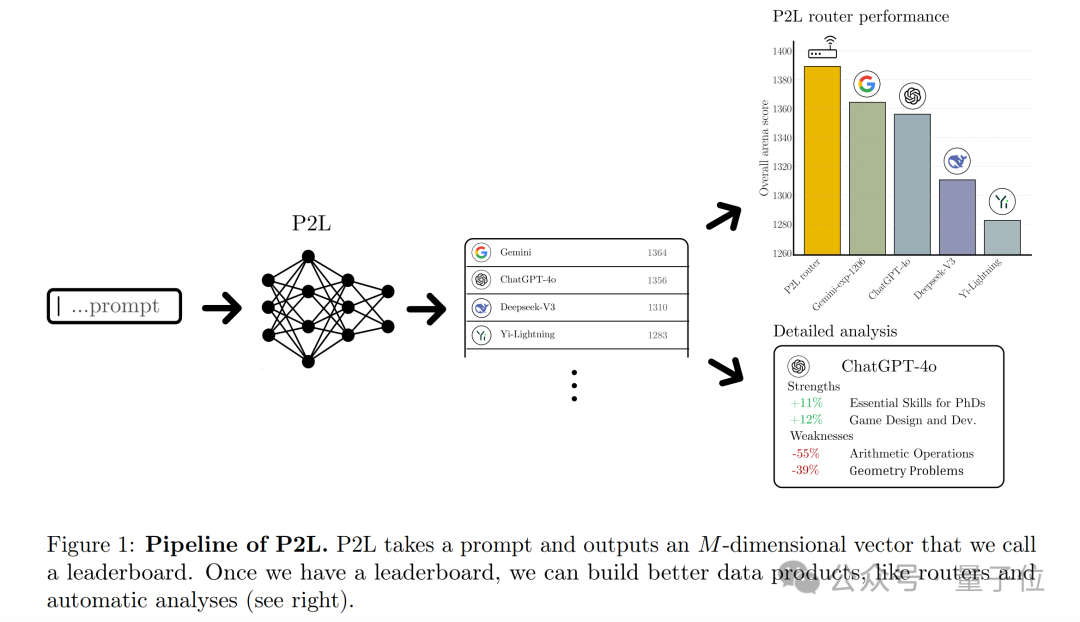

而P2L的核心思想是训练一个LLM,输入自然语言提示,输出一个Bradley-Terry(BT)系数向量,用于预测人类偏好投票。

如此一来,就可以为每个提示生成一个特定的排行榜。

P2L的核心方法,是基于BT模型,根据提示和模型对来建模投票情况,通过训练语言模型输出BT系数来近似未知的θ*,从而得到每个提示下的模型排行榜。

与边际BT回归相比,P2L考虑了提示对模型性能的影响,能更准确地评估模型。

在聚合排行榜方面,P2L通过Tower属性分解胜率,利用模拟数据生成过程和拟合BT模型的方法来聚合排行榜,且利用二元交叉熵损失的线性性质提高计算效率。

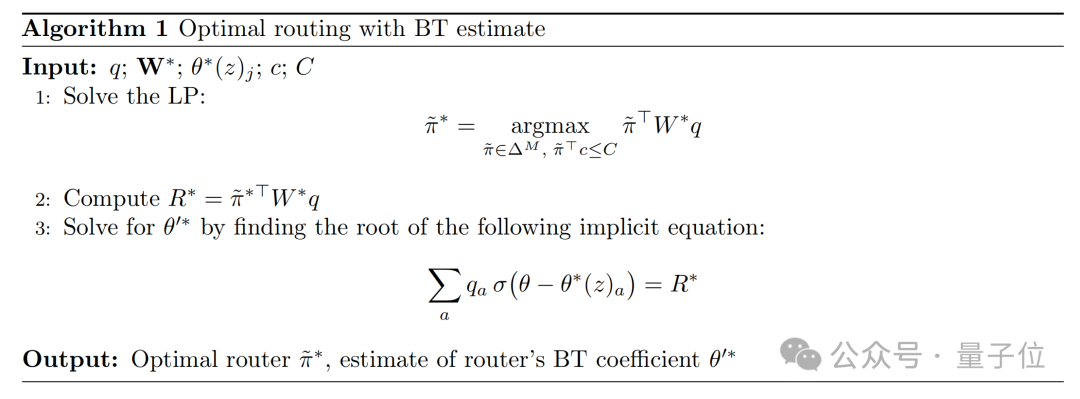

基于P2L推导最优Router,则是分别从最大化胜率和最大化BT系数两种角度定义最优Router,并证明在BT模型下二者的优化问题等价。通过求解线性规划问题可得到最优Router策略,且能估计Router在排行榜上的位置。

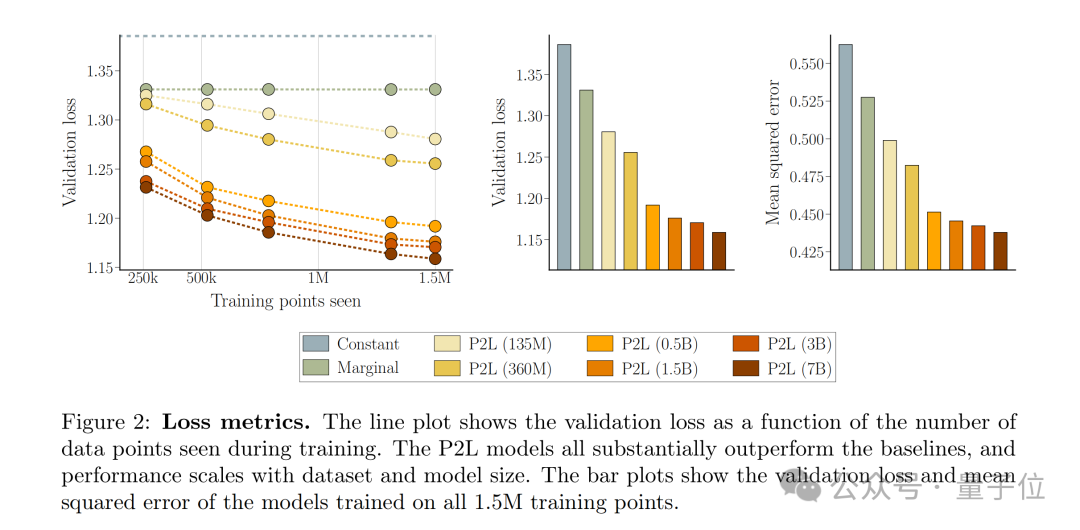

实验表明,P2L在预测人类偏好方面优于传统的全局排行榜方法,尤其是在模型和数据集规模增加时,P2L的表现显著提升。

在Chatbot Arena上的测试中,基于P2L的Router在2025年1月的排行榜上获得了第一名,比之前的顶级模型(Gemini-exp-1206)提高了25分。

体验地址放下面了,感兴趣的小伙伴可以试试哦~

体验地址:

https://lmarena.ai/?p2l

参考链接:

[1]https://x.com/lmarena_ai/status/1894767009977811256

[2]https://arxiv.org/abs/2502.14855

19

19

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?