丰色 发自 凹非寺

量子位 | 公众号 QbitAI

号称“史上最强的开源大语言模型”出现了。

它叫Falcon(猎鹰),参数400亿,在1万亿高质量token上进行了训练。

最终性能超越650亿的LLaMA,以及MPT、Redpajama等现有所有开源模型。

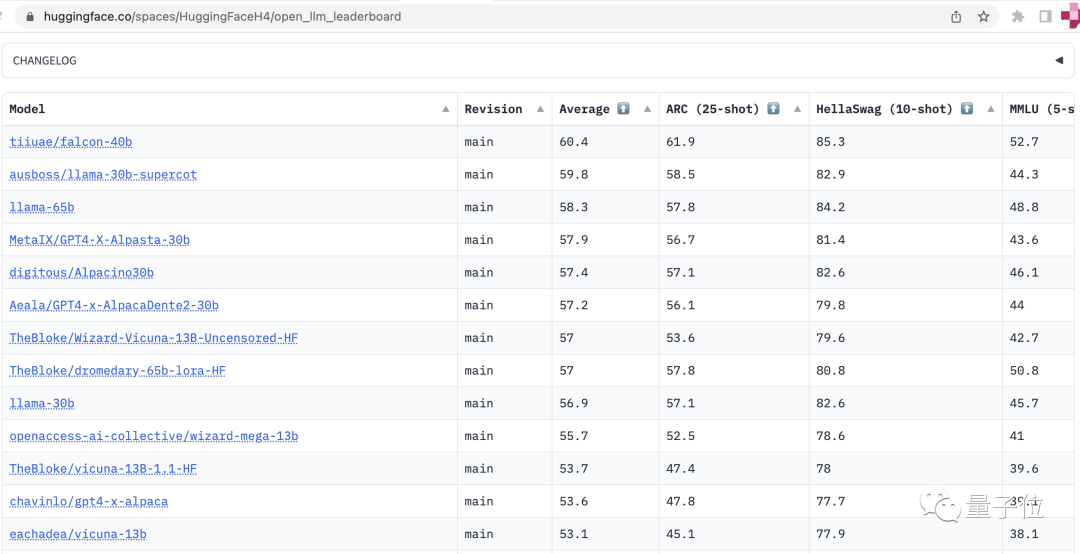

一举登顶HuggingFace OpenLLM全球榜单:

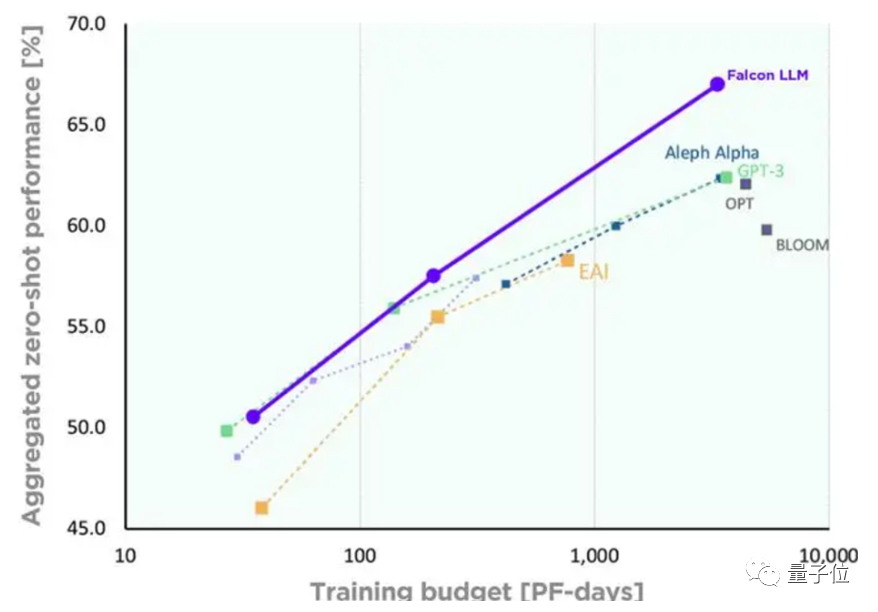

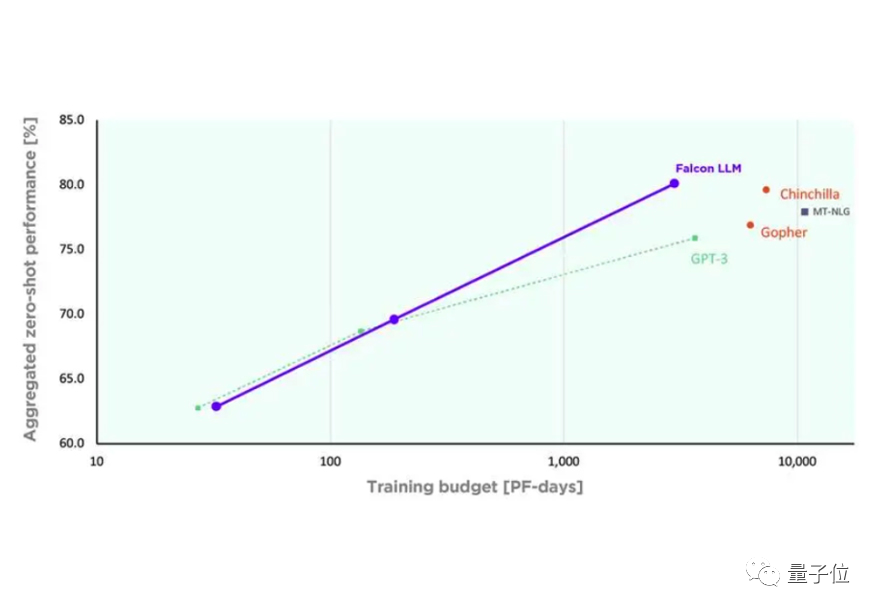

除了以上成绩,Falcon还可以只用到GPT-3 75%的训练预算,性能就显著超越GPT-3,且推理阶段的计算也只需GPT-3的1/5。

据悉,这只半路杀出来的“猎鹰”来自阿联酋阿布扎比技术创新研究所(TII)。

有意思的是,作为一个开源模型,TII在Falcon上推出了一个相当特别的授权许可证要求:

可以商业使用,但如果用它产生的收益超过了100万美元,就要被收取10%的授权费。

一时之间,争议满满。

史上最强开源LLM

据介绍,Falcon属于自回归解码器模型。

它使用自定义工具构建,包含一个独特的数据管道,该管道从公开网络中提取训练数据。

——Falcon宣称它“特别注重数据质量”,从公网上抓取内容构建好Falcon的初始预训练数据集后,再使用CommonCrawl转储,进行大量过滤(包括删除机器生成的文本和成人内容)并消除重复数据,最终得到一个由近5万亿个token组成的庞大预训练数据集。

为了扩大Falcon的能力,该数据集随后又加进了很多精选语料,包括研究论文和社交媒体对话等内容。

除了数据把关,作者还对Falcon的架构进行了优化以提升性能,但细节没有透露,相关论文将很快发布。

据悉,Falcon一共耗费两个月,在AWS的384个GPU上训练而成。

最终,Falcon一共包含4个版本:

Falcon-40B:在1万亿token上进行训练,并使用精选语料库进行了增强;主要接受英语、德语、西班牙语、法语的训练,不会中文。

Falcon-40B-Instruct:在Baize上进行了微调,使用FlashAttention和多查询对推理架构进行了优化,是一个即用型聊天模型。

Falcon-7B:参数70亿,在1.5万亿token上进行了训练,作为一个原始的预训练模型,还需要用户针对大多数用例进一步微调。

Falcon-RW-7B:参数70亿,在3500亿token上进行训练,该模型旨在用作“研究神器”,单独研究各种在网络数据进行训练的影响。

开源许可证引争议

Falcon作为开源模型,已公开源代码和模型权重,可供研究和商业使用。

这对业界来说是一个好消息,毕竟像Meta的羊驼家族都只能用于研究目的,且还得填表格申请才行,很是麻烦。

但Falcon还是引起了争议。

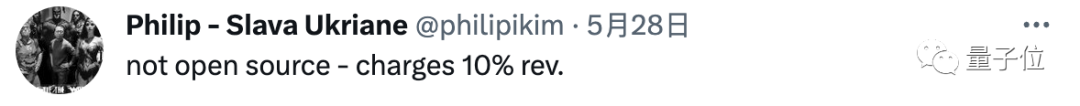

这主要是因为它那“超过100万美元的任何商业应用都要收10%的授权费”的许可证要求。

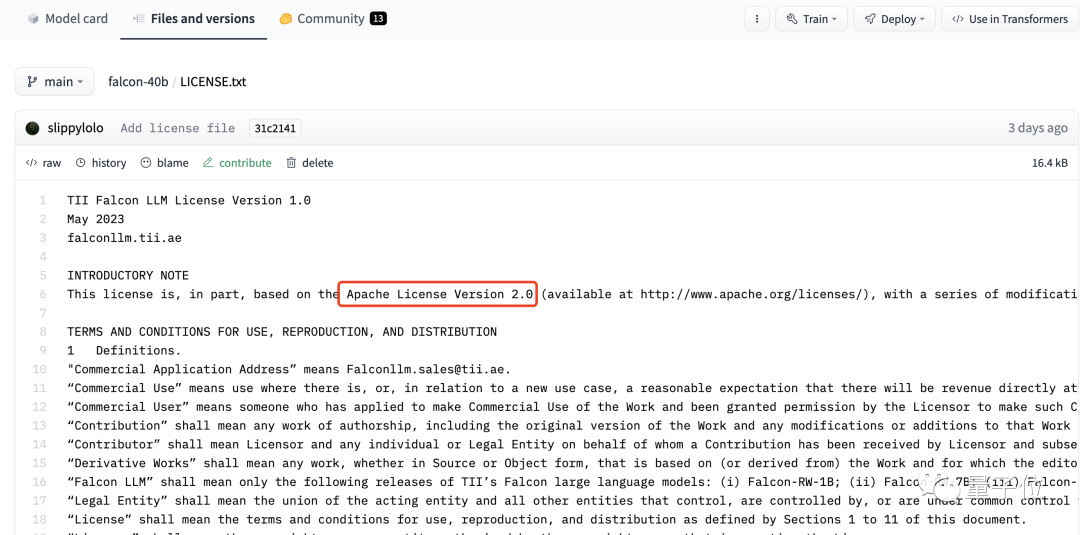

据悉,该许可证部分基于Apache License 2.0协议,该协议对商业应用友好,使用者修改代码只需满足相关需求即可将新作品作为开源或商业产品发布或销售。

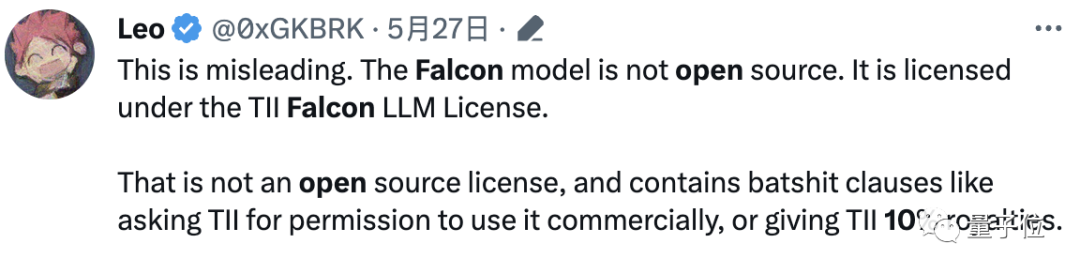

有不少网友认为,既然Falcon宣称开源,还要收费,就违背了Apache License Version 2.0的宗旨,不属于真正的开源。

并有人称这是一种“有损Apache软件基金会来之不易的名誉”的做法。

有网友已经跑到TII的官方账号下“讨要说法”:

你自己能解释一下这是如何符合“开源”的定义吗?

目前,官方并没有回复。

你认为这种做法究竟算不算开源呢?

参考链接:

[1]https://falconllm.tii.ae/

[2]https://twitter.com/ItakGol/status/1662149041831002138

[3]https://twitter.com/TIIuae/status/1662159306588815375

— 完 —

「AIGC+垂直领域社群」

招募中!

欢迎关注AIGC的伙伴们加入AIGC+垂直领域社群,一起学习、探索、创新AIGC!

请备注您想加入的垂直领域「教育」或「电商零售」,加入AIGC人才社群请备注「人才」&「姓名-公司-职位」。

点这里👇关注我,记得标星哦~

44

44

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?