Alex 发自 凹非寺

量子位 | 公众号 QbitAI

人工神经网络的尽头是一个神经元?

——没准儿还真有可能。

当前,最先进的AI系统通过创建多层神经网络来模仿人类大脑,旨在将尽可能多的神经元塞进尽可能小的空间。

可惜,这样的设计需要消耗大量的电力等资源,而产生的输出结果与强大且“节能”的人脑比起来相形见绌。

最近,柏林工业大学的研究小组提供了一个新思路:把任意大小的深度神经网络折叠成单神经元,这个神经元具有多个延时反馈回路。

关于研究成果的论文发布于Nature子刊。

这个“单个神经元的AI大脑”概念的提出,无疑给神经网络的发展指明了一个新方向。

下面就来看看这是一项怎样的研究吧!

具体方法

研究团队设计了一种多层前馈深度学习神经网络的完全时间折叠的方法(Fit-DNN)。

Fit-DNN的诞生主要受到“folded- in-time”概念的启发,即:使用单一的延迟环路配置和输入数据的时间复用来模拟环形拓扑结构。

传统的深度神经网络由多层神经元组成,以前馈结构耦合。

如果用一个神经元来实现传统DNN的功能,需要保留各层的逻辑顺序,同时找到一种方法来顺序化层内的操作。

这只能通过在时间上分割以前同时进行的过程来实现:单个神经元在正确的时间接受正确的输入,依次模拟每一层的各个神经元。

传统的相邻层之间的连接,转变成单个神经元在不同时间的连接,即:层间连接变成了延迟连接。

在不同时间对同一神经元进行不同的加权,权重由反向传播算法确定。

这类似于单个客人通过快速切换座位并说出每个部分,来模拟大型餐桌上的对话。

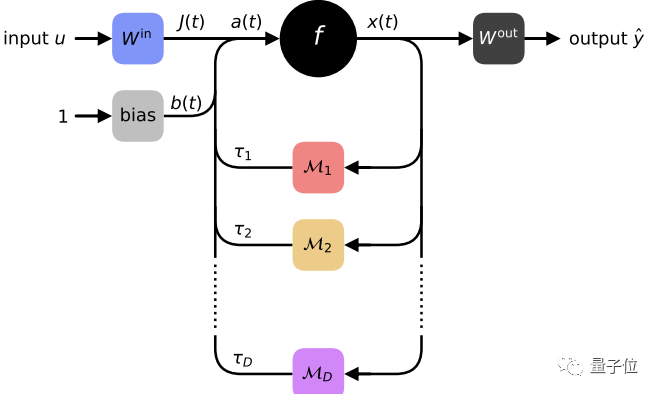

Fit-DNN的核心由一个具有多个延迟和调制反馈的单一神经元组成,上图展示了其结构:

标着字母f的黑色圆代表神经元,它在t时的信号为x(t);这个信号是数据J(t)、偏移量b(t)和反馈信号之和。

可调节的元素用方块表示:数据信号由输入向量u产生,蓝色方块中的矩阵包含输入权重。偏置系数产生灰色方块中的偏置信号。每个反馈环路实现一个延迟和一个时间调制,来产生反馈信号。

最后,使用输出权重矩阵从信号x(t)中获得输出。

注意,为了获得数据信号J(t)和输出,需要进行适当的预处理或操作后处理。

与传统多层层经网络的等效性

单神经元的Fit-DNN在功能上真的可以等同于多层神经网络吗?

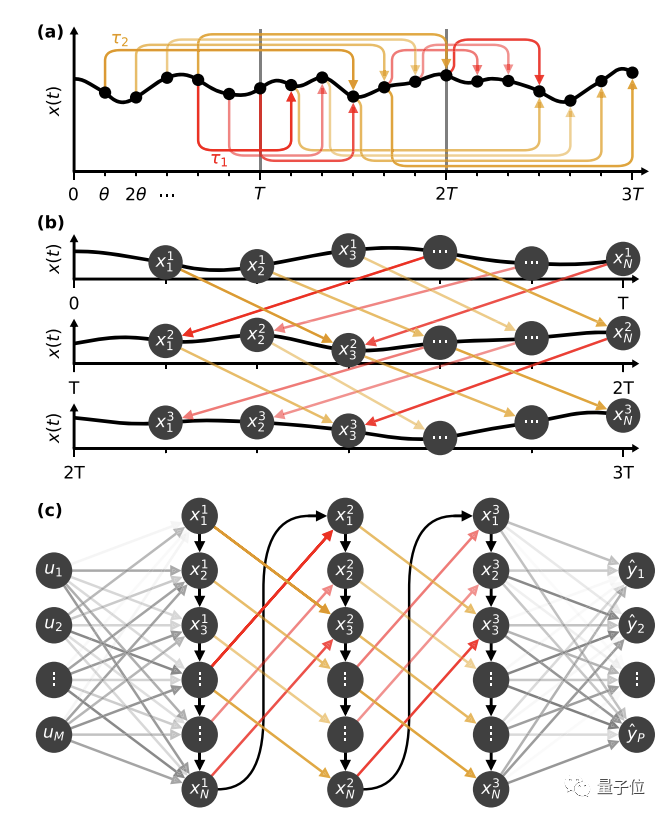

如下图所示,Fit-DNN可以将具有多个延迟环的单个神经元的动态性转化为DNN。

图a展示了信号x(t)的时间演化可以分为长度为T的时间间隔,每个间隔模拟一个隐藏层;实线上的黑点表示节点,θ代表节点分离值。

图b表示原始的时间轨迹被切割成长度为T的区间,在各区间内,节点根据其网络位置被标记。

图c由图b的旋转所得,在此基础上增加了一个输入和一个输出层。

这些连接是由节点之间的动态依赖关系决定的,这些依赖关系可以根据θ的值精确计算。

当节点分离值θ较大时,网络节点之间将形成熟悉的多层DNN形状。

不过,当节点分离值θ较小时,每个节点的状态都依赖于前一个节点,而不是完全独立。这些额外的 “惯性 “连接在图c中用黑色箭头表示。

虽然研究者们用D = 2N - 1延迟环路恢复了一个全连接的DNN,但模拟测试表明,这并不完全符合要求。

实际上,用更少的延迟环路就可以获得足够的性能。在这种情况下,Fit-DNN将实现一种特殊类型的稀疏DNNs。

可见,在一定条件下,Fit-DNN可以完全恢复一个没有卷积层的标准DNN,此时,它的性能与多层DNN相同。

单神经元的Fit-DNN将前馈多层神经网络的拓扑复杂性,通过延迟环结构折叠到时域。

这个延迟系统本身就拥有一个无限大的相空间,因此,只要有一个带反馈的神经元就足以折叠整个网络。

Fit-DNN的计算机视觉功能测试

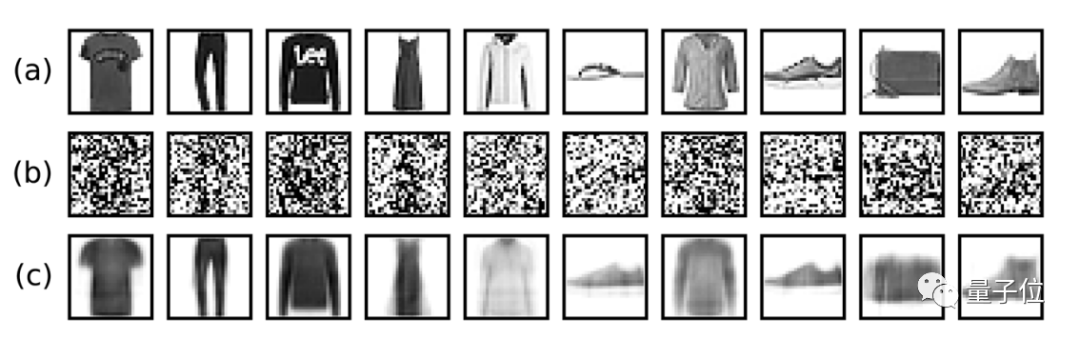

研究人员使用Fit-DNN进行图像降噪,即:从噪声版本中重建原始图像。

他们把强度为1的高斯噪声加入Fashion-MNIST数据集的图像中,并将高斯噪声视为值在0(白色)和1(黑色)之间的向量。

然后截断阈值0和1处剪切所得的向量条目,以获得有噪声的灰度图像。

如上图所示,a行包含来自Fashion-MNIST数据集的原始图像;b行为带有额外高斯噪声的相同图像,这些噪声图像作为训练系统的输入数据。c行表示获得的原始图像的重建结果。

可见,Fit-DNN的图像恢复效果不错。

不过Fit-DNN真正的问题是,时间循环的单个神经元是否能产生与数十亿个神经元相同的输出。

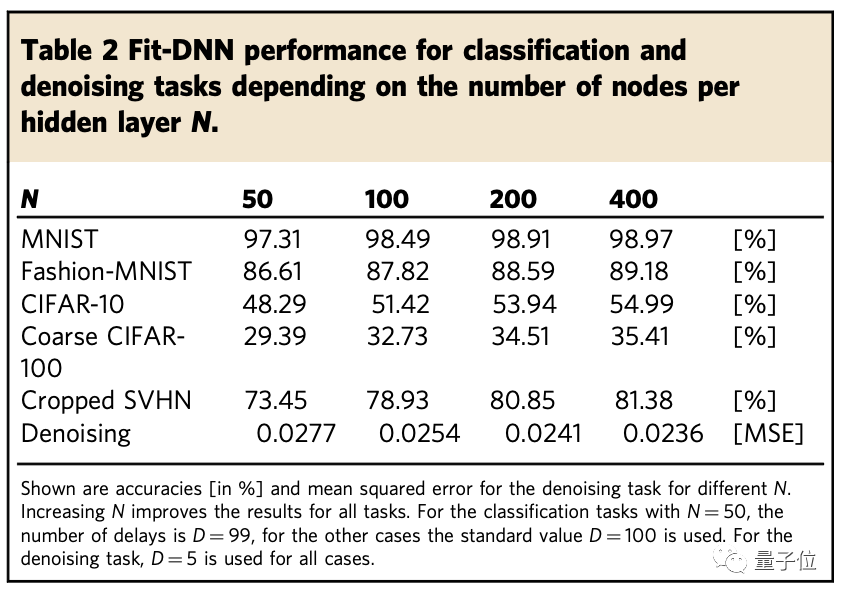

为了证明Fit-DNN和时间状态下的计算能力,研究人员选了五个图像分类任务:MNIST40、Fashion-MNIST41、CIFAR-10、CIFAR-100,以及SVHN。

实验对比了隐藏层的节点数不同时(N=50,100,200,400),Fit-DNN在上述任务中的表现。

结果表示,对于相对简单的MNIST和Fashion-MNIST任务,单个神经元取得了很高的准确率。

但对于更具挑战性的CIFAR-10、CIFAR-100和SVHN任务,单个神经元的准确率较低。

值得注意的是,这里的Fit-DNN只使用了权重矩阵可用对角线的一半。如果增加节点的个数N,将有效地提高性能。

研究团队

论文的通讯作者是Serhiy Yanchuk,他在柏林工业大学先后担任过研究员、客座教授,目前任德国最大国家基金管理组织DFG项目的首席研究员。

Ingo Fischer是论文的共同作者之一。他取得了菲利普斯·马尔堡大学获得半导体物理领域博士学位,后在欧洲多国的大学中担任工程和物理学的博士后研究员、助理教授和全职教授。

经典的多层神经网络,如火爆全球的GPT-3,目前已有750亿个参数,比其前身GPT-2的参数量要多100倍。

据估计,仅仅训练一次GPT-3就需要相当于丹麦126个家庭一年使用的电力,或者约等于开车往返一次月球的耗能。

柏林团队的研究人员认为,Fit-DNN可以对抗训练强大神经网络所需能源成本的上升。

科学家们相信,随着技术的发展,该系统可以扩展到从悬浮在时间中的神经元创建 “无限数量的 “神经元连接。

感兴趣的读者可以戳下面的链接继续深入了解。

论文链接:

https://www.nature.com/articles/s41467-021-25427-4.pdf

参考链接:

https://thenextweb.com/news/how-ai-brain-with-only-one-neuron-could-surpass-humans

柏林工大研究团队提出Fit-DNN,将深度神经网络压缩为单神经元,利用延时反馈回路模拟多层结构。实验显示,尽管单神经元在某些任务上性能接近,但在复杂任务上仍需改进。这项工作有望降低AI能耗,指向更节能的人工智能设计。

柏林工大研究团队提出Fit-DNN,将深度神经网络压缩为单神经元,利用延时反馈回路模拟多层结构。实验显示,尽管单神经元在某些任务上性能接近,但在复杂任务上仍需改进。这项工作有望降低AI能耗,指向更节能的人工智能设计。

9

9

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?