Dify经过从旧服务器迁移到新的服务器之后。服务器使用vllm运行大模型,今天在Dify中使用插件LocalAI配置模型供应商后,使用工作流的时候,报错:“Run failed: PluginInvokeError: {"args":{},"error_type":"ValueError","message":"User message content must be str"}”

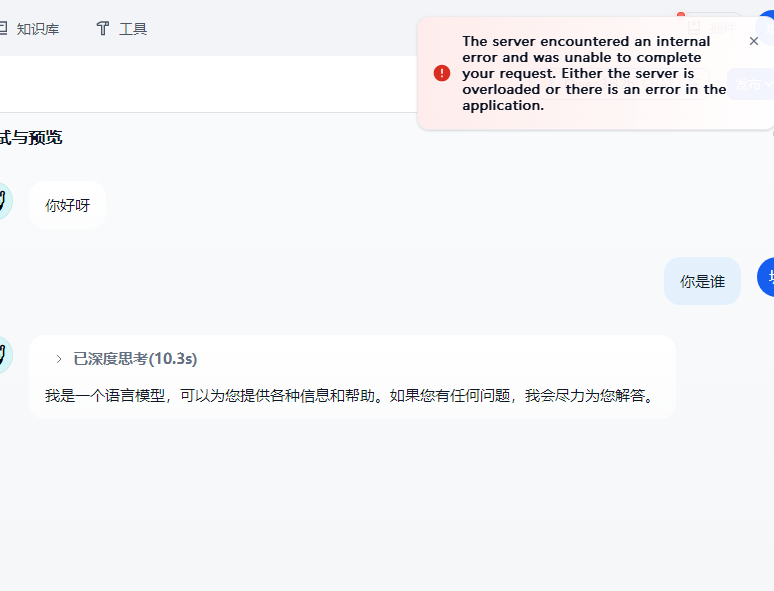

场景:上传文件后,然后再次提问机会出现错误如下:

刚开始怀疑是模型参数之类的问题,但是用ollama配置的模型就不会报错。原因不明。于是改成使用Vllm插件重新添加模型供应商。

然后又可以开心的玩耍了。

过了几天,谁曾想又遇到了一个问题,在使用迁移过来的对话应用时。发现大模型次回答完毕之后都报错:

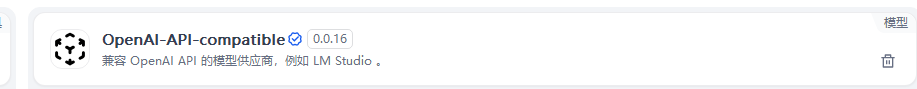

看了日志记录,感觉是旧数据的问题, 重新创建应用就好了。并且改成了使用

OpenAI-API-compatible 插件,

而且它可以可以设置是否开启思考模式,这对于使用Qwen3的模型很有帮助:

898

898

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?