多模态大语言模型(MLLMs)虽然功能强大,但处理高分辨率图片时,海量的视觉Token(可以理解为图像的“像素块”信息)带来了巨大的计算开销,让推理速度变得很慢。为了给这些“臃肿”的模型“瘦身”,学术界一直在研究视觉Token剪枝(Token Pruning)技术,也就是丢掉那些不重要的视觉信息。

最近,一篇被 NeurIPS 2025 接收的论文《Don’t Just Chase “Highlighted Tokens” in MLLMs: Revisiting Visual Holistic Context Retention》对现有的剪枝方法提出了挑战,并带来了一个简单又高效的解决方案—— HoloV。这项研究由香港科技大学、INSAIT、索非亚大学和上海交通大学等机构的研究者们共同完成。HoloV这个名字源于“Holistic Vision”,强调了它在剪枝时所采用的“全局视觉”策略。

- 论文标题: Don’t Just Chase “Highlighted Tokens” in MLLMs: Revisiting Visual Holistic Context Retention

- 作者: Xin Zou, Di Lu, Yizhou Wang, Yibo Yan, Yuanhuiyi Lyu, Xu Zheng, Linfeng Zhang, Xuming Hu

- 机构: 香港科技大学(广州)、香港科技大学、INSAIT 索非亚大学、上海交通大学

- 录用会议: NeurIPS 2025

- 论文地址: https://arxiv.org/abs/2510.02912

- 项目地址: https://github.com/obananas/HoloV

现有方法的困境:只追“高光”,丢失全局

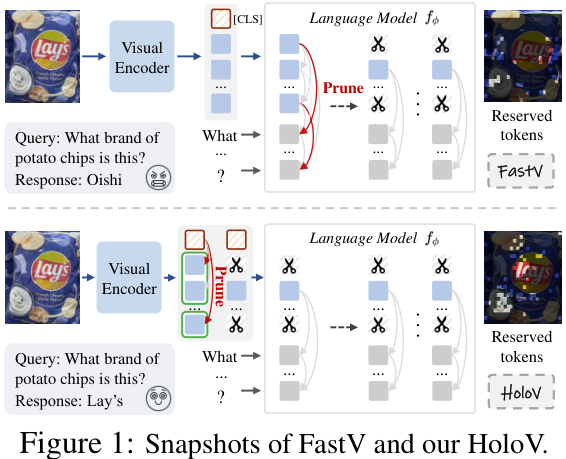

以往的Token剪枝方法,如FastV,大多采用一种“注意力优先”(Attention-First)的策略。它们通过计算文本和视觉之间的交叉注意力,或者利用特殊的[CLS] Token的注意力得分,来判断哪些视觉Token最“重要”,然后保留这些“高光”Token。

这种方法看似合理,但论文作者发现了一个致命缺陷:注意力机制倾向于关注那些语义相似的Token。比如,一张图里有一只猫,那么很多高注意力的Token可能都集中在描述这只猫的不同部位。在高比例剪枝(比如剪掉90%)的情况下,模型保留下来的可能是一堆关于“猫”的冗余信息,而图片中的背景、其他物体等全局上下文信息则被完全丢弃了。这导致模型性能急剧下降。

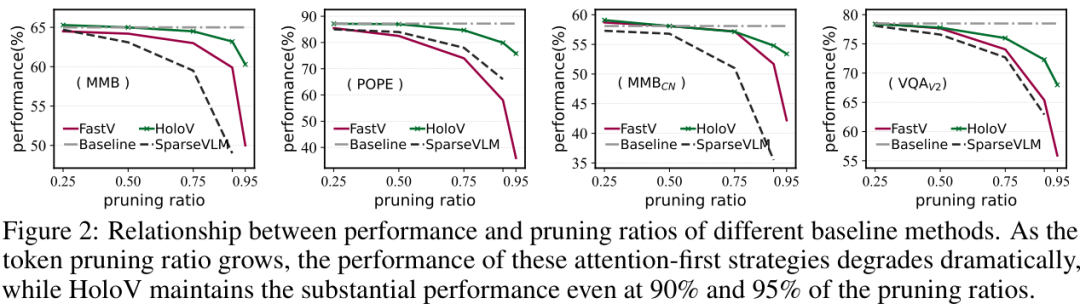

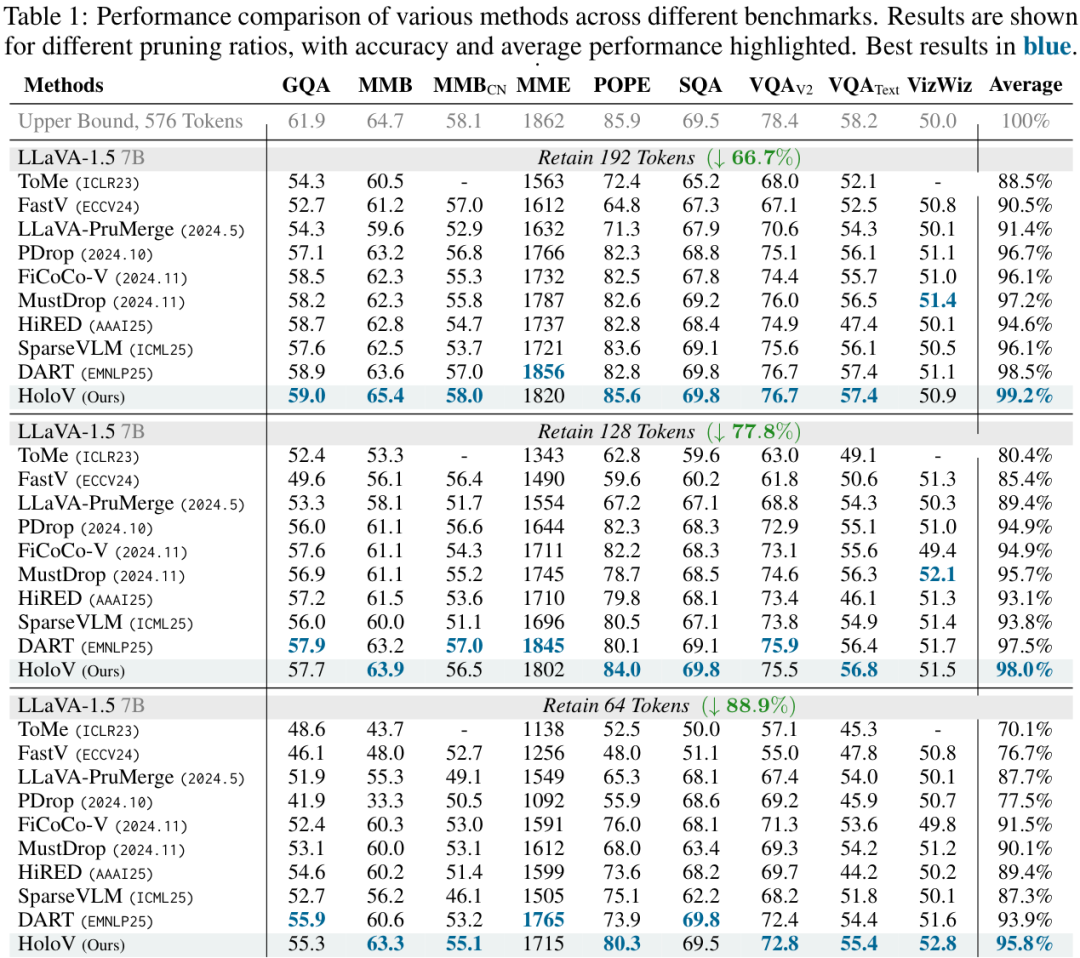

上图清晰地展示了这个问题,随着剪枝率的提高,基于注意力的方法(虚线)性能急剧恶化,而HoloV(实线)则能在高剪枝率下依然保持强大的性能。

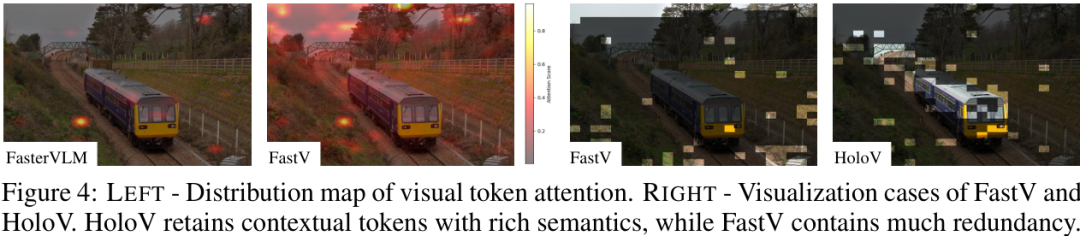

上图右侧的可视化案例更直观,FastV保留的Token(绿色点)高度集中,存在大量冗余,而HoloV保留的Token则分布更均匀,覆盖了更丰富的上下文信息。

HoloV:从全局视角保留视觉上下文

为了解决上述问题,HoloV放弃了只追逐“高光”Token的思路,而是从一个更宏观、更整体的视角(Holistic Perspective)来重新思考Token的保留策略。

HoloV的核心机制可以概括为:

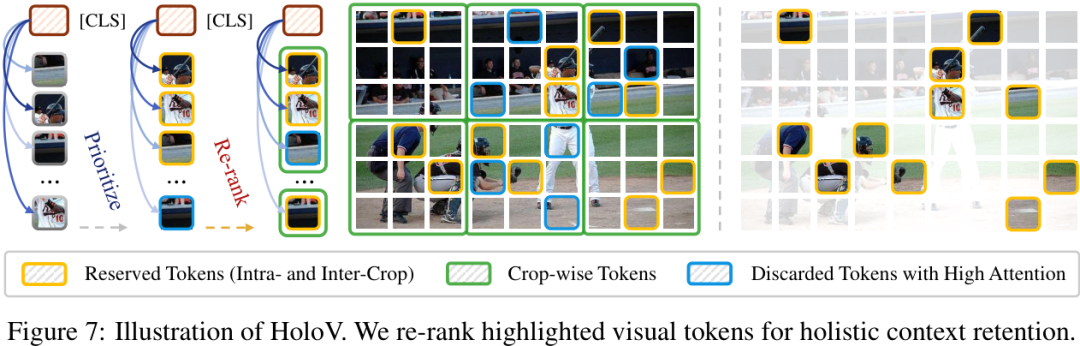

- 划分区域:将输入的图片看作由多个空间区块(Spatial Crops)组成。

- 预算分配:不再将所有“保留名额”都给注意力最高的Token,而是自适应地将剪枝预算分配到不同的空间区块中。

- 全局保留:通过对高亮Token进行重新排序,确保最终保留下来的Token能够覆盖全局的视觉上下文,而不是仅仅聚集在少数几个显著特征上。

通过这种方式,HoloV避免了“表征崩溃”(Representational Collapse)的现象,即使在极高的剪枝率下,也能有效地保留与任务相关的重要信息,实现了局部显著性和全局上下文的平衡。

实验结果:极致的效率-精度权衡

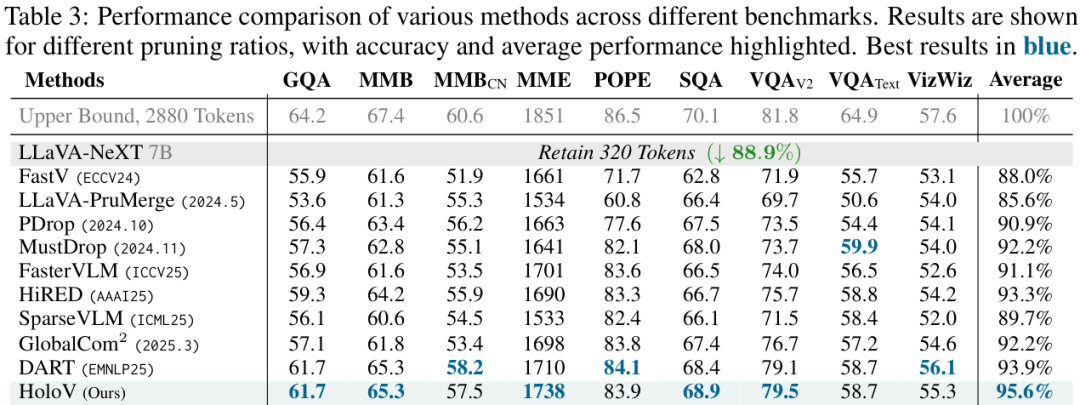

HoloV作为一个即插即用的框架,在多种任务、多种MLLM架构和不同剪枝率下都展现了卓越的性能。

最惊人的结果是,在LLaVA-1.5模型上,HoloV 在剪掉了88.9%的视觉Token后,依然保留了原始模型95.8%的性能,实现了顶尖的效率-精度权衡。

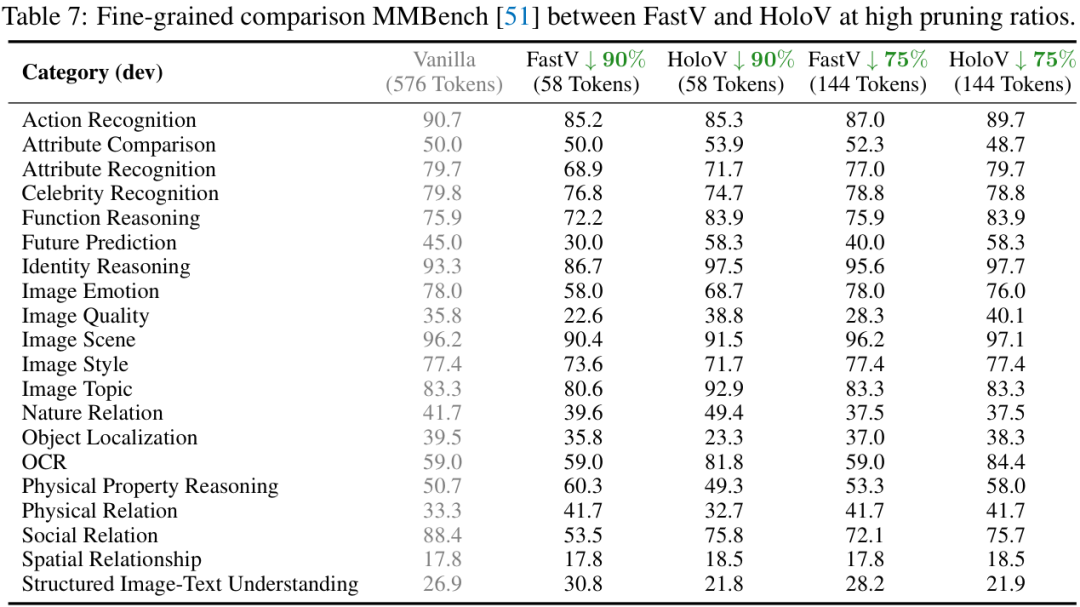

从上面两个性能对比表中可以看到,无论是在哪个基准测试上,HoloV(蓝色字体)的平均性能都远超其他SOTA方法,尤其是在高剪枝率(如87.5%)下,优势更为明显。

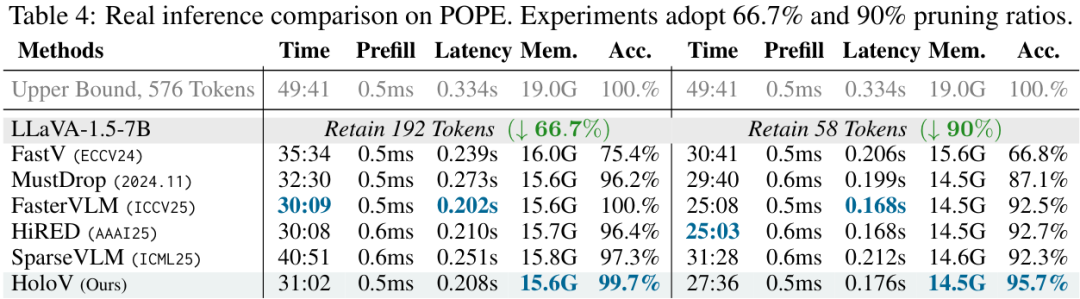

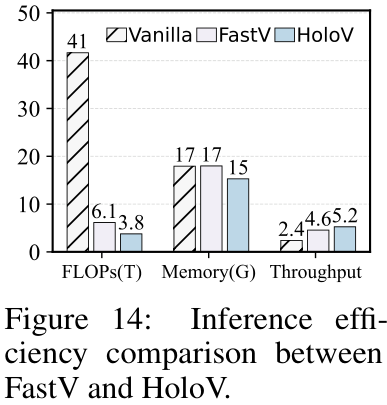

在推理速度上,HoloV也带来了实打实的提升。

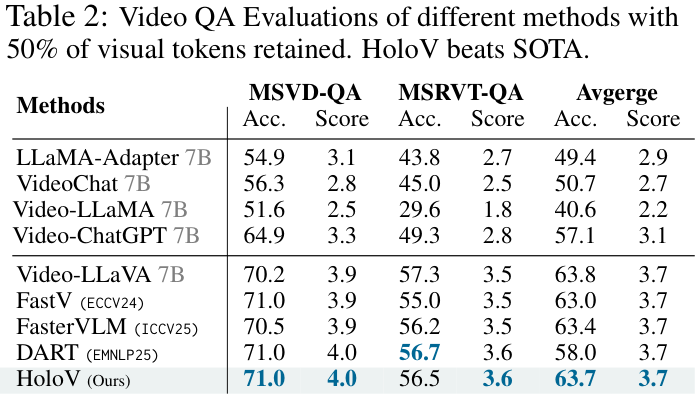

该方法不仅适用于图像任务,在视频问答(Video QA)任务上同样有效。

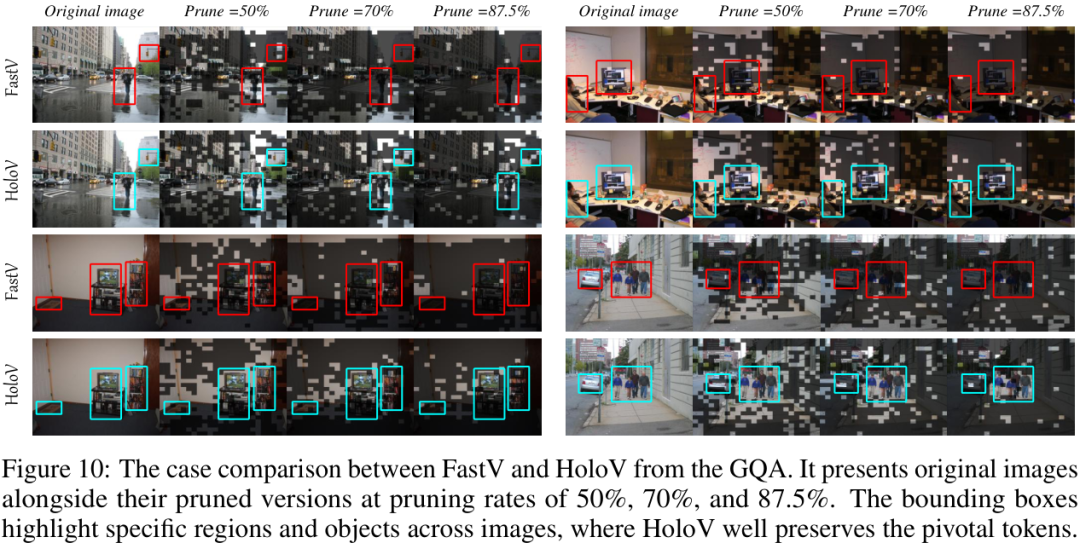

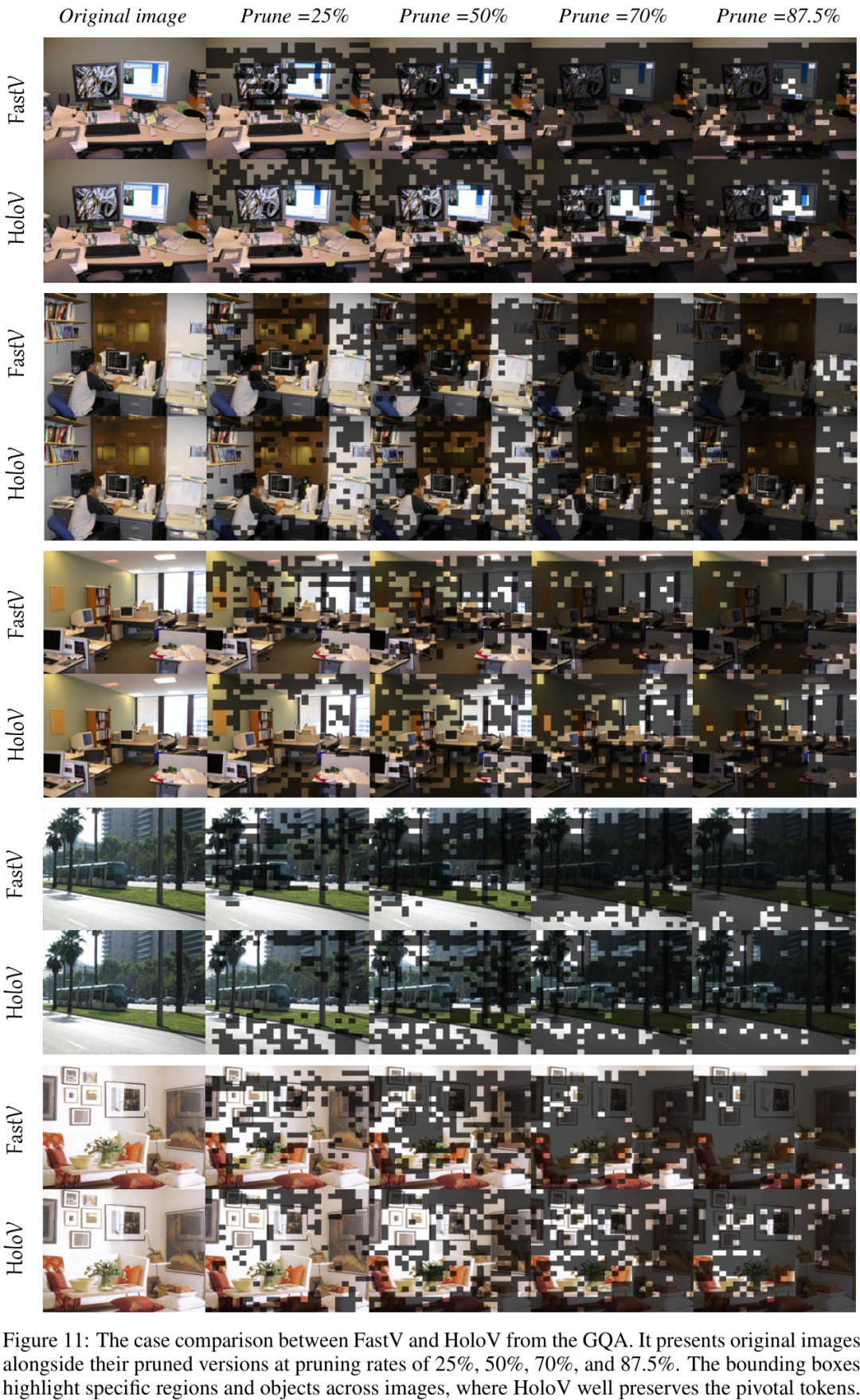

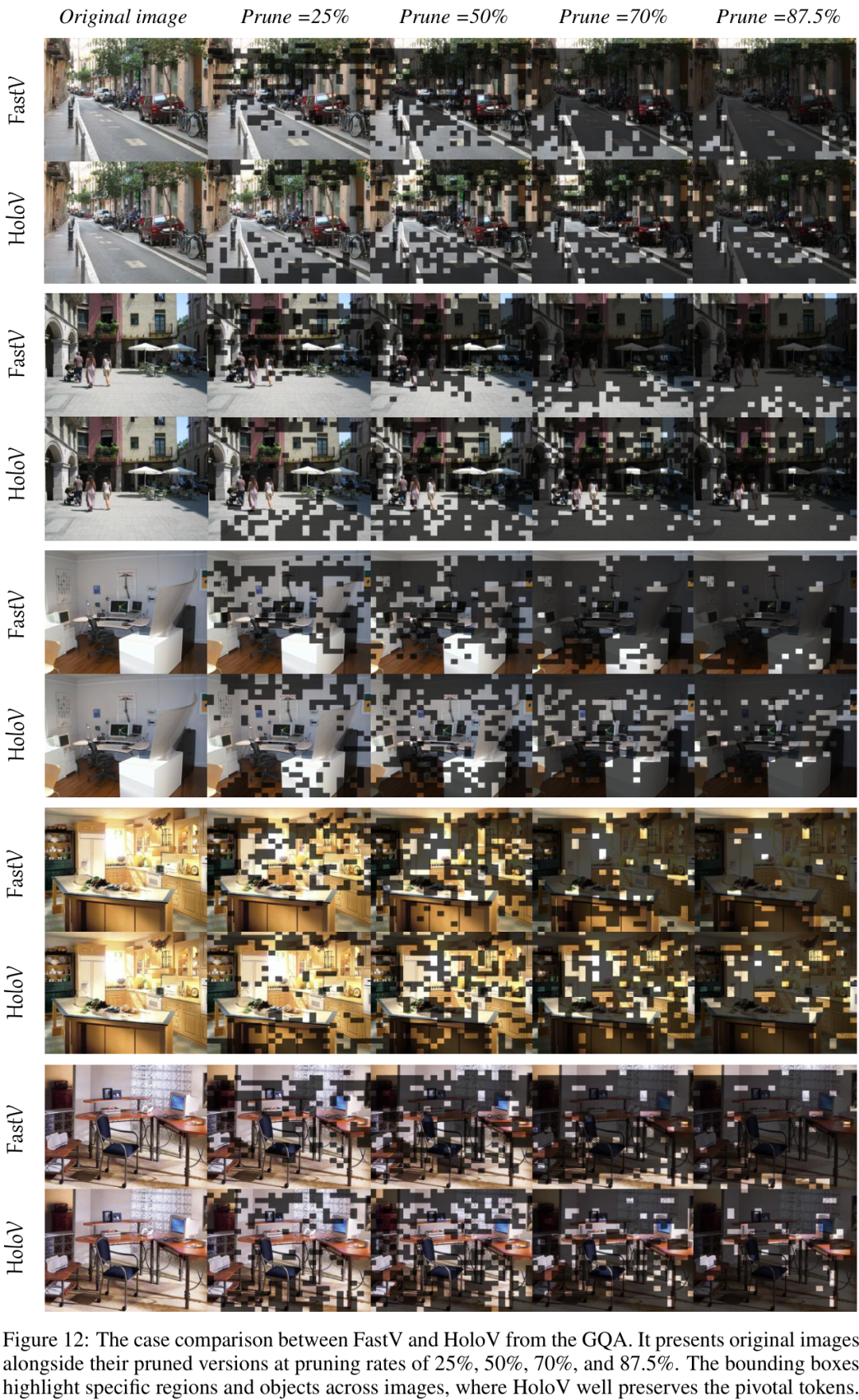

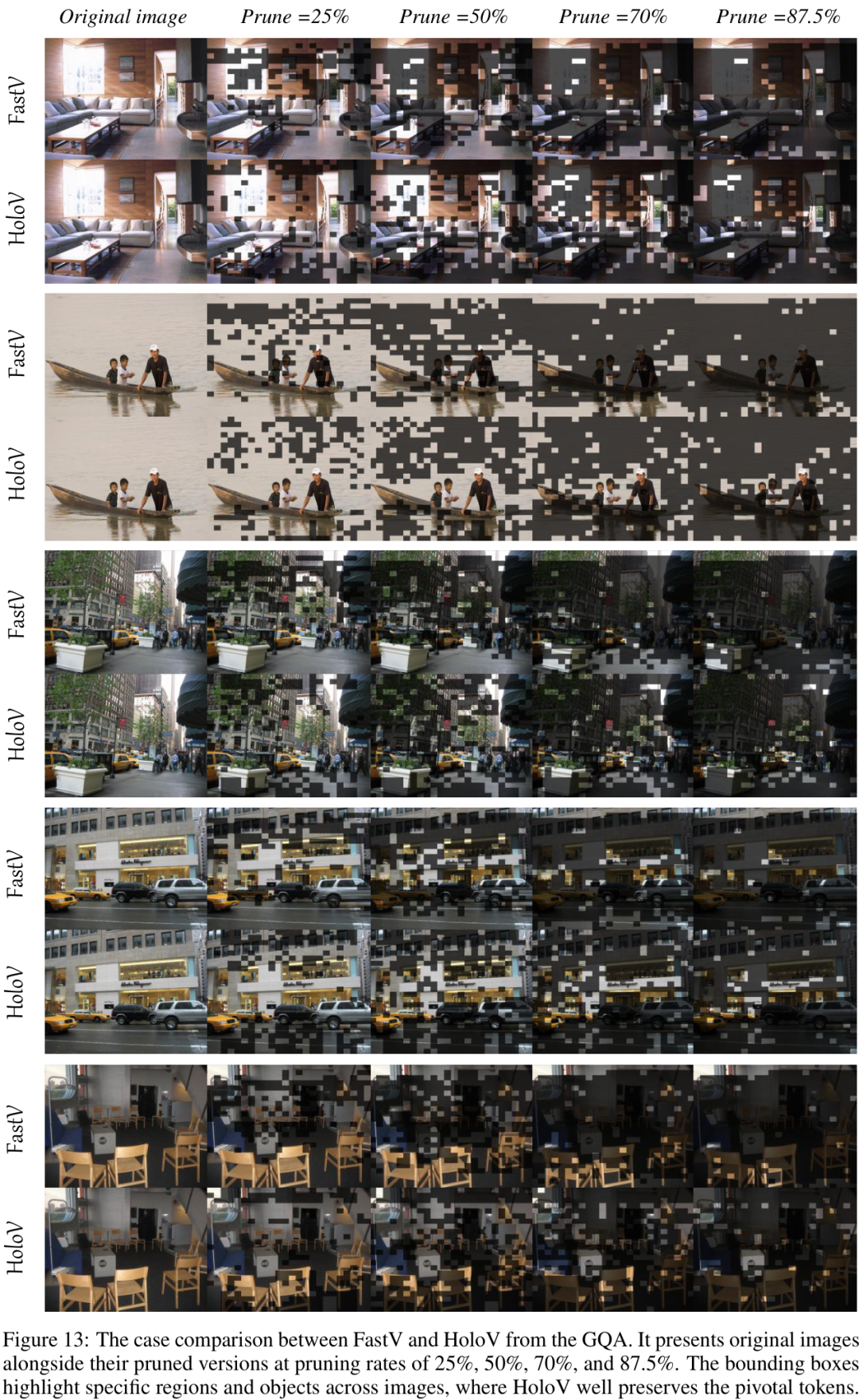

下面的可视化案例生动地对比了FastV和HoloV在不同剪枝率下的表现。可以看到,HoloV更好地保留了图片中的关键对象和场景信息(如路标、远处的建筑等),而FastV则丢失了大量重要上下文。

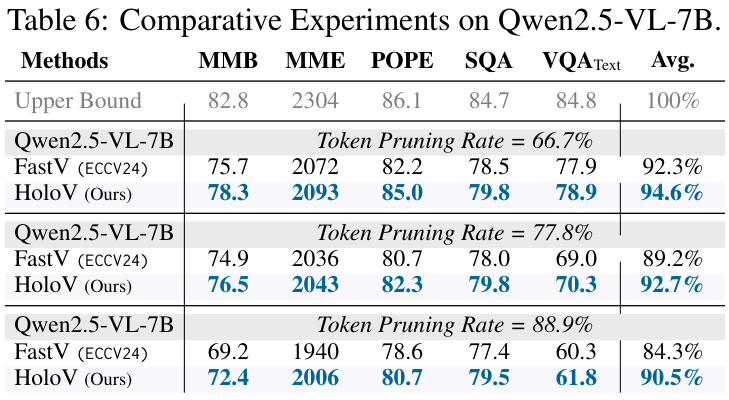

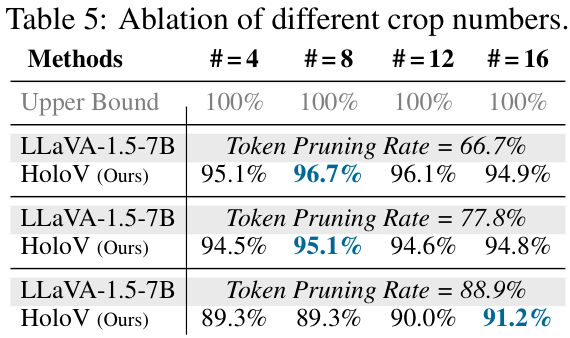

此外,作者还对不同的模型(如Qwen2.5-VL)、不同的剪枝率、不同的超参数(如区块数量)进行了广泛的实验和消融研究,均验证了HoloV的有效性和鲁棒性。

如何学习大模型 AI ?

我国在AI大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着Al技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国Al产业的创新步伐。加强人才培养,优化教育体系,国际合作并进,是破解困局、推动AI发展的关键。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

2025最新大模型学习路线

明确的学习路线至关重要。它能指引新人起点、规划学习顺序、明确核心知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

对于从来没有接触过AI大模型的同学,我帮大家准备了从零基础到精通学习成长路线图以及学习规划。可以说是最科学最系统的学习路线。

针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

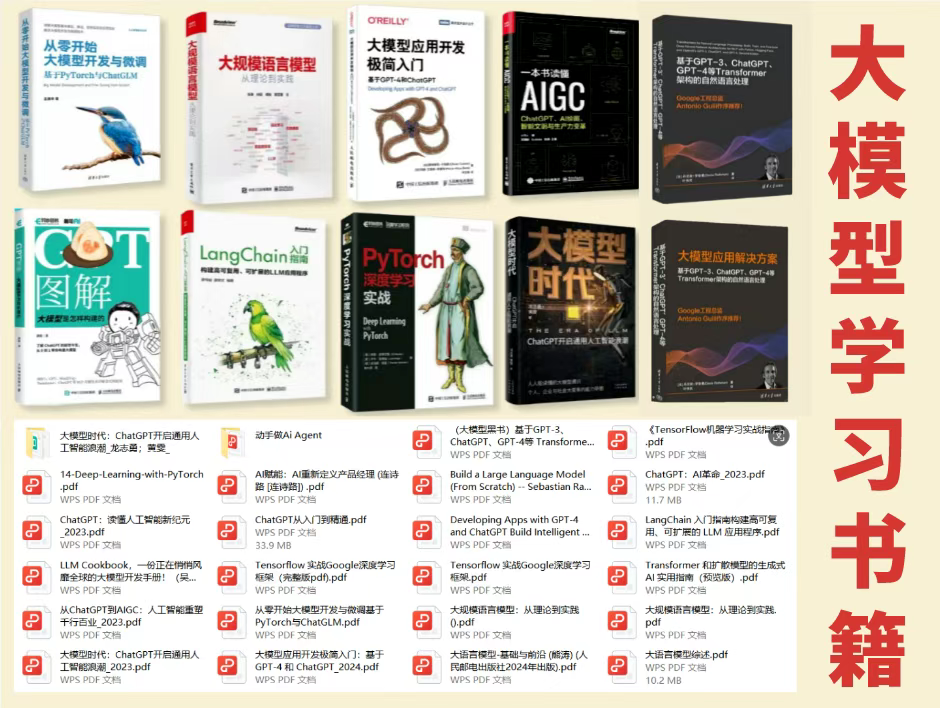

大模型经典PDF书籍

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路!

配套大模型项目实战

所有视频教程所涉及的实战项目和项目源码等

博主介绍+AI项目案例集锦

MoPaaS专注于Al技术能力建设与应用场景开发,与智学优课联合孵化,培养适合未来发展需求的技术性人才和应用型领袖。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

为什么要学习大模型?

2025人工智能大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

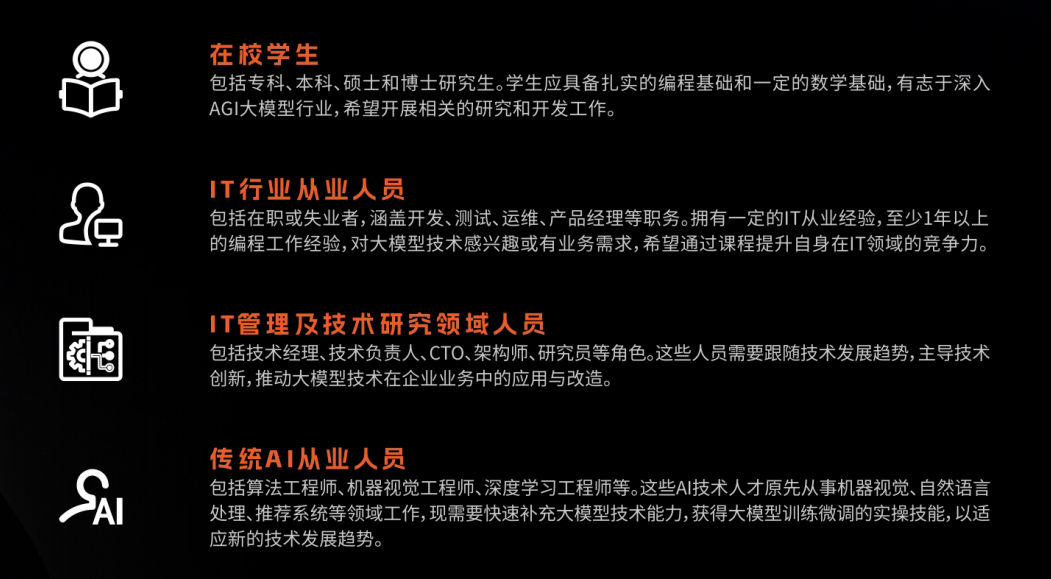

适合人群

- 在校学生:包括专科、本科、硕士和博士研究生。学生应具备扎实的编程基础和一定的数学基础,有志于深入AGI大模型行业,希望开展相关的研究和开发工作。

- IT行业从业人员:包括在职或失业者,涵盖开发、测试、运维、产品经理等职务。拥有一定的IT从业经验,至少1年以上的编程工作经验,对大模型技术感兴趣或有业务需求,希望通过课程提升自身在IT领域的竞争力。

- IT管理及技术研究领域人员:包括技术经理、技术负责人、CTO、架构师、研究员等角色。这些人员需要跟随技术发展趋势,主导技术创新,推动大模型技术在企业业务中的应用与改造。

- 传统AI从业人员:包括算法工程师、机器视觉工程师、深度学习工程师等。这些AI技术人才原先从事机器视觉、自然语言处理、推荐系统等领域工作,现需要快速补充大模型技术能力,获得大模型训练微调的实操技能,以适应新的技术发展趋势。

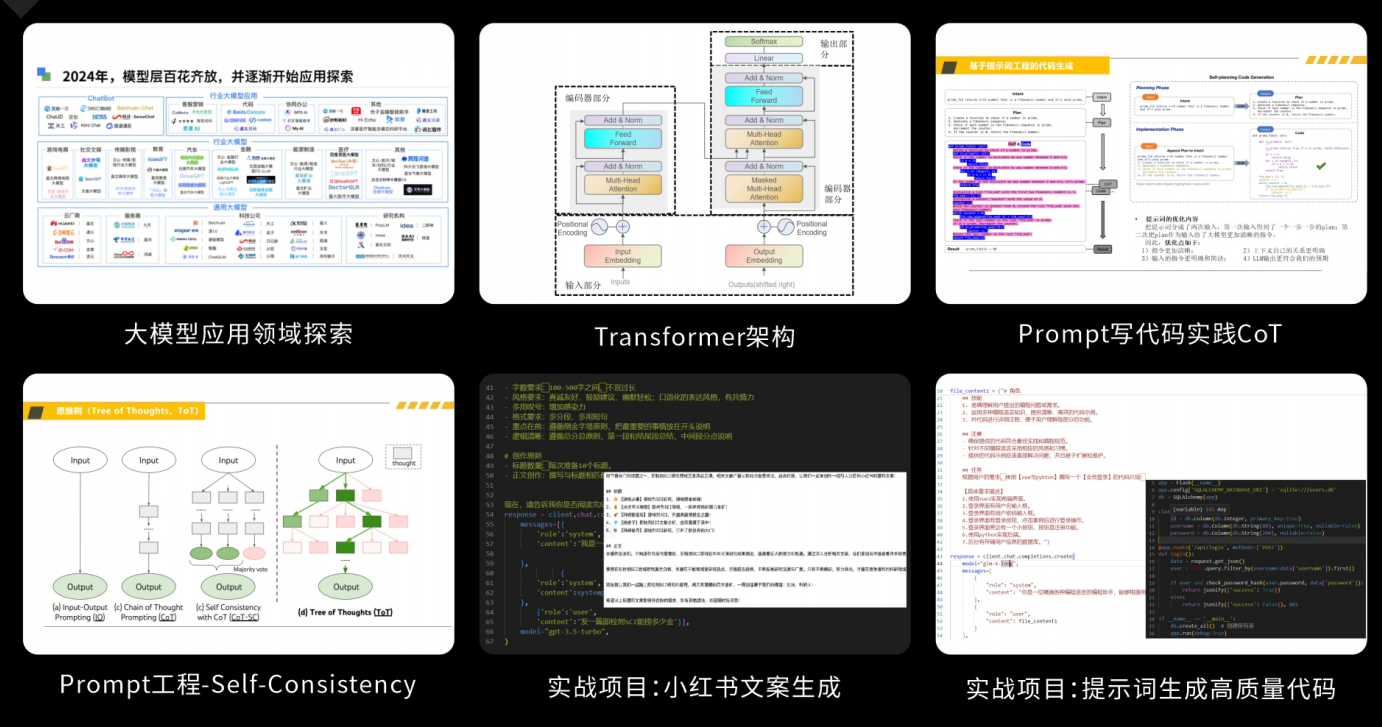

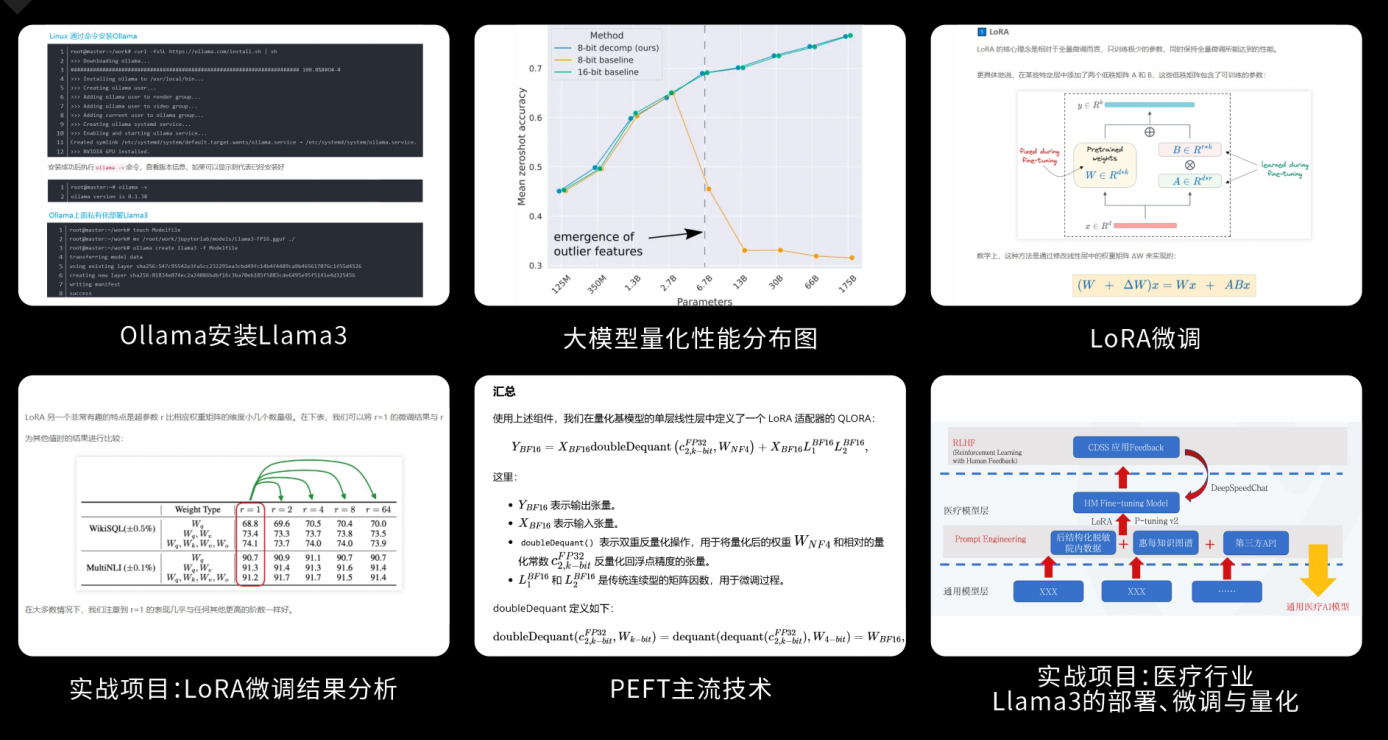

课程精彩瞬间

大模型核心原理与Prompt:掌握大语言模型的核心知识,了解行业应用与趋势;熟练Python编程,提升提示工程技能,为Al应用开发打下坚实基础。

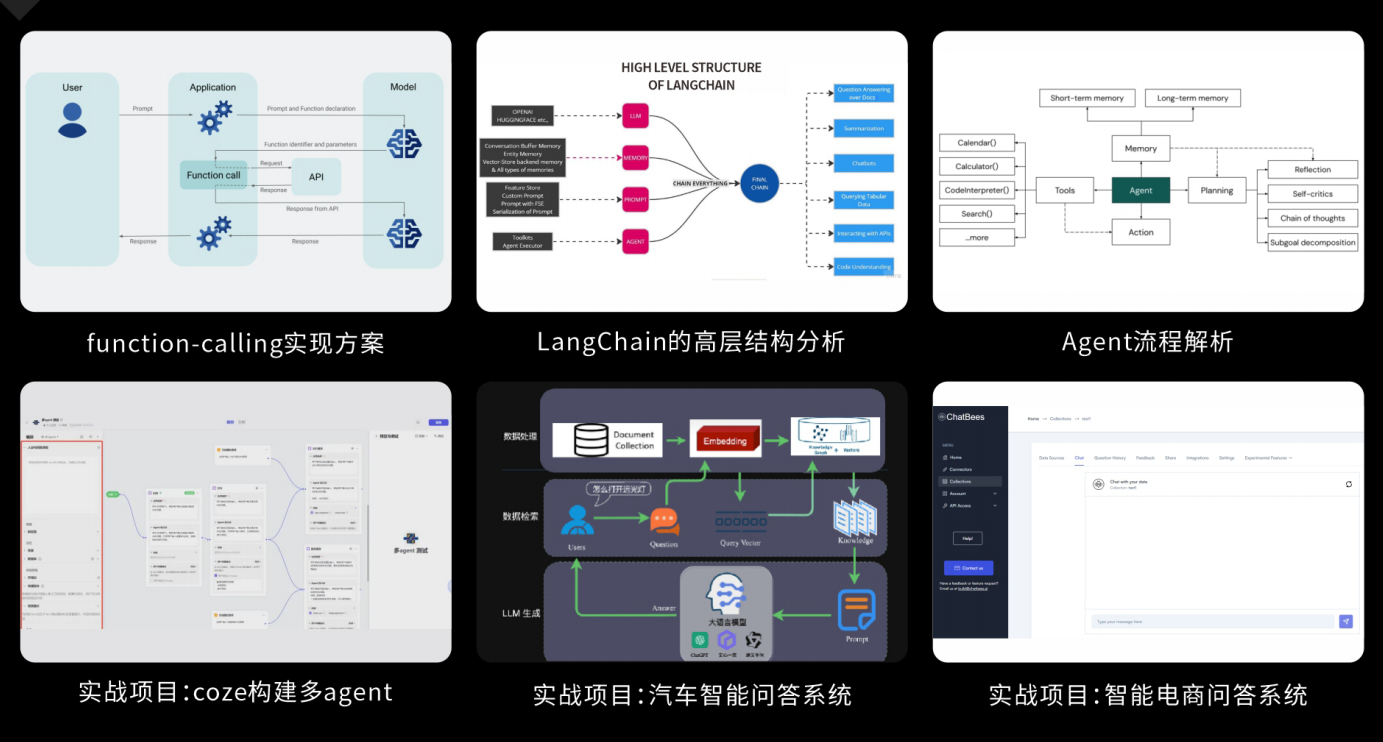

RAG应用开发工程:掌握RAG应用开发全流程,理解前沿技术,提升商业化分析与优化能力,通过实战项目加深理解与应用。

Agent应用架构进阶实践:掌握大模型Agent技术的核心原理与实践应用,能够独立完成Agent系统的设计与开发,提升多智能体协同与复杂任务处理的能力,为AI产品的创新与优化提供有力支持。

模型微调与私有化大模型:掌握大模型微调与私有化部署技能,提升模型优化与部署能力,为大模型项目落地打下坚实基础。

顶尖师资,深耕AI大模型前沿技术

实战专家亲授,让你少走弯路

一对一学习规划,职业生涯指导

- 真实商业项目实训

- 大厂绿色直通车

人才库优秀学员参与真实商业项目实训

以商业交付标准作为学习标准,具备真实大模型项目实践操作经验可写入简历,支持项目背调

大厂绿色直通车,冲击行业高薪岗位

文中涉及到的完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?