常关注AI大模型的童鞋可能会知道hugging face这个社区,国内也有同样的一个社区~魔搭,很多开源大模型都会上传到这两个社区。

比如今年常看到的DeepSeek、Qwen、Kimi、GLM等开源模型都会第一时间发布到hugging face和魔搭中,通过排名体现模型的能力和价值。

魔搭还有个比较好玩的功能-MCP广场,我很喜欢里面各种新奇好玩的MCP服务,配合DeepSeek、qwen等大模型一起用,能有想象不到的强大功能。

这里简单科普下MCP,它是模型上下文协议,是Claude提出来的,用于在模型中调用外部的工具和数据,比如说调用google搜索、高德地图、支付宝、12306等功能,给大模型增加了很多能力。

以下是MCP的官方科普:

MCP 是一个开放协议,它为应用程序向 LLM 提供上下文的方式进行了标准化。你可以将 MCP 想象成 AI 应用程序的 USB-C 接口。就像 USB-C 为设备连接各种外设和配件提供了标准化的方式一样,MCP 为 AI 模型连接各种数据源和工具提供了标准化的接口。

为什么选择 MCP?

MCP 帮助你在 LLM 的基础上构建代理(agents)和复杂的工作流。LLM 经常需要与数据和工具集成,而 MCP 提供了:

持续增长的预构建集成列表,LLM 可直接使用

灵活切换不同的 LLM 提供商和厂商

在你的基础设施内安全地处理数据的最佳实践

通用架构

MCP 核心采用客户端-服务器架构,主机应用可以连接多个服务器:

MCP Hosts: 如 Claude Desktop、IDE 或 AI 工具,希望通过 MCP 访问数据的程序

MCP Clients: 维护与服务器一对一连接的协议客户端

MCP Servers: 轻量级程序,通过标准的 Model Context Protocol 提供特定能力

本地数据源: MCP 服务器可安全访问的计算机文件、数据库和服务

远程服务: MCP 服务器可连接的互联网上的外部系统(如通过 APIs)

魔搭广场的MCP非常齐全,有点类似于GitHub的仓库,包括了开发者工具、搜索工具、日程管理、浏览器自动化等常用的MCP,应该有上千个。

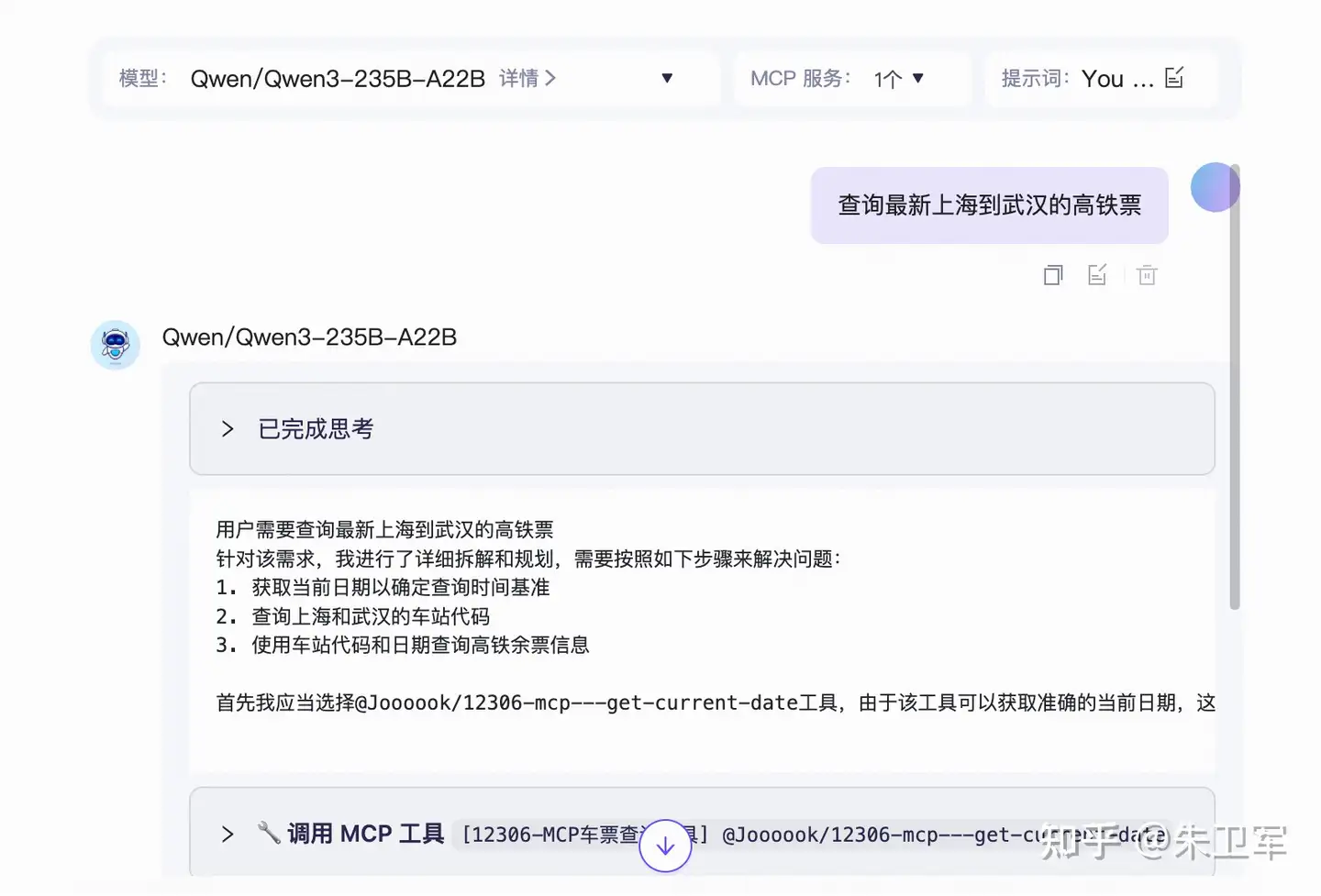

你可以在里面测试调用各种MCP功能,比如调用12306 MCP功能,查询高铁票。

最终大模型会调用MCP查询到相关火车票。

说实话MCP就像是AI的USB,用起来还是蛮方便的。

616

616

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?