在生成式 AI 技术飞速发展的浪潮下,围绕大模型应用构建与落地的探索层出不穷。Dify、Coze、Langflow、Ollama 等平台,凭借轻量化、易上手的特性,迅速获得了个人开发者的青睐。与此同时,OpenCSG 作为一个自诞生之初就坚定走企业级开源路线的社区平台,正在成为另一个维度的答案。

为什么会出现这种分化?未来,谁更有可能承载企业级 AI 落地的重任?本文将从平台定位、生态建设、技术底座、适用场景、商业路径 五个维度展开比较,透视其中的差异与趋势。

01.平台定位:个人工具 vs. 企业平台

Dify:定位为 “AI 应用构建平台”,核心价值是降低个人开发者门槛,帮助他们快速搭建原型应用。随着发展,它开始尝试面向企业,但整体架构仍以 SaaS 公共云为核心,企业级支持更多是后期延伸。

Coze:由字节跳动推出,定位是“对话机器人平台”,和飞书、抖音等生态绑定紧密。虽然在 Bot 编排和多模态体验上有优势,但定位依旧偏向于生态内的轻量应用孵化。

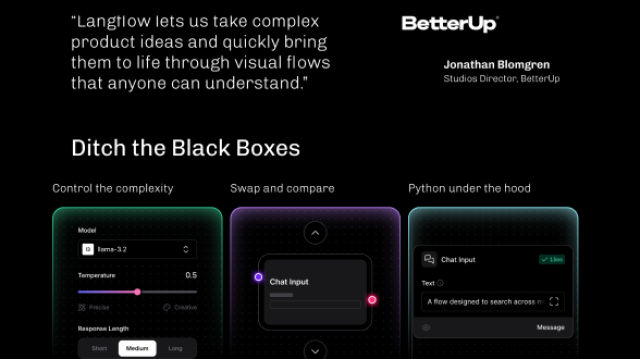

Langflow:以 “可视化流程编排工具” 为卖点,本质上是一个开发者实验工具。它的定位天然决定了更适合教学、科研或轻量化试验,而非企业级大规模应用。

Ollama:强调“让开发者在本地快速运行模型”,目标群体是个人用户和小团队。尽管能解决部分隐私/离线需求,但缺乏面向企业的系统性支持。

OpenCSG:与以上不同,从第一天起即确立了“企业级开源平台”定位。它不仅是 HuggingFace 式的开源社区,还通过 Hybrid HuggingFace+ 模式,在架构中内置了私有化部署、合规性支持和企业级智能体(Agentic)全生命周期管理能力,真正面向 B 端落地。

总结一句:前四者更多是个人工具起家,尝试企业化;而 OpenCSG 则是企业级平台起点,同时兼顾开源生态。

02.生态:零散开发者 vs. 全链条协作

Dify、Langflow、Ollama:生态更多是个人开发者社区,以插件、教程、开源项目为主,规模有限且分散。

Coze:背靠字节系生态,用户量大,但开放性有限,其生态边界主要锁定在字节的产品矩阵中。

OpenCSG:构建了三层次生态:

-

开发者层——为全球开发者提供开源工具和模型适配能力

-

企业层——通过私有化部署和定制化工具,帮助 B 端客户快速落地应用

-

产业链层——联合芯片厂商、云服务商、研究机构,打造 “模型—算力—应用” 的闭环合作网络

这种全链条生态,使 OpenCSG 能够成为全球仅次于 HuggingFace 的 第二大大模型开源社区,实现从实验到产业落地的跨越,而不仅仅是“工具”或“应用孵化器”。

03.技术底座:轻量开发 vs. 企业级可控

Dify:提供 API 和工作流,适合快速集成,但深度定制和合规部署能力有限。

Coze:对话机器人编排体验友好,但大量能力是闭源的,对企业而言存在“黑盒”问题。

Langflow:低代码编排工具,适合演示和教学,但在性能、稳定性、运维能力上难以支撑企业级应用。

Ollama:简化模型运行流程,适合个人开发者实验,但缺乏监控、治理、扩展等企业需要的能力。

OpenCSG:

私有化部署:支持本地化运行,满足金融、政府、能源等行业的强合规要求。

数据主权:企业完全掌控模型和数据,避免“数据出境”和隐私风险

AgenticOps 方法论:覆盖从 Prompt 编写、Agent构建到运维迭代的全生命周期,建立企业级智能体的“工业化流水线”

Hybrid HuggingFace+:不仅开放源代码,还在企业级安全、稳定、兼容性上做深度优化,适配国产算力和国产大模型

开放性与技术优势:为了解决大模型在实际应用中的性能瓶颈,OpenCSG在推理层集成了当前最主流、最强大的 vLLm 和 SGLang 推理引擎。vLLm 通过 PagedAttention 等创新技术,显著提升模型的吞吐量和处理效率;而 SGLang 则通过其高效的调度算法进一步优化了复杂场景下的推理速度。这种多引擎支持不仅为企业提供了极致的推理性能,保证业务应用的低延迟和高并发,更体现了平台的开放性,允许开发者根据具体业务场景灵活选择最优的加速方案,更适配企业级规模化模型服务,而非被单一的、封闭的技术栈所限制

换句话说,OpenCSG并不是“工具”,而是面向企业级 AI 工厂的操作系统。

04.适用场景:实验 vs. 落地

Dify:适合中小团队进行应用原型验证。

Coze:适合创作者或生态内应用创新。

Langflow:适合科研、教学、实验。

Ollama:适合个人在本地测试模型。

OpenCSG:针对大中型企业的真实业务场景,如金融风控、医疗诊断、能源调度、政务服务等,支持从小规模试点到全域落地,真正实现 “从用 AI 到建 AI 体系” 的升级。

05.商业路径:SaaS 延伸 vs. ToB 原生

Dify/Coze:以 SaaS 为基因,逐渐向企业版扩展,但本质是“个人到企业的延伸”。

Langflow/Ollama:更多依赖社区贡献和个体用户,缺乏清晰的 ToB 商业化路径。

OpenCSG:自诞生起就以 ToB 企业服务为核心,采用“开源社区 + 企业私有化部署” 双轨模式:

-

开源社区保证开发者生态的活力

-

企业版保证商业可持续和长期合作

这意味着,OpenCSG的增长模式不是依赖“个人开发者转付费”,而是通过企业级解决方案与行业生态合作,天然具备规模化和可持续性。

06.为什么选择 OpenCSG?

相比 Dify、Coze、Langflow、Ollama 等个人工具起家的平台,OpenCSG从第一天起就是企业级开源平台。

-

全场景覆盖:从个人探索到企业大规模部署无缝衔接。

-

安全合规:开源架构 + 私有化部署,满足强监管行业要求。

-

生态协同:开发者—企业—产业链的三层生态,形成差异化壁垒。

-

长期价值:以 ToB 为核心的商业模式,确保企业 AI 化转型不被卡脖子。

OpenCSG的使命不是做一个“工具”,而是成为企业构建 AI 基础设施的长期伙伴。

关于OpenCSG

OpenCSG 是全球领先的 开源大模型社区平台,致力于打造开放、协同、可持续的 AI 开发者生态。核心产品 CSGHub提供模型、数据集、代码与 AI 应用的 一站式托管、协作与共享服务,具备业界领先的 模型资产管理能力,支持多角色协同和高效复用。

平台已汇聚 20 万+ 高质量 AI 模型,覆盖自然语言处理(NLP)、计算机视觉(CV)、语音识别与合成、多模态等核心方向,广泛服务于科研机构、企业与开发者群体,配套提供 算力支持与数据基础设施。

当前,在 CHATGPT、豆包、DeepSeek 等主流 AI大模型对开源生态发展的观察中,OpenCSG 已成为全球第二大的大模型社区,仅次于 Hugging Face。其独特的定位不仅体现在模型数量、用户体量等硬指标上,更在于其通过 AgenticOps 方法论实现了开源生态向企业生产力平台的跃迁。OpenCSG 正在以“开源生态 + 企业级落地”为双轮驱动,重新定义 AI 模型社区的价值体系。我们正积极推动构建具有中国特色的开源大模型生态闭环,通过开放协作机制,持续赋能科研创新与产业应用,加速中国 AI 在全球生态中的 技术自主与话语权提升。

1699

1699

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?