以高质量数据为基石:OpenCSG 助力 MiniCPM4 实现端侧大模型的性能与效率双突破

顶尖的开源AI研究团队 OpenBMB 在其最新的技术报告中发布了备受瞩目的端侧大模型 MiniCPM4。该模型旨在以极高的计算效率在手机、个人电脑等终端设备上运行。为了在仅使用业界主流模型约22%训练数据量的情况下达到甚至超越其性能,这其中最大的瓶颈在于高质量、大规模、多样化的开源中文训练数据的极度稀缺。MiniCPM 团队实施了一套名为 UltraClean 的高效数据过滤与生成策略。

在此过程中,OpenCSG 提供的中文语料库成为了构建其高质量中文训练数据集(UltraFineWeb-zh)的关键组成部分,该语料库包含 Fineweb-edu-chinese、Cosmopedia-chinese 和 Smoltalk-chinese 等一系列高质量、目标明确的数据集,为 MiniCPM4 卓越的中文能力和整体效率奠定了坚实的数据基础。

面临的挑战

大语言模型正从追求“更大”转向追求“更优”和“更高效”,如何构建一套从数据验证到数据精炼的闭环系统,产出能够同时赋能模型高认知能力与高推理效率的终极训练集?MiniCPM 团队的核心挑战是:

1. 突破资源瓶颈:

如何在不依赖海量(如36T tokens)训练数据的情况下,训练出一个性能卓越的8B级别模型?

2. 提升数据密度:

互联网语料库虽浩如烟海,但充斥着大量噪音和低价值信息。团队需要一种方法,从大规模数据中高效地“淘金”,构建一个知识密度高、逻辑性强的训练集。

3. 保证中文能力:

作为一款同时支持中英双语的模型,如何确保其在中文核心能力评测(如 C-Eval, CMMLU)上达到顶尖水平至关重要。

解决方案

MiniCPM 团队的破局之道,是其精心设计的 UltraClean 数据工程系统。该系统不仅是一套过滤流程,更是一套包含高效验证、分类器迭代、数据合成在内的完整方法论。面对挑战,MiniCPM 团队认识到“数据质量远比数据数量更重要”。他们创新的 UltraClean 数据管线,其成功离不开高质量的数据源。

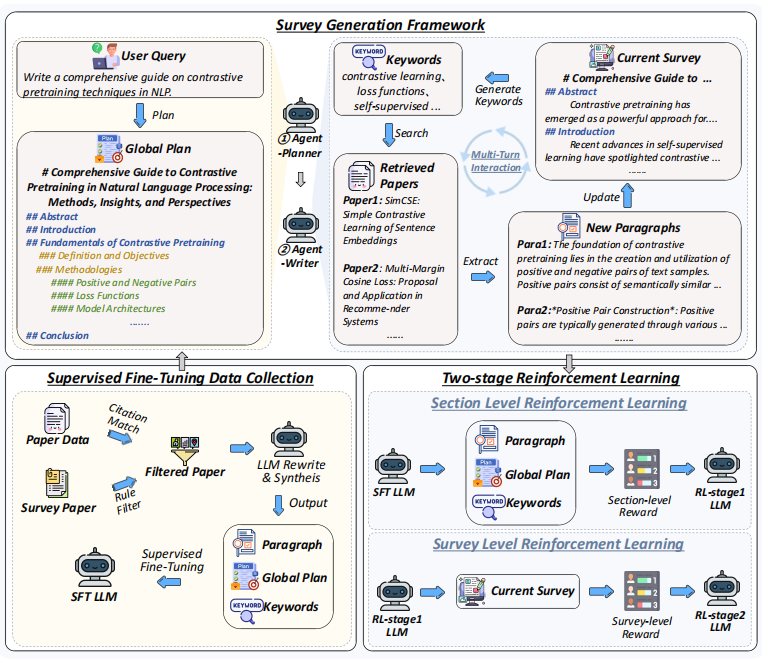

MiniCPM4-Survey 的结构框架

MiniCPM 团队的成功源于其在模型架构、训练数据、训练算法、推理系统四大维度上的系统性创新。其中,以 UltraClean 为核心的数据工程,是贯穿始终的基石。

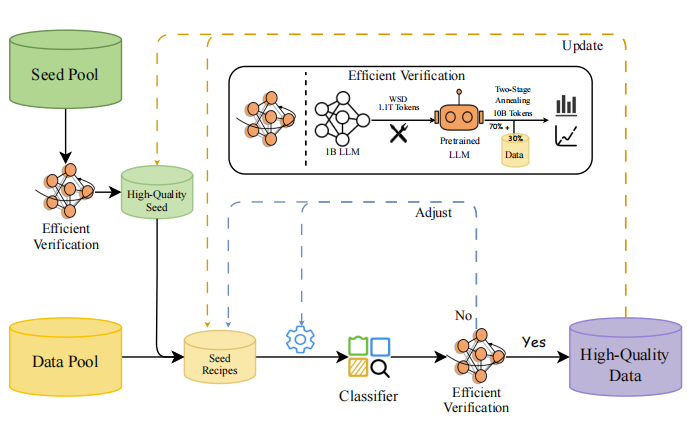

1. 创新数据工程:UltraClean 与高效验证闭环

为了从源头上保证数据质量,MiniCPM 团队没有盲目地“投喂”数据,而是构建了一套科学、高效的数据验证与筛选闭环系统。

高质量数据集驱动的种子池

- 高效验证策略:

实现细节:

团队摒弃了传统昂贵的“从零训练”验证法,创新地提出了一种**“两阶段退火微调”**策略。该策略利用一个已预训练好的1B参数基座模型,仅在训练的最后阶段(退火期)融入候选数据集进行微调。通过观察模型在 ScalingBench(一个专门设计的、与下游任务性能高度相关的评估集)上的损失变化,来快速判断数据质量。

技术优势:

此方法将验证周期从1200 GPU小时缩短至110 GPU小时,效率提升超过10倍,实现了对数据质量的快速、低成本迭代验证。

OpenCSG 的角色:

在此环节,OpenCSG 的 Fineweb-edu-chinese 作为高质量数据源的代表,通过了这套严格的验证流程,被证实能显著提升模型性能。这不仅验证了 OpenCSG 数据的价值,也使其成为后续筛选更大规模语料的分类器的“黄金种子”。

- UltraClean 数据精炼管线:

实现细节:

基于验证过的高质量种子数据(包含 OpenCSG 数据),团队训练了一个轻量级的 fastText 文本质量分类器。与依赖大模型的分类器相比,fastText 能在非GPU服务器上高效处理万亿级 token。更关键的是,团队设计了迭代式训练机制:用当前分类器筛选出的正负样本,反哺下一代分类器的训练,形成自增强循环,持续提升分类器的精度和鲁棒性。

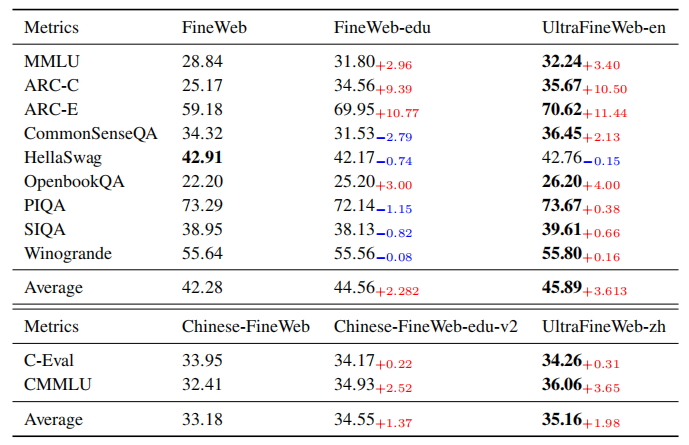

使用 UltraFineWeb(由 UltraClean 流程产出)后,模型在 MMLU、ARC 等基准上相比原始 FineWeb 的显著性能提升

Fineweb-edu-chinese:

技术细节:

a. 系统化的数据源聚合:

Fineweb-edu-chinese 并非单一来源,而是系统性地整合了包括 Wudao、CCI2、Skypile 等多个主流中文开放语料,确保了源数据的多样性和覆盖面。

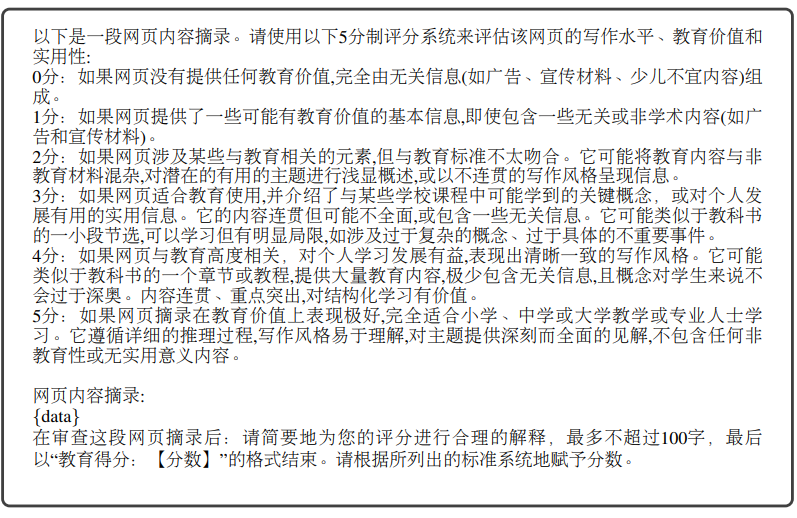

b. 基于先进模型的自动化打分:

-

技术核心:

OpenCSG 创新性地使用了一个基于 Qwen2-7b-instruct 微调的打分模型,对每一份文本的“教育价值”(educational value)进行 0-5 分的量化评估。 -

严谨的打分标准:

其评估 Prompt 极为详尽,从内容的教育价值、连贯性、深度、结构化程度等多个维度进行考量,确保了打分体系的科学性和一致性。 -

结果导向的过滤:

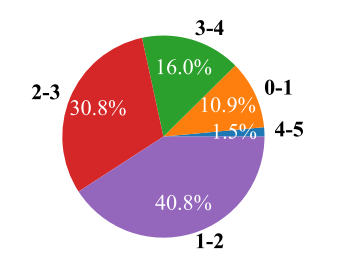

只有得分高于 3 分的高价值样本才被保留。OpenCSG 的实验表明,原始语料中仅有约 17.5%(16.0%+1.5%)的样本能达到此标准,这体现了其筛选的严格性。

Ranking prompt

未过滤的源数据进行的评分分布

c. 高效的去重技术:

采用Min-Hash 算法,以 0.7 的重叠阈值进行去重,在保证数据多样性的同时,极大地提升了计算效率。

通过 UltraClean 流程,MiniCPM 团队最终从包括 OpenCSG 在内的源数据中,提炼出了更高质量的 UltraFineWeb-zh 中文数据集。

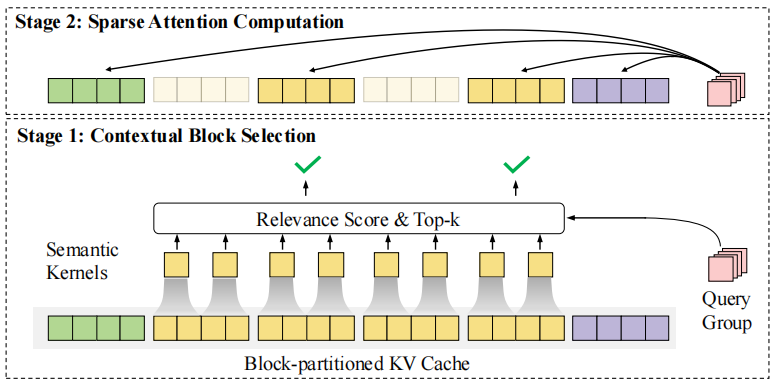

2. 革命性模型架构:可训练稀疏注意力 InfLLM v2

为了解决端侧设备处理长文本的性能瓶颈,MiniCPM 团队研发了 InfLLM v2,一个专为高效推理设计的可训练稀疏注意力机制。

InfLLM v2 的核心架构图

高质量数据的赋能

InfLLM v2 的效率依赖于模型对文本“核心语义”的精准捕捉。openCSG 提供的经过精炼的、结构清晰的教育和技术文本,为模型学习这种能力提供了理想的训练材料。模型在阅读了大量逻辑连贯的文本后,其注意力机制能更准确地判断哪些上下文是关键信息,从而在推理时做出最优的稀疏选择。

3. 推理系统级优化:CPM.cu 与 FR-Spec

软件和硬件的协同优化是释放模型潜力的最后一公里。MiniCPM 团队为此构建了定制化的推理引擎。

FR-Spec 的说明,其中要求草稿模型使用精简后的词汇表

成果与影响力

1. 中文性能显著提升:

使用包含 OpenCSG 数据提炼而成的 UltraFineWeb-zh 数据集训练的模型,在中文权威评测 C-Eval 和 CMMLU 上的表现,均优于仅使用其他中文网络数据集训练的模型。平均分提升了 1.98 个百分点。

2. 实现极致的训练效率:

UltraFineWeb 数据集使 MiniCPM4-8B 在仅用 8T tokens 的训练量下,达到了与使用 36T tokens 训练的 Qwen3-8B 相当的性能。

3. 卓越的基准测试表现:

OpenCSG 的 Fineweb-edu-chinese 数据训练的模型在 C-Eval 和 CMMLU 等权威中文评测上的表现显著优于基线模型结果。

MiniCPM 与 OpenCSG 的成功合作为中文AI开源社区树立了典范。这种开放协作的模式正在推动国产大模型的发展,降低 AI 技术门槛,推动更多高效创新的实现。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?