Spark3报错: hive.ql.metadata.HiveException: Unable to fetch table Invalid method name: ‘get_table_req’

- 环境

hive版本1.1.0-cdh-5.10scala版本2.11.11hadoop版本2.6.0

我之前用的是spark的2.4.4的发行版的包,现在想切换成spark3.0版本包。

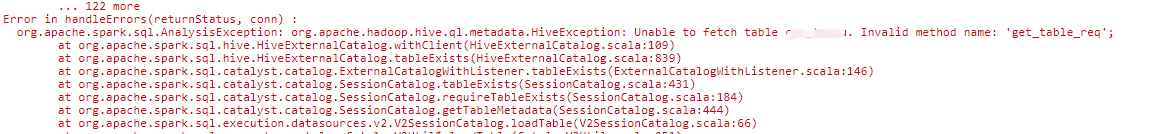

调用spark.sql("select * from xxxDbname.xxtable")便会出现下面的错误。

报错截图如下:

这里我用的spark的包是spark官网上的

spark-3.0.0-preview2

这个版本,它打包的hive版本是2.3.6

而我所用的hive版本是1.1.0

所以会报出上述错误,相关的错误原因我已经在源码上面查看到了

错误详情:

去github上面直接

Spark3与Hive版本不兼容导致的get_table_req错误

Spark3与Hive版本不兼容导致的get_table_req错误

在尝试使用Spark 3.0.0-preview2版本时,遇到HiveException:Unable to fetch table,错误源于get_table_req方法在该版本中未找到。问题出在Spark版本与Hive版本的不匹配,Spark依赖的Hive版本不包含此方法。解决方案是手动构建Spark发行版包,指定Hive版本为与源码兼容的版本。

在尝试使用Spark 3.0.0-preview2版本时,遇到HiveException:Unable to fetch table,错误源于get_table_req方法在该版本中未找到。问题出在Spark版本与Hive版本的不匹配,Spark依赖的Hive版本不包含此方法。解决方案是手动构建Spark发行版包,指定Hive版本为与源码兼容的版本。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1720

1720

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?