0. Abstract

背景:

多模态医学图像融合现有方法主要基于特定的变换理论。现有算法存在诸多问题,如适应性差、效率低、细节模糊等。

工作:

本文提出了一种基于双流注意力机制的生成对抗网络(DSAGAN),用于解剖和功能图像融合。

- 双流架构和多尺度卷积被用于提取深度特征。

- 注意力机制被用来进一步增强融合特征。

- 融合图像和多模态输入图像被输入判别器。

结果:

DSAGAN在融合时间上消耗更少,并在QAGQ_{AG}QAG、QENQ_{EN}QEN和QNIQEQ_{NIQE}QNIQE等客观指标上表现更优。

1. Introduction

现有算法基本包括三个过程:图像变换、融合规则和逆变换。

图像变换是通过特定算法将图像空间转换到其他空间以进行处理和分析的过程,

图像逆变换则是将其他空间转换回图像空间的过程,是图像变换的逆操作。

图像变换过程通常在特定的变换域中完成。

融合规则是一种用于特征融合的特定数学算法,其目的是将两个或多个特征融合为单一特征。

多尺度变换(MST) 利用灵活的融合规则提取不同尺度的信息以提高融合质量。

Chen等人[6]提出了一种基于目标增强MST的红外与可见光图像融合算法。

目前,许多基于MST的融合算法已被提出,例如小波变换[78]、剪切波变换[9–10]、金字塔变换[11–12]、非下采样剪切波变换(NSST)[13–14]

以及非下采样轮廓波变换(NSCT)[15–17]。

基于MST的融合算法容易出现信息丢失,导致细节模糊和边缘退化。

基于稀疏表示(SR) 模型的图像融合算法被提出[18–20]。

Liu和Wang[21]提出了一种基于自适应稀疏表示的融合算法。

Zhang和Levine[22]提出了一种多任务稀疏表示融合算法。

Li等人[23]提出了一种基于群稀疏表示的融合与去噪算法。

**基于SR的融合方法主要依赖于优化字典,这些方法具有节省存储空间和应用范围广的优势。然而,基于SR的融合算法依赖于优化模型的结果,不同的优化算法和融合策略对融合质量有不同的影响。此外,优化过程非常复杂。

**

大多数现有算法采用特定理论进行图像变换和融合,导致融合过程中存在大量参数。因此,这些算法具有较高的复杂度和较大的计算量。此外,设计

融合规则非常复杂且困难,不同变换域需要不同的规则,降低了方法的通用性。

Ian Goodfellow [24] 提出了生成对抗网络(GANs)。

WGAN [25,26] 利用 Wasserstein 距离来衡量真实分布与生成分布之间的误差。

Mao 等人提出了 LSGAN [27] 用于生成图像和字符。

LSGAN 采用均方误差(MSE)作为损失函数,取得了更好的效果。

由于在融合过程中丢失了详细信息,融合图像的边缘强度较弱且细节模糊。

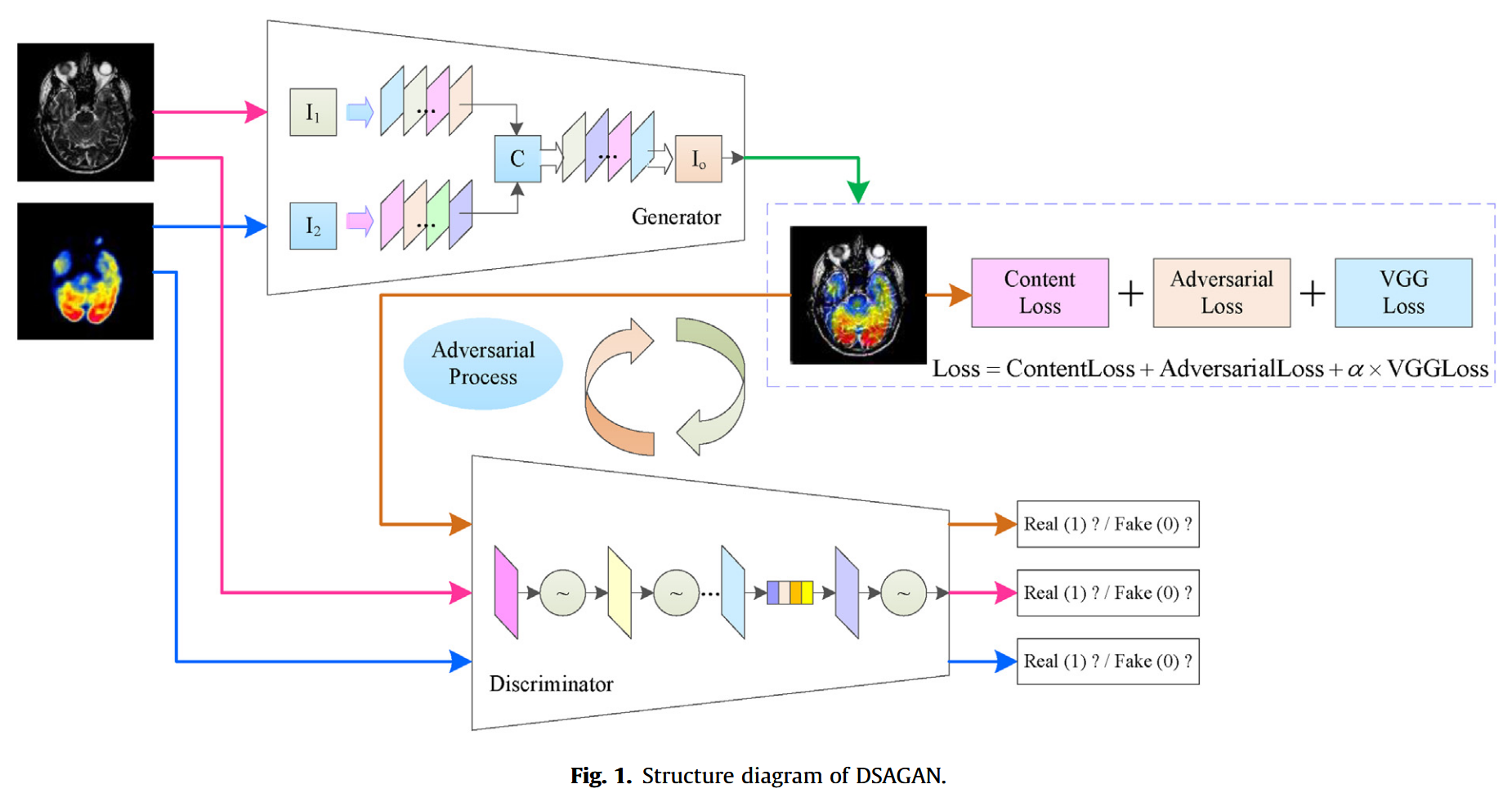

本文提出了基于双流架构和注意力机制的DSAGAN,用于解剖和功能图像的融合。DSAGAN的结构图如图1所示。本文的贡献总结如下。

- DSAGAN 提出用于解剖和功能医学图像融合。该模型采用双流架构提取多尺度特征,并利用注意力机制增强提取的特征以提高融合质量。

- 本文介绍了 DSAGAN 的架构和原理,并从理论上证明了其收敛性和稳定性。此外,我们讨论了所提算法与参考算法在融合图像直方图上的差异,并对像素分布的合理性进行了分析。

- DSAGAN 是一种端到端模型,一旦训练完成,即可直接输出融合图像,无需其他操作。与现有算法相比,DSAGAN 的融合时间更短。

- DSAGAN 的融合图像边缘更清晰、细节更丰富,在客观指标上优于对比算法。

2. Related works

2.1. Traditional fusion methods

大多数早期的医学图像融合算法都是基于变换域的。

易于实现、策略灵活

常用的变换域包括MST和SR,它们是大量融合算法的基础理论。

Liu等人[28]提出了一种基于MST和SR的通用图像融合框架,结合了二者的优势。

不同的变换域和模型具有不同的融合质量,需要特定的融合规则。

需要调整和优化的参数和系数较多,增加了计算量。

在图像变换和逆变换过程中容易丢失细节信息。

算法复杂、通用性差、效率低和边缘模糊等。

2.2. DL-based fusion methods

[29]提出了一种基于深度学习的无监督多曝光图像融合算法。

Li等人[30]提出了用于红外与可见光图像融合的DenseNet。

[31]提出了一种基于卷积神经网络(CNN)的多焦点图像融合算法。该算法利用CNN提取权重图,并将其用于高斯金字塔中的融合过程。

基于深度学习的融合算法依赖于网络架构和损失函数,这些因素难以选择且相互适应。

2.3. GAN-based fusion methods

基于GAN的融合算法原理相同,仅在网络结构和损失函数上略有差异。

FuseGAN 在文献 [32] 中被提出并应用于多焦点图像融合。

FusionGAN 在文献 [33] 中被提出并应用于红外与可见光图像融合。FusionGAN 结构简单,包含 5 个卷积层、4 个批归一化层、4 个 Leaky

ReLU 激活层和 1 个 tanh 激活层。

DDcGAN在[34]中被提出,并应用于医学图像和红外-可见光图像融合。

3. Proposed algorithm

3.1. Generator

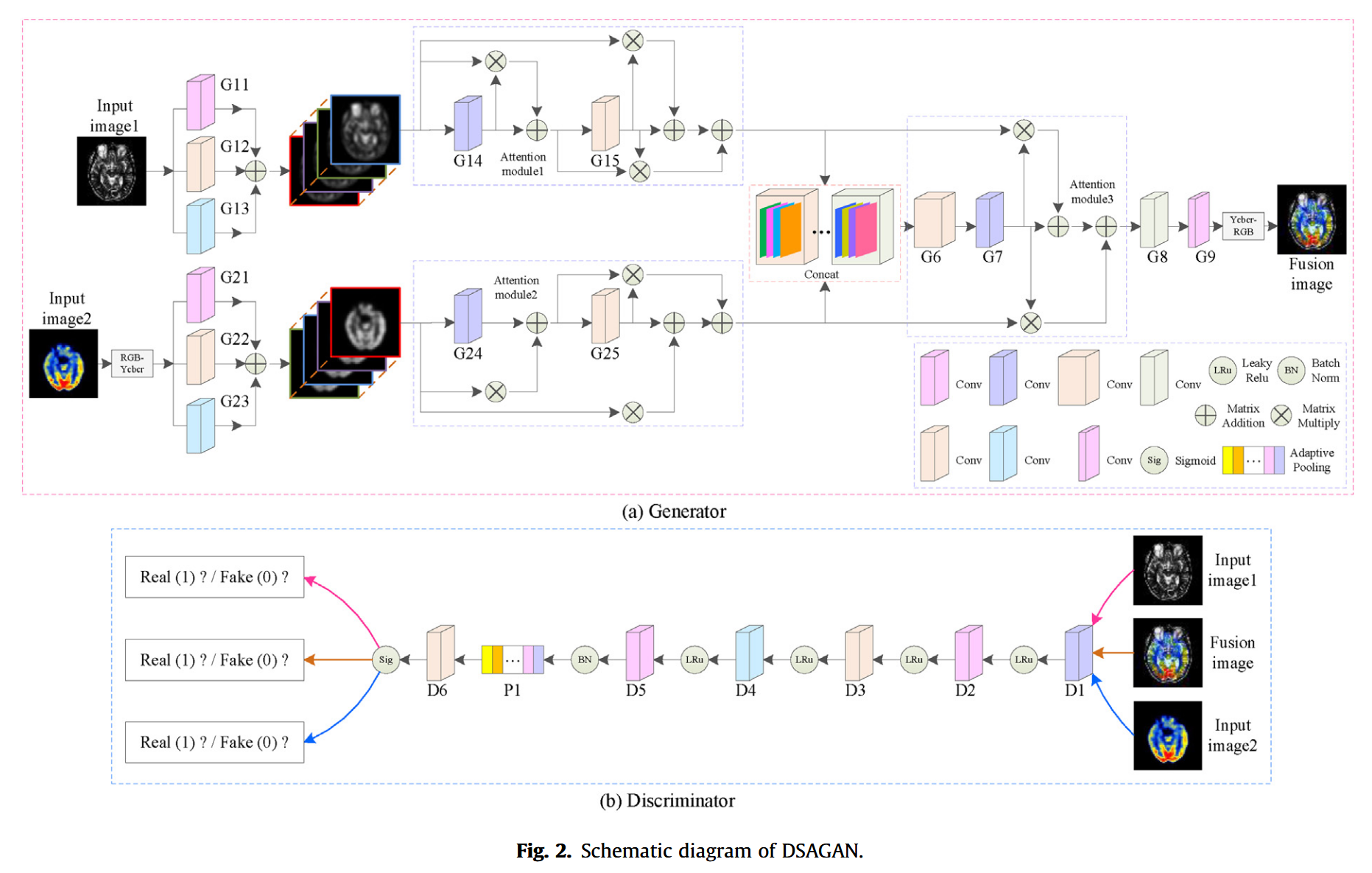

生成器的目的是生成融合图像。

解剖图像为灰度图像,作为图像1;功能图像为彩色图像,作为图像2。

首先,通过RGB-Ycbcr变换获取图像2的亮度图像。

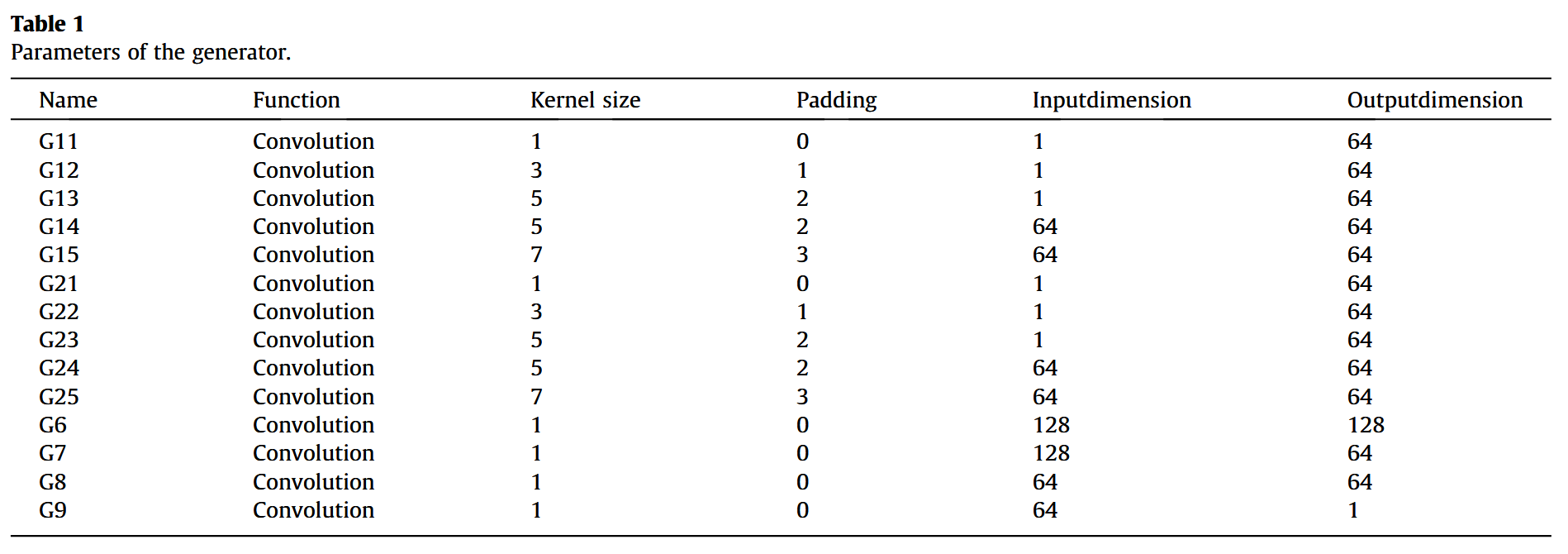

随后,生成器利用双流结构和注意力机制提取多尺度特征。多尺度提取模块中应用了1×1、3×3和5×5卷积核。5×5和7×7卷积核用于提取深层特征,并通过空间注意力机制进行增强。

增强后的特征进行拼接以获得融合特征。经过三次1×1卷积操作,融合特征从128维降至64维。

然后,融合特征再次通过注意力机制增强。最后,通过一次1×1卷积将融合特征从64维降至1维,得到亮度图像。经过Ycbcr-RGB变换后,生成融合图像。

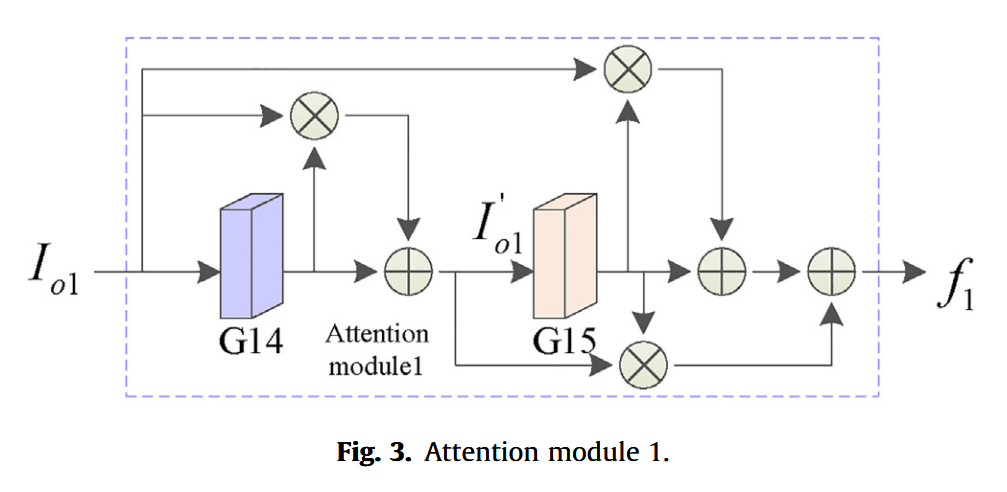

生成器的参数如表1所示。算法中包含三个注意力模块。注意力模块1和注意力模块2构成双流注意力机制,用于增强提取的多尺度特征。注意力模块3用于增强拼接后的特征。

三个注意力模块介绍如下。

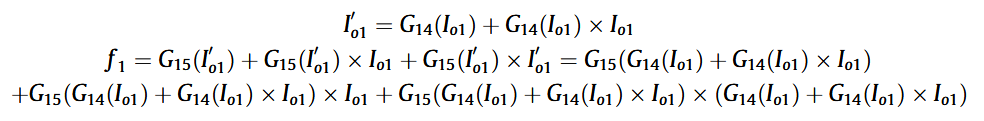

注意力模块1如图3所示,包含两次卷积操作、三次乘积操作和三次加法操作,可用公式(2)表示。

其中Io1=G11(I1)+G12(I1)+G13(I1)I_{o1} = G_{11}(I_1) + G_{12}(I_1) + G_{13}(I_1)Io1=G11(I1)+G12(I1)+G13(I

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

7418

7418