在AI技术飞速发展的今天,应用开发者正面临着一个日益严峻的挑战:如何从海量、异构的AI模型中,高效、稳定地选取并集成最适合自身业务的模型?传统的API调用方式,虽然是连接服务的基石,但在AI模型的集成上,往往显得不够聚合,不够灵活。

Nebula API作为一个一站式的大模型API平台,提供了灵活的AI集成、开箱即用的API服务以及模型部署的托管服务,极大地简化了AI应用的开发流程。

一、传统API调用的挑战:碎片化与低效率

传统的API调用模式,我们通常会经历以下步骤:

1)模型选型与研究: 针对具体需求,开发者需要调研市面上不同的AI模型提供商,了解各家模型的性能、适用场景、价格以及API文档。

2)独立接入与适配: 每个模型可能都有其独特的API接口、认证方式和数据格式。开发者需要为每一个模型编写独立的集成代码,进行参数适配、数据格式转换等繁琐工作。

3)版本管理与维护: 随着模型更新迭代,开发者需要持续关注API版本的变化,并及时更新自己的集成代码,以保证服务的稳定性和先进性。

4)多模型协同复杂: 当应用需要调用多个不同模型的服务时(例如,先进行语音识别,再进行文本翻译,最后生成图像),这种碎片化的API调用模式会急剧增加集成的复杂度和潜在的错误点。

这些挑战导致AI应用的开发周期被拉长,成本增加,并且难以快速响应市场变化。

二、Nebula API 的革新之处:统一、灵活、高效

Nebula API 通过其设计理念和功能特性,有效解决了传统AI模型集成中的痛点:

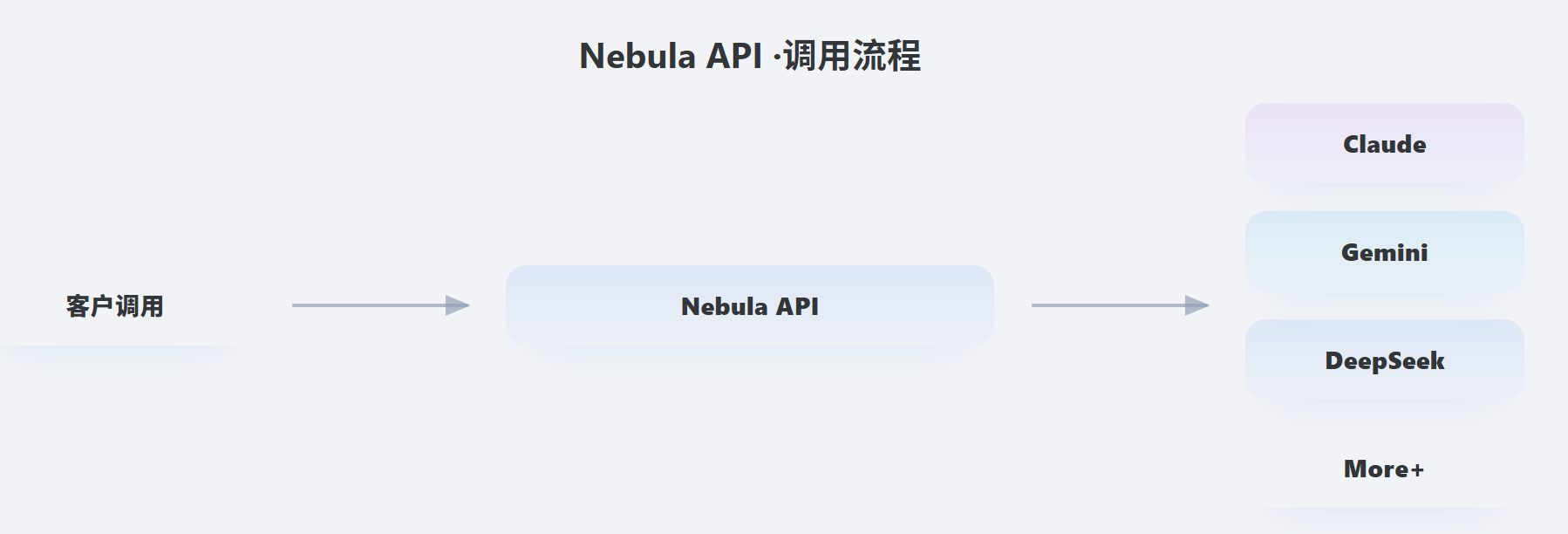

1、统一的接入层

- 传统模式: 客户调用 → 多个独立的模型API。

- Nebula API 模式: 客户调用 → Nebula API → (Claude, Gemini, DeepSeek, More+等)。

Nebula API 充当了一个“AI模型聚合器”和“标准化接口层”。无论您需要调用的是Claude、Gemini还是其他模型,只需通过Nebula API这一套接口。这极大地简化了开发者的接入工作,避免了为每个模型维护一套独立接口的麻烦。

2、模型托管与赋能多模态

- 传统模式: 开发者可能需要自行管理模型的部署和运维。

- Nebula API 模式: 提供“模型部署的托管服务”,开发者“无需关注底层资源与运维”。这意味着Nebula API平台负责模型的稳定运行、资源调度和性能优化,开发者则可以更专注于业务逻辑。

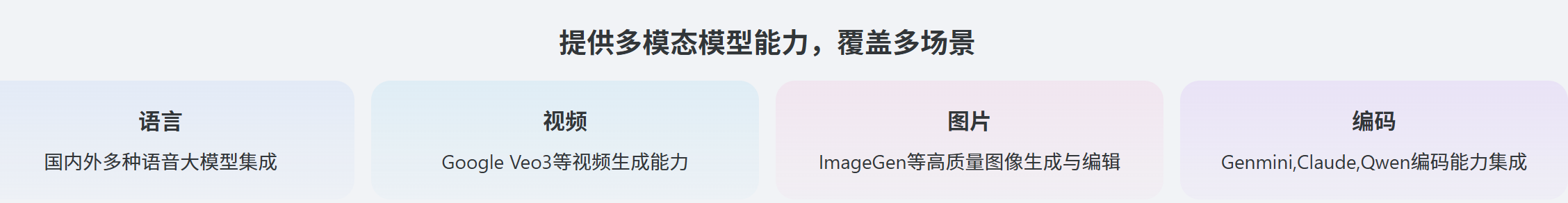

Nebula API 不局限于单一模态,而是提供多模态能力,覆盖多场景,包括语言、视频、图片、编码等。这使得开发者可以轻松地将多种AI能力组合起来,构建更复杂、更智能的应用,例如:

a、通过语音API输入,结合图片生成API输出。

b、通过文本API进行分析,再调用编码API生成代码。

3、开箱即用与按需付费

- Nebula API 的“开箱即用的大模型API+”特性,让开发者可以直接调用,无需繁琐的配置。

- “按量计费”的模式,让成本控制更加灵活,尤其适合初创公司或需要快速试错的项目。

4、灵活的AI集成

Nebula API 提供了“提供灵活的AI集成”的能力,针对“不同行业及需求场景”,提供“灵活的解决方案”。这表明平台不仅提供标准API,还可能支持定制化集成或优化服务,以满足更精细化的业务需求。

AI模型集成正从“碎片化调用”迈向“平台化、统一化”的时代。Nebula API通过提供标准化的接口、托管化的服务以及对多模态能力的整合,极大地降低了AI应用的开发门槛和复杂性,让开发者能够更专注于释放AI的巨大潜力,构建更具创新性和竞争力的产品。对于那些希望在AI时代快速布局并取得成功的企业和开发者而言,Nebula API 无疑是一个值得重点关注的利器。

NEBULA DATA 星雲數據 ,行业领先的云网一体化及智能算力服务提供商![]() https://www.nebula-data.com/

https://www.nebula-data.com/

1061

1061

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?