日志流量分析取证

声明

学习内容来自 B 站UP主泷羽sec,如涉及侵权马上删除文章。

笔记的只是方便各位师傅学习知识,以下网站只涉及学习内容,其他的都与本人无关,切莫逾越法律红线,否则后果自负。

✍🏻作者简介:致力于网络安全领域,目前作为一名学习者,很荣幸成为一名分享者,最终目标是成为一名开拓者,很有趣也十分有意义

🤵♂️ 个人主页: @One_Blanks

欢迎评论 💬点赞👍🏻 收藏 📂加关注+

- 关注公众号:泷羽Sec-Blanks

目录

同款Kali链接

https://pan.quark.cn/s/097b4bfd5ecc

Kali官方的日志练习文件

介绍:

这是一个被攻击者的日志,我们需要对这个日志进行分析并且溯源

准备

创建一个操作目录并进入

mkdir loggg

cd loggg

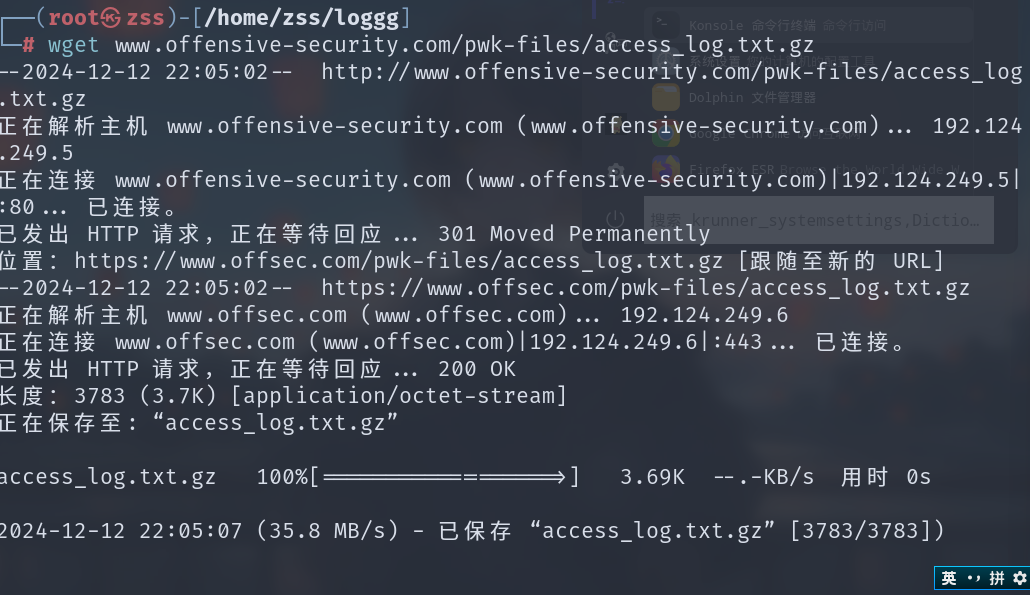

使用wget加URL进行文件下载

wget www.offensive-security.com/pwk-files/access_log.txt.gz

wget是一个从网络上自动下载文件的自由工具,支持通过 HTTP、HTTPS、FTP 等常见的 TCP/IP 协议下载,并可以使用 HTTP 代理。

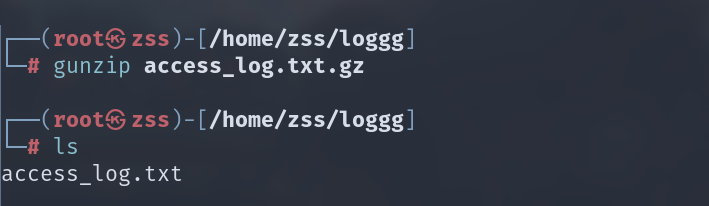

使用gunzip工具进行解压

gunzip access_log.txt.gz

gunzip是一个用于解压缩文件的工具,主要用于解压被gzip压缩的文件。

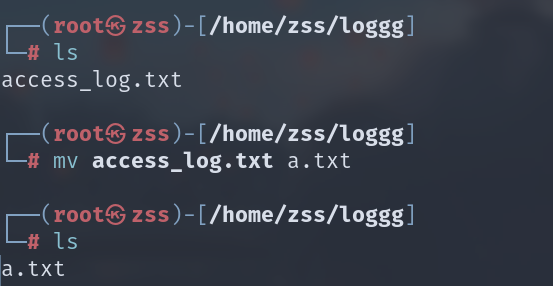

改个名字方便操作

mv access_log.txt a.txt

操作与分析

利用cat查看并结合数据文本处理命令分析

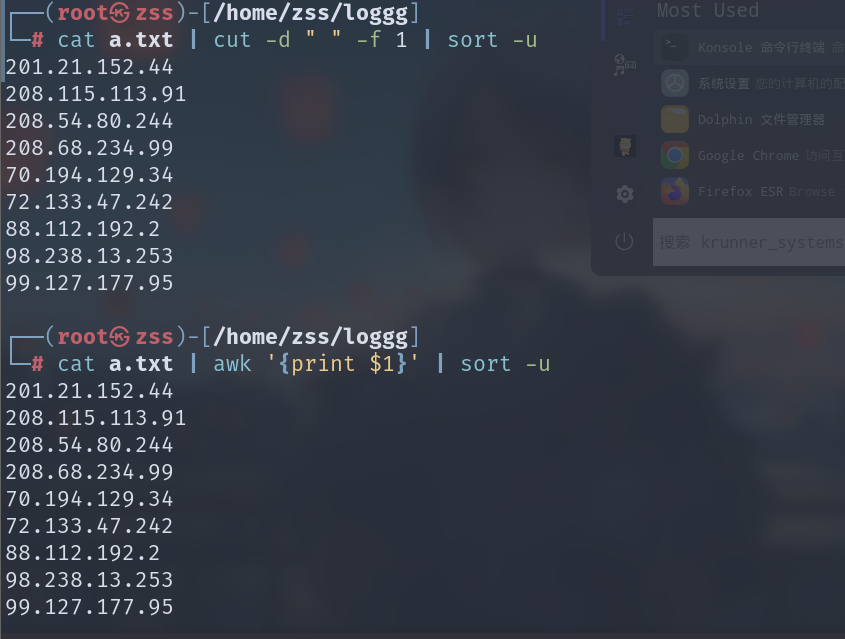

查看访问服务器的IP

cat a.txt | cut -d " " -f 1 | sort -u

或

cat a.txt | awk '{print $1}' | sort -u

- cat [文件] 进行文件数据查看并且将数据显示到终端中来

- cut 文本内容提取工具 ,

-d " "设置分隔符为空格,-f 1表示提取分隔后的第一部分的内容 - awk 与cut类似也是文本内容提取工具,

-F设置分隔符,这里没有写出表示默认分隔符为空格,$1表示显示出分隔后的第一部分的内容 - sort 排序命令,

-u表示对数据内容进行去重操作

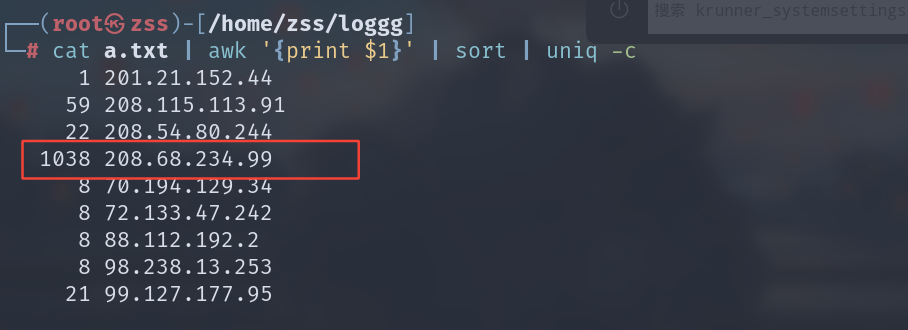

但是只看访问的ip信息还是不能得出什么有效结论,所以我们对ip访问的次数进行统计

筛选出攻击者

cat a.txt | awk '{print $1}' | sort | uniq -c

- sort 这里就直接进行排序,因为要统计出现次数就不进行去重操作了。

- uniq 数据统计命令,

-c选项表示对数字进行统计

- 这里也可以使用

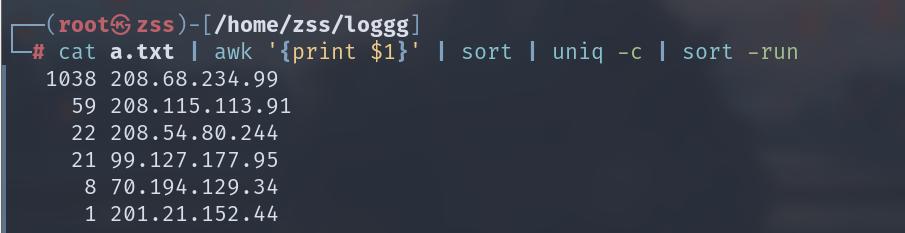

sort -run进行一个数字排序

cat a.txt | awk '{print $1}' | sort | uniq -c | sort -run

查看输出结果,并且找到了一个访问了1000+次数的ip,那我们就找到了攻击者(恶意IP)

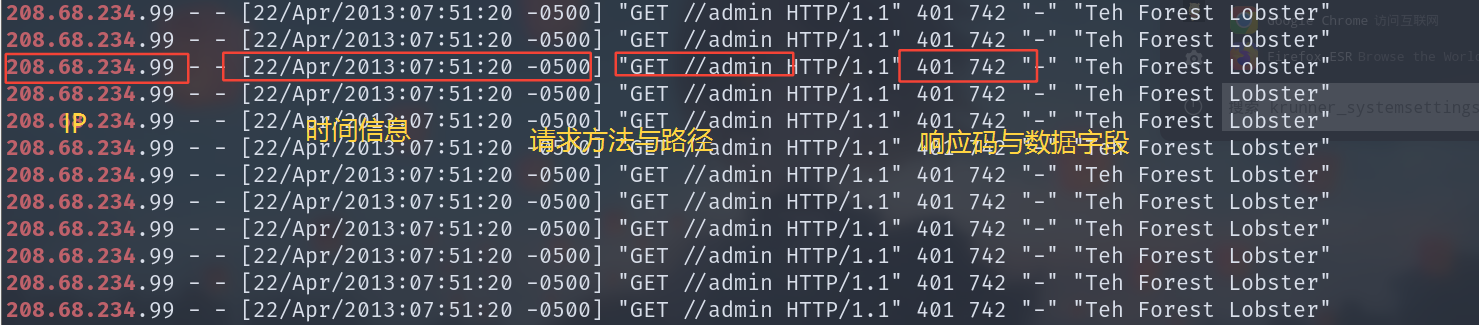

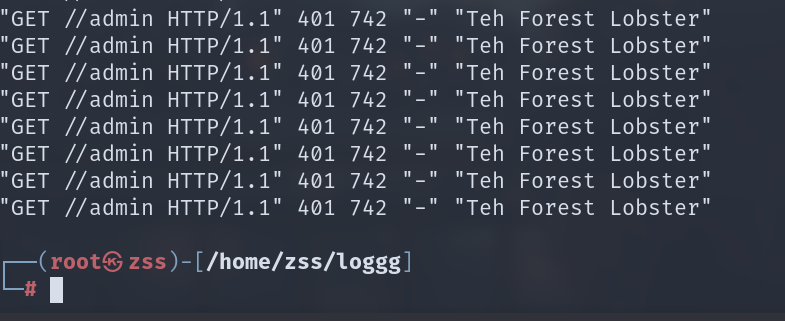

将这个IP的请求信息筛选出来看看它攻击的是哪个业务

cat a.txt | grep 208.68.234.99

再筛选只留有用信息(响应信息)

cat a.txt | grep '208.68.234.99' | awk -F "] " '{print $2}'

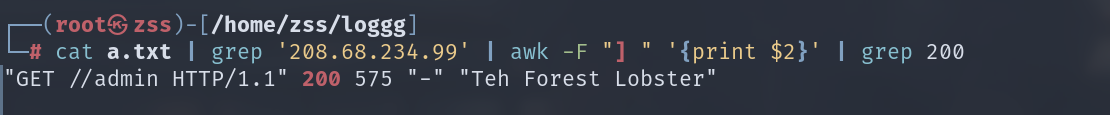

进一步检索,查看攻击者是否成功

cat a.txt | grep '208.68.234.99' | awk -F "] " '{print $2}' | grep 200

发现攻击者已经攻击成功,并且IP为:208.68.234.99

67

67

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?