问题1:All master are unresponsive! Giving up.

问题1—提交代码的方式:spark-submit connectedComponentAnalysis.py --master yarn --deploy-mode cluster --executor-memory 3g --num-executors 10

问题1—代码环境配置:

conf = SparkConf()

conf.setAppName("cca")

sc = SparkContext(conf=conf) # 必须带参数名

解决方法:

在代码中配置 yarn

conf = SparkConf()

conf.setAppName("cca").setMaster("yarn")

sc = SparkContext(conf=conf) # 必须带参数名

原因:不太清楚

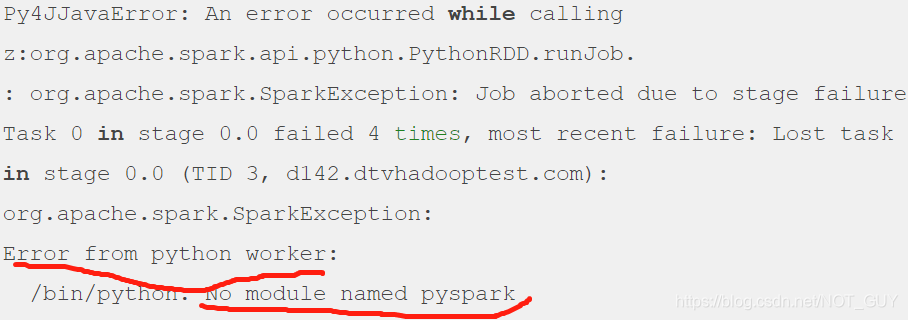

问题2:Error from python worker: /bin/python. No module named pyspark.

问题2—代码

conf = SparkConf()

conf.setAppName("c

这篇博客详细记录了在使用PySpark时遇到的三个主要问题:1) Master节点响应失败;2) Python工作进程找不到pyspark模块;3) Python版本不匹配。针对这些问题,博主给出了相应的解决策略,包括配置YARN、调整环境变量和确保Python版本一致。

这篇博客详细记录了在使用PySpark时遇到的三个主要问题:1) Master节点响应失败;2) Python工作进程找不到pyspark模块;3) Python版本不匹配。针对这些问题,博主给出了相应的解决策略,包括配置YARN、调整环境变量和确保Python版本一致。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1272

1272

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?