全连接网络(FC)、前馈神经网络(BP)、多层感知机(MLP)三种称呼实质是一样的。以全连接网络为例讲解训练过程。

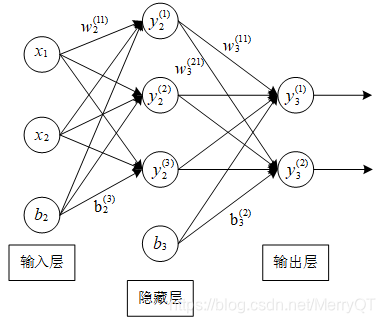

全连接网络实际上可以看作由多个隐藏层(dense)组成的网络模型,隐藏层的每个节点都与上一层所有节点相连,所以叫全连接,如图4.2所示,为最简单的全连接网络结构,只含有一个隐藏层,该网络实现了将二维输入经过一层隐藏层的加权计算后转换为二维输出。其中输入层和输出层都为一层但神经元可以有多个,隐藏层可以有多层,层数越多,模型越复杂,计算量越大,所以在实际问题中要选择合适的隐藏层层数进行训练。

图4.2 全连接网络结构

训练全连接网络的关键是确定网络的权重值,每一层的权重W决定着如何将线性不可分的数据空间转换到线性可分的数据空间,这一步通常要依靠激活函数f来实现,常用激活函数有sigmoid、tanh、relu、softmax等,最终得到训练好的神经网络所有层的权重矩阵。每一层的输入向量即为上一层的输出向量,如输入层的输出向量作为隐藏层的输入,隐藏层的输出向量作为输出层的输入向量,每一层的输出向量通过如下式子进行计算:

全连接网络、前馈神经网络和多层感知机是同义概念,它们通常包括多层隐藏层,每个节点与上一层所有节点相连。训练过程涉及确定权重和偏置,通过激活函数实现线性不可分到线性可分的转换。前向传播计算输出,反向传播更新权重,采用梯度下降法优化损失函数,以最小化预测值与真实值的差距。

全连接网络、前馈神经网络和多层感知机是同义概念,它们通常包括多层隐藏层,每个节点与上一层所有节点相连。训练过程涉及确定权重和偏置,通过激活函数实现线性不可分到线性可分的转换。前向传播计算输出,反向传播更新权重,采用梯度下降法优化损失函数,以最小化预测值与真实值的差距。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?