一、什么是模型微调?

模型微调(Fine-tuning)是指基于预训练大模型(如GPT、BERT等),在特定领域数据上进行二次训练的技术。预训练模型通过海量通用数据掌握了语言理解、知识推理等基础能力,而微调则使其适应具体应用场景。

以医疗问答系统为例:

-

原始GPT-3可以生成流畅文本,但无法准确回答专业医学问题

-

使用医学文献和病例数据进行微调后,模型能理解医学术语并给出专业建议

核心价值体现:

节省算力成本:无需从头训练(预训练需数千张GPU)

保留通用能力:维持原有语言理解和生成能力

提升专业性能:在目标领域达到接近专家水平

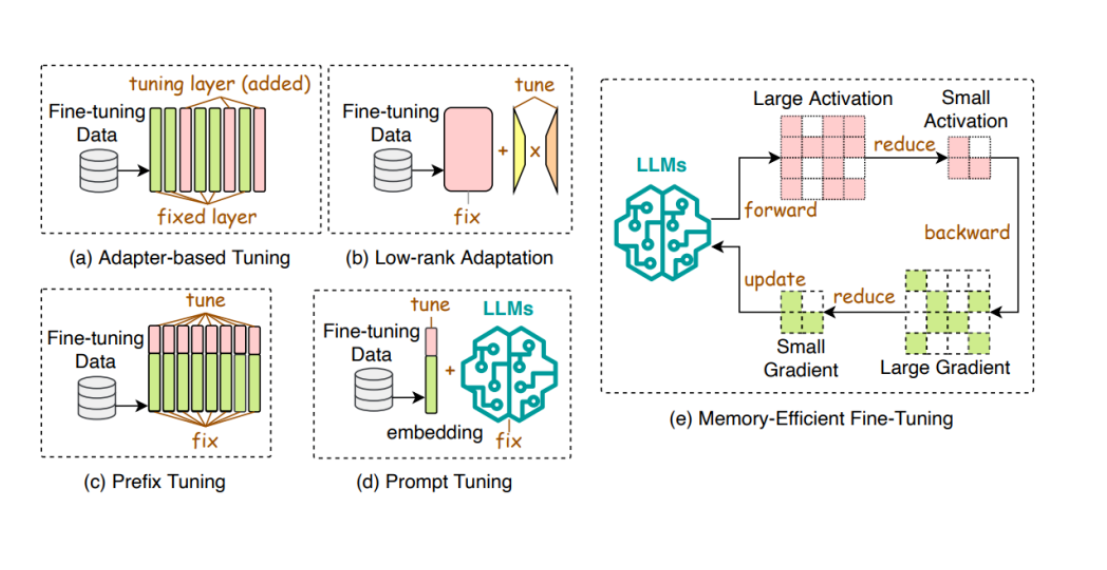

二、模型微调的方式

1.全量微调(Full Fine-tuning)

-

特点:更新所有模型参数

-

适用场景:数据量充足(百万级样本)、计算资源丰富

-

示例代码:

-

Python

model = AutoModelForCausalLM.from_pretrained("gpt2") trainer = Trainer(model=model, args=training_args, train_dataset=dataset) trainer.train()

大模型微调:从理论到实战指南

大模型微调:从理论到实战指南

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

918

918

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?