前言

这篇文章用的也是交替算法,不得不说,这个东西太好用了,变来变去怎么都能玩出花来。这篇论文的关键之处,我感觉是对adjusted variance的算法,比较让人信服。

文章概述

X

是

中

心

化

的

样

本

矩

阵

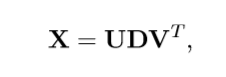

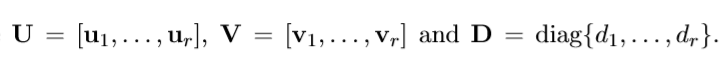

X是中心化的样本矩阵

X是中心化的样本矩阵

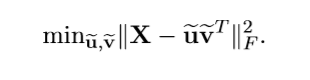

考虑下面的一个最优分解(F-范数)。

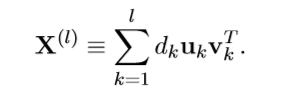

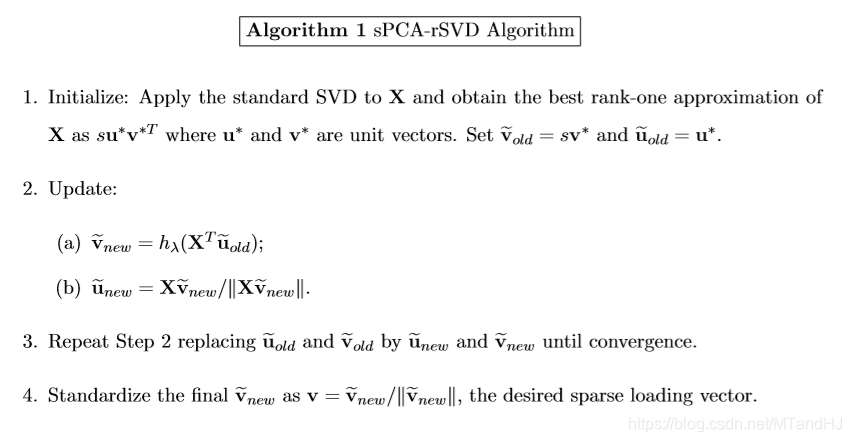

本文采取的也是一种搜索算法,每次计算一个载荷向量,所以,每次都处理的是rank-1的分解。

也就是:

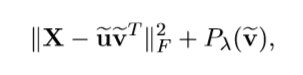

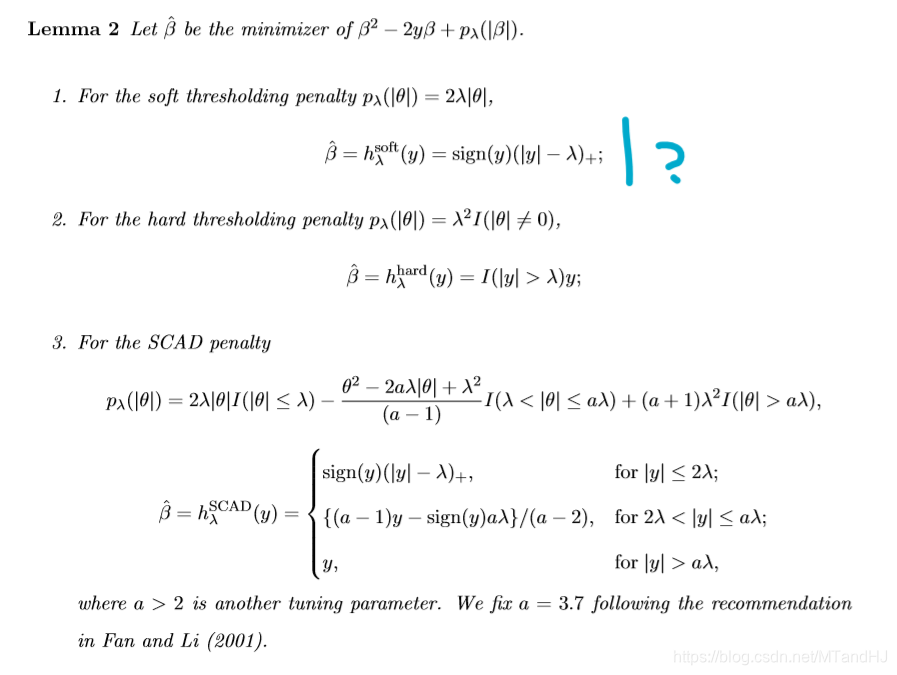

为了稀疏化,必须加上惩罚项,一般的就是1-范数或者0-范数。

限定

∥

u

~

∥

=

1

\|\widetilde{\mathrm{u}}\|=1

∥u

∥=1

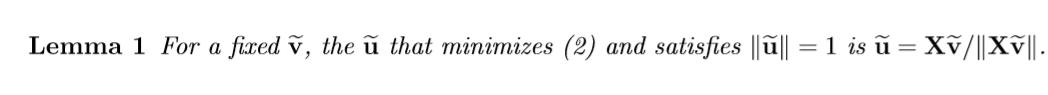

固定 v ~ \widetilde{\mathrm{v}} v

跟之前的论文差不了太多,挺好证的。

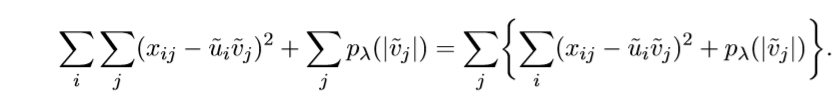

固定 u ~ \widetilde{\mathrm{u}} u

上述问题,根据下面的改写:

于是就可以分解为多个等价的小问题,每个子问题只需要考虑

v

~

j

\widetilde{v}_j

v

j就可以了。

根据不同的截断手法,有不同的解:

注:对于第一种方法,存疑,因为我证出来的不大一样,当然,可能是我哪里搞错了。

还有一点要注意:因为最后我们要求的其实是载荷向量

v

\mathrm{v}

v,它只需在最后收敛后归一化即可,看下来算法:

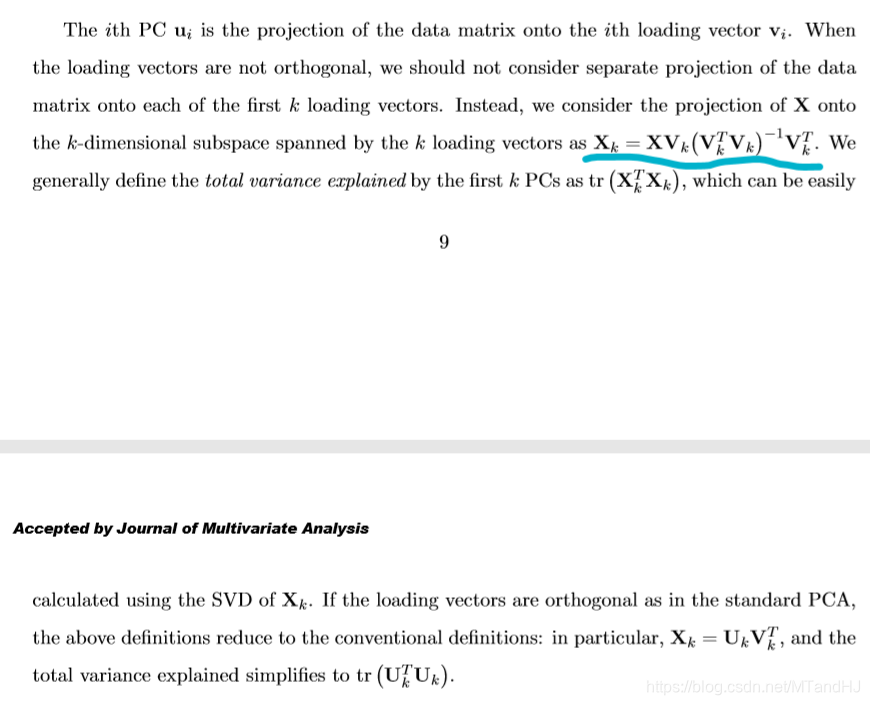

Adjusted Variance

本文深入探讨了AdjustedVariance算法,一种在交替算法框架下优化矩阵分解的有效方法。通过引入惩罚项实现载荷向量的稀疏化,文章详细阐述了如何通过固定其中一个变量求解另一个变量的问题,最终达到矩阵的最优分解。

本文深入探讨了AdjustedVariance算法,一种在交替算法框架下优化矩阵分解的有效方法。通过引入惩罚项实现载荷向量的稀疏化,文章详细阐述了如何通过固定其中一个变量求解另一个变量的问题,最终达到矩阵的最优分解。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?