Dify系列文章

Dify使用01-Dify安装与部署

Dify使用-常见问题及解决方案

Dify使用02-Dify集成Ollama

Dify使用02-Dify集成Ollama

环境说明

| 编号 | 软件 | 环境说明 |

|---|---|---|

| 1 | Ollama | 安装在本机上 |

| 2 | Dify | 安装在本机WSL的Ubuntu中 |

| 3 | 本机 | Windows11 |

1、Ollama安装及配置

步骤一:下载Ollama

由于本机只有英特尔集显,因此去魔搭社区下载英特尔优化版Ollama,也可以去Ollama官网下载。

步骤二:Ollama配置远程访问

Ollama默认仅支持本机访问,需通过修改环境变量让其可以远程访问,windows电脑配置方法是在环境变量中新增OLLAMA_HOST,配置的值为0.0.0.0:11434

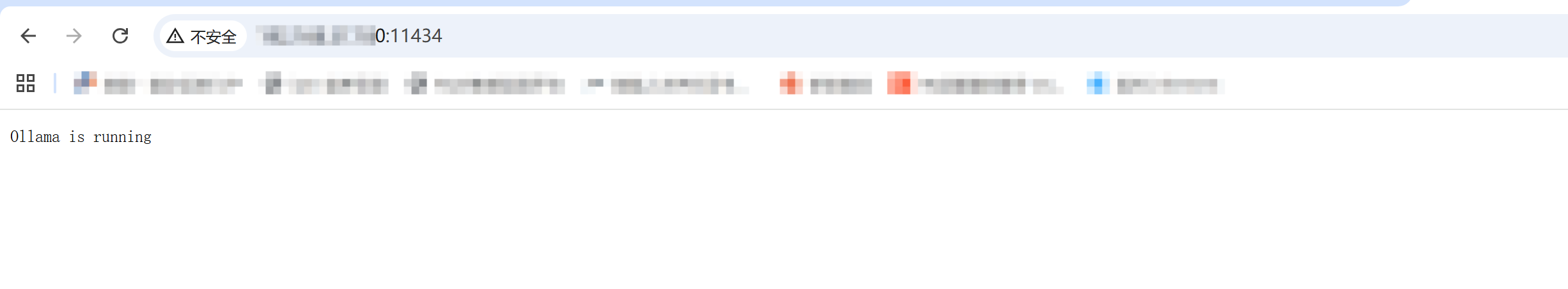

步骤三:启动Ollama并验证Ollama可访问

启动Ollama后,在浏览器输入本机IP:11434显示Ollama is running则表示Ollama可以远程访问。

使用Ollama拉取一个qwen3:8b模型,用于后续使用。

2、Dify集成Ollama

步骤一:安装Ollama插件

点击dify插件,然后搜索Ollama,安装Ollama插件即可。

步骤二:添加Ollama本地模型

进入设置页面

进入ollama添加模型页面

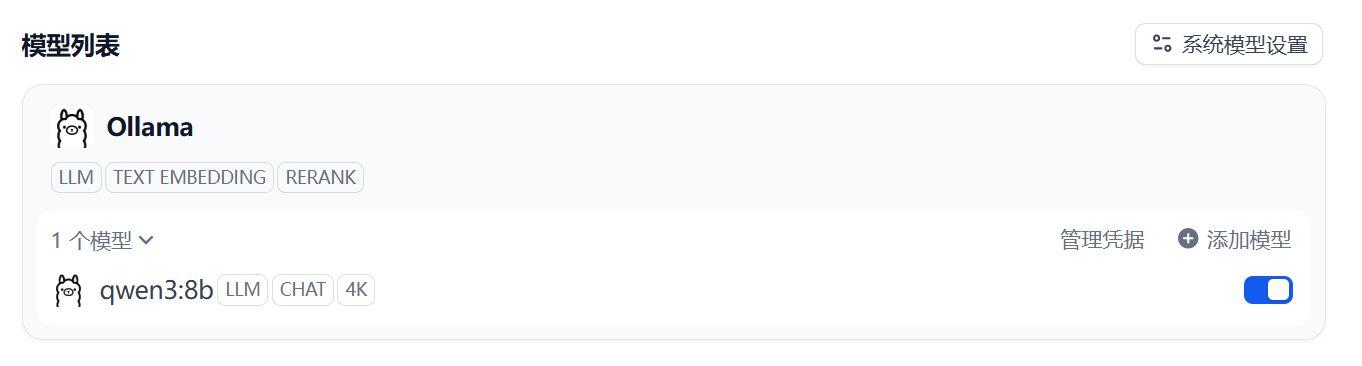

在设置页面,点击模型供应商,即可看到模型列表有Ollama,此时点击ollama的添加模型。

添加Ollama本地模型

表单说明如下:

| 字段 | 说明 |

|---|---|

| 模型名称 | 与ollama模型名称相对应,如qwen3:8b |

| 模型类型 | 可选值为LLM(大语言模型)、Text Embedding(文本嵌入模型)、Rerank(重新排序模型) |

| 基础URL | Ollama的访问地址,为“http://主机IP:11434” |

| 模型类型 | 可选值为对话、补全 |

| 模型上下文长度 | 若不清楚就填默认值4096 |

| 最大token上限 | 若不清楚就填默认值4096 |

| 是否支持 Vision | 模型支持图片理解则选是,否则选否 |

| 是否支持函数调用 | 模型支持选是,否则选否 |

| 填写完成后,点击添加,此时ollama下会显示该模型。 | |

|

3、基于Ollama构建Dify应用

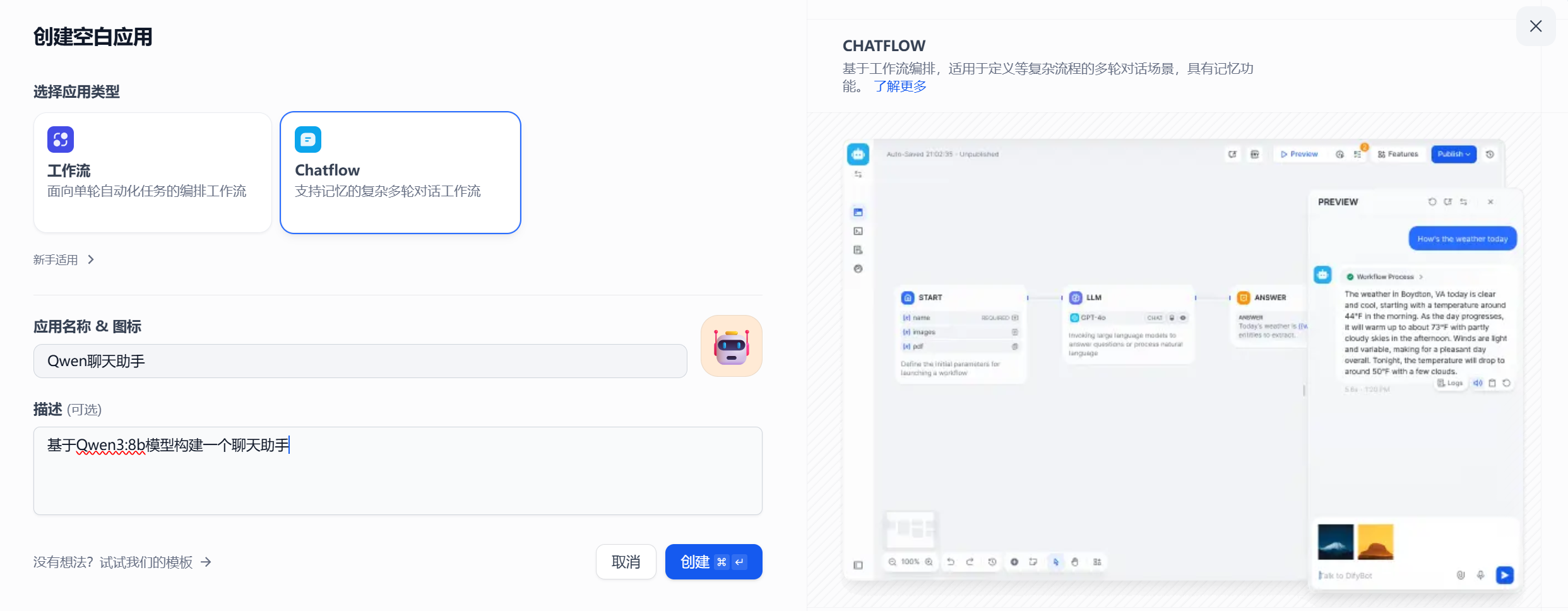

步骤一:创建并发布应用

进入dify工作室,点击创建空白应用

配置应用名称和描述。

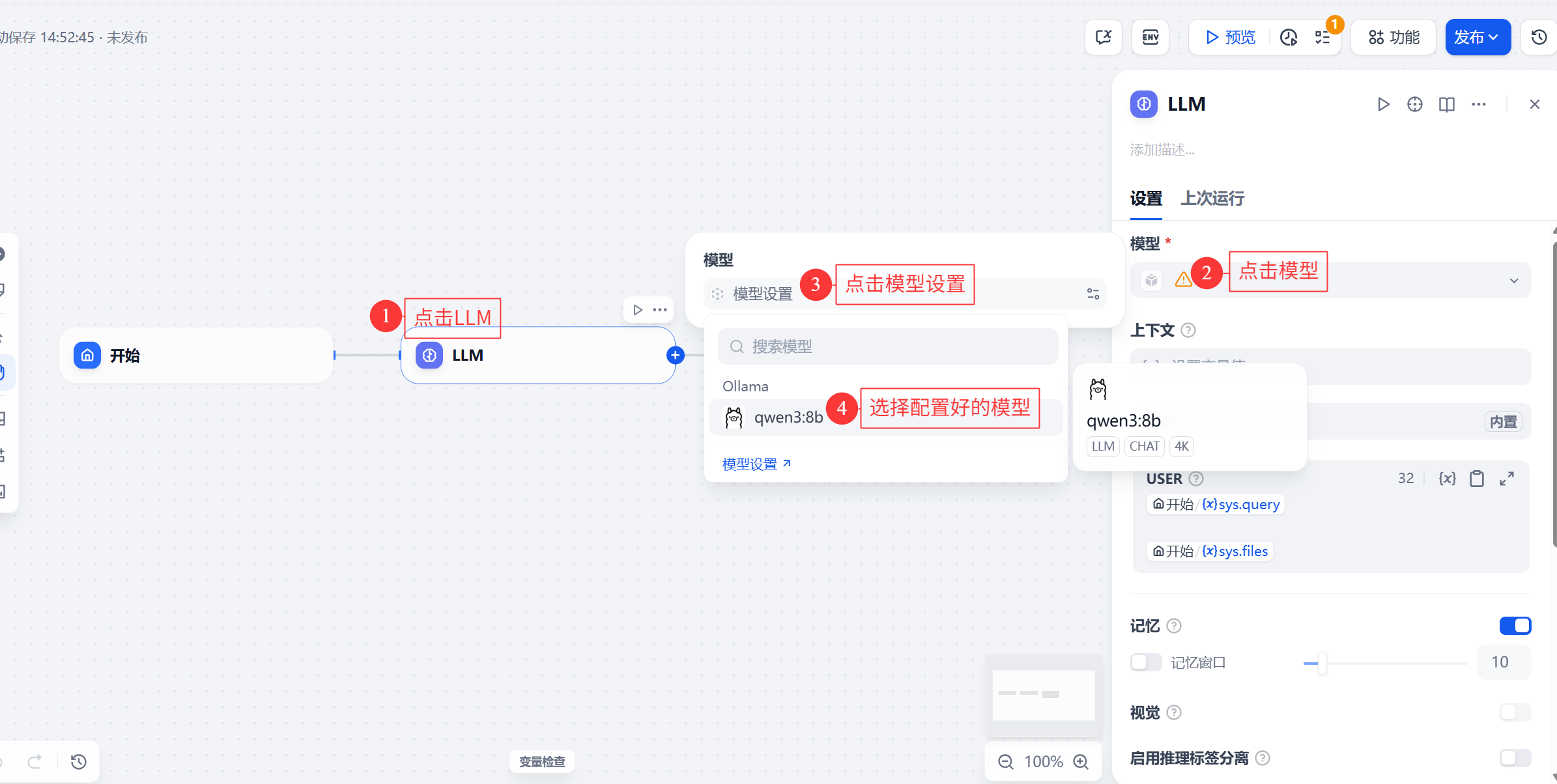

配置应用要调用的模型。

完成配置后,点击发布

步骤二:使用应用

点击探索,此时工作区就有应用,点击应用即可使用。

常见问题

1、Dify无法访问Ollama

可参照以下顺序去排查:

(1)未配置OLLAMA_HOST参数,开放Ollama远程访问: 环境变量增加OLLAMA_HOST参数后,重启Ollama;

(2)OLLAMA_HOST参数不生效: Ollama英特尔优化版配置OLLAMA_HOST参数不生效,是因为ollama-serve.bat有设置OLLAMA_HOST,会覆盖系统设置,所以需要修改ollama-serve.bat,改为set OLLAMA_HOST=0.0.0.0:11434。

(3)Ollama IP填写错误: Dify通过Docker部署,此时填写127.0.0.1这样的IP,Dify是无法正确识别的,需要填写Ollama所在主机的具体IP地址,Dify才能正确识别。

2、Ollama插件添加模型后,Dify页面模型为空

原因: Dify默认配置对插件安装过程的超时限制较短,且依赖下载可能因网络问题失败.

解决方法: 进入/dify/docker目录下,修改env文件,改成如下值即可。

PLUGIN_PYTHON_ENV_INIT_TIMEOUT=1200

PLUGIN_MAX_EXECUTION_TIMEOUT=900

# PIP_MIRROR_URL=https://pypi.tuna.tsinghua.edu.cn/simple

PIP_MIRROR_URL=https://pypi.tuna.tsinghua.edu.cn/simple

Dify集成Ollama实现AI本地化

Dify集成Ollama实现AI本地化

5584

5584

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?