背景知识-LR/GLM应用场景及原理

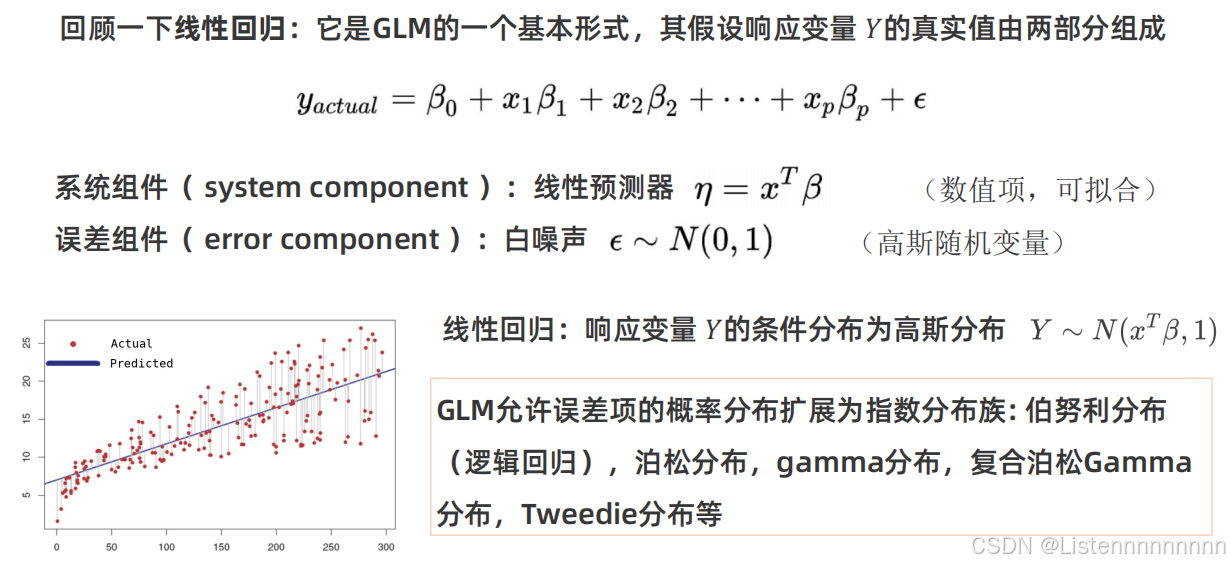

什么是广义线性模型(Generalized Linear Models)

广义线性模型是一种统计模型,可以帮助我们找到数据中的模式。它比普通的线性回归模型更灵活,因为它能处理更多类型的数据,比如分类数据(比如是否购买某产品)或计数数据(比如一天内卖出多少商品),GLM有如下特点:

- 灵活性:GLM能够处理各种类型的响应变量,包括连续、二分类和计数数据。

- 统一框架:提供了一个统一的统计建模框架,使得不同类型的数据和问题可以用类似的方法处理。

- 实际应用广泛:GLM在各个领域都有广泛的应用,例如医学中的生存分析、经济学中的计数数据建模、社会科学中的分类问题等。

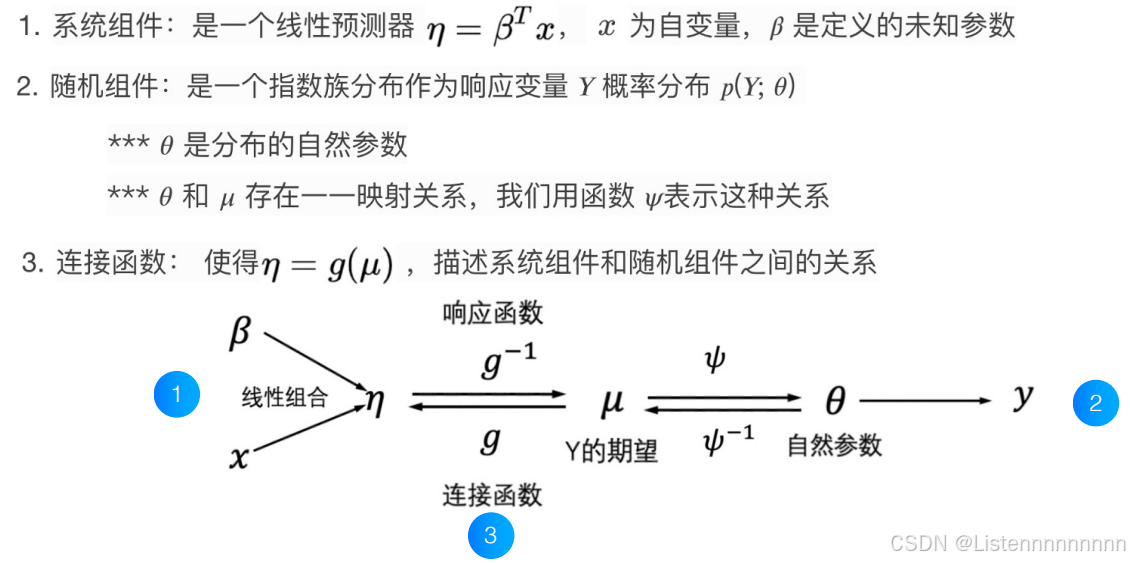

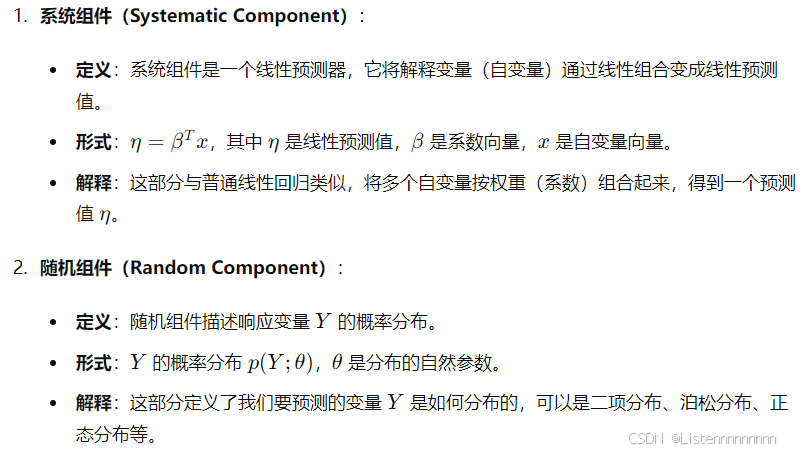

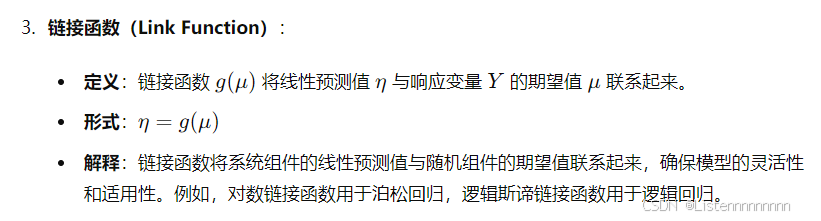

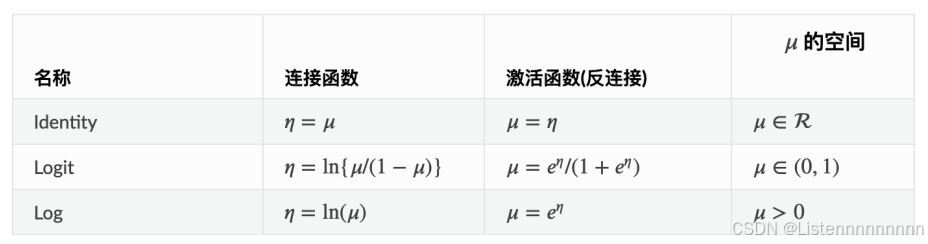

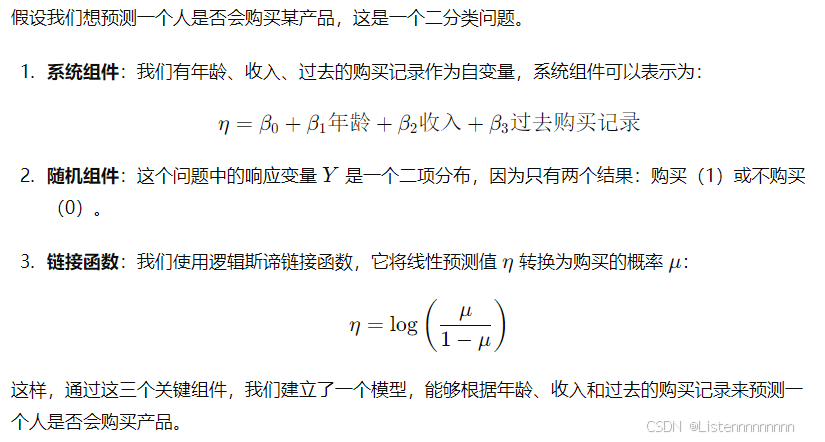

一个广义线性模型有三个关键组件

隐语模型-密态SS(SecretShared)LR/SSGLM

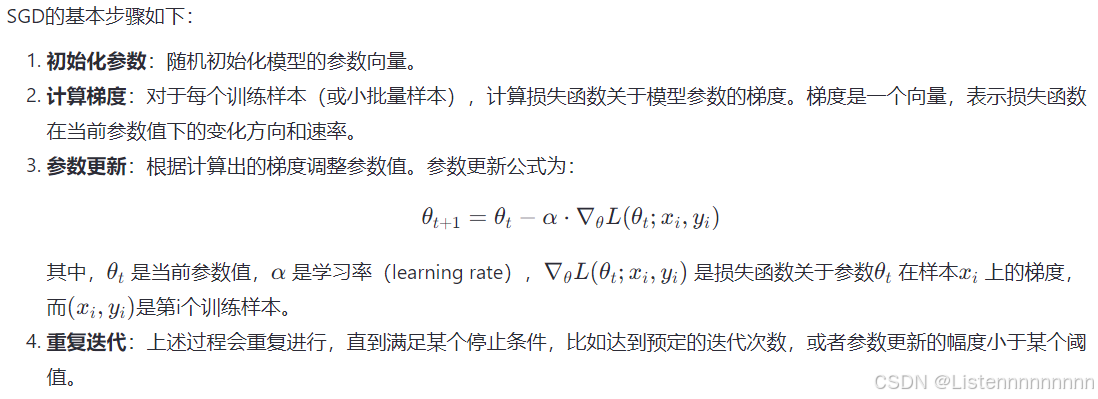

随机梯度下降(Stochastic Gradient Descent, SGD),是一种在机器学习和深度学习中广泛使用的参数优化方法。它主要用于最小化或最大化一个目标函数(例如损失函数)。与传统的批量梯度下降(Batch Gradient Descent)相比,SGD在每次迭代时只使用单个样本(或一个小批量的样本)来更新模型参数,这使得它在处理大规模数据集时更为高效。

随机梯度下降(Stochastic Gradient Descent, SGD),是一种在机器学习和深度学习中广泛使用的参数优化方法。它主要用于最小化或最大化一个目标函数(例如损失函数)。与传统的批量梯度下降(Batch Gradient Descent)相比,SGD在每次迭代时只使用单个样本(或一个小批量的样本)来更新模型参数,这使得它在处理大规模数据集时更为高效。

SGD有多种变种,它们通过不同的方式调整学习率或梯度计算来改进性能,比如Momentum、AdaGrad、RMSProp、Adam等。这些变种通常能提供更快的收敛速度和更好的性能。

- Momentum:引入动量项,使参数更新沿历史梯度的方向加速,有助于克服局部极小值。

- AdaGrad:自动调整学习率,对频繁更新的参数减小学习率,对较少更新的参数增大学习率。

- RMSProp:修正AdaGrad中学习率衰减过快的问题,通过指数加权平均平方梯度来动态调整学习率。

- Adam:结合了Momentum和RMSProp的优点,同时使用了动量和自适应学习率,是目前最常用的优化算法之一。

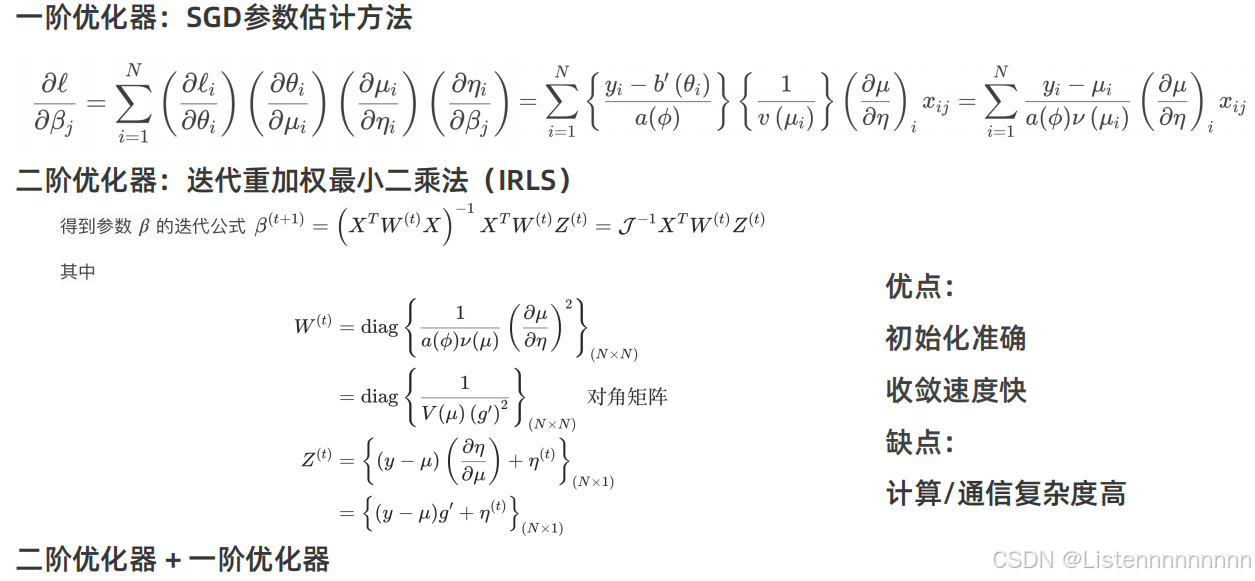

广义线性模型参数估计

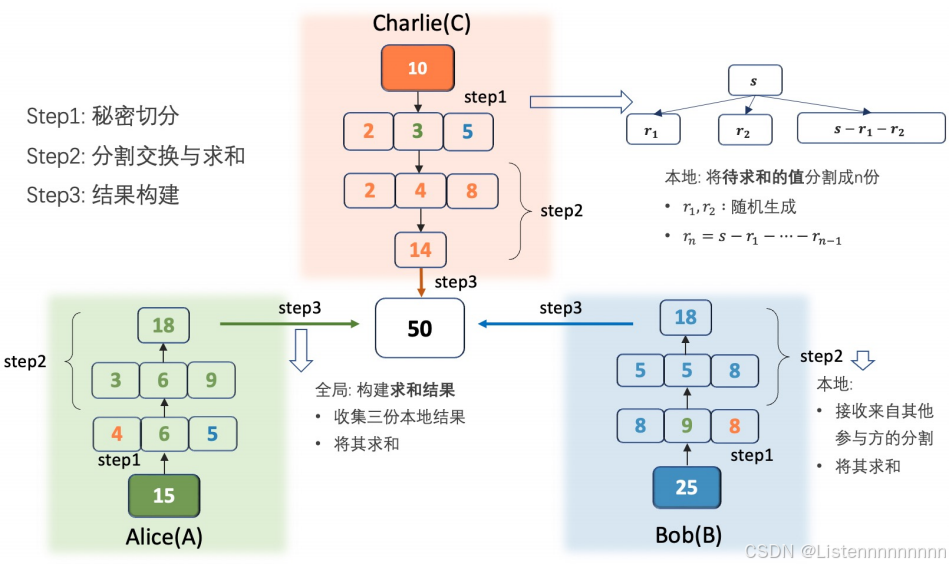

秘密分享加法

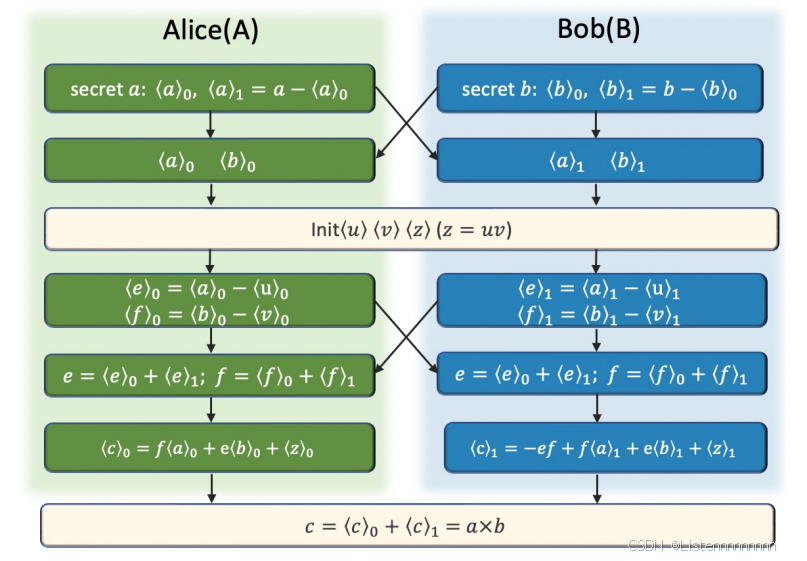

秘密分享乘法

应用实现-从理论到隐语应用

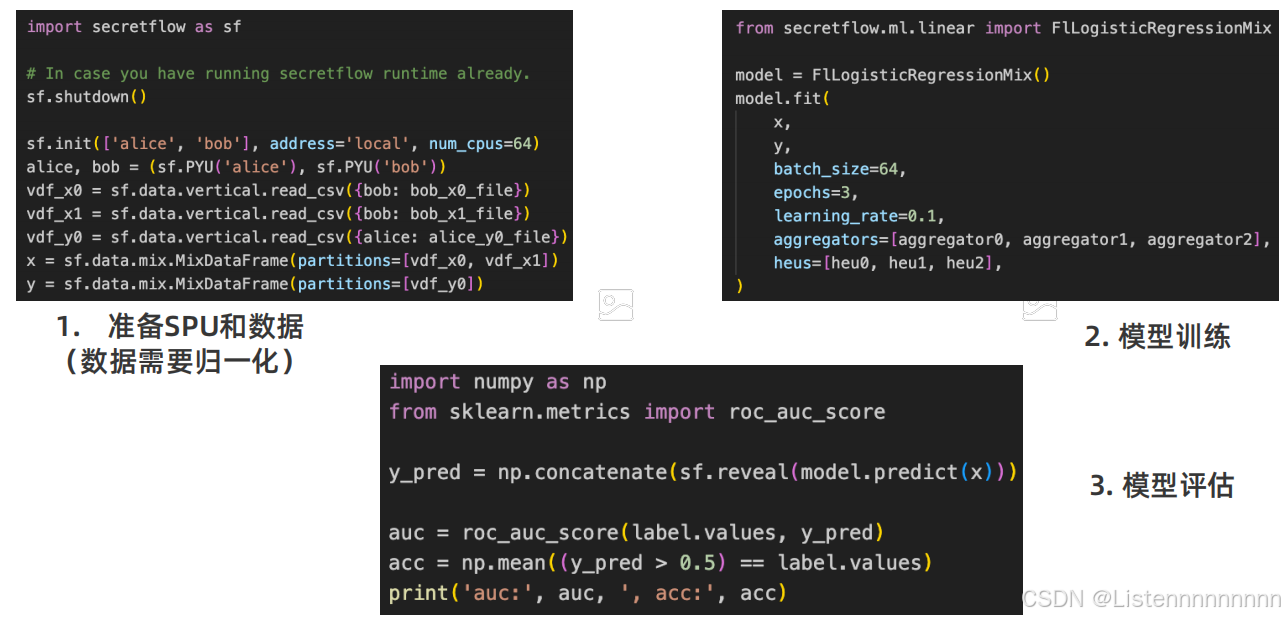

SSLR

SSGLM

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?