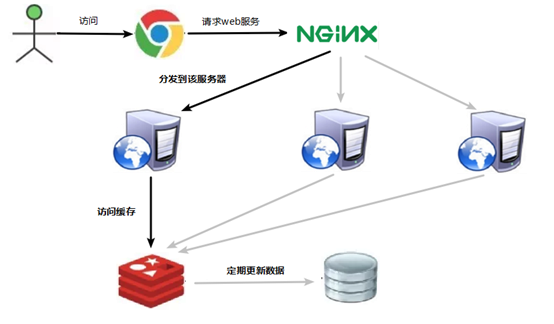

一 应用场景

为什么需要redis集群?

当主备复制场景,无法满足主机的单点故障时,需要引入集群配置。

一般数据库要处理的读请求远大于写请求 ,针对这种情况,我们优化数据库可以采用读写分离的策略。我们可以部 署一台主服务器主要用来处理写请求,部署多台从服务器 ,处理读请求。

二 基本原理

哨兵选举机制,如果有半数节点发现某个异常节点,共同决定改异常节点的状态,如果该节点是主节点,对应的备节点自动顶替为主节点。Sentinel(哨兵)是Redis 的高可用性解决方案:由一个或多个Sentinel 实例 组成的Sentinel 系统可以监视任意多个主服务器,以及这些主服务器属下的所有从服务器,并在被监视的主服务器进入下线状态时,自动将下线主服务器属下的某个从服务器升级为新的主服务器。

主从复制的作用

1、数据冗余:主从复制实现了数据的热备份,是持久化之外的一种数据冗余方式。

2、故障恢复:当主节点出现问题时,可以由从节点提供服务,实现快速的故障恢复;实际上是一种服务的冗余。

3、负载均衡:在主从复制的基础上,配合读写分离,可以由主节点提供写服务,由从节点提供读服务(即写Redis数据时应用连接主节点,读Redis数据时应用连接从节点),分担服务器负载;尤其是在写少读多的场景下,通过多个从节点分担读负载,可以大大提高Redis服务器的并发量。

4、读写分离:可以用于实现读写分离,主库写、从库读,读写分离不仅可以提高服务器的负载能力,同时可根据需求的变化,改变从库的数量。

5、高可用基石:除了上述作用以外,主从复制还是哨兵和集群能够实施的基础,因此说主从复制是Redis高可用的基础

配置集群所需的环境

Redis集群至少需要3个节点,因为投票容错机制要求超过半数节点认为某个节点挂了该节点才是挂了,所以2个节点无法构成集群。

要保证集群的高可用,需要每个节点都有从节点,也就是备份节点,所以Redis集群至少需要6台服务器。因为我没有那么多服务器,也启动不了那么多虚拟机,所在这里搭建的是伪分布式集群,即一台服务器虚拟运行6个redis实例,修改端口号为(7001-7006),当然实际生产环境的Redis集群搭建和这里是一样的。

1,规划网络。

用一台虚拟机模拟6个节点,一台机器6个节点,创建出3 master、3 salve 环境。虚拟机是 CentOS7 ,ip地址192.168.159.34

2,创建 Redis 节点

首先在 192.168.159.34 机器上 /usr/java/目录下创建 redis_cluster 目录;

mkdir redis_cluster

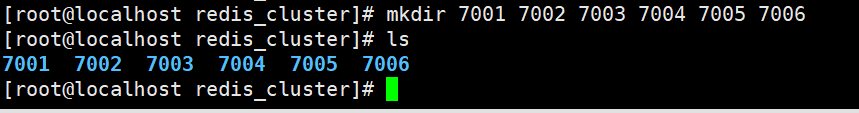

3 创建目录

在 redis_cluster 目录下,创建名为7001、7002,7003、7004、7005,7006的目录

mkdir 7001 7002 7003 7004 7005 7006

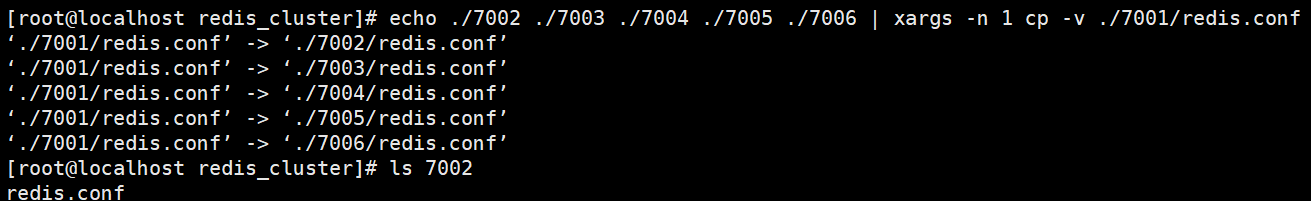

4 将 redis.conf 拷贝到这六个目录中,

echo ./7002 ./7003 ./7004 ./7005 ./7006 | xargs -n 1 cp -v /usr/java/redis_cluster/7001/redis.conf

将7001文件夹下面的redis.conf文件拷贝到7002,7003,7004,7005,7006文件夹里面

5 配置redis7001.conf

include /usr/java/redis_cluster/redis.conf

port 7001

pidfile "/var/run/redis_7001.pid"

dbfilename "dump_7001.rdb"

dir "/usr/java/redis_cluster/7001"

logfile "/usr/java/redis_cluster/7001/redis_err_7001.log"

cluster-enabled yes

cluster-config-file nodes-7001.conf

cluster-node-timeout 15000集群配置一般不要设置密码

后台启动

6 启动这6个redis

[root@localhost redis_cluster]# /usr/java/redis/bin/redis-server /usr/java/redis_cluster/7001/redis.conf

[root@localhost redis_cluster]# /usr/java/redis/bin/redis-server /usr/java/redis_cluster/7002/redis.conf

[root@localhost redis_cluster]# /usr/java/redis/bin/redis-server /usr/java/redis_cluster/7003/redis.conf

[root@localhost redis_cluster]# /usr/java/redis/bin/redis-server /usr/java/redis_cluster/7004/redis.conf

[root@localhost redis_cluster]# /usr/java/redis/bin/redis-server /usr/java/redis_cluster/7005/redis.conf

[root@localhost redis_cluster]# /usr/java/redis/bin/redis-server /usr/java/redis_cluster/7006/redis.conf

一键启动redis

7 创建redis的集群

/usr/java/redis/bin/redis-cli --cluster create 192.168.159.34:7001 192.168.159.34:7002 192.168.159.34:7003 192.168.159.34:7004 192.168.159.34:7005 192.168.159.34:7006 --cluster-replicas 1

--replicas 1

1其实代表的是一个比例,就是主节点数/从节点数的比例。那么想一想,在创建集群的时候,哪些节点是主节点呢?哪些节点是从节点呢?答案是将按照命令中IP:PORT的顺序,先是3个主节点,然后是3个从节点。

分配原则尽量保证每个主数据库运行在不同的IP地址,每个从库和主库不在一个IP地址上。

配置成功如下图

8 使用cli连接redis集群

使用客户端链接集群 必须使用 -c 连接

/usr/java/redis/bin/redis-cli -c -h 192.168.159.34 -p 7002

查看集群的节点的信息 :cluster nodes

9 检查集群的状态

/usr/java/redis/bin/redis-cli --cluster check 192.168.159.34:7002

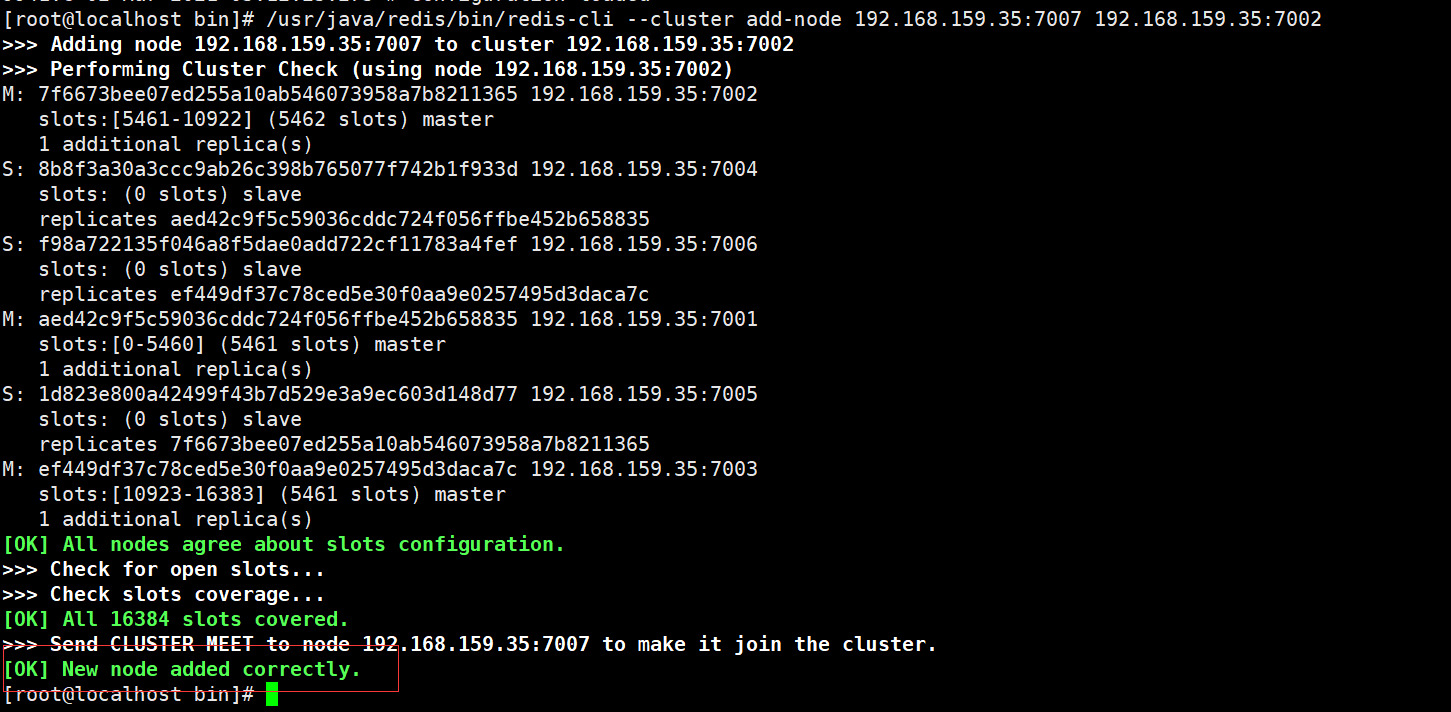

10 添加主节点

配置文件 7007 /redis.conf

启动

在添加之前首先要像7001-6一样,修改配置文件,启动7007 服务

/usr/java/redis/bin/redis-cli --cluster add-node 192.168.159.34:7007 192.168.159.34:7002

前面的IP加端口号是要添加的redis节点,后面的IP和端口号是集群中的任意一个节点。

检查节点的状态

11 配置从节点

刚才添加的主节点还没有分配槽,所以无法使用

添加从节点之前需要设置从节点并启动节点

--cluster-master-id 为从节点对应主节点的id

/usr/java/redis/bin/redis-cli --cluster add-node 192.168.159.34:7008 192.168.159.34:7002 --cluster-slave --cluster-master-id 67211a02cffe48ee7197092ca48e9e7294dc5961

添加的主节点还不能使用,因为没有分配slots,

重新分配slots

slot的概念。slot对于Redis集群而言,就是一个存放数据的地方,就是一个槽。对于每一个Master而言,会存在一个slot的范围,而Slave则没有。在Redis集群中,依然是Master可以读、写,而Slave只读

/usr/java/redis/bin/redis-cli --cluster reshard 192.168.159.34:7002

all 代表从所有有数据据节点进行迁移到目的节点,也可以选择 目标节点id回车,最后以done进行结束

done 代表结束

分配成功以后

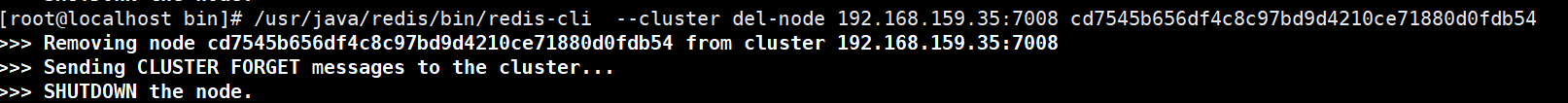

删除节点

--cluster del-node 集群 节点id

删除主节点需要先使用 reshard 把主节点的slots移到其他节点才可以

redis客户端 --cluster del-node [集群中的任意一个节点:端口号] 被删除的节点的id/usr/java/redis/bin/redis-cli --cluster del-node 192.168.159.34:7002 67211a02cffe48ee7197092ca48e9e7294dc5961

删除从节点

--cluster del-node 集群 节点id

redis客户端 --cluster del-node [集群中的任意一个节点:端口号] 被删除的节点的id/usr/java/redis/bin/redis-cli --cluster del-node 192.168.159.34:7002 cd7545b656df4c8c97bd9d4210ce71880d0fdb54

集群关机之后,集群重启,只需要直接启动各个节点,不需要重新组网,redis会根据node.conf自动组网

12故障检测

验证集群是否生效:

关闭一个主节点查看对应的备用节点是不是能够顶替主节点成为主节点

存/取数据的时候查看对应的端口号

(关闭主节点以后需要耐心等待一会儿 让他重新分配一下空间)

关闭的时候一定要使用shutdown命令不要使用kill命令

/usr/java/redis/bin/redis-cli -h 192.168.159.34 -p 7001 shutdown

查看主从关系

关闭之后查看7004是否成为了主节点

7004变成了主节点 证明集群配置成功

主节点恢复后,主从关系会如何?主节点回来变成从机。

如果所有某一段插槽的主从节点都宕掉,redis服务是否还能继续?

如果某一段插槽的主从都挂掉,而cluster-require-full-coverage 为yes ,那么 ,整个集群都挂掉

如果某一段插槽的主从都挂掉,而cluster-require-full-coverage 为no ,那么,该插槽数据全都不能使用,也无法存储。

redis.conf中的参数 cluster-require-full-coverage

添加数据测试一下集群

一键启动脚本 一键关闭脚本 redis的脚本的名称不能是redis否则错误难搞

#! /bin/sh

l=`ps -ef|grep -w redis|grep -v grep|wc -l`

if [ $l == 0 ]

then

echo "redis还没有启动,开始启动。。。。"

/usr/java/redis/bin/redis-server /usr/java/redis_cluster/7001/redis.conf

/usr/java/redis/bin/redis-server /usr/java/redis_cluster/7002/redis.conf

/usr/java/redis/bin/redis-server /usr/java/redis_cluster/7003/redis.conf

/usr/java/redis/bin/redis-server /usr/java/redis_cluster/7004/redis.conf

/usr/java/redis/bin/redis-server /usr/java/redis_cluster/7005/redis.conf

/usr/java/redis/bin/redis-server /usr/java/redis_cluster/7006/redis.conf

echo "启动成功。。。。。。。。。"

else

echo "redis已经启动,开始关闭******************************"

/usr/java/redis/bin/redis-cli -h 127.0.0.1 -p 7001 shutdown

/usr/java/redis/bin/redis-cli -h 127.0.0.1 -p 7002 shutdown

/usr/java/redis/bin/redis-cli -h 127.0.0.1 -p 7003 shutdown

/usr/java/redis/bin/redis-cli -h 127.0.0.1 -p 7004 shutdown

/usr/java/redis/bin/redis-cli -h 127.0.0.1 -p 7005 shutdown

/usr/java/redis/bin/redis-cli -h 127.0.0.1 -p 7006 shutdown

echo "关闭成功****************************************"

fi三什么是slots

[OK] All 16384 slots covered.

一个 Redis 集群包含 16384 个插槽(hash slot), 数据库中的每个键都属于这 16384 个插槽的其中一个,

集群使用公式 CRC16(key) % 16384 来计算键 key 属于哪个槽, 其中 CRC16(key) 语句用于计算键 key 的 CRC16 校验和 。

集群中的每个节点负责处理一部分插槽。 举个例子, 如果一个集群可以有主节点, 其中:

节点 A 负责处理 0 号至 5460 号插槽。

节点 B 负责处理 5461 号至 10922 号插槽。

节点 C 负责处理 10923 号至 16383 号插槽。

1.在集群中录入值

在redis-cli每次录入、查询键值,redis都会计算出该key应该送往的插槽,如果不是该客户端对应服务器的插槽,redis会报错,并告知应前往的redis实例地址和端口。

redis-cli客户端提供了 –c 参数实现自动重定向。

如 redis-cli -c –p 7000登入后,再录入、查询键值对可以自动重定向。

- 批量存储引发的问题

不在一个slot下的键值,是不能使用mget,mset等多键操作。

- 解决批量存储 组 {组的名字}

可以通过{}来定义组的概念,从而使key中{}内相同内容的键值对放到一个slot中去。(按组分配插槽)

Redis 集群优点

实现扩容

分摊压力

无中心配置相对简单

Redis 集群的不足

多键操作是不被支持的

多键的Redis事务是不被支持的

由于集群方案出现较晚,很多公司已经采用了其他的集群方案,而代理或者客户端分片的方案想要迁移至redis cluster,需要整体迁移而不是逐步过渡,复杂度较大。

四 Redis的应用问题

缓存穿透

缓存穿透是指缓存和数据库中都没有的数据,导致所有的请求都落到数据库上,造成数据库短时间内承受大量请求而崩掉。

问题描述

key对应的数据在数据库并不存在,每次针对此key的请求从缓存获取不到,请求都会压到数据库,从而可能压垮数据库。比如用一个不存在的用户id获取用户信息,不论缓存还是数据库都没有,若黑客利用此漏洞进行攻击可能压垮数据库。

解决方案

一个一定不存在缓存及查询不到的数据,由于缓存是不命中时被动写的,并且出于容错考虑,如果从存储层查不到数据则不写入缓存,这将导致这个不存在的数据每次请求都要到存储层去查询,失去了缓存的意义。

解决方案:

(1) 对空值缓存:如果一个查询返回的数据为空(不管是数据是否不存在),我们仍然把这个空结果(null)进行缓存,设置空结果的过期时间会很短,最长不超过五分钟

(2) 设置可访问的名单(白名单):

使用bitmaps类型定义一个可以访问的名单,名单id作为bitmaps的偏移量,每次访问和bitmap里面的id进行比较,如果访问id不在bitmaps里面,进行拦截,不允许访问。

(3) 采用布隆过滤器:(布隆过滤器(Bloom Filter)是1970年由布隆提出的。它实际上是一个很长的二进制向量(位图)和一系列随机映射函数(哈希函数)。

布隆过滤器可以用于检索一个元素是否在一个集合中。它的优点是空间效率和查询时间都远远超过一般的算法,缺点是有一定的误识别率和删除困难。)

将所有可能存在的数据哈希到一个足够大的bitmaps中,一个一定不存在的数据会被 这个bitmaps拦截掉,从而避免了对底层存储系统的查询压力。

(4) 进行实时监控:当发现Redis的命中率开始急速降低,需要排查访问对象和访问的数据,和运维人员配合,可以设置黑名单限制服务

缓存次数/总的查询次数

缓存击穿

缓存击穿是指缓存中没有但数据库中有的数据(一般是缓存时间到期),这时由于并发用户特别多,同时读缓存没读到数据,又同时去数据库去取数据,引起数据库压力瞬间增大,造成过大压力。和缓存雪崩不同的是,缓存击穿指并发查同一条数据,缓存雪崩是不同数据都过期了,很多数据都查不到从而查数据库。

问题描述

key对应的数据存在,但在redis中没有过期,此时若有大量并发请求过来,这些请求发现缓存过期一般都会从后端DB加载数据并回设到缓存,这个时候大并发的请求可能会瞬间把后端DB压垮。

解决方案

key可能会在某些时间点被超高并发地访问,是一种非常“热点”的数据。这个时候,需要考虑一个问题:缓存被“击穿”的问题。

解决问题:

(1)预先设置热门数据:在redis高峰访问之前,把一些热门数据提前存入到redis里面,加大这些热门数据key的时长

(2)实时调整:现场监控哪些数据热门,实时调整key的过期时长

(3)使用锁:

(1) 就是在缓存失效的时候(判断拿出来的值为空),不是立即去加载数据库。

(2) 先使用缓存工具的某些带成功操作返回值的操作(比如Redis的SETNX)去set一个mutex key

(3) 当操作返回成功时,再进行load db的操作,并回设缓存,最后删除mutex key;

(4) 当操作返回失败,证明有线程在load db,当前线程睡眠一段时间再重试整个get缓存的方法。

缓存雪崩

缓存雪崩是指缓存同一时间大面积的失效,所以,后面的请求都会落到数据库上,造成数据库短时间内承受大量请求而崩掉。

问题描述

key对应的数据存在,但在redis中过期,此时若有大量并发请求过来,这些请求发现缓存过期一般都会从后端DB加载数据并回设到缓存,这个时候大并发的请求可能会瞬间把后端DB压垮。

缓存雪崩与缓存击穿的区别在于这里针对很多key缓存,击穿则是某一个key正常访问

缓存失效瞬间

解决方案

缓存失效时的雪崩效应对底层系统的冲击非常可怕!

解决方案:

(1) 构建多级缓存架构:nginx缓存 + redis缓存 +其他缓存(ehcache等)

(2) 使用锁或队列:

用加锁或者队列的方式保证来保证不会有大量的线程对数据库一次性进行读写,从而避免失效时大量的并发请求落到底层存储系统上。不适用高并发情况

(3) 设置过期标志更新缓存:

记录缓存数据是否过期(设置提前量),如果过期会触发通知另外的线程在后台去更新实际key的缓存。

(4) 将缓存失效时间分散开:

比如我们可以在原有的失效时间基础上增加一个随机值,比如1-5分钟随机,这样每一个缓存的过期时间的重复率就会降低,就很难引发集体失效的事件。

五 分布式锁

问题描述

随着业务发展的需要,原单体单机部署的系统被演化成分布式集群系统后,由于分布式系统多线程、多进程并且分布在不同机器上,这将使原单机部署情况下的并发控制锁策略失效,单纯的Java API并不能提供分布式锁的能力。为了解决这个问题就需要一种跨JVM的互斥机制来控制共享资源的访问,这就是分布式锁要解决的问题!

分布式锁主流的实现方案:

1. 基于数据库实现分布式锁

2. 基于缓存(Redis等)

3. 基于Zookeeper

每一种分布式锁解决方案都有各自的优缺点:

1. 性能:redis最高

2. 可靠性:zookeeper最高

这里,我们就基于redis实现分布式锁。

解决方案:使用redis实现分布式锁

redis:命令

# set sku:1:info “OK” NX PX 10000

EX second :设置键的过期时间为 second 秒。 SET key value EX second 效果等同于 SETEX key second value 。

PX millisecond :设置键的过期时间为 millisecond 毫秒。 SET key value PX millisecond 效果等同于 PSETEX key millisecond value 。

NX :只在键不存在时,才对键进行设置操作。 SET key value NX 效果等同于 SETNX key value 。

XX :只在键已经存在时,才对键进行设置操作。

1. 多个客户端同时获取锁(setnx)

2. 获取成功,执行业务逻辑{从db获取数据,放入缓存},执行完成释放锁(del)

3. 其他客户端等待重试

1.1.1. 编写代码

Redis: set num 0

@GetMapping("testLock")

public void testLock(){

//1获取锁,setnx

Boolean lock = redisTemplate.opsForValue().setIfAbsent("lock", "111");

//2获取锁成功、查询num的值

if(lock){

// 1/0

Object value = redisTemplate.opsForValue().get("num");

//2.1判断num为空return

if(StringUtils.isEmpty(value)){

return;

}

//2.2有值就转成成int

int num = Integer.parseInt(value+"");

//2.3把redis的num加1

redisTemplate.opsForValue().set("num", ++num);

//2.4释放锁,del

redisTemplate.delete("lock");

}else{

//3获取锁失败、每隔0.1秒再获取

try {

Thread.sleep(100);

testLock();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}进行压力测试

问题:setnx刚好获取到锁,业务逻辑出现异常,导致锁无法释放

解决:设置过期时间,自动释放锁。

优化之设置锁的过期时间

设置过期时间有两种方式:

1. 首先想到通过expire设置过期时间(缺乏原子性:如果在setnx和expire之间出现异常,锁也无法释放)

2. 在set时指定过期时间(推荐)

设置过期时间:

代码中设置过期时间

Boolean lock = redisTemplate.opsForValue()

.setIfAbsent("lock", "111",3,TimeUnit.SECONDS);

问题:可能会释放其他服务器的锁。

场景:如果业务逻辑的执行时间是7s。执行流程如下

1. index1业务逻辑没执行完,3秒后锁被自动释放。 //

2. index2获取到锁,执行业务逻辑,3秒后锁被自动释放。

3. index3获取到锁,执行业务逻辑

4. index1业务逻辑执行完成,开始调用del释放锁,这时释放的是index3的锁,导致index3的业务只执行1s就被别人释放。

最终等于没锁的情况。

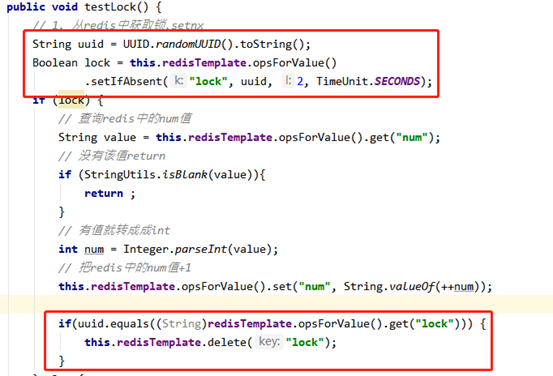

解决:setnx获取锁时,设置一个指定的唯一值(例如:uuid);释放前获取这个值,判断是否自己的锁

优化之UUID防误删

设置过期时间 唯一的uuid

index1 执行逻辑 完之后 ——》删除锁 对比一下 lock的值是不是一样的

一样的 锁的过期时间到了 锁会被自定删除 index2 过来了 加一个锁 uuid

index1 执行删除

问题:删除操作缺乏原子性。

场景:

1. index1执行删除时,查询到的lock值确实和uuid相等

uuid=v1

set(lock,uuid);

2. index1执行删除前,lock刚好过期时间已到,被redis自动释放

在redis中没有了lock,没有了锁。

3. index2获取了lock

index2线程获取到了cpu的资源,开始执行方法

uuid=v2

set(lock,uuid);

4. index1执行删除,此时会把index2的lock删除

index1 因为已经在方法中了,所以不需要重新上锁。index1有执行的权限。index1已经比较完成了,这个时候,开始执行

删除的index2的锁!

LUA脚本保证删除的原子性

KEYS[1] 用来表示在redis 中用作键值的参数占位,主要用来传递在redis 中的key。

ARGV[1] 用来表示在redis 中用作参数的占位,主要用来传递在redis中用做 value值的参数。

@GetMapping("testLockLua")

public void testLockLua() {

//1 声明一个uuid ,将做为一个value 放入我们的key所对应的值中

String uuid = UUID.randomUUID().toString();

//2 定义一个锁:lua 脚本可以使用同一把锁,来实现删除!

String skuId = "25"; // 访问skuId 为25号的商品

String locKey = "lock:" + skuId; // 锁住的是每个商品的数据

// 3 获取锁

Boolean lock = redisTemplate.opsForValue().setIfAbsent(locKey, uuid, 3, TimeUnit.SECONDS);

// 第一种: lock 与过期时间中间不写任何的代码。

// redisTemplate.expire("lock",10, TimeUnit.SECONDS);//设置过期时间

// 如果true

if (lock) {

// 执行的业务逻辑开始

// 获取缓存中的num 数据

Object value = redisTemplate.opsForValue().get("num");

// 如果是空直接返回

if (StringUtils.isEmpty(value)) {

return;

}

// 不是空 如果说在这出现了异常! 那么delete 就删除失败! 也就是说锁永远存在!

int num = Integer.parseInt(value + "");

// 使num 每次+1 放入缓存

redisTemplate.opsForValue().set("num", String.valueOf(++num));

/*使用lua脚本来锁*/

// 定义lua 脚本

String script = "if redis.call('get', KEYS[1]) == ARGV[1] then return redis.call('del', KEYS[1]) else return 0 end";

// 使用redis执行lua执行

DefaultRedisScript<Long> redisScript = new DefaultRedisScript<>();

redisScript.setScriptText(script);

// 设置一下返回值类型 为Long

// 因为删除判断的时候,返回的0,给其封装为数据类型。如果不封装那么默认返回String 类型,

// 那么返回字符串与0 会有发生错误。

redisScript.setResultType(Long.class);

// 第一个要是script 脚本 ,第二个需要判断的key,第三个就是key所对应的值。

redisTemplate.execute(redisScript, Arrays.asList(locKey), uuid);

} else {

// 其他线程等待

try {

// 睡眠

Thread.sleep(1000);

// 睡醒了之后,调用方法。

testLockLua();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

if redis.call('get', KEYS[1]) == ARGV[1] then return redis.call('del', KEYS[1]) else return 0 end

如果redis里面 num ==10 然后 删除num 1 return 0lUA脚本

Lua 是一个小巧的脚本语言,Lua脚本可以很容易的被C/C++ 代码调用,也可以反过来调用C/C++的函数,Lua并没有提供强大的库,一个完整的Lua解释器不过200k,所以Lua不适合作为开发独立应用程序的语言,而是作为嵌入式脚本语言。

很多应用程序、游戏使用LUA作为自己的嵌入式脚本语言,以此来实现可配置性、可扩展性。

这其中包括魔兽争霸地图、魔兽世界、博德之门、愤怒的小鸟等众多游戏插件或外挂。

LUA脚本在Redis中的优势

将复杂的或者多步的redis操作,写为一个脚本,一次提交给redis执行,减少反复连接redis的次数。提升性能。

LUA脚本是类似redis事务,有一定的原子性,不会被其他命令插队,可以完成一些redis事务性的操作。

但是注意redis的lua脚本功能,只有在Redis 2.6以上的版本才可以使用。

lua脚本示例

local userid=KEYS[1];

local prodid=KEYS[2];

local qtkey="sk:"..prodid..":qt"; // str="sk:"+hfjsdgfjhhsg+":qt"

local usersKey="sk:"..prodid..":usr";

local userExists=redis.call("sismember",usersKey,userid);

if tonumber(userExists)==1

then

return 2;

end

local num= redis.call("get" ,qtkey);

if tonumber(num)<=0 then

return 0;

else

redis.call("decr",qtkey);

redis.call("sadd",usersKey,userid);

end

return 1;出错

针对如上错误,作如下处理:

1)查看打开文件的上限和redis服务进程,修改上限:

输入如下命令,查看其上限:

ulimit -a

设置上限

ulimit -n 10032

重启redis即可

redission 实现分布式锁 自动续期 sso

springboot+redis

1131

1131

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?