firecrawl本地部署真的是超级多的坑,为了不再让各位同行和我一样深受其害,我会将我遇到的所有的坑,全都说明上,并写出解决办法

1.拉取firecrawl(你首先需要有git,没有git自行下载)

git clone https://github.com/mendableai/firecrawl.git

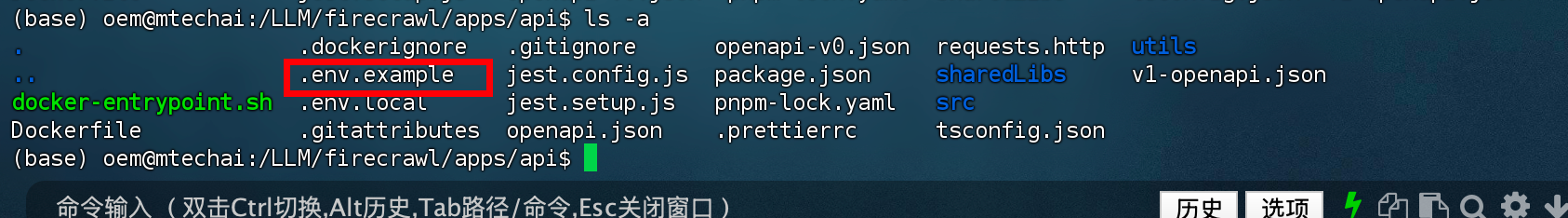

2.git拉取完成之后会有一个firecrawl文件,我们需要

cd /firecrawl/apps/api

3.进入到api文件后 输入 ls -a,可以看到有一个 .env.example 的文件

4.我们需要将这个文件复制到firecrawl文件目录下

4.我们需要将这个文件复制到firecrawl文件目录下

cp ./.env.example ../../.env

可以看到 firecrawl下有一个.env文件

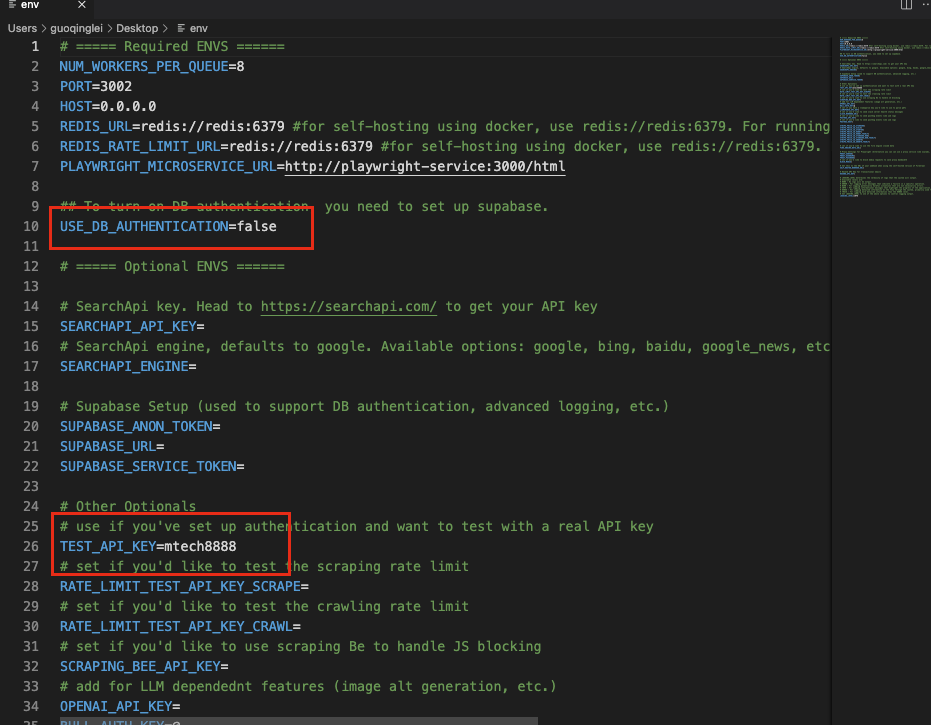

5.然后需要修改我们刚才复制的.env这个文件,你可以将这个文件使用编辑器打开,按照我划红线的位置修改

6.修改完成后,你可以再次查看 看看有没有修改成功,修改成功后你需要使用docker 开始拉取

docker pull python

docker pull golang:1.24

docker pull node:18-slim

docker pull redis:alpine

7.在firecrawl目录下 使用命令

docker compose build

上个命令执行完后执行

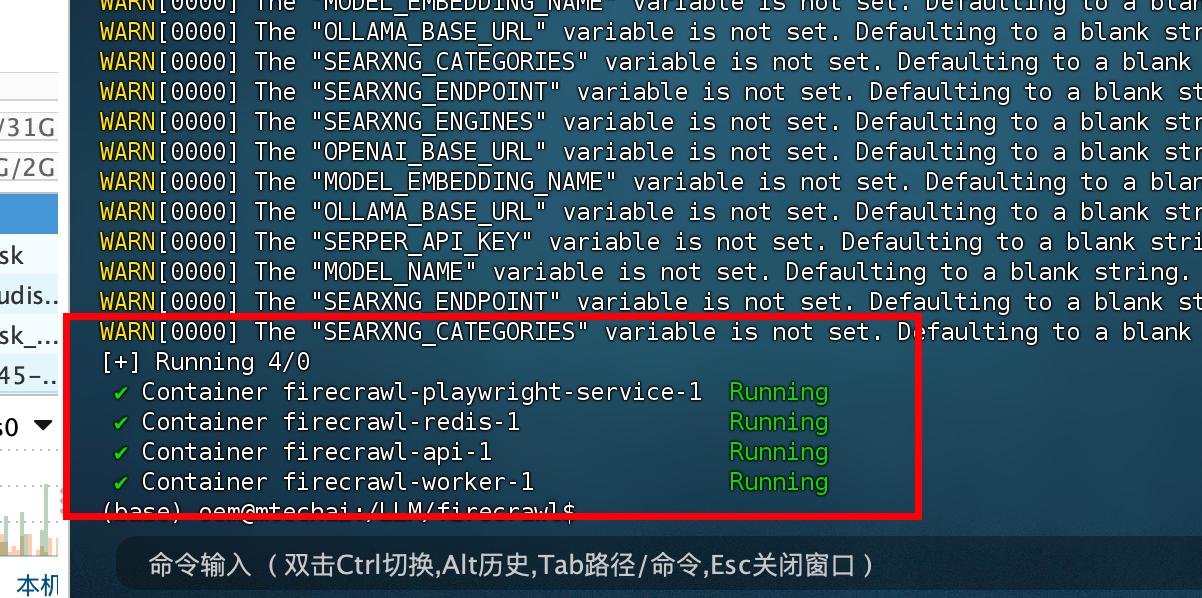

docker compose up -d

出现这样的信息就是成功了

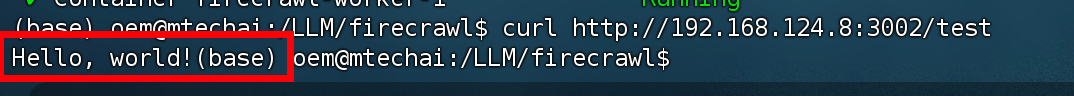

8.可以使用 curl http://192.168.124.8:3002/test (这里我使用的我本机地址,你需要换成你的本机地址),显示hello word 就是成功启动了

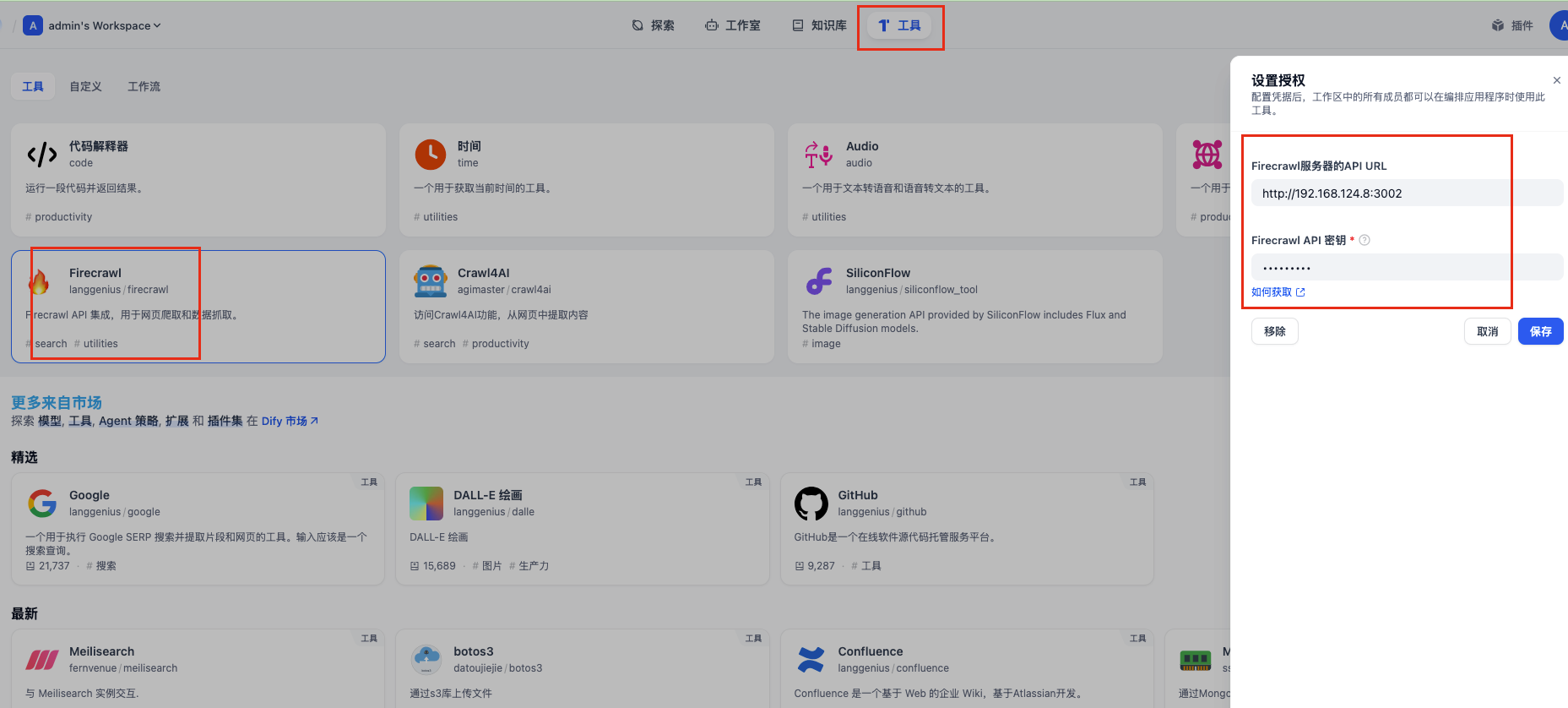

9.在dify中使用授权,如果没有安装,可以在dify工具中搜索安装

10.遇到的所有的坑

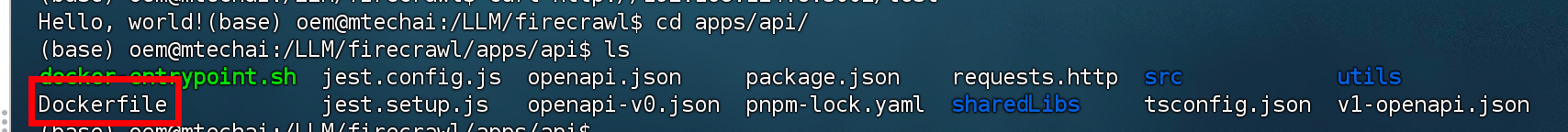

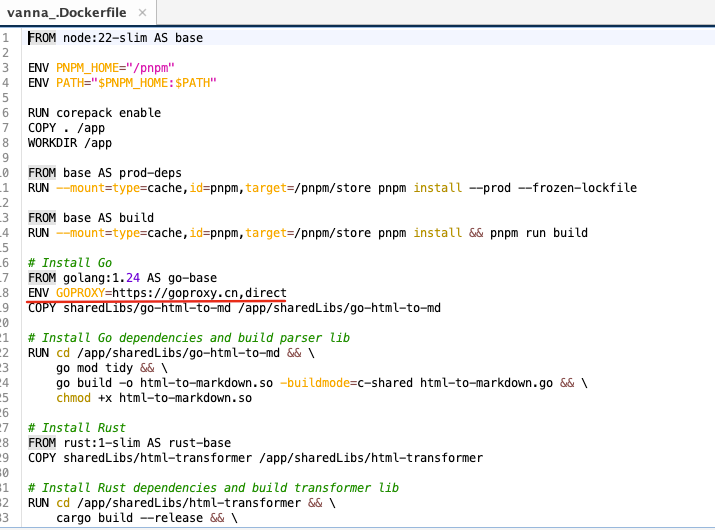

(1)在我compose build 或者 up 的时候报错,是一个go语言的报错

你需要进入 firecrawl/apps/api 输入 ls 可以看到有一个 docker file 文件

修改这个文。添加 ENV GOPROXY=https://goproxy.cn,direct 然后保存 或者从新传到api中,然后从新执行 docker compose build docker compose up -d

修改这个文。添加 ENV GOPROXY=https://goproxy.cn,direct 然后保存 或者从新传到api中,然后从新执行 docker compose build docker compose up -d

(2) 第二个坑就是,我在dify授权firecrawl的时候 一直保存不了,这是因为防火墙设置,我使用的是ubuntu系统,执行以下命令,把3002

ubuntu:

查看防火墙状态:sudo ufw status

打开某个端口:sudo ufw allow 3002/tcp

如果有3002/tcp (v6) ALLOW Anywhere (v6) 那么就可以保存了

(3)如果你的docker 一直拉不下来你可以更换你的镜像源,这是我配置的镜像源地址 ,你可以使用

{

"registry-mirrors":

[

"https://docker.registry.cyou",

"https://docker-cf.registry.cyou",

"https://dockercf.jsdelivr.fyi",

"https://docker.jsdelivr.fyi",

"https://dockertest.jsdelivr.fyi",

"https://mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://docker.mirrors.ustc.edu.cn",

"https://mirror.iscas.ac.cn",

"https://docker.rainbond.cc"

]

}

3938

3938

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?