0 前言

腾讯混元大模型(Tencent Hunyuan)具备:

- 强大的中文创作能力

- 复杂语境下的逻辑推理能力

- 可靠的任务执行能力

基于混元大模型,腾讯云推出文本生成、图像创作、视频创作产品方案,覆盖全场景AIGC应用:

1 都有啥产品?

1.1 大模型知识引擎

混元生文

基于自然语言对话方式,可结合输入的文本或图片输出相关文本内容,可在文本生成、创作、问答等场景服务各类行业。

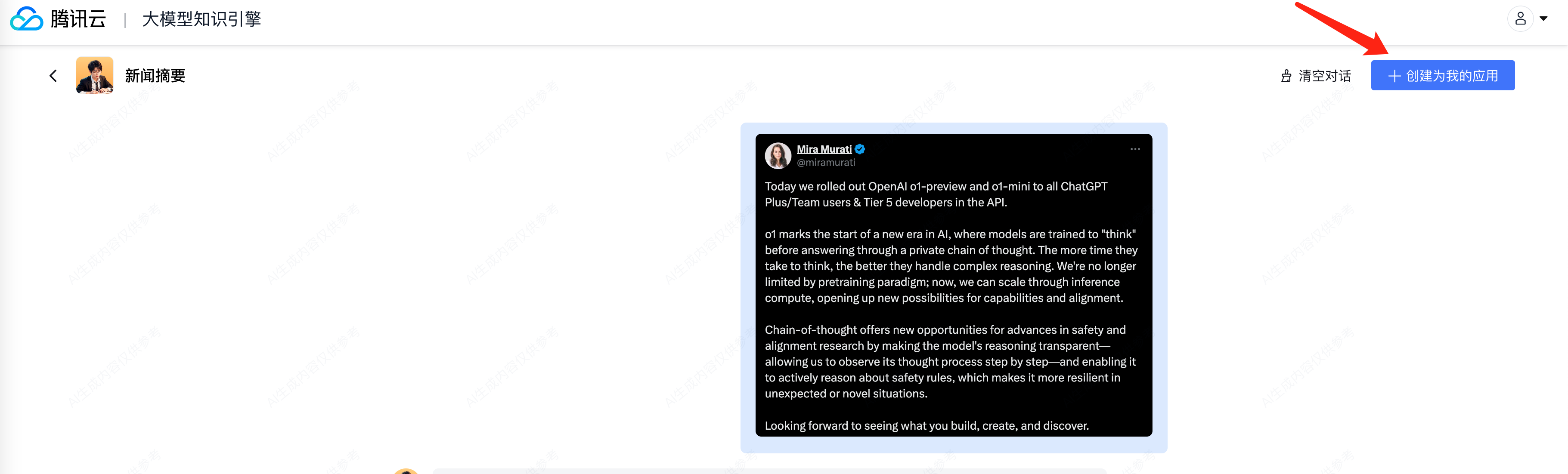

点击,进入新闻摘要:

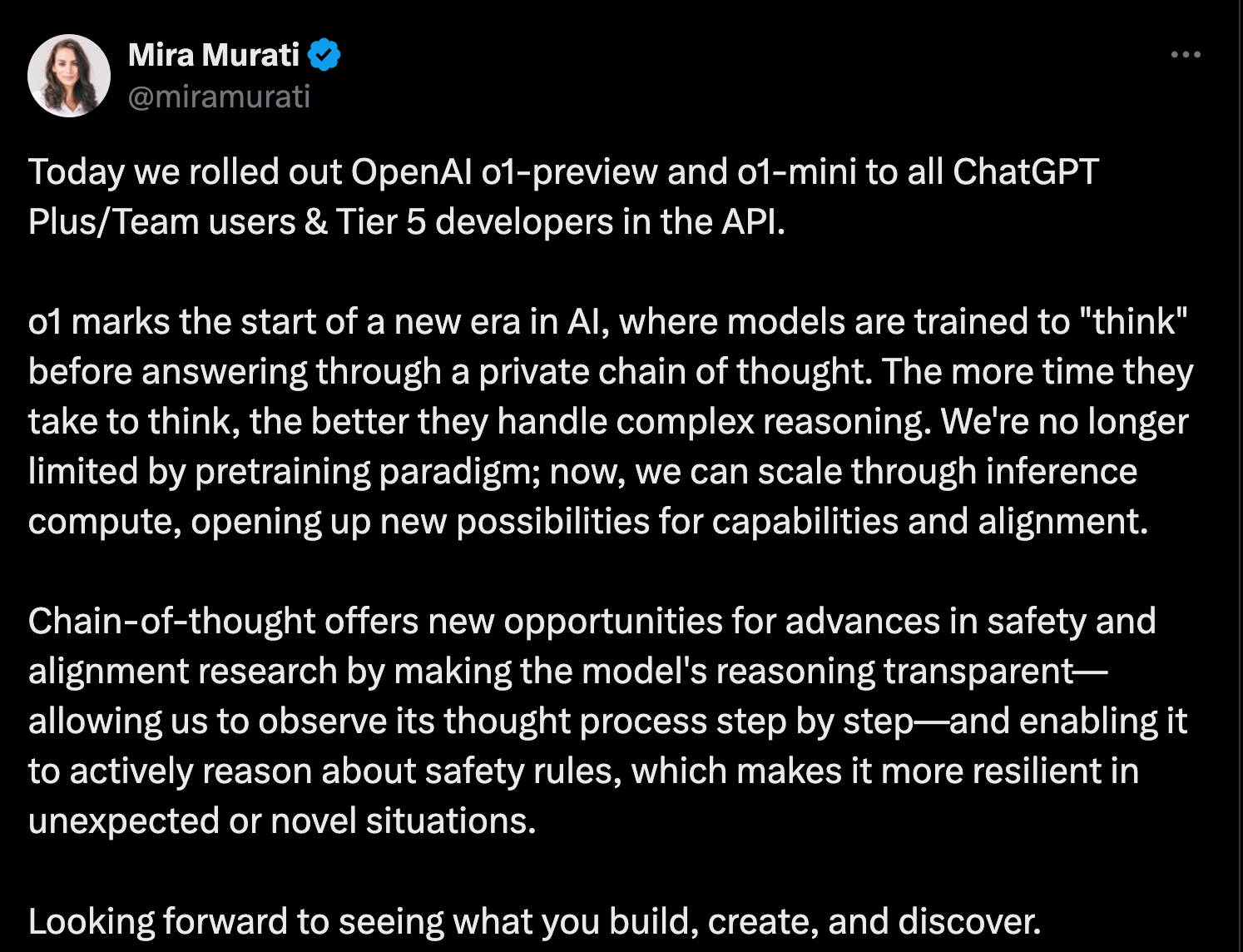

正好 OpenAI最近有大更新的头条:

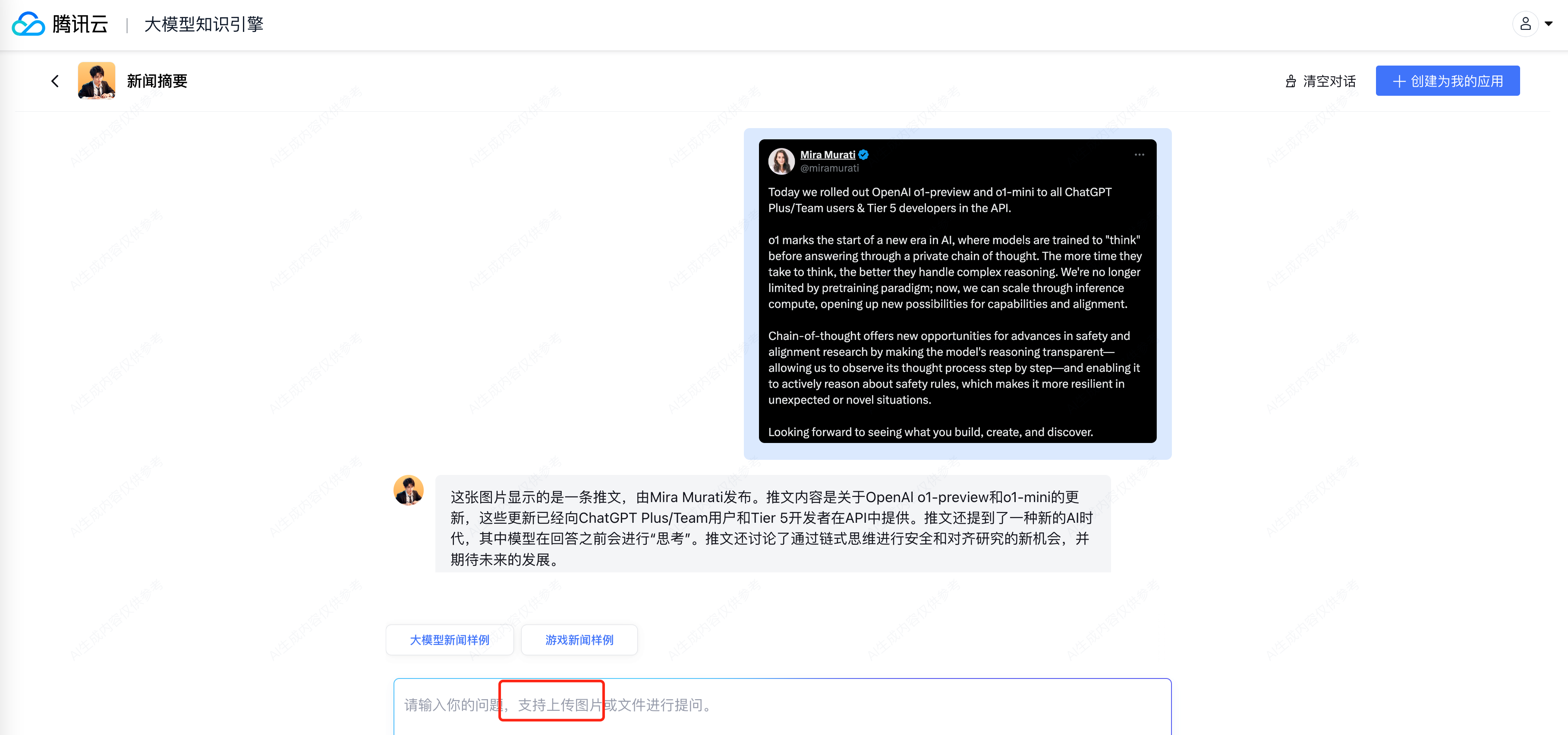

我们来看看使用混元大模型的解读:

快速帮我们总结了这篇全英文AI头条的核心概念。再不用自己翻译并用中文通读和理解一遍了!

而且还支持直接截图去理解回答:

1.2 混元文生图大模型

混元生图

基于混元文生图大模型,可结合输入的文本描述智能创作出与输入相关的图像内容,为高质量的内容创作、内容运营提供技术支持。

1.3 大模型图像创作引擎

提供AI图像生成与编辑技术服务,可以结合输入的文本或图片智能创作图像。

图像风格化

基于图生图技术将输入的图像进行风格转化,支持动漫、3D、水彩画等多种风格。

大模型图像创作引擎提供AI图像生成与编辑技术服务,可以结合输入的文本或图片智能创作图像。

AI写真

提供 AI 写真训练与生成能力,训练指定人物形象的写真模型,生成多样化风格的写真形象照。

商品背景生成

按照自定义的文本描述智能生成和替换商品图中的背景画面。

1.4 大模型视频创作引擎

视频转译

转译后的视频,能够保留说话人的音色特征,同时实现说话人口型与目标语种一致的视听效果。适用于视频本地化、跨境电商等场景。

基于大模型视频创作引擎,包括视频转译、视频风格化、图片跳舞等多项视频创作能力,基于腾讯混元大模型等一系列领先的人工智能音视频处理技术,支持用户高质量生成视频并处理视频内容。广泛应用在影视制作、广告营销、短视频、游戏等领域。

视频风格化

基于混元视频生成大模型技术,支持将输入视频生成特定风格的视频。生成后的视频画面流畅自然,时序一致性强。

图片跳舞

输入单张全身人像照片并选择舞蹈模板,即可生成对应模板的跳舞视频。生成后的视频,表情自然、动作流畅,娱乐性强。

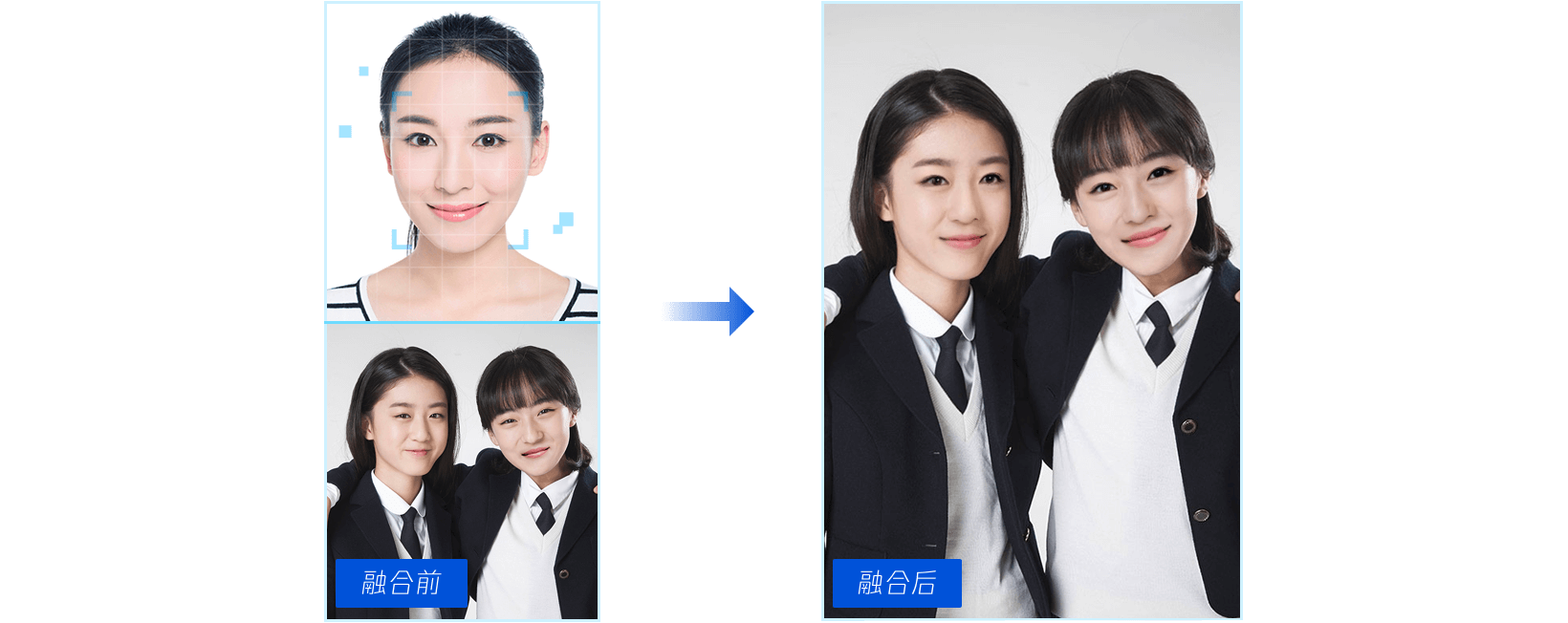

1.5 人脸融合

人脸融合(Face Fusion)可将一张人脸图像对应的人脸特征融合到模板图像中的特定人物上,生成的图片既兼具指定图像和模板图像中的人脸特征,也保持了模板图像中人物的姿态、表情、动作等属性,支持单脸、多脸、选脸融合。

2 创建自己的应用

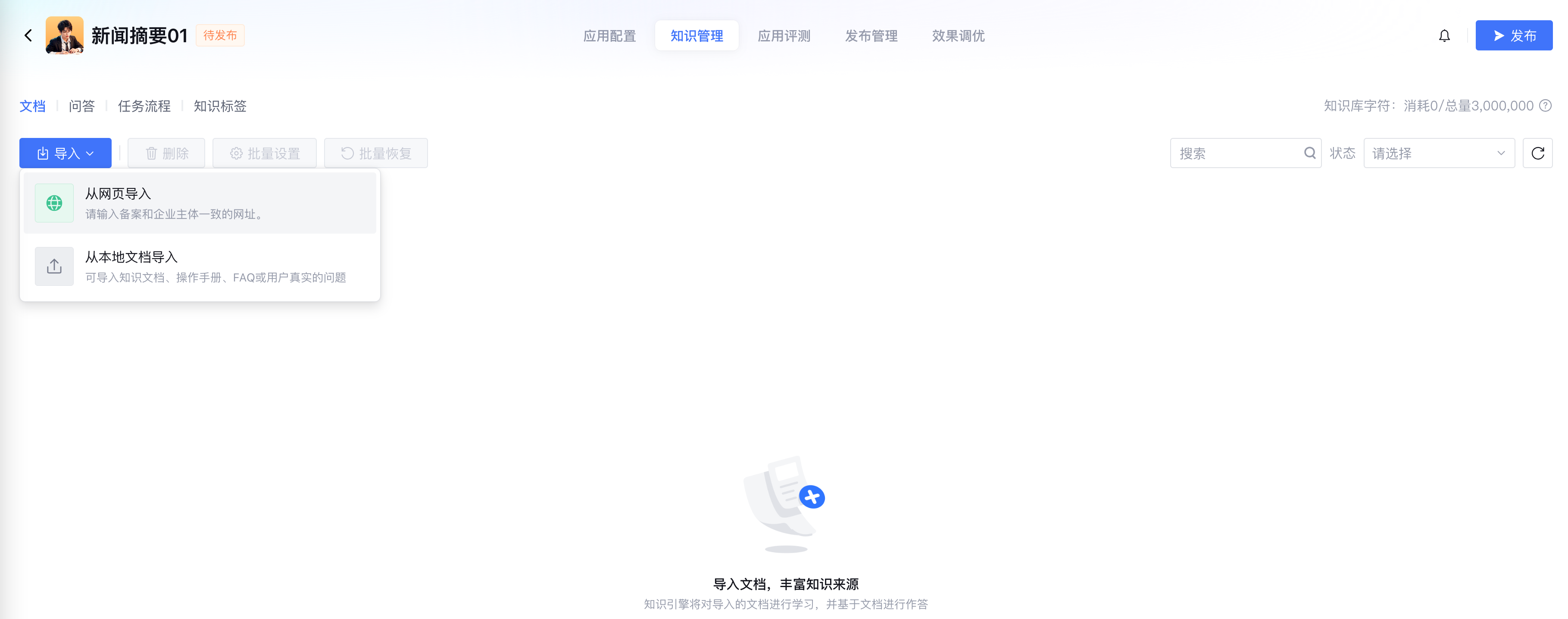

比如1.1节里提到的混元生文,点击【创建为我的应用】:

应用配置

可配置如下基础信息:

知识管理

注意到这里的知识库和支持的大模型列表:

点击上图中的蓝色高亮的【知识管理】就来到这里:

我们来导入本地文件:

等待他解析并完成内容审核成功:

学习中,【发布】按钮会置灰:

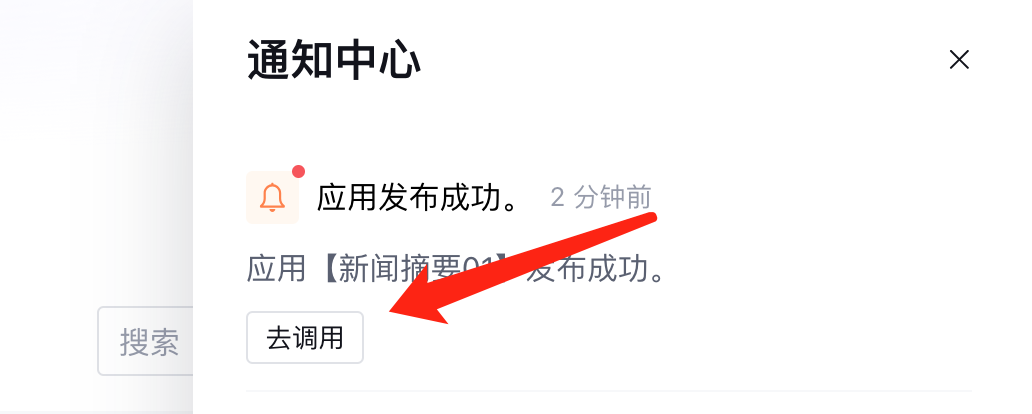

等到学习完成,文档即变成待发布状态,之后点击发布即可,填写发布说明:

等待发布过程结束,这里注意到文档也会消耗一定 token 的哟:

发布管理

发布成功通知后,点击去调用:

直接根据指引,选择直接在线使用还是接入 API 即可玩耍:

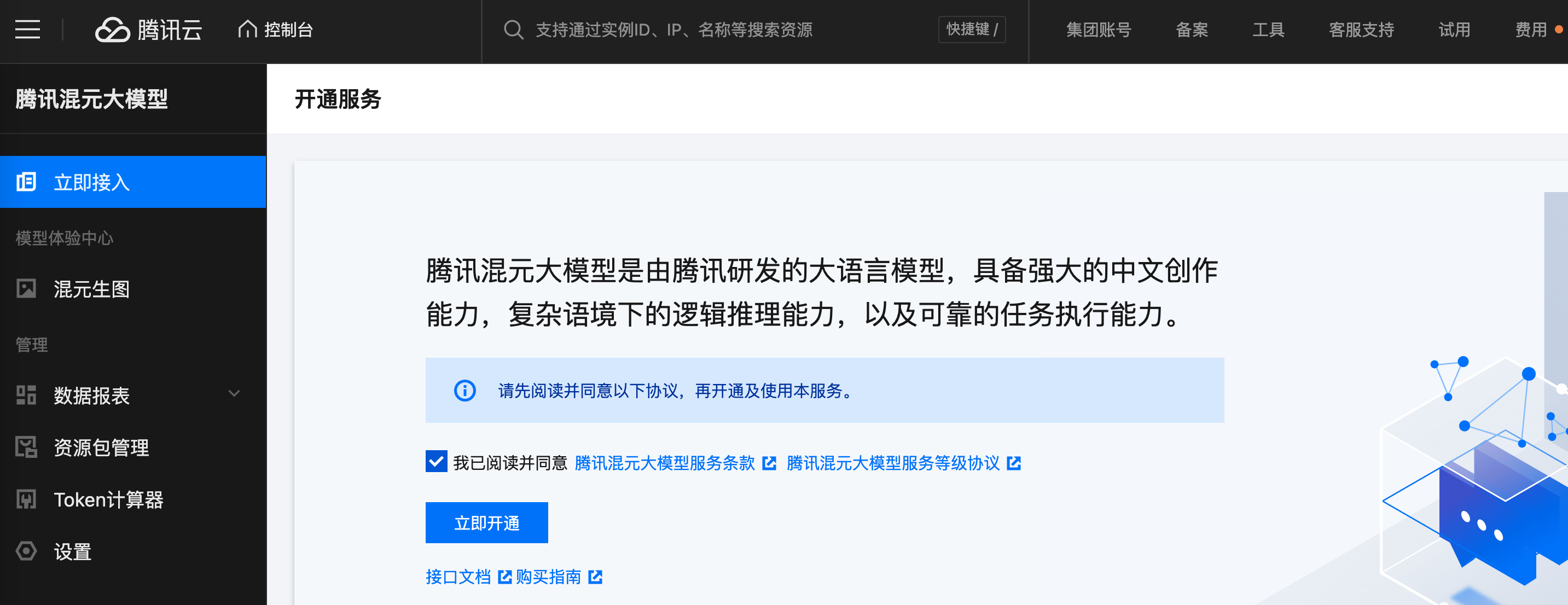

3 更多规格的大模型

点击直达:

新用户专享资源包

新人还能 0 元购!

体验混元的无穷乐趣,点击直达,直接0 元开通!

如何系统的去学习大模型LLM ?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

事实上,抢你饭碗的不是AI,而是会利用AI的人。

继科大讯飞、阿里、华为等巨头公司发布AI产品后,很多中小企业也陆续进场!超高年薪,挖掘AI大模型人才! 如今大厂老板们,也更倾向于会AI的人,普通程序员,还有应对的机会吗?

与其焦虑……

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高。

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、LLM大模型经典书籍

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套LLM大模型报告合集

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、LLM大模型系列视频教程

四、LLM大模型开源教程(LLaLA/Meta/chatglm/chatgpt)

LLM大模型学习路线 ↓

阶段1:AI大模型时代的基础理解

-

目标:了解AI大模型的基本概念、发展历程和核心原理。

-

内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

-

目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

-

内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.3 流水线工程

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

-

目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

-

内容:

- L3.1 Agent模型框架

- L3.2 MetaGPT

- L3.3 ChatGLM

- L3.4 LLAMA

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

-

目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

-

内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

这份 LLM大模型资料 包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

639

639

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?