前 言

Jetson Orin NX 是专为边缘计算设计的高性能设备,其核心优势包括:

- 超强算力与能效平衡:搭载 NVIDIA Ampere 架构 GPU(含 1024 个 CUDA 核心和 128 个 Tensor Core)及专用深度学习加速器(DLA),AI 性能达 100 TOPS,支持 Super 模式提升算力至 2 倍,同时功耗仅 10-25 瓦,适合嵌入式场景。

- 多传感器融合能力:支持 16 路 GMSL 相机输入、激光雷达、毫米波雷达等多源数据同步处理,通过 μs 级硬件时间戳对齐实现精准环境感知。

- 完善软件生态:依托 JetPack SDK 提供 TensorRT、CUDA 等工具链,可快速将 YOLO 等 AI 模型优化为 TensorRT 引擎,显著降低推理延迟。

- 灵活扩展性:配备 PCIe Gen4、USB 3.2、M.2 等高速接口,支持多摄像头并行接入与复杂传感器配置,适用于智能安防、工业质检等多样化场景。

将 YOLO 算法部署于 Orin NX 的核心原因:

- 实时性保障:YOLO 轻量级架构结合 Orin NX 的硬件加速(如 TensorRT 优化),可实现毫秒级目标检测。例如,YOLOv8 在 Orin NX 上通过 INT8 量化后推理时间缩短至 20ms 以内,满足交通监控、无人机巡检等场景的实时需求。

- 边缘计算优势:本地化处理避免云端依赖,降低网络带宽消耗(如多路 4K 视频流无需上传),同时保护数据隐私。

- 硬件协同优化:Orin NX 的 GPU 和 DLA 专为 AI 推理设计,可并行处理多帧图像。例如,Super 模式下 YOLOv8 的帧率提升 1.5-2 倍,显著增强复杂场景下的检测效率。

- 多场景适配:支持多传感器融合(如 LiDAR + 摄像头)和动态模型更新,适用于智能物流、机器人导航等需实时环境感知与决策的领域。

部署的环境配置都有哪些?

- JetPack SDK 安装:

一般买的Jetson Orin NX边缘计算设备上,都已经刷入了最新 JetPack(如 JetPack 5.1.2),包含 CUDA 11.4、cuDNN 8.6、TensorRT 8.5 、Python3.8 等依赖,这些一般不需要自己安装。

- 基础插件安装:

主要包括:TensorFlow、Pytorch、TorchVision、ZED2相机软件、Ultralyrtics(YOLOV8)。

系 统 信 息

lsb_release -a # 输出系统版本(如Ubuntu 20.04.6 LTS):cite[3]:cite[8]

sudo apt-cache show nvidia-jetpack # 查看JetPack版本(如5.1.3):cite[3]:cite[8]

dpkg -l | grep -E "cuda|tensorrt|opencv" # 检查关键组件(CUDA/TensorRT等)

nvcc --version # 输出CUDA版本(如11.4.315):cite[3]

sudo jetson_stats # 安装后运行jtop,可视化查看CPU/GPU/内存占用:cite[3]

jtop # 可视化查看CPU/GPU/内存占用:cite[3]比如我的系统信息如下:JetPack=5.1.3 [L4T 35.5.0]、Ubuntu=20.04.6LTS、Python=3.8.20、CUDA=11.4 V11.4.315。

如上述版本无误,但在查询组件时遇见如下报错:

nvcc --version -bash: nvcc: command not found sudo jetson_stats: command not found jtop: command not found# (1)nvcc不可用 # 原因:CUDA 工具链未安装或未正确配置 PATH。 # 解决方案:安装完整 CUDA 工具包: sudo apt install cuda-toolkit-11-4 # JetPack 5.1 默认对应 CUDA 11.4 # 添加 PATH 到环境变量(安装后执行): echo 'export PATH=/usr/local/cuda/bin:$PATH' >> ~/.bashrc source ~/.bashrc # (2)jtop 和 jetson_stats 不可用 # 原因:未安装 Jetson 状态监控工具。 # 解决方案:通过 pip 安装 jetson-stats: sudo pip3 install jetson-stats # 安装后重启系统,运行 jtop 即可监控设备状态。

1. Miniconda安装及虚拟环境创建

在 NVIDIA Jetson 设备上(ARM64 架构)安装 Miniconda 已适配 JetPack 5.1.5 和 Ubuntu 20.04 环境:

1.1 下载Miniconda 安装包

Jetson 设备必须使用 aarch64 (ARM64) 版本,x86_64 版本不兼容

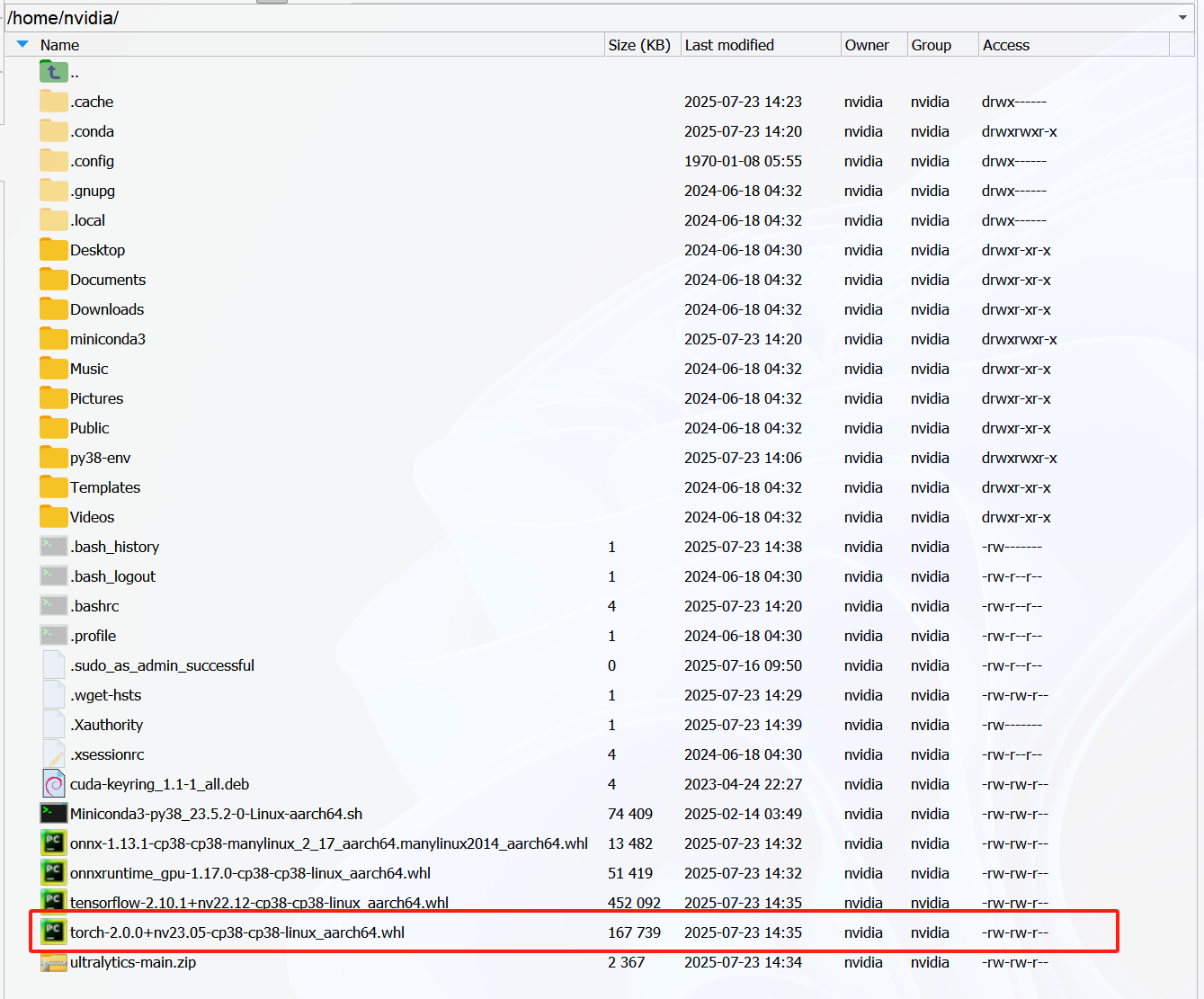

wget https://repo.anaconda.com/miniconda/Miniconda3-py38_23.5.2-0-Linux-aarch64.sh将下载的文件移至路径(后面的几个文件操作类似,不再赘述):/home/nvidia/

1.2 执行安装脚本

bash Miniconda3-py38_23.5.2-0-Linux-aarch64.sh1.3 创建适配 Jetson 的 Python 环境

conda create -n py38-env python=3.8 -y

conda activate jetson-env1.4 安装 Jetson 专用扩展包

pip install --pre --extra-index-url https://developer.download.nvidia.com/compute/redist/jp/v51 \

nvidia-cuda-runtime-cu11 \

nvidia-cudnn \

nvidia-tensorrt1.5 . 配置 CUDA 兼容性(关键步骤)

echo -e "\n# Jetson CUDA Path" >> ~/.bashrc

echo "export LD_LIBRARY_PATH=/usr/local/cuda-11.4/lib64:\$LD_LIBRARY_PATH" >> ~/.bashrc

source ~/.bashrc2. Pytorch环境搭建

PyTorch 是一个由 Meta(原 Facebook)开发的开源深度学习框架,以灵活性和易用性著称,广泛用于学术研究和工业应用。参考链接:

https://forums.developer.nvidia.com/t/pytorch-for-jetson/72048

Installing PyTorch for Jetson Platform - NVIDIA Docs

2.1 安装依赖

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/arm64/cuda-keyring_1.1-1_all.deb # 1. 下载CUDA存储库密钥环包(适用于Ubuntu 22.04)

sudo dpkg -i cuda-keyring_1.1-1_all.deb# 2. 安装CUDA GPG密钥

sudo apt update # 3. 更新软件包列表

sudo apt -y install libcusparselt0 libcusparselt-dev -y # 4. 安装稀疏矩阵计算库

sudo apt remove python3-sympy # 5. 移除Python符号计算库

2.2 安装Pytorch

PyTorch的安装选择离线和在线的其中一种方式即可!

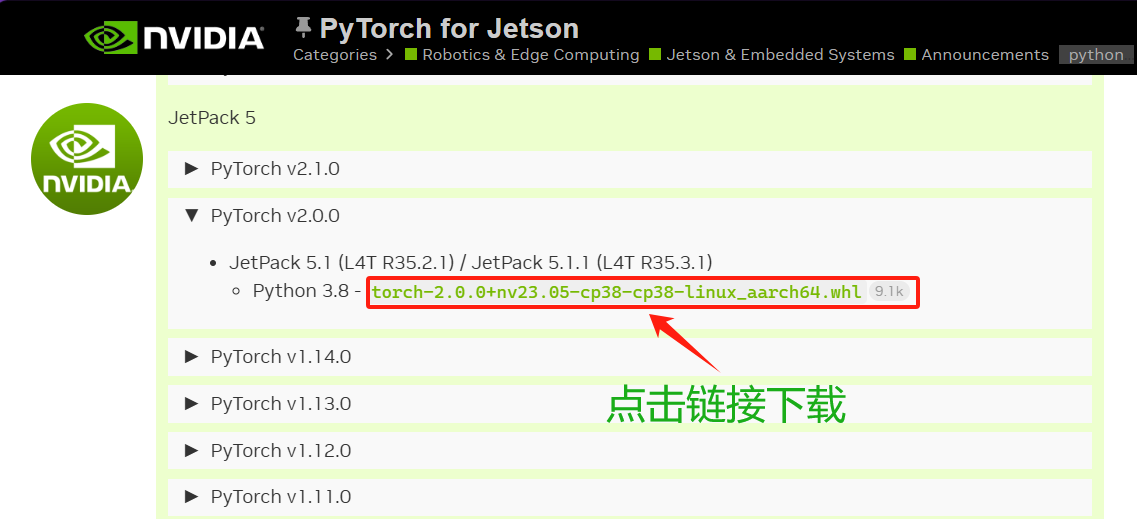

2.2.1 离线安装

手动进入下载网址下载指定的PyTorch版本。

下载网址:https://forums.developer.nvidia.com/t/pytorch-for-jetson/72048

cd Downloads/ #绝对下载路径

pip3 install torch-2.0.0+nv23.05-cp38-cp38-linux_aarch64.whl2.2.2 在线安装

export TORCH_INSTALL=https://developer.download.nvidia.cn/compute/redist/jp/v61/pytorch/torch-2.0.0+nv23.05-cp38-cp38-linux_aarch64.whl

sudo python3 -m pip install --no-cache $TORCH_INSTALL2.3 验证安装

python3 -c "import torch; print(f'Torch: {torch.__version__}')"

# 正常输出版本号:Torch: 2.0.0+nv23.05

3. Torchvision环境搭建

参 考 链 接 :

【问题解决】Jetson nano 安装torchvision-0.15.1_jetson torchvision-优快云博客

https://github.com/pytorch/vision

Quick Start Guide: NVIDIA Jetson with Ultralytics YOLO11

3.1 安装依赖

sudo apt update

sudo apt install ninja-build libwebp-dev libjpeg-dev -y3.2 安装Torchvision

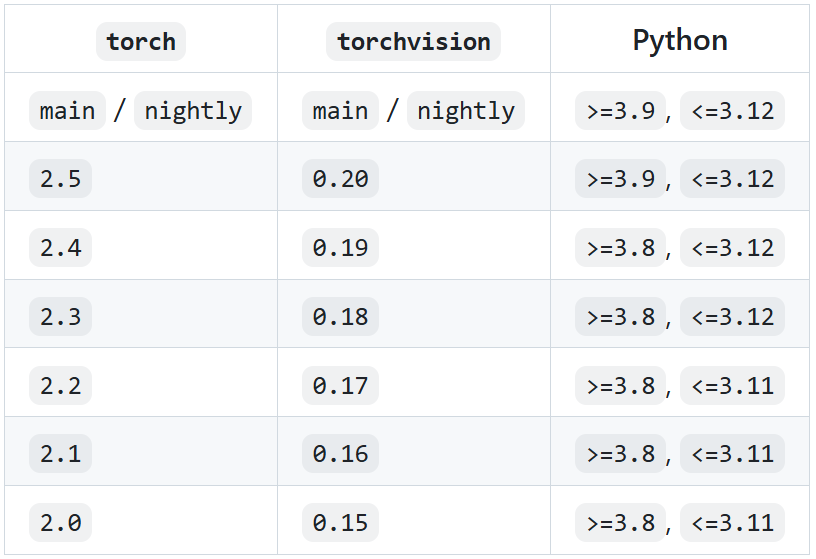

根据PyTorch与Torchvision版本对应关系,我们需要安装v0.15版本Torchvision。

#安装依赖

sudo apt-get install libjpeg-dev zlib1g-dev libpython3-dev libopenblas-dev libavcodec-dev libavformat-dev libswscale-dev

pip3 install setuptools

#克隆torchvision源代码

git clone --branch v0.15.1 https://gitclone.com/github.com/pytorch/vision torchvision

cd torchvision/

#编译

export BUILD_VERSION=0.15.1

python3 setup.py install

3.3 验证安装

python3 -c "import torchvision; print(f'Torchvision: {torchvision.__version__}')"

4. TensorFlow环境搭建

TensorFlow 是一个由 Google 开发并开源的端到端机器学习和深度学习框架,用于构建和训练各种类型的机器学习模型。参 考 链 接 :

Installing TensorFlow for Jetson Platform - NVIDIA Docs

4.1 安装TensorFlow

TensorFlow的安装选择离线和在线的其中一种方式即可!

4.1.1 离线安装(推荐)

手动进入下载网址下载指定的TensorFlow版本。

cd Downloads/ #绝对下载路径

pip3 install tensorflow-2.10.1+nv22.12-cp38-cp38-linux_aarch64.whl4.1.2 在线安装

export TORCH_INSTALL=https://developer.download.nvidia.cn/compute/redist/jp/v502/tensorflow/tensorflow-2.10.1+nv22.12-cp38-cp38-linux_aarch64.whl

sudo python3 -m pip install --no-cache $TORCH_INSTALL4.1.3 安装Numpy

安装指定版本的Numpy:后期的YOLO8也需要该版本的Numpy

sudo pip install numpy==1.23.54.2 验证安装

python3 -c "import tensorflow as tf; print(f'TensorFlow: {tf.__version__}')"

# 输出 TensorFlow: 2.10.1

3008

3008

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?