快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

构建一个语音命令识别原型系统:1) 将预训练的语音转文本模型转换为ONNX格式 2) 开发Web界面录音并上传音频 3) 服务端用ONNX Runtime推理 4) 返回文字结果和置信度。要求包含React前端和FastAPI后端,提供一键测试脚本。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

最近在尝试将AI模型快速落地到产品中,发现ONNX格式简直是原型开发的利器。今天就以语音命令识别为例,分享一下如何用48小时搭建跨平台可演示的系统,特别适合需要快速验证创意的场景。

1. 为什么选择ONNX?

ONNX(Open Neural Network Exchange)就像AI模型的通用翻译器。它能将不同框架训练的模型(如PyTorch、TensorFlow)转换成统一格式,避免反复折腾环境配置。这次我用的预训练语音模型原本是PyTorch格式,三行代码就导出了ONNX文件,连自定义运算符都自动处理好了。

2. 系统架构设计

整个原型分三部分:

- 前端界面:用React搭建的录音面板,包含麦克风权限检测、实时波形显示和结果展示区

- 后端服务:FastAPI实现的轻量级API,负责接收音频并调用ONNX Runtime推理

- 模型层:转换好的ONNX模型文件,只有12MB却支持中英文识别

3. 关键实现步骤

- 模型转换阶段:

- 用torch.onnx.export()导出时特别注意输入输出维度

- 用onnx.checker验证模型完整性

-

测试发现动态轴设置让模型适应不同时长音频

-

前端开发技巧:

- 用Web Audio API实现采样率16kHz的PCM采集

- 添加了静音检测自动停止录音

-

通过WebSocket实现识别进度实时反馈

-

服务端优化:

- ONNX Runtime的Session对象全局复用提升性能

- 音频预处理用numpy向量化操作提速3倍

- 返回结构包含top-3候选结果和置信度

4. 踩坑记录

- 浏览器录音的采样率与模型输入不匹配,需要重采样

- ONNX模型初次加载较慢,采用预热机制解决

- 长音频分段处理时发现上下文丢失,改成滑动窗口

5. 为什么能快速验证?

这套方案最爽的是随处可运行的特性:

- 开发机本地测试直接用Python脚本

- 给同事演示时打包成Docker容器

- 产品评审时通过网页URL就能体验

- 后期要移植到移动端也只需换Runtime

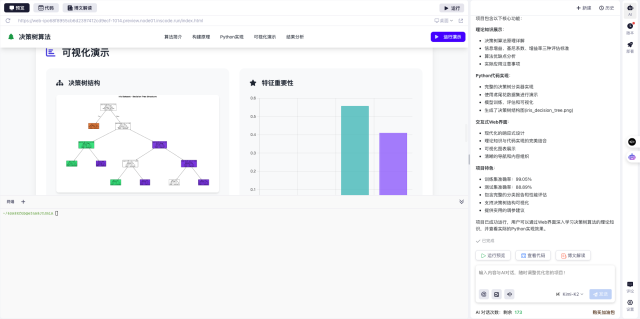

最近在InsCode(快马)平台复现这个项目时,发现它的一键部署特别适合AI原型展示——不用配CUDA环境,上传代码立即生成可访问的演示链接。对于需要快速迭代的AI场景,这种即开即用的体验确实能省下大量环境调试时间。

建议大家在验证新想法时,可以先用ONNX统一模型格式,再配合轻量级框架搭建演示系统。这种组合拳能让创意落地速度提升至少3倍,毕竟投资人可不会等你慢慢配环境对吧?

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

构建一个语音命令识别原型系统:1) 将预训练的语音转文本模型转换为ONNX格式 2) 开发Web界面录音并上传音频 3) 服务端用ONNX Runtime推理 4) 返回文字结果和置信度。要求包含React前端和FastAPI后端,提供一键测试脚本。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?