快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框输入如下内容

帮我开发一个AI模型管理系统,帮助开发者快速定位和管理本地AI模型文件。系统交互细节:1.显示模型存储路径 2.支持路径自定义设置 3.提供模型分类管理 4.支持快速搜索功能。注意事项:不同平台路径可能有所差异。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

在AI模型开发过程中,模型文件的存储管理是个容易被忽视但至关重要的问题。很多开发者在使用Ollama时都会遇到找不到模型文件的困扰,下面我们就来详细解析这个问题。

-

通过CMD安装时的默认存储路径 当使用命令行安装Ollama模型时,所有模型文件默认会存放在用户目录下。具体路径通常为:C:\Users\你的用户名.ollama\models\manifests\registry.ollama.ai。需要注意的是,路径中的用户名部分会因系统而异,需要根据自己的实际情况调整。

-

Open WebUI下载的模型存储位置 通过Web界面下载的模型文件会存放在类似路径下,但会多一个library子目录:C:\Users\你的用户名.ollama\models\manifests\registry.ollama.ai\library。这里会同时显示通过不同方式下载的模型文件,方便统一管理。

-

路径查找技巧 如果找不到确切的路径,可以尝试以下方法:

- 在文件资源管理器中搜索.ollama文件夹

- 在命令行中输入ollama list查看已安装模型

-

检查环境变量中的OLLAMA_MODELS设置

-

模型文件管理建议 为了更好管理模型文件,建议:

- 定期清理不再使用的模型释放空间

- 考虑将模型文件迁移到空间更大的磁盘分区

-

为常用模型创建快捷方式方便访问

-

跨平台路径差异 需要注意的是,不同操作系统下模型存储路径会有所不同:

- Linux系统通常在~/.ollama/models

- MacOS在~/Library/Application Support/ollama/models

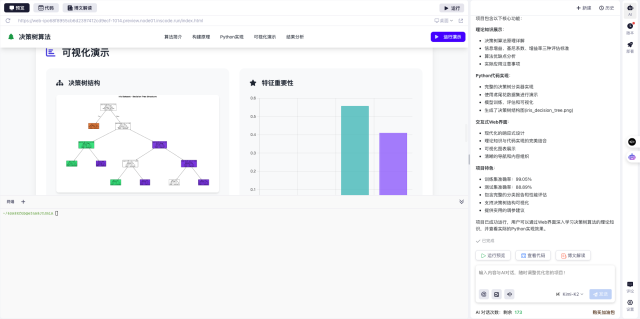

在实际使用中,我发现InsCode(快马)平台可以快速搭建一个模型管理系统原型,无需从零开始写代码。平台的内置AI助手能根据简单描述生成完整项目框架,特别适合想要快速验证想法的开发者。整个过程非常流畅,从描述需求到看到运行效果只需要几分钟时间。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?