1. 前言:从NLU到MLLM,这不仅仅是概念升级

还记得当年在爱丁堡大学死磕NLU(自然语言理解)的时候,Keller教授给出的定义吗?输入是自然语言,输出是计算机能理解的结构化信息。现在,风水轮流转,轮到多模态大模型(MLLM)了。

简单粗暴地说,MLLM就是把NLU的输入升级成文本+图片等等,但输出还是结构化信息(通常是文本)。这就像给AI加了个“眼睛”,让它不仅仅能“听懂”人话,还能“看懂”世界。

当下最火的,莫过于多模态大模型 MLLM (Multimodal Large Language Model):它是 Multimodality Understanding 与 LLM (Large Language Model) 的激情碰撞。

本文的目标?不是简单地复述论文,而是结合我多年的踩坑经验,用大白话把MLLM的那些弯弯绕绕给各位讲清楚。参考的这篇论文(A Survey on Multimodal Large Language Models)是基础,我的理解和吐槽才是灵魂。

2. 模型架构:三大组件,缺一不可?

MLLM的架构,说白了就是三个部分:

- 模态编码器 (Modality Encoder):负责把图片、音频这些“非人话”转换成AI能理解的“embedding”。

- 预训练大语言模型 (Pre-trained LLM):负责“理解”embedding,然后生成文本。

- 模态接口 (Modality Interface):负责把不同模态的信息“融合”在一起,让LLM能同时“看”和“听”。

这三个组件,就像是人的眼睛、大脑和神经系统,少了哪个都不行。

2.1 模态编码器:不只是压缩,更是对齐

模态编码器,顾名思义,就是把原始数据压缩成latent embedding。视觉编码器这块,直接拿来主义就行,用那些pre-train好的。

这里必须点名表扬CLIP(Contrastive Language-Image Pre-Training)。它通过大规模的图像-文本对预训练,让视觉编码器在语义上与文本对齐。这种预对齐简直是神来之笔,让后续的LLM对齐工作事半功倍。

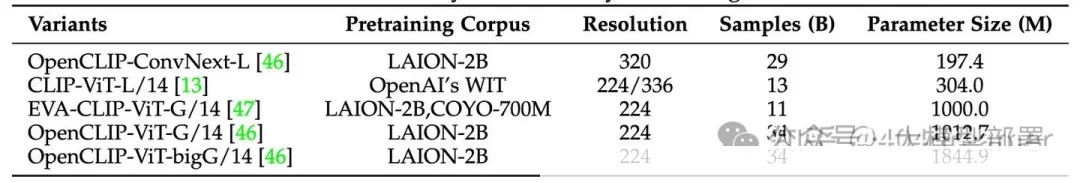

常用的视觉编码器详情

选择视觉编码器的时候,别光看参数量,分辨率、模型参数量和编码器的预训练数据集,一个都不能少。

记住,分辨率才是王道!

处理高分辨率图片,有两种主流策略:

- 双编码器融合:CogAgent就是个例子,用两个vision encoders分别处理高低分辨率图片,然后用cross-attention融合特征。

- 图片切片:把高分辨率图片切成小块,再用低分辨率编码器处理。这种方法可能需要positional embedding来标记每个小块的位置。

别纠结哪个更好,根据你的应用场景和计算资源来决定。

2.2 预训练大语言模型:参数量决定一切?Naive!

LLM,绝对是MLLM的核心。虽然现在都在卷千亿、万亿参数大模型,但参数量真能决定一切吗?Naive!

Scaling Law 固然重要,但训练策略更关键。参数量大了,训练不好,照样拉胯。所以,别盲目追求大,选择适合你应用场景的LLM才是正道。

2.3 模态接口:连接“眼睛”和“大脑”的桥梁

有了“眼睛”(模态编码器)和“大脑”(LLM),还得有个桥梁把它们连接起来。这个桥梁就是模态接口。

最常见的两种方法:

- Learnable Connector:通过一个可学习的模块,把多模态信息融合成LLM能理解的形式。

- Expert Model:让专家模型(比如image caption模型)把图片转换成文字,把多模态输入变成单模态输入。

2.3.1 Learnable Connector:两种融合方式,殊途同归?

Learnable Connector 的核心,就是把多模态信息融合成LLM能理解的信息。融合的粒度可以分为两种:token-level和feature-level。

-

Token-level Fusion:把modality encoder输出的特征转换成token representation,然后和text token representation拼接起来,作为LLM的输入。

-

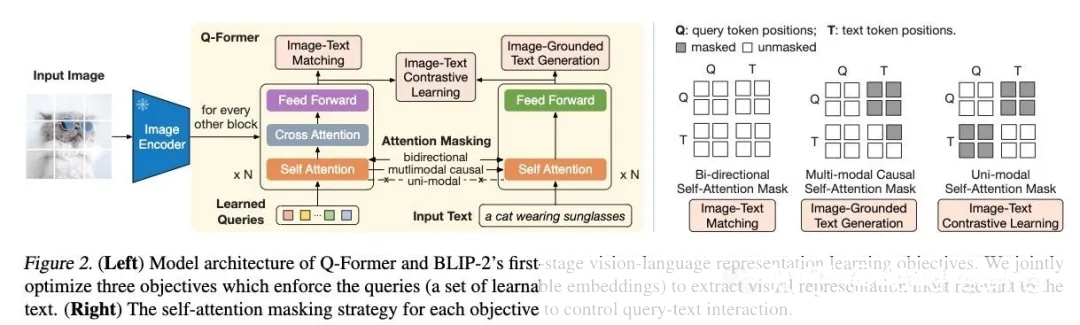

Q-former style (BLIP2):用learnable queries来缩小image encoder和LLM之间的gap。

Blip2: Q-former

* MLP (LLaVA):用MLP把视觉特征和文本特征对齐。

* Feature-level Fusion:在LLM或visual transformer中插入额外的layer,实现文本特征和视觉特征的深度交互和融合。 -

Flamingo:在LLM中插入cross-attention层,加强模态融合。

-

一句话总结:token-level fusion不改变LLM或ViT的内部结构,feature-level fusion则会修改LLM或ViT的内部结构。

2.3.2 Expert Model:偷懒的捷径?

Expert Model,说白了就是把多模态问题转换成单模态问题。比如,用image caption模型把图片转换成文字,然后直接用LLM处理文字。

这种方法简单粗暴,但效果往往不如端到端训练的MLLM。

3. 训练策略及数据:玄学炼丹,数据为王

3.1 Pretraining:打好基础,才能盖高楼

Pretraining阶段,主要目标是模态融合和提供基础的世界知识。

通常的做法是冻结LLM和visual encoder,只训练模态融合的interface。这样做是为了保证其他模块的预训练知识不流失。

当然,也有人选择更新pre-trained modules的参数,但前提是数据质量要过硬,否则容易出现幻觉。

3.1.2 Data:数据质量比数量更重要!

预训练数据可以分为粗粒度(coarse-grained)和细粒度(fine-grained)。

- 粗粒度数据:来源于网络,noise多,可以用CLIP模型过滤掉图文不匹配的数据。

- 细粒度数据:需要通过商用模型(比如chatgpt-4o)构建。

记住,数据宁缺毋滥!脏数据对MLLM的打击是毁灭性的。

3.2 Instruction-tuning:让AI听懂人话

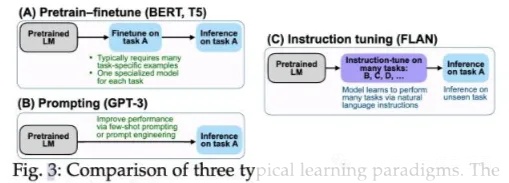

Instruction-tuning的目的是让模型理解指令,输出符合指令的答案。通过指令调优,LLM有望提高zero-shot能力。

Pretrain-finetune:预训练后微调,微调通常需要大量的任务强相关数据。

Prompting:提示方法减少了对大规模数据的依赖,可以通过提示工程来完成专门的任务。

Instruction tuning 可以提升模型的泛化能力从而提升zero-shot能力。

3.2.1 Training Detail

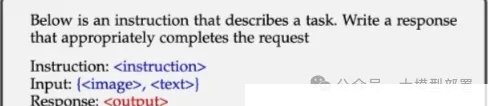

Instruction tuning常见模式

instruction tuning将一条instruction,一组多模态数据作为输入,从而可以得到模型的predicted response(答案),与ground-truth response相比较,通过cross-entropy即可实现模型训练。

3.2.2 Data Collection:三种数据收集方法,各有千秋

- Data Adaption:使用现有数据集构建指令形式的数据集。

- Self-Instruction:让大语言模型生成一部分数据。

- Data Mixture:数据混训(带图和不带图),只训练文本信息也可以给MLLM注入知识。

3.3 Alignment tuning:让AI更懂你

Alignment tuning 通过人类的反馈来训练模型,让模型更符合人类的偏好。

4. Evaluation:别光说不练,拉出来溜溜

在学校的时候,我总是跳过evaluation部分,直接看methodology。现在才知道,评测才是重中之重!

评测可以分为两类:

- Closed-set:有固定答案,无需人工干预。

- Open-set:答案灵活,需要人工打分。

5. Multimodal Hallucination:AI也会瞎说?

Multimodal hallucination,就是MLLM生成的答案和图片内容不符。

常见的幻觉问题:

- Existence Hallucination:物体存在性识别错误。

- Attribute Hallucination:物体属性识别错误。

- Relationship Hallucination:物体之间的关联错误。

6. Brainstorming:一些不成熟的小建议

- 能力层级递进:训练MLLM,要循序渐进,先打好基础,再挑战高难度任务。

- 数据宁缺毋滥:数据质量比数量更重要!

*************************************2025最新版优快云大礼包:《AGI大模型学习资源包》免费分享***************************************

一、2025最新大模型学习路线

一个明确的学习路线可以帮助新人了解从哪里开始,按照什么顺序学习,以及需要掌握哪些知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1级别:AI大模型时代的华丽登场

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理,关键技术,以及大模型应用场景;通过理论原理结合多个项目实战,从提示工程基础到提示工程进阶,掌握Prompt提示工程。

L2级别:AI大模型RAG应用开发工程

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3级别:大模型Agent应用架构进阶实践

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体;同时还可以学习到包括Coze、Dify在内的可视化工具的使用。

L4级别:大模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

整个大模型学习路线L1主要是对大模型的理论基础、生态以及提示词他的一个学习掌握;而L3 L4更多的是通过项目实战来掌握大模型的应用开发,针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

二、大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

三、大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

四、大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

五、大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

*************************************2025最新版优快云大礼包:《AGI大模型学习资源包》免费分享*************************************

1782

1782

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?