大家好,这里是架构资源栈!点击上方关注,添加“星标”,一起学习大厂前沿架构!

关注、发送C1即可获取JetBrains全家桶激活工具和码!

随着 AI 编程助手不断演进,开发者正在寻找既强大又可本地部署的解决方案。由 Mistral AI 和 All Hands AI 联合打造的 Devstral-Small-2507 正是这样一款专为开发者设计的大模型 —— 不仅支持 128k 上下文窗口,还可在高端 PC 或 Mac 上本地运行,并登顶 SWE-Bench 编程能力排行榜。本篇文章将手把手教你如何在本地环境中部署 Devstral Small 1.1,并打造属于自己的 AI 编程助手。

✨ Devstral Small 1.1 有何亮点?

- 🧠 强大的上下文处理能力:128k tokens

- 🛠️ 面向工程:可理解复杂代码、执行多文件编辑

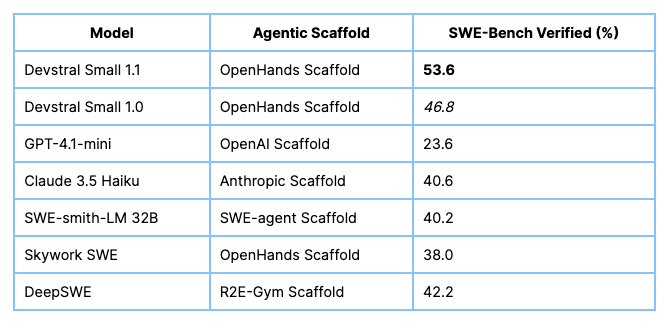

- 📈 性能卓越:SWE-Bench Verified 得分 53.6%,击败前代模型 Devstral Small 1.0 和所有公开模型

- 💡 多语言支持:识别 24 种语言

- 🖥️ 支持本地 GPU:无需依赖云平台即可运行

🚀 环境部署前准备

我们将在 GPU 环境中运行 Devstral 模型。教程基于 NodeShift 云平台,但你也可以选择任何支持 GPU 的本地或云平台。本文演示使用以下 Docker 镜像:

该镜像预装完整 CUDA 工具链,适用于 vLLM 推理框架。

🛠️ 步骤 1:创建 GPU 虚拟机

在 NodeShift 或其他云服务商上选择支持 CUDA 的 GPU,如 H100、A100、L40 等,并启动交互式 shell 容器。推荐配置:

- GPU: H100 (或 VRAM ≥ 40GB)

- 镜像:

nvidia/cuda:12.1.1-devel-ubuntu22.04 - 认证方式: SSH 密钥

🧩 步骤 2:安装 Miniconda 与 Python 环境

安装后激活 conda 并创建 Python 环境:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2559

2559

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?